15. 深度学习——tensorflow实现线性回归和模型的保存、加载

1、tensorflow实现一个简单的线性回归案例

代码

import tensorflow as tf

# 1.准备数据, x特征值[100,1] y目标值[100](自己制造一个数据集)

# 两个参数mean是均值,stddev是方差

x = tf.random_normal([100, 1], mean=1.75, stddev=0.5, name='x_data')

# 矩阵相乘必须是二维的,目标值也自己制作看最后的线性回归求解的w和b是0.7和0.8吗

y_true = tf.matmul(x, [[0.7]]) + 0.8

# 2.建立线性回归模型 y =x w + b(多个数据一般写x w) 1个特征, 1个权重, 一个偏置

# 随机给一个权重和偏置的值,让他去计算损失,然后在当前的状态下优化

# 用变量定义才能优化

weight = tf.Variable(tf.random_normal([1, 1], mean=0.0, stddev=1.0), name='w')

bias = tf.Variable(0.0, name='b')

y_predict = tf.matmul(x, weight) + bias

# 3.建立损失函数,均方误差

loss = tf.reduce_mean(tf.square(y_true - y_predict))

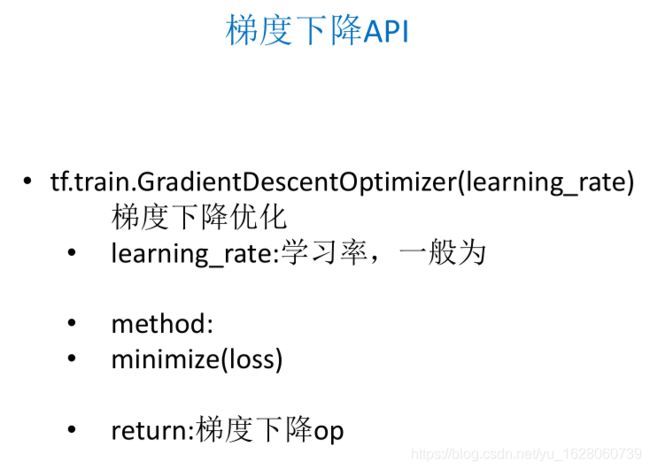

# 4.梯度下降优化损失

train_op = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

init = tf.global_variables_initializer()

# 通过会话运行程序

with tf.Session() as sess:

# 初始化变量

sess.run(init)

# 打印随机初始化的权重和偏置

print('初始化的权重:%f, 偏置: %f'%(weight.eval(), bias.eval()))

# 运行优化

sess.run(train_op)

print('权重:%f, 偏置: %f' % (weight.eval(), bias.eval()))

循环优化代码

import tensorflow as tf

# 1.准备数据, x特征值[100,1] y目标值[100](自己制造一个数据集)

# 两个参数mean是均值,stddev是方差

x = tf.random_normal([100, 1], mean=1.75, stddev=0.5, name='x_data')

# 矩阵相乘必须是二维的,目标值也自己制作看最后的线性回归求解的w和b是0.7和0.8吗

y_true = tf.matmul(x, [[0.7]]) + 0.8

# 2.建立线性回归模型 y =x w + b(多个数据一般写x w) 1个特征, 1个权重, 一个偏置

# 随机给一个权重和偏置的值,让他去计算损失,然后在当前的状态下优化

# 用变量定义才能优化

weight = tf.Variable(tf.random_normal([1, 1], mean=0.0, stddev=1.0), name='w')

bias = tf.Variable(0.0, name='b')

y_predict = tf.matmul(x, weight) + bias

# 3.建立损失函数,均方误差

loss = tf.reduce_mean(tf.square(y_true - y_predict))

# 4.梯度下降优化损失

train_op = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

init = tf.global_variables_initializer()

# 通过会话运行程序

with tf.Session() as sess:

# 初始化变量

sess.run(init)

# 打印随机初始化的权重和偏置

print('初始化的权重:%f, 偏置: %f'%(weight.eval(), bias.eval()))

# 循环训练 运行优化

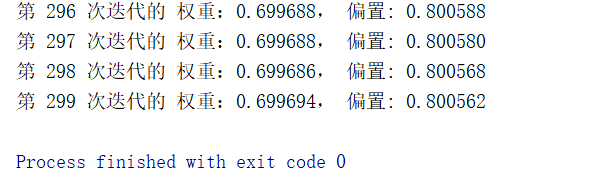

for i in range(300):

sess.run(train_op)

print('第 %d 次迭代的 权重:%f, 偏置: %f' % (i, weight.eval(), bias.eval()))

2.模型的保存和加载

保存模型

import tensorflow as tf

# 1.准备数据, x特征值[100,1] y目标值[100](自己制造一个数据集)

# 两个参数mean是均值,stddev是方差

x = tf.random_normal([100, 1], mean=1.75, stddev=0.5, name='x_data')

# 矩阵相乘必须是二维的,目标值也自己制作看最后的线性回归求解的w和b是0.7和0.8吗

y_true = tf.matmul(x, [[0.7]]) + 0.8

# 2.建立线性回归模型 y =x w + b(多个数据一般写x w) 1个特征, 1个权重, 一个偏置

# 随机给一个权重和偏置的值,让他去计算损失,然后在当前的状态下优化

# 用变量定义才能优化

weight = tf.Variable(tf.random_normal([1, 1], mean=0.0, stddev=1.0), name='w')

bias = tf.Variable(0.0, name='b')

y_predict = tf.matmul(x, weight) + bias

# 3.建立损失函数,均方误差

loss = tf.reduce_mean(tf.square(y_true - y_predict))

# 4.梯度下降优化损失

train_op = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

# 定义一个保存模型的实例

saver = tf.train.Saver()

init = tf.global_variables_initializer()

# 通过会话运行程序

with tf.Session() as sess:

# 初始化变量

sess.run(init)

# 打印随机初始化的权重和偏置

print('初始化的权重:%f, 偏置: %f'%(weight.eval(), bias.eval()))

# 循环训练 运行优化

for i in range(300):

sess.run(train_op)

print('第 %d 次迭代的 权重:%f, 偏置: %f' % (i, weight.eval(), bias.eval()))

saver.save(sess, "H:/FCX/资源/黑马python全栈-人工智能/人4/线性回归模型保存/modle")

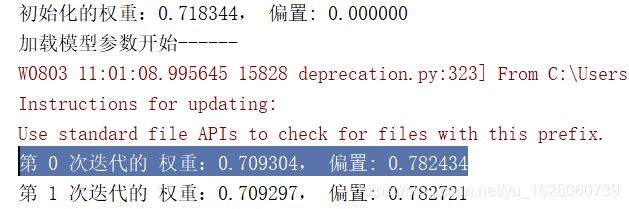

当加载模型的时候看下时候是从第299次的参数开始

代码

import tensorflow as tf

import os

# 1.准备数据, x特征值[100,1] y目标值[100](自己制造一个数据集)

# 两个参数mean是均值,stddev是方差

x = tf.random_normal([100, 1], mean=1.75, stddev=0.5, name='x_data')

# 矩阵相乘必须是二维的,目标值也自己制作看最后的线性回归求解的w和b是0.7和0.8吗

y_true = tf.matmul(x, [[0.7]]) + 0.8

# 2.建立线性回归模型 y =x w + b(多个数据一般写x w) 1个特征, 1个权重, 一个偏置

# 随机给一个权重和偏置的值,让他去计算损失,然后在当前的状态下优化

# 用变量定义才能优化

weight = tf.Variable(tf.random_normal([1, 1], mean=0.0, stddev=1.0), name='w')

bias = tf.Variable(0.0, name='b')

y_predict = tf.matmul(x, weight) + bias

# 3.建立损失函数,均方误差

loss = tf.reduce_mean(tf.square(y_true - y_predict))

# 4.梯度下降优化损失

train_op = tf.train.GradientDescentOptimizer(0.1).minimize(loss)

# 定义一个保存模型的实例

saver = tf.train.Saver()

init = tf.global_variables_initializer()

# 通过会话运行程序

with tf.Session() as sess:

# 初始化变量

sess.run(init)

# 打印随机初始化的权重和偏置

print('初始化的权重:%f, 偏置: %f'%(weight.eval(), bias.eval()))

# 应该优化之前加载模型参数,覆盖模型当中随机初始化的参数,从上次训练的参数结果开始

if os.path.exists("H:/FCX/资源/黑马python全栈-人工智能/人4/线性回归模型保存/checkpoint"):

print('加载模型参数开始------')

saver.restore(sess, "H:/FCX/资源/黑马python全栈-人工智能/人4/线性回归模型保存/modle")

# 循环训练 运行优化

for i in range(300):

sess.run(train_op)

print('第 %d 次迭代的 权重:%f, 偏置: %f' % (i, weight.eval(), bias.eval()))

saver.save(sess, "H:/FCX/资源/黑马python全栈-人工智能/人4/线性回归模型保存/modle")