奇异值分解

最近两天都在看奇异值分解及其在推荐系统和图像压缩方面的应用,这部分知识比较散也比较难理解,看代码不是很好懂,所以通过编学边整理的方式帮助大脑理解这部分知识。

奇异值分解是什么

奇异值分解(Singular Value Decomposition,SVD),是一种提取信息的方法。比如有一份记录用户关于餐馆观点的数据,要对其进行处理分析,提取背后的因素,这个因素可能是餐馆的类别,烹饪配料等,然后利用这些因素估计人们对没有去过的餐馆的看法,从而进行推荐,提取这些信息的方法就叫奇异值分解法。

奇异值分解的作用是什么

奇异值分解能够简约数据,去除噪声和冗余数据。其实它说白了也是一种降维方法,将数据映射到低维空间。看到这里其实就会想,它和主成分分析(PCA)有什么联系或者差异呢?奇异值分解和主成分分析一样,也是告诉我们数据中重要特征,奇异值是数据矩阵乘以该矩阵的转置的特征值的平方根(Data*Data^T特征值的平方根)。

奇异值分解的数学原理

前面说的关于奇异值分解是什么,其实是从应用角度上来说的,从数学的角度讲,它就是一种矩阵分解法。

什么是矩阵分解

顾名思义,矩阵分解就是把一个大矩阵分解成易于处理的形式,这种形式可能是两个或多个矩阵的乘积,就如同我们在代数中的因子分解,这种因子分解在数学里便于我们计算,赋予现实的含义,给一个真实的应用背景,就能方便我们解决生活中遇到的问题。

SDV是如何分解矩阵的

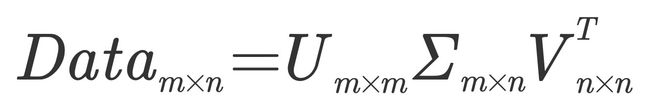

SVD将原始的数据集矩阵Data分解成三个矩阵:U、Sigma、V^T,如果原始矩阵是m行n列,那么U、Sigma和V^T分别就是m行m列、m行n列、n行n列。比较值得一提的是矩阵Sigma,该矩阵只有对角元素,其他元素均为0,有一个惯例是:Sigma的对角元素是从大到小排列的。这些对角元素就称为奇异值。在科学和工程中,一直存在一个普遍事实:在某个奇异值的数目r之后,其他的奇异值均置0,也就是我们仅保留r个重要特征,其余特征都是噪声或者冗余特征。那么问题来了,这个r到底是多少勒?如何选取呢?确定要保留的奇异值个数有很多启发式的策略,其中一个典型的做法就是保留矩阵90%的能量信息。为了计算能量信息,将所有的奇异值求平均和,直到累加到总值的90%为止。另一个启发式策略是当矩阵有上万个奇异值时,保留前面的2000个或3000个。其实这两种方法要想为什么的话可能就涉及到繁杂的数学证明了,每一个为什么的地方都有可能有创新点,留着有灵感的时候深入思考吧。

一个用例理解SVD

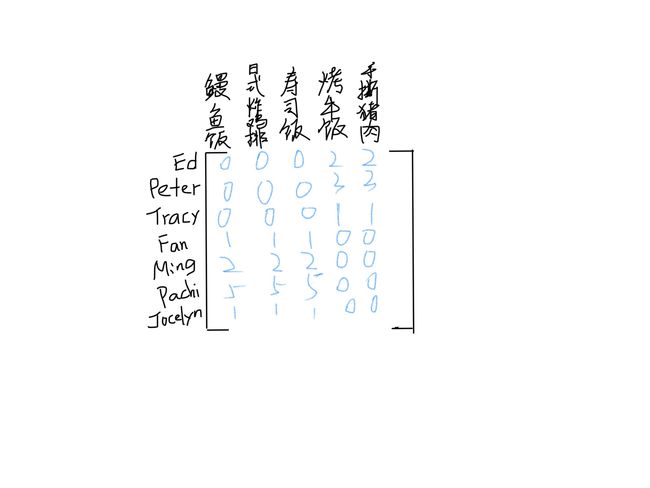

比如给了一些用户和菜系,如下面的矩阵,这个矩阵的值代表了用户对吃过的菜系的评分,没吃过的评分为0,要给这些用户推荐几个他没吃过的菜系。

拿到这个问题,最直观的一个思路流程就是:计算菜系的相似度->结合评分->对没吃过的菜系计算预测评分->预测评分排序->推荐前x个菜。

这也是简单版本的推荐系统的程序流程,计算相似度有欧式距离、皮尔逊相关系数和余弦相似度等常用计算方法。SVD做的改进就是将矩阵分解,从数据中构建出一个主题空间,再在该主题空间下计算相似度,提高了推荐效果(但是SVD会降低程序的速度,尤其是大规模数据集中,这一点以后再谈)。

在上例中,对数据矩阵进行SVD处理,会得到两个奇异值。因此,有两个概念或主题与此数据集相关联,比如我们基于每个组的共同特征来命名,可能是美式BBQ和日式食品这二维(这两个维度是我们通过分析数据得到的,在生活中,我们一看那些菜就发现菜是有类型的,我们按照类型定相似度,进行推荐,奇异值是我生活的经验映射在数学空间的一种体现,来自于数学角度的解释,是巧合也是必然),如何将原始数据变换到这二维呢?V^T矩阵会将用户映射到BBQ/日式食品空间,U矩阵会将菜系映射到BBQ/日式食品空间,在这个空间下求的相似度,然后进行后续流程,实现推荐。详细的推荐系统实现会在下一篇中介绍。

在Python中如何使用SVD

Numpy线性代数库中有一个实现SVD的方法,可以直接拿来用。具体SVD是如何用程序实现的我打算专门写一篇程序实现的介绍,也包括比如特征值到底怎么求的等等方法。这里就简介调用方式。

import numpy as np

def load_data():

return [[0,0,0,2,2],

[0,0,0,3,3],

[0,0,0,1,1],

[1,1,1,0,0],

[2,2,2,0,0],

[5,5,5,0,0],

[1,1,1,0,0]]

data = load_data()

u, sigma, vt = np.linalg.svd(data)

print(sigma)运行结果如下:

[ 9.64365076e+00 5.29150262e+00 8.36478329e-16 6.91811207e-17

3.04963694e-34]可以发现前两个值比后三个值大的多,所以可以取这两个奇异值,把其余三个置0。对于Sigma矩阵为什么长成行向量的样子,是Python内部的机制,为了节省空间,因为它除了对角线都是0,记着Sigma是个矩阵就好。

具体的推荐系统和详细代码解析我会在下一篇中介绍,还在理解和实验当中。