- cuda编程python接口_使用Python写CUDA程序的方法

weixin_39822184

cuda编程python接口

使用Python写CUDA程序有两种方式:*Numba*PyCUDAnumbapro现在已经不推荐使用了,功能被拆分并分别被集成到accelerate和Numba了。例子numbaNumba通过及时编译机制(JIT)优化Python代码,Numba可以针对本机的硬件环境进行优化,同时支持CPU和GPU的优化,并且可以和Numpy集成,使Python代码可以在GPU上运行,只需在函数上方加上相关的指

- 基于 Python 的网站信息探测工具设计与实现

计算机毕业设计指导

python网络服务器

基于Python的网站信息探测工具设计与实现摘要在渗透测试与网络安全评估中,信息探测是最基础且关键的一步。通过对目标网站的操作系统、服务器、CMS、端口、目录结构等信息进行自动化探测,可为后续攻击路径识别提供基础数据支撑。传统工具如WhatWeb、FOFA等虽功能强大,但在定制化与扩展性方面受限。本文设计并实现了一款基于Python的轻量级网站信息探测工具,支持URL/IP扫描、开放端口探测、CM

- 微信上传素材(永久) ,thumb_media_id 获取

亿水清华

首先在获取thumb_media_id时所用微信接口是url="https://api.weixin.qq.com/cgi-bin/material/add_material?access_token={}&type={}"通过url获得的media_id可做thumb_media_id使用。注意如果过程中出现40007错误,可能是你和我一样跳入了这个大坑temporary_url="https:

- 一文弄懂开源大型语言模型 (LLM) 应用程序开发平台--Dify

Llama-Turbo

AI大模型程序员LLM人工智能大模型dify

Dify简介Dify是一个开源大型语言模型(LLM)应用程序开发平台,旨在弥合AI应用程序原型设计与生产部署之间的差距。本文为希望了解或扩展该平台的开发者和技术用户提供了Dify架构、组件和功能的技术概述。平台概述Dify提供端到端解决方案,通过可视化工具和API的组合,构建基于LLM的应用程序。其架构旨在支持AI应用程序开发的整个生命周期,包括模型集成、提示、知识管理、工作流编排和部署。主要特点

- 开源Agent平台Dify源码剖析系列(六)核心模块core/agent之CotCompletionAgentRunner

ATM006

机器智能人工智能大模型人机协同AgentDify

每一篇文章都短小精悍,不啰嗦。笔者寄语本期介绍Dify框架的核心模块core/agent。接下来我们一起深入剖析core/agent目录下的所有代码,并以通俗易懂的方式解释。我们需要先了解这个目录的完整结构,然后逐个分析关键文件,最后总结整个Agent框架的设计和工作原理。首先,让我查看core/agent目录的完整结构:dify/api/core/agent.├──base_agent_runn

- 拼多多返利app叫什么,拼多多返利软件哪个最好

一起高省

拼多多返利app叫高省佣金更高应用市场搜索高省高省码333888(助力新人送皇冠会员送千元礼包百度霸屏拉群后台找我)关于聪明的网购人来说,肯定会想到用返利软件来网购,但是现在返利软件太多了,哪个返利软件返利蕞高?哪个返利app的功能蕞强壮?这是咱们蕞关心的。今日就为我们引荐一个2022年返利佣钱蕞高的app软件,他不只可以返利省钱,蕞要害的是你还可以利用它来挣钱。2022年这个返利软件太火爆了!!

- Dify接入微信

AI量化投资

微信人工智能多智能体智能体语言模型

本文将指导您通过LangBot将Dify应用快速接入微信平台,实现在微信生态中部署智能聊天机器人。前提条件在开始之前,请确保您已完成以下准备工作:Dify应用准备:已在Dify平台(官网或私有部署)创建并发布一个应用(支持聊天助手、Agent或工作流类型)。获取应用的API密钥和API服务器地址(通常为https://api.dify.ai/v1,私有部署需确认具体地址)。LangBot环境:已安

- 使用CrewAI创建一个研究团队

AI量化投资

php开发语言多智能体智能体人工智能

本指导文档将带你一步步完成使用CrewAI框架创建你的第一个AI代理团队的过程。通过这个简单的示例,你将学习如何构建一个研究团队,用于研究和分析指定主题,并生成一份综合报告。本教程基于CrewAI官方文档,适合初学者快速上手。前提条件在开始之前,请确保你已完成以下准备工作:安装Python:确保你的系统安装了Python版本在3.10到3.13之间。你可以通过以下命令检查Python版本:pyth

- Python成第四个支持CUDA的编程语言

Python成第四个支持CUDA的编程语言3月19日NVIDIA的GTC2013图形技术大会将开幕,在此之前会有很多宣传造势内容,其中最重大也是最主要的就是NVIDIA老总黄仁勋的开幕词了,其他合作伙伴也会发布各自的演讲。ContinuumAnalytics联合NVIDIA宣布将会引入新的PythonCUDA编译器——NumbaPro,Python也成为继C、C++以及Fortan之后的第四个支持

- Python FastMCP:让你的AI工具链飞起来

PythonFastMCP:让你的AI工具链飞起来FastMCPFastMCP是什么?1.工具(Tools):赋予LLM执行能力2.Resources(资源):安全数据通道3.Prompts(提示模板):标准化LLM交互4.组件协同:构建项目AI工具链5.部署架构与性能优化博主热门文章推荐:官方文档:FastMCP官方文档:https://gofastmcp.com/MCP协议规范:https:/

- 生命中一束特别的光

抹茶阿白

每个人的生命中都会有一束特别的光,这束光是信仰,激励着我们不断前进。谈谈我自己吧,我的生命中有两束特别的光。第一束:鞠婧祎。她是现在舞台上闪闪发光的偶像,是粉丝们的信仰。2018年我通过大火的古装影视剧《芸汐传》认识她。她饰演的韩芸汐,是一个活泼开朗的小丫头,也是一个温婉动人的王妃娘娘。当时也只是因为她的颜值而喜欢她,努力去了解她,从百度开始,至此,我开始关注她的作品。2019年《新白娘子传奇》开

- Python 解析 PDF 文件的基础方法

电脑维修员xy

pythonpdf前端

```htmlPython解析PDF文件的基础方法Python解析PDF文件的基础方法在现代数据处理和信息提取任务中,PDF文件是一种常见的文档格式。然而,PDF文件的结构复杂且难以直接解析,尤其是当需要从中提取文本或数据时。幸运的是,Python提供了多种强大的库来帮助我们轻松地解析PDF文件。1.PyPDF2库PyPDF2是一个功能强大的Python库,用于处理PDF文件。它可以读取、分割、合

- Vue 3 组合式 API 中的组件生命周期函数详解

码力无边-OEC

Vuevue.js前端javascript前端框架web

Vue3组合式API中的组件生命周期函数详解Vue3引入了组合式API(CompositionAPI),相比于选项式API(OptionsAPI),它更加灵活且易于复用。在组件的开发中,生命周期函数是必不可少的一部分,用于在特定的阶段执行逻辑操作。本文将详细讲解Vue3组合式API的生命周期函数及其相关知识点,并通过语法糖实现相关示例。什么是生命周期函数?Vue组件从创建到销毁的过程中,会经历一系

- socket网络通信TCP与UDP原理及代码实现(c++、python)

目录Socket原理通信协议原理TCPUDP代码实现TCPC++pythonUDPC++pythonSocket原理Socket(套接字)是计算机网络中用于实现进程间通信的一种机制,特别是在不同主机之间通过网络进行数据传输时。它是网络编程的核心概念之一,为应用程序提供了统一的接口,使得开发者可以通过网络发送和接收数据。可以将Socket类比为电话系统中的“电话机”。两台设备通过Socket建立连接

- 如何区分Bug是前端问题还是后端问题?

海姐软件测试

缺陷管理bug前端

在软件测试中,精准定位Bug的归属(前端or后端)是高效协作的关键。以下是系统化的排查方法,结合技术细节和实战技巧:1.核心判断逻辑「数据vs展示」二分法:后端问题:数据本身错误(API返回错误数据/逻辑错误/数据库问题)前端问题:数据正确但展示异常(UI渲染错误/交互逻辑问题)2.四步定位法第一步:抓包分析(必做)工具:ChromeDevTools>Network/Fiddler/Charles

- 【Qt Designer使用快捷键】

QtDesigner简介QtDesigner是Qt框架提供的可视化界面设计工具,用于快速创建GUI(图形用户界面)。用户可通过拖拽控件(如按钮、文本框等)设计界面,无需手动编写布局代码。生成的界面文件(.ui)可通过pyuic或uic工具转换为代码(如Python或C++),与业务逻辑集成。常用快捷键及用途通用操作Ctrl+N:新建界面文件。Ctrl+O:打开现有.ui文件。Ctrl+S:保存当前

- “重复”定义函数的睿智(Python/与ai助手“智普清言”深度交流)

梦幻精灵_cq

笔记学习

镜像双胞谬重复,定制便捷巧活工。 笔记模板由python脚本于2025-07-1612:16:30创建,本篇笔记适合至少通晓一门语言,熟悉基本编程范式的coder翻阅。学习的细节是欢悦的历程 博客的核心价值:在于输出思考与经验,而不仅仅是知识的简单复述。Python官网: 这里,才python前沿。英文原版,原汁原味,才是寻根溯源的正统。地址:https://www.python.org/F

- 偶拾《退让》,一阙仿七律带出的文化思考(中文诗创作)

梦幻精灵_cq

笔记学习

礼貌温言沐春风,谦让理解通彼此。 笔记模板由python脚本于2025-07-0111:29:03创建,本篇笔记适合喜欢中文仿古七言诗的coder翻阅。学习的细节是欢悦的历程 博客的核心价值:在于输出思考与经验,而不仅仅是知识的简单复述。Python官网: 这里,才python前沿。英文原版,原汁原味,才是寻根溯源的正统。地址:https://www.python.org/Free: 大咖

- 008、Python+fastapi,第一个后台管理项目走向第8步:ubutun 20.04下配置远程桌面、安装vscode+python环境配置

浪淘沙jkp

学习fastapi

一、说明白飘了3个月无影云电脑,开始选了个windowsserver非常不好用,后台改为ubuntu想升级到22,没成功,那就20.04吧。今天先安装下开发环境,后续2个月就想把他当做开发服务器,不知道行不行,公网ip是否可以外部链接。本来想装个宝塔面板直接管理,不过那玩意用了一次,决定说方便也不方便,还是放弃,要用也搞个掏钱的,你懂的,免费的不放心啊那我们就一个一个安装好了,大概要安装mysql

- 适合学生赚钱的软件 学生在校赚零花钱

氧惠_飞智666999

生时代是人生中最美好的阶段之一,但也是经济压力较大的阶段之一。很多学生想要通过自己的努力赚取一些零花钱,既能减轻家庭负担,又能锻炼自己的能力和经验。但是,在校学习任务繁重,时间和空间都有限制,如何找到适合自己的赚钱方式呢?氧惠APP,2022全新模式,0投资,最快63天做到月入十万。我的直推也会放到你下面,我曾经1年做到百万团队,现在加入我也会帮你做到百万团队。【氧惠】百度有几百万篇报道,也期待你

- python爬大学生就业信息报告_Python语言爬虫——Python 岗位分析报告

weixin_39578457

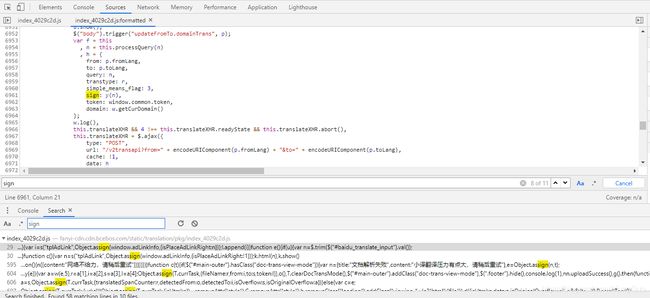

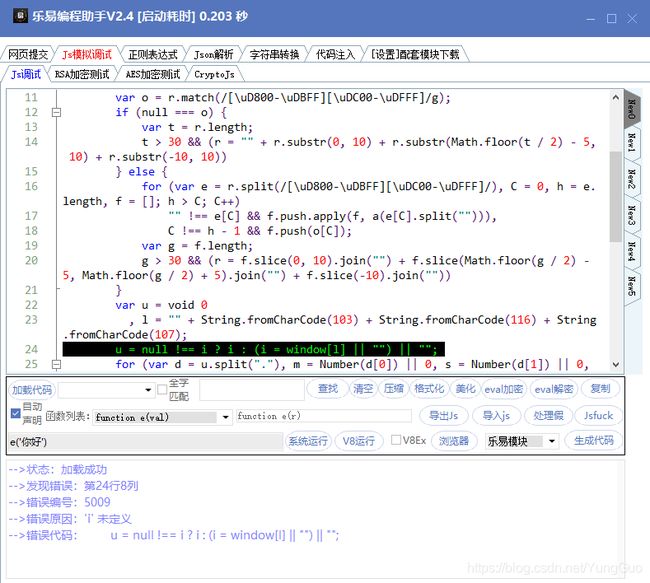

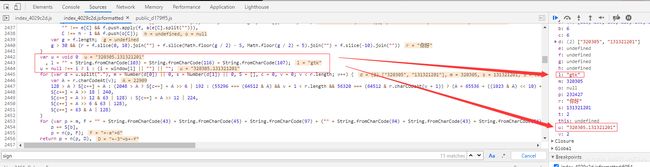

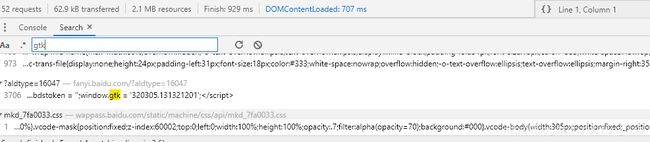

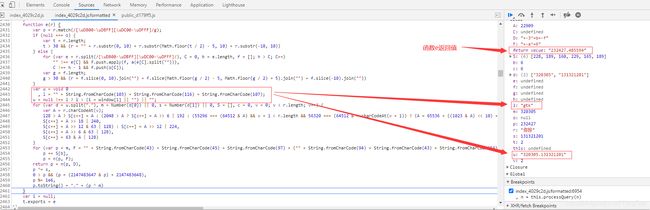

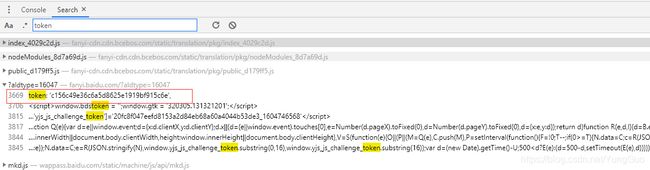

本文主要向大家介绍了Python语言爬虫——Python岗位分析报告,通过具体的内容向大家展示,希望对大家学习Python语言有所帮助。前两篇我们分别爬取了糗事百科和妹子图网站,学习了Requests,BeautifulSoup的基本使用。不过前两篇都是从静态HTML页面中来筛选出我们需要的信息。这一篇我们来学习下如何来获取Ajax请求返回的结果。本篇以拉勾网为例来说明一下如何获取Ajax请求内容

- GKD v1.9.2 安卓自动跳过广告

在下周大侠

安卓软件

GKD是一款基于无障碍+高级选择器+订阅规则的自定义屏幕点击APP。支持点击跳过任何开屏广告/点击关闭应用内部任何弹窗广告,如关闭百度贴吧帖子广告回复/知乎回答底部推荐广告回复;GKD还支持一些快捷操作,如微信电脑登录自动同意/微信扫描登录自动同意/微信自动领取红包。软件特色基于高级选择器+订阅规则+快照审查,它可以实现点击跳过任意开屏广告/点击关闭应用内部任意弹窗广告,如关闭百度贴吧帖子广告卡片

- 快速入门Robocorp:用Python构建和操作工作流

jaioyfpo

python开发语言

快速入门Robocorp:用Python构建和操作工作流引言在现代开发环境中,自动化是提高效率和降低成本的关键。Robocorp作为一个强大的平台,它帮助您使用Python构建和操作工作流,无论在何地运行都可以保持无缝连接和高扩展性。本文将带领您快速入门Robocorp的基本安装和设置,并展示如何使用ActionServer进行项目的创建和管理。主要内容1.安装和设置要开始使用Robocorp,首

- Apache Ignite异常处理与故障管理指南

张栋涓Kerwin

ApacheIgnite异常处理与故障管理指南概述在分布式系统中,异常处理和故障管理是确保系统稳定性的关键环节。ApacheIgnite作为一个高性能的内存计算平台,提供了完善的异常处理机制和故障管理策略。本文将深入解析Ignite中的异常类型、处理方式以及关键故障处理机制,帮助开发者构建更健壮的Ignite应用。Ignite常见异常类型及处理IgniteAPI定义了多种异常类型,每种异常都有其特

- 解决百度网盘上传请求中或上传慢的方法

百度网盘正常情况下是超快的,不应该是"上传请求中"或几k的速度。原因是因为DNS解释问题。尤其是海外用户。例如,使用DNS8.8.8.8PSC:\WINDOWS\system32>nslookupDefaultServer: dns.googleAddress: 8.8.8.8>server8.8.8.8DefaultServer: dns.googleAddress: 8.8.8.8>c.pcs

- Python关于pandas的基础知识

WeiJingYu.

pythonpandas开发语言

一.扫盲(一)、pandas是什么pandas是Python的一个第三方数据处理库,它提供了高效、灵活的数据结构(如Series和DataFrame),能方便地对结构化数据进行清洗、转换、分析和处理。(二)、pandas与NumPy的关系NumPy是Python中用于科学计算的基础库,主要用于存储和处理数值型数组。但它有一个局限,就是不能直接存储和处理字符串等非数值类型的数据。而pandas是在N

- Python 爬虫——Pyppeteer

Python爬虫——PyppeteerPythonSpider——Pyppeteer一、爬虫的两种方式二、Pyppeteer三、爬虫实现PythonSpider——Pyppeteer爬虫具有时效性,该文产生于2023年末一、爬虫的两种方式爬虫大致可以分为两类方式:直接请求直接请求的方式一般是使用python的HTTP请求库发起HTTP请求,然后接收返回的数据再进行解析,这种方式存在很大的局限性。当

- Python关于numpy的基础知识数组的升维

WeiJingYu.

pythonnumpy开发语言

在Python数据处理中,numpy是常用的科学计算库,数组操作是其核心内容之一。下面通过代码示例,展示如何从Python自带列表构建numpy一维数组,再进一步升维构建二维数组。\importnumpyasnp#一维数组构建:从Python列表到numpy一维数组list1=[1,2,3,4,5]#Python自带的列表数据类型print("Python列表list1:",list1)v=np.

- Selenium+Java 自动化测试入门到实践:从环境搭建到元素操作

yy鹈鹕灌顶

seleniumjava测试工具

在自动化测试领域,Selenium凭借其强大的跨浏览器兼容性和灵活的API,成为Web应用测试的首选工具。而Java作为一门稳定且广泛应用的编程语言,与Selenium结合能构建出高效、可维护的自动化测试框架。本文将从环境搭建开始,逐步介绍Selenium+Java的核心用法,帮助新手快速上手。一、环境搭建:让工具跑起来1.安装Java开发环境Selenium的Java客户端需要依赖JDK,建议安

- Selenium Python 代码之打开网页自动填充内容并搜索

iCloudEnd

SeleniumPython代码之打开网页自动填充内容并搜索流程通过id找到文本框inputElement.send_keys(Keys.BACK_SPACE)发送删除键,清除一下之前文字inputElement.send_keys(Keys.BACK_SPACE)发送需要查询对内容并送个回车inputElement=driver1.find_element_by_id("TextBox1")in

- 312个免费高速HTTP代理IP(能隐藏自己真实IP地址)

yangshangchuan

高速免费superwordHTTP代理

124.88.67.20:843

190.36.223.93:8080

117.147.221.38:8123

122.228.92.103:3128

183.247.211.159:8123

124.88.67.35:81

112.18.51.167:8123

218.28.96.39:3128

49.94.160.198:3128

183.20

- pull解析和json编码

百合不是茶

androidpull解析json

n.json文件:

[{name:java,lan:c++,age:17},{name:android,lan:java,age:8}]

pull.xml文件

<?xml version="1.0" encoding="utf-8"?>

<stu>

<name>java

- [能源与矿产]石油与地球生态系统

comsci

能源

按照苏联的科学界的说法,石油并非是远古的生物残骸的演变产物,而是一种可以由某些特殊地质结构和物理条件生产出来的东西,也就是说,石油是可以自增长的....

那么我们做一个猜想: 石油好像是地球的体液,我们地球具有自动产生石油的某种机制,只要我们不过量开采石油,并保护好

- 类与对象浅谈

沐刃青蛟

java基础

类,字面理解,便是同一种事物的总称,比如人类,是对世界上所有人的一个总称。而对象,便是类的具体化,实例化,是一个具体事物,比如张飞这个人,就是人类的一个对象。但要注意的是:张飞这个人是对象,而不是张飞,张飞只是他这个人的名字,是他的属性而已。而一个类中包含了属性和方法这两兄弟,他们分别用来描述对象的行为和性质(感觉应该是

- 新站开始被收录后,我们应该做什么?

IT独行者

PHPseo

新站开始被收录后,我们应该做什么?

百度终于开始收录自己的网站了,作为站长,你是不是觉得那一刻很有成就感呢,同时,你是不是又很茫然,不知道下一步该做什么了?至少我当初就是这样,在这里和大家一份分享一下新站收录后,我们要做哪些工作。

至于如何让百度快速收录自己的网站,可以参考我之前的帖子《新站让百

- oracle 连接碰到的问题

文强chu

oracle

Unable to find a java Virtual Machine--安装64位版Oracle11gR2后无法启动SQLDeveloper的解决方案

作者:草根IT网 来源:未知 人气:813标签:

导读:安装64位版Oracle11gR2后发现启动SQLDeveloper时弹出配置java.exe的路径,找到Oracle自带java.exe后产生的路径“C:\app\用户名\prod

- Swing中按ctrl键同时移动鼠标拖动组件(类中多借口共享同一数据)

小桔子

java继承swing接口监听

都知道java中类只能单继承,但可以实现多个接口,但我发现实现多个接口之后,多个接口却不能共享同一个数据,应用开发中想实现:当用户按着ctrl键时,可以用鼠标点击拖动组件,比如说文本框。

编写一个监听实现KeyListener,NouseListener,MouseMotionListener三个接口,重写方法。定义一个全局变量boolea

- linux常用的命令

aichenglong

linux常用命令

1 startx切换到图形化界面

2 man命令:查看帮助信息

man 需要查看的命令,man命令提供了大量的帮助信息,一般可以分成4个部分

name:对命令的简单说明

synopsis:命令的使用格式说明

description:命令的详细说明信息

options:命令的各项说明

3 date:显示时间

语法:date [OPTION]... [+FORMAT]

- eclipse内存优化

AILIKES

javaeclipsejvmjdk

一 基本说明 在JVM中,总体上分2块内存区,默认空余堆内存小于 40%时,JVM就会增大堆直到-Xmx的最大限制;空余堆内存大于70%时,JVM会减少堆直到-Xms的最小限制。 1)堆内存(Heap memory):堆是运行时数据区域,所有类实例和数组的内存均从此处分配,是Java代码可及的内存,是留给开发人

- 关键字的使用探讨

百合不是茶

关键字

//关键字的使用探讨/*访问关键词private 只能在本类中访问public 只能在本工程中访问protected 只能在包中和子类中访问默认的 只能在包中访问*//*final 类 方法 变量 final 类 不能被继承 final 方法 不能被子类覆盖,但可以继承 final 变量 只能有一次赋值,赋值后不能改变 final 不能用来修饰构造方法*///this()

- JS中定义对象的几种方式

bijian1013

js

1. 基于已有对象扩充其对象和方法(只适合于临时的生成一个对象):

<html>

<head>

<title>基于已有对象扩充其对象和方法(只适合于临时的生成一个对象)</title>

</head>

<script>

var obj = new Object();

- 表驱动法实例

bijian1013

java表驱动法TDD

获得月的天数是典型的直接访问驱动表方式的实例,下面我们来展示一下:

MonthDaysTest.java

package com.study.test;

import org.junit.Assert;

import org.junit.Test;

import com.study.MonthDays;

public class MonthDaysTest {

@T

- LInux启停重启常用服务器的脚本

bit1129

linux

启动,停止和重启常用服务器的Bash脚本,对于每个服务器,需要根据实际的安装路径做相应的修改

#! /bin/bash

Servers=(Apache2, Nginx, Resin, Tomcat, Couchbase, SVN, ActiveMQ, Mongo);

Ops=(Start, Stop, Restart);

currentDir=$(pwd);

echo

- 【HBase六】REST操作HBase

bit1129

hbase

HBase提供了REST风格的服务方便查看HBase集群的信息,以及执行增删改查操作

1. 启动和停止HBase REST 服务 1.1 启动REST服务

前台启动(默认端口号8080)

[hadoop@hadoop bin]$ ./hbase rest start

后台启动

hbase-daemon.sh start rest

启动时指定

- 大话zabbix 3.0设计假设

ronin47

What’s new in Zabbix 2.0?

去年开始使用Zabbix的时候,是1.8.X的版本,今年Zabbix已经跨入了2.0的时代。看了2.0的release notes,和performance相关的有下面几个:

:: Performance improvements::Trigger related da

- http错误码大全

byalias

http协议javaweb

响应码由三位十进制数字组成,它们出现在由HTTP服务器发送的响应的第一行。

响应码分五种类型,由它们的第一位数字表示:

1)1xx:信息,请求收到,继续处理

2)2xx:成功,行为被成功地接受、理解和采纳

3)3xx:重定向,为了完成请求,必须进一步执行的动作

4)4xx:客户端错误,请求包含语法错误或者请求无法实现

5)5xx:服务器错误,服务器不能实现一种明显无效的请求

- J2EE设计模式-Intercepting Filter

bylijinnan

java设计模式数据结构

Intercepting Filter类似于职责链模式

有两种实现

其中一种是Filter之间没有联系,全部Filter都存放在FilterChain中,由FilterChain来有序或无序地把把所有Filter调用一遍。没有用到链表这种数据结构。示例如下:

package com.ljn.filter.custom;

import java.util.ArrayList;

- 修改jboss端口

chicony

jboss

修改jboss端口

%JBOSS_HOME%\server\{服务实例名}\conf\bindingservice.beans\META-INF\bindings-jboss-beans.xml

中找到

<!-- The ports-default bindings are obtained by taking the base bindin

- c++ 用类模版实现数组类

CrazyMizzz

C++

最近c++学到数组类,写了代码将他实现,基本具有vector类的功能

#include<iostream>

#include<string>

#include<cassert>

using namespace std;

template<class T>

class Array

{

public:

//构造函数

- hadoop dfs.datanode.du.reserved 预留空间配置方法

daizj

hadoop预留空间

对于datanode配置预留空间的方法 为:在hdfs-site.xml添加如下配置

<property>

<name>dfs.datanode.du.reserved</name>

<value>10737418240</value>

- mysql远程访问的设置

dcj3sjt126com

mysql防火墙

第一步: 激活网络设置 你需要编辑mysql配置文件my.cnf. 通常状况,my.cnf放置于在以下目录: /etc/mysql/my.cnf (Debian linux) /etc/my.cnf (Red Hat Linux/Fedora Linux) /var/db/mysql/my.cnf (FreeBSD) 然后用vi编辑my.cnf,修改内容从以下行: [mysqld] 你所需要: 1

- ios 使用特定的popToViewController返回到相应的Controller

dcj3sjt126com

controller

1、取navigationCtroller中的Controllers

NSArray * ctrlArray = self.navigationController.viewControllers;

2、取出后,执行,

[self.navigationController popToViewController:[ctrlArray objectAtIndex:0] animated:YES

- Linux正则表达式和通配符的区别

eksliang

正则表达式通配符和正则表达式的区别通配符

转载请出自出处:http://eksliang.iteye.com/blog/1976579

首先得明白二者是截然不同的

通配符只能用在shell命令中,用来处理字符串的的匹配。

判断一个命令是否为bash shell(linux 默认的shell)的内置命令

type -t commad

返回结果含义

file 表示为外部命令

alias 表示该

- Ubuntu Mysql Install and CONF

gengzg

Install

http://www.navicat.com.cn/download/navicat-for-mysql

Step1: 下载Navicat ,网址:http://www.navicat.com/en/download/download.html

Step2:进入下载目录,解压压缩包:tar -zxvf navicat11_mysql_en.tar.gz

- 批处理,删除文件bat

huqiji

windowsdos

@echo off

::演示:删除指定路径下指定天数之前(以文件名中包含的日期字符串为准)的文件。

::如果演示结果无误,把del前面的echo去掉,即可实现真正删除。

::本例假设文件名中包含的日期字符串(比如:bak-2009-12-25.log)

rem 指定待删除文件的存放路径

set SrcDir=C:/Test/BatHome

rem 指定天数

set DaysAgo=1

- 跨浏览器兼容的HTML5视频音频播放器

天梯梦

html5

HTML5的video和audio标签是用来在网页中加入视频和音频的标签,在支持html5的浏览器中不需要预先加载Adobe Flash浏览器插件就能轻松快速的播放视频和音频文件。而html5media.js可以在不支持html5的浏览器上使video和audio标签生效。 How to enable <video> and <audio> tags in

- Bundle自定义数据传递

hm4123660

androidSerializable自定义数据传递BundleParcelable

我们都知道Bundle可能过put****()方法添加各种基本类型的数据,Intent也可以通过putExtras(Bundle)将数据添加进去,然后通过startActivity()跳到下一下Activity的时候就把数据也传到下一个Activity了。如传递一个字符串到下一个Activity

把数据放到Intent

- C#:异步编程和线程的使用(.NET 4.5 )

powertoolsteam

.net线程C#异步编程

异步编程和线程处理是并发或并行编程非常重要的功能特征。为了实现异步编程,可使用线程也可以不用。将异步与线程同时讲,将有助于我们更好的理解它们的特征。

本文中涉及关键知识点

1. 异步编程

2. 线程的使用

3. 基于任务的异步模式

4. 并行编程

5. 总结

异步编程

什么是异步操作?异步操作是指某些操作能够独立运行,不依赖主流程或主其他处理流程。通常情况下,C#程序

- spark 查看 job history 日志

Stark_Summer

日志sparkhistoryjob

SPARK_HOME/conf 下:

spark-defaults.conf 增加如下内容

spark.eventLog.enabled true spark.eventLog.dir hdfs://master:8020/var/log/spark spark.eventLog.compress true

spark-env.sh 增加如下内容

export SP

- SSH框架搭建

wangxiukai2015eye

springHibernatestruts

MyEclipse搭建SSH框架 Struts Spring Hibernate

1、new一个web project。

2、右键项目,为项目添加Struts支持。

选择Struts2 Core Libraries -<MyEclipes-Library>

点击Finish。src目录下多了struts