【VQA文献阅读】PATHVQA: 30000+ QUESTIONS FOR MEDICAL VISUAL QUESTION ANSWERING

【VQA文献阅读】PATHVQA: 30000+ QUESTIONS FOR MEDICAL VISUAL QUESTION ANSWERING

原文地址:https://arxiv.org/abs/2003.10286

ABSTRACT

Is it possible to develop an “AI Pathologist" to pass the board-certified examination of the American Board of Pathology? To achieve this goal, the first step is to create a visual question answering(VQA) dataset where the AI agent is presented with a pathology image together with a question and is asked to give the correct answer. Our work makes the first attempt to build such a dataset. Different from creating general-domain VQA datasets where the images are widely accessible and there are many crowdsourcing workers available and capable of generating question-answer pairs, developing a medical VQA dataset is much more challenging. First, due to privacy concerns, pathology images are usually not publicly available. Second, only well-trained pathologists can understand pathology images, but they barely have time to help create datasets for AI research. To address these challenges, we resort to pathology textbooks and online digital libraries. We develop a semi-automated pipeline to extract pathology images and captions from textbooks and generate question-answer pairs from captions using natural language processing. We collect 32,799 open-ended questions from 4,998pathology images where each question is manually checked to ensure correctness. To our best knowledge, this is the first dataset for pathology VQA. Our dataset will be released publicly to promote research in medical VQA.

有可能培养一个“AI病理学家”通过美国病理学委员会认证的考试吗?为了实现这个目标,第一步是创建一个视觉问题回答(VQA)数据集,其中AI代理被呈现一个病理图像和一个问题,并被要求给出正确答案。我们的工作是建立这样一个数据集的第一次尝试。与创建通用领域的VQA数据集不同,后者的图像可广泛访问,有许多众包工作者可用,并有能力生成问答对,开发医疗VQA数据集更具挑战性。首先,出于隐私考虑,病理图像通常不会公开。其次,只有训练有素的病理学家才能理解病理图像,但他们几乎没有时间帮助创建AI研究的数据集。为了应对这些挑战,我们求助于病理学教科书和在线数字图书馆。我们开发了一个半自动的管道来从教科书中提取病理图像和字幕,并使用自然语言处理从字幕中生成问题-答案对。我们从4,998个病理图像中收集了32,799个开放式问题,每个问题都经过手工检查以确保正确性。据我们所知,这是第一个病理VQA数据集。我们的数据集将公开发布,以促进医学VQA的研究。

Keywords

Visual question answering, dataset, pathology, healthcare

视觉问答,数据集,病理学,医疗保健

1 Introduction

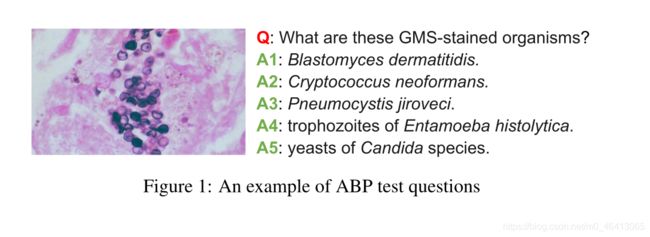

病理学研究疾病或伤害的原因和后果。它是病人护理的每个方面的基础,从诊断检测和治疗建议到使用尖端基因技术和预防疾病。从事病理学的医学专业人员被称为病理学家,他们检查身体和身体组织。在美国,医学专业人士要想成为一名获得委员会认证的病理学家,需要通过由美国病理学委员会(ABP)组织的认证考试,这是一项非常具有挑战性的任务。我们有兴趣问:是否可以开发一个人工智能(AI)系统来通过ABP考试?这是实现人工智能辅助临床决策支持和临床教育的重要一步。在ABP测试的问题中,一个主要的类型是了解病理图像。给出一个病理图像和一个问题,要求考生选择一个正确的答案。图1显示了一个示例。为了训练一个AI系统通过这个考试,我们需要收集一个包含类似于ABP测试的问题的数据集。ABP提供了一些示例问题,但它们太少,无法用于培训数据驱动模型。一些商业机构提供的实践问题数量较多,但价格昂贵,且由于版权问题无法与公众分享。

为了解决这些限制,我们的目标是创建一个病理学视觉问题回答(VQA)数据集,其中包含类似于ABP测试的问题,并可以与医疗保健人工智能的广泛研究社区共享。据我们所知,这是第一个病理VQA数据集。VQA[1]是近年来引起广泛关注的跨学科研究问题。给定一幅图像(例如,一幅狗在追球的图像)和一个关于图像视觉内容的问题(例如,“狗在追什么?”),VQA的目标是开发人工智能算法来推断正确答案(例如,“球”)。VQA需要深入理解图像和文本问题,以及视觉对象和文本实体之间的关系,这在技术上要求很高。虽然通用领域的VQA有几个数据集[2,1,3,4,5],但医学领域的VQA数据集非常罕见。

医学VQA数据集的构建比一般领域的VQA数据集更具挑战性。首先,亚马逊机械土耳其(Amazon Mechanical Turk)等众包平台的许多员工可以从通用领域的图像中生成问题和答案。这些图像包含的内容(如,狗,猫,湖)很容易理解的人。对图像的理解几乎没有障碍,对视觉对象提出适当的问题,并给出正确的答案。然而,医学图像如病理图像具有高度的领域特异性,这只能由受过良好教育的医学专业人士来解释。雇佣医疗专业人员帮助创建医疗VQA数据集非常困难和昂贵。其次,要创建VQA数据集,首先需要收集图像数据集。尽管普通领域的图像普遍存在,但由于隐私问题,医学图像很难获取。

为了应对这些挑战,我们求助于病理学教科书,尤其是那些可以在网上免费获取的教科书,以及在线数字图书馆。这些教科书包含了很多病理学图像,涵盖了病理学的整个领域。每张图像都有一个描述图像中病理发现的标题(如图2所示)。该标题用词谨慎,临床精确。==我们从教科书和在线数字图书馆中提取图像和字幕,并开发一个半自动的管道,从每个字幕中生成问题-答案对。我们已经手动检查了自动生成的问题和答案,并修正了小语法问题。==最后,我们收集了一个包含4998张图像和32799个问答对的病理VQA数据集。

本文的主要贡献如下:

•我们创建了一个包含4998张病理图像和32799对问答对的病理学视觉问答(VQA)数据集,以促进医学VQA的研究。据我们所知,这是第一个病理VQA数据集。

•我们开发了一个半自动化的管道,以有效地从医学教科书和在线数字图书馆创建医学VQA数据集。我们的流水线可以广泛应用于病理学以外的其他医学成像领域,如放射学、超声等。

•我们将几种成熟和最先进的VQA方法应用到我们的数据集,并生成一组基线结果供其他研究人员基准。

本文的其余部分组织如下。

第2节介绍了现有VQA数据集的概述。

第3节描述了从病理学教科书和在线数字图书馆构建病理学VQA数据集的管道。

第4节展示了我们数据集的统计信息。

第5节介绍基线VQA模型和在我们的数据集上实现的结果。

第6部分是全文的总结

2 Related Works

2.1 Datasets

据我们所知,目前有两个用于医学视觉问题回答的数据集。VQA-Med[6]数据集是在4200张放射图像上创建的,有15292个问答对。临床问题分为四类:形态问题、平面问题、器官系统问题和异常问题。对于前三个类别,QA采用多项选择(MC)风格,可能的答案的数量是固定的(分别为36、16和10)。因此,QA任务可以等价地表述为分别有36、16和10个类别的多路分类问题。这使得这个数据集的难度大大降低。异常类问题是真正具有挑战性的开放式问题。然而,只有2408题(15.7%)。 VQA-RAD[7]是一个人工制作的数据集,其中的问题和答案是由临床医生提供的放射图像。共有情态、平面等11种类型3515题。58%为MC风格,其余为开放式。我们的数据集与VQA-Med和VQA-RAD有两个不同之处。首先,我们的数据集是关于病理学的,而VQA-Med和VQA-RAD[7]都是关于放射学的。其次,我们的数据集是一个真正具有挑战性的QA数据集,其中大多数问题都是开放式的,而在VQA-Med和VQA-RAD中,==大多数问题都有固定数量的候选答案,可以通过多种方式分类来回答。==此外,我们的数据集中的问题数量比VQA-Med和VQA-RAD要大得多。

在一般领域,已经开发了许多可视化问题回答数据集。DAQUAR[2]建立在包含室内场景RGBD图像的NYU-Depth V2数据集[8]之上。DAQUAR由(1)基于文本模板自动生成的合成问题-答案对和(2)由五个注释器生成的人工问题-答案对组成。VQA数据集[1]是以MS COCO[9]中的真实图像和[10,11]中的抽象场景图像为基础开发的。问答对是由人类注解员创建的,他们被鼓励提出“有趣的”和“多样的”问题。VQA v2[5]是从VQA[1]数据集扩展来实现视觉和文本信息之间的更平衡,通过以一种方式收集互补的图像,每个问题都与具有不同答案的一对相似的图像相关联。在COCO-QA[3]数据集中,基于语法解析和语言规则,从图像字幕中自动生成问答对。cleverr[4,12]是一个基于不同尺寸、材质和颜色的空间相关对象(包括立方体、球体和圆柱体)的渲染图像开发的数据集。对象的位置和属性都被标注在每张图片上。这些问题是自动从注释中生成的。

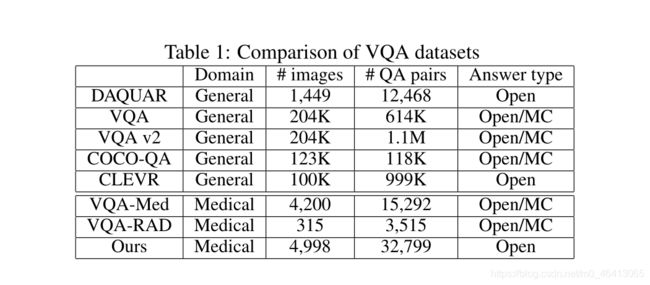

表1给出了不同VQA数据集的比较。前5个数据集属于一般领域,后3个属于医学领域。毫无疑问,通用领域数据集的大小(包括图像和问答对的数量)要比医疗数据集大得多,因为通用领域的图像更容易公开使用,而且有许多合格的人类注释员可以在通用图像上生成QA对。

2.2 Automatic Construction of Question-Answer Pairs

现有的数据集已经使用自动方法来构造问题-答案对。在DAQUAR中,==问题是通过模板生成的,比如“{image_id}中有多少个{object} ?”这些模板是用数据库中的基本事实实例化的。在COCO-QA中,作者开发了一个基于斯坦福句法解析器[13]的问题生成算法,并使用手工制作的规则形成了四种类型的问题——“对象”、“数字”、“颜色”和“位置”。在cleverr中,每幅图像中物体的位置和属性都得到了充分的标注,自动算法在此基础上生成问题。该算法不能应用于难以获得目标和场景详细标注的自然图像。在[14]中,作者开发了一个条件自动编码器[15]模型,可以从图像中自动生成问题。==为了训练这样的模型,需要图像-问题对,这就产生了一个先有鸡还是先有蛋的问题:目标是生成问题,但实现这个目标需要生成问题。在VQA-Med中,作者从medpix1数据库中收集医学图像以及相关侧信息(如标题、模式、平面),并根据[7]中手动定义的模式生成问题-答案对。为了确保测试集中问题的正确性,两位医生被要求进行手工验证。

3 Dataset Collection

我们开发了一个半自动的管道,从病理学教科书和在线数字图书馆中生成病理学VQA数据集。我们手动检查自动生成的问题-答案对,以修正语法错误。该自动化流程包括两个步骤:

(1)从病理学电子教材和病理学教育信息资源(PEIR)数字图书馆网站中提取病理学图像及其标题;

(2)根据字幕生成问答对。

3.1 Extracting Pathology Images and Captions

鉴于有一本PDF格式的病理学教科书,并且可以在网上公开获得,我们使用两个第三方工具pypdf23和pdfminer4来提取图像和相关的标题。PyPDF2提供api来访问每个PDF页面中的“Resources”对象,其中“XObject”提供关于图像的信息。PDFMiner允许用户获取文本及其在页面中的确切位置。为了从每个页面的文本中提取图像标题,我们使用正则表达式来搜索前缀为“Fig.”或“Figure”,后面跟着数字和标题文本的代码片段。对于包含多个图像的页面,我们根据它们的位置对它们进行排序;字幕也是一样。图像和位置是根据它们的顺序匹配的。给出了一个在线病理数字图书馆,如PEIR,我们使用两个第三方工具request5和Beautiful soup6来抓取图像和相关的字幕。Requests是一个使用Python构建的HTTP库,并提供了发送HTTP/1.1请求的api。Beautiful Soup生成’ http。解析器’,并可以访问网址和标签的图像在网站页面上。给定一组url,我们使用请求来读取网站页面,并使用Beautiful Soup来查找目标HTML标记下的图像,包括内容分割元素hdivi、无序列表元素huli和hlii元素。然后我们就可以下载带有请求的图像,并将它们的说明直接写入本地文件。对提取的图像-标题对进行后处理,包括:

(1)去除非病理图像,如流程图、肖像;

(2)纠正图像与字幕的错误匹配。

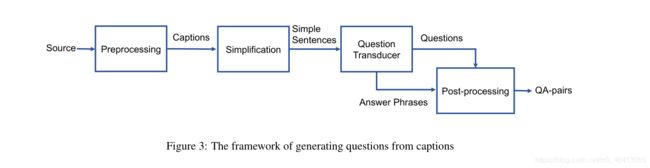

3.2 Question Generation

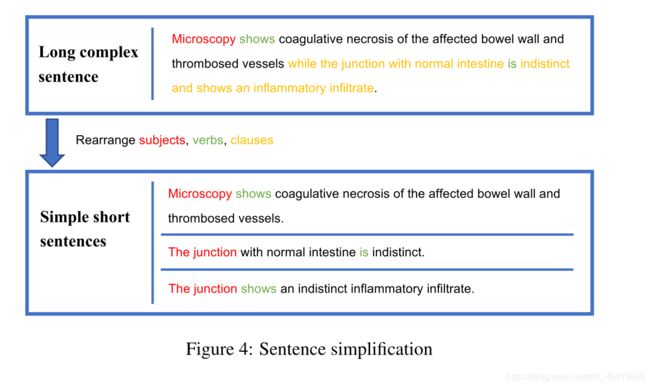

在本节中,我们将讨论如何从字幕半自动生成问题。图3显示了总体框架。我们使用Stanford CoreNLP[13]工具包对标题进行自然语言处理,包括句子拆分、词素化、词性标注、命名实体识别(NER)、成分解析和依赖解析。许多句子都很长,句法结构复杂。我们把一个长句子简化成几个短句子。对经过词性标注和句法解析的主语、动词、子句等,我们采用[16,17]中提出的规则对其进行重新排列,以达到简化的目的。图4显示了一个示例。

给定简化句的POS标记和命名实体,我们为它们生成问题:包括日期和时间实体的“when”类型的问题和短语,如“in/during…”“阶段/时期”、“在……之前”、“在……之后”;“多少/多少”类型的问题标记为数字的单词;用“whose”对物主代词的疑问句(如“its”、“their”);以“内部”、“内部”、“在…的左边/右边”开头的位置实体和介词短语的“where”问题;以“using”,“via”,“with”,“through”开头的形容词或短语用“how”疑问句,其余的名词短语用“what”疑问句。表2显示了每种类型的问题的示例。

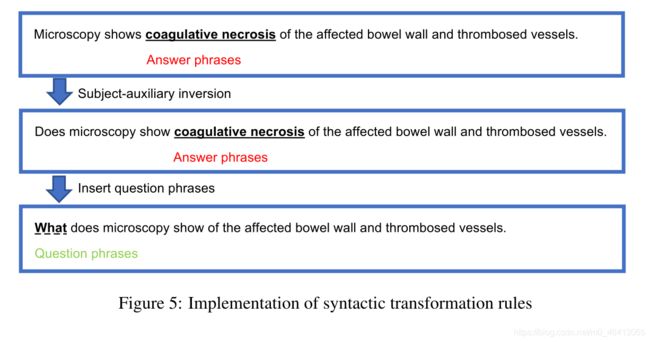

我们使用来自Stanford CoreNLP工具的Tregex[18],这是一种树型查询语言,包括各种基于直接支配性和直接优先级的基本关系的关系运算符,来实现将陈陈述句(标题)转换为问题的[19]规则。为了减少语法错误,我们避免对状语从句的句子产生疑问,如“肺慢性炎症,表现出所有三个典型的组织学特征”。问题传感器主要包括三个步骤。首先,我们根据动词的时态进行主要动词的分解。例如,我们将“显示”分解为“确实显示”。值得注意的是,对于“be+shown/presented/演示”结构的被动句,我们保留了它们原有的形式,而不是进行动词分解。第二,进行主辅倒装。在陈述句中我们把主语和助动词倒装成疑问句。倒置后,出现“是/否”的二元问题,如图5所示,“镜检显示患肠壁凝固性坏死和血栓形成血管”被倒置为“镜检显示患肠壁凝固性坏死和血栓形成血管吗?”为了生成答案为“否”的问题,我们随机从其他标题中选择一个词性相同的短语来替换原问题的头词。例如,我们将“凝固性坏死”一词用其他名词短语代替“显微镜检查是否显示受累肠壁和血栓形成血管的凝固性坏死”。第三,我们删除目标回答短语,插入前面获得的问题短语,生成属于“what”、“where”、“when”、“whose”、“how”和“how much/how many”类型的开放式问题,如表2所示。例如,我们将“显微镜下显示病变肠壁和血栓形成血管的凝固性坏死”转换为“显微镜下显示病变肠壁和血栓形成血管的情况”,如图5所示。

考虑到自动生成的问题可能包含语法和语义错误,我们执行后处理来修复这些问题。我们手工校对所有的问题,以纠正拼写错误、语法错误和语义不一致。问题和答案通过删除额外的空格和不相关的符号被进一步清理。太短或太模糊的问题被删除。出现在答案开头的文章被剥离。

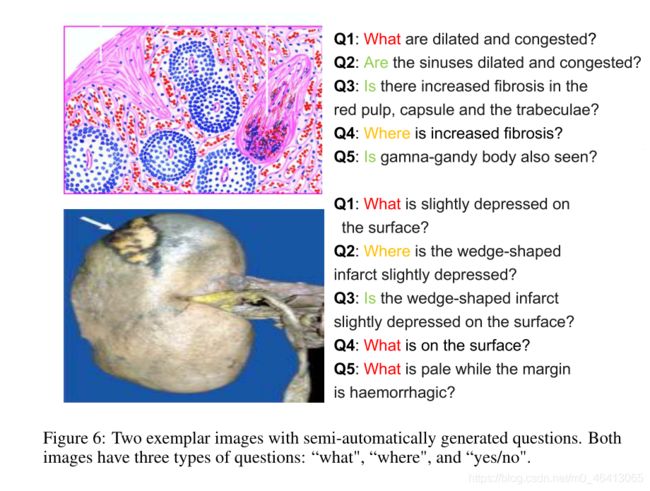

4 Dataset Statistics

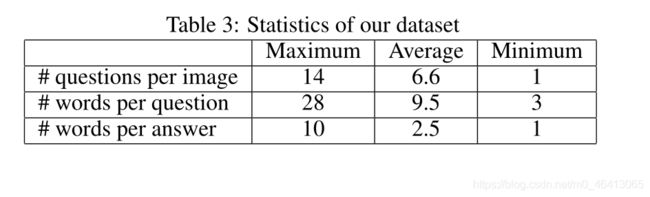

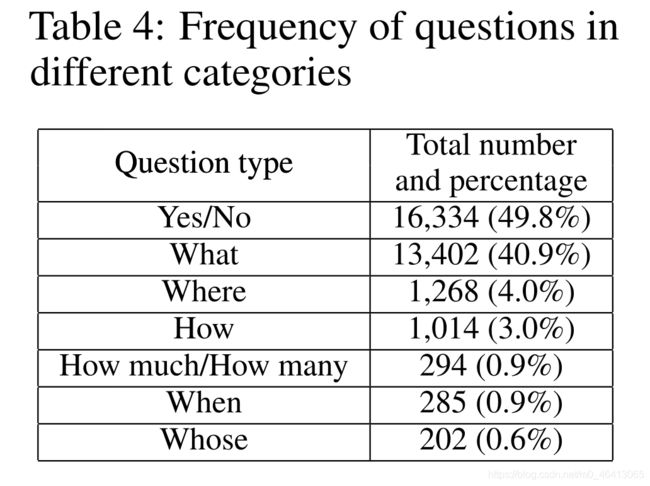

我们的PathVQA数据集由32,799个问答对组成,这些问答对来自两个病理学教科书:“病理学教科书”和“基础病理学”的1,670个病理学图像,以及从peir7数字图书馆收集的3,328个病理学图像。图6显示了一些示例。==平均来说,每张图片有6.6个问题。每张图片的最大问题数和最小问题数分别为14和1。每个问题和每个答案的平均字数分别是9.5和2.5。表3总结了这些统计数据。有7类问题:什么,哪里,何时,谁的,如何,多少/多少,是/否。表4显示了问题的数量和每个类别的百分比。前6类题为开放式题,共16465题,占题数的50.2%。其余的都是封闭式的“是/否”问题。“是”和“否”的回答数量相等,分别为8145和8189。==题目涵盖了视觉内容的各个方面,包括颜色、位置、外观、形状等。这种临床多样性对AI模型解决病理VQA问题提出了巨大挑战。

图7显示了开放式问题的不同答案的频率。x轴表示70个最常见的答案,y轴表示每个答案出现的频率。可以看出,答案的频率呈长尾分布,少数答案的频率很高,大部分答案的频率较低。大多数答案都有一两个词。

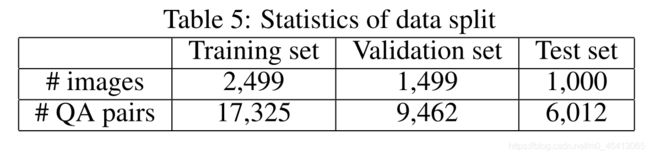

为了标准化这个数据集上的性能比较,我们创建了一个“正式”分割。我们以0.5、0.3和0.2的比率将图像和相关问题随机划分为训练集、验证集和测试集。统计结果汇总在表5中。

5 Benchmark VQA Performance

在本节中,我们将现有的完善的和最先进的VQA方法应用于我们的PathVQA数据集,以获得一些基准性能数字,供研究团体进行基准测试

5.1 Models

我们使用三种著名的VQA方法来生成基准测试结果。

•方法1:[20]中提出的方法使用门选递归单元(GRU)[21]递归网络和更快的R-CNN[22]网络来嵌入问题和图像。它使用双线性注意网络(BAN)学习双线性注意分布,并使用低秩近似技术来近似问题嵌入和图像嵌入之间的双线性相互作用。

•方法2:在[23]中,使用CNN对图像进行编码,使用LSTM[24]网络对问题和答案进行编码。提出了一种多模态压缩双线性池化机制来匹配图像编码和问题编码,并利用注意机制来推断答案。

•方法3:堆叠注意网络[25]分别使用CNN和LSTM嵌入图像和问题/答案,并利用堆叠注意机制定位与回答问题相关的图像区域。它多次查询图像,以逐步缩小区域,以参加。

5.2 Experimental Settings

给定问题和答案,我们执行标准的预处理,包括删除标点和停止词、标记化和转换为小写。对于问题编码和答案解码,我们创造了一个有2200个单词的词汇表,频率最高。数据增强应用于图像,包括移动、缩放和剪切。在方法1-3中,我们沿用了[20,23,25]的原始模型构型,==分别使用更快的R-CNN、ResNet-152[26]和VGGNet[27]进行视觉特征提取,更快的R-CNN在视觉基因组[28]上预先训练,后两个都在ImageNet[29]上预先训练。问题和答案中的单词使用在通用领域语料如维基百科、Twitter等上预先训练好的GloV e[30]向量来表示。==在方法1中,线性映射的dropout[31]率设为0.2,分类器的dropout[31]率设为0.5。初始学习率设置为0.005使用了Adamax优化器[32]。批量大小设置为512。在方法2中,将dropout应用于LSTM层,概率为0.4。在多模压缩双线性池中,我们将特征维数设为2048。优化器为Adam[32],初始学习率为0.0001,小批量大小为32。在方法3中,注意层数和LSTM层数都设置为2,LSTM的隐藏维数设置为512。权重参数的学习采用随机梯度下降(SGD),动量为0.9,学习率为0.1,小批量大小为100。与方法1和方法2相比,我们将方法3中的图像编码器分别换成更快的R-CNN和ResNet-152。我们将这两个基线模型分别称为Method 3 + Faster R-CNN和Method 3 + ResNet。

对于“是/否”的问题,我们使用准确性来评估。对于开放式问题,我们使用三个指标进行评估:(1)精确匹配[2],它衡量的是推断出的答案与ground-truth完全匹配的百分比;(2)宏观平均F1[33],衡量预测答案与ground-truth之间的平均重叠,将答案视为一袋代币;(3) BLEU[34],通过n-gram匹配来度量预测答案与ground-truth的相似度。

5.3 Results

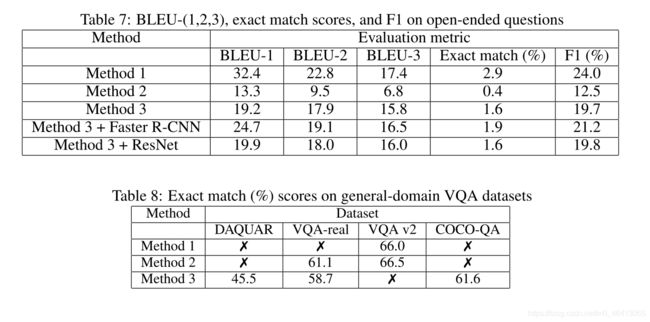

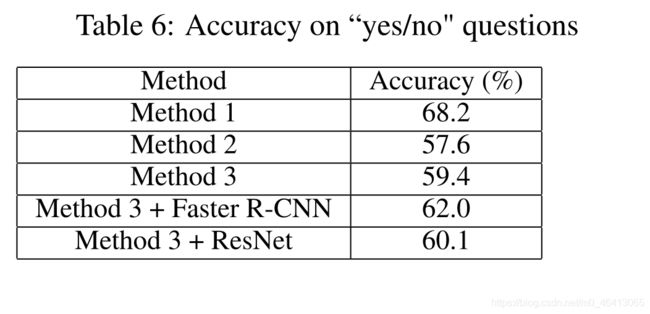

表6显示了不同方法对“是/否”问题的准确率。所有方法都比随机猜测(准确率为50%)更好。这表明该数据集具有临床意义,使得VQA模型具有可学习性。在方法1-3中,方法1表现最好。==一个主要原因是它使用自底向上的机制来提出候选图像区域和提取区域特定的视觉特征。==通常,答案只与整个病理图像的一小部分有关。方法1有效地定位图像区域最有助于推断正确的答案。这可以通过比较方法3 + Faster R-CNN和方法3来进一步验证,前者的性能优于后者。方法3 +更快的R-CNN提取特定区域的特征,方法3提取整个图像的整体特征。此外,注意残差学习的使用以及双线性注意优于其他共同注意方法也使得方法1的准确率最高。另一个观察结果是方法3优于方法2。这是因为方法3利用多层注意力来逐步学习要注意的地方,因此比使用单层注意力的方法2取得更好的成绩。方法3 + ResNet的效果优于方法3,原因是ResNet提取的视觉特征比VGGNet更好。

表7显示了精确的匹配分数,F1和BLEU-(1,2,3)分数,开放式问题属于以下类别:什么,在哪里,如何,谁,和何时。可以看出,这些分数总体上比较低,这说明我们的数据集对于医学VQA来说是非常具有挑战性的。作为参考,我们在表8中总结了这些基线方法在一般域VQA数据集上的精确匹配得分。可以看出,这些数字要高得多。我们的数据集如此具有挑战性的原因在于以下事实。首先,我们数据集中的大多数问题都是开放式的,其中可能答案的数量是O(VL),其中V是词汇量大小,L是答案的预期长度。这很容易导致词汇量外的问题,即测试示例中的单词可能永远不会出现在训练示例中。其次,与一般的域VQA数据集相比,我们的数据集的大小要小得多。VQA模型需要更多的创新来弥补性能上的差距。开放式问题的精确匹配分数远低于“是/否”问题的准确分数。这并不奇怪,因为回答开放式问题的考生数量很大,而回答“是/否”的只有2个。与表7得出的结论相似,基于双线性注意的方法1表现最好。方法3比方法2更有效,它利用了大量的注意力机制。

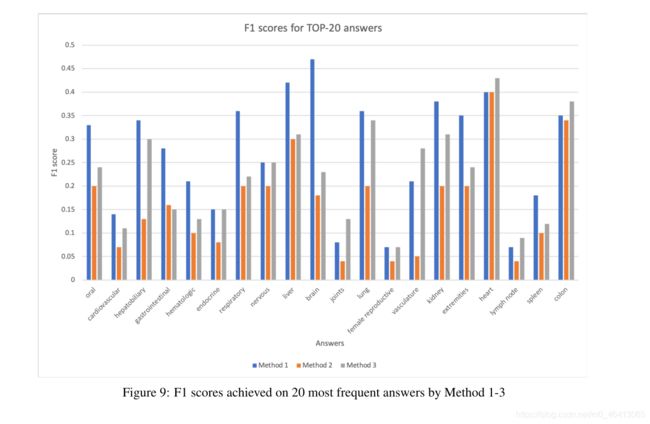

图9显示了采用方法1-3的20个最常见答案的F1得分。可以看出,方法1在大多数答案上优于方法2和3。这与表6和表7的结果一致

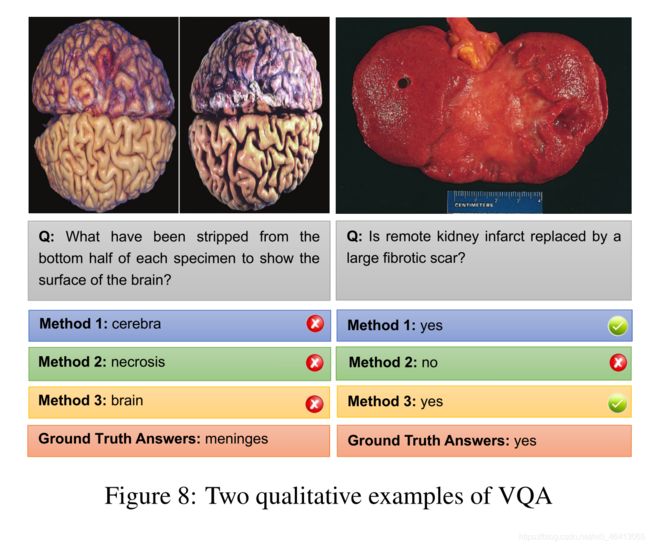

我们在图8中展示了两个通过方法1-3获得的VQA结果的定性示例。在左边的例子中,所有的方法都不能给出正确的答案,因为这个答案并不常见。但这三个答案在语义上与图像非常相关,表明模型可以学习到有意义的东西。在正确的例子中,方法1和方法3都正确地预测了答案,而方法2则失败了。这表明这两种方法相对于方法2有一定的优势,因为它们有效的注意机制使它们能够更好地识别感兴趣的图像区域,有助于给出正确的答案。

Suggestions for model improvement

==基线方法中使用的视觉特征提取器是在与病理图像有域差异的一般域图像上进行预先训练的。==一种改进的方法是,从教科书、网站等收集与我们数据集中的图像领域更接近的公开医学图像(最好是病理图像),然后使用这些医学图像对cnn进行预训练。同样,在一般领域语料库上预先训练的词嵌入可能不能有效地捕捉与病理学相关的语义。为了提高词汇嵌入能力,我们可以在医学教科书、临床指南、医学出版物等医学文献上进行预先训练。

6 Conclusion and Future Works

本文对开发人工智能系统的目标通过board-certificated美国董事会病理学检查和培养研究在医学视觉问答,我们建立一个病理学酒瓶数据集,其中包含32799个问答对7的类别,从4998年生成的图像。我们数据集中的大部分问题都是开放式的,这给医学VQA研究带来了巨大的挑战。我们的数据集是公开的。

对于未来的研究,有几个方面需要改进。首先,我们数据集中的问题还没有完全与ABP测试中的问题一致。在ABP测试问题中,每个图像都与描述病人的病史和人口统计资料的简短文本相关联。这些信息在确定答案时很有用。为了弥补这一差距,我们计划从MedPix数据集创建医疗VQA数据集,其中每个图像都与描述病史和患者人口统计信息的标题和文本相关联。其次,在我们现有的方法中,从字幕中生成的问题/答案对大多基于语言规则,这些规则可能不够多样化或健壮。我们计划开发深度生成模型,学习如何从字幕生成QA对。第三,我们计划应用我们的自动化流水线为其他类型的医学图像创建VQA数据集,如放射学、超声、CT扫描等。除了病理学委员会,其他医学影像领域也有自己的委员会,组织不同类型的委员会认证的考试。构建通过这些考试的AI系统也很有趣。