Spark基础解析

一、Spark概述

1.什么是Spark

1.1 定义

- Spark是一种基于内存的快速、通用、可扩展的大数据分析引擎

1.2 历史

- 2009年诞生于加州大学伯克利分校AMPLab,项目由Scala编写

- 2010年开源

- 2013年6月成为Apache的孵化项目

- 2014年2月成为Apache的顶级项目

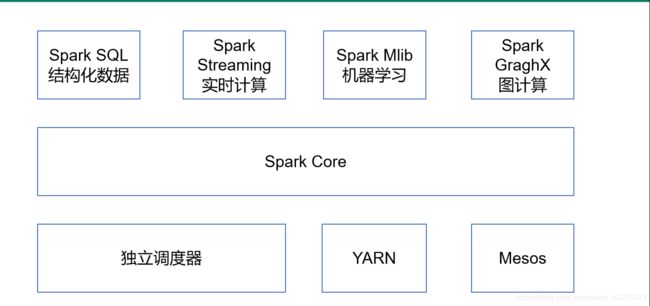

2.Spark的内置模块

Spark Core:实现了Spark的基本功能,包含任务调度、内存管理、错误恢复、与存储系统交互等模块。Spark Core中还包含了 对弹性分布式数据集(Resilient Distributed DataSet,简称RDD)的API定义。

Spark SQL:是Spark用来操作结构化数据的程序包。通过Spark SQL,我们可以使用 SQL或者Apache Hive版本的SQL方言(HQL)来查询数据。Spark SQL支持多种数据源,比如Hive表、Parquet以及JSON等。

Spark Streaming:是Spark提供的对实时数据进行流式计算的组件。提供了用来操作数据流的API,并且与Spark Core中的RDDAPI高度对应。

Spark MLlib:提供常见的机器学习(ML)功能的程序库。包括分类、回归、聚类、协同过滤等,还提供了模型评估、数据导入等额外的支持功能。

集群管理器:Spark 设计为可以高效地在一个计算节点到数千个计算节点之间伸缩计 算。为了实现这样的要求,同时获得最大灵活性,Spark支持在各种集群管理器(Cluster Manager)上运行,包括Hadoop YARN、Apache Mesos,以及Spark自带的一个简易调度器,叫作独立调度器。

Spark得到了众多大数据公司的支持,这些公司包括Hortonworks、IBM、Intel、Cloudera、MapR、Pivotal、百度、阿里、腾讯、京东、携程、优酷土豆。当前百度的Spark已应用于大搜索、直达号、百度大数据等业务;阿里利用GraphX构建了大规模的图计算和图挖掘系统,实现了很多生产系统的推荐算法;腾讯Spark集群达到8000台的规模,是当前已知的世界上最大的Spark集群。

3. Spark的特点

快:与Hadoop的MapReduce相比,Spark基于内存的运算速度快100倍以上,基于硬盘的运算也要快10倍以上,Spark实现了高效的DAG执行引擎,可以通过基于内存来高效处理数据流,计算的中间结果是存在于内存中的。

易用:Spark支持Java、Python和Scala的API,还支持超过80种高级算法,使用户可以快速构建不同的应用。而且Spark支持交互式的Python和Scala的Shell,可以非常方便地在这些Shell中使用Spark集群来验证解决问题的方法。

通用:Spark提供了统一的解决方案。Spark可以用于批处理、交互式查询(Spark SQL)、实时流处理(Spark Streaming)、机器学习(Spark MLlib)和图计算(GraphX)。这些不同类型的处理都可以在同一个应用中无缝使用。减少了开发和维护的人力成本和部署平台的物力成本。

兼容性:Spark可以非常方便地与其他的开源产品进行融合。比如,Spark可以使用Hadoop的YARN和Apache Mesos作为它的资 源管理和调度器,并且可以处理所有Hadoop支持的数据,包括HDFS、HBase等。这对于已经部署Hadoop集群的用户特别重要,因为不需要做任何数据迁移就可以使用Spark的强大处理能力。

二、Spark的运行模式

1.下载

- 官网地址:http://spark.apache.org/

- 文档查看地址:https://spark.apache.org/docs/2.1.1/

- 下载地址:https://spark.apache.org/downloads.html

2.安装

- 将下载的压缩包上传到虚拟机中

- 压缩包解压 tar -xvzf xxxxx -C xxxx

3.Local模式

介绍

- Local模式就是运行在一台计算机上的模式,通常就是用于在本机上练手和测试。它可以通过以下集中方式设置Master。

- Local: 所有计算都运行在一个线程当中,没有任何并行计算,通常我们在本机执行一些测试代码,或者练手,就用这种模式;

- Local[K]: 指定使用几个线程来运行计算,比如local[4]就是运行4个Worker线程。通常我们的Cpu有几个Core,就指定几个线程,最大 化利用Cpu的计算能力;

- Local[*]: 这种模式直接帮你按照Cpu最多Cores来设置线程数了。

4.Standalone模式

4.1介绍

构建一个由Master+Slave构成的Spark集群,Spark运行在集群中。

4.2配置

4.2.1修改slaves

vi slaves

hadoop102

hadoop103

hadoop1044.2.2修改spark-env.sh

vi spark-env.sh

SPARK_MASTER_HOST=hdp-1

SPARK_MASTER_PORT=70774.2.3 分发spark包

scp -r xxxxxxxxxxxxxx hadp-2:$PWD

scp -r xxxxxxxxxxxxxx hadp-3:$PWD

scp -r xxxxxxxxxxxxxx hadp-4:$PWD4.2.4启动

sbin/start-all.sh注意:如果遇到 “JAVA_HOME not set” 异常,可以在sbin目录下的spark-config.sh 文件中加入如下配置:

export JAVA_HOME=XXXX4.2.5启动spark-shell

bin/spark-shell \

--master spark://hdp-1:7077 \

--executor-memory 1g \

--total-executor-cores 2--master 连接集群的master

--executor-memory 运行内存大小

--total-executoe-cores 运行核数

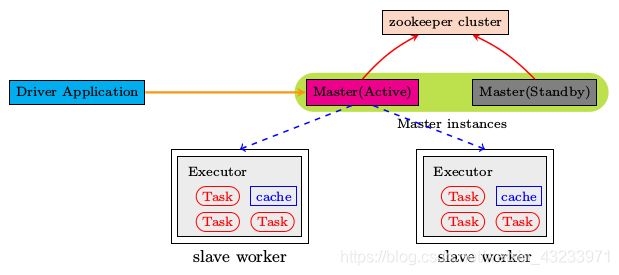

4.3HA配置

zookeeper正常安装并启动

修改spark-env.sh文件添加如下配置:

vi spark-env.sh

注释掉如下内容:

#SPARK_MASTER_HOST=hdp-1

#SPARK_MASTER_PORT=7077

添加上如下内容:

export SPARK_DAEMON_JAVA_OPTS="

-Dspark.deploy.recoveryMode=ZOOKEEPER

-Dspark.deploy.zookeeper.url=hdp-1,hdp-2,hdp-3

-Dspark.deploy.zookeeper.dir=/spark"分发配置文件,master节点全部启动,其他的节点单独启动master

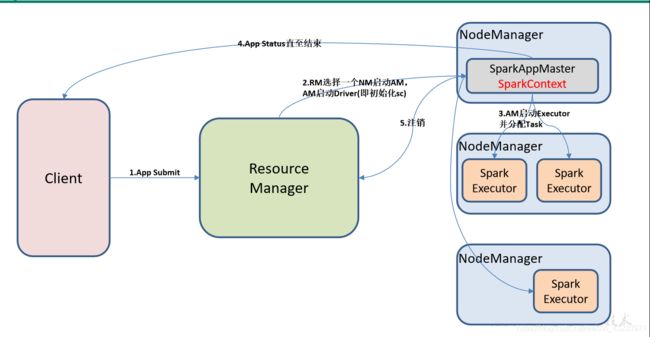

5.Yarn模式

- Spark客户端直接连接Yarn,不需要额外构建Spark集群。有yarn-client和yarn-cluster两种模式,主要区别在于:Driver程序的运行节点。

- yarn-client:Driver程序运行在客户端,适用于交互、调试,希望立即看到app的输出

- yarn-cluster:Driver程序运行在由RM(ResourceManager)启动的AP(APPMaster)适用于生产环境。

5.1 修改hadoop配置文件yarn-site.xml,添加如下内容:

vi yarn-site.xml

yarn.nodemanager.pmem-check-enabled

false

yarn.nodemanager.vmem-check-enabled

false

5.2修改spark-env.sh,添加如下配置:

vi spark-env.sh

YARN_CONF_DIR=xxxxxxxxxxx/etc/hadoop5.3分发配置文件

scp spark-env.sh hdp-2:$PWD

scp spark-env.sh hdp-3:$PWD

scp spark-env.sh hdp-4:$PWD6.Mesos模式

Spark客户端直接连接Mesos;不需要额外构建Spark集群。国内应用比较少,更多的是运用yarn调度。