- Long类型前后端数据不一致

igotyback

前端

响应给前端的数据浏览器控制台中response中看到的Long类型的数据是正常的到前端数据不一致前后端数据类型不匹配是一个常见问题,尤其是当后端使用Java的Long类型(64位)与前端JavaScript的Number类型(最大安全整数为2^53-1,即16位)进行数据交互时,很容易出现精度丢失的问题。这是因为JavaScript中的Number类型无法安全地表示超过16位的整数。为了解决这个问

- LocalDateTime 转 String

igotyback

java开发语言

importjava.time.LocalDateTime;importjava.time.format.DateTimeFormatter;publicclassMain{publicstaticvoidmain(String[]args){//获取当前时间LocalDateTimenow=LocalDateTime.now();//定义日期格式化器DateTimeFormatterformat

- Linux下QT开发的动态库界面弹出操作(SDL2)

13jjyao

QT类qt开发语言sdl2linux

需求:操作系统为linux,开发框架为qt,做成需带界面的qt动态库,调用方为java等非qt程序难点:调用方为java等非qt程序,也就是说调用方肯定不带QApplication::exec(),缺少了这个,QTimer等事件和QT创建的窗口将不能弹出(包括opencv也是不能弹出);这与qt调用本身qt库是有本质的区别的思路:1.调用方缺QApplication::exec(),那么我们在接口

- DIV+CSS+JavaScript技术制作网页(旅游主题网页设计与制作)云南大理

STU学生网页设计

网页设计期末网页作业html静态网页html5期末大作业网页设计web大作业

️精彩专栏推荐作者主页:【进入主页—获取更多源码】web前端期末大作业:【HTML5网页期末作业(1000套)】程序员有趣的告白方式:【HTML七夕情人节表白网页制作(110套)】文章目录二、网站介绍三、网站效果▶️1.视频演示2.图片演示四、网站代码HTML结构代码CSS样式代码五、更多源码二、网站介绍网站布局方面:计划采用目前主流的、能兼容各大主流浏览器、显示效果稳定的浮动网页布局结构。网站程

- 【华为OD机试真题2023B卷 JAVA&JS】We Are A Team

若博豆

java算法华为javascript

华为OD2023(B卷)机试题库全覆盖,刷题指南点这里WeAreATeam时间限制:1秒|内存限制:32768K|语言限制:不限题目描述:总共有n个人在机房,每个人有一个标号(1<=标号<=n),他们分成了多个团队,需要你根据收到的m条消息判定指定的两个人是否在一个团队中,具体的:1、消息构成为:abc,整数a、b分别代

- 关于城市旅游的HTML网页设计——(旅游风景云南 5页)HTML+CSS+JavaScript

二挡起步

web前端期末大作业javascripthtmlcss旅游风景

⛵源码获取文末联系✈Web前端开发技术描述网页设计题材,DIV+CSS布局制作,HTML+CSS网页设计期末课程大作业|游景点介绍|旅游风景区|家乡介绍|等网站的设计与制作|HTML期末大学生网页设计作业,Web大学生网页HTML:结构CSS:样式在操作方面上运用了html5和css3,采用了div+css结构、表单、超链接、浮动、绝对定位、相对定位、字体样式、引用视频等基础知识JavaScrip

- HTML网页设计制作大作业(div+css) 云南我的家乡旅游景点 带文字滚动

二挡起步

web前端期末大作业web设计网页规划与设计htmlcssjavascriptdreamweaver前端

Web前端开发技术描述网页设计题材,DIV+CSS布局制作,HTML+CSS网页设计期末课程大作业游景点介绍|旅游风景区|家乡介绍|等网站的设计与制作HTML期末大学生网页设计作业HTML:结构CSS:样式在操作方面上运用了html5和css3,采用了div+css结构、表单、超链接、浮动、绝对定位、相对定位、字体样式、引用视频等基础知识JavaScript:做与用户的交互行为文章目录前端学习路线

- node.js学习

小猿L

node.jsnode.js学习vim

node.js学习实操及笔记温故node.js,node.js学习实操过程及笔记~node.js学习视频node.js官网node.js中文网实操笔记githubcsdn笔记为什么学node.js可以让别人访问我们编写的网页为后续的框架学习打下基础,三大框架vuereactangular离不开node.jsnode.js是什么官网:node.js是一个开源的、跨平台的运行JavaScript的运行

- Java 重写(Override)与重载(Overload)

叨唧唧的

Java重写(Override)与重载(Overload)重写(Override)重写是子类对父类的允许访问的方法的实现过程进行重新编写,返回值和形参都不能改变。即外壳不变,核心重写!重写的好处在于子类可以根据需要,定义特定于自己的行为。也就是说子类能够根据需要实现父类的方法。重写方法不能抛出新的检查异常或者比被重写方法申明更加宽泛的异常。例如:父类的一个方法申明了一个检查异常IOExceptio

- 简单了解 JVM

记得开心一点啊

jvm

目录♫什么是JVM♫JVM的运行流程♫JVM运行时数据区♪虚拟机栈♪本地方法栈♪堆♪程序计数器♪方法区/元数据区♫类加载的过程♫双亲委派模型♫垃圾回收机制♫什么是JVMJVM是JavaVirtualMachine的简称,意为Java虚拟机。虚拟机是指通过软件模拟的具有完整硬件功能的、运行在一个完全隔离的环境中的完整计算机系统(如:JVM、VMwave、VirtualBox)。JVM和其他两个虚拟机

- 1分钟解决 -bash: mvn: command not found,在Centos 7中安装Maven

Energet!c

开发语言

1分钟解决-bash:mvn:commandnotfound,在Centos7中安装Maven检查Java环境1下载Maven2解压Maven3配置环境变量4验证安装5常见问题与注意事项6总结检查Java环境Maven依赖Java环境,请确保系统已经安装了Java并配置了环境变量。可以通过以下命令检查:java-version如果未安装,请先安装Java。1下载Maven从官网下载:前往Apach

- Java企业面试题3

马龙强_

java

1.break和continue的作用(智*图)break:用于完全退出一个循环(如for,while)或一个switch语句。当在循环体内遇到break语句时,程序会立即跳出当前循环体,继续执行循环之后的代码。continue:用于跳过当前循环体中剩余的部分,并开始下一次循环。如果是在for循环中使用continue,则会直接进行条件判断以决定是否执行下一轮循环。2.if分支语句和switch分

- JVM、JRE和 JDK:理解Java开发的三大核心组件

Y雨何时停T

Javajava

Java是一门跨平台的编程语言,它的成功离不开背后强大的运行环境与开发工具的支持。在Java的生态中,JVM(Java虚拟机)、JRE(Java运行时环境)和JDK(Java开发工具包)是三个至关重要的核心组件。本文将探讨JVM、JDK和JRE的区别,帮助你更好地理解Java的运行机制。1.JVM:Java虚拟机(JavaVirtualMachine)什么是JVM?JVM,即Java虚拟机,是Ja

- Java面试题精选:消息队列(二)

芒果不是芒

Java面试题精选javakafka

一、Kafka的特性1.消息持久化:消息存储在磁盘,所以消息不会丢失2.高吞吐量:可以轻松实现单机百万级别的并发3.扩展性:扩展性强,还是动态扩展4.多客户端支持:支持多种语言(Java、C、C++、GO、)5.KafkaStreams(一个天生的流处理):在双十一或者销售大屏就会用到这种流处理。使用KafkaStreams可以快速的把销售额统计出来6.安全机制:Kafka进行生产或者消费的时候会

- 白骑士的Java教学基础篇 2.5 控制流语句

白骑士所长

Java教学java开发语言

欢迎继续学习Java编程的基础篇!在前面的章节中,我们了解了Java的变量、数据类型和运算符。接下来,我们将探讨Java中的控制流语句。控制流语句用于控制程序的执行顺序,使我们能够根据特定条件执行不同的代码块,或重复执行某段代码。这是编写复杂程序的基础。通过学习这一节内容,你将掌握如何使用条件语句和循环语句来编写更加灵活和高效的代码。条件语句条件语句用于根据条件的真假来执行不同的代码块。if语句‘

- python语法——三目运算符

HappyRocking

pythonpython三目运算符

在java中,有三目运算符,如:intc=(a>b)?a:b表示c取两者中的较大值。但是在python,不能直接这样使用,估计是因为冒号在python有分行的关键作用。那么在python中,如何实现类似功能呢?可以使用ifelse语句,也是一行可以完成,格式为:aifbelsec表示如果b为True,则表达式等于a,否则等于c。如:c=(aif(a>b)elseb)同样是完成了取最大值的功能。

- ArrayList 源码解析

程序猿进阶

Java基础ArrayListListjava面试性能优化架构设计idea

ArrayList是Java集合框架中的一个动态数组实现,提供了可变大小的数组功能。它继承自AbstractList并实现了List接口,是顺序容器,即元素存放的数据与放进去的顺序相同,允许放入null元素,底层通过数组实现。除该类未实现同步外,其余跟Vector大致相同。每个ArrayList都有一个容量capacity,表示底层数组的实际大小,容器内存储元素的个数不能多于当前容量。当向容器中添

- Java爬虫框架(一)--架构设计

狼图腾-狼之传说

java框架java任务html解析器存储电子商务

一、架构图那里搜网络爬虫框架主要针对电子商务网站进行数据爬取,分析,存储,索引。爬虫:爬虫负责爬取,解析,处理电子商务网站的网页的内容数据库:存储商品信息索引:商品的全文搜索索引Task队列:需要爬取的网页列表Visited表:已经爬取过的网页列表爬虫监控平台:web平台可以启动,停止爬虫,管理爬虫,task队列,visited表。二、爬虫1.流程1)Scheduler启动爬虫器,TaskMast

- Java:爬虫框架

dingcho

Javajava爬虫

一、ApacheNutch2【参考地址】Nutch是一个开源Java实现的搜索引擎。它提供了我们运行自己的搜索引擎所需的全部工具。包括全文搜索和Web爬虫。Nutch致力于让每个人能很容易,同时花费很少就可以配置世界一流的Web搜索引擎.为了完成这一宏伟的目标,Nutch必须能够做到:每个月取几十亿网页为这些网页维护一个索引对索引文件进行每秒上千次的搜索提供高质量的搜索结果简单来说Nutch支持分

- python怎么将png转为tif_png转tif

weixin_39977276

发国外的文章要求图片是tif,cmyk色彩空间的。大小尺寸还有要求。比如网上大神多,找到了一段代码,感谢!https://www.jianshu.com/p/ec2af4311f56https://github.com/KevinZc007/image2Tifimportjava.awt.image.BufferedImage;importjava.io.File;importjava.io.Fi

- JavaScript 中,深拷贝(Deep Copy)和浅拷贝(Shallow Copy)

跳房子的前端

前端面试javascript开发语言ecmascript

在JavaScript中,深拷贝(DeepCopy)和浅拷贝(ShallowCopy)是用于复制对象或数组的两种不同方法。了解它们的区别和应用场景对于避免潜在的bugs和高效地处理数据非常重要。以下是对深拷贝和浅拷贝的详细解释,包括它们的概念、用途、优缺点以及实现方式。1.浅拷贝(ShallowCopy)概念定义:浅拷贝是指创建一个新的对象或数组,其中包含了原对象或数组的基本数据类型的值和对引用数

- JAVA·一个简单的登录窗口

MortalTom

java开发语言学习

文章目录概要整体架构流程技术名词解释技术细节资源概要JavaSwing是Java基础类库的一部分,主要用于开发图形用户界面(GUI)程序整体架构流程新建项目,导入sql.jar包(链接放在了文末),编译项目并运行技术名词解释一、特点丰富的组件提供了多种可视化组件,如按钮(JButton)、文本框(JTextField)、标签(JLabel)、下拉列表(JComboBox)等,可以满足不同的界面设计

- WebMagic:强大的Java爬虫框架解析与实战

Aaron_945

Javajava爬虫开发语言

文章目录引言官网链接WebMagic原理概述基础使用1.添加依赖2.编写PageProcessor高级使用1.自定义Pipeline2.分布式抓取优点结论引言在大数据时代,网络爬虫作为数据收集的重要工具,扮演着不可或缺的角色。Java作为一门广泛使用的编程语言,在爬虫开发领域也有其独特的优势。WebMagic是一个开源的Java爬虫框架,它提供了简单灵活的API,支持多线程、分布式抓取,以及丰富的

- 博客网站制作教程

2401_85194651

javamaven

首先就是技术框架:后端:Java+SpringBoot数据库:MySQL前端:Vue.js数据库连接:JPA(JavaPersistenceAPI)1.项目结构blog-app/├──backend/│├──src/main/java/com/example/blogapp/││├──BlogApplication.java││├──config/│││└──DatabaseConfig.java

- 00. 这里整理了最全的爬虫框架(Java + Python)

有一只柴犬

爬虫系列爬虫javapython

目录1、前言2、什么是网络爬虫3、常见的爬虫框架3.1、java框架3.1.1、WebMagic3.1.2、Jsoup3.1.3、HttpClient3.1.4、Crawler4j3.1.5、HtmlUnit3.1.6、Selenium3.2、Python框架3.2.1、Scrapy3.2.2、BeautifulSoup+Requests3.2.3、Selenium3.2.4、PyQuery3.2

- JAVA学习笔记之23种设计模式学习

victorfreedom

Java技术设计模式androidjava常用设计模式

博主最近买了《设计模式》这本书来学习,无奈这本书是以C++语言为基础进行说明,整个学习流程下来效率不是很高,虽然有的设计模式通俗易懂,但感觉还是没有充分的掌握了所有的设计模式。于是博主百度了一番,发现有大神写过了这方面的问题,于是博主迅速拿来学习。一、设计模式的分类总体来说设计模式分为三大类:创建型模式,共五种:工厂方法模式、抽象工厂模式、单例模式、建造者模式、原型模式。结构型模式,共七种:适配器

- JavaScript `Map` 和 `WeakMap`详细解释

跳房子的前端

JavaScript原生方法javascript前端开发语言

在JavaScript中,Map和WeakMap都是用于存储键值对的数据结构,但它们有一些关键的不同之处。MapMap是一种可以存储任意类型的键值对的集合。它保持了键值对的插入顺序,并且可以通过键快速查找对应的值。Map提供了一些非常有用的方法和属性来操作这些数据对:set(key,value):将一个键值对添加到Map中。如果键已经存在,则更新其对应的值。get(key):获取指定键的值。如果键

- 切换淘宝最新npm镜像源是

hai40587

npm前端node.js

切换淘宝最新npm镜像源是一个相对简单的过程,但首先需要明确当前淘宝npm镜像源的状态和最新的镜像地址。由于网络环境和服务更新,镜像源的具体地址可能会发生变化,因此,我将基于当前可获取的信息,提供一个通用的切换步骤,并附上最新的镜像地址(截至回答时)。一、了解npm镜像源npm(NodePackageManager)是JavaScript的包管理器,用于安装、更新和管理项目依赖。由于npm官方仓库

- 【Java】已解决:java.util.concurrent.CompletionException

屿小夏

java开发语言

文章目录一、分析问题背景出现问题的场景代码片段二、可能出错的原因三、错误代码示例四、正确代码示例五、注意事项已解决:java.util.concurrent.CompletionException一、分析问题背景在Java并发编程中,java.util.concurrent.CompletionException是一种常见的运行时异常,通常在使用CompletableFuture进行异步计算时出现

- 设计模式之建造者模式(通俗易懂--代码辅助理解【Java版】)

ok!ko

设计模式设计模式建造者模式java

文章目录设计模式概述1、建造者模式2、建造者模式使用场景3、优点4、缺点5、主要角色6、代码示例:1)实现要求2)UML图3)实现步骤:1)创建一个表示食物条目和食物包装的接口2)创建实现Packing接口的实体类3)创建实现Item接口的抽象类,该类提供了默认的功能4)创建扩展了Burger和ColdDrink的实体类5)创建一个Meal类,带有上面定义的Item对象6)创建一个MealBuil

- HQL之投影查询

归来朝歌

HQLHibernate查询语句投影查询

在HQL查询中,常常面临这样一个场景,对于多表查询,是要将一个表的对象查出来还是要只需要每个表中的几个字段,最后放在一起显示?

针对上面的场景,如果需要将一个对象查出来:

HQL语句写“from 对象”即可

Session session = HibernateUtil.openSession();

- Spring整合redis

bylijinnan

redis

pom.xml

<dependencies>

<!-- Spring Data - Redis Library -->

<dependency>

<groupId>org.springframework.data</groupId>

<artifactId>spring-data-redi

- org.hibernate.NonUniqueResultException: query did not return a unique result: 2

0624chenhong

Hibernate

参考:http://blog.csdn.net/qingfeilee/article/details/7052736

org.hibernate.NonUniqueResultException: query did not return a unique result: 2

在项目中出现了org.hiber

- android动画效果

不懂事的小屁孩

android动画

前几天弄alertdialog和popupwindow的时候,用到了android的动画效果,今天专门研究了一下关于android的动画效果,列出来,方便以后使用。

Android 平台提供了两类动画。 一类是Tween动画,就是对场景里的对象不断的进行图像变化来产生动画效果(旋转、平移、放缩和渐变)。

第二类就是 Frame动画,即顺序的播放事先做好的图像,与gif图片原理类似。

- js delete 删除机理以及它的内存泄露问题的解决方案

换个号韩国红果果

JavaScript

delete删除属性时只是解除了属性与对象的绑定,故当属性值为一个对象时,删除时会造成内存泄露 (其实还未删除)

举例:

var person={name:{firstname:'bob'}}

var p=person.name

delete person.name

p.firstname -->'bob'

// 依然可以访问p.firstname,存在内存泄露

- Oracle将零干预分析加入网络即服务计划

蓝儿唯美

oracle

由Oracle通信技术部门主导的演示项目并没有在本月较早前法国南斯举行的行业集团TM论坛大会中获得嘉奖。但是,Oracle通信官员解雇致力于打造一个支持零干预分配和编制功能的网络即服务(NaaS)平台,帮助企业以更灵活和更适合云的方式实现通信服务提供商(CSP)的连接产品。这个Oracle主导的项目属于TM Forum Live!活动上展示的Catalyst计划的19个项目之一。Catalyst计

- spring学习——springmvc(二)

a-john

springMVC

Spring MVC提供了非常方便的文件上传功能。

1,配置Spring支持文件上传:

DispatcherServlet本身并不知道如何处理multipart的表单数据,需要一个multipart解析器把POST请求的multipart数据中抽取出来,这样DispatcherServlet就能将其传递给我们的控制器了。为了在Spring中注册multipart解析器,需要声明一个实现了Mul

- POJ-2828-Buy Tickets

aijuans

ACM_POJ

POJ-2828-Buy Tickets

http://poj.org/problem?id=2828

线段树,逆序插入

#include<iostream>#include<cstdio>#include<cstring>#include<cstdlib>using namespace std;#define N 200010struct

- Java Ant build.xml详解

asia007

build.xml

1,什么是antant是构建工具2,什么是构建概念到处可查到,形象来说,你要把代码从某个地方拿来,编译,再拷贝到某个地方去等等操作,当然不仅与此,但是主要用来干这个3,ant的好处跨平台 --因为ant是使用java实现的,所以它跨平台使用简单--与ant的兄弟make比起来语法清晰--同样是和make相比功能强大--ant能做的事情很多,可能你用了很久,你仍然不知道它能有

- android按钮监听器的四种技术

百合不是茶

androidxml配置监听器实现接口

android开发中经常会用到各种各样的监听器,android监听器的写法与java又有不同的地方;

1,activity中使用内部类实现接口 ,创建内部类实例 使用add方法 与java类似

创建监听器的实例

myLis lis = new myLis();

使用add方法给按钮添加监听器

- 软件架构师不等同于资深程序员

bijian1013

程序员架构师架构设计

本文的作者Armel Nene是ETAPIX Global公司的首席架构师,他居住在伦敦,他参与过的开源项目包括 Apache Lucene,,Apache Nutch, Liferay 和 Pentaho等。

如今很多的公司

- TeamForge Wiki Syntax & CollabNet User Information Center

sunjing

TeamForgeHow doAttachementAnchorWiki Syntax

the CollabNet user information center http://help.collab.net/

How do I create a new Wiki page?

A CollabNet TeamForge project can have any number of Wiki pages. All Wiki pages are linked, and

- 【Redis四】Redis数据类型

bit1129

redis

概述

Redis是一个高性能的数据结构服务器,称之为数据结构服务器的原因是,它提供了丰富的数据类型以满足不同的应用场景,本文对Redis的数据类型以及对这些类型可能的操作进行总结。

Redis常用的数据类型包括string、set、list、hash以及sorted set.Redis本身是K/V系统,这里的数据类型指的是value的类型,而不是key的类型,key的类型只有一种即string

- SSH2整合-附源码

白糖_

eclipsespringtomcatHibernateGoogle

今天用eclipse终于整合出了struts2+hibernate+spring框架。

我创建的是tomcat项目,需要有tomcat插件。导入项目以后,鼠标右键选择属性,然后再找到“tomcat”项,勾选一下“Is a tomcat project”即可。具体方法见源码里的jsp图片,sql也在源码里。

补充1:项目中部分jar包不是最新版的,可能导

- [转]开源项目代码的学习方法

braveCS

学习方法

转自:

http://blog.sina.com.cn/s/blog_693458530100lk5m.html

http://www.cnblogs.com/west-link/archive/2011/06/07/2074466.html

1)阅读features。以此来搞清楚该项目有哪些特性2)思考。想想如果自己来做有这些features的项目该如何构架3)下载并安装d

- 编程之美-子数组的最大和(二维)

bylijinnan

编程之美

package beautyOfCoding;

import java.util.Arrays;

import java.util.Random;

public class MaxSubArraySum2 {

/**

* 编程之美 子数组之和的最大值(二维)

*/

private static final int ROW = 5;

private stat

- 读书笔记-3

chengxuyuancsdn

jquery笔记resultMap配置ibatis一对多配置

1、resultMap配置

2、ibatis一对多配置

3、jquery笔记

1、resultMap配置

当<select resultMap="topic_data">

<resultMap id="topic_data">必须一一对应。

(1)<resultMap class="tblTopic&q

- [物理与天文]物理学新进展

comsci

如果我们必须获得某种地球上没有的矿石,才能够进行某些能量输出装置的设计和建造,而要获得这种矿石,又必须首先进行深空探测,而要进行深空探测,又必须获得这种能量输出装置,这个矛盾的循环,会导致地球联盟在与宇宙文明建立关系的时候,陷入困境

怎么办呢?

- Oracle 11g新特性:Automatic Diagnostic Repository

daizj

oracleADR

Oracle Database 11g的FDI(Fault Diagnosability Infrastructure)是自动化诊断方面的又一增强。

FDI的一个关键组件是自动诊断库(Automatic Diagnostic Repository-ADR)。

在oracle 11g中,alert文件的信息是以xml的文件格式存在的,另外提供了普通文本格式的alert文件。

这两份log文

- 简单排序:选择排序

dieslrae

选择排序

public void selectSort(int[] array){

int select;

for(int i=0;i<array.length;i++){

select = i;

for(int k=i+1;k<array.leng

- C语言学习六指针的经典程序,互换两个数字

dcj3sjt126com

c

示例程序,swap_1和swap_2都是错误的,推理从1开始推到2,2没完成,推到3就完成了

# include <stdio.h>

void swap_1(int, int);

void swap_2(int *, int *);

void swap_3(int *, int *);

int main(void)

{

int a = 3;

int b =

- php 5.4中php-fpm 的重启、终止操作命令

dcj3sjt126com

PHP

php 5.4中php-fpm 的重启、终止操作命令:

查看php运行目录命令:which php/usr/bin/php

查看php-fpm进程数:ps aux | grep -c php-fpm

查看运行内存/usr/bin/php -i|grep mem

重启php-fpm/etc/init.d/php-fpm restart

在phpinfo()输出内容可以看到php

- 线程同步工具类

shuizhaosi888

同步工具类

同步工具类包括信号量(Semaphore)、栅栏(barrier)、闭锁(CountDownLatch)

闭锁(CountDownLatch)

public class RunMain {

public long timeTasks(int nThreads, final Runnable task) throws InterruptedException {

fin

- bleeding edge是什么意思

haojinghua

DI

不止一次,看到很多讲技术的文章里面出现过这个词语。今天终于弄懂了——通过朋友给的浏览软件,上了wiki。

我再一次感到,没有辞典能像WiKi一样,给出这样体贴人心、一清二楚的解释了。为了表达我对WiKi的喜爱,只好在此一一中英对照,给大家上次课。

In computer science, bleeding edge is a term that

- c中实现utf8和gbk的互转

jimmee

ciconvutf8&gbk编码

#include <iconv.h>

#include <stdlib.h>

#include <stdio.h>

#include <unistd.h>

#include <fcntl.h>

#include <string.h>

#include <sys/stat.h>

int code_c

- 大型分布式网站架构设计与实践

lilin530

应用服务器搜索引擎

1.大型网站软件系统的特点?

a.高并发,大流量。

b.高可用。

c.海量数据。

d.用户分布广泛,网络情况复杂。

e.安全环境恶劣。

f.需求快速变更,发布频繁。

g.渐进式发展。

2.大型网站架构演化发展历程?

a.初始阶段的网站架构。

应用程序,数据库,文件等所有的资源都在一台服务器上。

b.应用服务器和数据服务器分离。

c.使用缓存改善网站性能。

d.使用应用

- 在代码中获取Android theme中的attr属性值

OliveExcel

androidtheme

Android的Theme是由各种attr组合而成, 每个attr对应了这个属性的一个引用, 这个引用又可以是各种东西.

在某些情况下, 我们需要获取非自定义的主题下某个属性的内容 (比如拿到系统默认的配色colorAccent), 操作方式举例一则:

int defaultColor = 0xFF000000;

int[] attrsArray = { andorid.r.

- 基于Zookeeper的分布式共享锁

roadrunners

zookeeper分布式共享锁

首先,说说我们的场景,订单服务是做成集群的,当两个以上结点同时收到一个相同订单的创建指令,这时并发就产生了,系统就会重复创建订单。等等......场景。这时,分布式共享锁就闪亮登场了。

共享锁在同一个进程中是很容易实现的,但在跨进程或者在不同Server之间就不好实现了。Zookeeper就很容易实现。具体的实现原理官网和其它网站也有翻译,这里就不在赘述了。

官

- 两个容易被忽略的MySQL知识

tomcat_oracle

mysql

1、varchar(5)可以存储多少个汉字,多少个字母数字? 相信有好多人应该跟我一样,对这个已经很熟悉了,根据经验我们能很快的做出决定,比如说用varchar(200)去存储url等等,但是,即使你用了很多次也很熟悉了,也有可能对上面的问题做出错误的回答。 这个问题我查了好多资料,有的人说是可以存储5个字符,2.5个汉字(每个汉字占用两个字节的话),有的人说这个要区分版本,5.0

- zoj 3827 Information Entropy(水题)

阿尔萨斯

format

题目链接:zoj 3827 Information Entropy

题目大意:三种底,计算和。

解题思路:调用库函数就可以直接算了,不过要注意Pi = 0的时候,不过它题目里居然也讲了。。。limp→0+plogb(p)=0,因为p是logp的高阶。

#include <cstdio>

#include <cstring>

#include <cmath&

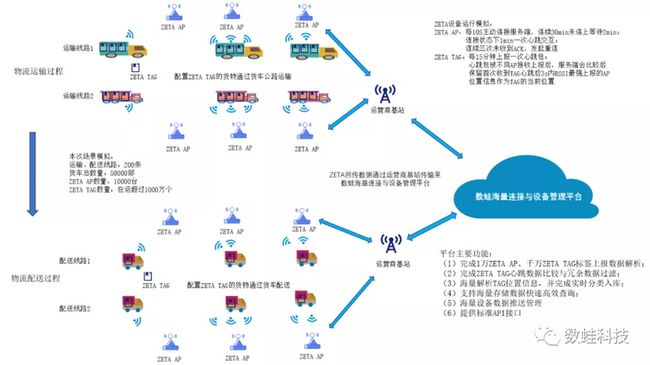

ZETA设备运行模拟: ZETA AP:每10s主动连接服务端,连续30min未连上等待2min再次连接;连接状态下1min一次心跳交互;连续三次未收到ACK,发起重连。 ZETA TAG:每15分钟上报一次心跳包;心跳报文被不同AP接收上报后,服务端会比较后保留首次 收到TAG心跳后3s内RSSI最强上报的AP位置信息作为TAG的当前位置。

客户端场景模拟描述: 运输、配送线路:本次场景模拟线路总计200条,线路可以配置。 运输车辆:本次场景模拟运输车辆50000部,货车会模拟真实物流场景在既定线路上进行移动,车上ZETAG标签随之移动。 ZETA AP:本次模拟10000台,每条线路上分布500台ZETA AP ZETA TAG数量:本次模拟在运ZETAG1000万个,ZETAG随运输车辆移动,每隔15分钟的心跳报文被相邻的2-3个ZETA AP接收。

服务端业务描述: 1、每15分钟内完成千万在运ZETAG标签心跳数据包解析(加上冗余报文,每15分钟内解析心跳报文数量2000多万条); 2、完成ZETA TAG心跳数据比较与冗余数据过滤; 3、完成解析出的海量TAG位置信息实时分类入库; 4、支持ZETA TAG最新位置更新与轨迹查询; 5、每分钟完成1万ZETA AP的心跳报文解析、存储; 6、完成ZETA AP运行状态信息的接收与存储; 7、支持ZETA AP运行状态信息查询。 根据测试系统中消息的业务场景情况,选取以下指标作为场景压力测试情况判断依据: A、ZETA AP在线情况统计 B、ZETA AP在线率 C、在线ZETAG标签数量 D、ZETA标签解析包数量 E、1/5/15分钟CPU平均负载 F、内存使用量 +

压测技术 + 系统监控 服务端与客户端系统监控和业务数据监控采用Prometheus&Grafana做统计与展示

时序数据监控 --- Grafana&TDengine监控插件(监控TDengine数据总量、丢包数以及增长速率)

ZETA设备运行模拟: ZETA AP:每10s主动连接服务端,连续30min未连上等待2min再次连接;连接状态下1min一次心跳交互;连续三次未收到ACK,发起重连。 ZETA TAG:每15分钟上报一次心跳包;心跳报文被不同AP接收上报后,服务端会比较后保留首次 收到TAG心跳后3s内RSSI最强上报的AP位置信息作为TAG的当前位置。

客户端场景模拟描述: 运输、配送线路:本次场景模拟线路总计200条,线路可以配置。 运输车辆:本次场景模拟运输车辆50000部,货车会模拟真实物流场景在既定线路上进行移动,车上ZETAG标签随之移动。 ZETA AP:本次模拟10000台,每条线路上分布500台ZETA AP ZETA TAG数量:本次模拟在运ZETAG1000万个,ZETAG随运输车辆移动,每隔15分钟的心跳报文被相邻的2-3个ZETA AP接收。

服务端业务描述: 1、每15分钟内完成千万在运ZETAG标签心跳数据包解析(加上冗余报文,每15分钟内解析心跳报文数量2000多万条); 2、完成ZETA TAG心跳数据比较与冗余数据过滤; 3、完成解析出的海量TAG位置信息实时分类入库; 4、支持ZETA TAG最新位置更新与轨迹查询; 5、每分钟完成1万ZETA AP的心跳报文解析、存储; 6、完成ZETA AP运行状态信息的接收与存储; 7、支持ZETA AP运行状态信息查询。 根据测试系统中消息的业务场景情况,选取以下指标作为场景压力测试情况判断依据: A、ZETA AP在线情况统计 B、ZETA AP在线率 C、在线ZETAG标签数量 D、ZETA标签解析包数量 E、1/5/15分钟CPU平均负载 F、内存使用量 +

压测技术 + 系统监控 服务端与客户端系统监控和业务数据监控采用Prometheus&Grafana做统计与展示

时序数据监控 --- Grafana&TDengine监控插件(监控TDengine数据总量、丢包数以及增长速率)

系统指标监控 --- Grafana&&Prometheus监控插件,用node\_exporter采集数据(监控CPU,内存,网络、存储四大指标)

系统指标监控 --- Grafana&&Prometheus监控插件,用node\_exporter采集数据(监控CPU,内存,网络、存储四大指标)

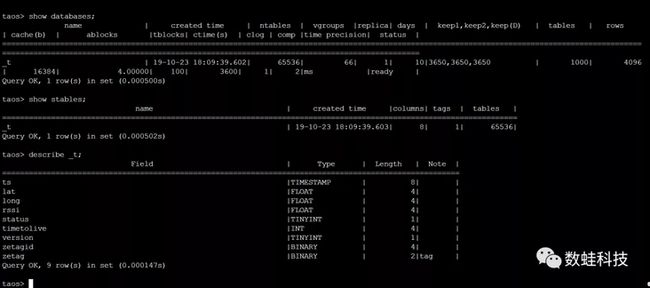

业务消息监控 --- Grafana&Prometheus监控插件,业务层通过Prometheus client实时统计各个消息路由节点上发包数、收包数以及丢包数等指标,业务层主要指标如下: { "name": "ap", "help": "ap数量", "type": "counter", "labels": ["from"] }, { "name": "tag", "help": "tag的包数量", "type": "counter", "labels": ["from"] }, { "name": "zetag", "help": "zetag info", "type": "gauge", "labels": [ "status" ] } ] [ { "name": "shuwa\_group\_metrics", "help": "数蛙任务调度与消息汇聚消息统计", "type": "counter", "labels": [ "di","tid","rid","cid","type" ] } ] + 时序数据 ZETag物流标签的地址域是4个字节,最高的一个字节是保留字节,本次压测的ZETag物流标签的实际地址域是3个字节,所以ZETag地址为FF XX XX XX,总计16,777,215个标签的地址,如果按照一个标签设备一个子表的方式设计,需要1600多万个子表。根据实测结果,Tdengine 1.6.3单机版本子表数量超过49万就极不稳定,很容易崩溃,但子表数量在10万以下具有良好的性能。所以子表设计采用了一种虚拟分组设计,将最低两个字节(总计65,535个子表)作为子表空间,每个子表存储一个字节(总计255个标签)的标签时序数据。

时序数据模型设计: zetag() -> #{ <<"stable"\>> => #{ <<"\_\_database\_\_"\>> => <<"t"\>>, <<"\_\_stable\_\_"\>> => <<"t"\>>, <<"tags"\>> => #{ <<"zetag"\>> => shuwa\_tdengine\_bridge\_dialect:binary(2) }, <<"value"\>> => #{ <<"ts"\>> => shuwa\_tdengine\_bridge\_dialect:timestamp(), <<"zetagid"\>> => shuwa\_tdengine\_bridge\_dialect:binary(4), <<"timetolive"\>> => shuwa\_tdengine\_bridge\_dialect:int(), <<"lat"\>> => shuwa\_tdengine\_bridge\_dialect:float(), <<"long"\>> => shuwa\_tdengine\_bridge\_dialect:float(), <<"version"\>> => shuwa\_tdengine\_bridge\_dialect:tinyint(), <<"status"\>> => shuwa\_tdengine\_bridge\_dialect:tinyint(), <<"rssi"\>> => shuwa\_tdengine\_bridge\_dialect:float() } }, <<"table"\>> => #{ <<"type"\>> => <<"function"\>>, <<"mod"\>> => <<"shuwa\_zeta\_model"\>>, <<"function"\>> => <<"zeta\_tag\_subtable"\>>, <<"args"\>> => #{ <<"\_\_database\_\_"\>> => <<"t"\>>, <<"\_\_stable\_\_"\>> => <<"t"\>>, <<"tags"\>> => [<<"FF"\>>] } } }.

业务消息监控 --- Grafana&Prometheus监控插件,业务层通过Prometheus client实时统计各个消息路由节点上发包数、收包数以及丢包数等指标,业务层主要指标如下: { "name": "ap", "help": "ap数量", "type": "counter", "labels": ["from"] }, { "name": "tag", "help": "tag的包数量", "type": "counter", "labels": ["from"] }, { "name": "zetag", "help": "zetag info", "type": "gauge", "labels": [ "status" ] } ] [ { "name": "shuwa\_group\_metrics", "help": "数蛙任务调度与消息汇聚消息统计", "type": "counter", "labels": [ "di","tid","rid","cid","type" ] } ] + 时序数据 ZETag物流标签的地址域是4个字节,最高的一个字节是保留字节,本次压测的ZETag物流标签的实际地址域是3个字节,所以ZETag地址为FF XX XX XX,总计16,777,215个标签的地址,如果按照一个标签设备一个子表的方式设计,需要1600多万个子表。根据实测结果,Tdengine 1.6.3单机版本子表数量超过49万就极不稳定,很容易崩溃,但子表数量在10万以下具有良好的性能。所以子表设计采用了一种虚拟分组设计,将最低两个字节(总计65,535个子表)作为子表空间,每个子表存储一个字节(总计255个标签)的标签时序数据。

时序数据模型设计: zetag() -> #{ <<"stable"\>> => #{ <<"\_\_database\_\_"\>> => <<"t"\>>, <<"\_\_stable\_\_"\>> => <<"t"\>>, <<"tags"\>> => #{ <<"zetag"\>> => shuwa\_tdengine\_bridge\_dialect:binary(2) }, <<"value"\>> => #{ <<"ts"\>> => shuwa\_tdengine\_bridge\_dialect:timestamp(), <<"zetagid"\>> => shuwa\_tdengine\_bridge\_dialect:binary(4), <<"timetolive"\>> => shuwa\_tdengine\_bridge\_dialect:int(), <<"lat"\>> => shuwa\_tdengine\_bridge\_dialect:float(), <<"long"\>> => shuwa\_tdengine\_bridge\_dialect:float(), <<"version"\>> => shuwa\_tdengine\_bridge\_dialect:tinyint(), <<"status"\>> => shuwa\_tdengine\_bridge\_dialect:tinyint(), <<"rssi"\>> => shuwa\_tdengine\_bridge\_dialect:float() } }, <<"table"\>> => #{ <<"type"\>> => <<"function"\>>, <<"mod"\>> => <<"shuwa\_zeta\_model"\>>, <<"function"\>> => <<"zeta\_tag\_subtable"\>>, <<"args"\>> => #{ <<"\_\_database\_\_"\>> => <<"t"\>>, <<"\_\_stable\_\_"\>> => <<"t"\>>, <<"tags"\>> => [<<"FF"\>>] } } }.

240亿数据存储空间占用230G磁盘空间

240亿数据存储空间占用230G磁盘空间

数据存储目录

数据存储目录

时序数据入库示例: -module(shuwa\_td\_test). -author("shuwa"). -export([rand\_tag/0, t/0]). rand\_tag() -> integer\_to\_binary(4278190080 + round(rand:uniform() * 16777215), 16). t() -> shuwa\_tdengine\_format:insert\_zeta( #{ <<"zetagID"\>> => rand\_tag(), <<"times"\>> => 1, <<"lat"\>> => 2, <<"long"\>> => 3, <<"version"\>> => 4, <<"status"\>> => 5, <<"rssi"\>> => 6, <<"ts"\>> => shuwa\_utils:now\_ms() } ).

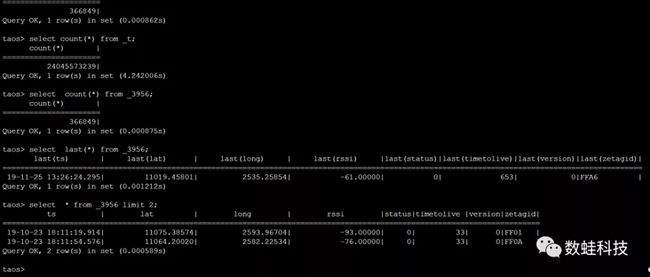

时序数据入库策略: 本次模拟了1300多万的物流标签15分钟一个心跳,平均1.4万多的QPS,峰值QPS很容易超过Tdengine的入库QPS阀值,导致Tdengine崩溃。在消息路由层设计了一个基于令牌桶算法的消息缓存层进行削峰处理,在保证时序数据的顺序性的同时,也能让时序数据以比较平稳的速率批量入库。由于Tdengine没有提供erlang的连接池程序,最开始用默认的http客户端来入库,长时间运行不稳定,最后我们把Tdengine原生的c语言的连接池程序进行了改造,添加了mqtt订阅功能,通过mqtt协议来转发批量存库时序数据。

时序数据出库策略: 由于对子表进行虚拟分组设计,查找任何一个物流标签数据的物流轨迹数据都有非常便捷的寻址算法,快速查找到用户层期望的时序数据,在百亿级数据规模的情况下,查询速度也可以到毫秒级。

ZetaEtag即时数据查询接口:/zeta/etag/{tag} 超时时间为5秒 随机读tag,数据库内数据58169933条 tag 生成方式:FF开头后六位随机生成

时序数据入库示例: -module(shuwa\_td\_test). -author("shuwa"). -export([rand\_tag/0, t/0]). rand\_tag() -> integer\_to\_binary(4278190080 + round(rand:uniform() * 16777215), 16). t() -> shuwa\_tdengine\_format:insert\_zeta( #{ <<"zetagID"\>> => rand\_tag(), <<"times"\>> => 1, <<"lat"\>> => 2, <<"long"\>> => 3, <<"version"\>> => 4, <<"status"\>> => 5, <<"rssi"\>> => 6, <<"ts"\>> => shuwa\_utils:now\_ms() } ).

时序数据入库策略: 本次模拟了1300多万的物流标签15分钟一个心跳,平均1.4万多的QPS,峰值QPS很容易超过Tdengine的入库QPS阀值,导致Tdengine崩溃。在消息路由层设计了一个基于令牌桶算法的消息缓存层进行削峰处理,在保证时序数据的顺序性的同时,也能让时序数据以比较平稳的速率批量入库。由于Tdengine没有提供erlang的连接池程序,最开始用默认的http客户端来入库,长时间运行不稳定,最后我们把Tdengine原生的c语言的连接池程序进行了改造,添加了mqtt订阅功能,通过mqtt协议来转发批量存库时序数据。

时序数据出库策略: 由于对子表进行虚拟分组设计,查找任何一个物流标签数据的物流轨迹数据都有非常便捷的寻址算法,快速查找到用户层期望的时序数据,在百亿级数据规模的情况下,查询速度也可以到毫秒级。

ZetaEtag即时数据查询接口:/zeta/etag/{tag} 超时时间为5秒 随机读tag,数据库内数据58169933条 tag 生成方式:FF开头后六位随机生成

+

消息路由 ZETag物流标签数据从数据产生到数据落库,1300多万ZETag标签 =》5万卡车进程=》1万AP基站客户端连接进程=》1万AP的服务端连接进程=》65535虚拟分组进程=》消息缓存调度进程 =》Tdengine的mqtt客户端=》Tdengine连接池存储进程,消息需要经过7次转发,每一跳都需要小心处理内存释放和消息堵塞问题。每15分钟有将近3000万-4500万消息的生产和消费,需要有非常好的GC处理机制。其中1万AP的服务端连接进程--》65535虚拟分组进程,这一跳消息转发速率没有固定的对应关系,两点之间QPS波动非常大,用开源的mqtt消息转发和消费组策略也非常容易导致消息堵塞和内存持续上涨。这里也还是得益于之前的虚拟分组设计,通过虚拟分组比较好的解决了这一跳的高效消息路由,同时也把这两点之间的消息转发的QPS峰值削的比较平。 +

影子设备 本次测试模拟的是类似双11这样的物流标签轨迹最繁忙的场景,模拟了5万台卡车装满(200多件贴上ZETag标签的快递件)快递件,在200多条线路上飞奔,在行驶过程中不停切换AP基站,上报ZETag标签轨迹数据,满怀期望的用户时不时登录快递网站查看一下自己购买的货物到了何处。我们在系统中设计了5万个卡车影子设备,1万的AP基站影子设备和65535虚拟分组影子设备来处理这一较为复杂的业务场景。卡车影子设备承载了ZETA标签信息,线路位置信息和线路沿途的AP基站信息的交互,AP基站影子设备承载了ZEtag通信协议处理,虚拟分组影子设备承担了1300万ZETag标签的边缘计算和时序数据存储处理。 +

任务调度 每15分钟有将近3000万-4500万ZETag标签消息的生产和消费除了需要良好的GC机制,同时也需要一个良好的任务调度机制。治大国如烹小鲜,每一个影子设备上面的任务调度处理细节非常关键,每一个小的偏差都会被乘以一个3000-45000万的系数放大,对任务调度质量要求是零缺陷。合理的分组策略(也即合理的影子设备设计)非常关键,可以从宏观上对系统资源进行削峰,在单个影子设备上进行完美的微操作,让每一个影子设备的任务调度策略达到零缺陷。 +

压测结果

+

消息路由 ZETag物流标签数据从数据产生到数据落库,1300多万ZETag标签 =》5万卡车进程=》1万AP基站客户端连接进程=》1万AP的服务端连接进程=》65535虚拟分组进程=》消息缓存调度进程 =》Tdengine的mqtt客户端=》Tdengine连接池存储进程,消息需要经过7次转发,每一跳都需要小心处理内存释放和消息堵塞问题。每15分钟有将近3000万-4500万消息的生产和消费,需要有非常好的GC处理机制。其中1万AP的服务端连接进程--》65535虚拟分组进程,这一跳消息转发速率没有固定的对应关系,两点之间QPS波动非常大,用开源的mqtt消息转发和消费组策略也非常容易导致消息堵塞和内存持续上涨。这里也还是得益于之前的虚拟分组设计,通过虚拟分组比较好的解决了这一跳的高效消息路由,同时也把这两点之间的消息转发的QPS峰值削的比较平。 +

影子设备 本次测试模拟的是类似双11这样的物流标签轨迹最繁忙的场景,模拟了5万台卡车装满(200多件贴上ZETag标签的快递件)快递件,在200多条线路上飞奔,在行驶过程中不停切换AP基站,上报ZETag标签轨迹数据,满怀期望的用户时不时登录快递网站查看一下自己购买的货物到了何处。我们在系统中设计了5万个卡车影子设备,1万的AP基站影子设备和65535虚拟分组影子设备来处理这一较为复杂的业务场景。卡车影子设备承载了ZETA标签信息,线路位置信息和线路沿途的AP基站信息的交互,AP基站影子设备承载了ZEtag通信协议处理,虚拟分组影子设备承担了1300万ZETag标签的边缘计算和时序数据存储处理。 +

任务调度 每15分钟有将近3000万-4500万ZETag标签消息的生产和消费除了需要良好的GC机制,同时也需要一个良好的任务调度机制。治大国如烹小鲜,每一个影子设备上面的任务调度处理细节非常关键,每一个小的偏差都会被乘以一个3000-45000万的系数放大,对任务调度质量要求是零缺陷。合理的分组策略(也即合理的影子设备设计)非常关键,可以从宏观上对系统资源进行削峰,在单个影子设备上进行完美的微操作,让每一个影子设备的任务调度策略达到零缺陷。 +

压测结果

参考网站: 数蛙科技:

http://www.iotn2n.com/ 纵行科技:

https://www.zifisense.com/ 涛思数据:

https://www.taosdata.com/ > 欢迎大家底部留言,一起探讨物联网科技的魅力所在。

参考网站: 数蛙科技:

http://www.iotn2n.com/ 纵行科技:

https://www.zifisense.com/ 涛思数据:

https://www.taosdata.com/ > 欢迎大家底部留言,一起探讨物联网科技的魅力所在。