Python 学习笔记 https://www.jianshu.com/nb/49026514

引言

Excel操作之前的文章已经分享,本文分享的是如何把Json文件写入Excel,如何把Excel数据读取后转换成Json。在接口自动化测试过程中有时需要把返回的Json文件实时写入Excel中。

Json 介绍

JSON是一种轻量级的数据交换格式,功能上类似于XML,但是JSON的数据更新更容易解析,更小、速度更快。JSON是一种完全独立于编程语言的文本格式(占用空间小,利于传输),因此JSON可以运用于不同的语言中。采用完全独立于编程语言的文本格式来存储和表示数据,易于阅读和编写,同时也易于机器解析和生成,并有效地提升网络传输效率。

- 数据格式:对象和字符串

- 后端独立部署,提供接口,提供数据

- 前端独立部署,负责渲染后端的数据

Json对象

{

"name": "千叶老人",

"福地": "终南山",

"desc": "苍穹派掌门",

"age": "300"

}

- 对象共创建了四个变量,并为变量进行了赋值。

- 在创建对象时,数值名称必须用双引号,数值是Object类型。

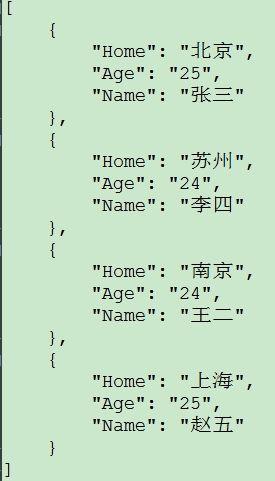

JSON数组(多个对象)

[

{

"Home": "北京",

"Age": "25",

"Name": "张三"

},

{

"Home": "苏州",

"Age": "24",

"Name": "李四"

},

{

"Home": "南京",

"Age": "24",

"Name": "王二"

},

{

"Home": "上海",

"Age": "25",

"Name": "赵五"

}

]

- 该数组中包括了三个元素,每个元素代表一个商品的信息,

- 花括号中的内容是一个对象,方括号中的内容是一个数组。

json文件获取值

参考 https://www.jianshu.com/p/9c463a42d9fb 这篇文章

Json写入Excel

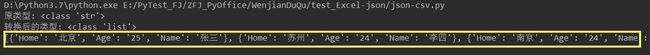

第1步 读取Json

- 方法1: with open读取Json文件,加上,encoding='utf-8',防止中文乱码

import csv ,json

def red1_json(filename):

with open(filename, 'r',encoding='utf-8') as json_file:

data = json_file.read()

print("原类型:", type(data))

json_data_dict = json.loads(data)

print("转换后的类型:", type(json_data_dict))

# new_result = json.dumps(json_data_dict, ensure_ascii=False)

return json_data_dict

if __name__ == "__main__":

print(red1_json('xinx.json'))

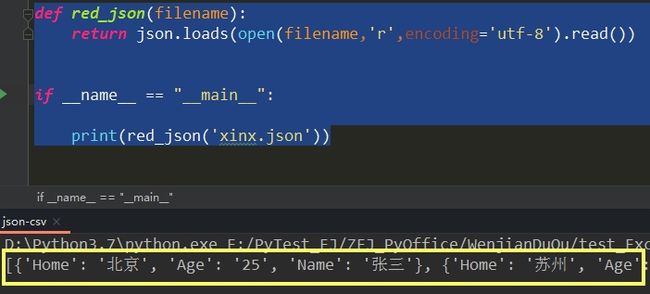

- 方法2: with open读取Json文件,加上,encoding='utf-8',防止中文乱码

def red_json(filename):

return json.loads(open(filename,'r',encoding='utf-8').read())

if __name__ == "__main__":

print(red_json('xinx.json'))

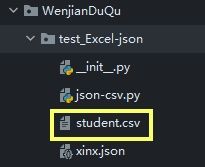

第2步 写入CSV文件

-

初始目录没有CSV文件

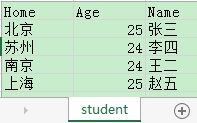

执行代码,目录生成CSV文件

def write_csv(data,csvname):

with open(csvname,r'w') as f:

dw = csv.DictWriter(f,data[0].keys())

dw.writeheader()

for row in data:

dw.writerow(row)

if __name__ == "__main__":

write_csv(red_json('xinx.json'),'student.csv')

-

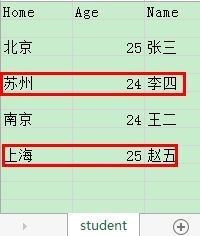

打开CSV文件

问题思考???

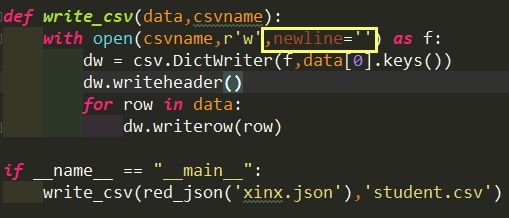

为什么csv文件有空行呢?所以要优化代码,分两种情况,Python2和Python3

- python2 将写入方式改为wb+ 二进制写入 不做详细解释

- python3版本 更改为二级制写入方式 会报错 官方推荐 newline='' 去掉空行,优化代码参考

def write_csv(data,csvname):

with open(csvname,r'w',newline='') as f:

dw = csv.DictWriter(f,data[0].keys())

dw.writeheader()

for row in data:

dw.writerow(row)

if __name__ == "__main__":

write_csv(red_json('xinx.json'),'student.csv')

全部代码参考

# -*- coding: utf-8 -*-

# @Time : 2021/3/1 20:41

# @File : json-csv.py

# @Author : Yvon_早安阳光

import csv ,json

def red1_json(filename):

with open(filename, 'r',encoding='utf-8') as json_file:

data = json_file.read()

print("原类型:", type(data))

json_data_dict = json.loads(data)

print("转换后的类型:", type(json_data_dict))

# new_result = json.dumps(json_data_dict, ensure_ascii=False)

return json_data_dict

def red_json(filename):

return json.loads(open(filename,'r',encoding='utf-8').read())

def write_csv(data,csvname):

with open(csvname,r'w',newline='') as f:

dw = csv.DictWriter(f,data[0].keys())

dw.writeheader()

for row in data:

dw.writerows(row)

if __name__ == "__main__":

write_csv(red1_json('xinx.json'),'student.csv')

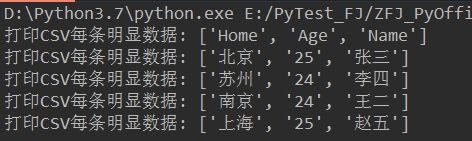

Excel数据转换json文件- 第1步 : 读取CSV文件

方法1: 传统读取代码参考如下:

#读取csv文件

def read_csv(csvname):

with open(csvname,'r') as read_csvfile:

reader = csv.reader(read_csvfile)

for row in reader:

print("打印CSV每条明显数据: %s" % row)

if __name__ == "__main__":

# write_csv(red_json('xinx.json'),'student.csv')

read_csv('student.csv')

方法1 读取的数据显然不适合写入Json,需要优化代码, 把读取的数据放入列表中,故采用方法2读取CSV数据

方法2 优化读取代码

# -*- coding: utf-8 -*-

# @Time : 2021/3/2 15:13

# @File : csv-json.py

# @Author : Yvon_早安阳光

import csv,json

'''读取csv文件'''

def read_csv(filename):

csv_rows = []

with open(filename) as csv_file:

# 读取数据

reader_shuju = csv.DictReader(csv_file)

# 读取标题列

title = reader_shuju.fieldnames

# 循环读取数据

for row in reader_shuju:

csv_rows.extend([{title[i]:row[title[i]] for i in range(len(title))}])

return csv_rows

if __name__ == "__main__":

print(read_csv('student.csv'))

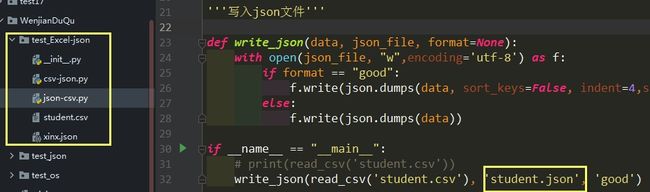

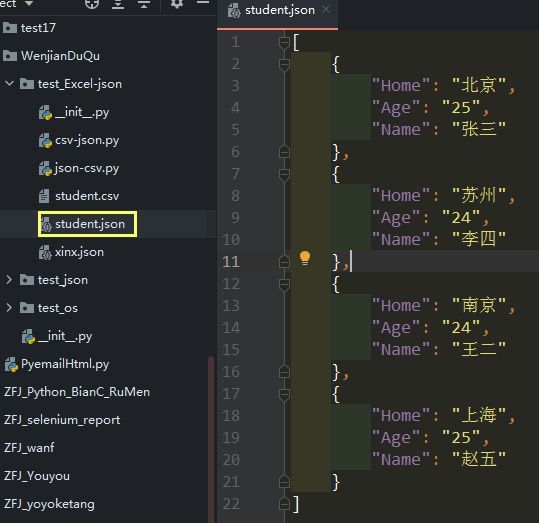

Excel数据转换json文件- 第2步 : 写入json文件

-

初始目录下没有student.json文件

- 读取的数据写入student.json文件

'''写入json文件'''

def write_json(data, json_file, format=None):

with open(json_file, "w",encoding='utf-8') as f:

if format == "good":

f.write(json.dumps(data, sort_keys=False, indent=4,separators=(',', ': '),ensure_ascii=False))

else:

f.write(json.dumps(data))

if __name__ == "__main__":

# print(read_csv('student.csv'))

write_json(read_csv('student.csv'), 'student.json', 'good')