本文由AI科技评论读者 BBuf 投稿来稿见文末说明

大规模的目标检测数据集(例如MS-COCO)在进行Ground Truth框标注时仍然存在歧义。这篇论文提出了新的边界框回归损失针对目标框的移动以及位置方差进行学习,这种方法在几乎不增加计算量的基础上提高不同结构定位的准确性。另一个关键点是,由于学习了bounding box的分布,可以将其应用在NMS阶段合并相邻目标框,进一步提升定位的准确性。代码已开源。

1.研究背景

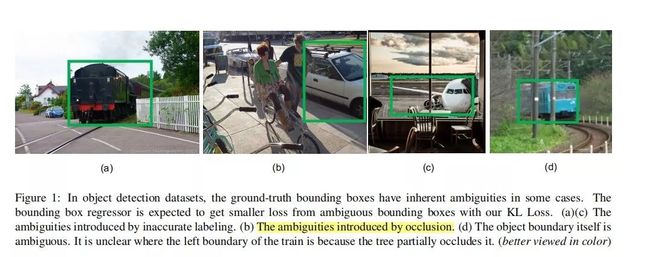

在大规模目标检测数据集中,一些场景下目标框的标注是存在歧义的,这种情况如果直接使用以前目标检测的边界框回归损失,也即是Smooth L1Loss会出现学习很不稳定,学习的损失函数大的问题。Figure 1展示了哪些场景可能存在目标框标注不准确的情况:

(a,c)框的标记不准确。(b)由遮挡引起的歧义。(d)图片物体不完整,不明确物体的边界在哪里。目标检测包含分类以及定位,是一个多任务的学习问题。Faster R-CNN,Cascade R-CNN及Mask R-CNN依靠边界框回归来进行目标定位。

然而,传统的边界框损失即Smooth L1损失并没有考虑到groundtruth模糊的情形。一般来说,分类的分数越高,其边界框的回归应该更加准确,然而,这种情况不是总是发生,如Figure2所示:

(a)两个候选框都是不准确的。大的过大,小的过小。

(b)具有较高分类分数的边界框的左边界是不准确。(颜色更容易观察)

2. 相关工作

双阶段检测器单阶段检测虽然高效,但是state-of-art仍然基于双阶段检测。双阶段首先会生成proposal,进而产生大量重叠的边界框,标准的NMS会将类别分数较低,但是较为准确的框给剔除掉。本文的var voting尝试利用相邻的边界框来进行更好的定位。

目标检测损失函数UnitBox引入IoU loss函数用于边界框的预测,Focal Loss通过修改标准的交叉熵损失用于处理类别不平衡问题,对于容易分类的样本其权重更低。KL损失可以在训练时调整每个物体的边界方差,可以学习到更多差异的特征。

NMSsoft NMS及learning NMS用于改进NMS,相比删除所有类别分数较低的边界框,soft NMS将衰减其他相邻框的检测分数来作为与更高分数框重叠率的连续函数,leaningNMS,提出学习一个新的网络只对boxes及分类分数进行NMS处理。

边界框精炼MR-CNN首次提出在迭代定位中将框进行merge操作。IoU-Net提出学习预测框与ground truth框之间的IoU,然后,根据学习到的IoU应用IoU-NMS,与IoU-Net不同,论文从概率分布的角度对位置方差进行单独学习。因此,本文可以对四个坐标的方差进行单独的学习,而不只是IoU。var voting 通过由KL损失学习到的相邻边界框的方差来对选择的框产生新的位置。

3. 解决方法

为了解决上诉定位不精确问题,论文提出了新的边界框损失函数-KL损失,可以同时学习边界框的回归以及定位的不准确性。特别的,为了捕捉边界框预测的不确定性,首先将边界框的预测以及ground truth框分别看做高斯分布函数和狄克拉分布函数。则新定义的回归损失可以看作是预测分布和真实分布之间的KL散度。我们知道KL有3个优点:(1)可以成功捕获数据集中的模糊。边界框回归器从模糊的边界框中获得较小的损失。(1)在后处理过程中,所学的方差是有用的。论文提出了VaR投票(方差投票)方法,即在非最大抑制(NMS)过程中,利用相邻位置的预测方差加权,对候选框的位置进行投票。(3)所学概率分布反映了边界框预测的不确定性水平。

3.1边界框参数化

基于双阶段的目标检测网络如Faster-RCNN,MaskR-CNN。网络结构如Figure 3所示:

从图中看出,模型有3个分支,分别为Class代表图像的类别,Box代表预测的框,Box std是预测框的四个坐标(左上角和右下角两个点的四个坐标)与真实框之间的标准差,即坐标之间的距离。通过Box std计算得到的KL损失函数反向传播修改Box中的坐标点位置和预测框的大小。这里用(x1,y1,x2,y2)代表预测边界框左上角和右下角的坐标。(x1*,y1*,x2*,y2*)表示真实的边界框左上角和右下角的坐标。(x1a,x2a,y1a,y2a,wa,ha)是Anchor。那么预测边界框和真实边界框分别与Anchor的偏差如公式1所示:

同样,不带*号的t表示预测边框与Anchor的偏差,带*号的t表示真实边框和Anchor的偏差。

论文的重点在于评估位置的置信度。所以,论文在预测边界框位置的基础上又预测了一个位置的分布,这里假设坐标是独立的,为了简单起见,使用了单变量的高斯函数,如公式2所示:

式子中边界框坐标表示为x,因为我们可以独立地优化每个坐标,Θ是一组可以学习的参数,

是我们预测的边界框的位置。标准差σ测量估计的不确定度。当σ趋近于0时,表示网络对估计的位置非常有信心。地面真实边界框也可以表示为高斯分布,由于是真实的框,我们让σ趋近于0,这就变成了狄克拉函数,如公式(3)所示:

其中xg是地面真实边界框信息。

3.2 基于KL损失的边界框回归

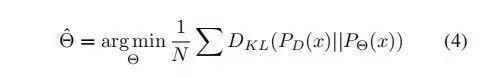

论文目标定位的目标是通过在N个样本最小化

和

之间的KL散度来评估

,如公式(4)所示:

使用KL散度作为边界框回归的损失函数Lreg。分类损失Lcls保持不变。对于单个样本,有公式5:

公式使用分步积分展开得到。我们来观察一下Figure 4:

图中,蓝色和灰色的高斯分布是我们的估计。橙色中的狄克拉函数是地面真值边界框的分布。当位置

估计不准确时,我们期望网络能够预测更大的方差σ²从而使Lreg更低(蓝色)。从公式可以看出

和

不依赖于估计参数

,所以有公式(6):

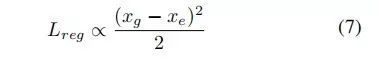

特殊的,当σ=1时,KL损失退化为标准欧几里得损失:

损失函数是可微的,对于

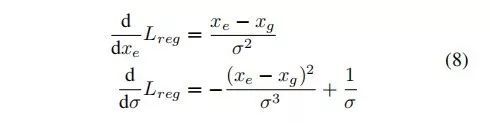

和σ分别求偏导如公式(8)所示:

然而,由于σ是分母,有时会在训练开始时梯度爆炸。为了避免梯度爆炸,网络在实际中预测α=㏒(σ²)而不是σ。如公式9所示:

在测试过程中我们将α转回σ。对于|xg-xe|>1,我们采用类似于fast R-CNN中定义的Smooth L1 的损失。最后回归损失函数定义为公式10:

用随机高斯分布对FC层进行初始化,标准偏差及均值分别设置为0.0001及0,因此,KL损失在训练的刚开始时与smoothL1损失相似。

3.3 方差投票

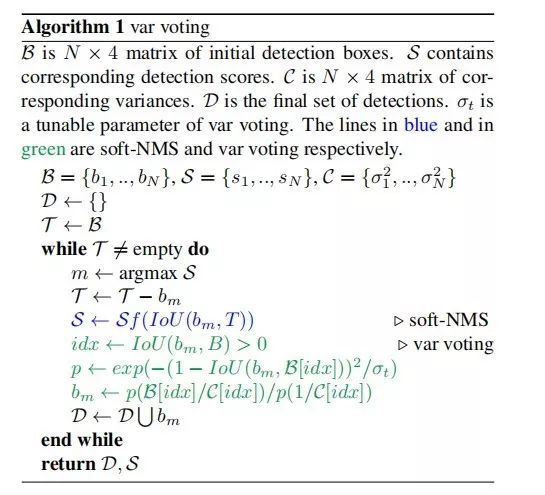

在得到预测位置的方差后,根据已知的相邻边界框的方差对候选边界框位置进行投票。如Algorithm1所示,用三行代码更改NMS,实际上这里为soft nms:

可以看到,这里不仅使用了softnms,使得同一类靠很近的目标漏检降低,还提出了var voting思想。即对于iou大于阈值的那些boxes,可以通过他们各自学到的方差(box的一对角点 x1,y1,x2,y2,四个值的方差 δx₁,δy₁,δx₂,δy₂,加权以更新box坐标,使得定位更准。新坐标的计算方式如Figure 11所示:

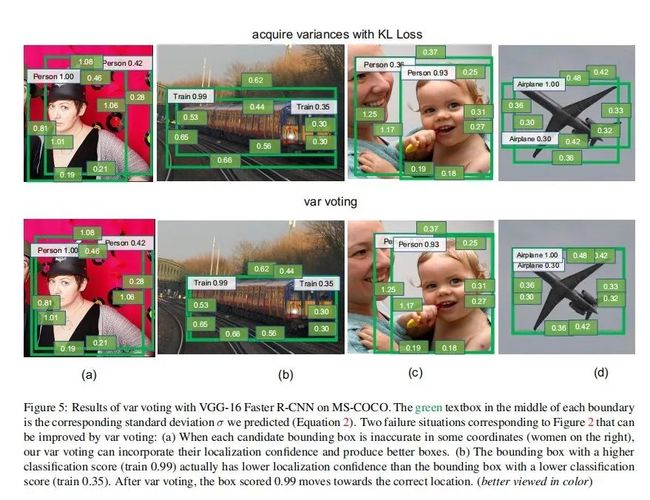

是变量表决的可调参数。当

越大,pi越大,即“距离”越近或交并比越大的两个框产生的pi值越大。对剩下的3个坐标值也进行同样的操作。以下两种类型的相邻边界框在投票时会得到较低的权重:(1)方差较大的框。(2)带有所选框的小IOU的框。分类分数不参与投票,因为得分较低的框可能具有较高的信心。在Figure 5中,提供了方差投票的可视化说明。通过方差投票,有时可以避免Figure2中提到的检测结果偏差很大的几种情况。

4. 结果

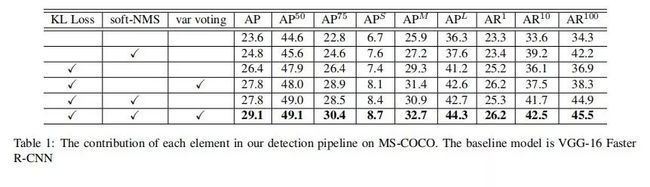

Table5和Table6在MS-COCO和PSCALL VOC2007数据上用各种目标检测网络和论文提出的方法进行测试,可以看到一些AP值都获得了较大的提升。

5. 意义

综上,大规模目标检测数据集中的不确定性会阻碍最先进的目标检测算法的性能。分类置信度并不总是与定位置信度密切相关。本文提出了一种新的具有不确定性的边界盒回归损失方法,用于学习更精确的目标定位。通过训练KL损失,网络学习预测每个坐标的定位方差。由此产生的差异使方差投票成为可能,它可以通过方差投票来优化选定的边界框。使用MS-COCO和Pascal VOC 2007数据集,在vgg-16 Fast r-cnn、resnet-50 fpn和mask r-cnn上应用我们论文的方法得到了令人信服的结果。

投稿需知

投稿请联系:

微信:jiawei1066

更多内容

「LSTM之父」 Jürgen Schmidhuber访谈:畅想人类和 AI 共处的世界 | WAIC 2019

历年 AAAI 最佳论文(since 1996)

一份完全解读:是什么使神经网络变成图神经网络?

点击 阅读原文 加入 CVPR 顶会交流小组