背景

通过显微成像拍摄大脑非常薄的层的照片并以三维形式对其进行重构,可以确定结构在哪里以及它们之间的关系。但这会带来巨大挑战。获取高分辨率图像并快速捕获以覆盖大脑的合理区域是一项主要任务。

一部分问题在于任何摄影师都熟悉的权衡和折衷。打开光圈足够长的时间以允许大量的光线进入,任何运动都会造成模糊;快速拍摄图像以避免模糊,被摄对象可能会变暗。

而且在串行块面电子显微镜的广泛使用的技术中,将一块组织切成块,将其表面成像,切下一个薄片,然后对该块再次成像。重复该过程直到完成。但是,产生微观图像的电子束实际上会导致样品熔化,从而扭曲其试图捕获的物体。

研究人员认为如果到达显微镜的物理极限,也许软件和图像算法可以提供解决方案。

研究人员认为深度学习(一种使用多层分析从原始输入中逐步提取高级功能的机器学习形式)对于提高显微镜图像的分辨率非常有用。

显微镜成像介绍

显微镜是理解生物学系统组织的重要工具,几乎与生物学本身同义。像所有成像系统一样,图像分辨率,照明强度(以及由此造成的样品损坏)和成像速度都彼此关联着。在单个系统中,通常不可能优化一个参数而不损害其他参数中的至少一个。这对于点扫描系统(例如,扫描电子(SEM)和激光扫描共聚焦(LSM)显微镜,其高分辨率图像需要更多数量的顺序采集像素以确保正确采样,从而增加成像时间和与像素分辨率成正比的样品损坏。尽管存在这些限制,但由于点扫描系统的多功能性和易用性,因此它们仍可能是生物研究实验室中最常见的成像方式。

“超分辨率”深度学习已被广泛用于对下采样数字图像中的像素进行“超级采样”,有效地提高了它们的分辨率。对于显微镜,将深度学习作为图像分析和分割的最佳方法已确立。

最近,在将显微镜图像从相对嘈杂的低分辨率采集恢复为具有高信噪比(SNR)的高分辨率输出的显微镜图像中,深度学习已获得了令人瞩目的结果。

各向异性荧光和EM体积数据已使用深度学习进行了超采样。在这里,我们表明基于深度学习的16倍欠采样图像的恢复有助于在SEM和扫描共聚焦显微镜上进行更快,更低剂量的成像,从而可以使成像速度提高16倍,对样品的损害减少≥16倍,并且原始图像文件的大小减小16倍。由于获得的像素数减少了16倍。因此,点扫描超分辨率(PSSR)方法提供了一种策略,可将点扫描成像系统的时空分辨率提高到以前无法达到的水平。

结果

三维电子显微镜(3DEM)是确定组织体积超微结构的有力技术,这对于连接组学研究而言是无价的。除串行截面EM(ssEM)和聚焦离子束SEM(FIB-SEM)外,用于高通量3DEM成像的最常用工具之一是串行块面扫描电子显微镜(SBFSEM),其中内置有超薄切片机在用激光束成像后,将超薄切片(通常在50-100 nm之间)从方块的表面切下扫描电子探针。这种方法有助于实现相对自动化,高通量的3DEM成像,并且采集后的图像对准最少。

但也有带来问题,较高的电子剂量会导致样品带电,这会使样品太软而无法可靠地切片和成像。此外相对大体积的高分辨率3DEM成像固有的极长的成像时间和大文件大小为许多实验室带来了很大的瓶颈。因此,大多数3DEM数据集都是通过亚奈奎斯特采样(例如像素大小≥4 nm)获取的,从而无法可靠地检测或分析较小的亚细胞结构,例如约35 nm的突触前囊泡。虽然欠采样的3DEM数据集可能适用于许多分析,但能够挖掘这些大型数据集的目标区域以获得更高分辨率的超结构信息将非常有用。不幸的是,许多3DEM成像方法具有破坏性,而高分辨率ssEM可能很慢且费力。

通过计算提高这些数据集的分辨率的能力具有很高的价值和广泛的用途。由于无法以所需的2 nm分辨率和SNR可靠地检测突触前囊泡而无法执行SBFSEM成像,我们决定测试在2 nm高分辨率(HR)图像上训练的深度卷积神经网络模型(PSSR)是否可以“超将8纳米低分辨率(LR)图像解析为2纳米分辨率(图1)。

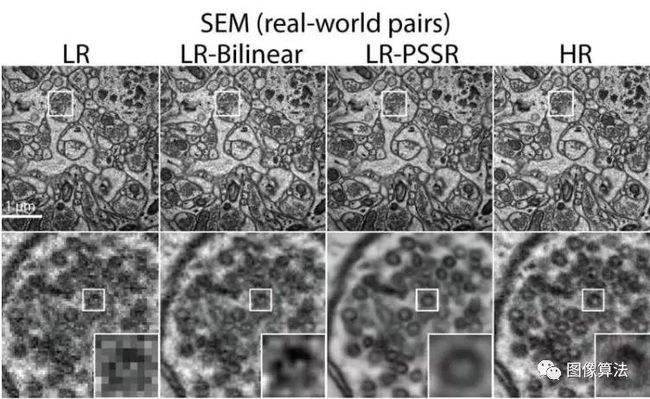

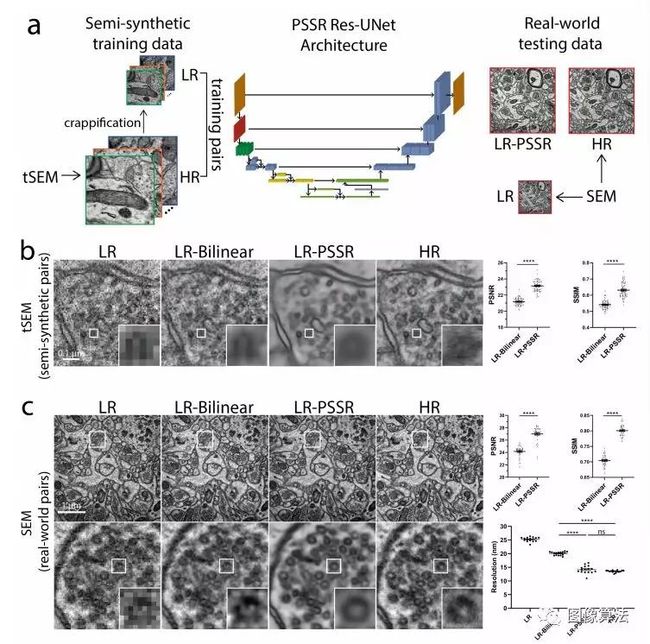

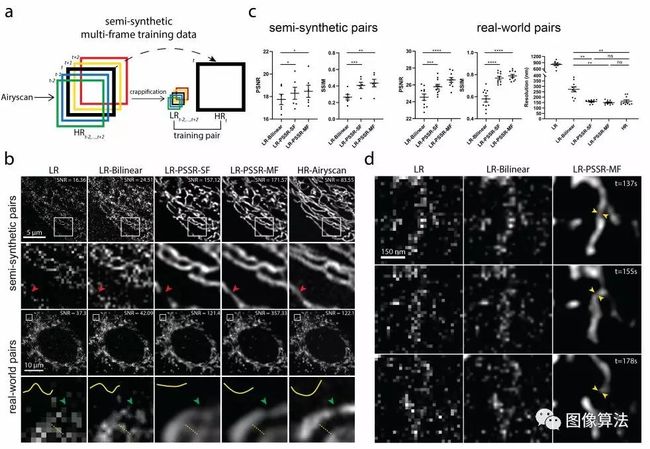

图1 |使用在半合成生成的训练对上训练的PSSR模型还原半合成和真实世界的EM测试数据。 a,一般工作流程概述。通过将降级函数应用于以透射模式(tSEM)从扫描电子显微镜拍摄的HR图像以生成LR对应物,可以半合成创建训练对(左列)。 b,tSEM在半合成测试对上的恢复性能。。 c,手动获取的SEM测试对的恢复结果。

为了为此目的训练模型,需要许多完美对齐的高分辨率和低分辨率图像对。我们选择手动生成高分辨率图像以模拟在显微镜下采集时其低分辨率对应图像的外观,而不是人工获取用于训练的高分辨率和低分辨率图像对,而是选择生成半合成的训练数据。为此,我们使用了来自Long Evans雄性大鼠海马的40 nm超薄切片的2 nm像素透射模式扫描电子显微镜(tSEM17)图像的〜130 GB训练数据。为了生成半综合训练对,我们对我们的HR数据(包括高斯高斯)应用了主动下采样和降级滤波器。

除了像素分辨率的16倍下采样外,还包括模糊,随机像素移位和随机椒盐噪声。然后在基于ResNet的U-Net模型上训练了图像对。

通过目视检查以及峰信噪比(PSNR),结构相似度(SSIM)和傅立叶环相关(FRC)分析,使用均方误差(MSE)损失函数可产生出色的结果。从我们的半合成对中恢复的PSSR图像包含更多细节,但显示的噪音更少,这使得辨别诸如突触前囊泡等精细细节变得更加容易(图1b)。接下来,我们测试了PSSR模型在“真实” LR图像上是否有效。通常,基于深度学习的图像恢复模型对图像特性的变化极为敏感,因此无法使用从训练条件下生成的模型在另一条件下获取的图像上训练模型(即,使用其他样品制备技术,类型或在不同的显微镜上)。

如上所述,我们的训练图像是使用tSEM检测器从40 nm切片中生成的。但对于我们的测试数据,我们获得了80 nm截面的HR和LR图像,这些图像是用反向散射检测器成像的。基于PSNR,SSIM,FRC(图1),NanoJ SQUIRREL误差映射分析和目视检查等多个指标,我们发现PSSR非常有效地还原了低分辨率图像(图1c)。因此,我们的PSSR模型不限于以与我们的训练集完全相同的方式获取的数据。

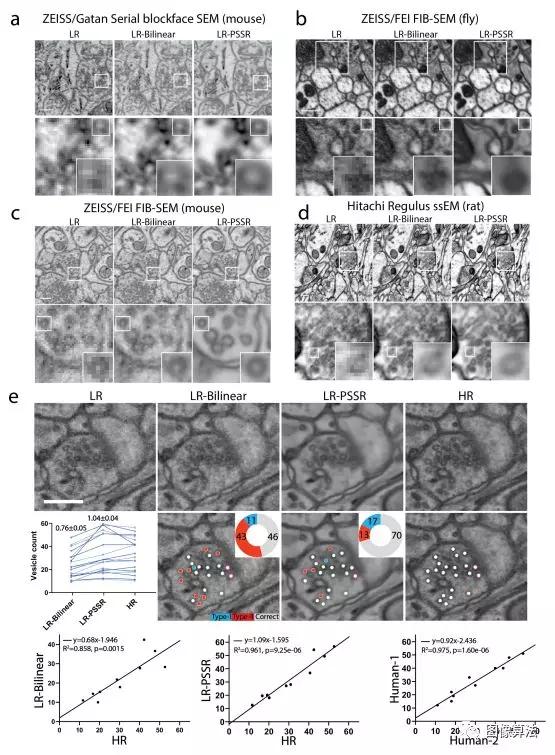

图2 | PSSR模型对于多种EM模态和样品类型有效

接下来,我们测试了使用PSSR是否可以将8 nm SBFSEM数据集充分恢复到2 nm,因为目前尚无法实现2 nm SBFSEM成像。使用我们的PSSR模型,我们能够将8 nm像素的SBFSEM 3D数据集恢复到2 nm(图2a)。值得注意的是,我们的PSSR模型在四个不同实验室的四个不同显微镜上成像的小鼠,大鼠和果蝇样品上也能很好地工作(图2a-d)。除了我们的SBFSEM和SEM成像系统外,PSSR处理似乎还可以恢复从蔡司FIB-SEM(来自Janelia Farms的Hess实验室,图2c,补充电影3)和日立Regulus FE-SEM(来自国立生理科学研究所的久保田实验室)。值得注意的是,PSSR图像更容易手动分割-正确分析的主要要求 3DEM数据集。

PSSR处理在分辨率为10x10x10 nm的FIB-SEM飞脑数据集上也表现良好,从而获得了具有更高SNR和分辨率的2 x 2 x 10 nm分辨率的数据集(图2b)。因此,PSSR可用于25倍的超级采样,并获得有用的结果,从而将FIB-SEM成像的横向分辨率和速度提高了至少25倍。

基于深度学习的图像处理的一个主要问题是准确性,尤其是误报的可能性。

如上所述,2nm像素SBFSEM数据集超出了我们的样本和检测器的功能,不包括为我们的SBFSEM数据生成地面真实性验证图像。鉴于需要能够信任不存在“基本事实”数据的已处理数据集,我们接下来决定使用基本事实数据来确定我们的PSSR输出是否足够准确,可用于有用的下游分析。为此,我们手动获取了超薄切片的低8 nm和高2 nm像素分辨率的SEM图像对,然后使用双线性插值(LR)对8 nm像素图像(LR)到2 nm像素图像(HR)进行16倍超采样。双线性)或PSSR(LR-PSSR)。然后,我们测量了LR-Bilinear和LR-PSSR的PSNR和SSIM,发现LR-PSSR明显优于LRBilinear。为了在更具体的生物学环境中进一步测试PSSR输出的准确性和实用性,我们接下来将LR-Bilinear,LR-PSSR和HR图像随机化,然后将它们分发给两名盲人专家,以对突触前囊泡进行手动分割,既具有生物学意义,也很难通过8nm像素采集来检测。我们发现LR-PSSR分割比LR-Bilinear分割准确得多(图2e)。有趣的是,虽然LR PSSR输出将假阴性减少了〜300%,但LR-PSSR输出的“假阳性”数量比LR-Bilinear稍高。最重要的是,LR-PSSR和HR结果之间的方差与HR数据上两个专家人工结果之间的方差相似(图2e),这可能非常接近最大可能的准确性和精确度。两者合计,我们的数据表明PSSR是一种从8 nm分辨率采集中产生2 nm 3DEM数据的可行方法,揭示了重要的亚细胞结构,这些结构否则会在许多3DEM数据集中丢失。

为了生成地面实况训练和测试数据集,我们使用了ZEISS Airyscan LSM 880,这是一种先进的共聚焦显微镜,它使用32个探测器阵列和后处理像素重新分配以生成分辨率提高约1.7倍(约120 nm)的图像,并且SNR比标准共聚焦系统高8倍。所有的HR地面真相和训练数据都是用63倍物镜(至少2倍Nyquist像素大小(约50±10 nm))采集的,然后使用蔡司Zen软件对Airyscan进行处理(像素重新分配)。与我们的EM模型相似,半合成LR训练数据是通过对具有随机噪声和模糊的HR Airyscan图像进行计算退化而生成的。对于我们的LR测试数据,我们在PMT共焦检测器上以2.5 AU针孔获取了16倍低像素分辨率(170 nm)的图像,而无需进行任何其他图像处理。在HR和LR测试采集中,我们保持了相同的像素停留时间。我们还将LR采集的激光功率降低了4或5倍,从而使净激光剂量减少了约64倍至90倍(例如,激光功率降低了5倍,曝光时间缩短了16倍)产生的激光剂量要低90倍)。此外,我们的LR测试数据没有进行反卷积,并且使用的有效针孔尺寸比HR Airyscan地面真相数据大得多。因此,需要将低分辨率,低SNR,欠采样共聚焦图像恢复为过采样,高SNR,高分辨率Airyscan图像质量。首先,我们对U2OS细胞中线粒体的活细胞延时进行了训练。如预期的那样,以全分辨率(〜49 nm像素)成像会导致显着的漂白和光毒性引起的线粒体肿胀和裂变(补充电影5)。但是,由于欠采样,LR(〜196 nm像素)的采集非常嘈杂并且像素化。另一方面,当以相同的帧频和持续时间成像时,LR扫描显示的光致漂白要少得多。PSSR处理降低了噪声并提高了LR采集的分辨率,这是通过在半合成和现实世界的低分辨率和高分辨率图像对上进行测试确定的(图3b-c)。为了进一步改善延时摄影数据的PSSR性能,我们通过一次训练5个时间点(MultiFrame-PSSR或“ PSSR-S”,利用实时成像数据的连续性和PSSR ResU-Net架构的多维功能) MF”,图3a)。

图3 | 多帧PSSR共焦至Airyscan线粒体动力学的超分辨率时移。

通过PSNR,SSIM和NanoJ-SQUIRREL误差映射测量,与原始输入(LR),16倍双线性内插输入(LR-)相比,LR采集(LR-PSSR-MF)的PSSR-MF处理显示出显着提高的分辨率和SNR。双线性或单帧PSSR(LR PSSR-SF)(图3b-c)。因此,对于所有延时PSSR,我们使用PSSR-MF并将其在本文的其余部分中称为PSSR。改进的速度,分辨率和SNR使我们能够检测在LR或LRBilinear图像中无法检测到的线粒体裂变事件(黄色箭头,图3d)。另外,在HR采集期间相对较高的激光剂量引起了关于观察到的裂变事件是否是光毒性伪像的问题。

因此与使用常规共焦光学器件和检测器的标准高分辨率Airyscan成像相比,PSSR提供了机会以极低的光毒诱发伪像检测非常快的线粒体裂变事件。除了光毒性问题外,HR扫描共聚焦成像的慢速还会导致快速移动的结构(例如神经元中的运动性线粒体)的时间欠采样。但是相对较快的LR扫描不能提供足够的像素分辨率或SNR来解决裂变或融合事件,或者当单个线粒体沿着轴突彼此通过时可能会导致错误的分析或数据解释。因此,我们接下来测试了PSSR是否能充分恢复神经元线粒体运输中欠采样的延时成像。PSSR提供的整体分辨率和SNR改善使我们能够解决轴突中移动的邻近线粒体以及线粒体裂变和融合事件(图4a和4c)。由于我们的LR采集速率比HR快16倍。

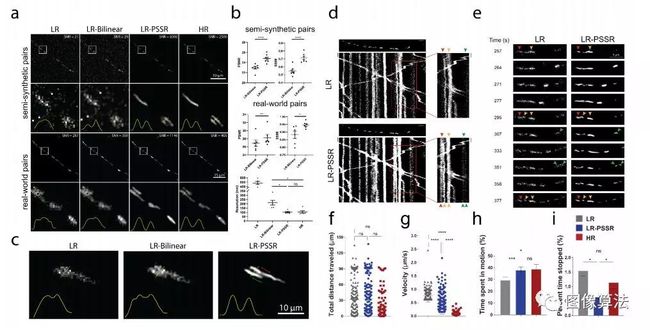

图4 | 神经元线粒体运动的时空分析

因此在LR-PSSR中保留了即时运动细节,而在HR图像中却丢失了这些信息(图4d)。LR和HR线粒体在轴突中移动的总距离相同(图4f)。但是,通过以高16倍的帧频进行成像,我们能够获得有关它们如何移位的独特信息(图4g)。有趣的是,与LR和HR图像相比,在LR-PSSR中识别的速度范围更大。总体而言,LR-PSSR和HR为线粒体运动所花费的时间百分比提供了相似的值(图4h)。在我们的LR-PSSR图像中更容易检测到较小的行进距离,因此,在我们的LR-PSSR数据中,线粒体在停止位置花费的时间百分比总体上减少了(图4i)。综上所述,这些数据表明PSSR提供了一种检测关键生物学事件的方法,而使用标准HR或LR成像在我们的共聚焦系统上是不可能的。

方法

半合成训练图像生成

使用扫描电子或Airyscan共聚焦显微镜获取HR图像。由于所获取的HR图像中图像属性(例如格式,大小,动态范围和深度)的差异,数据清理对于生成可在训练期间轻松访问的训练集必不可少。在本文中,我们将“数据源”和“数据集”的概念区分开来,其中数据源是指未清洗的采集的高分辨率图像,而数据集是指从数据源生成和预处理的图像。HR数据集是在对来自数据源的HR图像进行预处理之后获得的,而LR数据集是使用“ crappifier”功能从HR数据集生成的。

预处理

从HR数据源的图像堆栈中的每个帧中随机裁剪了预定义尺寸(例如256 x 256和512 x 512像素)的图块。所有图块均以.tif格式另存为单独的图像,这些图像一起形成了HR数据集。

图像压缩

然后使用“粉碎器”将HR数据集综合降级为LR图像,目的是逼近直接在同一视场下拍摄的同一视场的现实世界中低分辨率和低SNR图像中不希望的和不可避免的像素强度变化。成像系统。这些人力资源图片以及其损坏的对应图片用作培训对,以促进“取消应用”。贴图功能可以很简单,但是可以从实质上改善PSSR输出的质量和特性。

在像素分辨率下对图像集进行16倍下采样之前,图像集会从0标准化到1(例如,将1000 x 1000像素的图像下采样至250 x 250像素)。为了模拟在实际点扫描成像系统上由16倍欠采样引起的图像质量下降,将具有指定局部方差的椒盐噪声和高斯加性噪声随机注入高分辨率图像中。然后将降级的图像重新缩放为8位,以便使用常规图像分析软件进行查看。

EM Crappifier

注入了随机的高斯分布加性噪声, 然后使用1阶样条插值对降级的图像进行降采样。

MitoTracker和神经元线粒体Crappifier

MitoTracker和神经元线粒体数据的崩溃遵循类似的过程。椒盐噪声被随机注入每个图像像素的0.5%中,并用噪声替换,然后注入随机的高斯分布加性噪声(782 = 0,782 = 5)。然后使用1阶样条插值对interpolation缩的图像进行降采样。

数据扩充

生成残缺的低分辨率图像后,我们使用了诸如随机裁剪,二面仿射功能,旋转,随机缩放之类的数据增强技术来增加训练数据的种类和大小24。

多框架训练对

与固定样本的成像数据不同,在固定样本的成像数据中,我们使用传统的一对一高分辨率图像和低分辨率图像作为训练对,对于延时电影,连续五个帧合成为五张LR图像,再加上时间HR中间帧 形成五对一的训练“对”。五对一训练“对”的设计利用了动态生物学行为的时空连续性。

神经网络

单帧神经网络(PSSR-SF)

基于ResNet的U-Net被用作我们的卷积神经网络进行训练25。我们的U-Net采用具有跳过连接的编码器-解码器的形式,其中编码器逐渐缩小输入图像的大小,然后解码器将图像重新采样回其原始大小。对于EM数据,我们利用ImageNet上预训练的ResNet作为编码器。对于解码器的设计,

多帧神经网络(PSSR-MF)

类似的但经过稍微修改的U-Net用于延时电影训练。重新设计了输入层以同时拍摄五帧,而最后一层仍产生一帧作为输出。

训练细节

损失函数:MSE损失用作我们的损失函数。

优化方法:实施了具有重新启动的随机梯度下降(SGDR)。

循环学习率和动量:我们没有采用随着训练收敛而逐渐降低的学习率,而是采用循环学习率,在上限和下限之间循环,这有助于向更高的学习率振荡,从而避免了超维训练损失空间中的鞍点。

渐进式调整大小(仅用于EM数据):在EM模型的训练期间应用了逐步调整大小。

区分学习率(仅用于EM数据):为了更好地保存以前学习的信息,在每轮培训中都采用了区分学习,以进行微调。

最佳模型保存(仅用于荧光数据)。

消除平铺工件。由于图形卡的内存限制,测试图像在输入到我们的模型之前通常需要裁剪成较小的平铺。

评估指标

PSNR和SSIM量化

SNR量化

实验环境

PyTorch在两个NVIDIA TITAN RTX GPU上生成的,实验是使用NVIDIA Tesla V100,NVIDIA Quadro p6000,NVIDIA Quadro M5000,NVIDIA Titan Vs,NVIDIA GeForce GTX 1080或NVIDIA GeForce RTX 2080Ti GPU进行的

论文地址或源码下载地址:关注“图像算法”微信公众号 回复"PSSR"