生成对抗网络的评价指标的实验研究

摘要:

评价生成对抗网络(GANs)本身就是具有挑战的。在本文中,我们重新审视了几种典型的基于样本的生成对抗网络的评价指标,并且处理了如何评价评价指标这个问题。我们从指标的几个必要条件开始,来产生有意义的分数,比如从生成的样本中分辨出真实样本,识别模式丢失和模式坍塌,以及检测过拟合。在一系列精心设计的试验中,我们全面地研究了现有的基于样本的指标,并且鉴别了他们在实际设定中的长处和局限性。基于这些结果,我们注意到,核最大平均差异(MMD)和1-最近邻居双样本测试似乎满足了大多数想要的特性,提供了在合适的特征空间计算的样本间的距离。我们的实验也揭示了一些流行的GAN模型的行为的有趣的属性,比如它们是否记忆了训练样本,以及它们距离学习的目标分布有多远。

本文并没有提出任何的框架,只是探索了基于样本的一些GAN的评价指标,提出了量化评价GAN生成图片好坏的指标,应该具有哪些特性,并通过实验对比了现有的评价指标的优缺点,同时探究了评价指标局限性的原因所在。文中仅仅探究了基于有限样本的对于GAN的评价指标。

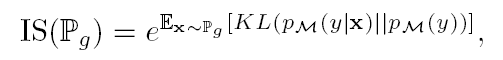

Inception Score这个评价指标数值越高,表明生成图片的质量越高,并且越具有多样性。

Kernel MMD(Maximum Mean Discrepancy)

这个评价指标是用固定的内核函数k,来测量两个分布之间的差异度。 这个指标的数值越低,表明生成的图片越接近真实图片,也就表明生成的图片的质量越好。

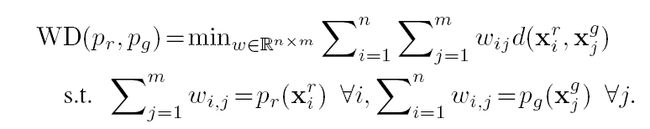

Wasserstein distance

这个评价指标也是测度的两个分布之间的差异度。 对于离散的分布,在实际应用中,WD一般被用作Earth Mover’s Distance 这个评价指标也是越小,表明生成的图片和真实图片越像,意味着生成的图片质量越好。

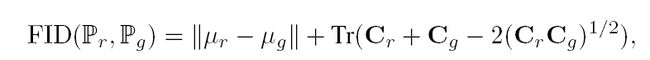

The Fréchet Inception Distance (FID)

这个评价采用了一个特征函数,将原来的分布映射成高斯随机变量,然后来计算两个高斯分布之间的Fréchet distance。

这个评价指标也是越小,表示生成的图片越接近真实图片,因而说明生成的图片质量越好。

The 1-Nearest Neighbor classifier

这个评价标准是用两个样本的测试来估计两个分布是否为同一个分布的。其采用的原来是1个最近邻分类方法,也就是一个样本所属的类别,是由距离其最近的1个样本所决定的。让真实的图片为正样本,生成的图片为负样本,这样通过1-NN分类器分类得到的结果的准确率就是这个评价指标的内容。这个评价指标被近一步划分为1-NN accuracy (real)指的是这个分类器在划分真实样本中的准确率,以及1-NN accuracy (fake)指的是这个分类器在划分生成样本中的准确率。

假设GAN发生了模式崩塌,也就是GAN只会生成真实图片中的很少量类别(比如一个类或者两个类)的图片,那么其1-NN accuracy (real)会变得很低,这是因为GAN崩塌的少量的类别中,一个真实样本可能被大量生成的样本包围,导致这些类别中所有样本都被分类为负样本,因此致使其准确率为0,那么平均起来,自然准确率会降低;而与此同时1-NN accuracy (fake)会变得较高,因为所有的样本都集中在了一两个类中,可能一个生成的样本周围有多个与其类似的生成样本,因而导致负样本基本都被正确的分类为负样本。

文中就测试了上述的集中,基于样本来评估GAN生成图片的评估标准。但也有其他不是基于样本来评估GAN生成图片的评估标准,文中介绍了几种,并没有在实验中进行评价。

文章实验设计部分,首先讨论了度量图片的距离的问题,不应该采用图片的像素空间来进行距离的计算,而是应该采用卷积网络提取的特征来进行距离计算,因为这样的特征,一般对于很多变化是不变的(比如光照变化,旋转等等)。

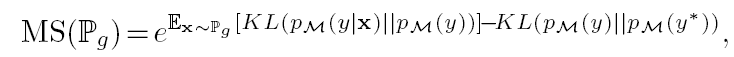

为了统一所有评价指标,文中处理了Inception Score和Mode Score,处理后的评价指标的缩写分别为RIS(relative inverse Inception Score)和RMS(relative inverse Mode Score)。两者处理方式类似,计算真实的训练集的图片的Inception Score作为IS0,那么RIS=(1-IS/IS0)。这样处理之后,这两个评价指标也是数值越小,表明生成的图片越好。

文中从如下几个方面分别对于上述的评价指标进行了评价:分辨力,对于转换的鲁棒性,效率,对于过拟合的发现能力。

对于评价指标的分辨力,文中考察了各个指标,分辨真实样本和生成样本的能力;发现模型发生模式崩塌的能力;以及发现模型发生模式丢失的能力。

评价各个指标对于真实样本和生成样本的分辨能力设计的实验是,用2000真实图片作为训练样本,然后每个指标评价的是一个由2000张图片组成的混合集合,Sg(t),其中t表明生成的图片在该集合中的占比。随着t的增加,各个评价指标数值应该是逐渐增加的,其实验结果如下:可以从图中看出,在像素空间的结果,差异比较大,有些比较好,有些比较差;但在卷积空间,RIS和RMS在LSUN数据集上出现了随着数据集中生成图片增加,数值降低的情况(也就是说在这个数据集上分辨真假能力不足);无论在像素空间,还是卷积空间,WD距离都不能很好的区别真假(数值几乎保持不变)。

作者认为出现上述错误结果的原因如下:对于RIS和RMS,很可能是因为生成的图片其类别与ImageNet上的类别不太合适(也就是说生成图片不能很好的归类到ImageNet上的某一类中去)导致了这个评价指标发生错误;对于WD距离出现错误的原因可能是样本的数量不够。

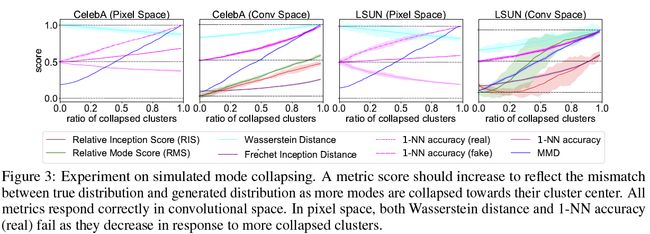

对于评价指标分辨模式坍塌的能力,文中定义的模式坍塌,是真实数据集中的不同模式的数据,被模型平均到了一个模式中。评价这样的情况的发生,并不能用GAN来生成图片,因为无法知道什么时候发生了模式坍塌,于是作者采用了如下操作模拟模式坍塌的发生。Sr是有2000张真实图片,Sr’也是有2000张真实图片,但不与Sr重复。然后在训练集中(估计是Sr’)用k-means算法找到50个簇类,并逐步将每个类用其类中心替代,从而模拟模式坍塌的情况。实验结果如下所示,在卷积空间,所有的评价指标都正确的反映了图片质量下降的情况;在像素空间,WD距离发生了错误,并且认为发生模式坍塌的样本集比真实样本集的图片更为真实。

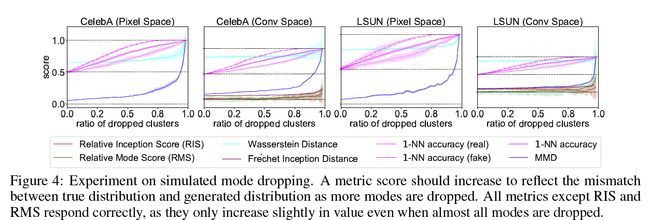

对于评价指标分辨模式丢失的能力,文中定义模式丢失,是真实数据集中一些难以表达的模式,被生成模型忽略(也就是不存在那些复杂模式的图片)。这样的情况,依旧不能直接用GAN来生成,只能模拟。文中设计的模拟过程为,Sr为2000张真实图片,Sr’用k-means找到50个簇类(如上个实验一样),然后随机的去除簇类,但是为了保证Sr’数据集的大小保持不变,去除的类用随机选择的其他类中图片取代,以保持总量不变。最终的实验结果如下:所有的评价指标都能分辨出模式丢失的情况,除了RIS和RMS两个评价指标。作者认为这种情况,还是因为这两个评价指标分类是与ImageNet类别相关,不具有很好的泛化性。

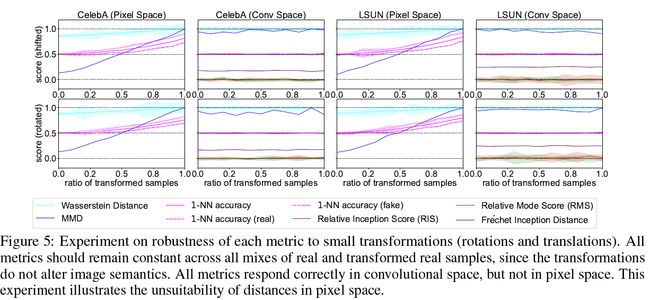

对于转换的鲁棒性

文中认为,对于一个理想的评价指标,应该在一定程度上对于图片的变化鲁棒(比如图片移动几个像素或者旋转了很小的角度)。实验设计为Sr是2000张真实图片,Sr’也是2000张与Sr不同的真实图片,并且一定比例的Sr’中的图片被随机移动(最多4个像素)或者旋转(最多15度)。实验结果如下图,所有的评价标准在卷积空间中变动很小,而在像素空间变化较大。因此这个实验其实说明了评价指标对于转换鲁棒,主要是选择好评价的输入空间,比如选择本身就对旋转移动不变的卷积空间。

效率

文中主要从样本效率和计算效率两个方面,讨论了各个评价指标的效率问题。

对于样本效率,文中认为是使用n个样本,使得评价指标能把真实样本与生成样本区分开来。因而实验使用了三个数据集,Sg是生成的样本集合,Sr’是真实样本的集合,Sr是与Sr’互斥的真实样本集。三个样本集的数量都是n,而n为一个变量。这样分别评价p(Sr,Sr’)以及p(Sr,Sg),当前者分数低于后者,说明能够区分真假样本。

实验结果可以看出,MMD,FID,1-NN三个评价标准(文中的介绍,其实可以看到RMS也能够分辨出)能够在相对较少的样本情况下区分真假样本。WD距离在样本少于1000的情况下,无法区分两者。RIS在实验中出现了认为生成的样本比真实样本更“真”的评价结果。

计算效率的评价,直接用的样本数,跟计算时间画出的实验图。可以从图中看出,MD距离计算效率相比其他的评价指标略低。

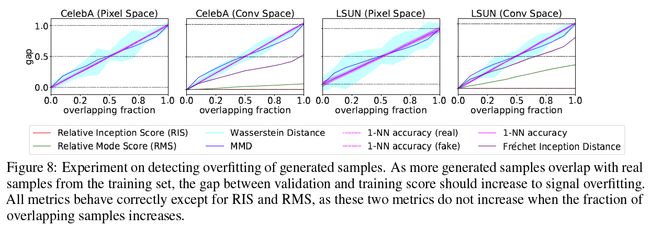

检测过拟合的能力

这个实验的设计涉及到三个数据集,一个是Sr_tr为训练数据集(实际上按照文中描述,这个实验应该没有进行GAN的训练),一个验证集Sr_val,最后一个是由Sr_tr中的数据和不属于Sr_tr以及Sr_val中的真实数据混合的集合,这个集合被看做了是GAN生成的数据(模拟),实验结果中横坐标就是混合的比例。因为作者认为发生过拟合,就是GAN模型记录下了训练集中所有的数据,也就是生成数据中出现了大量和训练数据一样的数据。其最终的实验结果如下:从图中可以看出RIS没有检测出过拟合的发生,而RMS在文中被作者认为也没有检测出过拟合(应该是小于0.5这个阈值)。

结论:

Inception Score这个评价指标与生成的图片的质量和多样性比较相关,但是其实际上分数更高的图片是一些锐利并且多样化的图片,而并不是表示的生成的图片与真实图片之间的关系的程度(两个分布之间的相似性等)。Mode Score也是一样的。

Kernel MMD在卷积特征空间,用预训练的ResNet提取特征来进行评价,能将生成的图片与真实图片区分开,并且样本复杂度和计算复杂度较低,因而很适用于实际应用。

Wasserstein distance这个评价指标的样本复杂度和计算复杂度都较高,因而不太实用。

Fréchet Inception Distance这个评价指标在分辨力,鲁棒性和效率上都表现不错,对于GAN的评价是个不错的评价指标。

1-NN classifier这个评价指标是个对于GAN评价的理想评价指标。

这篇文章提供了PyTorch的实现代码

https://github.com/xuqiantong/GAN-Metrics