收纳进此专辑:I/O流官方中文指南系列概述及索引

内容参考: 知乎 @胖胖 ,

深入分析 Java I/O 的工作机制,

深入分析 Java 中的中文编码问题,

字符编码笔记:ASCII,Unicode和UTF-8

作者: @youyuge

个人博客站点: https://youyuge.cn

一、字节与字符

首先明确“字节(Byte)”和“字符(Character)”的大小:

- 1 byte = 8 bit

- 1 char = 2 byte = 16 bit (Java默认UTF-16编码)

虽然1 bit才是数据真正的最小单位,但1 bit 的信息量太少了。要表示一个有用的信息,需要好几个bit一起表示。所以除了硬件层面存在1个比特位的寄存器,大多数情况下,字节是数据最小的基本单位。我们熟知的基本型的大小都是8 bit(也就是1字节)的整数倍:

- boolean: 1 byte

- short: 2 byte

- int: 4 byte

- float: 4 byte

- long: 8 byte

- double: 8 byte

二、为何要编码

要回答这个问题必须要回到计算机是如何表示我们人类能够理解的符号的,这些符号也就是我们人类使用的语言。由于人类的语言有太多,因而表示这些语言的符号太多,无法用计算机中一个基本的存储单元—— byte 来表示,因而必须要经过拆分或一些翻译工作,才能让计算机能理解。我们可以把计算机能够理解的语言假定为英语,其它语言要能够在计算机中使用必须经过一次翻译,把它翻译成英语。这个翻译的过程就是编码。所以可以想象只要不是说英语的国家要能够使用计算机就必须要经过编码。这看起来有些霸道,但是这就是现状,这也和我们国家现在在大力推广汉语一样,希望其它国家都会说汉语,以后其它的语言都翻译成汉语,我们可以把计算机中存储信息的最小单位改成汉字,这样我们就不存在编码问题了。

所以总的来说,编码的原因可以总结为:

- 计算机中存储信息的最小单元是一个字节即 8 个 bit,所以能表示的字符范围是 0~255 个

- 人类要表示的符号太多,无法用一个字节来完全表示

- 要解决这个矛盾必须需要一个新的数据结构 char,从 char 到 byte 必须编码

三、各类编码规范

3.1 ASCII

我们知道,在计算机内部,所有的信息最终都表示为一个二进制的字符串。每一个二进制位(bit)有0和1两种状态,因此八个二进制位就可以组合出256种状态,这被称为一个字节(byte)。也就是说,一个字节一共可以用来表示256种不同的状态,每一个状态对应一个符号,就是256个符号,从0000000到11111111。

上个世纪60年代,美国制定了一套字符编码,对英语字符与二进制位之间的关系,做了统一规定。这被称为ASCII码,一直沿用至今。

ASCII码一共规定了128个字符的编码,比如空格"SPACE"是32(二进制00100000),大写的字母A是65(二进制01000001)。这128个符号(包括32个不能打印出来的控制符号),只占用了一个字节的后面7位,最前面的1位统一规定为0。

3.2 ISO-8859-1

但西方世界不光只有英语一门语言。什么德语,法语,西班牙语都有自己的特殊字母。但这也没什么大不了的。每个国家都可以定义属于自己语言的特殊编码标准,而且大小照样不超过256。因为ASCII码中本身就有很多空码位没有使用。

128 个字符显然是不够用的,于是 ISO 组织在 ASCII 码基础上又制定了一些列标准用来扩展 ASCII 编码,它们是 ISO-8859-1~ISO-8859-15,其中 ISO-8859-1 涵盖了大多数西欧语言字符,所有应用的最广泛。ISO-8859-1 仍然是单字节编码,它总共能表示 256 个字符。

3.3 GB2312

它的全称是《信息交换用汉字编码字符集 基本集》,它是双字节编码,总的编码范围是 A1-F7,其中从 A1-A9 是符号区,总共包含 682 个符号,从 B0-F7 是汉字区,包含 6763 个汉字。但是还是远远不够不是吗?

3.4 GBK

全称叫《汉字内码扩展规范》,是国家技术监督局为 windows95 所制定的新的汉字内码规范,它的出现是为了扩展 GB2312,加入更多的汉字,它的编码范围是 8140~FEFE(去掉 XX7F)总共有 23940 个码位,它能表示 21003 个汉字,它的编码是和 GB2312 兼容的,也就是说用 GB2312 编码的汉字可以用 GBK 来解码,并且不会有乱码。

这也是很多文件默认使用的编码,有时候打开文件中文变乱码了,这时候就需要规定编码方式为GBK。(比如eclipse打开别人的java文件,中文注释乱码了)

3.5 Unicode

需要注意的是,Unicode只是一个符号集,它只规定了符号的二进制代码,却没有规定这个二进制代码应该如何存储。

在出现Unicode之前,几乎每一种文字都有一套自己的编码方式。同一段“字节流”,在美帝可能是"hello world",到我们天朝就变成“锟斤拷” ,“烫烫烫”了。

ISO 试图想创建一个全新的超语言字典,世界上所有的语言都可以通过这本字典来相互翻译。可想而知这个字典是多么的复杂,关于 Unicode 的详细规范可以参考相应文档。

最初,每个字符占用2个字节,总共65535个字符空间。从第四版开始加入的“扩展字符集”开始使用4个字节(32 bit)编码。目前Unicode收录的字符规模大概在12万左右。

比如,把“尤”这个字符转换成Unicode编码则为:

3.6 UTF-16

编码里最容易搞混的一件事就是:Unicode只是一套符号的编码。但计算机具体怎么读取这套编码,又是另外一件事。

UTF-16 具体定义了 Unicode 字符在计算机中存取方法。UTF-16 用两个字节来表示 Unicode 转化格式,这个是定长的表示方法,不论什么字符都可以用两个字节表示,两个字节是 16 个 bit,所以叫 UTF-16。UTF-16 表示字符非常方便,每两个字节表示一个字符,这个在字符串操作时就大大简化了操作,这也是 Java 以 UTF-16 作为内存的字符存储格式的一个很重要的原因。

字符串“I am 君山”用 UTF-16 编码,下面是编码结果:

注意:因为Java中char默认就是UTF-16编码,所以下面的char[]字符串是两个字节表示一个字符。

用 UTF-16 编码将 char 数组放大了一倍,单字节范围内的字符,在高位补 0 变成两个字节,中文字符也变成两个字节。从 UTF-16 编码规则来看,仅仅将字符的高位和地位进行拆分变成两个字节。特点是编码效率非常高,规则很简单,但是这对于存储来说是极大的浪费,可以看到补了很多的0,文本文件的大小会因此大出二三倍,这是无法接受的。

3.7 UTF-8

互联网的普及,强烈要求出现一种统一的编码方式。UTF-8就是在互联网上使用最广的一种Unicode的实现方式。其他实现方式还包括UTF-16(字符用两个字节或四个字节表示)和UTF-32(字符用四个字节表示),不过在互联网上基本不用。

重复一遍,这里的关系是,UTF-8(或者UTF-16)是Unicode的实现方式之一。

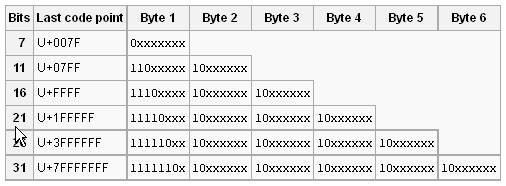

UTF-8最大的一个特点,就是它是一种变长的编码方式。它可以使用1~4个字节表示一个符号,根据不同的符号而变化字节长度。

UTF-8的编码规则很简单,只有二条:

对于单字节的符号,字节的第一位设为0,后面7位为这个符号的unicode码。因此对于英语字母,UTF-8编码和ASCII码是相同的。

对于n字节的符号(n>1),第一个字节的前n位都设为1,第n+1位设为0,后面字节的前两位一律设为10。剩下的没有提及的二进制位,全部为这个符号的unicode码。

我们再来看看字符串“I am 君山”用 UTF-8 编码:

可以看到没有补0,没有空间浪费,相对的,中文字用了3个字节存储。 “君”字UTF-8编码成 e5909b具体的编码过程为:

UTF-8 编码代码片段:

private CoderResult encodeArrayLoop(CharBuffer src,

ByteBuffer dst){

char[] sa = src.array();

int sp = src.arrayOffset() + src.position();

int sl = src.arrayOffset() + src.limit();

byte[] da = dst.array();

int dp = dst.arrayOffset() + dst.position();

int dl = dst.arrayOffset() + dst.limit();

int dlASCII = dp + Math.min(sl - sp, dl - dp);

// ASCII only loop

while (dp < dlASCII && sa[sp] < '\u0080')

da[dp++] = (byte) sa[sp++];

while (sp < sl) {

char c = sa[sp];

if (c < 0x80) {

// Have at most seven bits

if (dp >= dl)

return overflow(src, sp, dst, dp);

da[dp++] = (byte)c;

} else if (c < 0x800) {

// 2 bytes, 11 bits

if (dl - dp < 2)

return overflow(src, sp, dst, dp);

da[dp++] = (byte)(0xc0 | (c >> 6));

da[dp++] = (byte)(0x80 | (c & 0x3f));

} else if (Character.isSurrogate(c)) {

// Have a surrogate pair

if (sgp == null)

sgp = new Surrogate.Parser();

int uc = sgp.parse(c, sa, sp, sl);

if (uc < 0) {

updatePositions(src, sp, dst, dp);

return sgp.error();

}

if (dl - dp < 4)

return overflow(src, sp, dst, dp);

da[dp++] = (byte)(0xf0 | ((uc >> 18)));

da[dp++] = (byte)(0x80 | ((uc >> 12) & 0x3f));

da[dp++] = (byte)(0x80 | ((uc >> 6) & 0x3f));

da[dp++] = (byte)(0x80 | (uc & 0x3f));

sp++; // 2 chars

} else {

// 3 bytes, 16 bits

if (dl - dp < 3)

return overflow(src, sp, dst, dp);

da[dp++] = (byte)(0xe0 | ((c >> 12)));

da[dp++] = (byte)(0x80 | ((c >> 6) & 0x3f));

da[dp++] = (byte)(0x80 | (c & 0x3f));

}

sp++;

}

updatePositions(src, sp, dst, dp);

return CoderResult.UNDERFLOW;

}

3.8 ANSI

ANSI是默认的编码方式。对于英文文件是ASCII编码,对于简体中文文件是GB2312编码(只针对Windows简体中文版,如果是繁体中文版会采用Big5码)。

四、几种编码格式的比较

对中文字符后面四种编码格式都能处理,GB2312 与 GBK 编码规则类似,但是 GBK 范围更大,它能处理所有汉字字符,所以 GB2312 与 GBK 比较应该选择 GBK。

UTF-16 与 UTF-8 都是处理 Unicode 编码,它们的编码规则不太相同,相对来说 UTF-16 编码效率最高,字符到字节相互转换更简单,进行字符串操作也更好。它适合在本地磁盘和内存之间使用,可以进行字符和字节之间快速切换,如 Java 的内存编码就是采用 UTF-16 编码。但是它不适合在网络之间传输,因为网络传输容易损坏字节流,一旦字节流损坏将很难恢复,想比较而言 UTF-8 更适合网络传输,对 ASCII 字符采用单字节存储,另外单个字符损坏也不会影响后面其它字符,在编码效率上介于 GBK 和 UTF-16 之间,所以 UTF-8 在编码效率上和编码安全性上做了平衡,是理想的中文编码方式。

五、总结

- 总而言之,一切都是字节流,其实没有字符流这个东西。字符只是根据编码集对字节流翻译之后的产物。而编码集是人为规定的产物。