Kafka的灵魂伴侣Logi-KafkaManger(二)kafka针对Topic粒度的配额管理(限流)

申请配额(限流)

不了解kafak配额管理机制的可以先了解一下 kafka中的配额管理(限速)机制

默认创建完Topic之后是没有设置配额信息的,而且我们都知道Kafka的配额(限流)只支持三种粒度:

user + clientid

user

clientid

如果kafka集群没有开启身份认证,则只能使用clientid方式来进行限流。

但是KaFkaManager是可以支持到Topic粒度的; 假如你对kafka配额机制原理非常清楚的话,那么你就很容易理解KM是怎么实现的了:一言以蔽之, clientid+topic组成一个单独的clientId

当你需要对Topic限流的时候 就需要做如下操作了;

针对Topic粒度的配额如何生效的

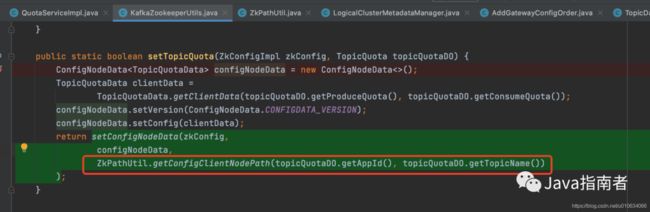

从代码中我们可以看到, 我们写入到 zk中的配额clients节点路径是 apppId.TopicName; 想要让配额生效, 那么我们在生产和消费Topic的时候, clientId 需要设置为apppId.TopicName的格式; 一个topic单独分配一个clientId; 这样看起来想要使用这个功能是不是还挺麻烦;但是滴滴的 kafka-gateway 帮我们实现了这个功能;

kafka-gateway: 这个是滴滴内部针对社区版kafka做了一些扩展,增强; 比如这个功能,kafka-gateway就帮我们自动解决了,不需要那么麻烦

当然我们也可以不用kafka-gateway,在每个Topic生产/消费那里根据上门的规则单独设置clientId

测试kafka限流是否成功

我们将Topic Test2的生产限流设置为0.000001

然后写一段发送消息的代码, 设置client.id = apppId.TopicName的格式; 然后不停的发送

@Test

void contextLoads() {

Properties props = new Properties();

props.put("bootstrap.servers", "xxxxx");

props.put("acks", "all");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("linger.ms", 1);

props.put("buffer.memory", 33554432);

props.put("client.id", "appId_000001_cn.Test2");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer producer = new KafkaProducer<>(props);

for(int i = 0; i < 50000000; i++){

producer.send(new ProducerRecord("Test2", Integer.toString(i), Integer.toString(i)));

}

producer.close();

}

这里的申请配额通过之后,实际上是去zk上更新了配置输入; 比如我申请配额为1M/s = 1024*1024=1048576kb

可以看到zk上的配置更新了