天池比赛---零基础入门推荐系统 - 新闻推荐【赛题理解+Baseline】

文章目录

- 一、赛题数据

-

- 1.数据表

- 2.结果提交

- 3.评分标准

- 二、赛题理解

-

- 1.赛题理解

- 2.赛题简介

- 3.数据概况

- 三、baseline

-

- 1.核心函数

- 2.结果提交

- 四、总结

一、赛题数据

如何开始一个比赛,先从分析比赛的数据开始。

赛题以预测用户未来点击新闻文章为任务,数据集报名后可见并可下载,该数据来自某新闻APP平台的用户交互数据,包括30万用户,近300万次点击,共36万多篇不同的新闻文章,同时每篇新闻文章有对应的embedding向量表示。为了保证比赛的公平性,将会从中抽取20万用户的点击日志数据作为训练集,5万用户的点击日志数据作为测试集A,5万用户的点击日志数据作为测试集B。

1.数据表

-

train_click_log.csv:训练集用户点击日志

-

testA_click_log.csv:测试集用户点击日志

-

articles.csv:新闻文章信息数据表

-

articles_emb.csv:新闻文章embedding向量表示

-

sample_submit.csv:提交样例文件

2.结果提交

提交前请确保预测结果的格式与sample_submit.csv中的格式一致,以及提交文件后缀名为csv。其格式如下:

user_id,article_1,article_2,article_3,article_4,article_5

其中user_id为用户id, article_1,article_2,article_3,article_4,article_5为预测用户点击新闻文章Top5的article_id依概率从高到低排序,例如:

user_id,article_1,article_2,article_3,article_4 ,article_5

200000,1 ,2,3,4,5

200001,1 ,2,3,4,5

200002,1 ,2,3,4,5

200003,1,2,3,4,5

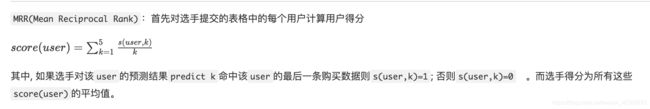

3.评分标准

二、赛题理解

1.赛题理解

赛题理解是切入一道赛题的基础,会影响后续特征工程和模型构建等各种工作,也影响着后续发展工作的方向,正确了解赛题背后的思想以及赛题业务逻辑的清晰,有利于花费更少时间构建更为有效的特征模型, 在各种比赛中, 赛题理解都是极其重要且必须走好的第一步, 今天我们就从赛题的理解出发, 首先了解一下这次赛题的概况和数据,从中分析赛题以及大致的处理方式, 其次我们了解模型评测的指标,最后对赛题的理解整理一些经验。

2.赛题简介

此次比赛是新闻推荐场景下的用户行为预测挑战赛, 该赛题是以新闻APP中的新闻推荐为背景, 目的是要求我们根据用户历史浏览点击新闻文章的数据信息预测用户未来的点击行为, 即用户的最后一次点击的新闻文章, 这道赛题的设计初衷是引导大家了解推荐系统中的一些业务背景, 解决实际问题。

3.数据概况

该数据来自某新闻APP平台的用户交互数据,包括30万用户,近300万次点击,共36万多篇不同的新闻文章,同时每篇新闻文章有对应的embedding向量表示。为了保证比赛的公平性,从中抽取20万用户的点击日志数据作为训练集,5万用户的点击日志数据作为测试集A,5万用户的点击日志数据作为测试集B。具体数据表和参数, 大家可以参考赛题说明。下面说一下拿到这样的数据如何进行理解, 来有效的开展下一步的工作。

三、baseline

1.核心函数

itemcf的物品相似度计算

def itemcf_sim(df):

"""

文章与文章之间的相似性矩阵计算

:param df: 数据表

:item_created_time_dict: 文章创建时间的字典

return : 文章与文章的相似性矩阵

思路: 基于物品的协同过滤(详细请参考上一期推荐系统基础的组队学习), 在多路召回部分会加上关联规则的召回策略

"""

user_item_time_dict = get_user_item_time(df)

# 计算物品相似度

i2i_sim = {

}

item_cnt = defaultdict(int)

for user, item_time_list in tqdm(user_item_time_dict.items()):

# 在基于商品的协同过滤优化的时候可以考虑时间因素

for i, i_click_time in item_time_list:

item_cnt[i] += 1

i2i_sim.setdefault(i, {

})

for j, j_click_time in item_time_list:

if(i == j):

continue

i2i_sim[i].setdefault(j, 0)

i2i_sim[i][j] += 1 / math.log(len(item_time_list) + 1)

i2i_sim_ = i2i_sim.copy()

for i, related_items in i2i_sim.items():

for j, wij in related_items.items():

i2i_sim_[i][j] = wij / math.sqrt(item_cnt[i] * item_cnt[j])

# 将得到的相似性矩阵保存到本地

pickle.dump(i2i_sim_, open(save_path + 'itemcf_i2i_sim.pkl', 'wb'))

return i2i_sim_

itemcf 的文章推荐

# 基于商品的召回i2i

def item_based_recommend(user_id, user_item_time_dict, i2i_sim, sim_item_topk, recall_item_num, item_topk_click):

"""

基于文章协同过滤的召回

:param user_id: 用户id

:param user_item_time_dict: 字典, 根据点击时间获取用户的点击文章序列 {user1: [(item1, time1), (item2, time2)..]...}

:param i2i_sim: 字典,文章相似性矩阵

:param sim_item_topk: 整数, 选择与当前文章最相似的前k篇文章

:param recall_item_num: 整数, 最后的召回文章数量

:param item_topk_click: 列表,点击次数最多的文章列表,用户召回补全

return: 召回的文章列表 {item1:score1, item2: score2...}

注意: 基于物品的协同过滤(详细请参考上一期推荐系统基础的组队学习), 在多路召回部分会加上关联规则的召回策略

"""

# 获取用户历史交互的文章

user_hist_items = user_item_time_dict[user_id]

user_hist_items_ = {

user_id for user_id, _ in user_hist_items}

item_rank = {

}

for loc, (i, click_time) in enumerate(user_hist_items):

for j, wij in sorted(i2i_sim[i].items(), key=lambda x: x[1], reverse=True)[:sim_item_topk]:

if j in user_hist_items_:

continue

item_rank.setdefault(j, 0)

item_rank[j] += wij

# 不足10个,用热门商品补全

if len(item_rank) < recall_item_num:

for i, item in enumerate(item_topk_click):

if item in item_rank.items(): # 填充的item应该不在原来的列表中

continue

item_rank[item] = - i - 100 # 随便给个负数就行

if len(item_rank) == recall_item_num:

break

item_rank = sorted(item_rank.items(), key=lambda x: x[1], reverse=True)[:recall_item_num]

return item_rank

给每个用户根据物品的协同过滤推荐文章

# 定义

user_recall_items_dict = collections.defaultdict(dict)

# 获取 用户 - 文章 - 点击时间的字典

user_item_time_dict = get_user_item_time(all_click_df)

# 去取文章相似度

i2i_sim = pickle.load(open(save_path + 'itemcf_i2i_sim.pkl', 'rb'))

# 相似文章的数量

sim_item_topk = 10

# 召回文章数量

recall_item_num = 10

# 用户热度补全

item_topk_click = get_item_topk_click(all_click_df, k=50)

for user in tqdm(all_click_df['user_id'].unique()):

user_recall_items_dict[user] = item_based_recommend(user, user_item_time_dict, i2i_sim,

sim_item_topk, recall_item_num, item_topk_click)

2.结果提交

# 生成提交文件

def submit(recall_df, topk=5, model_name=None):

recall_df = recall_df.sort_values(by=['user_id', 'pred_score'])

recall_df['rank'] = recall_df.groupby(['user_id'])['pred_score'].rank(ascending=False, method='first')

# 判断是不是每个用户都有5篇文章及以上

tmp = recall_df.groupby('user_id').apply(lambda x: x['rank'].max())

assert tmp.min() >= topk

del recall_df['pred_score']

submit = recall_df[recall_df['rank'] <= topk].set_index(['user_id', 'rank']).unstack(-1).reset_index()

submit.columns = [int(col) if isinstance(col, int) else col for col in submit.columns.droplevel(0)]

# 按照提交格式定义列名

submit = submit.rename(columns={

'': 'user_id', 1: 'article_1', 2: 'article_2',

3: 'article_3', 4: 'article_4', 5: 'article_5'})

save_name = save_path + model_name + '_' + datetime.today().strftime('%m-%d') + '.csv'

submit.to_csv(save_name, index=False, header=True)

# 获取测试集

tst_click = pd.read_csv(data_path + 'testA_click_log.csv')

tst_users = tst_click['user_id'].unique()

# 从所有的召回数据中将测试集中的用户选出来

tst_recall = recall_df[recall_df['user_id'].isin(tst_users)]

# 生成提交文件

submit(tst_recall, topk=5, model_name='itemcf_baseline')

四、总结

本博客只是简单的分享一些该赛题的解读和部分baseline代码,后续会继续更新,感谢关注,学习不易,继续加油!(另外想说一点天池实验室还是不错的,就是数据关联有点问题,免费提高的cpu和gpu还不错。)

记录时间:2020年11月25日