从0开始使用kubeadm快速搭建k8s集群

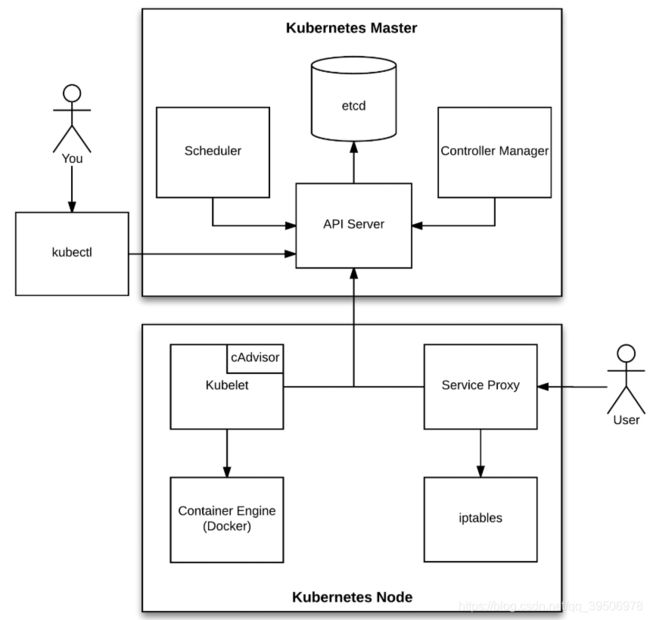

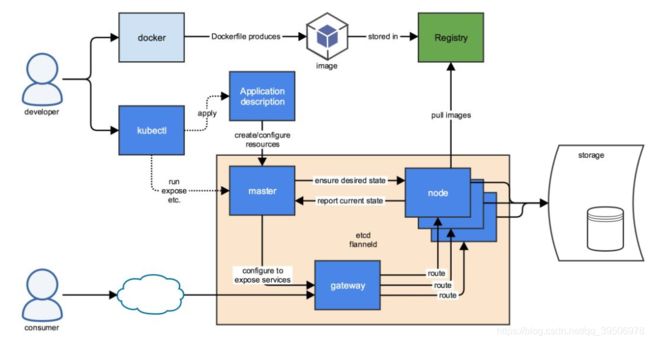

整体架构

推荐学习:

A. https://www.kuboard.cn/ ,也是基于kubeadm安装,提供了一个更nice的dashboard

B.https://www.kubernetes.org.cn/k8s 中文社区文档

一.准备工作(所有节点)

1.准备3台虚拟机(克隆)或物理机,1.5GB左右内存(如果资源有限,停止虚拟机其它没必要的服务,停止window没必要的应用,这里master1.5G,node1,node2均1G,勉强可玩),2个CPU及以上(如果1个CPU安装过程中会报错)

2.关闭防火墙:systemctl stop firewalld && systemctl disable firewalld

3.关闭selinux: sed -i 's/enforcing/disabled/' /etc/selinux/config && setenforce 0

4.关闭swap分区:swapoff -a;sed -ri 's/.*swap.*/#&/' /etc/fstab

5.修改hostname:hostnamectl set-hostname xxx ,分别改为master/node1/node2,并修改hosts文件/etc/hosts ,末尾追加

192.168.154.134 master

192.168.154.135 node1

192.168.154.136 node26.网络配置并使生效

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOFsysctl --system

二.所有节点安装Docker/kubeadm/kubelet

1.安装docker(1.13版本)或docker-ce(ce社区版)均可

#yum源

yum install -y wget && wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

#yum安装

yum -y install docker-ce-18.06.1.ce-3.el7

#启动并开机自启

systemctl enable docker && systemctl start docker

#配置镜像加速vim /etc/docker/daemon.json

{

"registry-mirrors": ["https://5c3uuctj.mirror.aliyuncs.com","https://hub-mirror.c.163.com", "https://reg-mirror.qiniu.com"]

}

#重启docker

systemctl restart docker2.安装kubeadm,kubelet和kubectl

# yum源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

# yum安装kubelet/kubeadm/kubectl

yum install -y kubelet-1.15.0 kubeadm-1.15.0 kubectl-1.15.0

#开机自启kubelet服务,kubeadm是临时的集群安装工具不需要加入自启服务,kubectl是操作k8s集群的命令,也不需要加入自启服务

systemctl enable kubelet

三.使用kubeadm初始化k8s集群(只在master 节点192.168.154.134执行)

这步比较慢,会安装mater节点的etcd,scheduler,apiserver,controller-manager等组件(docker容器)

kubeadm init \

--apiserver-advertise-address=192.168.154.134 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.15.0 \

--service-cidr=10.1.0.0/16 \

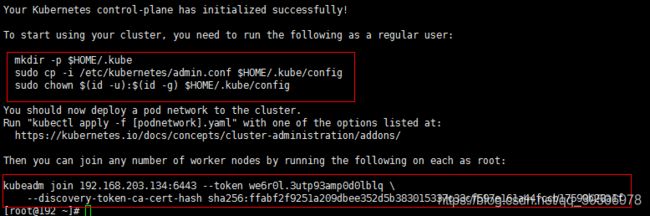

--pod-network-cidr=10.244.0.0/16按提示创建文件夹并修改文件夹所属用户,kubeadm join xxxx稍后再node1 node2这两个普通节点执行,类似docker swarm

安装flannel网络插件,配置文件

# 下载flannel的yml文件(下不了可使用这个大哥的https://www.lanzous.com/i8jjpij,该文件有点类似docker-compose.yml,里面的image可能拉取不了,可以把该配置项全部替换为lizhenliang/flannel:v0.11.0-amd64,建议直接拉lizhenliang/flannel:v0.11.0-amd64,再把它重新打个tag为需要的那个镜像名——docker tag lizhenliang/flannel:v0.11.0-amd64 quay.io/coreos/flannel:v0.11.0-ppc64le)

wget https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

# 执行这个文件生成flannel的pods

kubectl apply -f kube-flannel.yml

四、普通node1,node2加入k8s集群

kubeadm join 192.168.154.134:6443 --token 30mbdv.ocf1kju9qoh8uqem \

--discovery-token-ca-cert-hash sha256:97b3c71e5ae44f0c11a3de8ef65e5eef0d935315a7a1b6ec577a019b861914c3

加入失败尝试:iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X检查一下:kubectl get pods,可能因为网络,或虚拟机资源不够等原因造成普通node长时间NotReady状态

尝试重新加入集群

#在node1执行重置

kubeadm reset

#在master执行资源删除,语法:kubectl 操作 资源类型(node/service/pod等) 资源名

kubectl delete node node1

#重新执行加入集群

kubeadm join 192.168.154.134:6443 --token 30mbdv.ocf1kju9qoh8uqem \

--discovery-token-ca-cert-hash sha256:97b3c71e5ae44f0c11a3de8ef65e5eef0d935315a7a1b6ec577a019b861914c3如果要重置master

kubeadm reset -f

modprobe -r ipip

lsmod

rm -rf ~/.kube/

rm -rf /etc/kubernetes/

rm -rf /etc/systemd/system/kubelet.service.d

rm -rf /etc/systemd/system/kubelet.service

rm -rf /usr/bin/kube*

rm -rf /etc/cni

rm -rf /opt/cni

rm -rf /var/lib/etcd

rm -rf /var/etcd

yum remove -y kubelet-1.15.0 kubeadm-1.15.0 kubectl-1.15.0K8S命令较多,增强tab键提示:echo "source <(kubectl completion bash)" >> ~/.bashrc ,重新ssh登录

五,部署k8s nginx容器进行测试

创建一个nginx容器,暴露为nodePort,并扩容

#创建容器

kubectl create deployment nginx --image=nginx

#暴露为service,能通过NodePort直接访问,否则只能通过cluster-ip访问

kubectl expose deployment nginx --port=80 --type=NodePort

#查看服务

kubectl get pod,svc

#扩容

kubectl scale deployment nginx-deployment --replicas=2

#再次查看pod,可见有两个pod

kubectl get pod

查看pods,services

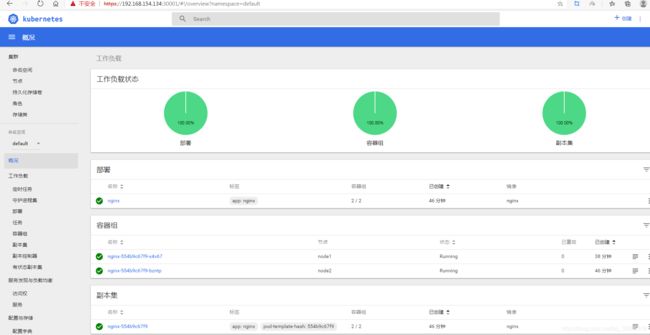

在node1,node2分可以看到均匀分配的两个Nginx

直接访问http://192.168.154.134:31379 或http://192.168.154.135:31379 或http://192.168.154.136:31379均可访问到该Nginx,但是会集中访问到某一Nginx实例,需要负载均衡则需要通过Nginx服务的CLUSTER-IP进行访问(curl 10.1.56.244,docker logs -f nginx的docker容器ID/NAME 查看node1,node2到nginx日志 或kubectl logs -f nginx的PodName查看日志)

六,安装K8S的dashboard,配置文件

#配置文件参考https://www.lanzous.com/i8jjpij

kubectl apply -f kube-dashboard.yml#查看服务,治理需要指明命名空间,默认的default查看不到该服务

kubectl get pods,services -n kube-system谷歌访问https://192.168.154.134:30001,必须是https

但页面无法访问,需要配置一下https证书

mkdir key && cd key

#生成证书

openssl genrsa -out dashboard.key 2048

#我这里写的自己的node1节点,因为我是通过nodeport访问的;如果通过apiserver访问,可以写成自己的master节点ip

openssl req -new -out dashboard.csr -key dashboard.key -subj '/CN=192.168.135.129'

openssl x509 -req -in dashboard.csr -signkey dashboard.key -out dashboard.crt

#删除原有的证书secret

kubectl delete secret kubernetes-dashboard-certs -n kube-system

#创建新的证书secret

kubectl create secret generic kubernetes-dashboard-certs --from-file=dashboard.key --from-file=dashboard.crt -n kube-system

#查看pod

kubectl get pod -n kube-system

#重启pod(删除pod,k8s会重新启动一个pod)

kubectl delete pod kubernetes-dashboard-78dc5f9d6b-zgvr6 -n kube-system

再次访问https://192.168.154.134:30001

访问dashboard可通过一个token进行访问

kubectl create serviceaccount dashboard-admin -n kube-system

kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

kubectl describe secrets -n kube-system $(kubectl -n kube-system get secret | awk '/dashboard-admin/{print $1}')效果预览,感觉没docker swarm那个功能强大

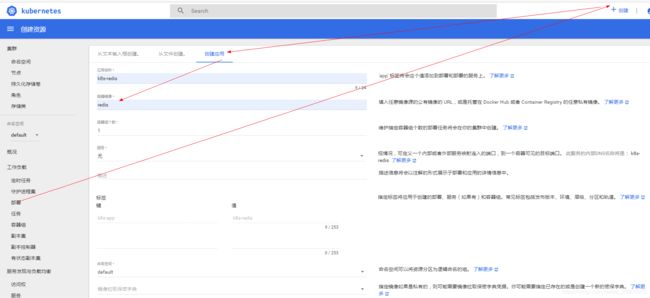

可进行副本集伸缩,新应用部署,操作类似docker swarm

对接CICD,从私库拉取微服务镜像进行部署

另一款非官方dashboard,感觉挺不错https://www.kuboard.cn/install/install-dashboard.html