android10以后的版本才完全支持深色模式,测试下面两种方法判断系统是否深色模式都是有效的。publicstaticbooleanisDarkMode1(){if(Build.VERSION.SDK_INT

【目标检测】机场内部目标检测数据集4106张YOLO+VOC格式

数据集格式:VOC格式+YOLO格式压缩包内含:3个文件夹,分别存储图片、xml、txt文件JPEGImages文件夹中jpg图片总计:4106Annotations文件夹中xml文件总计:4106labels文件夹中txt文件总计:4106标签种类数:7标签名称:["Ground_vehicles","Horizontal_sign","Runaway_limit","Taxiway","Ver

数字孪生技术为UI前端注入新活力:实现产品设计的沉浸式体验

ui设计前端开发老司机

ui

hello宝子们...我们是艾斯视觉擅长ui设计、前端开发、数字孪生、大数据、三维建模、三维动画10年+经验!希望我的分享能帮助到您!如需帮助可以评论关注私信我们一起探讨!致敬感谢感恩!一、引言:从“平面交互”到“沉浸体验”的UI革命当用户在电商APP中翻看3D家具模型却无法感知其与自家客厅的匹配度,当设计师在2D屏幕上绘制汽车内饰却难以预判实际乘坐体验——传统UI设计的“平面化、静态化、割裂感”

传统检测响应慢?陌讯多模态引擎提速90+FPS实战

2501_92473147

算法计算机视觉目标检测

开篇痛点:实时目标检测在安防监控中的核心挑战在安防监控领域,实时目标检测是保障公共安全的关键技术。然而,传统算法如YOLOv5或开源框架MMDetection常面临两大痛点:误报率高(复杂光照或遮挡场景下检测不稳定)和响应延迟(高分辨率视频流处理FPS低于30)。实测数据显示,城市交通监控系统误报率达15%,导致安保资源浪费;客户反馈表明,延迟超100ms时,目标跟踪可能失效。这些问题源于算法泛化

NGS测序基础梳理01-文库构建(Library Preparation)

qq_21478261

#生物信息生物学

本文介绍Illumina测序平台文库构建(LibraryPreparation)步骤,文库结构。写作时间:2020.05。推荐阅读:10W字《Python可视化教程1.0》来了!一份由公众号「pythonic生物人」精心制作的PythonMatplotlib可视化系统教程,105页PDFhttps://mp.weixin.qq.com/s/QaSmucuVsS_DR-klfpE3-Q10W字《Rg

Java设计模式实战:高频场景解析与避坑指南

mckim_

笔记学习java设计模式

引言设计模式是软件开发的基石,但许多开发者面对23种模式时容易陷入“学完就忘”或“滥用模式”的困境。本文从工业级项目视角出发,精选10种高频设计模式,结合真实代码案例与主流框架应用,帮你建立模式思维,拒绝纸上谈兵。一、创建型模式:告别new的暴力美学1.工厂方法模式(FactoryMethod)核心痛点:对象创建逻辑散落各处,难以统一管理。场景案例:电商平台需要支持多种支付方式(支付宝、微信、银联

LeetCode Hot 100 回文链表

源

leetcode链表算法

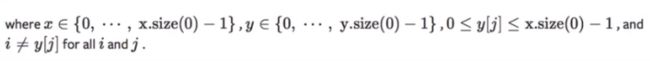

给你一个单链表的头节点head,请你判断该链表是否为回文链表。如果是,返回true;否则,返回false。示例1:输入:head=[1,2,2,1]输出:true示例2:输入:head=[1,2]输出:false提示:链表中节点数目在范围[1,105]内0vals;while(head!=nullptr){vals.emplace_back(head->val);head=head->next;}

自动化运维工程师面试题解析【真题】

ZabbixAgent默认监听的端口是A.10050。以下是关键分析:选项排除:C.80是HTTP默认端口,与ZabbixAgent无关。D.5432是PostgreSQL数据库的默认端口,不涉及ZabbixAgent。B.10051是ZabbixServer的默认监听端口,用于接收Agent发送的数据,而非Agent自身的监听端口。ZabbixAgent的配置:根据官方文档,ZabbixAgen

javaSE面试题---语法基础、面向对象、常用类、集合、多线程、文件和IO

yang_xiao_wu_

java面试开发语言javasejava基础多线程文件和IO

目录语法基础1.jdkjrejvm区别2.基本数据类型3.引用数据类型4.自动类型转换、强制类型转换5.常见的运算符6.&和&&区别7.++--在前和在后的区别8.+=有什么作用9.switch..case中switch支持哪些数据类型10.break和continue区别11.while和dowhile区别12.如何生成一个取值范围在[min,max]之间的随机数13.数组的长度如何获取?数组下

【DBC】DBC中CAN信号多路复用

徐饼干

DBC程序人生其他经验分享

DBC文件信号多路复用详解1何时定义有些信号比较长,但是又不常用,就可以定义多路复用信号以节约空间。2具体定义2.1定义一个短信号来当做“控制开关”。【若定义1bit,则有2种可能0x00和0x01,复用两路】【若定义2bit,则有4种可能0x00和0x01和0x10和0x11,复用四路】…所以说,这个短信号的长度和你想复用多少路有关,多长?放在什么位置?由定义者决定2.2节约空间是如何体现的现在

pythonjson中list操作_Python json.dumps 特殊数据类型的自定义序列化操作

场景描述:Python标准库中的json模块,集成了将数据序列化处理的功能;在使用json.dumps()方法序列化数据时候,如果目标数据中存在datetime数据类型,执行操作时,会抛出异常:TypeError:datetime.datetime(2016,12,10,11,04,21)isnotJSONserializable那么遇到json.dumps序列化不支持的数据类型,该怎么办!首先,

树莓派 5 - Raspberry Pi OS 新版本 Bookworm(书虫)

kuan_li_lyg

树莓派&Jetson教程机器人stm32嵌入式硬件自动驾驶ROS树莓派raspberrypi

文章目录在这里插入图片描述版本说明前言二、PipeWire三、Networking四、Firefox五、Documentation六、What’smissing? 新版本下载地址为:https://www.raspberrypi.com/software/operating-systems/版本说明 2023-10-10:基于Debianbookworm版本支持树莓派5在RaspberryPi4和

h5-video标签全屏显示记录

ZhDan91

前端开发混合app

video{width:100%;height:100%;object-fit:fill;}

自测魅族手机webview加载h5时ul嵌套li标签js失效问题记录

ZhDan91

混合app前端开发

自测魅族手机ul嵌套li标签js失效问题:可采用div嵌套option实现样式:.hot_list{width:100%;display:flex;flex-wrap:wrap;justify-content:space-between;}.hot_listoption{text-align:center;width:30%;padding:.16rem.34rem;border:0.1remso

在 Windows 上安装 Docker Desktop

不老刘

人工智能windowsdocker容器

还是简单说一下,如何在Windows上安装DockerDesktop,具体步骤如下:系统要求Windows10/1164-bit(专业版、企业版或教育版,版本21H2或更高)启用WSL2(WindowsSubsystemforLinux2)或Hyper-V至少4GB内存BIOS中启用虚拟化(VT-x/AMD-V)安装步骤1.下载DockerDesktop访问Docker官网下载页面。下载Docke

剑指offer-12、数值的整数次方

java

题⽬描述给定⼀个double类型的浮点数base和int类型的整数exponent。求base的exponent次⽅。保证base和exponent不同时为0。示例1:输⼊:2.00000,3返回值:8.00000示例2:输⼊:2.10000,3返回值:9.26100思路及解答暴力求解如果使⽤暴⼒解答,那么就是不断相乘,对于负数⽽⾔,则是相除,并且符号取反。publicclassSolution{

苦练Python第9天:if-else分支九剑

python后端前端人工智能

苦练Python第9天:if-else分支九剑前言大家好,我是倔强青铜三。是一名热情的软件工程师,我热衷于分享和传播IT技术,致力于通过我的知识和技能推动技术交流与创新,欢迎关注我,微信公众号:倔强青铜三。欢迎点赞、收藏、关注,一键三连!!!欢迎来到100天Python挑战第9天!今天我们不练循环,改磨“分支剑法”——ifelse三式:单分支、双分支、多分支,以及嵌套和三元运算符,全部实战演练,让

苦练Python第8天:while 循环之妙用

python后端前端人工智能

苦练Python第8天:while循环之妙用原文链接:https://dev.to/therahul_gupta/day-9100-while-loops-with-real-world-examples-528f作者:RahulGupta译者:倔强青铜三前言大家好,我是倔强青铜三。是一名热情的软件工程师,我热衷于分享和传播IT技术,致力于通过我的知识和技能推动技术交流与创新,欢迎关注我,微信公众

苦练Python第5天:字符串从入门到格式化

python后端人工智能前端

苦练Python第5天:字符串从入门到格式化原文链接:https://dev.to/therahul_gupta/day-5100-working-with-strings-basics-to-formatting-2kkn作者:RahulGupta译者:倔强青铜三前言大家好,我是倔强青铜三。是一名热情的软件工程师,我热衷于分享和传播IT技术,致力于通过我的知识和技能推动技术交流与创新,欢迎关注我

java线程Thread和Runnable区别和联系

zx_code

javajvmthread多线程Runnable

我们都晓得java实现线程2种方式,一个是继承Thread,另一个是实现Runnable。

模拟窗口买票,第一例子继承thread,代码如下

package thread;

public class ThreadTest {

public static void main(String[] args) {

Thread1 t1 = new Thread1(

【转】JSON与XML的区别比较

丁_新

jsonxml

1.定义介绍

(1).XML定义

扩展标记语言 (Extensible Markup Language, XML) ,用于标记电子文件使其具有结构性的标记语言,可以用来标记数据、定义数据类型,是一种允许用户对自己的标记语言进行定义的源语言。 XML使用DTD(document type definition)文档类型定义来组织数据;格式统一,跨平台和语言,早已成为业界公认的标准。

XML是标

c++ 实现五种基础的排序算法

CrazyMizzz

C++c算法

#include<iostream>

using namespace std;

//辅助函数,交换两数之值

template<class T>

void mySwap(T &x, T &y){

T temp = x;

x = y;

y = temp;

}

const int size = 10;

//一、用直接插入排

我的软件

麦田的设计者

我的软件音乐类娱乐放松

这是我写的一款app软件,耗时三个月,是一个根据央视节目开门大吉改变的,提供音调,猜歌曲名。1、手机拥有者在android手机市场下载本APP,同意权限,安装到手机上。2、游客初次进入时会有引导页面提醒用户注册。(同时软件自动播放背景音乐)。3、用户登录到主页后,会有五个模块。a、点击不胫而走,用户得到开门大吉首页部分新闻,点击进入有新闻详情。b、

linux awk命令详解

被触发

linux awk

awk是行处理器: 相比较屏幕处理的优点,在处理庞大文件时不会出现内存溢出或是处理缓慢的问题,通常用来格式化文本信息

awk处理过程: 依次对每一行进行处理,然后输出

awk命令形式:

awk [-F|-f|-v] ‘BEGIN{} //{command1; command2} END{}’ file

[-F|-f|-v]大参数,-F指定分隔符,-f调用脚本,-v定义变量 var=val

各种语言比较

_wy_

编程语言

Java Ruby PHP 擅长领域

oracle 中数据类型为clob的编辑

知了ing

oracle clob

public void updateKpiStatus(String kpiStatus,String taskId){

Connection dbc=null;

Statement stmt=null;

PreparedStatement ps=null;

try {

dbc = new DBConn().getNewConnection();

//stmt = db

分布式服务框架 Zookeeper -- 管理分布式环境中的数据

矮蛋蛋

zookeeper

原文地址:

http://www.ibm.com/developerworks/cn/opensource/os-cn-zookeeper/

安装和配置详解

本文介绍的 Zookeeper 是以 3.2.2 这个稳定版本为基础,最新的版本可以通过官网 http://hadoop.apache.org/zookeeper/来获取,Zookeeper 的安装非常简单,下面将从单机模式和集群模式两

tomcat数据源

alafqq

tomcat

数据库

JNDI(Java Naming and Directory Interface,Java命名和目录接口)是一组在Java应用中访问命名和目录服务的API。

没有使用JNDI时我用要这样连接数据库:

03. Class.forName("com.mysql.jdbc.Driver");

04. conn

遍历的方法

百合不是茶

遍历

遍历

在java的泛

linux查看硬件信息的命令

bijian1013

linux

linux查看硬件信息的命令

一.查看CPU:

cat /proc/cpuinfo

二.查看内存:

free

三.查看硬盘:

df

linux下查看硬件信息

1、lspci 列出所有PCI 设备;

lspci - list all PCI devices:列出机器中的PCI设备(声卡、显卡、Modem、网卡、USB、主板集成设备也能

java常见的ClassNotFoundException

bijian1013

java

1.java.lang.ClassNotFoundException: org.apache.commons.logging.LogFactory 添加包common-logging.jar2.java.lang.ClassNotFoundException: javax.transaction.Synchronization

【Gson五】日期对象的序列化和反序列化

bit1129

反序列化

对日期类型的数据进行序列化和反序列化时,需要考虑如下问题:

1. 序列化时,Date对象序列化的字符串日期格式如何

2. 反序列化时,把日期字符串序列化为Date对象,也需要考虑日期格式问题

3. Date A -> str -> Date B,A和B对象是否equals

默认序列化和反序列化

import com

【Spark八十六】Spark Streaming之DStream vs. InputDStream

bit1129

Stream

1. DStream的类说明文档:

/**

* A Discretized Stream (DStream), the basic abstraction in Spark Streaming, is a continuous

* sequence of RDDs (of the same type) representing a continuous st

通过nginx获取header信息

ronin47

nginx header

1. 提取整个的Cookies内容到一个变量,然后可以在需要时引用,比如记录到日志里面,

if ( $http_cookie ~* "(.*)$") {

set $all_cookie $1;

}

变量$all_cookie就获得了cookie的值,可以用于运算了

java-65.输入数字n,按顺序输出从1最大的n位10进制数。比如输入3,则输出1、2、3一直到最大的3位数即999

bylijinnan

java

参考了网上的http://blog.csdn.net/peasking_dd/article/details/6342984

写了个java版的:

public class Print_1_To_NDigit {

/**

* Q65.输入数字n,按顺序输出从1最大的n位10进制数。比如输入3,则输出1、2、3一直到最大的3位数即999

* 1.使用字符串

Netty源码学习-ReplayingDecoder

bylijinnan

javanetty

ReplayingDecoder是FrameDecoder的子类,不熟悉FrameDecoder的,可以先看看

http://bylijinnan.iteye.com/blog/1982618

API说,ReplayingDecoder简化了操作,比如:

FrameDecoder在decode时,需要判断数据是否接收完全:

public class IntegerH

js特殊字符过滤

cngolon

js特殊字符js特殊字符过滤

1.js中用正则表达式 过滤特殊字符, 校验所有输入域是否含有特殊符号function stripscript(s) { var pattern = new RegExp("[`~!@#$^&*()=|{}':;',\\[\\].<>/?~!@#¥……&*()——|{}【】‘;:”“'。,、?]"

hibernate使用sql查询

ctrain

Hibernate

import java.util.Iterator;

import java.util.List;

import java.util.Map;

import org.hibernate.Hibernate;

import org.hibernate.SQLQuery;

import org.hibernate.Session;

import org.hibernate.Transa

linux shell脚本中切换用户执行命令方法

daizj

linuxshell命令切换用户

经常在写shell脚本时,会碰到要以另外一个用户来执行相关命令,其方法简单记下:

1、执行单个命令:su - user -c "command"

如:下面命令是以test用户在/data目录下创建test123目录

[root@slave19 /data]# su - test -c "mkdir /data/test123"

好的代码里只要一个 return 语句

dcj3sjt126com

return

别再这样写了:public boolean foo() { if (true) { return true; } else { return false;

Android动画效果学习

dcj3sjt126com

android

1、透明动画效果

方法一:代码实现

public View onCreateView(LayoutInflater inflater, ViewGroup container, Bundle savedInstanceState)

{

View rootView = inflater.inflate(R.layout.fragment_main, container, fals

linux复习笔记之bash shell (4)管道命令

eksliang

linux管道命令汇总linux管道命令linux常用管道命令

转载请出自出处:

http://eksliang.iteye.com/blog/2105461

bash命令执行的完毕以后,通常这个命令都会有返回结果,怎么对这个返回的结果做一些操作呢?那就得用管道命令‘|’。

上面那段话,简单说了下管道命令的作用,那什么事管道命令呢?

答:非常的经典的一句话,记住了,何为管

Android系统中自定义按键的短按、双击、长按事件

gqdy365

android

在项目中碰到这样的问题:

由于系统中的按键在底层做了重新定义或者新增了按键,此时需要在APP层对按键事件(keyevent)做分解处理,模拟Android系统做法,把keyevent分解成:

1、单击事件:就是普通key的单击;

2、双击事件:500ms内同一按键单击两次;

3、长按事件:同一按键长按超过1000ms(系统中长按事件为500ms);

4、组合按键:两个以上按键同时按住;

asp.net获取站点根目录下子目录的名称

hvt

.netC#asp.nethovertreeWeb Forms

使用Visual Studio建立一个.aspx文件(Web Forms),例如hovertree.aspx,在页面上加入一个ListBox代码如下:

<asp:ListBox runat="server" ID="lbKeleyiFolder" />

那么在页面上显示根目录子文件夹的代码如下:

string[] m_sub

Eclipse程序员要掌握的常用快捷键

justjavac

javaeclipse快捷键ide

判断一个人的编程水平,就看他用键盘多,还是鼠标多。用键盘一是为了输入代码(当然了,也包括注释),再有就是熟练使用快捷键。 曾有人在豆瓣评

《卓有成效的程序员》:“人有多大懒,才有多大闲”。之前我整理了一个

程序员图书列表,目的也就是通过读书,让程序员变懒。 写道 程序员作为特殊的群体,有的人可以这么懒,懒到事情都交给机器去做,而有的人又可

c++编程随记

lx.asymmetric

C++笔记

为了字体更好看,改变了格式……

&&运算符:

#include<iostream>

using namespace std;

int main(){

int a=-1,b=4,k;

k=(++a<0)&&!(b--

linux标准IO缓冲机制研究

音频数据

linux

一、什么是缓存I/O(Buffered I/O)缓存I/O又被称作标准I/O,大多数文件系统默认I/O操作都是缓存I/O。在Linux的缓存I/O机制中,操作系统会将I/O的数据缓存在文件系统的页缓存(page cache)中,也就是说,数据会先被拷贝到操作系统内核的缓冲区中,然后才会从操作系统内核的缓冲区拷贝到应用程序的地址空间。1.缓存I/O有以下优点:A.缓存I/O使用了操作系统内核缓冲区,

随想 生活

暗黑小菠萝

生活

其实账户之前就申请了,但是决定要自己更新一些东西看也是最近。从毕业到现在已经一年了。没有进步是假的,但是有多大的进步可能只有我自己知道。

毕业的时候班里12个女生,真正最后做到软件开发的只要两个包括我,PS:我不是说测试不好。当时因为考研完全放弃找工作,考研失败,我想这只是我的借口。那个时候才想到为什么大学的时候不能好好的学习技术,增强自己的实战能力,以至于后来找工作比较费劲。我

我认为POJO是一个错误的概念

windshome

javaPOJO编程J2EE设计

这篇内容其实没有经过太多的深思熟虑,只是个人一时的感觉。从个人风格上来讲,我倾向简单质朴的设计开发理念;从方法论上,我更加倾向自顶向下的设计;从做事情的目标上来看,我追求质量优先,更愿意使用较为保守和稳妥的理念和方法。

&