转发自http://crickcollege.com/news/148.html

承前

小编很惊喜地看到,上一篇介绍蛋白质组学统计学参数的推文在朋友圈着实火了一把,真心感谢各路大侠小侠们的包涵和鼓励!篇幅所限,当时只聊了p值和E值,很多小伙伴读完后都发来消息,表示十分期待后续的FDR和q值!小编也一直把此事挂在心上,但由于近来杂事缠事,一晃就是一个地球月过去了,这才把第二篇完成,让大伙儿久等了,在此深表歉意!

>> p值、E值、FDR、q值…你晕菜了吗?

温故

在继续开扒之前,我们先来回顾一下总表:

虽然这张表已经第二次露脸了,但小编明白,要你爱上它的概率仍然是很低很低的!不过不要紧,你就当它是课程表就好,根据表上的顺序,下面我们就开始聊假发现率FDR、q-value以及后验错误率PEP。

FDR

当FDR的字眼出现在屏幕上时,你心中是否有这样的疑问:不是已经有p-value和E-value了吗?还不够用来评估鉴定结果么?又整出一堆幺蛾子干啥?

讲真,小编认为这是一个好问题!要说清楚呢,我们还是举个例子先:

假设我有很多袋彩球,每袋100颗,其中紫色球95颗(代表正确的鉴定结果),其它颜色的球5颗(代表错误的鉴定结果):

- 把一袋彩球倒入一个盒子里,随机从盒子里抽出一个球,抽到紫色球的概率为0.95,这个都会算吧。

- 把两袋彩球倒入一个盒子里,随机从盒子里同时抽出两个球,抽到两个紫色球的概率为:0.95*0.95=0.9025

- 把一百袋彩球倒入一个盒子里,随机从盒子里同时抽出100个球,抽到100个紫色球的概率为100个0.95相乘,即0.005921!

发现没有?虽然每个袋子里鉴定结果的正确率是很高的(紫色球占95%),但是当鉴定的肽段(或蛋白)数量非常多的时候,我们也完全保证不了整个结果集合的正确率!

无论是p-value还是E-value,也是类似的道理,它们只针对单个肽段进行可信度的评估,如果我们不对所有肽段匹配结果进行一个整体的质控,单个肽段的错误率就在集合中累积,甚至严重影响整个结果报告的可信度!

怎么来对整个结果的数据集进行质控呢?这就需要整点更高端的,行话叫“多重假设检验”,此处,FDR闪亮登场!

FDR全名叫False-Discovery Rate,严格一些,准确翻译为“假发现率”,决不能称为“假阳率(FPR,False Positive Rate)”。FDR表示错误拒绝零假设的个数占所有被拒绝假设的比例的期望。其中,期望表示对真实值的估计。直观说,可以认为假发现率FDR是对假阳率FPR的估计。这种定义,是不是看着就想吐血?

先忍忍,听小编跟你解释!我们可以估计韩寒和郭敬明的身高为170厘米。这是估计,可能有偏差。为什么要估计?我要是知道真实值,我还估计?我有病?!另外,既然我估计了,我基本还是敢说,他俩身高决不会超过180厘米。假阳率FPR就是两位大神的身高,假发现率FDR就是我们的估计……

这么说,如果我们设FDR为1%,从统计学角度讲,就表示我们可以接受这样的匹配结果列表:其中有99%的匹配是正确的,只有1%的匹配是错误的。当然,我们也可以心大一点,比如把FDR设到10%,那你肯定会得到长得多的结果报告,但问题是,这里面是错误匹配的可能性也会高得多!

懂了吗,亲?不同于p-value或者E-value只能评估单个肽段的可信度,FDR却是为评价整体匹配结果的正确率而生的!样本中肽段(或蛋白)越多,它的重要性越明显!

那么,FDR是怎么算的呢?话说,最早提出这个评价指标是一位叫Benjamini的大爷,按照他的思路,在鸟枪法蛋白质组学中,FDR就是一把切菜刀,鉴定结果的列表就是一根香肠,p-value越小的瘦肉,放在越前面,越往后肉越肥,然后从前面开始切,切到p-value大于一个阈值,就不切了,切好的拿来炒菜,剩下的都丢掉!

这就是大名鼎鼎的The Bonferroni Method,详细的解释有兴趣的童鞋可以找文献来读,我们只需要知道的是,这种思路搞出来的切菜刀太过苛刻,符合打分的鉴定结果越多,FDR卡值越严格,而最终能被切到的香肠片却可能只是寥寥,大部分都被扔掉了!这多浪费啊,还能不能愉快地炒菜了?!

针对这种情况,后面又有各种大牛来改进思路,比如BH方法之类的,总之目的都是为了不要矫枉过正,才能在保证正确率的前提下,又能切到足够多的香肠片。目前主流的软件用到的计算方法大体分两类:

目标库诱饵库策略(Target-Decoy Approach,TDA)

这个名字看着很长,其实很简单,相信很多童鞋多多少少也听过,就是我们通常说的Decoy反库。Decoy库里的蛋白质序列一般是目标库(Target)序列的反向序列或者随机打乱后的序列,总之就是实际不存在的序列,因此发生在反库的肽谱匹配我们就认为是错误的匹配,可以用来评估FDR。

一些主流的软件都有Decoy参数,比如Mascot,如果你想使用这种方法进行质控,就勾上Decoy选项,软件就用根据你设定的目标蛋白库,自动生成一个反库,进行FDR的评估。

经验贝叶斯方法

看到这个名字,估计有些人就要醉了!放心,小编不会整公式出来,实在感兴趣的童鞋可以自行去读文献,大家只需要了解,它的基本策略是将每张谱图对应的最好的匹配打分分布视为正确匹配打分分布与错误匹配打分分布的混合分布,然后从混合分布中求解这两类分布,从而计算出FDR(以及PEP,后面会讲到)。

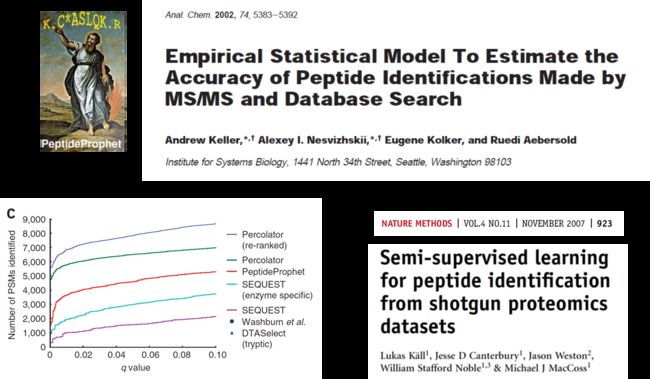

使用这个算法最有名的软件是PeptideProphet,后来还有一个更牛的改进算法Percolator(基于半监督学习模型的过滤算法),能够过滤得到更多可靠的结果。目前Percolator已经被移植到Mascot、X!Tandem、OMSSA以及MSGF+等搜索引擎中,并且都获得了很好的效果。大家用的时候心里有个谱就可以了~

q-value

给定一个按打分从好到坏排序好的鉴定结果列表,前100个来自正库,第101个来自反库。那么,这101个结果组成的集合的FDR为1%(D/T=1/100=0.01)。继续往下数到201个,依然来自正库,此时FDR反而一直是小于1%的(D/T=1/201=0.005)。到第202个结果,来自反库,此时这202个结果组成的集合的FDR又变为1%(D/T=2/200=0.01)。上面这个过程,FDR是一个从0到0.01,再减小,再到0.01的过程。也就是FDR不是单调的。这让处女座的科研人员怎可忍受?!

q-values就是能够过滤出打分为x的肽谱匹配所需的最小FDR阈值,它是对FDR在打分上的单调化。还是上面那个按打分从好到坏排序好的鉴定结果列表,设定q-value为0.01表示我要202个结果(其中2个来自反库)组成的集合,不要101个结果(其中1个来自反库)组成的集合。

PEP

说完了q-value,你以为就结束了吗?想得美!还有一个重要的统计学指标,小编还没介绍呢!

PEP(Posterior Error Probability),翻译过来叫后验错误率。听起来好像很吓人,解释起来其实很简单,就是一个肽段匹配是错误的概率。比如针对EAMRQPK这个匹配结果的PEP是5%,就表示有95%的可能性EAMRQPK这个结果是对的!

看问题呢,我们多换几个角度,理解就会更深刻一些。比如PEP,它与FDR是啥关系呢?画个图大伙儿就清楚了:

从图上看很直观了,PEP是针对单个结果的假阳性率评估,所以是线段与线段的比值;FDR是针对整个集合的假阳性率评估,所以是面积对面积的比值。FDR就是所有PEP线段的集合(积分),所以,PEP又叫做局部FDR,就是这么来的~

既然PEP与FDR友谊这么深,刚才小编列举的计算FDR的两种算法思路(搜反库策略以及贝叶斯方法)也同样适用于PEP哦!

如果你真的有这个疑惑,说明你已经进入状态了,恭喜!接下来小编就来回答这个问题,建议你拿个小本本记下来~

在针对肽段匹配的质控环节,q-value和PEP被认为是非常重要的两个指标,该用哪个指标取决你的研究目的:

- 请用q-value:如果你想知道样本里都有些什么肽段(蛋白),或者在系统层次研讨这些蛋白的生物通路、互作网络、功能聚类等特性;

- 请用PEP:就想知道特定的那个肽段(或蛋白)到底在不在我的样本中;

小结

不知不觉又扯了这么多,能看完整篇的童鞋举个手,小编都觉得很感动!在结束这烧脑的推文之前,再简单地总结一下吧~

我们一共聊了五个统计学指标,其中p-value和E-value是一对,而FDR、q- value以及PEP是一伙儿。如果我们只用p-value/E-value来筛选结果,约束就过余宽松,难以控制整体结果的质量;如果我们用Bonferroni策略来严格限制p-value,又过余苛刻(回忆一下切香肠的例子),比较适中的是PEP和q- value,当我们的研究目标是特定的某个肽段或蛋白时,用PEP最合适,当我们的研究目标是整个蛋白集合时,q- value最合适!

好吧,关于统计参数的介绍就写到这里了,小编已经尽力了,但仍然不免错误和不严谨之处,欢迎各种大神留言指正,也欢迎小伙伴们提问讨论~

**特别致谢:

中科院计算所pFind团队提供的写作素材和专业指导!

参考文献**

Kall L, Storey J D, MacCoss M J, et al.Posterior error probabilities and false discovery rates: Two sides of the same coin. J Proteome Res, 2008, 7(1): 40-4

Benjamini Y, Hochberg Y. Controlling the False Discovery Rate - a Practical and Powerful Approach to Multiple Testing. J Roy Stat Soc B, 1995, 57(1): 289-300

Storey J D. A direct approach to false discovery rates. J Roy Stat Soc B, 2002, 64(3): 479-98

Efron B, Tibshirani R. Empirical bayes methods and false discovery rates for microarrays. Genet Epidemiol, 2002, 23(1): 70-86

Moore R E, Young M K, Lee T D. Qscore: an algorithm for evaluating SEQUEST database search results. J Am Soc Mass Spectrom, 2002, 13(4): 378-86

Keller A, Nesvizhskii A I, Kolker E, et al. Empirical statistical model to estimate the accuracy of peptide identifications made by MS/MS and database search. Anal Chem, 2002, 74(20): 5383-92

Kall L, Canterbury J D, Weston J, et al. Semi-supervised learning for peptide identification from shotgun proteomics datasets. Nat Methods, 2007, 4(11): 923-5