人工智能(和公共云)市场的竞争白热化,使歌与亚马逊相抗衡。谷歌在其云平台上提供人工智能硬件,旨在让培训和运行机器学习/深度学习系统更加轻松,快捷和便宜,而亚马逊,据报道,正在开发自己的AI芯片组合。 这是两家公司与微软Azure,IBM云和其他公共云服务提供商一起采取的一系列与处理器相关的举措中的最新举措,近几个月来,随着人工智能日益融入我们的业务和家庭生活,他们已经做出了自己的定位。

谷歌正在开始使用云端TPU(Tensor Processing Units)加速器,从谷歌云平台(GCP)开始,该公司表示这将有助于让机器学习(ML)模型得到更好的培训和运行。

Cloud TPU是Google设计的硬件,旨在加速和扩展使用TensorFlow编程的ML工作负载。每个Cloud TPU由四个定制ASIC构建,在单个板上具有高达180 teraflops的浮点性能和64 GB的内存。

“您可以通过您控制并可自定义的Google Compute Engine VM,无需等待作业在共享计算群集上进行计划,而是可以对网络连接的云TPU进行交互式独占访问,”产品经理John Barrus表示。云端TPU,谷歌云和Zak Stone,TensorFlow和云端TPU的产品经理,Google Brain Team,在一篇联合撰写的博客文章中。 “而不是等待数天或数周来培训关键业务ML模型,您可以在一组云TPU上培训同一模型的多个变体,并在第二天将最准确的训练模型部署到生产中。”

与此同时,据路透社报道,亚马逊为家用安全摄像机制造商Blink及其节能芯片技术支付了9000万美元。

“这笔交易的基本原理和价格标签,以前没有报道,强调了亚马逊的目标,不仅仅是出售另一款受欢迎的相机,正如分析师所认为的那样,”路透社报道。 其中一位知情人士表示,“在线零售商正在探索Blink专有的芯片,可以降低生产成本,延长其他产品的电池续航时间,从亚马逊的Cloud Cam开始,可能扩展到其Echo扬声器系列。”

根据该报告,亚马逊寻求通过内部设备加强与消费者的联系。 虽然亚马逊的Cloud Cam和Echo需要一个插入式电源,但Blink声称其相机可以使用两节AA锂电池持续两年。亚马逊拒绝对此次收购的条款或策略发表评论。

此外,The Information发布的一份报告指出,亚马逊正在开发自己的AI芯片,该芯片旨在用于Echo以及由亚马逊的Alexa虚拟助手提供支持的其他硬件。 据报道,该芯片将通过设备而不是AWS在本地边缘进行处理,从而帮助其支持语音的产品更有效地处理任务。

HPCwire去年10月报道称,对HPC和AI计算能力的需求激增,缩小了主要由Nvidia开发的高端GPU和云供应商采用的高端GPU之间的时间差距。据知道,随着Nvidia V100发布墨水仍处于干燥状态,其他大型云供应商仍在开展Pascal发布,亚马逊网络服务已成为第一家提供Tesla Volta GPU的云计算巨头,击败竞争对手谷歌和微软,“HPCwire报道。 “谷歌一直是提供P100 GPU的三巨头中的第一家,但现在我们了解到,亚马逊正在完全跳过Pascal并直接推向Volta,推出支持V100的P3实例,其中包括由NVLink连接的多达8个GPU。”

至于谷歌的云TPU,该公司表示,它正在通过提供高级TensorFlow API以及开源参考云TPU模型实现来简化ML培训。作者使用单一的云TPU,ResNet-50(和其他流行的图像分类模型)“在不到一天的时间内就ImageNet基准挑战的预期准确度”不到200美元。

Barrus和Stone还表示,客户可以单独使用Cloud TPU,也可以通过“超快速专用网络连接形成多petaflop ML超级计算机,我们称之为'TPU pod'。”客户现在开始使用Cloud TPU,他们表示,将从今年晚些时候推出的TPU吊舱中获益。 “正如我们在2017年NIPS上宣布的那样,ResNet-50和变压器培训时间从一天中的大部分时间开始下降到完整TPU吊舱的30分钟以下,无需更改代码。”

投资管理公司Two Sigma的首席技术官Alfred Spector表示:“我们决定将我们的深度学习研究重点放在云计算上。”但主要是为了获得最新的机器学习基础设施.Google Cloud TPU就是一个例子。支持深度学习的创新,快速发展的技术,我们发现将TensorFlow工作负载转移到TPU通过大大降低编程新模型的复杂性和培训它们所需的时间来提高我们的生产力。使用云TPU而不是其他集群加速器使我们能够专注于构建我们的模型,而不会因管理集群通信模式的复杂性而分心。“

Lyft公司也表示对Google Cloud TPU的速度印象深刻。 “通常需要几天的时间现在可能需要几个小时,”Lyft的自动驾驶级别5软件主管Anantha Kancherla说。 “深度学习正迅速成为运行自动驾驶汽车的软件的支柱。随着更多数据的结果越来越好,每周算法都会有重大突破。在这个世界中,云TPU通过整合我们车队的最新导航相关数据以及研究界的最新算法进展,帮助我们快速行动。“

Barras和Stone在Cloud TPU中突出了公共云计算提供的通常优势。 “他们说,”您不需要投入设计,安装和维护具有专业电源,冷却,网络和存储要求的现场ML计算集群所需的资金,时间和专业知识,而是可以从大规模,紧密的方式中受益。集成的ML基础架构,多年来一直在Google上进行了大量优化。“

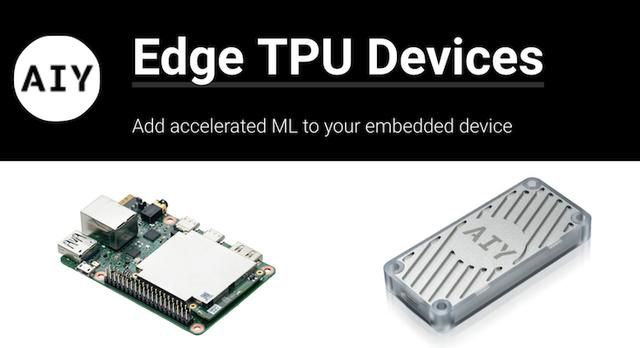

谷歌表示,目前云TPU数量有限,是按小时收费的。谷歌宣称它的TPU比现代GPU和推理CPU快15到30倍,并且TOPS / Watt测量值提高了30-80倍。并且谷歌在同年还发布了用于边缘计算的Edge TPU,以及相关设备:AIY Projects Edge TPU Dev Board和Edge TPU Accelerator 围绕谷歌新推出的专用边缘TPU。