一、 安装前准备

下载安装JDk1.7以上版本。

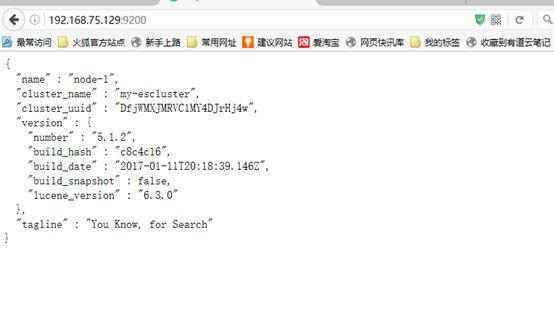

下载ElasticSearch安装包,官网获取,我这里下载的是最新版本5.1.2. elasticsearch-5.1.2.tar.gz

二、 安装过程

检查jdk版本 java –version

登录服务器,创建文件夹mkdir –p /opt/elasticsearch

上传elasticsearch-5.1.2.tar.gz 至服务器/opt/elasticsearch/ 下

解压 tar –zvxf elasticsearch-5.1.2.tar.gz

启动elasticsearch cd /opt/elasticsearch/elasticsearch-5.1.2 ./bin/elasticsearch

需要修改的参数(防止下面报错)

1、

vim /etc/sysctl.conf

添加如下配置:vm.max_map_count=655360

并执行命令:sysctl -p

2、

vim /etc/security/limits.conf

修改以下配置

* soft nofile 655360

* hard nofile 655360

* soft nproc unlimited

* hard nproc unlimited

* hard memlock unlimited

* soft memlock unlimited

3、

vim /etc/security/limits.d/90-nproc.conf

修改以下配置

* soft nproc unlimited

三、 安装过程可能出现的错误

1、 如果是用root账号启动,会报以下错误

解决办法:

这是出于系统安全考虑设置的条件。由于ElasticSearch可以接收用户输入的脚本并且执行,为了系统安全考虑,

建议创建一个单独的用户用来运行ElasticSearch

1、创建elsearch用户组及elsearch用户

groupadd elsearch

2、更改elasticsearch文件夹及内部文件的所属用户及组为elsearch:elsearch

useradd elsearch -g elsearch -p elasticsearch

cd /opt

chown -R elsearch:elsearch elasticsearch

3、切换至elsearch用户再启动

su elsearch

cd /opt/elasticsearch/elasticsearch-5.1.2 ./bin/elasticsearch

2、 警告问题

解决办法:

使用新的liunx 系统就不会出现此类问题

3、ERROR: bootstrap checks failed

(一)max file descriptors [4096] for elasticsearch process likely too low, increase to at least [65536]

max number of threads [1024] for user [lishang] likely too low, increase to at least [2048]

解决办法:

切换到root用户,编辑limits.conf 添加类似如下内容

vi /etc/security/limits.conf

添加如下内容:

* soft nofile 65536

* hard nofile 131072

* soft nproc 2048

* hard nproc 4096

(二) max number of threads [1024] for user [lish] likely too low, increase to at least [2048]

解决办法:

切换到root用户,进入limits.d目录下修改配置文件。

vi /etc/security/limits.d/90-nproc.conf

修改如下内容:

* soft nproc 1024

修改为

* soft nproc 2048

(三)****max virtual memory areas vm.max_map_count [65530] likely too low, increase to at least [262144]

解决办法:

切换到root用户修改配置sysctl.conf

vi /etc/sysctl.conf

添加下面配置:

vm.max_map_count=262144

并执行命令:

sysctl -p

然后,重新启动elasticsearch,即可启动成功。

附录

ElasticSearch后端启动命令

./elasticsearch –d

ElasticSearch-head5.1.2 安装

由于5.X版本变化比较大,所以5.X暂时不支持直接安装,但是head的作者提供了另外一种安装方式。

1、下载head插件源码

https://github.com/mobz/elasticsearch-head

2、下载nodejs

nodejs官网下载地址https://nodejs.org/dist/

wget https://nodejs.org/dist/v6.9.2/node-v6.9.2-linux-x64.tar.xz

3、配置node环境变量

xz –d node-v6.9.2-linux-x64.tar.xz

tar –xvf node-v6.9.2-linux-x64.tar

mv node-v6.9.2-linux-x64 /home/jacker/soft/node-v6.9.2-linux-x64

vim /etc/profile

export NODE_HOME=/home/jacker/soft/node-v6.9.2-linux-x64

export PATH=$PATH:$NODE_HOME/bin

source /etc/profile

# node –v

v6.9.2

# npm –v

3.10.9

4、安装grunt

如果生产环境无法联网在线安装grunt,可以找一台能联网的主机配置好node,安装好grunt后将elasticsearch-head目录下的node_models打包上传

cd elasticsearch-head

:

5、打开elasticseach-head目录下的Gruntfile.js文件,命令模式下查找修改处:

/9100

修改为:

connect:

{

server:{

options: {

port: 9100,

**hostname:****'*',**

base: '.',

keepalive: true

}

}

}

*部分为新加上去的。

6、修改elasticsearch-head/_site/app.js链接地址:

this.base_uri = this.config.base_uri || this.prefs.get("app-base_uri") || "http://localhost:9200";

把localhost修改成你es的服务器地址,如:

this.base_uri = this.config.base_uri || this.prefs.get("app-base_uri") || "http://10.10.10.10:9200";

7、elasticsearch配置允许跨域访问

修改elasticsearch配置文件elasticsearch.yml

http.cors.enabled: true

http.cors.allow-origin: "*"

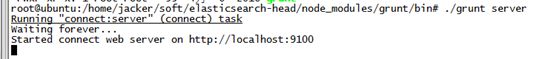

8、重启elasticsearch,并启动node

cd elasticsearch-head

node_modules/grunt/bin/grunt server

9、访问http://192.168.75.129:9100

ElasticSearch-analysis-ik分词器的安装

去GitHub下载配套的IK分词器,Smartcn也可以,不过据说没有ik灵活https://github.com/medcl/elasticsearch-analysis-ik/releases ,直接下编译好的zip包

现在开始安装ik分词器,安装之前,先说明一些变化:

- 之前可以在node节点上配置index默认的分词器,如果是多节点,那么在每个节点上都配置就行了。这个有点不灵活,所以5.0之后,ES已经不再支持在elasticsearch.yml中配置分词器,改而在新建索引时,使用settings去配置,这个会在后面的编程中说到。

-

之前使用delete-by-query插件来实现type的整个删除。这个插件也是从5.0开始没有了,被整个岛ES的Core中

- 从5.0开始ik的tokenizer发生了变化,提供了两种,一种为ik_smart,一种为ik_max_word。直接一点,ik_max_word会尽量从输入中拆分出更多 token,而ik_smart则相反,个人感觉,ik_max_word就是原来的ik,ik_smart是新加的。

- 好了,开始安装,只需要把elasticsearch-analysis-ik-5.0.1.zip解压,然后拷贝到ES安装目录下的plugins文件夹内,并把elasticsearch-analysis-ik-5.0.1文件夹名修改为ik。这样,就安装好了。正如前面说的,安装完插件,现在不需要在配置文件中配置了,需要在新建索引的时候指定分词器。

- 重启启动ES,可以看到如下log

安装kibana

接下来安装Kibana,也挺简单,解压之后,先进到安装目录/config/kibana.yml中,将server.host修改一下,否则远程无法访问,这个配置在Kibana4.6.1(对应ES2.4.0)的时候还不需要配置,但是5.1.2就需要了。

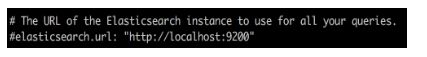

然后kibana里面有默认的ES访问路径,如果你没有改动过ES的端口,并且Kibana跟ES部署在一起,就不需要改动,否则需要配置这里:

然后远程启动,看下Kibana5.1.2的样子

ES节点角色

在生产环境下,如果不修改elasticsearch节点的角色信息,在高数据量,高并发的场景下集群容易出现脑裂等问题。

默认情况下,elasticsearch 集群中每个节点都有成为主节点的资格,也都存储数据,还可以提供查询服务。这些功能是由两个属性控制的。

1. node.master

2. node.data

默认情况下这两个属性的值都是true。

node.master:这个属性表示节点是否具有成为主节点的资格

注意:此属性的值为 true,并不意味着这个节点就是主节点。因为真正的主节点,是由多个具有主节点资格的节点进行选举产生的。所以,这个属性只是代表这个节点是不是具有主节点选举资格。

node.data:这个属性表示节点是否存储数据。

四种组合

1. node.master: true AND node.data: true AND node.ingest: true

这种组合表示这个节点既有成为主节点的资格,又可以存储数据,还可以作为预处理节点,这个时候如果某个节点被选举成为了真正的主节点,那么他还要存储数据,这样对于这个节点的压力就比较大了。

elasticsearch 默认是:每个节点都是这样的配置,在测试环境下这样做没问题。实际工作中建议不要这样设置,这样相当于 主节点 和 数据节点 的角色混合到一块了。

2. node.master: false AND node.data: true AND node.ingest: false

这种组合表示这个节点没有成为主节点的资格,也就不参与选举,只会存储数据。这个节点我们称为 data(数据)节点。在集群中需要单独设置几个这样的节点负责存储数据。后期提供存储和查询服务

3. node.master: true AND node.data: false AND node.ingest: false

这种组合表示这个节点不会存储数据,有成为主节点的资格,可以参与选举,有可能成为真正的主节点。这个节点我们称为master节点

4. node.master: false AND node.data: false AND node.ingest: true

这种组合表示这个节点即不会成为主节点,也不会存储数据,这个节点的意义是作为一个 client(客户端)节点,主要是针对海量请求的时候可以进行负载均衡。在新版 ElasticSearch5.x 之后该节点称之为:coordinate 节点,其中还增加了一个叫:ingest 节点,用于预处理数据(索引和搜索阶段都可以用到),当然,作为一般应用是不需要这个预处理节点做什么额外的预处理过程,那么这个节点和我们称之为 client 节点之间可以看做是等同的,我们在代码中配置访问节点就都可以配置这些 ingest 节点即可。

总结

默认情况下,每个节点都有成为主节点的资格,也会存储数据,还会处理客户端的请求。在一个生产集群中我们可以对这些节点的职责进行划分。

建议集群中设置 3台 以上的节点作为 master 节点【node.master: true node.data: false node.ingest:false】,这些节点只负责成为主节点,维护整个集群的状态。

再根据数据量设置一批 data节点【node.master: false node.data: true node.ingest:false】,这些节点只负责存储数据,后期提供建立索引和查询索引的服务,这样的话如果用户请求比较频繁,这些节点的压力也会比较大

所以在集群中建议再设置一批 ingest 节点也称之为 client 节点【node.master: false node.data: false node.ingest:true】,这些节点只负责处理用户请求,实现请求转发,负载均衡等功能。

master节点:普通服务器即可(CPU 内存 消耗一般)

data 节点:主要消耗磁盘,内存

client | ingest 节点:普通服务器即可(如果要进行分组聚合操作的话,建议这个节点内存也分配多一点)