kvm虚拟化之IO虚拟化

(文章来自作者维护的社区微信公众号【虚拟化云计算】)

(目前有两个微信群《kvm虚拟化》和《openstack》,扫描二维码点击“云-交流”,进群交流提问)

QEMU-KVM作为一个VMM提供了全虚拟化环境,guest不经过任何修改就能运行在KVM环境中。不过KVM在IO虚拟化方面,使用QEMU纯软件的方式来模拟IO设备,效率并不高。在KVM中,要想提高IO虚拟化的效率,就要使用半虚拟化的方式:virtio。

简单介绍全虚拟化和半虚拟化

在全虚拟化 中,guest操作系统运行在VMM之上,并不知道它已被虚拟化,不需要任何更改就可以工作。相反,在半虚拟化中,guest操作系统不仅知道它运行在 VMM上,还需要做修改来对接VMM的代码。

在全虚拟化中,VMM必须模拟设备硬件,尽管这种模拟很彻底很干净,但它效率低代码最复杂。在半虚拟化模式中,guest和 VMM共同合作,模拟更加高效。

IO全虚拟化使用QEMU软件模拟

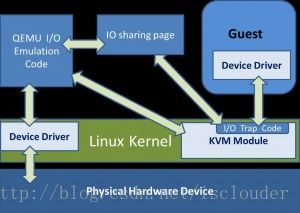

1.当虚拟机进行I/O操作时,根据《也谈Intel的cpu虚拟化》我们知道,虚拟机通过VM exit将cpu控制权返回给VMM,从而陷入到root模式下的ring0内的VMM,进行”陷入模拟“。

2.将本次I/O请求的信息存放到IO共享页,QEMU从IO共享页读取信息后由硬件模拟代码来模拟出本次的IO操作,并调用内核中的硬件驱动把IO请求发送到物理硬件,完成之后将结果放回到IO共享页。

3.KVM模块中的捕获代码读取IO共享页中的结果,把结果返回到guest。

4.通过VM entry,guest再次获得cpu控制权,根据IO返回的结果进行处理。

说明:VMM和guest的IO信息共享不光IO共享页一种,还可以使用DMA。QEMU不把IO结果放到IO共享页中,而是通过DMA将结果直接写到guest的内存中去,然后通过KVM模块告诉客户机DMA操作已经完成。

下面这张图(来自网络Eric博客)是软件模拟IO的流程图:

IO半虚拟化virtio

guest和host使用使用virtio前后端的技术减少了guest IO时的VM Exit(guest和host的上下文切换)并且使guest和host能并行处理IO来提高throughput和减少latency。但是IO的路径并没有比全虚拟化技术减少。下面是virtio的IO路径:

guest在IO请求时,首先guest需要切换到host kernel,然后host kernel会切换到hyperisor来处理guest的请求,hypervisor通过系统调用将数据包发送到外部网络后切换回host kernel,然后再切换回guest。这个长IO路径和全虚拟化时相同的,只是减少了VM exit和VM entry。

vhost

为了解决virio的IO路径太长的问题,vhost产生了。它是位于host kernel的一个模块,用于和guest直接通信,所以数据交换就在guest和host kernel间进行,减少了上下文的切换。vhost相对与virto架构,把virtio驱动后端驱动从用户态放到了内核态中(vhost的内核模块充当virtiO后端驱动)

下面这张图(来自redhat)描述了在virtio和vhost(vhost-net时vhost架构中的网卡实现)架构下内核的不同工作流程:

下面这张图(来自intel)介绍了vhost工作原理:

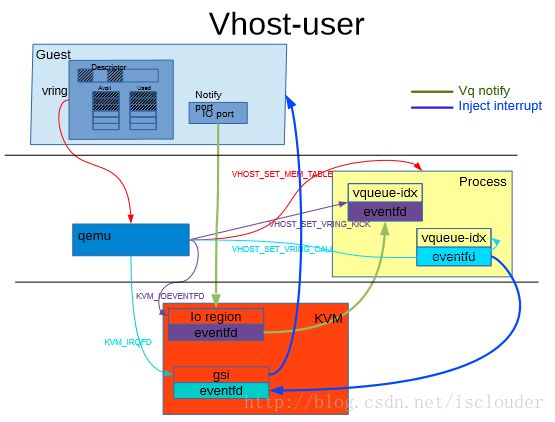

vhost-user

vhost-user和vhost类似,只是使用一个用户态进程vhost-user代替了内核中的vhost模块。vhost-user进程和Guset之间时通过共享内存的方式进行数据操作。vhost-user相对与vhost架构,把virtio驱动后端驱动从内核态又放回到了用户态中(vhost-user进程充当virtiO后端驱动)。

下面这张图(来自intel)介绍了vhost-user的工作原理:

总结

io虚拟化经历了从全虚拟化io到半虚拟化virtio。半虚拟化的后端驱动又经历了从VMM中到内核中,从内核中到用户空间中的过程。

============================================================

关注微信公众号【虚拟化云计算】,阅读更多虚拟化云计算知识,纯技术干货更新不停。