- pycharm2023,修改文件夹路径,venv解释器无法新增

day_323

pythonpycharm

pycharm2023,修改文件夹路径,venv解释器无法新增1问题描述2处理方法1问题描述我的pycharm版本为2023.1.2。原有代码所在文件夹路径变更后,再用pycharm打开代码,然后进入setting-pythoninterpreter中,新增venv虚拟环境,pycharm无反应,venv环境一直无法新增。2处理方法1关闭pycharm。然后进入代码文件夹,删除.idea文件夹和v

- 养老院管理系统基于SpringBoot的养老院管理系统系统设计与实现(源码+论文+部署讲解等)

博主介绍:✌全网粉丝60W+,csdn特邀作者、Java领域优质创作者、csdn/掘金/哔哩哔哩/知乎/道客/小红书等平台优质作者,计算机毕设实战导师,目前专注于大学生项目实战开发,讲解,毕业答疑辅导,欢迎高校老师/同行前辈交流合作✌技术栈范围:SpringBoot、Vue、SSM、Jsp、HLMT、Nodejs、Python、爬虫、数据可视化、小程序、安卓app、大数据、物联网、机器学习、单片机

- java8的stream流常用用法sorted

l1o3v1e4ding

后端开发热点代码java开发语言

java8的stream流常用用法持续更新~~,用法案例,项目开发中方便寻找一.排序stream().sorted()1.缺省排序字段:以类属性一升序排序2.带排序字段:以类属性一升序排序,推荐Comparator.reverseOrder()2.1.升序:不加参数即可2.2.降序:reversed()和Comparator.reverseOrder(),有区别:2.3.案例:注意两种写法3.多属

- 解决【WVP服务+ZLMediaKit媒体服务】加入海康摄像头后,能发现设备,播放/点播失败,提示推流超时!

l1o3v1e4ding

后端开发热点代码视频编解码音视频实时音视频javalinux

环境介绍每人搭建的环境不一样,情况不一样,但是原因都是下面几种:wvp配置不当网络端口未放开网络不通我搭建的环境:WVP服务:windows下,用idea运行的源码ZLM服务:虚拟机里问题描述1.国标设备里能发现海康的摄像头,心跳正常2.WVP服务与ZLM服务心跳正常3.播放失败,推流超时解决问题,我是第三种情况(详见下面的点播流程图的第5步)原因是ZLM服务在虚拟机里,虚拟机默认是NAT网络连接

- 大数据处理技术:分布式文件系统HDFS

茜茜西西CeCe

hdfshadoop大数据HDFS-JAVA接口文件头歌Java

目录1实验名称:2实验目的3实验内容4实验原理5实验过程或源代码5.1HDFS的基本操作5.2HDFS-JAVA接口之读取文件5.3HDFS-JAVA接口之上传文件5.4HDFS-JAVA接口之删除文件6实验结果6.1HDFS的基本操作6.2HDFS-JAVA接口之读取文件6.3HDFS-JAVA接口之上传文件6.4HDFS-JAVA接口之删除文件1实验名称:分布式文件系统HDFS2实验目的1.理

- Spring04:Spring MVC

dfraetaem

Springspringmvcjava后端

一、SpringMVC核心解析SpringMVC是基于Java实现MVC模型的轻量级Web框架,其核心优势在于简化Web开发、灵活性强和与Spring生态无缝集成。通过分层设计,它将应用分为:Controller层:处理请求和响应Service层:业务逻辑处理Dao层:数据持久化操作分层架构示例(SpringBoot+MyBatis)1.Dao层(数据访问层)//UserDao.java(接口)@

- 75、Java并发集合与GUI多线程编程详解

fire9

Java编程艺术:从入门到精通Java并发集合GUI多线程编程

Java并发集合与GUI多线程编程详解1.并发集合概述在多线程编程中,对共享集合的操作需要特别处理,以避免数据不一致等问题。java.util.concurrent包中的并发集合就是为此而设计和优化的。1.1并发集合的优势与通过JavaCollectionsAPI获取的同步集合不同,java.util.concurrent包中的集合专门针对多线程共享集合的场景进行了优化,能更好地支持多线程环境下的

- 从 Spring Boot 2.x 到 Spring Boot 3.x:全面对比与快速上手指南

超级小忍

SpringBootspringboot后端java

一、前言SpringBoot自诞生以来,凭借其“约定优于配置”的理念、开箱即用的设计和强大的生态支持,迅速成为Java开发领域的主流框架。随着Java语言的持续演进和开发者需求的提升,SpringBoot也在不断升级。SpringBoot3.x是一次重大版本升级,不仅带来了对现代Java特性的全面支持,还对底层架构、依赖管理和性能进行了深度优化。本文将从以下几个方面,详细对比SpringBoot2

- Java 中的函数式编程详解

超级小忍

Javajavapython开发语言

前言Java语言自从2014年发布的Java8版本引入了函数式编程(FunctionalProgramming)特性以来,其编程范式发生了深远的变革。函数式编程不仅带来了更简洁、更富有表达力的代码风格,也使得Java更加适合处理并发、流式数据处理等现代编程场景。本文将详细介绍Java中的函数式编程特性,包括Lambda表达式、函数式接口、方法引用、StreamAPI等核心概念,并通过示例展示其在实

- Java 中 Consumer 与 Provider 的用法详解

前言在Java编程中,Consumer和Provider是两个非常重要的函数式接口,它们在函数式编程和依赖注入等场景中被广泛使用。本文将详细讲解这两个接口的定义、使用场景以及实际示例,帮助你更好地理解和应用它们。一、Consumer接口1.1Consumer接口的定义Consumer是Java8引入的一个函数式接口,位于java.util.function包中。它表示一个接受单个输入参数并且无返回

- WEB:DOM (二)核心操作 —— 内容

文章目录一、innerHTML二、innerText与textContent2.1innerText2.2textContent2.3对比与选择三、表单元素的值操作获取和修改元素的内容是DOM操作中最常见的需求,JavaScript提供了多种方式来操作元素的内容。一、innerHTMLinnerHTML属性用于获取或设置元素的HTML内容,设置时会解析HTML标签。原始内容constcontent

- Java高并发编程核心:并发集合与原子类详解

msbQQ

java开发语言后端并发编程

在当今高并发、高吞吐的分布式系统中,Java并发编程已成为开发者必备的核心能力。当线程如潮水般涌来,如何确保数据安全?如何避免死锁陷阱?如何实现无阻塞的高效运算?答案就隐藏在并发集合与原子类这两大基石之中。1.并发集合:线程安全的容器1.1ConcurrentHashMap我在最开始学习这个容器的时候当时会记住它的特点是:线程安全,允许多个线程进行读和写。null值和键:ConcurrentHas

- Java 中的并发集合(Concurrent Collections)详解与使用指南

超级小忍

Javajava开发语言

前言在多线程编程中,共享数据结构的线程安全是一个关键问题。传统的集合类(如HashMap、ArrayList)并不是线程安全的,如果在并发环境下直接使用,可能会导致数据不一致、死锁等问题。为了解决这个问题,Java提供了一套线程安全的并发集合类,它们都位于java.util.concurrent包中。本文将详细介绍Java中常见的并发集合类,包括它们的实现原理、使用场景以及性能对比,帮助你更好地选

- (2)React的JSX语法

__method__

JSX−JSX是JavaScript语法的扩展。React开发不一定使用JSX,但我们建议使用它。要使用自定义的组件,要以大写字母开始自行编辑一个todolist页面首先在src下面创建src/TodoList.js,输入以下代码importReact,{Component}from"react";classTodoListextendsComponent{render(){return(todo

- JavaScript语言基础全解析:语法、面向对象与异步编程

白仑色

前端系列javascriptudp开发语言

引言:JavaScript的三大核心支柱JavaScript作为一门跨平台、多范式的编程语言,已从最初的网页脚本发展为全栈开发的基石。其语言基础可概括为三大核心:语法基础(变量、数据类型、控制流等)、面向对象与原型系统(独特的原型继承机制)、异步编程模型(处理非阻塞操作的核心方案)。掌握这三部分,不仅能写出规范的代码,更能深入理解JavaScript的设计哲学。本文将系统讲解这三大模块,每个知识点

- 【NLP舆情分析】基于python微博舆情分析可视化系统(flask+pandas+echarts) 视频教程 - 基于wordcloud库实现词云图

大家好,我是java1234_小锋老师,最近写了一套【NLP舆情分析】基于python微博舆情分析可视化系统(flask+pandas+echarts)视频教程,持续更新中,计划月底更新完,感谢支持。今天讲解基于wordcloud库实现词云图视频在线地址:2026版【NLP舆情分析】基于python微博舆情分析可视化系统(flask+pandas+echarts+爬虫)视频教程(火爆连载更新中..

- 能说说MyBatis的工作原理吗?

java1234_小锋

javajava开发语言

大家好,我是锋哥。今天分享关于【能说说MyBatis的工作原理吗?】面试题。希望对大家有帮助;能说说MyBatis的工作原理吗?超硬核AI学习资料,现在永久免费了!MyBatis是一个用于简化数据库操作的持久层框架,它通过SQL映射技术,将Java对象和数据库之间的关系映射起来。MyBatis的工作原理可以从以下几个方面来解析:1.配置文件的加载MyBatis通过加载配置文件来初始化框架。配置文件

- Java网络编程基础(TCP/IP协议、Socket编程)

扬子鳄008

Java网络javatcp/ip

Java网络编程是现代软件开发中的一个重要组成部分,尤其是在构建分布式系统和网络服务时。Java提供了丰富的网络编程API,使得开发者能够轻松地实现各种网络通信功能。本文将详细介绍Java网络编程的基础知识,包括TCP/IP协议和Socket编程的基本概念和实现方法。TCP/IP协议简介TCP/IP(传输控制协议/互联网协议)是一组用于网络通信的标准协议集。它由多个层次组成,每个层次负责不同的功能

- Java基础语法四件套:变量、数据类型、运算符、流程控制(新手必看)

杨凯凡

java开发语言

前言刚学Java就被变量和if-else绕晕了?别急!这篇博客将用“说人话”+代码演示的方式,带你彻底搞懂:如何声明变量?inta=10;和finaldoublePI=3.14;有什么区别?为什么10/3结果是3而不是3.333?for和while循环到底用哪个?学完这篇,你写的代码将从HelloWorld升级为能算能判能循环的智能程序!文章摘要核心内容:✅变量与常量:声明、作用域、final关键

- 子图同构算法-VF2(java实现)

xitianxiaofeixue

java数据结构

子图同构算法-VF2(java实现) 最近在项目中用到了子图同构算法VF2,自己查找的时候发现csdn上没有太详细的博客,所以在这里记录一下。内容主要来自一篇论文(A(Sub)GraphIsomorphismAlgorithmforMatchingLargeGraphs)一、什么是VF2算法 VF2算法是一种子图同构算法,而子图同构我们可以这样定义: 假设有两个图H=(VH,EH)H=(VH,EH

- Java List 集合详解:从基础到实战,掌握 Java 列表操作全貌

大葱白菜

java合集java开发语言后端学习个人开发

作为一名Java开发工程师,你一定在项目中频繁使用过List集合。它是Java集合框架中最常用、最灵活的数据结构之一。无论是从数据库查询出的数据,还是前端传递的参数列表,List都是处理这些数据的首选结构。本文将带你全面掌握:List接口的核心方法与特性常见实现类(如ArrayList、LinkedList、Vector、CopyOnWriteArrayList)List的遍历、增删改查、排序、线

- Java File 类详解:从基础操作到实战应用,掌握文件与目录处理全貌

作为一名Java开发工程师,你一定在实际开发中遇到过需要操作文件或目录的场景,例如:读写配置文件、上传下载、日志处理、文件遍历、路径管理等。Java提供了java.io.File类来帮助开发者完成这些任务。本文将带你全面掌握:File类的核心方法与功能文件与目录的创建、删除、重命名、判断是否存在等操作文件属性获取(大小、修改时间、是否是目录/文件等)文件路径的处理(绝对路径、相对路径、父路径等)F

- Java 递归方法详解:从基础语法到实战应用,彻底掌握递归编程思想

大葱白菜

java合集java开发语言个人开发后端学习

作为一名Java开发工程师,你一定在开发中遇到过需要重复调用自身逻辑的问题,比如:树形结构处理、文件夹遍历、斐波那契数列、算法实现(如DFS、回溯、分治)等。这时候,递归方法(RecursiveMethod)就成为你不可或缺的工具。本文将带你全面掌握:什么是递归方法?递归的三要素(边界条件、递归公式、递归方向)递归与循环的对比常见递归问题与实现(阶乘、斐波那契、汉诺塔、树遍历等)递归在真实项目中的

- Java 匿名内部类详解:简洁、灵活的内联类定义方式

大葱白菜

java合集开发语言后端java学习个人开发

作为一名Java开发工程师,你一定在开发过程中遇到过这样的场景:需要实现一个接口或继承一个类,但这个类只使用一次想简化代码结构,避免创建过多无意义的“一次性”类在事件监听器、线程任务、函数式编程中需要快速定义行为逻辑这时候,匿名内部类(AnonymousInnerClass)就派上用场了!本文将带你全面理解:什么是匿名内部类?匿名内部类的语法结构与执行流程使用场景与实际案例解析匿名内部类与Lamb

- Java 异常处理详解:从基础语法到最佳实践,打造健壮的 Java 应用

大葱白菜

java合集开发语言java后端个人开发学习

作为一名Java开发工程师,你一定遇到过运行时错误、空指针异常、文件找不到等问题。Java提供了强大的异常处理机制,帮助我们优雅地捕获和处理这些错误。本文将带你全面掌握:Java异常体系结构try-catch-finally的使用throw与throws的区别自定义异常类的设计Java7+新特性(try-with-resources)常见异常类型及排查方法异常处理的最佳实践与注意事项并通过丰富的代

- Java 常用 API 详解:掌握核心类库,提升开发效率

大葱白菜

java合集开发语言java后端学习个人开发

作为一名Java开发工程师,你每天都在与各种Java标准库打交道。熟练掌握Java中的常用API是提高代码质量、提升开发效率的关键技能之一。本文将带你全面了解Java开发中最常用的API类和接口,包括:java.lang包中的核心类(如String,Object,Math,System)集合框架(Collection,List,Set,Map)多线程相关类(Thread,Runnable,Exec

- Saprk中RDD詳解

文子轩

一.常用的transfromRDD算子通過並行化scala創建RDDvalrdd1=sc.parallelize(Array(1,2,3,4,5,6,7,8))查看該RDD的分區數量rdd1.partitions.lengthres23:Int=4使用filter算子valrdd2=sc.parallelize(List(5,6,4,7,3,8,2,9,1,10)).map(*2).sortBy(

- Java实习模拟面试之创玖科技:前后端交互、数据库、Spring全家桶、性能优化与Linux实战

培风图南以星河揽胜

java面试java面试科技

关键词:JavaScript、JQuery、Ajax、Node.js、MySQL、Oracle、Spring、SpringMVC、SpringBoot、MyBatis、Tomcat、Redis、Nginx、Linux、Git、SAAS系统开发一、面试开场:自我介绍面试官提问:请做个自我介绍,重点突出你的技术栈和项目经验。候选人回答:您好,我是一名计算机科学与技术专业的应届生,具备扎实的Java基础

- Java与机器学习的邂逅:Weka框架入门指南

墨夶

Java学习资料1java机器学习数据挖掘

在这个数据驱动的时代,机器学习已经成为各行业创新和优化的关键技术。而Java,作为一门成熟且广泛应用的编程语言,在企业级应用开发中占据着重要地位。将二者结合起来,利用Java实现机器学习算法,不仅可以充分发挥其强大的生态系统优势,还能为开发者提供一个高效、稳定的开发环境。今天,我们将带您走进Java与机器学习的世界,探索如何使用Weka这一著名的机器学习库来开启您的智能之旅。Weka简介及其优势什

- 前端实现抛物线小球动画效果:从原理到代码实践

编程随想▿

前端抛物线JSvuereact.js

目录引言一、抛物线动画的核心原理二、纯HTML/CSS实现抛物线动画1.HTML结构2.CSS动画3.效果说明三、动态交互:JavaScript实现抛物线动画1.HTML结构2.JavaScript逻辑3.效果说明四、Vue.js实现抛物线动画1.组件结构2.实现思路五、React实现抛物线动画1.组件代码2.实现思路六、注意事项七、总结引言在前端开发中,动画效果是提升用户体验的重要手段之一。抛物

- tomcat基础与部署发布

暗黑小菠萝

Tomcat java web

从51cto搬家了,以后会更新在这里方便自己查看。

做项目一直用tomcat,都是配置到eclipse中使用,这几天有时间整理一下使用心得,有一些自己配置遇到的细节问题。

Tomcat:一个Servlets和JSP页面的容器,以提供网站服务。

一、Tomcat安装

安装方式:①运行.exe安装包

&n

- 网站架构发展的过程

ayaoxinchao

数据库应用服务器网站架构

1.初始阶段网站架构:应用程序、数据库、文件等资源在同一个服务器上

2.应用服务和数据服务分离:应用服务器、数据库服务器、文件服务器

3.使用缓存改善网站性能:为应用服务器提供本地缓存,但受限于应用服务器的内存容量,可以使用专门的缓存服务器,提供分布式缓存服务器架构

4.使用应用服务器集群改善网站的并发处理能力:使用负载均衡调度服务器,将来自客户端浏览器的访问请求分发到应用服务器集群中的任何

- [信息与安全]数据库的备份问题

comsci

数据库

如果你们建设的信息系统是采用中心-分支的模式,那么这里有一个问题

如果你的数据来自中心数据库,那么中心数据库如果出现故障,你的分支机构的数据如何保证安全呢?

是否应该在这种信息系统结构的基础上进行改造,容许分支机构的信息系统也备份一个中心数据库的文件呢?

&n

- 使用maven tomcat plugin插件debug关联源代码

商人shang

mavendebug查看源码tomcat-plugin

*首先需要配置好'''maven-tomcat7-plugin''',参见[[Maven开发Web项目]]的'''Tomcat'''部分。

*配置好后,在[[Eclipse]]中打开'''Debug Configurations'''界面,在'''Maven Build'''项下新建当前工程的调试。在'''Main'''选项卡中点击'''Browse Workspace...'''选择需要开发的

- 大访问量高并发

oloz

大访问量高并发

大访问量高并发的网站主要压力还是在于数据库的操作上,尽量避免频繁的请求数据库。下面简

要列出几点解决方案:

01、优化你的代码和查询语句,合理使用索引

02、使用缓存技术例如memcache、ecache将不经常变化的数据放入缓存之中

03、采用服务器集群、负载均衡分担大访问量高并发压力

04、数据读写分离

05、合理选用框架,合理架构(推荐分布式架构)。

- cache 服务器

小猪猪08

cache

Cache 即高速缓存.那么cache是怎么样提高系统性能与运行速度呢?是不是在任何情况下用cache都能提高性能?是不是cache用的越多就越好呢?我在近期开发的项目中有所体会,写下来当作总结也希望能跟大家一起探讨探讨,有错误的地方希望大家批评指正。

1.Cache 是怎么样工作的?

Cache 是分配在服务器上

- mysql存储过程

香水浓

mysql

Description:插入大量测试数据

use xmpl;

drop procedure if exists mockup_test_data_sp;

create procedure mockup_test_data_sp(

in number_of_records int

)

begin

declare cnt int;

declare name varch

- CSS的class、id、css文件名的常用命名规则

agevs

JavaScriptUI框架Ajaxcss

CSS的class、id、css文件名的常用命名规则

(一)常用的CSS命名规则

头:header

内容:content/container

尾:footer

导航:nav

侧栏:sidebar

栏目:column

页面外围控制整体布局宽度:wrapper

左右中:left right

- 全局数据源

AILIKES

javatomcatmysqljdbcJNDI

实验目的:为了研究两个项目同时访问一个全局数据源的时候是创建了一个数据源对象,还是创建了两个数据源对象。

1:将diuid和mysql驱动包(druid-1.0.2.jar和mysql-connector-java-5.1.15.jar)copy至%TOMCAT_HOME%/lib下;2:配置数据源,将JNDI在%TOMCAT_HOME%/conf/context.xml中配置好,格式如下:&l

- MYSQL的随机查询的实现方法

baalwolf

mysql

MYSQL的随机抽取实现方法。举个例子,要从tablename表中随机提取一条记录,大家一般的写法就是:SELECT * FROM tablename ORDER BY RAND() LIMIT 1。但是,后来我查了一下MYSQL的官方手册,里面针对RAND()的提示大概意思就是,在ORDER BY从句里面不能使用RAND()函数,因为这样会导致数据列被多次扫描。但是在MYSQL 3.23版本中,

- JAVA的getBytes()方法

bijian1013

javaeclipseunixOS

在Java中,String的getBytes()方法是得到一个操作系统默认的编码格式的字节数组。这个表示在不同OS下,返回的东西不一样!

String.getBytes(String decode)方法会根据指定的decode编码返回某字符串在该编码下的byte数组表示,如:

byte[] b_gbk = "

- AngularJS中操作Cookies

bijian1013

JavaScriptAngularJSCookies

如果你的应用足够大、足够复杂,那么你很快就会遇到这样一咱种情况:你需要在客户端存储一些状态信息,这些状态信息是跨session(会话)的。你可能还记得利用document.cookie接口直接操作纯文本cookie的痛苦经历。

幸运的是,这种方式已经一去不复返了,在所有现代浏览器中几乎

- [Maven学习笔记五]Maven聚合和继承特性

bit1129

maven

Maven聚合

在实际的项目中,一个项目通常会划分为多个模块,为了说明问题,以用户登陆这个小web应用为例。通常一个web应用分为三个模块:

1. 模型和数据持久化层user-core,

2. 业务逻辑层user-service以

3. web展现层user-web,

user-service依赖于user-core

user-web依赖于user-core和use

- 【JVM七】JVM知识点总结

bit1129

jvm

1. JVM运行模式

1.1 JVM运行时分为-server和-client两种模式,在32位机器上只有client模式的JVM。通常,64位的JVM默认都是使用server模式,因为server模式的JVM虽然启动慢点,但是,在运行过程,JVM会尽可能的进行优化

1.2 JVM分为三种字节码解释执行方式:mixed mode, interpret mode以及compiler

- linux下查看nginx、apache、mysql、php的编译参数

ronin47

在linux平台下的应用,最流行的莫过于nginx、apache、mysql、php几个。而这几个常用的应用,在手工编译完以后,在其他一些情况下(如:新增模块),往往想要查看当初都使用了那些参数进行的编译。这时候就可以利用以下方法查看。

1、nginx

[root@361way ~]# /App/nginx/sbin/nginx -V

nginx: nginx version: nginx/

- unity中运用Resources.Load的方法?

brotherlamp

unity视频unity资料unity自学unityunity教程

问:unity中运用Resources.Load的方法?

答:Resources.Load是unity本地动态加载资本所用的方法,也即是你想动态加载的时分才用到它,比方枪弹,特效,某些实时替换的图像什么的,主张此文件夹不要放太多东西,在打包的时分,它会独自把里边的一切东西都会集打包到一同,不论里边有没有你用的东西,所以大多数资本应该是自个建文件放置

1、unity实时替换的物体即是依据环境条件

- 线段树-入门

bylijinnan

java算法线段树

/**

* 线段树入门

* 问题:已知线段[2,5] [4,6] [0,7];求点2,4,7分别出现了多少次

* 以下代码建立的线段树用链表来保存,且树的叶子结点类似[i,i]

*

* 参考链接:http://hi.baidu.com/semluhiigubbqvq/item/be736a33a8864789f4e4ad18

* @author lijinna

- 全选与反选

chicony

全选

<!DOCTYPE HTML PUBLIC "-//W3C//DTD HTML 4.01 Transitional//EN" "http://www.w3.org/TR/html4/loose.dtd">

<html>

<head>

<title>全选与反选</title>

- vim一些简单记录

chenchao051

vim

mac在/usr/share/vim/vimrc linux在/etc/vimrc

1、问:后退键不能删除数据,不能往后退怎么办?

答:在vimrc中加入set backspace=2

2、问:如何控制tab键的缩进?

答:在vimrc中加入set tabstop=4 (任何

- Sublime Text 快捷键

daizj

快捷键sublime

[size=large][/size]Sublime Text快捷键:Ctrl+Shift+P:打开命令面板Ctrl+P:搜索项目中的文件Ctrl+G:跳转到第几行Ctrl+W:关闭当前打开文件Ctrl+Shift+W:关闭所有打开文件Ctrl+Shift+V:粘贴并格式化Ctrl+D:选择单词,重复可增加选择下一个相同的单词Ctrl+L:选择行,重复可依次增加选择下一行Ctrl+Shift+L:

- php 引用(&)详解

dcj3sjt126com

PHP

在PHP 中引用的意思是:不同的名字访问同一个变量内容. 与C语言中的指针是有差别的.C语言中的指针里面存储的是变量的内容在内存中存放的地址 变量的引用 PHP 的引用允许你用两个变量来指向同一个内容 复制代码代码如下:

<?

$a="ABC";

$b =&$a;

echo

- SVN中trunk,branches,tags用法详解

dcj3sjt126com

SVN

Subversion有一个很标准的目录结构,是这样的。比如项目是proj,svn地址为svn://proj/,那么标准的svn布局是svn://proj/|+-trunk+-branches+-tags这是一个标准的布局,trunk为主开发目录,branches为分支开发目录,tags为tag存档目录(不允许修改)。但是具体这几个目录应该如何使用,svn并没有明确的规范,更多的还是用户自己的习惯。

- 对软件设计的思考

e200702084

设计模式数据结构算法ssh活动

软件设计的宏观与微观

软件开发是一种高智商的开发活动。一个优秀的软件设计人员不仅要从宏观上把握软件之间的开发,也要从微观上把握软件之间的开发。宏观上,可以应用面向对象设计,采用流行的SSH架构,采用web层,业务逻辑层,持久层分层架构。采用设计模式提供系统的健壮性和可维护性。微观上,对于一个类,甚至方法的调用,从计算机的角度模拟程序的运行情况。了解内存分配,参数传

- 同步、异步、阻塞、非阻塞

geeksun

非阻塞

同步、异步、阻塞、非阻塞这几个概念有时有点混淆,在此文试图解释一下。

同步:发出方法调用后,当没有返回结果,当前线程会一直在等待(阻塞)状态。

场景:打电话,营业厅窗口办业务、B/S架构的http请求-响应模式。

异步:方法调用后不立即返回结果,调用结果通过状态、通知或回调通知方法调用者或接收者。异步方法调用后,当前线程不会阻塞,会继续执行其他任务。

实现:

- Reverse SSH Tunnel 反向打洞實錄

hongtoushizi

ssh

實際的操作步驟:

# 首先,在客戶那理的機器下指令連回我們自己的 Server,並設定自己 Server 上的 12345 port 會對應到幾器上的 SSH port

ssh -NfR 12345:localhost:22

[email protected]

# 然後在 myhost 的機器上連自己的 12345 port,就可以連回在客戶那的機器

ssh localhost -p 1

- Hibernate中的缓存

Josh_Persistence

一级缓存Hiberante缓存查询缓存二级缓存

Hibernate中的缓存

一、Hiberante中常见的三大缓存:一级缓存,二级缓存和查询缓存。

Hibernate中提供了两级Cache,第一级别的缓存是Session级别的缓存,它是属于事务范围的缓存。这一级别的缓存是由hibernate管理的,一般情况下无需进行干预;第二级别的缓存是SessionFactory级别的缓存,它是属于进程范围或群集范围的缓存。这一级别的缓存

- 对象关系行为模式之延迟加载

home198979

PHP架构延迟加载

形象化设计模式实战 HELLO!架构

一、概念

Lazy Load:一个对象,它虽然不包含所需要的所有数据,但是知道怎么获取这些数据。

延迟加载貌似很简单,就是在数据需要时再从数据库获取,减少数据库的消耗。但这其中还是有不少技巧的。

二、实现延迟加载

实现Lazy Load主要有四种方法:延迟初始化、虚

- xml 验证

pengfeicao521

xmlxml解析

有些字符,xml不能识别,用jdom或者dom4j解析的时候就报错

public static void testPattern() {

// 含有非法字符的串

String str = "Jamey친ÑԂ

- div设置半透明效果

spjich

css半透明

为div设置如下样式:

div{filter:alpha(Opacity=80);-moz-opacity:0.5;opacity: 0.5;}

说明:

1、filter:对win IE设置半透明滤镜效果,filter:alpha(Opacity=80)代表该对象80%半透明,火狐浏览器不认2、-moz-opaci

- 你真的了解单例模式么?

w574240966

java单例设计模式jvm

单例模式,很多初学者认为单例模式很简单,并且认为自己已经掌握了这种设计模式。但事实上,你真的了解单例模式了么。

一,单例模式的5中写法。(回字的四种写法,哈哈。)

1,懒汉式

(1)线程不安全的懒汉式

public cla

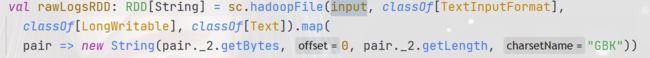

这里先分析下乱码原因,因为spark没有自己读取文件的方式所以它采用了hadoop的默认读取文件方式,一般日志文件的格式是

这里先分析下乱码原因,因为spark没有自己读取文件的方式所以它采用了hadoop的默认读取文件方式,一般日志文件的格式是