-

{ {element.positionName}}

[ { {element.workAddress}}] { {element.createTime}} 发布{ {element.salary}} 经验{ {element.workYear}}年 / { {element.education}}{ {element.companyName}} 该企业已经上 传营业执照并通过资质验证审核福利 【{ {element.positionAdvantage}}】

Elasticsearch7.x搜索实战

Elasticsearch7.x

- 第一部分 全文搜索引擎Elasticsearch基础

-

- 第1节 Elasticsearch是什么

- 第2节 Elasticsearch的功能

- 第3节 Elasticsearch的特点

- 第4节 Elasticsearch企业使用场景

- 第5节 主流全文搜索方案对比

- 第6节 Elasticsearch的版本

-

- 1.Elasticsearch版本介绍

- 2.Elasticsearch与其他软件兼容

-

- 2.1Elasticsearch与操作系统

- 第7节 Elasticseach Single-Node Mode快速部署

- 第二部分 玩转Elasticsearch之入门使用

-

- 第1节 核心概念

- 第2节 Elasticsearch API介绍

- 第3节 安装配置kibana

- 第4节 Elasticsearch集成IK分词器

- 第5节 索引操作(创建、查看、删除)

- 第6节 映射操作

- 第7节 文档增删改查及局部更新

- 第三部分 玩转Elasticsearch之高级应用

-

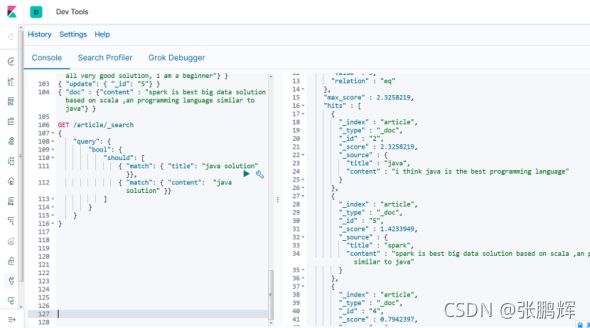

- 第2节 Query DSL

-

- 1. 查询所有(match_all query)

- 2. 全文搜索(full-text query)

-

- 2.2.1 匹配搜索(match query)

- 2.2.2 短语搜索(match phrase query)

- 2.2.3 query_string 查询

- 2.2.4 多字段匹配搜索(multi match query)

- 第3节 Filter DSL

- 第4节 定位非法搜索及原因

- 第6节 玩转Elasticsearch零停机索引重建

- 第7节 玩转Elasticsearch Suggester智能搜索建议

- 第8节 玩转Elasticsearch Java Client

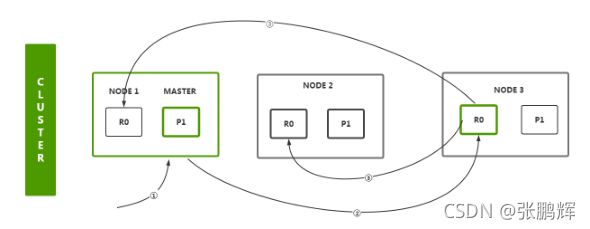

- 第四部分 玩转Elasticsearch之企业级高可用分布式集群

-

- 第1节 核心概念

- 第3节 集群环境搭建

- 第4节 集群规划

-

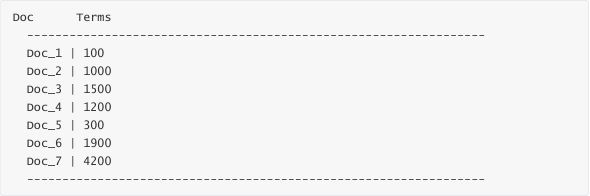

- 4.1 我们需要多大规模的集群

- 4.2 集群中的节点角色如何分配

- 4.3 如何避免脑裂问题

- 4.4 索引应该设置多少个分片

- 4.5 分片应该设置几个副本

- 第5节 分布式集群调优策略

-

- 1. Index(写)调优

-

- 1.1 副本数置0

- 1.2 自动生成doc ID

- 1.3 合理设置mappings

- 1.4 调整_source字段

- 1.5 对analyzed的字段禁用norms

- 1.6 调整索引的刷新间隔

- 1.7 批处理

- 第五部分 玩转Elasticsearch之数据模型构建

-

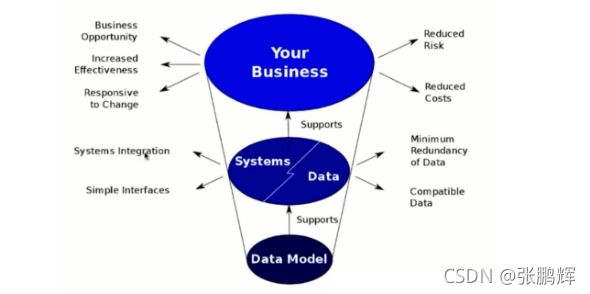

- 第1节 什么是数据模型

- 第2节 数据建模的过程

- 第3节 数据建模的意义

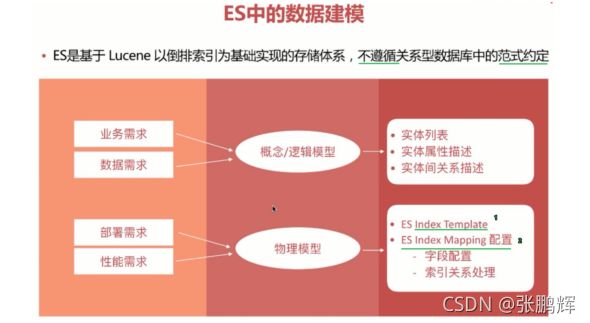

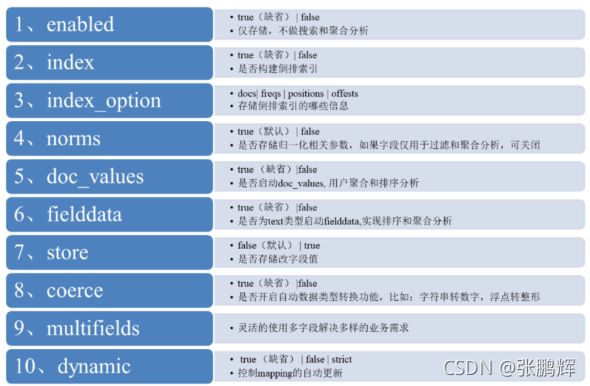

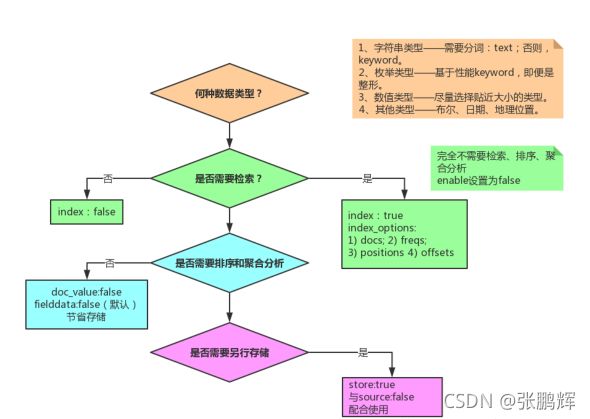

- 第4节 ES数据建模Mapping设置

- 第5节 ES关联关系处理

- 第六部分 玩转Elasticsearch之搜索实战

-

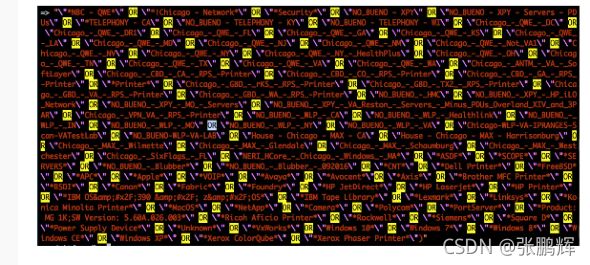

- 第1节 案例需求

- 第七部分 玩转Elasticsearch之深度应用及原理剖析

-

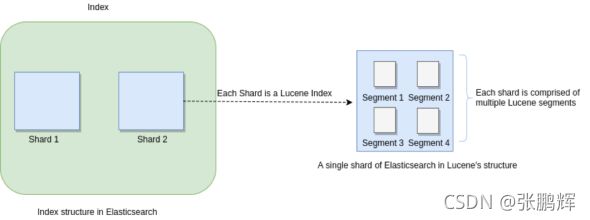

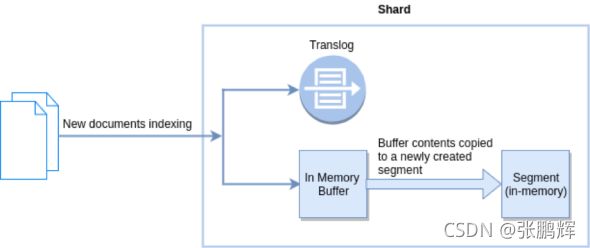

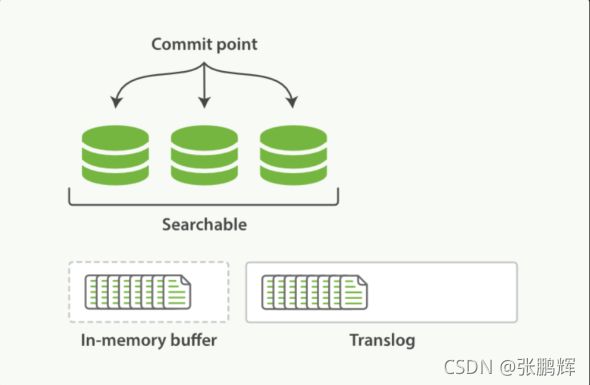

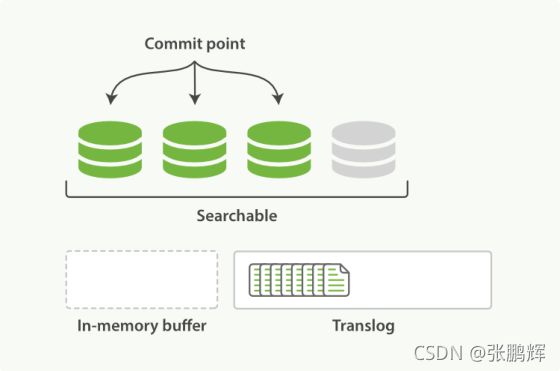

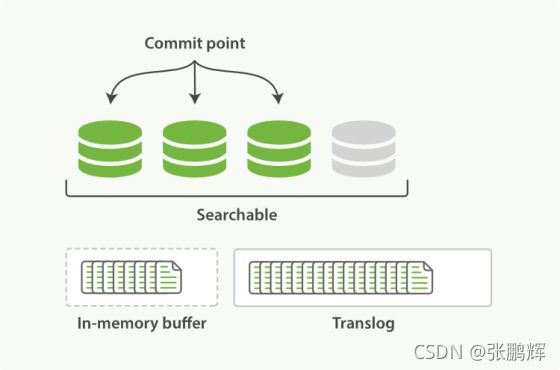

- 第1节 索引文档写入和近实时搜索原理

- 第2节 索引文档存储段合并机制(segment merge、policy、optimize)

- 第3节 并发冲突处理机制剖析

-

- 1. 详解并发冲突

- 2. 解决方案

-

- 2.1 悲观锁

- 2.2 乐观锁

- 2.3 Elasticsearch的乐观锁

- 2.4 es的乐观锁并发控制示例

- 第4节 分布式数据一致性如何保证?quorum及timeout机制的原理

- 第5节 Query文档搜索机制剖析

- 第6节 文档增删改和搜索请求过程

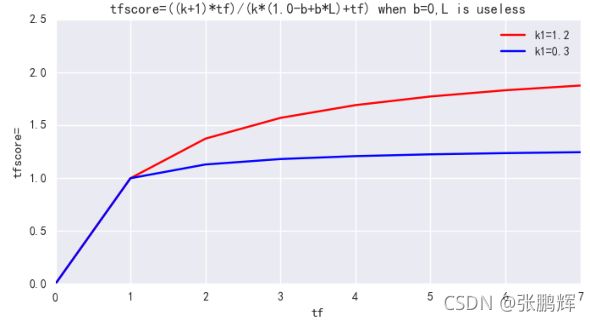

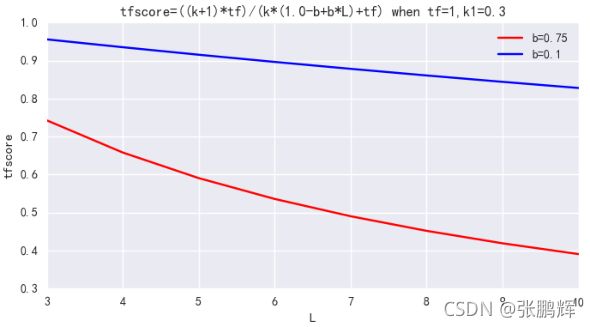

- 第7节 相关性评分算法BM25

- 第8节 排序那点事之内核级DocValues机制大揭秘

- 第9节 Filter过滤机制剖析(bitset机制与caching机制)

- 第10节 控制搜索精准度 - 基于boost的细粒度搜索的条件权重控制

- 第11节 控制搜索精准度 - 基于dis_max实现best fields策略

- 第12节 控制搜索精准度 - 基于function_score自定义相关度分数算法

- 第13节 bulk操作的api json格式与底层性能优化的关系?

- 第14节 deep paging性能问题 和 解决方案

主要课程内容

Elasticsearch 是一个分布式的 开源搜索和分析引擎

第一部分:全文搜索引擎Elasticsearch基础

ES是什么 功能 特点 使用场景 搜索方案对比 版本介绍 环境搭建

第二部分:玩转Elasticsearch之入门使用

核心概念(索引 类型 映射 ) API介绍 Kibana安装使用 IK分词器 索引操作 映射操作 文档操作

第三部分:玩转Elasticsearch之高级应用

映射高级(地理坐标类型 动态映射 自定义映射) DSL(全部匹配 全文搜索(match query string phrase ) 词条匹配(范围 正则 模糊 id ) 复合搜索高亮 分页 批处理)Filter 定位非法搜索以及原因 聚合操作 零停机索引重建方案 智能搜索建议 SpringBoot访问ES (RestClient)

第四部分:玩转Elasticsearch之企业级高可用分布式集群

集群核心概念(cluster node 分片 副本 ) ES整体结构 集群搭建 head插件安装查看集群

集群规划 集群调优策略

第五部分:玩转Elasticsearch之数据模型构建

数据模型 数据建模过程 数据建模意义 mapping映射和建模 关联关系处理

第六部分:玩转Elasticsearch之搜索实战

职位搜索 数据从MySQL导入到ES ES的搜索

第七部分:玩转Elasticsearch之深度应用及原理剖析

文档写入和近实时搜索的原理 文件合并机制 并发冲突处理 分布式数据一致性如何保证 文档索引和搜索过程 相关性得分算法BM25 doc_values Query文档搜索机制剖析 Filter过滤机制剖析 控制搜索精准度bulk操作json格式和底层优化关系 深度分页性能问题

第一部分 全文搜索引擎Elasticsearch基础

第1节 Elasticsearch是什么

Elaticsearch简称为ES,是一个开源的可扩展的分布式的全文检索引擎,它可以近乎实时的存储、检索数据。本身扩展性很好,可扩展到上百台服务器,处理PB级别的数据。ES使用Java开发并使用Lucene作为其核心来实现索引和搜索的功能,但是它通过简单的RestfulAPI和javaAPI来隐藏Lucene的复杂性,从而让全文搜索变得简单。

Elasticsearch官网:官网

起源:Shay Banon。2004年失业,陪老婆去伦敦学习厨师。失业在家帮老婆写一个菜谱搜索引擎。封装了lucene,做出了开源项目compass。找到工作后,做分布式高性能项目,再封装compass,写出了elasticsearch,使得lucene支持分布式。现在是Elasticsearch创始人兼Elastic首席执行官。

第2节 Elasticsearch的功能

分布式的搜索引擎

分布式:Elasticsearch自动将海量数据分散到多台服务器上去存储和检索

搜索:百度、谷歌,站内搜索

全文检索

提供模糊搜索等自动度很高的查询方式,并进行相关性排名,高亮等功能

数据分析引擎(分组聚合)

电商网站,最近一周笔记本电脑这种商品销量排名top10的商家有哪些?新闻网站,最近1个月访问量排名top3的新闻板块是哪些

对海量数据进行近实时的处理

海量数据的处理:因为是分布式架构,Elasticsearch可以采用大量的服务器去存储和检索数据,自然而然就可以实现海量数据的处理

近实时:Elasticsearch可以实现秒级别的数据搜索和分析

第3节 Elasticsearch的特点

Elasticsearch的特点是它提供了一个极速的搜索体验。这源于它的高速(speed)。相比较其它的一些大数据引擎,Elasticsearch可以实现秒级的搜索,速度非常有优势。Elasticsearch的cluster是一种分布式的部署,极易扩展(scale )这样很容易使它处理PB级的数据库容量。最重要的是Elasticsearch是它搜索的结果可以按照分数进行排序,它能提供我们最相关的搜索结果(relevance) 。

- 安装方便:没有其他依赖,下载后安装非常方便;只用修改几个参数就可以搭建起来一个集群

- JSON:输入/输出格式为 JSON,意味着不需要定义 Schema,快捷方便

- RESTful:基本所有操作 ( 索引、查询、甚至是配置 ) 都可以通过 HTTP 接口进行

- 分布式:节点对外表现对等(每个节点都可以用来做入口) 加入节点自动负载均衡

- 多租户:可根据不同的用途分索引,可以同时操作多个索引

- 支持超大数据: 可以扩展到 PB 级的结构化和非结构化数据 海量数据的近实时处理

第4节 Elasticsearch企业使用场景

1.常见场景

1. 搜索类场景

比如说电商网站、招聘网站、新闻资讯类网站、各种app内的搜索。

2. 日志分析类场景

经典的ELK组合(Elasticsearch/Logstash/Kibana),可以完成日志收集,日志存储,日志分析查询界面基本功能,目前该方案的实现很普及,大部分企业日志分析系统使用了该方案。

3. 数据预警平台及数据分析场景

例如电商价格预警,在支持的电商平台设置价格预警,当优惠的价格低于某个值时,触发通知消息,通知用户购买。

数据分析常见的比如分析电商平台销售量top 10的品牌,分析博客系统、头条网站top 10关注度、评论数、访问量的内容等等。

4. 商业BI(Business Intelligence)系统

比如大型零售超市,需要分析上一季度用户消费金额,年龄段,每天各时间段到店人数分布等信息,输出相应的报表数据,并预测下一季度的热卖商品,根据年龄段定向推荐适宜产品。

Elasticsearch执行数据分析和挖掘,Kibana做数据可视化。

2.常见案例

维基百科、百度百科:有全文检索、高亮、搜索推荐功能

stack overflow:有全文检索,可以根据报错关键信息,去搜索解决方法。

github:从上千亿行代码中搜索你想要的关键代码和项目。

日志分析系统:各企业内部搭建的ELK平台。

第5节 主流全文搜索方案对比

Lucene、Solr、Elasticsearch是目前主流的全文搜索方案,基于倒排索引机制完成快速全文搜索。

Lucene

Lucene是Apache基金会维护的一套完全使用Java编写的信息搜索工具包(Jar包),它包含了索引结构、读写索引工具、相关性工具、排序等功能,因此在使用Lucene时仍需要我们自己进一步开发搜索引擎系统,例如数据获取、解析、分词等方面的东西。

注意:Lucene只是一个框架,我们需要在Java程序中集成它再使用。而且需要很多的学习才能明白它是如何运行的,熟练运用Lucene非常复杂。

Solr

Solr是一个有HTTP接口的基于Lucene的查询服务器,是一个搜索引擎系统,封装了很多Lucene细节,Solr可以直接利用HTTP GET/POST请求去查询,维护修改索引。

Elasticsearch

Elasticsearch也是一个建立在全文搜索引擎 Apache Lucene基础上的搜索引擎。采用的策略是分布式实时文件存储,并将每一个字段都编入索引,使其可以被搜索。

三者之间的区别和联系

Solr和Elasticsearch都是基于Lucene实现的。但Solr和Elasticsearch之间也是有区别的

1)Solr利用Zookpper进行分布式管理,而Elasticsearch自身带有分布式协调管理功能

2)Solr比Elasticsearch实现更加全面,Solr官方提供的功能更多,而Elasticsearch本身更注重于核心功能, 高级功能多由第三方插件提供

3)Solr在传统的搜索应用中表现好于Elasticsearch,而Elasticsearch在实时搜索应用方面比Solr表现好

https://db-engines.com/en/ranking

第6节 Elasticsearch的版本

1.Elasticsearch版本介绍

Elasticsearch 主流版本为5.x , 6.x及7.x版本

7.x 更新的内容如下

- 集群连接变化:TransportClient被废弃

以至于,es7的java代码,只能使用restclient。对于java编程,建议采用 High-level-rest-client 的方式操作ES集群。High-level REST client 已删除接受Header参数的API方法,Cluster Health API默认为集群级别。

- ES数据存储结构变化:简化了Type 默认使用_doc

es6时,官方就提到了es7会逐渐删除索引type,并且es6时已经规定每一个index只能有一个type。在es7中使用默认的_doc作为type,官方说在8.x版本会彻底移除type。api请求方式也发送变化,如获得某索引的某ID的文档:GET index/_doc/id其中index和id为具体的值

- ES程序包默认打包jdk:以至于7.x版本的程序包大小突然增大了200MB+, 对比6.x发现,包大了200MB+, 正是JDK的大小

- 默认配置变化:默认节点名称为主机名,默认分片数改为1,不再是5。

- Lucene升级为lucene 8 查询相关性速度优化:Weak-AND算法 es可以看过是分布式lucene,lucene的性能直接决定es的性能。lucene8在top k及其他查询上有很大的性能提升。

weak-and算法 核心原理:取TOP N结果集,估算命中记录数。

TOP N的时候会跳过得分低于10000的文档来达到更快的性能。

- 间隔查询(Intervals queries): intervals query 允许用户精确控制查询词在文档中出现的先后关系,实现了对terms顺序、terms之间的距离以及它们之间的包含关系的灵活控制。

- 引入新的集群协调子系统 移除 minimum_master_nodes 参数,让 Elasticsearch 自己选择可以形成仲裁的节点。

- 7.0将不会再有OOM的情况,JVM引入了新的circuit breaker(熔断)机制,当查询或聚合的数据量超出单机处理的最大内存限制时会被截断。设置indices.breaker.fielddata.limit的默认值已从JVM堆大小的60%降低到40%。

- 分片搜索空闲时跳过refresh

以前版本的数据插入,每一秒都会有refresh动作,这使得es能成为一个近实时的搜索引擎。但是当没有查询需求的时候,该动作会使得es的资源得到较大的浪费。

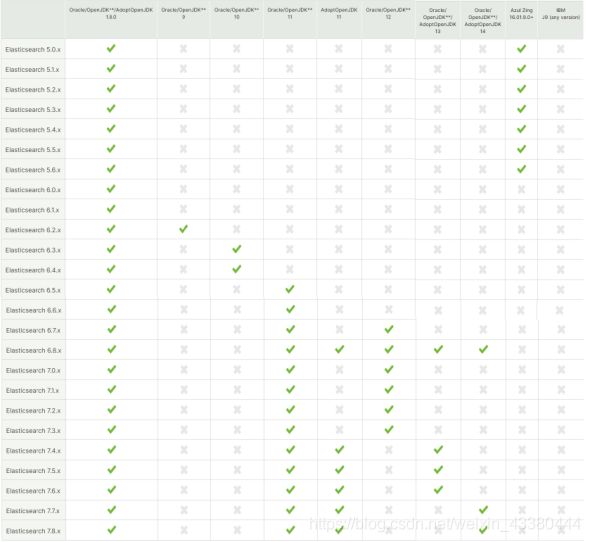

2.Elasticsearch与其他软件兼容

2.1Elasticsearch与操作系统

第7节 Elasticseach Single-Node Mode快速部署

Elasticsearch是一个分布式全文搜索引擎,支持单节点模式(Single-Node Mode)和集群模式(Cluster Mode)部署,一般来说,小公司的业务场景往往使用Single-Node Mode部署即可。课程中我们先以 Single-Node Mode部署实例学习,随后再专门讲授集群模式相关内容。

- 虚拟机环境准备

准备一台虚拟机

操作系统:CentOS 7.x 64 bit

客户端连接工具:XShell

关闭虚拟机的防火墙

systemctl stop firewalld.service #停止firewall

systemctl disable firewalld.service #禁止firewall开机启动

firewall-cmd --state # 查看防火墙

- Elasticsearch Single-Node Mode部署

我们在虚拟机上部署Single-Node Mode Elasticsearch

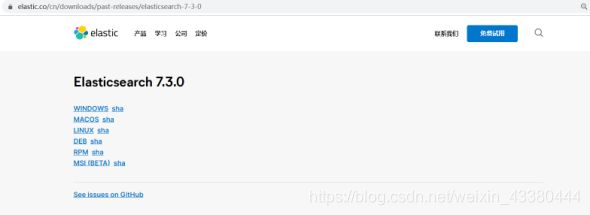

下载Elasticsearch

地址: https://www.elastic.co/cn/downloads/elasticsearch 最新版本

下载: https://www.elastic.co/cn/downloads/past-releases/elasticsearch-7.3…0 版本

选择Linux版本下载:

开始安装JDK

1.解压三个tar.gz文件

tar -zxvf jdk-8u171-linux-x64.tar.gz

tar -zxvf elasticsearch-7.3.0-linux-x86_64.tar.gz

2.移动文件到安装目录

mv /root/jdk1.8.0_171 /usr/java/

mv /root/elasticsearch-7.3.0 /usr/elasticsearch/

3.配置jdk环境变量

vim /etc/profile

在profile结尾添加如下内容:

JAVA_HOME=/usr/java

JRE_HOME=/usr/java/jre

CLASS_PATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

export JAVA_HOME JRE_HOME CLASS_PATH PATH

source /etc/profile

java -version

jdk配置完成!

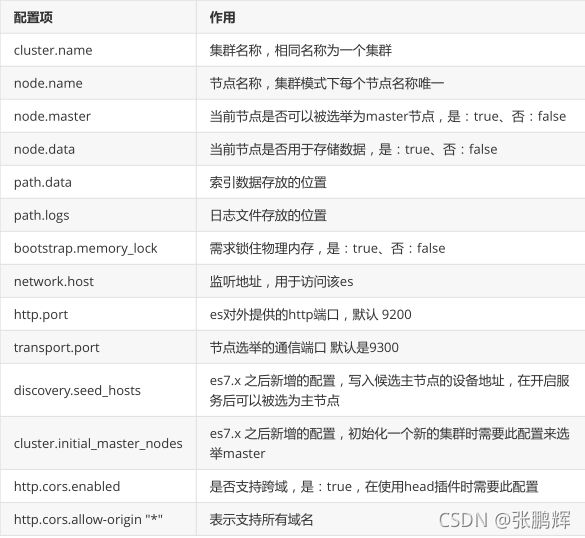

配置Elasticsearch

1.编辑vim /usr/elasticsearch/config/elasticsearch.yml ,注意冒号后面有个空格。

vim /usr/elasticsearch/config/elasticsearch.yml

单机安装请取消注释:node.name: node-1,否则无法正常启动。

修改网络和端口,取消注释master节点,单机只保留一个node

node.name: node-1

network.host: 192.168.211.136

#

# Set a custom port for HTTP:

#

http.port: 9200

cluster.initial_master_nodes: ["node-1"]

2.按需修改vim /usr/elasticsearch/config/jvm.options内存设置

vim /usr/elasticsearch/config/jvm.options

根据实际情况修改占用内存,默认都是1G,单机1G内存,启动会占用700m+然后在安装kibana后,基本上无法运行了,运行了一会就挂了报内存不足。 内存设置超出物理内存,也会无法启动,启动报错。

-Xms1g

-Xmx1g

3.添加es用户,es默认root用户无法启动,需要改为其他用户

useradd estest

修改密码

passwd estest

改变es目录拥有者账号

chown -R estest /usr/elasticsearch/

4.修改/etc/sysctl.conf

vim /etc/sysctl.conf

末尾添加:vm.max_map_count=655360

执行sysctl -p 让其生效

sysctl -p

5.修改/etc/security/limits.conf

vim /etc/security/limits.conf

末尾添加:

* soft nofile 65536

* hard nofile 65536

* soft nproc 4096

* hard nproc 4096

6.启动es

切换刚刚新建的用户

su estest

启动命令

/usr/elasticsearch/bin/elasticsearch

7.配置完成:浏览器访问测试。 ip:9200

第二部分 玩转Elasticsearch之入门使用

Elasticsearch是基于Lucene的全文检索引擎,本质也是存储和检索数据。ES中的很多概念与MySQL类似 我们可以按照关系型数据库的经验去理解。

第1节 核心概念

索引(index)

类似的数据放在一个索引,非类似的数据放不同索引, 一个索引也可以理解成一个关系型数据库。

类型(type)

代表document属于index中的哪个类别(type)也有一种说法一种type就像是数据库的表,比如dept表,user表。

注意ES每个大版本之间区别很大:

ES 5.x中一个index可以有多种type。

ES 6.x中一个index只能有一种type。

ES 7.x以后 要逐渐移除type这个概念。

映射(mapping)

mapping定义了每个字段的类型等信息。相当于关系型数据库中的表结构。

常用数据类型:text、keyword、number、array、range、boolean、date、geo_point、ip、nested、object

https://www.elastic.co/guide/en/elasticsearch/reference/current/mapping-types.html#_multi_fields_2

第2节 Elasticsearch API介绍

Elasticsearch提供了Rest风格的API,即http请求接口,而且也提供了各种语言的客户端API。

Rest风格API

文档地址:https://www.elastic.co/guide/en/elasticsearch/reference/current/index.html

客户端API

Elasticsearch支持的语言客户端非常多:https://www.elastic.co/guide/en/elasticsearch/client/index.html,我们在实战时将使用到Java客户端

API

ElasticSearch没有自带图形化界面,我们可以通过安装ElasticSearch的图形化插件,完成图形化界面的效果,完成索引数据的查看,比如可视化插件Kibana。

第3节 安装配置kibana

1.什么是Kibana

Kibana是一个基于Node.js的Elasticsearch索引库数据统计工具,可以利用Elasticsearch的聚合功能,生成各种图表,如柱形图,线状图,饼图等。

而且还提供了操作Elasticsearch索引数据的控制台,并且提供了一定的API提示,非常有利于我们学习Elasticsearch的语法。

2.安装Kibana

1)下载Kibana

kibana与操作系统

2) 安装kibana

root账户下操作

tar -zxvf kibana-7.3.0-linux-x86_64.tar.gz

mv /root/kibana-7.3.0-linux-x86_64 /usr/kibana/

改变es目录拥有者账号

chown -R estest /usr/kibana/

还需要设置访问权限

chmod -R 777 /usr/kibana/

修改配置文件

vim /usr/kibana/config/kibana.yml

修改端口,访问ip,elasticsearch服务器ip

server.port: 5601

server.host: "0.0.0.0"

# The URLs of the Elasticsearch instances to use for all your queries.elasticsearch.hosts: ["http://192.168.211.136:9200"]

配置完成启动:

切换用户

su estest

./bin/kibana(路径:/usr/kibana)

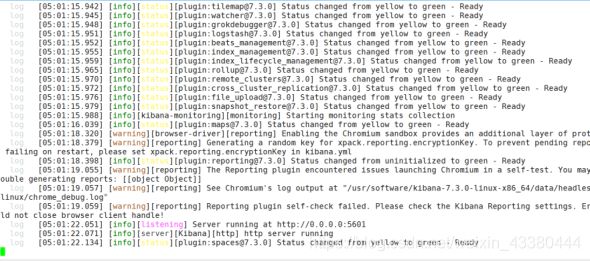

没有error错误启动成功:

访问ip:5601,即可看到安装成功

已全部安装完成,然后可以接入数据使用了。

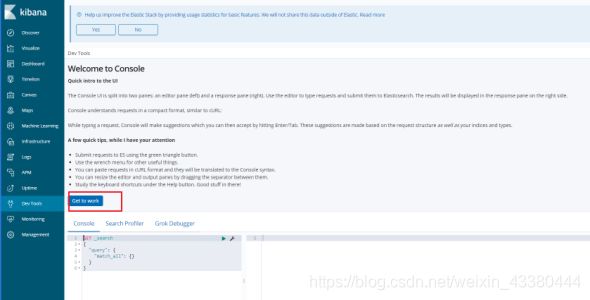

3) kidbana使用页面

选择左侧的DevTools菜单,即可进入控制台页面:

在页面右侧,我们就可以输入请求,访问Elasticsearch了。

4 )扩展kibana dev tools快捷键:

ctrl+enter 提交请求

ctrl+i 自动缩进

第4节 Elasticsearch集成IK分词器

- 集成IK分词器

IKAnalyzer是一个开源的,基于java语言开发的轻量级的中文分词工具包。从2006年12月推出1.0版

开始,IKAnalyzer已经推出 了3个大版本。最初,它是以开源项目Lucene为应用主体的,结合词典分词

和文法分析算法的中文分词组件。新版本的IKAnalyzer3.0则发展为 面向Java的公用分词组件,独立于

Lucene项目,同时提供了对Lucene的默认优化实现。

IK分词器3.0的特性如下:

1)采用了特有的“正向迭代最细粒度切分算法“,具有60万字/秒的高速处理能力。

2)采用了多子处理器分析模式,支持:英文字母(IP地址、Email、URL)、数字(日期,常用中文数

量词,罗马数字,科学计数法),中文词汇(姓名、地名处理)等分词处理。

3)支持个人词条的优化的词典存储,更小的内存占用。

4)支持用户词典扩展定义。

5)针对Lucene全文检索优化的查询分析器IKQueryParser;采用歧义分析算法优化查询关键字的搜索

排列组合,能极大的提高Lucene检索的命中率

下载地址:

https://github.com/medcl/elasticsearch-analysis-ik/releases/tag/v7.3.0

下载插件并安装(安装方式一)

1)在elasticsearch的bin目录下执行以下命令,es插件管理器会自动帮我们安装,然后等待安装完成:

/usr/elasticsearch/bin/elasticsearch-plugin install

https://github.com/medcl/elasticsearch-analysis-

ik/releases/download/v7.3.0/elasticsearch-analysis-ik-7.3.0.zip

2)下载完成后会提示 Continue with installation?输入 y 即可完成安装

3)重启Elasticsearch 和Kibana

上传安装包安装 (安装方式二)

1)在elasticsearch安装目录的plugins目录下新建 analysis-ik 目录

#新建analysis-ik文件夹

mkdir analysis-ik

#切换至 analysis-ik文件夹下

cd analysis-ik

#上传资料中的 elasticsearch-analysis-ik-7.3.0.zip

#解压

unzip elasticsearch-analysis-ik-7.3.3.zip

#解压完成后删除zip

rm -rf elasticsearch-analysis-ik-7.3.0.zip

2)重启Elasticsearch 和Kibana

测试案例

IK分词器有两种分词模式:ik_max_word和ik_smart模式。

1)ik_max_word (常用)

会将文本做最细粒度的拆分

2)ik_smart

会做最粗粒度的拆分

大家先不管语法,我们先在Kibana测试一波输入下面的请求:

POST _analyze

{

"analyzer": "ik_max_word",

"text": "南京市长江大桥"

}

ik_max_word 分词模式运行得到结果:

{

"tokens": [{

"token": "南京市",

"start_offset": 0,

"end_offset": 3,

"type": "CN_WORD",

"position": 0

},

{

"token": "南京",

"start_offset": 0,

"end_offset": 2,

"type": "CN_WORD",

"position": 1

},

{

"token": "市长",

"start_offset": 2,

"end_offset": 4,

"type": "CN_WORD",

"position": 2

},

{

"token": "长江大桥",

"start_offset": 3,

"end_offset": 7,

"type": "CN_WORD",

"position": 3

},

{

"token": "长江",

"start_offset": 3,

"end_offset": 5,

"type": "CN_WORD",

"position": 4

},

{

"token": "大桥",

"start_offset": 5,

"end_offset": 7,

"type": "CN_WORD",

"position": 5

}

]}

POST _analyze

{

"analyzer": "ik_smart",

"text": "南京市长江大桥"

}

ik_smart分词模式运行得到结果:

{

"tokens": [{

"token": "南京市",

"start_offset": 0,

"end_offset": 3,

"type": "CN_WORD",

"position": 0

},

{

"token": "长江大桥",

"start_offset": 3,

"end_offset": 7,

"type": "CN_WORD",

"position": 1

}

]

}

如果现在假如江大桥是一个人名,是南京市市长,那么上面的分词显然是不合理的,该怎么办?

2 扩展词典使用

扩展词:就是不想让哪些词被分开,让他们分成一个词。比如上面的江大桥

自定义扩展词库

1)进入到 config/analysis-ik/(插件命令安装方式) 或 plugins/analysis-ik/config(安装包安装方式) 目录下, 新增自定义词典

vim lagou_ext_dict.dic

输入 :江大桥

2)将我们自定义的扩展词典文件添加到IKAnalyzer.cfg.xml配置中

vim IKAnalyzer.cfg.xml

IK Analyzer 扩展配置

lagou_ext_dict.dic

lagou_stop_dict.dic

3)重启Elasticsearch

3 停用词典使用

停用词:有些词在文本中出现的频率非常高。但对本文的语义产生不了多大的影响。例如英文的a、an、the、of等。或中文的”的、了、呢等”。这样的词称为停用词。停用词经常被过滤掉,不会被进行索引。在检索的过程中,如果用户的查询词中含有停用词,系统会自动过滤掉。停用词可以加快索引的速度,减少索引库文件的大小。

自定义停用词库

1)进入到 config/analysis-ik/(插件命令安装方式) 或 plugins/analysis-ik/config(安装包安装方式) 目录下, 新增自定义词典

vim lagou_stop_dict.dic

输入

的

了

啊

2)将我们自定义的停用词典文件添加到IKAnalyzer.cfg.xml配置中

3)重启Elasticsearch

4 同义词典使用

语言博大精深,有很多相同意思的词,我们称之为同义词,比如“番茄”和“西红柿”,“馒头”和“馍”等。在

搜索的时候,我们输入的可能是“番茄”,但是应该把含有“西红柿”的数据一起查询出来,这种情况叫做

同义词查询。

注意:扩展词和停用词是在索引的时候使用,而同义词是检索时候使用。

配置IK同义词

Elasticsearch 自带一个名为 synonym 的同义词 filter。为了能让 IK 和 synonym 同时工作,我们需要

定义新的 analyzer,用 IK 做 tokenizer,synonym 做 filter。听上去很复杂,实际上要做的只是加一段

配置。

1)创建/config/analysis-ik/synonym.txt 文件,输入一些同义词并存为 utf-8 格式。例如

lagou,拉勾

china,中国

1)创建索引时,使用同义词配置,示例模板如下

PUT /索引名称

{

"settings": {

"analysis": {

"filter": {

"word_sync": {

"type": "synonym",

"synonyms_path": "analysis-ik/synonym.txt"

}

},

"analyzer": {

"ik_sync_max_word": {

"filter": [

"word_sync"

],

"type": "custom",

"tokenizer": "ik_max_word"

},"ik_sync_smart": {

"filter": [

"word_sync"

],

"type": "custom",

"tokenizer": "ik_smart"

}

}

}

},

"mappings": {

"properties": {

"字段名": {

"type": "字段类型",

"analyzer": "ik_sync_smart",

"search_analyzer": "ik_sync_smart"

}

}

}

}

以上配置定义了ik_sync_max_word和ik_sync_smart这两个新的 analyzer,对应 IK 的 ik_max_word 和ik_smart 两种分词策略。ik_sync_max_word和 ik_sync_smart都会使用 synonym filter 实现同义词转换

3)到此,索引创建模板中同义词配置完成,搜索时指定分词为ik_sync_max_word或ik_sync_smart。

4)案例

PUT /lagou-es-synonym

{

"settings": {

"analysis": {

"filter": {

"word_sync": {

"type": "synonym",

"synonyms_path": "analysis-ik/synonym.txt"

}

},

"analyzer": {

"ik_sync_max_word": {

"filter": [

"word_sync"

],

"type": "custom",

"tokenizer": "ik_max_word"

},"ik_sync_smart": {

"filter": [

"word_sync"

],

"type": "custom",

"tokenizer": "ik_smart"

}

}

}

},

"mappings": {

"properties": {

"name": {

"type": "text",

"analyzer": "ik_sync_max_word",

"search_analyzer": "ik_sync_max_word"

}

}

}

}

插入数据

POST /lagou-es-synonym/_doc/1

{

"name":"拉勾是中国专业的互联网招聘平台"

}

使用同义词"lagou"或者“china”进行搜索

POST /lagou-es-synonym/_doc/_search

{

"query": {

"match": {

"name": "lagou"

}

}

}

第5节 索引操作(创建、查看、删除)

- 创建索引库

Elasticsearch采用Rest风格API,因此其API就是一次http请求,你可以用任何工具发起http请求

语法

PUT /索引名称

{

"settings": {

"属性名": "属性值"

}

}

settings:就是索引库设置,其中可以定义索引库的各种属性 比如分片数 副本数等,目前我们可以不设置,都走默认

示例

PUT /lagou-company-index

可以看到索引创建成功了。

2. 判断索引是否存在

语法

HEAD /索引名称

示例 HEAD /lagou-company-index

3.查看索引

Get请求可以帮我们查看索引的相关属性信息,格式:

查看单个索引

语法

GET /索引名称

示例 GET /lagou-company-index

批量查看索引

语法

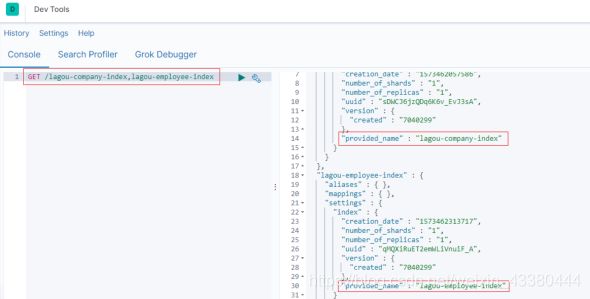

GET /索引名称1,索引名称2,索引名称3,…

示例 GET /lagou-company-index,lagou-employee-index

查看所有索引

方式一

GET _all

方式二

GET /_cat/indices?v

绿色:索引的所有分片都正常分配。

黄色:至少有一个副本没有得到正确的分配。

红色:至少有一个主分片没有得到正确的分配。

4. 打开索引

语法

POST /索引名称/_open

5.关闭索引

语法

POST /索引名称/_close

6. 删除索引库

删除索引使用DELETE请求

语法

DELETE /索引名称1,索引名称2,索引名称3…

再次查看,返回索引不存在

第6节 映射操作

索引创建之后,等于有了关系型数据库中的database。Elasticsearch7.x取消了索引type类型的设置,

不允许指定类型,默认为_doc,但字段仍然是有的,我们需要设置字段的约束信息,叫做字段映射

(mapping)

字段的约束包括但不限于:

字段的数据类型

是否要存储

是否要索引

分词器

我们一起来看下创建的语法。

1.创建映射字段

语法

PUT /索引库名/_mapping

{

"properties": {

"字段名": {

"type": "类型",

"index": true,

"store": true,

"analyzer": "分词器"

}

}

}

https://www.elastic.co/guide/en/elasticsearch/reference/7.3/mapping-params.html

字段名:任意填写,下面指定许多属性,例如:

type:类型,可以是text、long、short、date、integer、object等

index:是否索引,默认为true

store:是否存储,默认为false

analyzer:指定分词器

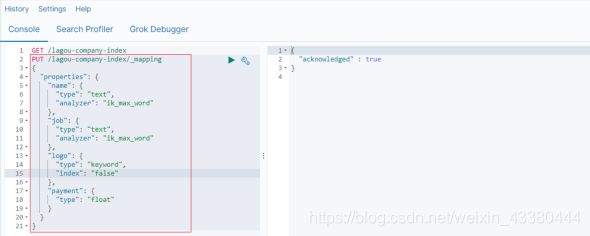

示例

发起请求:

PUT /lagou-company-index

PUT /lagou-company-index/_mapping/

{

"properties": {

"name": {

"type": "text",

"analyzer": "ik_max_word"

},

"job": {

"type": "text",

"analyzer": "ik_max_word"

},

"logo": {

"type": "keyword",

"index": "false"

},

"payment": {

"type": "float"

}

}

}

响应结果:

上述案例中,就给lagou-company-index这个索引库设置了4个字段:

name:企业名称

job: 需求岗位

logo:logo图片地址

payment:薪资

并且给这些字段设置了一些属性,至于这些属性对应的含义,我们在后续会详细介绍。

2.映射属性详解

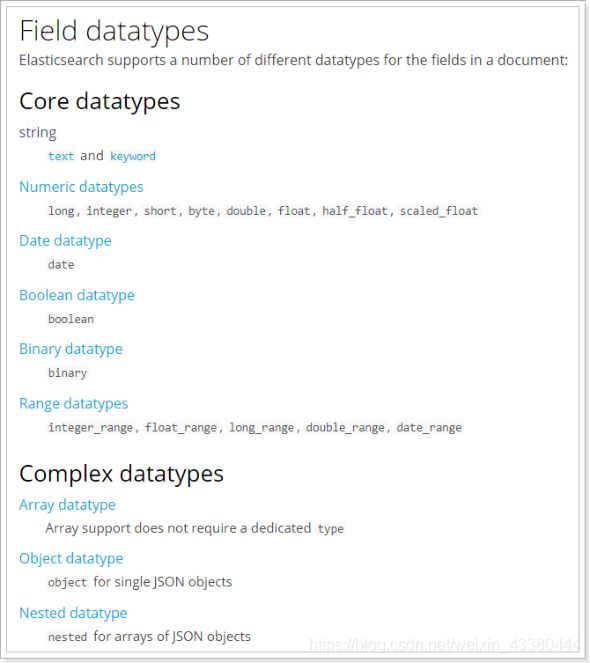

1)type

Elasticsearch中支持的数据类型非常丰富:

https://www.elastic.co/guide/en/elasticsearch/reference/7.3/mapping-types.html

我们说几个关键的:

String类型,又分两种:

text:可分词,不可参与聚合

keyword:不可分词,数据会作为完整字段进行匹配,可以参与聚合

Numerical:数值类型,分两类

基本数据类型:long、interger、short、byte、double、float、half_float

浮点数的高精度类型:scaled_float

需要指定一个精度因子,比如10或100。elasticsearch会把真实值乘以这个因子后存储,取出时再原。

Date:日期类型

elasticsearch可以对日期格式化为字符串存储,但是建议我们存储为毫秒值,存储为long,节省空间。

Array:数组类型

进行匹配时,任意一个元素满足,都认为满足排序时,如果升序则用数组中的最小值来排序,如果降序则用数组中的最大值来排序

Object:对象

{

name:"Jack",

age:21,

girl:{

name: "Rose", age:21

}

}

如果存储到索引库的是对象类型,例如上面的girl,会把girl变成两个字段:girl.name和girl.age

2)index

index影响字段的索引情况。

true:字段会被索引,则可以用来进行搜索。默认值就是true

false:字段不会被索引,不能用来搜索

index的默认值就是true,也就是说你不进行任何配置,所有字段都会被索引。

但是有些字段是我们不希望被索引的,比如企业的logo图片地址,就需要手动设置index为false。

3)store

是否将数据进行独立存储。

原始的文本会存储在 _source 里面,默认情况下其他提取出来的字段都不是独立存储的,是从

_source 里面提取出来的。当然你也可以独立的存储某个字段,只要设置store:true即可,获取独立存

储的字段要比从_source中解析快得多,但是也会占用更多的空间,所以要根据实际业务需求来设置,

默认为false。

4)analyzer:指定分词器

一般我们处理中文会选择ik分词器 ik_max_word ik_smart

3.查看映射关系

查看单个索引映射关系

语法:

GET /索引名称/_mapping

示例:

响应:

查看所有索引映射关系

方式一

GET _mapping

方式二

GET _all/_mapping

修改索引映射关系

语法

PUT /索引库名/_mapping

{

"properties": {

"字段名": {

"type": "类型",

"index": true,

"store": true,

"analyzer": "分词器"

}

}

}

注意:修改映射增加字段 做其它更改只能删除索引 重新建立映射

4.一次性创建索引和映射

刚才 的案例中我们是把创建索引库和映射分开来做,其实也可以在创建索引库的同时,直接制定索引库中的索引,基本语法:

put /索引库名称

{

"settings":{

"索引库属性名":"索引库属性值"

},

"mappings":{

"properties":{

"字段名":{

"映射属性名":"映射属性值"

}

}

}

}

案例

PUT /lagou-employee-index

{

"settings": {},

"mappings": {

"properties": {

"name": {

"type": "text",

"analyzer": "ik_max_word"

}

}

}

}

第7节 文档增删改查及局部更新

文档,即索引库中的数据,会根据规则创建索引,将来用于搜索。可以类比做数据库中的一行数据。

- 新增文档

新增文档时,涉及到id的创建方式,手动指定或者自动生成。

新增文档(手动指定id)

语法

POST /索引名称/_doc/{id}

示例

POST /lagou-company-index/_doc/1

{

"name" : "百度",

"job" : "小度用户运营经理",

"payment" : "30000",

"logo" :

"http://www.lgstatic.com/thubnail_120x120/i/image/M00/21/3E/CgpFT1kVdzeAJNbU

AABJB7x9sm8374.png"

}

新增文档(自动生成id

语法

POST /索引名称/_doc

{

“field”:“value”

}

可以看到结果显示为: created ,代表创建成功。

另外,需要注意的是,在响应结果中有个 _id 字段,这个就是这条文档数据的 唯一标识 ,以后的增删改查都依赖这个_id作为唯一标示,这里是Elasticsearch帮我们随机生成的id。

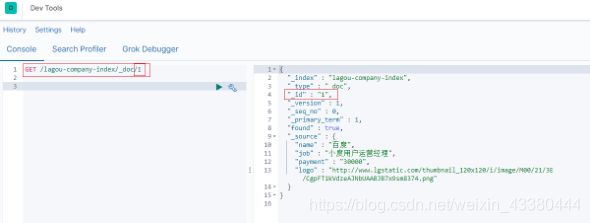

2. 查看单个文档

语法

GET /索引名称/_doc/{id}

示例

GET /lagou-company-index/_doc/1

文档元数据解读:

3. 查看所有文档

语法

POST /索引名称/_search

{

"query":{

"match_all": {

}

}

}

- _source定制返回结果

某些业务场景下,我们不需要搜索引擎返回source中的所有字段,可以使用source进行定制,如下,多个字段之间使用逗号分隔

GET /lagou-company-index/_doc/1?_source=name,job

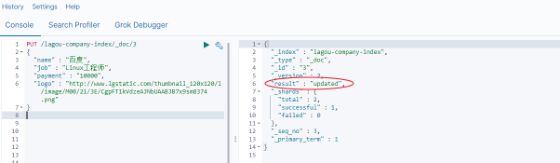

- 更新文档(全部更新)

把刚才新增的请求方式改为PUT,就是修改了,不过修改必须指定id

id对应文档存在,则修改

id对应文档不存在,则新增

比如,我们把使用id为3,不存在,则应该是新增

{

"_index" : "lagou-company-index",

"_type" : "_doc",

"_id" : "3",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 1,

"failed" : 0

},

"_seq_no" : 2,

"_primary_term" : 1

}

可以看到是 created ,是新增。

我们再次执行刚才的请求,不过把数据改一下

可以看到结果是: updated ,显然是更新数据

6. 更新文档(局部更新)

Elasticsearch可以使用PUT或者POST对文档进行更新(全部更新),如果指定ID的文档已经存在,则执行更新操作。

注意:Elasticsearch执行更新操作的时候,Elasticsearch首先将旧的文档标记为删除状态,然后添加新的文档,旧的文档不会立即消失,但是你也无法访问,Elasticsearch会在你继续添加更多数据的时候在后台清理已经标记为删除状态的文档。

全部更新,是直接把之前的老数据,标记为删除状态,然后,再添加一条更新的(使用PUT或者POST)

局域更新,只是修改某个字段(使用POST)

语法

POST /索引名/_update/{id}

{

"doc":{

"field":"value"

}

}

7. 删除文档

根据id进行删除:

语法

DELETE /索引名/_doc/{id}

可以看到结果是: deleted ,显然是删除数据

根据查询条件进行删除

语法

POST /索引库名/_delete_by_query

{

"query": {

"match": {

"字段名": "搜索关键字"

}

}

}

示例:

POST /lagou-company-index/_delete_by_query

{

"query":{

"match":{

"name":"1"

}

}

}

结果

{

"took" : 14,

"timed_out" : false,

"total" : 1,

"deleted" : 1,

"batches" : 1,

"version_conflicts" : 0,

"noops" : 0,

"retries" : {

"bulk" : 0,

"search" : 0

},

"throttled_millis" : 0,

"requests_per_second" : -1.0,

"throttled_until_millis" : 0,

"failures" : [ ]

}

删除所有文档

POST 索引名/_delete_by_query

{

"query": {

"match_all": {}

}

}

- 文档的全量替换、强制创建

全量替换

语法与创建文档是一样的,如果文档id不存在,那么就是创建;如果文档id已经存在,那么就是全量替换操作,替换文档的json串内容;

文档是不可变的,如果要修改文档的内容,第一种方式就是全量替换,直接对文档重新建立索引,替换里面所有的内容,elasticsearch会将老的文档标记为deleted,然后新增我们给定的一个文档,当我们创建越来越多的文档的时候,elasticsearch会在适当的时机在后台自动

删除标记为deleted的文档

强制创建

PUT /index/_doc/{id}?op_type=create {},PUT /index/_doc/{id}/_create {}

如果id 存在就会报错

第三部分 玩转Elasticsearch之高级应用

第1节 映射高级

- 地理坐标点数据类型

地理坐标点

地理坐标点是指地球表面可以用经纬度描述的一个点。 地理坐标点可以用来计算两个坐标间的距离,还可以判断一个坐标是否在一个区域中。地理坐标点需要显式声明对应字段类型为 geo_point :

示例:

PUT /company-locations

{

"mappings": {

"properties": {

"name": {

"type": "text"

},

"location": {

"type": "geo_point"

}

}

}

}

经纬度坐标格式

如上例, location 字段被声明为 geo_point 后,我们就可以索引包含了经纬度信息的文档了。 经纬度信息的形式可以是字符串、数组或者对象

# 字符串形式

PUT /company-locations/_doc/1

{

"name":"NetEase",

"location":"40.715,74.011"

}

# 对象形式

PUT /company-locations/_doc/2

{

"name":"Sina",

"location":{

"lat":40.722,

"lon":73.989

}

}

# 数组形式

PUT /company-locations/_doc/3

{

"name":"Baidu",

"location":[73.983,40.719]

}

注意

字符串形式以半角逗号分割,如 “lat,lon”

对象形式显式命名为 lat 和 lon

数组形式表示为 [lon,lat]

通过地理坐标点过滤

有四种地理坐标点相关的过滤器 可以用来选中或者排除文档

geo_bounding_box查询

这是目前为止最有效的地理坐标过滤器了,因为它计算起来非常简单。 你指定一个矩形的顶部 ,底部 , 左边界和右边界,然后过滤器只需判断坐标的经度是否在左右边界之间,纬度是否在上下边界之间

然后可以使用 geo_bounding_box 过滤器执行以下查询

GET /company-locations/_search

{

"query": {

"bool" : {

"must" : {

"match_all" : {}

},

"filter" : {

"geo_bounding_box" : {

"location" : {

"top_left" : {

"lat" : 40.73,

"lon" : 71.12

},

"bottom_right" : {

"lat" : 40.01,

"lon" : 74.1

}

}

}

}

}

}

}

location这些坐标也可以用 bottom_left 和 top_right 来表示

geo_distance

过滤仅包含与地理位置相距特定距离内的匹配的文档。假设以下映射和索引文档 然后可以使用 geo_distance 过滤器执行以下查询

GET /company-locations/_search

{

"query": {

"bool" : {

"must" : {

"match_all" : {}

},

"filter" : {

"geo_distance" : {

"distance" : "200km",

"location" : {

"lat" : 40,

"lon" : 70

}

}

}

}

}

}

2.动态映射

Elasticsearch在遇到文档中以前未遇到的字段,可以使用dynamic mapping(动态映射机制) 来确定字段的数据类型并自动把新的字段添加到类型映射。

Elastic的动态映射机制可以进行开关控制,通过设置mappings的dynamic属性,dynamic有如下设置项

true:遇到陌生字段就执行dynamic mapping处理机制

false:遇到陌生字段就忽略

strict:遇到陌生字段就报错

# 设置为报错

PUT /user

{

"settings":{

"number_of_shards": 3,

"number_of_replicas": 0

},

"mappings":{

"dynamic": "strict",

"properties": {

"name": {"type": "text"},

"address": {"type": "object", "dynamic": true}

}

}

}

# 插入以下文档,将会报错

# user索引层设置dynamic是strict,在user层内设置age将报错

# 在address层设置dynamic是ture,将动态映射生成字段

PUT /user/_doc/1

{

"name": "lisi",

"age": "20",

"address": {

"province": "beijing",

"city": "beijing"

}

}

PUT /user

{

"settings":{

"number_of_shards": 3,

"number_of_replicas": 0

},

"mappings":{

"dynamic": true,

"properties": {

"name": {"type": "text"},

"address": {"type": "object", "dynamic": true}

}

}

}

3.自定义动态映射

如果你想在运行时增加新的字段,你可能会启用动态映射。 然而,有时候,动态映射 规则 可能不太智能。幸运的是,我们可以通过设置去自定义这些规则,以便更好的适用于你的数据。

日期检测

当 Elasticsearch 遇到一个新的字符串字段时,它会检测这个字段是否包含一个可识别的日期,比如2014-01-01 如果它像日期,这个字段就会被作为 date 类型添加。否则,它会被作为 string 类型添加。有些时候这个行为可能导致一些问题。想象下,你有如下这样的一个文档:

{ “note”: “2014-01-01” }

假设这是第一次识别 note 字段,它会被添加为 date 字段。但是如果下一个文档像这样:{ “note”: “Logged out” }

这显然不是一个日期,但为时已晚。这个字段已经是一个日期类型,这个 不合法的日期 将会造成一个异常。

日期检测可以通过在根对象上设置 date_detection 为 false 来关闭

PUT /my_index/_doc/1

{ "note": "2014-01-01" }

PUT /my_index/_doc/1

{ "note": "Logged out" }

PUT /my_index

{

"mappings": {

"date_detection": false

}

}

使用这个映射,字符串将始终作为 string 类型。如果需要一个 date 字段,必须手动添加。Elasticsearch 判断字符串为日期的规则可以通过 dynamic_date_formats setting 来设置。

PUT /my_index

{

"mappings": {

"dynamic_date_formats": "MM/dd/yyyy"

}

}

PUT /my_index/_doc/1

{ "note": "2014-01-01" }

PUT /my_index/_doc/1

{ "note": "01/01/2014" }

dynamic_templates

使用 dynamic_templates 可以完全控制新生成字段的映射,甚至可以通过字段名称或数据类型来应用不同的映射。每个模板都有一个名称,你可以用来描述这个模板的用途,一个 mapping 来指定映射应

该怎样使用,以及至少一个参数 (如 match) 来定义这个模板适用于哪个字段。

模板按照顺序来检测;第一个匹配的模板会被启用。例如,我们给 string 类型字段定义两个模板:

es :以 _es 结尾的字段名需要使用 spanish 分词器。

en :所有其他字段使用 english 分词器。

我们将 es 模板放在第一位,因为它比匹配所有字符串字段的 en 模板更特殊:

PUT /my_index2

{

"mappings": {

"dynamic_templates": [

{

"es": {

"match": "*_es",

"match_mapping_type": "string",

"mapping": {

"type": "text",

"analyzer": "spanish"

}

}

},

{

"en": {

"match": "*",

"match_mapping_type": "string",

"mapping": {

"type": "text",

"analyzer": "english"

}

}

}

]

}

}

PUT /my_index2/_doc/1

{

"name_es":"testes",

"name":"es"

}

1)匹配字段名以 _es 结尾的字段

2)匹配其他所有字符串类型字段

match_mapping_type 允许你应用模板到特定类型的字段上,就像有标准动态映射规则检测的一样 (例如 string 或 long)

match参数只匹配字段名称,path_match 参数匹配字段在对象上的完整路径,所以 address.*.name将匹配这样的字段

{

"address": {

"city": {

"name": "New York"

}

}

}

第2节 Query DSL

https://www.elastic.co/guide/en/elasticsearch/reference/7.3/query-dsl.html

Elasticsearch提供了基于JSON的完整查询DSL(Domain Specific Language 特定域的语言)来定义查询。将查询DSL视为查询的AST(抽象语法树),它由两种子句组成:

叶子查询子句

叶子查询子句 在特定域中寻找特定的值,如 match,term或 range查询。

复合查询子句

复合查询子句包装其他叶子查询或复合查询,并用于以逻辑方式组合多个查询(例如 bool或dis_max查询),或更改其行为(例如 constant_score查询)。

我们在使用ElasticSearch的时候,避免不了使用DSL语句去查询,就像使用关系型数据库的时候要学会SQL语法一样。如果我们学习好了DSL语法的使用,那么在日后使用和使用Java Client调用时候也会变得非常简单。

基本语法

POST /索引库名/_search

{

"query":{

"查询类型":{

"查询条件":"查询条件值"

}

}

}

这里的query代表一个查询对象,里面可以有不同的查询属性

查询类型:

例如: match_all , match , term , range 等等

查询条件:查询条件会根据类型的不同,写法也有差异,后面详细讲解

1. 查询所有(match_all query)

示例

POST /lagou-company-index/_search

{

"query":{

"match_all": {}

}

}

query :代表查询对象

match_all :代表查询所有

结果

took:查询花费时间,单位是毫秒

time_out:是否超时

_shards:分片信息

hits:搜索结果总览对象

total:搜索到的总条数

max_score:所有结果中文档得分的最高分

hits:搜索结果的文档对象数组,每个元素是一条搜索到的文档信息

_index:索引库

_type:文档类型

_id:文档id

_score:文档得分

_source:文档的源数据

2. 全文搜索(full-text query)

全文搜索能够搜索已分析的文本字段,如电子邮件正文,商品描述等。使用索引期间应用于字段的同一

分析器处理查询字符串。全文搜索的分类很多 几个典型的如下:

2.2.1 匹配搜索(match query)

全文查询的标准查询,它可以对一个字段进行模糊、短语查询。 match queries 接收

text/numerics/dates, 对它们进行分词分析, 再组织成一个boolean查询。可通过operator 指定bool组

合操作(or、and 默认是 or )。

现在,索引库中有2部手机,1台电视;

PUT /lagou-property

{

"settings": {},

"mappings": {

"properties": {

"title": {

"type": "text",

"analyzer": "ik_max_word"

},

"images": {

"type": "keyword"

},

"price": {

"type": "float"

}

}

}

}

POST /lagou-property/_doc/

{

"title": "小米电视4A",

"images": "http://image.lagou.com/12479122.jpg",

"price": 4288

}

POST /lagou-property/_doc/

{

"title": "小米手机",

"images": "http://image.lagou.com/12479622.jpg",

"price": 2699

}

POST /lagou-property/_doc/

{

"title": "华为手机",

"images": "http://image.lagou.com/12479922.jpg",

"price": 5699

}

or关系

match 类型查询,会把查询条件进行分词,然后进行查询,多个词条之间是or的关系

POST /lagou-property/_search

{

"query":{

"match":{

"title":"小米电视4A"

}

}

}

结果:

{

"took" : 695,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 2,

"relation" : "eq"

},

"max_score" : 2.8330114,

"hits" : [

{

"_index" : "lagou-property",

"_type" : "_doc",

"_id" : "UKcMCnQB7BOR-NcQDHX4",

"_score" : 2.8330114,

"_source" : {

"title" : "小米电视4A",

"images" : "http://image.lagou.com/12479122.jpg",

"price" : 4288

}

},

{

"_index" : "lagou-property",

"_type" : "_doc",

"_id" : "UacMCnQB7BOR-NcQGnUb",

"_score" : 0.52354836,

"_source" : {

"title" : "小米手机",

"images" : "http://image.lagou.com/12479622.jpg",

"price" : 2699

}

}

]

}

}

在上面的案例中,不仅会查询到电视,而且与小米相关的都会查询到,多个词之间是 or 的关系。

and关系

某些情况下,我们需要更精确查找,我们希望这个关系变成 and ,可以这样做:

POST /lagou-property/_search

{"query": {"match": {

"title": {"query": "小米电视4A","operator": "and"}

}}}

结果:

{

"took" : 20,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 2.8330114,

"hits" : [

{

"_index" : "lagou-property",

"_type" : "_doc",

"_id" : "UKcMCnQB7BOR-NcQDHX4",

"_score" : 2.8330114,

"_source" : {

"title" : "小米电视4A",

"images" : "http://image.lagou.com/12479122.jpg",

"price" : 4288

}

}

]

}

}

本例中,只有同时包含 小米 和 电视 的词条才会被搜索到。

2.2.2 短语搜索(match phrase query)

match_phrase 查询用来对一个字段进行短语查询,可以指定 analyzer、slop移动因子

GET /lagou-property/_search

{

"query": {

"match_phrase": {

"title": "小米电视"

}

}

}

GET /lagou-property/_search

{

"query": {

"match_phrase": {

"title": "小米 4A"

}

}

}

GET /lagou-property/_search

{

"query": {

"match_phrase": {

"title": {

"query": "小米 4A",

"slop": 2

}

}

}

}

2.2.3 query_string 查询

Query String Query提供了无需指定某字段而对文档全文进行匹配查询的一个高级查询,同时可以指定在哪些字段上进行匹配。

# 默认 和 指定字段

GET /lagou-property/_search

{

"query": {

"query_string" : {

"query" : "2699"

}

}

}

GET /lagou-property/_search

{

"query": {

"query_string" : {

"query" : "2699",

"default_field" : "title"

}

}

}

# 逻辑查询

GET /lagou-property/_search

{

"query": {

"query_string" : {

"query" : "手机 OR 小米",

"default_field" : "title"

}

}

}

GET /lagou-property/_search

{

"query": {

"query_string" : {

"query" : "手机 AND 小米",

"default_field" : "title"

}

}

}

# 模糊查询

GET /lagou-property/_search

{

"query": {

"query_string" : {

"query" : "大米~1",

"default_field" : "title"

}

}

}

# 多字段支持

GET /lagou-property/_search

{

"query": {

"query_string" : {

"query":"2699",

"fields": [ "title","price"]

}

}

}

2.2.4 多字段匹配搜索(multi match query)

如果你需要在多个字段上进行文本搜索,可用multi_match 。multi_match在 match的基础上支持对多个字段进行文本查询。

GET /lagou-property/_search

{

"query": {

"multi_match" : {

"query":"2699",

"fields": [ "title","price"]

}

}

}

还可以使用*匹配多个字段:

GET /lagou-property/_search

{

"query": {

"multi_match" : {

"query":"http://image.lagou.com/12479622.jpg",

"fields": [ "title","ima*"]

}

}

}

- 词条级搜索(term-level queries)

可以使用term-level queries根据结构化数据中的精确值查找文档。结构化数据的值包括日期范围、IP地址、价格或产品ID。

与全文查询不同,term-level queries不分析搜索词。相反,词条与存储在字段级别中的术语完全匹配。

PUT /book

{

"settings": {},

"mappings" : {

"properties" : {

"description" : {

"type" : "text",

"analyzer" : "ik_max_word"

},

"name" : {

"type" : "text",

"analyzer" : "ik_max_word"

},

"price" : {

"type" : "float"

},

"timestamp" : {

"type" : "date",

"format" : "yyyy-MM-dd HH:mm:ss||yyyy-MM-dd||epoch_millis"

}

}

}

}

PUT /book/_doc/1

{

"name": "lucene",

"description": "Lucene Core is a Java library providing powerful indexing and

search features, as well as spellchecking, hit highlighting and advanced

analysis/tokenization capabilities. The PyLucene sub project provides Python

bindings for Lucene Core. ",

"price":100.45,

"timestamp":"2020-08-21 19:11:35"

}

PUT /book/_doc/2

{

"name": "solr",

"description": "Solr is highly scalable, providing fully fault tolerant

distributed indexing, search and analytics. It exposes Lucenes features through

easy to use JSON/HTTP interfaces or native clients for Java and other

languages.",

"price":320.45,

"timestamp":"2020-07-21 17:11:35"

}

PUT /book/_doc/3

{

"name": "Hadoop",

"description": "The Apache Hadoop software library is a framework that allows

for the distributed processing of large data sets across clusters of computers

using simple programming models.",

"price":620.45,

"timestamp":"2020-08-22 19:18:35"

}

PUT /book/_doc/4

{

"name": "ElasticSearch",

"description": "Elasticsearch是一个基于Lucene的搜索服务器。它提供了一个分布式多用户能力

的全文搜索引擎,基于RESTful web接口。Elasticsearch是用Java语言开发的,并作为Apache许可条

款下的开放源码发布,是一种流行的企业级搜索引擎。Elasticsearch用于云计算中,能够达到实时搜

索,稳定,可靠,快速,安装使用方便。官方客户端在Java、.NET(C#)、PHP、Python、Apache

Groovy、Ruby和许多其他语言中都是可用的。根据DB-Engines的排名显示,Elasticsearch是最受欢

迎的企业搜索引擎,其次是Apache Solr,也是基于Lucene。",

"price":999.99,

"timestamp":"2020-08-15 10:11:35"

}

- 词条搜索(term query)

term 查询用于查询指定字段包含某个词项的文档

POST /book/_search

{

"query": {

"term" : { "name" : "solr" }

}

}

- 词条集合搜索(terms query)

terms 查询用于查询指定字段包含某些词项的文档

GET /book/_search

{

"query": {

"terms" : { "name" : ["solr", "elasticsearch"]}

}

}

- 范围搜索(range query)

gte:大于等于

gt:大于

lte:小于等于

lt:小于

boost:查询权重

GET /book/_search

{

"query": {

"range" : {

"price" : {

"gte" : 10,

"lte" : 200,

"boost" : 2.0

}

}

}

}

GET /book/_search

{

"query": {

"range" : {

"timestamp" : {

"gte" : "now-2d/d",

"lt" : "now/d"

}

}

}

}

GET book/_search

{

"query": {

"range" : {

"timestamp" : {

"gte": "18/08/2020",

"lte": "2021",

"format": "dd/MM/yyyy||yyyy"

}

}

}

}

- 不为空搜索(exists query)

查询指定字段值不为空的文档。相当 SQL 中的 column is not null

GET /book/_search

{

"query": {

"exists" : { "field" : "price" }

}

}

- 词项前缀搜索(prefix query)

GET /book/_search

{ "query": {

"prefix" : { "name" : "so" }

}

}

- 通配符搜索(wildcard query)

GET /book/_search

{

"query": {

"wildcard" : { "name" : "so*r" }

}

}

GET /book/_search

{

"query": {

"wildcard": {

"name": {

"value": "lu*",

"boost": 2

}

}

}

}

- 正则搜索(regexp query)

regexp允许使用正则表达式进行term查询.注意regexp如果使用不正确,会给服务器带来很严重的性能压力。比如.*开头的查询,将会匹配所有的倒排索引中的关键字,这几乎相当于全表扫描,会很慢。因此如果可以的话,最好在使用正则前,加上匹配的前缀。

GET /book/_search

{

"query": {

"regexp":{

"name": "s.*"

}

}

}

GET /book/_search

{

"query": {

"regexp":{"name":{

"value":"s.*",

"boost":1.2

}

}

}

}

- 模糊搜索(fuzzy query)

GET /book/_search

{

"query": {

"fuzzy" : { "name" : "so" }

}

}

GET /book/_search

{

"query": {

"fuzzy" : {

"name" : {

"value": "so",

"boost": 1.0,

"fuzziness": 2

}

}

}

}

GET /book/_search

{

"query": {

"fuzzy" : {

"name" : {

"value": "sorl",

"boost": 1.0,

"fuzziness": 2

}

}

}

}

- ids搜索(id集合查询)

GET /book/_search

{

"query": {

"ids" : {

"type" : "_doc",

"values" : ["1", "3"]

}

}

}

- 复合搜索(compound query)

- constant_score query

用来包装另一个查询,将查询匹配的文档的评分设为一个常值

GET /book/_search

{

"query": {

"term" : { "description" : "solr"}

}

}

GET /book/_search

{

"query": {

"constant_score" : {

"filter" : {

"term" : { "description" : "solr"}

},

"boost" : 1.2

}

}

}

- 布尔搜索(bool query)

bool 查询用bool操作来组合多个查询字句为一个查询。 可用的关键字:

must:必须满足

filter:必须满足,但执行的是filter上下文,不参与、不影响评分

should:或

must_not:必须不满足,在filter上下文中执行,不参与、不影响评分

POST /book/_search

{

"query": {

"bool" : {

"must" : {

"match" : { "description" : "java" }

},

"filter": {

"term" : { "name" : "solr" }

},

"must_not" : {

"range" : {

"price" : { "gte" : 200, "lte" : 300 }

}

},

"minimum_should_match" : 1,

"boost" : 1.0

}

}

}

minimum_should_match代表了最小匹配精度,如果设置minimum_should_match=1,那么should语句中至少需要有一个条件满足。

5.排序

相关性评分排序

默认情况下,返回的结果是按照 相关性 进行排序的——最相关的文档排在最前。 在本章的后面部分,我们会解释 相关性 意味着什么以及它是如何计算的, 不过让我们首先看看 sort 参数以及如何使用它。

为了按照相关性来排序,需要将相关性表示为一个数值。在 Elasticsearch 中, 相关性得分 由一个浮点数进行表示,并在搜索结果中通过 _score 参数返回, 默认排序是 _score 降序,按照相关性评分升序排序如下

POST /book/_search

{

"query": {

"match": {"description":"solr"}

}

}

POST /book/_search

{

"query": {

"match": {"description":"solr"}

},

"sort": [

{"_score": {"order": "asc"}}

]

}

字段值排序

POST /book/_search

{

"query": {

"match_all": {}

},

"sort": [

{"price": {"order": "desc"}}

]

}

多级排序

假定我们想要结合使用 price和 _score(得分) 进行查询,并且匹配的结果首先按照价格排序,然后按照相关性得分排序:

POST /book/_search

{

"query":{

"match_all":{}

},

"sort": [

{ "price": { "order": "desc" }},

{ "timestamp": { "order": "desc" }}

]

}

6.分页

Elasticsearch中实现分页的语法非常简单:

POST /book/_search

{

"query": {

"match_all": {}

},

"size": 2,

"from": 0

}

POST /book/_search

{

"query": {

"match_all": {}

},

"sort": [

{"price": {"order": "desc"}}

],

"size": 2,

"from": 2

}

size:每页显示多少条

from:当前页起始索引, int start = (pageNum - 1) * size

7.高亮

Elasticsearch中实现高亮的语法比较简单:

POST /book/_search

{

"query": {

"match": {

"name": "elasticsearch"

}

},

"highlight": {

"pre_tags": "",

"post_tags": "",

"fields": [{"name":{}}]

}

}

POST /book/_search

{

"query": {

"match": {

"name": "elasticsearch"

}

},

"highlight": {

"pre_tags": "",

"post_tags": "",

"fields": [{"name":{}},{"description":{}}]

}

}

POST /book/_search

{

"query": {

"query_string" : {

"query" : "elasticsearch"

}

},

"highlight": {

"pre_tags": "",

"post_tags": "",

"fields": [{"name":{}},{"description":{}}]

}

}

在使用match查询的同时,加上一个highlight属性:

pre_tags:前置标签

post_tags:后置标签

fields:需要高亮的字段

name:这里声明title字段需要高亮,后面可以为这个字段设置特有配置,也可以空

结果:

{

"took" : 7,

"timed_out" : false,

"_shards" : {

"total" : 1,

"successful" : 1,

"skipped" : 0,

"failed" : 0

},

"hits" : {

"total" : {

"value" : 1,

"relation" : "eq"

},

"max_score" : 1.6153753,

"hits" : [

{

"_index" : "book",

"_type" : "_doc",

"_id" : "4",

"_score" : 1.6153753,

"_source" : {

"name" : "ElasticSearch",

"description" : "Elasticsearch是一个基于Lucene的搜索服务器。它提供了一个分布

式多用户能力的全文搜索引擎,基于RESTful web接口。Elasticsearch是用Java语言开发的,并作为

Apache许可条款下的开放源码发布,是一种流行的企业级搜索引擎。Elasticsearch用于云计算中,能够

达到实时搜索,稳定,可靠,快速,安装使用方便。官方客户端在Java、.NET(C#)、PHP、Python、

Apache Groovy、Ruby和许多其他语言中都是可用的。根据DB-Engines的排名显示,Elasticsearch

是最受欢迎的企业搜索引擎,其次是Apache Solr,也是基于Lucene。",

"price" : 999.99,

"timestamp" : "2020-08-15 10:11:35"

},

"highlight" : {

"name" : [

"ElasticSearch"

],

"description" : [

"Elasticsearch是一个基于Lucene的搜索服务器。它

提供了一个分布式多用户能力的全文搜索引擎,基于RESTful web接口。",

"Elasticsearch是用Java语言开发的,并作为

Apache许可条款下的开放源码发布,是一种流行的企业级搜索引擎。",

"Elasticsearch用于云计算中,能够达到实时搜索,

稳定,可靠,快速,安装使用方便。",

"根据DB-Engines的排名显示,Elasticsearch是最

受欢迎的企业搜索引擎,其次是Apache Solr,也是基于Lucene。"

]

}

}

]

}

}

8.文档批量操作(bulk 和 mget)

mget 批量查询

单条查询 GET /test_index/_doc/1,如果查询多个id的文档一条一条查询,网络开销太大。

GET /_mget

{

"docs" : [

{

"_index" : "book",

"_id" : 1

},

{

"_index" : "book",

"_id" : 2

}

]

}

返回:

{

"docs" : [

{

"_index" : "book",

"_type" : "_doc",

"_id" : "1",

"_version" : 1,

"_seq_no" : 0,

"_primary_term" : 1,

"found" : true,

"_source" : {

"name" : "lucene",

"description" : "Lucene Core is a Java library providing powerful

indexing and search features, as well as spellchecking, hit highlighting and

advanced analysis/tokenization capabilities. The PyLucene sub project provides

Python bindings for Lucene Core. ",

"price" : 100.45,

"timestamp" : "2020-08-21 19:11:35"

}

},

{

"_index" : "book",

"_type" : "_doc",

"_id" : "2",

"_version" : 1,

"_seq_no" : 1,

"_primary_term" : 1,

"found" : true,

"_source" : {

"name" : "solr",

"description" : "Solr is highly scalable, providing fully fault tolerant

distributed indexing, search and analytics. It exposes Lucenes features through

easy to use JSON/HTTP interfaces or native clients for Java and other

languages.",

"price" : 320.45,

"timestamp" : "2020-07-21 17:11:35"

}

}

]

}

同一索引下批量查询:

GET /book/_mget

{

"docs" : [

{

"_id" : 2

},

{

"_id" : 3

}

]

}

搜索简化写法

POST /book/_search

{

"query": {

"ids" : {

"values" : ["1", "4"]

}

}

}

bulk 批量增删改

Bulk 操作解释将文档的增删改查一些列操作,通过一次请求全都做完。减少网络传输次数。语法:

POST /_bulk

{"action": {"metadata"}}

{"data"}

如下操作,删除1,新增5,修改2。

POST /_bulk

{ "delete": { "_index": "book", "_id": "1" }}

{ "create": { "_index": "book", "_id": "5" }}

{ "name": "test14","price":100.99 }

{ "update": { "_index": "book", "_id": "2"} }

{ "doc" : {"name" : "test"} }

功能:

delete:删除一个文档,只要1个json串就可以了 删除的批量操作不需要请求体

create:相当于强制创建 PUT /index/type/id/_create

index:普通的put操作,可以是创建文档,也可以是全量替换文档

update:执行的是局部更新partial update操作

格式:每个json不能换行。相邻json必须换行。

隔离:每个操作互不影响。操作失败的行会返回其失败信息。

实际用法:bulk请求一次不要太大,否则一下积压到内存中,性能会下降。所以,一次请求几千个操作、大小在几M正好。

bulk会将要处理的数据载入内存中,所以数据量是有限的,最佳的数据两不是一个确定的数据,它取决于你的硬件,你的文档大小以及复杂性,你的索引以及搜索的负载。

一般建议是1000-5000个文档,大小建议是5-15MB,默认不能超过100M,可以在es的配置文件(ES的config下的elasticsearch.yml)中配置。http.max_content_length: 10mb

第3节 Filter DSL

Elasticsearch中的所有的查询都会触发相关度得分的计算。对于那些我们不需要相关度得分的场景下,

Elasticsearch以过滤器的形式提供了另一种查询功能,过滤器在概念上类似于查询,但是它们有非常快的执行速度,执行速度快主要有以下两个原因:

过滤器不会计算相关度的得分,所以它们在计算上更快一些。

过滤器可以被缓存到内存中,这使得在重复的搜索查询上,其要比相应的查询快出许多。

为了理解过滤器,可以将一个查询(像是match_all,match,bool等)和一个过滤器结合起来。我们以范围过滤器为例,它允许我们通过一个区间的值来过滤文档。这通常被用在数字和日期的过滤上。

下面这个例子使用一个被过滤的查询,其返回price值是在200到1000之间(闭区间)的书。

POST /book/_search

{

"query": {

"filtered": {

"query": {

"match_all": {}

},

"filter": {

"range": {

"price": {

"gte": 200,

"lte": 1000

}

}

}

}

}

}

#5.0 之后的写法

POST /book/_search

{

"query": {

"bool": {

"must": {

"match_all": {}

},

"filter": {

"range": {

"price": {

"gte": 200,

"lte": 1000

}

}

}

}

}

}

分解上面的例子,被过滤的查询包含一个match_all查询(查询部分)和一个过滤器(filter部分)。我们可以在查询部分中放入其他查询,在filter部分放入其它过滤器。在上面的应用场景中,由于所有的在这个范围之内的文档都是平等的(或者说相关度都是一样的),没有一个文档比另一个文档更相关,所以这个时候使用范围过滤器就非常合适了。通常情况下,要决定是使用过滤器还是使用查询,你就需要问自己是否需要相关度得分。如果相关度是不重要的,使用过滤器,否则使用查询。查询和过滤器在概念上类似于SELECT WHERE语句。

第4节 定位非法搜索及原因

在开发的时候,我们可能会写到上百行的查询语句,如果出错的话,找起来很麻烦,Elasticsearch提供了帮助开发人员定位不合法的查询的api _validate

GET /book/_search?explain

{

"query": {

"match1": {

"name": "test"

}

}

}

使用 validate

GET /book/_validate/query?explain

{

"query": {

"match1": {

"name": "test"

}

}

}

返回结果

{

"valid":false,

"error":"org.elasticsearch.common.ParsingException: no [query] registered for

[match1]"

}

在查询时,不小心把 match 写成了 match1 ,通过 validate api 可以清楚的看到错误原因

正确查询返回

{

"_shards" : {

"total" : 1,

"successful" : 1,

"failed" : 0

},

"valid" : true,

"explanations" : [

{

"index" : "book",

"valid" : true,

"explanation" : "name:test"

}

]

}

第5节 聚合分析

1.聚合介绍

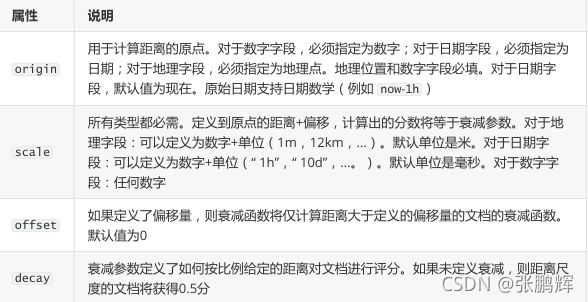

聚合分析是数据库中重要的功能特性,完成对一个查询的数据集中数据的聚合计算,如:找出某字段(或计算表达式的结果)的最大值、最小值,计算和、平均值等。Elasticsearch作为搜索引擎兼数据库,同样提供了强大的聚合分析能力。

对一个数据集求最大、最小、和、平均值等指标的聚合,在ES中称为指标聚合 metric而关系型数据库中除了有聚合函数外,还可以对查询出的数据进行分组group by,再在组上进行指标聚合。在 ES 中group by 称为分桶,桶聚合 bucketing

Elasticsearch聚合分析语法

在查询请求体中以aggregations节点按如下语法定义聚合分析:

"aggregations" : {

"" : {

"" : {

}

[,"meta" : { [] } ]?

[,"aggregations" : { []+ } ]?

}

说明:aggregations 也可简写为 aggs

2. 指标聚合

max min sum avg

示例一:查询所有书中最贵的

POST /book/_search

{

"size": 0,

"aggs": {

"max_price": {

"max": {

"field": "price"

}

}

}

}

文档计数count

示例: 统计price大于100的文档数量

POST /book/_count

{

"query": {

"range": {

"price" : {

"gt":100

}

}

}

}

value_count 统计某字段有值的文档数

POST /book/_search?size=0

{

"aggs": {

"price_count": {

"value_count": {

"field": "price"

}

}

}

}

cardinality值去重计数 基数

POST /book/_search?size=0

{

"aggs": {

"_id_count": {

"cardinality": {

"field": "_id"

}

},

"price_count": {

"cardinality": {

"field": "price"

}

}

}

}

stats 统计 count max min avg sum 5个值

POST /book/_search?size=0

{

"aggs": {

"price_stats": {

"stats": {

"field": "price"

}

}

}

}

Extended stats

高级统计,比stats多4个统计结果: 平方和、方差、标准差、平均值加/减两个标准差的区间

POST /book/_search?size=0

{

"aggs": {

"price_stats": {

"extended_stats": {

"field": "price"

}

}

}

}

Percentiles 占比百分位对应的值统计

POST /book/_search?size=0

{

"aggs": {

"price_percents": {

"percentiles": {

"field": "price"

}

}

}

}

指定分位值

POST /book/_search?size=0

{

"aggs": {

"price_percents": {

"percentiles": {

"field": "price",

"percents" : [75, 99, 99.9]

}

}

}

}

Percentiles rank 统计值小于等于指定值的文档占比

统计price小于100和200的文档的占比

POST /book/_search?size=0

{

"aggs": {

"gge_perc_rank": {

"percentile_ranks": {

"field": "price",

"values": [

100,200

]

}

}

}

}

- 桶聚合

Bucket Aggregations,桶聚合。

它执行的是对文档分组的操作(与sql中的group by类似),把满足相关特性的文档分到一个桶里,即桶分,输出结果往往是一个个包含多个文档的桶(一个桶就是一个group)

bucket:一个数据分组

metric:对一个数据分组执行的统计

POST /book/_search

{

"size": 0,

"aggs": {

"group_by_price": {

"range": {

"field": "price",

"ranges": [

{

"from": 0,

"to": 200

},

{

"from": 200,

"to": 400

},

{

"from": 400,

"to": 1000

}

]

},

"aggs": {

"average_price": {

"avg": {

"field": "price"

}

}

}

}

}

}

值的个数统计

"count_price": {

"value_count": {

"field": "price"

}

}

实现having 效果

POST /book/_search

{

"size": 0,

"aggs": {

"group_by_price": {

"range": {

"field": "price",

"ranges": [

{

"from": 0,

"to": 200

},

{

"from": 200,

"to": 400

},

{

"from": 400,

"to": 1000

}

]

},

"aggs": {

"average_price": {

"avg": {

"field": "price"

}

},

"having": {

"bucket_selector": {

"buckets_path": {

"avg_price": "average_price"

},

"script": {

"source": "params.avg_price >= 200 "

}

}

}

}

}

}

}

第6节 玩转Elasticsearch零停机索引重建

1.说明

Elasticsearch是一个实时的分布式搜索引擎,为用户提供搜索服务,当我们决定存储某种数据时,在创建索引的时候需要数据结构完整确定下来,与此同时索引的设定和很多固定配置将不能改变。当需要改变数据结构时就需要重建索引,为此,Elasticsearch团队提供了辅助工具帮助开发人员进行索引重建。

零停机完成索引重建的三种方案

2.方案一:外部数据导入方案

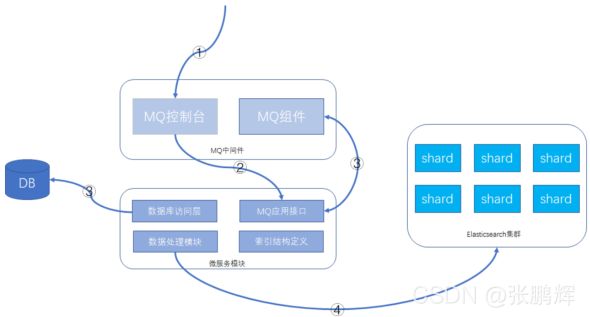

1)整体介绍

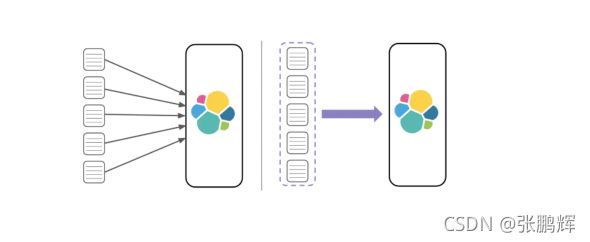

系统架构设计中,有关系型数据库用来存储数据,Elasticsearch在系统架构里起到查询加速的作用,如果遇到索引重建的操作,待系统模块发布新版本后,可以从数据库将数据查询出来,重新灌到Elasticsearch即可。

2)执行步骤

建议的功能方案:数据库 + MQ + 应用模块 + Elasticsearch,可以在MQ控制台发送MQ消息来触发重导数据,按批次对数据进行导入,整个过程异步化处理,请求操作示意如下所示:

3)详细操作步骤:

- 通过MQ的web控制台或cli命令行,发送指定的MQ消息

- MQ消息被微服务模块的消费者消费,触发ES数据重新导入功能

- 微服务模块从数据库里查询数据的总数及批次信息,并将每个数据批次的分页信息重新发送给MQ消息,分页信息包含查询条件和偏移量,此MQ消息还是会被微服务的MQ消息者接收处理。

- 微服务根据接收的查询条件和分页信息,从数据库获取到数据后,根据索引结构的定义,将数据组装成ES支持的JSON格式,并执行bulk命令,将数据发送给Elasticsearch集群。

这样就可以完成索引的重建工作。

4)方案特点

MQ中间件的选型不做具体要求,常见的rabitmq、activemq、rocketmq等均可。

在微服务模块方面,提供MQ消息处理接口、数据处理模块需要事先开发的,一般是创建新的索引时,配套把重建的功能也一起做好。整体功能共用一个topic,针对每个索引,有单独的结构定义和MQ消息

处理tag,代码尽可能复用。处理的批次大小需要根据实际的情况设置。

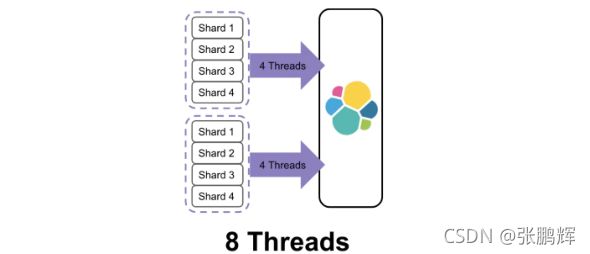

微服务模块实例会部署多个,数据是分批处理的,批次信息会一次性全部先发送给MQ,各个实例处理的数据相互不重叠,利用MQ消息的异步处理机制,可以充分利用并发的优势,加快数据重建的速度。

5)方案缺点 - 对数据库造成读取压力,短时间内大量的读操作,会占用数据库的硬件资源,严重时可能引起数据库性能下降。

- 网络带宽占用多,数据毕竟是从一个库传到另一个库,虽说是内网,但大量的数据传输带宽占用也需要注意。

- 数据重建时间稍长,跟迁移的数据量大小有关。 3.方案二:基于scroll+bulk+索引别名方案

1)整体介绍

利用Elasticsearch自带的一些工具完成索引的重建工作,当然在方案实际落地时,可能也会依赖客户端的一些功能,比如用Java客户端持续的做scroll查询、bulk命令的封装等。数据完全自给自足,不依赖其他数据源。

2)执行步骤

假设原索引名称是book,新的索引名称为book_new,Java客户端使用别名book_alias连接Elasticsearch,该别名指向原索引book。 - 若Java客户端没有使用别名,需要给客户端分配一个: PUT /book/_alias/book_alias

- 新建索引book_new,将mapping信息,settings信息等按新的要求全部定义好。

- 使用scroll api将数据批量查询出来

为了使用 scroll,初始搜索请求应该在查询中指定 scroll 参数,这可以告诉 Elasticsearch 需要保持搜索的上下文环境多久,1m 就是一分钟。

GET /book/_search?scroll=1m

{

"query": {

"match_all": {}

},

"sort": ["_doc"],

"size": 2

}

- 采用bulk api将scoll查出来的一批数据,批量写入新索引

POST /_bulk

{ "index": { "_index": "book_new", "_id": "对应的id值" }}

{ 查询出来的数据值 }

- 反复执行修改后的步骤3和步骤4,查询一批导入一批,以后可以借助Java Client或其他语言的API支持。

注意做3时需要指定上一次查询的 scroll_id

GET /_search/scroll

{

"scroll": "1m",

"scroll_id" : "步骤三中查询出来的值"

}

- 切换别名book_alias到新的索引book_new上面,此时Java客户端仍然使用别名访问,也不需要修改任何代码,不需要停机。 POST /_aliases

{

“actions”: [

{ “remove”: { “index”: “book”, “alias”: “book_alias” }},

{ “add”: { “index”: “book_new”, “alias”: “book_alias” }}

]

} - 验证别名查询的是否为新索引的数据 3)方案特点

在数据传输上基本自给自足,不依赖于其他数据源,Java客户端不需要停机等待数据迁移,网络传输占

用带宽较小。只是scroll查询和bulk提交这部分,数据量大时需要依赖一些客户端工具。

4)补充一点

在Java客户端或其他客户端访问Elasticsearch集群时,使用别名是一个好习惯。

4.方案三:Reindex API方案

Elasticsearch v6.3.1已经支持Reindex API,它对scroll、bulk做了一层封装,能够 对文档重建索引而不需要任何插件或外部工具。

1)最基础的命令:

POST _reindex

{

"source": {

"index": "book"

},

"dest": {

"index": "book_new"

}

}

响应结果:

{

"took": 180,

"timed_out": false,

"total": 4,

"updated": 0,

"created": 4,

"deleted": 0,

"batches": 1,

"version_conflicts": 0,

"noops": 0,

"retries": {

"bulk": 0,

"search": 0

},

"throttled_millis": 0,

"requests_per_second": -1,

"throttled_until_millis": 0,

"failures": []

}

注意: 如果不手动创建新索引book_new的mapping信息,那么Elasticsearch将启动自动映射模板对数据进行类型映射,可能不是期望的类型,这点要注意一下。

2)version_type 属性

使用reindex api也是创建快照后再执行迁移的,这样目标索引的数据可能会与原索引有差异,version_type属性可以决定乐观锁并发处理的规则。reindex api可以设置version_type属性,如下:

POST _reindex

{

"source": {

"index": "book"

},

"dest": {

"index": "book_new",

"version_type": "internal"

}

}

version_type属性含义如下:

internal:直接拷贝文档到目标索引,对相同的type、文档ID直接进行覆盖,默认值

external:迁移文档到目标索引时,保留version信息,对目标索引中不存在的文档进行创建,已存在的文档按version进行更新,遵循乐观锁

机制

3)op_type 属性和conflicts 属性

如果op_type设置为create,那么迁移时只在目标索引中创建ID不存在的文档,已存在的文档,会提示错误,如下请求:

POST _reindex

{

"source": {

"index": "book"

},

"dest": {

"index": "book_new",

"op_type": "create"

}

}

有错误提示的响应,节选部分:

{

"took": 11,

"timed_out": false,

"total": 5,

"updated": 0,

"created": 1,

"deleted": 0,

"batches": 1,

"version_conflicts": 4,

"noops": 0,

"retries": {

"bulk": 0,

"search": 0

},

"throttled_millis": 0,

"requests_per_second": -1,

"throttled_until_millis": 0,

"failures": [

{

"index": "book_new",

"type": "children"

"id": "2",

"cause": {

"type": "version_conflict_engine_exception",

"reason": "[children][2]: version conflict, document already exists

(current version [17])",

"index_uuid": "dODetUbATTaRL-p8DAEzdA",

"shard": "2",

"index": "book_new"

},

"status": 409

}

]

}

如果加上"conflicts": "proceed"配置项,那么冲突信息将不展示,只展示冲突的文档数量,请求和响应结果将变成这样:

请求:

POST _reindex

{

"conflicts": "proceed",

"source": {

"index": "book"

},

"dest": {

"index": "book_new",

"op_type": "create"

}

}

响应:

{

"took": 12,

"timed_out": false,

"total": 5,

"updated": 0,

"created": 1,

"deleted": 0,

"batches": 1,

"version_conflicts": 4,

"noops": 0,

"retries": {

"bulk": 0,

"search": 0

},

"throttled_millis": 0,

"requests_per_second": -1,

"throttled_until_millis": 0,

"failures": []

}

4)query支持

reindex api支持数据过滤、数据排序、size设置、_source选择等,也支持脚本执行,这里提供一个简单示例:

POST _reindex

{

"size": 100,

"source": {

"index": "book",

"query": {

"term": {

"language": "english"

}

},

"sort": {

"likes": "desc"

}

},

"dest": {

"index": "book_new"

}

}

5.小结

零停机索引重建操作的三个方案,从自研功能、scroll+bulk到reindex,我们作为Elasticsearch的使用者,三个方案的参与度是逐渐弱化的,但稳定性却是逐渐上升的,我们需要清楚地去了解各个方案的优劣,适宜的场景,然后根据实际的情况去权衡,哪个方案更适合我们的业务模型.

第7节 玩转Elasticsearch Suggester智能搜索建议

现代的搜索引擎,一般会具备"Suggest As You Type"功能,即在用户输入搜索的过程中,进行自动补全或者纠错。 通过协助用户输入更精准的关键词,提高后续全文搜索阶段文档匹配的程度。例如在京东上输入部分关键词,甚至输入拼写错误的关键词时,它依然能够提示出用户想要输入的内容:

如果自己亲手去试一下,可以看到京东在用户刚开始输入的时候是自动补全的,而当输入到一定长度,

如果因为单词拼写错误无法补全,就开始尝试提示相似的词。

那么类似的功能在Elasticsearch里如何实现呢? 答案就在Suggesters API。 Suggesters基本的运作原理是将输入的文本分解为token,然后在索引的字典里查找相似的term并返回。 根据使用场景的不同,

Elasticsearch里设计了4种类别的Suggester,分别是:

Term Suggester

Phrase Suggester

Completion Suggester

Context Suggester

在官方的参考文档里,对这4种Suggester API都有比较详细的介绍,下面的案例将在Elasticsearch 7.x上通过示例讲解Suggester的基础用法,希望能帮助部分国内开发者快速用于实际项目开发。

首先来看一个Term Suggester的示例:

准备一个叫做blogs的索引,配置一个text字段

PUT /blogs/

{

"mappings": {

"properties": {

"body": {

"type": "text"

}

}

}

}

通过bulk api写入几条文档

POST _bulk/?refresh=true

{ "index" : { "_index" : "blogs" } }

{ "body": "Lucene is cool"}

{ "index" : { "_index" : "blogs" } }

{ "body": "Elasticsearch builds on top of lucene"}

{ "index" : { "_index" : "blogs" } }

{ "body": "Elasticsearch rocks"}

{ "index" : { "_index" : "blogs" } }

{ "body": "Elastic is the company behind ELK stack"}

{ "index" : { "_index" : "blogs" } }

{ "body": "elk rocks"}

{ "index" : { "_index" : "blogs"} }

{ "body": "elasticsearch is rock solid"}

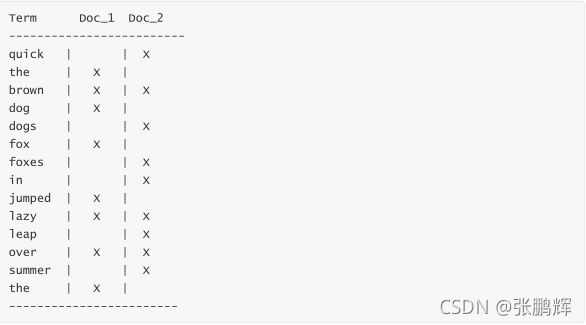

此时blogs索引里已经有一些文档了,可以进行下一步的探索。为帮助理解,我们先看看哪些term会存在于词典里。

将输入的文本分析一下:

POST _analyze

{

"text": [

"Lucene is cool",

"Elasticsearch builds on top of lucene",

"Elasticsearch rocks",

"Elastic is the company behind ELK stack",

"elk rocks",

"elasticsearch is rock solid"

]

}

这些分出来的token都会成为词典里一个term,注意有些token会出现多次,因此在倒排索引里记录的词频会比较高,同时记录的还有这些token在原文档里的偏移量和相对位置信息。

执行一次suggester搜索看看效果:

POST /blogs/_search

{

"suggest": {

"my-suggestion": {

"text": "lucne rock",

"term": {

"suggest_mode": "missing",

"field": "body"

}

}

}

}

suggest就是一种特殊类型的搜索,DSL内部的"text"指的是api调用方提供的文本,也就是通常用户界面上用户输入的内容。这里的lucne是错误的拼写,模拟用户输入错误。 "term"表示这是一个term

suggester。 “field"指定suggester针对的字段,另外有一个可选的"suggest_mode”。 范例里的"missing"实际上就是缺省值,它是什么意思?有点挠头… 还是先看看返回结果吧:

{

"took": 1,

"timed_out": false,

"_shards": {

"total": 1,

"successful": 1,

"failed": 0

},

"hits": {

"total": 0,

"max_score": 0,

"hits":

},

"suggest": {

"my-suggestion": [

{

"text": "lucne",

"offset": 0,

"length": 5,

"options": [

{

"text": "lucene",

"score": 0.8,

"freq": 2

}

]

},

{

"text": "rock",

"offset": 6,

"length": 4,

"options":

}

]

}

}

在返回结果里"suggest" -> “my-suggestion"部分包含了一个数组,每个数组项对应从输入文本分解出来的token(存放在"text"这个key里)以及为该token提供的建议词项(存放在options数组里)。 示例里返回了"lucne”,“rock"这2个词的建议项(options),其中"rock"的options是空的,表示没有可以建议的选项,为什么? 上面提到了,我们为查询提供的suggest mode是"missing”,由于"rock"在索引的词典里已经存在了,够精准,就不建议啦。 只有词典里找不到词,才会为其提供相似的选项。

如果将"suggest_mode"换成"popular"会是什么效果?

尝试一下,重新执行查询,返回结果里"rock"这个词的option不再是空的,而是建议为rocks。

"suggest": {

"my-suggestion": [

{

"text": "lucne",

"offset": 0,

"length": 5,

"options": [

{

"text": "lucene",

"score": 0.8,

"freq": 2

}

]

},

{

"text": "rock",

"offset": 6,

"length": 4,

"options": [

{

"text": "rocks",

"score": 0.75,

"freq": 2

}

]

}

]

}

回想一下,rock和rocks在索引词典里都是有的。 不难看出即使用户输入的token在索引的词典里已经有了,但是因为存在一个词频更高的相似项,这个相似项可能是更合适的,就被挑选到options里了。

最后还有一个"always" mode,其含义是不管token是否存在于索引词典里都要给出相似项。有人可能会问,两个term的相似性是如何判断的? ES使用了一种叫做Levenstein edit distance的算法,其核心思想就是一个词改动多少个字符就可以和另外一个词一致。 Term suggester还有其他很多

可选参数来控制这个相似性的模糊程度,这里就不一一赘述了。

Phrase suggester在Term suggester的基础上,会考量多个term之间的关系,比如是否同时出现在索引的原文里,相邻程度,以及词频等等。看个范例就比较容易明白了:

POST /blogs/_search

{

"suggest": {

"my-suggestion": {

"text": "lucne and elasticsear rock",

"phrase": {

"field": "body",

"highlight": {

"pre_tag": "",

"post_tag": ""

}

}

}

}

}

返回结果:

"suggest": {

"my-suggestion": [

{

"text": "lucne and elasticsear rock",

"offset": 0,

"length": 26,

"options": [

{

"text": "lucene and elasticsearch rock",

"highlighted": "lucene and elasticsearch rock",

"score": 0.004993905

},

{

"text": "lucne and elasticsearch rock",

"highlighted": "lucne and elasticsearch rock",

"score": 0.0033391973

},

{

"text": "lucene and elasticsear rock",

"highlighted": "lucene and elasticsear rock",

"score": 0.0029183894

}

]

}

]

}

options直接返回一个phrase列表,由于加了highlight选项,被替换的term会被高亮。因为lucene和elasticsearch曾经在同一条原文里出现过,同时替换2个term的可信度更高,所以打分较高,排在第一位返回。Phrase suggester有相当多的参数用于控制匹配的模糊程度,需要根据实际应用情况去挑选和调试。

下面来谈一下Completion Suggester,它主要针对的应用场景就是"Auto Completion"。 此场景下用户每输入一个字符的时候,就需要即时发送一次查询请求到后端查找匹配项,在用户输入速度较高的情况下对后端响应速度要求比较苛刻。因此实现上它和前面两个Suggester采用了不同的数据结构,索引并非通过倒排来完成,而是将analyze过的数据编码成FST和索引一起存放。对于一个open状态的索引,FST会被ES整个装载到内存里的,进行前缀查找速度极快。但是FST只能用于前缀查找,这也是Completion Suggester的局限所在。

为了使用Completion Suggester,字段的类型需要专门定义如下:

PUT /blogs_completion/

{

"mappings": {

"properties": {

"body": {

"type": "completion"

}

}

}

}

用bulk API索引点数据:

POST _bulk/?refresh=true

{ "index" : { "_index" : "blogs_completion" } }

{ "body": "Lucene is cool"}

{ "index" : { "_index" : "blogs_completion" } }

{ "body": "Elasticsearch builds on top of lucene"}

{ "index" : { "_index" : "blogs_completion"} }

{ "body": "Elasticsearch rocks"}

{ "index" : { "_index" : "blogs_completion" } }

{ "body": "Elastic is the company behind ELK stack"}

{ "index" : { "_index" : "blogs_completion" } }

{ "body": "the elk stack rocks"}

{ "index" : { "_index" : "blogs_completion"} }

{ "body": "elasticsearch is rock solid"}

查找:

POST /blogs_completion/_search?pretty

{ "size": 0,

"suggest": {

"blog-suggest": {

"prefix": "elastic i",

"completion": {

"field": "body"

}

}

}

}

结果:

"suggest" : {

"blog-suggest" : [

{

"text" : "elastic i",

"offset" : 0,

"length" : 9,

"options" : [

{

"text" : "Elastic is the company behind ELK stack",

"_index" : "blogs_completion",

"_type" : "_doc",

"_id" : "7WIhOnQB-DBpPI60CSK-",

"_score" : 1.0,

"_source" : {

"body" : "Elastic is the company behind ELK stack"

}

}

]

}

]

}

}

值得注意的一点是Completion Suggester在索引原始数据的时候也要经过analyze阶段,取决于选用的analyzer不同,某些词可能会被转换,某些词可能被去除,这些会影响FST编码结果,也会影响查找匹配的效果。

比如我们删除上面的索引,重新设置索引的mapping,将analyzer更改为"english":

PUT /blogs_completion/

{

"mappings": {

"properties": {

"body": {

"type": "completion",

"analyzer":"english"

}

}

}

}

POST _bulk/?refresh=true

{ "index" : { "_index" : "blogs_completion" } }

{ "body": "Lucene is cool"}

{ "index" : { "_index" : "blogs_completion" } }

{ "body": "Elasticsearch builds on top of lucene"}

{ "index" : { "_index" : "blogs_completion"} }

{ "body": "Elasticsearch rocks"}

{ "index" : { "_index" : "blogs_completion" } }

{ "body": "Elastic is the company behind ELK stack"}

{ "index" : { "_index" : "blogs_completion" } }

{ "body": "the elk stack rocks"}

{ "index" : { "_index" : "blogs_completion"} }

{ "body": "elasticsearch is rock solid"}

bulk api索引同样的数据后,执行下面的查询:

POST /blogs_completion/_search?pretty

{ "size": 0,

"suggest": {

"blog-suggest": {

"prefix": "elastic i",

"completion": {

"field": "body"

}

}

}

}

居然没有匹配结果了,多么费解! 原来我们用的english analyzer会剥离掉stop word,而is就是其中一个,被剥离掉了!

用analyze api测试一下:

POST _analyze

{

"text": "elasticsearch is rock solid",

"analyzer":"english"

}

会发现只有3个token:

{

"tokens": [

{

"token": "elasticsearch",

"start_offset": 0,

"end_offset": 13,

"type": "",

"position": 0

},

{

"token": "rock",

"start_offset": 17,

"end_offset": 21,

"type": "",

"position": 2

},

{

"token": "solid",

"start_offset": 22,

"end_offset": 27,

"type": "",

"position": 3

}

]

}

FST(Finite StateTransducers)只编码了这3个token,并且默认的还会记录他们在文档中的位置和分隔符。 用户输入"elastic i"进行查找的时候,输入被分解成"elastic"和"i",FST没有编码这个“i” , 匹配失败。

好吧,如果你现在还足够清醒的话,试一下搜索"elastic is",会发现又有结果,why? 因为这次输入的text经过english analyzer的时候is也被剥离了,只需在FST里查询"elastic"这个前缀,自然就可以匹配到了。

其他能影响completion suggester结果的,还有如"preserve_separators","preserve_position_increments"等等mapping参数来控制匹配的模糊程度。以及搜索时可以选用Fuzzy Queries,使得上面例子里的"elastic i"在使用english analyzer的情况下依然可以匹配到结果。

"preserve_separators": false, 这个设置为false,将忽略空格之类的分隔符

"preserve_position_increments": true,如果建议词第一个词是停用词,并且我们使用了过滤停用

词的分析器,需要将此设置为false。

因此用好Completion Sugester并不是一件容易的事,实际应用开发过程中,需要根据数据特性和业务需要,灵活搭配analyzer和mapping参数,反复调试才可能获得理想的补全效果。

回到篇首京东或者百度搜索框的补全/纠错功能,如果用ES怎么实现呢?我能想到的一个的实现方式:在用户刚开始输入的过程中,使用Completion Suggester进行关键词前缀匹配,刚开始匹配项会比较多,随着用户输入字符增多,匹配项越来越少。如果用户输入比较精准,可能Completion Suggester的结果已经够好,用户已经可以看到理想的备选项了。

如果Completion Suggester已经到了零匹配,那么可以猜测是否用户有输入错误,这时候可以尝试一下Phrase Suggester。如果Phrase Suggester没有找到任何option,开始尝试term Suggester。精准程度上(Precision)看: Completion > Phrase > term, 而召回率上(Recall)则反之。从性能上看,Completion Suggester是最快的,如果能满足业务需求,只用Completion Suggester做前缀匹配是最理想的。 Phrase和Term由于是做倒排索引的搜索,相比较而言性能应该要低不少,应尽量控制suggester用到的索引的数据量,最理想的状况是经过一定时间预热后,索引可以全量map到内存。

召回率(Recall) = 系统检索到的相关文件 / 系统所有相关的文件总数

准确率(Precision) = 系统检索到的相关文件 / 系统所有检索到的文件总数

从一个大规模数据集合中检索文档时,可把文档分成四组:

- 系统检索到的相关文档(A)

- 系统检索到的不相关文档(B)

- 相关但是系统没有检索到的文档(C)

- 不相关且没有被系统检索到的文档(D)

则:

- 召回率R:用实际检索到相关文档数作为分子,所有相关文档总数作为分母,即R = A / ( A + C )

- 精度P:用实际检索到相关文档数作为分子,所有检索到的文档总数作为分母,即P = A / ( A + B )

举例:一个数据库有 1000 个文档,其中有 50 个文档符合相关定义的问题,系统检索到 75 个文档,但

其中只有 45 个文档被检索出。

精度:P=45/75=60%。

召回率:R=45/50=90%。

Context Suggester

Completion Suggester 的扩展

可以在搜索中加入更多的上下文信息,然后根据不同的上下文信息,对相同的输入,比如"star",

提供不同的建议值,比如:

咖啡相关:starbucks

电影相关:star wars

第8节 玩转Elasticsearch Java Client

1.说明

ES提供多种不同的客户端:

1、TransportClient ES提供的传统客户端,官方计划8.0版本删除此客户端。

2、RestClient RestClient是官方推荐使用的,它包括两种:Java Low Level REST Client和 Java High Level REST Client。 ES在6.0之后提供 Java High Level REST Client, 两种客户端官方更推荐使用 Java High Level REST Client, 使用时加入对应版本的依赖即可。

2. SpringBoot 中使用 RestClient

1)配置 pom.xml

org.springframework.boot

spring-boot-starter-parent

2.0.1.RELEASE

org.springframework.boot

spring-boot-starter-test

org.elasticsearch.client

elasticsearch-rest-high-level-client

7.3.0

org.elasticsearch

elasticsearch

org.elasticsearch

elasticsearch

7.3.0

- application.yml文件配置

lagouelasticsearch:

elasticsearch:

hostlist: 192.168.211.138:9200 #多个结点中间用逗号分隔

3)配置类

@Configuration

public class ElasticsearchConfig {

@Value("${lagouelasticsearch.elasticsearch.hostlist}")

private String hostlist;

@Bean

public RestHighLevelClient restHighLevelClient(){

//解析hostlist配置信息

String[] split = hostlist.split(",");

//创建HttpHost数组,其中存放es主机和端口的配置信息

HttpHost[] httpHostArray = new HttpHost[split.length];

for(int i=0;i- 编写启动类

package com.lagou;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

@SpringBootApplication

public class ESApplication {

public static void main(String[] args) throws Exception {

SpringApplication.run(ESApplication.class, args);

}

}

5)索引操作

@SpringBootTest

@RunWith(SpringRunner.class)

public class TestIndex {

@Autowired

RestHighLevelClient client;

@Autowired

RestClient restClient;

//创建索引库

/*

PUT /elasticsearch_test

{

"settings": {},

"mappings": {

"properties": {

"description": {

"type": "text",

"analyzer": "ik_max_word"

},

"name": {

"type": "keyword"

},

"pic": {

"type": "text",

"index": false

},

"studymodel": {

"type": "keyword"

}

}

}

}

*/

@Test

public void testCreateIndex() throws IOException {

//创建索引对象

CreateIndexRequest createIndexRequest = new

CreateIndexRequest("elasticsearch_test");

//设置参数

createIndexRequest.settings(Settings.builder().put("number_of_shards","1").put(

"number_of_replicas","0"));

// 指定映射

XContentBuilder builder = XContentFactory.jsonBuilder()

.startObject()

.field("properties")

.startObject()

.field("studymodel").startObject().field("index",

"true").field("type", "keyword").endObject()

.field("name").startObject().field("index",

"true").field("type", "integer").endObject()

.field("description").startObject().field("index",

"true").field("type", "text").field("analyzer", "ik_max_word").endObject()

.field("pic").startObject().field("index",

"false").field("type", "text").endObject()

.endObject()

.endObject();

createIndexRequest.mapping("doc",builder);

/*指定映射

createIndexRequest.mapping("doc"," {\n" +

" \t\"properties\": {\n" +

" \"studymodel\":{\n" +

" \"type\":\"keyword\"\n" +

" },\n" +

" \"name\":{\n" +

" \"type\":\"keyword\"\n" +

" },\n" +

" \"description\": {\n" +

" \"type\": \"text\",\n" +

" \"analyzer\":\"ik_max_word\" \n" +

" },\n" +

" \"pic\":{\n" +

" \"type\":\"text\",\n" +

" \"index\":false\n" +

" }\n" +

" \t}\n" +

"}", XContentType.JSON);

*/

//操作索引的客户端

IndicesClient indices = client.indices();

//执行创建索引库

//CreateIndexResponse createIndexResponse =

indices.create(createIndexRequest, RequestOptions.DEFAULT);

CreateIndexResponse createIndexResponse =

indices.create(createIndexRequest,RequestOptions.DEFAULT);

//得到响应

boolean acknowledged = createIndexResponse.isAcknowledged();

System.out.println(acknowledged);

}

//删除索引库

@Test

public void testDeleteIndex() throws IOException {

//删除索引的请求对象

DeleteIndexRequest deleteIndexRequest = new

DeleteIndexRequest("elasticsearch_test");

//操作索引的客户端

IndicesClient indices = client.indices();

//执行删除索引

AcknowledgedResponse delete = indices.delete(deleteIndexRequest,

RequestOptions.DEFAULT);

//得到响应

boolean acknowledged = delete.isAcknowledged();

System.out.println(acknowledged);

}

//添加文档

/*

POST /elasticsearch_test/_doc/1

{

"name": "spring cloud实战",

"description": "本课程主要从四个章节进行讲解: 1.微服务架构入门 2.spring cloud 基

础入门 3.实战Spring Boot 4.注册中心eureka。",

"studymodel":"201001",

"timestamp": "2020-08-22 20:09:18",

"price": 5.6

}

*/

@Test

public void testAddDoc() throws IOException {

//创建索引请求对象

IndexRequest indexRequest = new

IndexRequest("elasticsearch_test","doc");

indexRequest.id("1");

//文档内容 准备json数据

Map jsonMap = new HashMap<>();