前言

这是使用tensorflow 搭建一个简单的回归模型,用于熟悉tensorflow的基本操作和使用方法。

模型说明

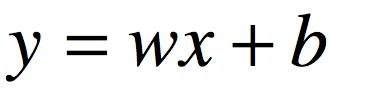

这是一个简单的线性回归模型

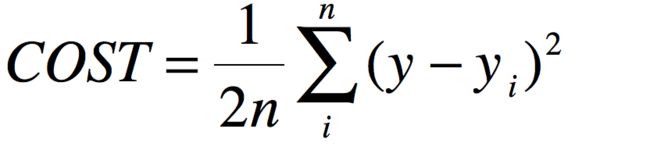

损失函数是均方误差

这个有机器学习基础的同学应该很熟悉了。

模型数据

造的假的

# 训练数据

train_X = np.asarray([3.3, 4.4, 5.5, 6.71, 6.93, 4.168, 9.779, 6.182, 7.59, 2.167,

7.042, 10.791, 5.313, 7.997, 5.654, 9.27, 3.1])

train_Y = np.asarray([1.7, 2.76, 2.09, 3.19, 1.694, 1.573, 3.366, 2.596, 2.53, 1.221,

2.827, 3.465, 1.65, 2.904, 2.42, 2.94, 1.3])

n=train_X.shape[0]

模型构建

根据之前说的tensorflow构建模型思路。

1、构造图节点

2、创建会话

构造图的节点

#定义两个变量的op占位符

X=tf.placeholder("float")

Y=tf.placeholder("float")

初始化权重w和偏置b

#初始化w,b

W=tf.Variable(random.random(),name="weight")

b=tf.Variable(random.random(),name="bias")

根据线性模型公式

y=wx+b

构造运算op

#初始化模型 pred op

pred=tf.add(tf.multiply(X,W),b)

根据损失函数做出COST op

#初始化cost op

cost=tf.reduce_sum(tf.pow(pred-Y,2))/(2*n)

初始化模型参数

#初始化模型参数

learning_rate=0.01

training_epochs=1000

display_step=50

构建梯度下降的op

#构建梯度下降op

optimizer=tf.train.GradientDescentOptimizer(learning_rate).minimize(cost)

训练模型要初始化所有的op(这个op在会话一开始就运行,只是初始化而已)

#初始化所有变量 op

init=tf.global_variables_initializer()

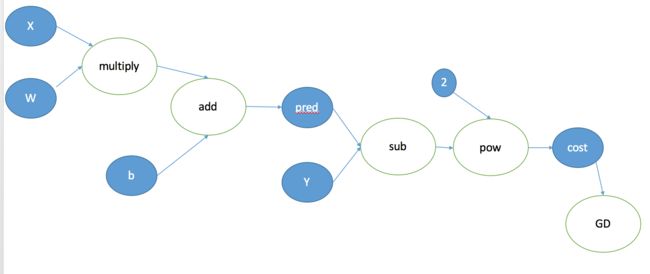

我们构造的计算图为

好了我们的图构造好了。可以创建会话进行运算了。会话可以自动帮我们找依赖关系,所以我们不用一个一个进行计算了。

创建会话

我们明确一下会话执行步骤

1、执行一次init op

2 、执行GD

结束了。。因为会自动帮我们找到依赖,所以我们只需要执行最后一个op即可。

#使用session 启动默认图

with tf.Session() as sess:

sess.run(init) #初始化

for epoch in range(training_epochs):

for (x,y) in zip(train_X,train_Y):

sess.run(optimizer,feed_dict={X:train_X,Y:train_Y})

#上面就已经结束了。计算一下cost 、w、b的值

print ("optimization Finished")

training_cost = sess.run(cost,feed_dict={X:train_X,Y:train_Y})

print ("Training cost=",training_cost,"W=",sess.run(W),"b=",sess.run(b),"\n")

#画图

plt.plot(train_X,train_Y,'ro',label="Original data")

plt.plot(train_X,sess.run(W)*train_X+sess.run(b),label="Fitted line")

plt.legend()

plt.show()

是不是so easy