最近对AVAudioEngine感兴趣,一方面是网上很多录音是通过AVAudioRecorder或AudioUnit来实现的,AVAudioEngine相对较少,另一方面是wwdc上关于音频技术的介绍,大部分都用AVAudioEngine来讲解了,所以想自己试着用用看。iOS上重采样的资料也很少,所以顺便探索一下重采样。

以下是我经过一段时间的尝试后,整理出来的音频相关知识和实现流程

音频

首先需要了解音频的一些相关概念,例如采样率,位宽,声道数等

推荐阅读:

iOS音频—音频基本概念

音频基本概念

AudioStreamBasicDescription

补充:

IOBufferDuration:采样的间隔,假设采样率为16k,那么1秒钟会采样16000个样本,设置IOBufferDuration为0.1秒,设备会按0.1秒一次去进行采样,每次采样数量为16000*0.1 = 1600,由于录音设备有它本身的条件限制,所以不能随意设置采样间隔,例如把IOBufferDuration设置为0.000001秒,系统会自动修改成当前设备支持的最低采样间隔,测试设备8p采样16k的最低采样间隔约为0.016秒

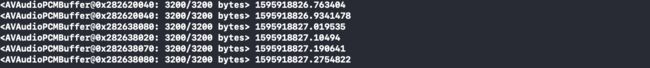

bufferSize:缓冲区的大小。录制实时音频流的时候,假设IOBufferDuration为0.1秒,音频不是每隔0.1秒给我们输出一次数据,而是每隔0.1秒把音频数据放入缓冲区,缓冲区满了后,再把音频输出一次给我们,例如bufferSize设为512,那么当缓冲区中的音频样本数达到512个,就会输出给我们,我们得到音频的时间间隔是1s/16000x512=0.032秒。由于AVAudioEngine的Tap方法要求缓冲区的大小为100ms~400ms采集音频的大小,0.032低于系统要求的0.1s,所以系统会自动修改缓冲区大小为0.1sx16000 = 1600,每隔0.1s输出一次音频给我们,每次的音频样本数为1600,大小为 3200字节。

注意:在

AVAudioEngine中缓冲区大小的单位是样本数,在AVAudioUnit中单位为字节数,在线性16位PCM格式单声道音频里,一个package含有一个frame,一个frame有1个channel,1个channel有16位,占两个字节,缓冲区512个样本数在使用AVAudioUnit时要设为1024个字节大小

AVAudioEngine录音

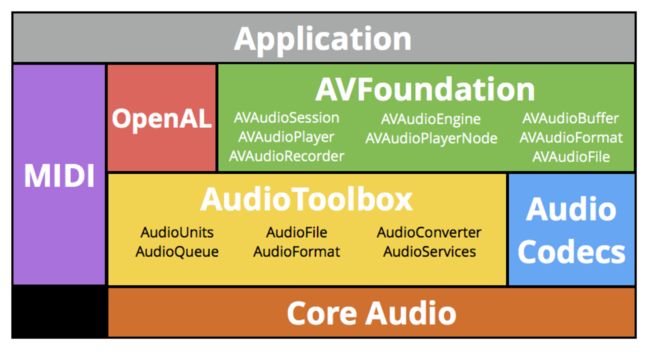

AVAudioEngine位于AVFoundation(一个顶层的音频框架),却拥有底层AudioUnit的能力。AVAudioEngine对象自带一个inputNode来完成录音,可以实时输出录制的音频流。

以下是录制16k16位单声道PCM格式音频示例

1.首先设置录音硬件的录音信息

let audiosession = AVAudioSession.sharedInstance()

do{

try audiosession.setPreferredSampleRate(16000)

try audiosession.setPreferredIOBufferDuration(0.016)

try audiosession.setActive(true, options: AVAudioSession.SetActiveOptions.notifyOthersOnDeactivation)

}catch{

print(error)

}

采样率为16k

IOBufferDuration为0.016s

2.设置引擎接收的录音信息

这是AVAudioEngine默认inputNode接收的录音信息

["AVLinearPCMBitDepthKey": 32,

"AVChannelLayoutKey": <01006400 00000000 00000000>,

"AVLinearPCMIsBigEndianKey": 0,

"AVSampleRateKey": 16000,

"AVLinearPCMIsNonInterleaved": 1,

"AVNumberOfChannelsKey": 1,

"AVFormatIDKey": 1819304813,

"AVLinearPCMIsFloatKey": 1]

我们要录制16k16位的格式,所以修改一下采样率和位宽

let inputNode = audioEngine.inputNode

var setting = audioEngine.inputNode.inputFormat(forBus: 0).settings

setting[AVLinearPCMBitDepthKey] = 16

setting[AVSampleRateKey] = 16000

setting[AVLinearPCMIsFloatKey] = 0

注意:在

AVAudioEngine中8 16位对应Int类型, 32位对应Float,修改成16位的同时需要把AVLinearPCMIsFloatKey设置为0,不然即使修改了位宽为16,inputNode还是以32位去接收

3.实时输出录制的音频

给inputNode安装一个水龙头tap,缓冲区大小设为最小的0.1s,对应16000x0.1s=1600个样本。接收的音频信息是第二步配置好的setting

let newFormat = AVAudioFormat.init(settings: setting)

inputNode.installTap(onBus: 0, bufferSize: AVAudioFrameCount(0.1*sampleRate), format: newFormat) { (buffer, time) in

print("\(buffer) \(Date().timeIntervalSince1970)")

}

调用audioEngine.start()开始录制,可以看到获取的音频大小为1600个样本,3200字节大小,音频的输出间隔约为0.1s

可以试着修改录音的参数,去录制不同的音频

AVAudioConverter重采样

之所以要重采样,是因为很多处理音频的SDK对音频采样率有不同的要求,例如腾讯音视频SDK需要48k采样率,讯飞的语音识别SDK需要16k采样率,使用重采样可以免去开多个录音器录制不同采样率的麻烦

1.修改AVAudioEngine录音信息

录制48k音频,重采样成16k

/// 录音引擎

private var audioEngine: AVAudioEngine = AVAudioEngine()

/// 采样率

private let sampleRate:Double = 48000

/// 采样间隔

private let ioBufferDuration = 0.1

2.设置重采样后的信息

let resampleFormat = AVAudioFormat(commonFormat:.pcmFormatInt16,sampleRate: Double(16000), channels: 1, interleaved: false)

let formatConverter = AVAudioConverter(from:newFormat!, to: resampleFormat!)

3.开始重采样

self.audioQueue.async {

guard let pcmBuffer = AVAudioPCMBuffer(pcmFormat: resampleFormat!,

frameCapacity: AVAudioFrameCount(1600)) else{

return

}

let inputBlock: AVAudioConverterInputBlock = {inNumPackets, outStatus in

outStatus.pointee = AVAudioConverterInputStatus.haveData

return buffer

}

var error: NSError? = nil

formatConverter?.convert(to: pcmBuffer, error: &error, withInputFrom: inputBlock)

print("\(pcmBuffer) \(Date().timeIntervalSince1970)")

}

48k重采样成16k后,样本数变成原来的3分之一,所以pcmBuffer的frameCapacity设为1600

4.pcmBuffer转data

func toNSData(PCMBuffer: AVAudioPCMBuffer) -> NSData {

let channelCount = 1 // given PCMBuffer channel count is 1

let channels = UnsafeBufferPointer(start: PCMBuffer.int16ChannelData, count: channelCount)

let ch0Data = NSData(bytes: channels[0], length:Int(PCMBuffer.frameCapacity * PCMBuffer.format.streamDescription.pointee.mBytesPerFrame))

return ch0Data

}

这是在网上找到的pcmBuffer转data方法,由于我重采样后的音频是16位int的,所以获取数据时,取PCMBuffer.int16ChannelData,不同的音频,获取数据时要选择对应格式的数据

注意:int16ChannelData、int32ChannelData、floatChannelData当其中一个有值时,另外两个为nil

48k重采样成16k后的音频数据,我放到识别引擎中可以成功识别出,效果很好

DEMO

参考

音频 API 一览

AVAudioEngine Tutorial for iOS: Getting Started

Apple's "Working with Audio"

Changing the Format of iOS AVAudioEngine Mic Input