离线数据分析平台实战——160Sqoop介绍

Sqoop介绍

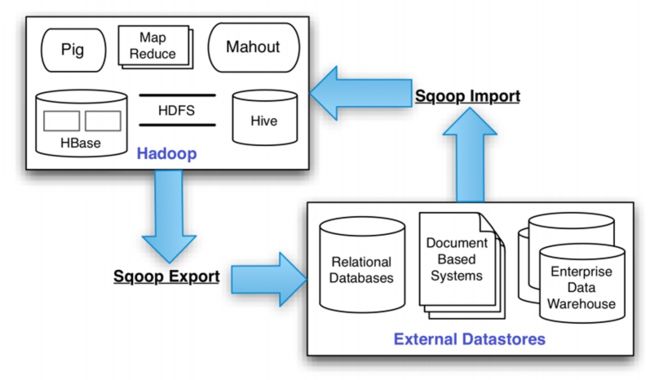

Apache Sqoop(SQL-to-Hadoop) 是一款开源的工具,主要用于在Hadoop(Hive)与传统的数据库(mysql、oracle...)间进行数据的传递,可以将一个关系型数据库中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。

一般情况下,是将数据分析的结果导出到关系型数据库中,供其他部门使用。

Sqoop成立于2009年,刚开始是作为hadoop的一个模块而存在的,不过后来为了更好的进行部署使用,成为apache基金会组织的一个项目。

Sqoop专门为大数据而设计,可以通过分割数据集来启动多个mapreduce程序来处理每个数据块。

Sqoop安装步骤

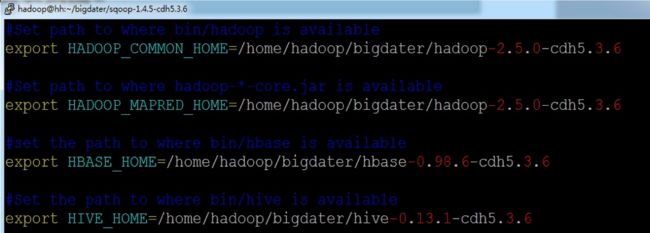

Sqoop选择版本sqoop-1.4.5-cdh5.3.6,安装步骤如下:

- 下载:wget http://archive.cloudera.com/cdh5/cdh/5/sqoop-1.4.5-cdh5.3.6.tar.gz

- 解压,sqoop根目录为:~/bigdater/sqoop-1.4.5-cdh5.3.6

- 复制相关的依赖包到lib文件夹中。

- 修改conf/sqoop-env.sh文件。

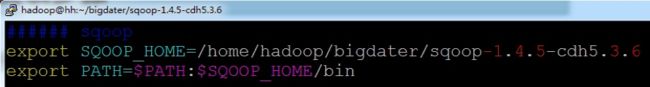

- 添加sqoop常量到用户环境变量中去。

- 测试是否安装成功。

Sqoop安装截图

Sqoop命令介绍

Sqoop总共有14个命令,包括:codegen,create-hive-table, eval, export, help, import, import-all-tables, import-mainframe, job, list-databases, list-tables, merge, metastore, version。其中常用命令为create-hive-table, export, import, help等。

sqoop命令格式:

sqoop

help命令

help命令主要作用是查看sqoop提供的帮助信息,

命令格式如下:

sqoop help [

help后面的参数为sqoop支持的命令名称。

如果不给定help后面的参数,那么表示显示sqoop命令的帮助信息,如果给定后面的参数,那么表示显示具体sqoop命令的帮助信息。

实例:

- sqoop help

- sqoop help list-tables

list-tables&list-databases命令

list-tables和list-databases两个命令都是针对关系型数据库(可以通过jdbc连接的数据库/数据仓库)而言的,我们一般可以通过该命令查看对应数据库中的table&database的列表。

基本命令格式为:

sqoop (list-tables|list-databases) --connect jdbc_url --username user_name --password user_pwd

实例:

sqoop list-tables --connect jdbc:mysql://hh:3306/hive --username hive --password hive

sqoop list-databases --connect jdbc:mysql://hh:3306/hive --username hive --password hive

create-hive-table命令

create-hive-table命令根据关系型数据库中的表创建hive表,不进行数据的copy,只进行表结构的copy。如果hive中存在要创建的表,默认情况下不进行任何操作。

命令格式:

sqoop create-hive-table --connect jdbc_url --username db_name --password db_pwd --table db_table_name --hive-table hive_table_name

实例:

sqoop create-hive-table --connect jdbc:mysql://hh:3306/test --username hive --password hive --table test --hive-table hivetest

import命令

import命令的主要作用是将关系型数据库中的数据导入到hdfs文件系统中(或者hbase/hive中),不管是导入到hbase还是导入到hive中,都需要先导入到hdfs中,然后再导入到最终的位置。

一般情况下,只会采用将关系型数据库的数据导入到hdfs或者hive中,不会导入到hbase中。

import命令导入到hdfs中默认采用','进行分割字段值,导入到hive中默认采用'\u0001'来进行分割字段值,如果有特殊的分割方式,我们可以通过参数指定。

import命令导入到hive的时候,会先在/user/${user.name}/文件夹下创建一个同关系型数据库表名的一个文件夹作为中转文件夹,如果该文件夹存在,则报错。

可以通过命令sqoop help import查看import命令的帮助信息。

import案例

案例1:将mysql表test中的数据导入hive的hivetest表,hive的hivetest表不存在。

案例2:在案例1的基础上,分别进行overwrite导入和into导入。

案例3:在案例2的基础上,通过增加mysql的test表数据,增量导入到hive表中。

案例4:将test表中的数据导出到使用','分割字段的hive表中。

案例5:将test表的数据导入到hdfs中。

案例6:在案例4的基础上,增量导出数据到hdfs中。

export命令

export命令的主要作用是将hdfs文件数据导入到关系型数据库中,不支持从hive和hbase中导出数据,但是由于hive的底层就是hdfs的一个基本文件,所以可以将hive导出数据转换为从hdfs导出数据。

导出数据的时候,默认字段分割方式是',',所以如果hive的字段分割不是',',那么就需要设计成对应格式的分割符号。

可以通过命令:sqoop help export查看export命令的详细参数使用方式&各个参数的含义。

注意:前提条件,关系型数据库中目的表已经存在。

export案例

案例1:将hdfs上的文件导出到关系型数据库test2表中。

案例2:将hive表数据导出到关系型数据库test2表中(使用insertOrUpdate方法导入)。