SiamRPN++:Evolution of Siamese Visual Tracking with very Deep Netwrks 论文学习

SiamRPN++:Evolution of Siamese Visual Tracking with very Deep Netwrks 论文学习

- 论文阅读总结

- Translation

-

- Abstract

- 1 Introduction

- 2 Related Work

- 3 Siamese Tracking with Very Deep Networks

-

- 3.1 Analysis on Siamese Networks for Tracking

- 3.2 ResNet-driven Siamese Tracking

- 3.3 Layer-wise Aggregation

- 3.4 Depthwise Cross Correlation

- 4 Experiments

-

- 4.1 Training Dataset and Evaluation

- 4.2 Implementation Details

- 4.3 Ablation Experiments

- 4.4 Comparison with the state-of-the-art

- 5 Conclusions

论文阅读总结

-

阅读疑问

(1)第3.1节的分析与实验不是很懂?

SiamFC中的孪生追踪框架存在两个固有的限制:(1)网络需要严格的平移不变性,所谓需要严格的平移不变性,就是网络的输出对目标在原始图像中不同位置有相同的响应,相似度网络的输出与目标在图像中的位置无关;(2)网络具有对称性,SiamFC是通过学习相似度度量来进行目标追踪的,如果将搜索区域图像和模板区域图像进行互换,网络的输出结果应该保持不变,这是由度量的性质决定的。

&emps; 现在化的深度网络在应用与孪生追踪框架时,比如ResNet50,会引入padding操作,pading操作会使破坏网络的严格平移不变性。SiamRPN之后,网络已经不再是进行相似度的计算,而是通过回归的偏移量和分类的分数来预测最终的目标位置,这导致网络不再具有对称性。SiamRPN网络的非对称部件可以参考SiamRPN网络结构图。

&emps;&emps;在网络不满足严格的平移不变性之后,如果按照SiamFC的训练方法,正样本位于图像正中心,网络会学习到这种统计特性,会给图像中心的位置分配更大的权重,而图像边缘的目标追踪就随缘了,这就是所谓的位置偏见。

第3.1节中的是一个模拟实验:当我们使用SiamFC中的方法训练深度网络,把正样本都放在图像中心,网络只会对图像中心产生响应;如果把正样本均匀分布在某个范围内(目标与中心的距离为shift),而不是一直在中心时,随着shift的增大,这种位置偏见会逐渐得到缓解。而模拟的结果也显示了,随着偏移的范围增大,深度网络可以由开始的完全没有效果逐渐变好。模拟实验表明,通过均匀分布的采样方式可以让目标在中心点进行偏移,可以缓解网络因为破坏了严格平移不变性带来的影响,从而让深度网络可以应用于孪生追踪算法中。 -

Research Objective

将现代化深度网络,例如ResNet50等,应用于基于孪生网络的追踪器中。 -

Problem Statement

在将深度网络应用于孪生追踪器中时,随着网络层数的增加,追踪性能反而可能会下降。深度网络不能应用于孪生追踪器中。 -

Method(s)

(1)提出一种基于均匀采样的策略,可以打破孪生网络对空间不变性的要求,将深度网络应用于孪生追踪器中。

(2)提出一种分层的特征聚合结构,可以帮助追踪器利用在多个级别上学习的特征来预测结果。

(3)提出一种深度可分离的相关结构,可以产生不同语义相关的多个相似度图。 -

Conclusion

本文提出了SiamRPN++网络,用于将深度网络应用于孪生追踪器中,并设计了如何在孪生追踪器中训练深层网络的方法。SiamRPN++网络由多层聚合模块组成,而深度互相关层则可以减少网络的计算成本和冗余参数,实现更好的收敛。SiamRPN++在VOT2018上获得了SOTA结果。 -

Notes

(1)SiamRPN++算法详解。强烈推荐这篇博客,讲解的非常清楚明白,对我在读论文过程中有疑问的地方都涉及到了。

(2)感觉大佬做的论文好强啊!读完感觉没得做了…

Translation

Abstract

基于孪生网络的追踪器将追踪形式化为目标模板和搜索区域之间的卷积特征互相关。但是,孪生追踪器和目前的SOTA算法相比,在精度方面仍然还有很大差距,并且孪生追踪器不能充分利用深度网络的特征,例如ResNet-50甚至更深的网络。在这项工作中,我们证明了其主要原因是缺乏严格的平移不变性。通过全面的理论分析和实验验证,我们通过一种简单而有效的空间感知采样策略来突破这一限制,并成功地训练了以ResNet为主干的孪生追踪器,获得了显著地性能提升。此外,我们提出了一种新的模型体系结构来执行分层聚合和深度聚合,这不仅可以进一步提高准确性,而且可以减小模型大小。我们进行了广泛的消融实验,证明所提出了追踪器的有效性,该追踪器目前在OTB2015,VOT2018,UAV123,LaSOT和TrackingNet等五个大型追踪基准上获得了最佳结果。

1 Introduction

视觉目标追踪在过去十年中受到越来越多的关注,并且一直是非常活跃的研究方向。它在视觉监控[49],人机交互[27]和增强现实[50]等不同领域具有广泛的应用。尽管最近已经取得了很大的进步,但由于光照变化、遮挡和背景干扰等因素[48],视觉目标追踪仍然被公认为一项非常具有挑战性的任务。

最近,基于孪生网络的追踪器[42、1、16、44、43、25、45、54、46]在追踪社区引起了很多关注。这些孪生追踪器将目标追踪问题形式化为相似度学习问题,相似度是由为目标模板和搜索区域学习的特征表示之间的互相关计算而来的。为了确保追踪的性能,离线学习的孪生相似度通常在运行期间是固定的[42,1,16]。CFNet追踪器[43]和DSiam追踪器[12]分别通过运行平均值模板和快速转换模块更新追踪模型。SiamRPN追踪器[25]在Siamese网络之后引入了区域提议网络[25],并进行联合分类和回归以进行追踪。DaSiamRPN追踪器[54]进一步引入了可识别干扰物模块,并提高了模型的判别能力。尽管上述Siamese追踪器已经获得了出色了追踪性能,尤其是在精度和速度方面取得了很好的平衡,例如SiamRPN,但其精度与在OTB2015基准上的SOTA[5]相比仍有显著差距。我们观察到,所有这些追踪器都在类似于AlexNet[24]结构的基础上建立了网络,也尝试了训练像ResNet[15]之类的复杂体系结构的孪生追踪器,却没有任何性能提升。受此观察的启发,我们对现有的孪生追踪器进行了分析,发现不能使用深层网络的原因是深层网络破坏了严格的平移不变性限制。由于目标可能出现在搜索区域的任何位置,从目标模板学习到的特征表示应当具有空间不变性,我们进一步从理论上发现,在最新的深度架构中,只有AlexNet的零填充变体能够满足空间不变性的限制。

为了克服这一限制,以更强大的深度架构来驱动孪生追踪器,我们通过广泛的实验验证,引入了一种简单而有效的采样策略,来打破孪生追踪器的空间不变性限制。我们使用ResNet作为骨干网络成功地训练了基于SiamRPN[25]的追踪器,并获得了显著的性能提升。受益于ResNet架构,我们为互相关操作提出了分层的特征聚合结构,该结构可帮助追踪器根据在多个级别上学习的特征来预测相似度图。通过分析孪生网络结构的互相关性,我们发现它的两个网络分支在参数数量方面高度不平衡。因此,我们进一步提出了一种深度可分离的相关结构,不仅可以大大减少目标模板分支中的参数数量,而且可以使整个模型训练的过程更加稳定。另外,我们观察到了一个有趣的现象,相同类别的目标在相同通道上具有高响应图,而其余通道的响应被抑制。正交特性有助于改善追踪性能。

总而言之,以下四项列出了这项工作的主要贡献:

- 我们提供了对孪生追踪器的深入分析,并证明了当使用深度网络时,准确性的降低是由于严格的平移不变性被破坏所致。

- 我们提出了一种简单而有效的采样策略来打破空间不变性的限制,从而成功地训练了ResNet架构驱动的孪生追踪器。

- 我们为互相关操作提出了一个分层的特征聚合结构,该结构可帮助追踪器根据在多个级别上学习的特征来预测相似度图。

- 我们提出了一种用于增强互相关的深度可分离的相关结构,以产生与不同语义相关的多个相似度图。

基于以上理论分析和技术贡献,我们开发了一种有效而高效的视觉追踪模型,该模型在追踪精度方面建立了新的技术水平,同时能以35FPS的效率运行。所提出的追踪器被称为SiamRPN ++,它在五个最大的追踪基准上始终获得最佳追踪结果,包括OTB2015 [48],VOT2018 [22],UAV123 [32],LaSOT [10]和TrackingNet [31]。此外,我们提出了一种使用MobileNet [19]作为骨干的追踪器的快速变体,它可以在保持70 FPS的同时保持有竞争性的性能。为了促进对视觉追踪方向的进一步研究,我们将发布SiamRPN ++追踪器的源代码和经过训练的模型。

2 Related Work

在本节中,我们简要地介绍最近的追踪器,特别关注于孪生追踪器[42, 1]。除此之外,我们也介绍了深度架构的最新发展。

由于建立了新的基准数据集[47, 48, 20, 22, 10, 31]和改进的方法[17, 53, 6, 7, 18, 33, 9, 5, 45, 54, 51].,视觉追踪在过去十年中迅速发展。标准化基准[47、48、10]为比较不同算法提供了公平的测试平台。每年举行的追踪挑战[23,20,21,22]不断提高追踪性能。随着这些进步,已经提出了许多有先进的追踪算法。Bolme等人的开创性工作[3]将卷积定理从信号处理领域引入视觉跟踪,并将目标模板匹配问题转化为频域的相关运算。由于这种转换,如果使用适当的特征,基于相关滤波器的追踪器不仅可以获得高效的运行速度,而且还可以提高准确性[17、52、53、8、6]。随着视觉追踪中深度学习模型的广泛应用,基于具有深度特征表示的相关滤波器的追踪算法[9,5]在流行的追踪基准[47,48]和挑战[ 23,20,21]取得了最高精度。

最近,基于孪生网络的追踪器因其追踪精度和效率的平衡而受到了广泛的关注[42、1、16、44、43、13、25、45、54、46]。这些跟踪器将视觉追踪形式化为互相关问题,并有望更好地利用端到端学习中的深度网络的优点。为了从两个分支的互相关中生成相似度图,他们训练了一个Y形神经网络,该神经网络连接了两个网络分支,一个用于目标模板,另一个用于搜索区域。另外,这两个分支可以在追踪阶段[42、1、16、45、25、54]保持固定,也可以在线更新以适应目标[44、43、13]的外观变化。当前最先进的孪生追踪器[25,54]通过在孪生网络之后增加区域提议网络提高了追踪性能,并产生了非常可喜的结果。然而,在OTB基准[48]上,它们的跟踪精度与ECO [5]和MDNet [33]等最新的深度追踪器仍存在较大差距。随着Krizhevsky等人[24]在2012年提出的现代深度架构AlexNet,网络架构的研究正在迅速发展,并提出了许多复杂的深度架构,例如VGGNet [38],GoogleNet [39],ResNet [15] ]和MobileNet [19]。这些深层的体系结构不仅提供了对神经网络设计的更深刻理解,而且还推动了许多计算机视觉任务的最新发展,例如目标检测[34],图像分割[4]和人体姿势估计[40] ]。在深度视觉追踪器中,网络体系结构通常包含不超过五个由AlexNet或VGGNet定制的结构层。解释这种现象的原因是浅层特征主要有助于物体的精确定位[35]。在这项工作中,我们认为,如果使用整个孪生网络对模型进行适当训练,则使用更深层次的模型可以极大地提高孪生追踪器的性能。

3 Siamese Tracking with Very Deep Networks

这项工作最重要的发现是,如果将更深的深度网络应用于孪生追踪器中 ,可以大大提高其性能。但是,仅通过直接使用像ResNet这样的更深层网络来训练孪生追踪器并不能获得预期的性能改进。我们发现根本原因很大程度上涉及孪生追踪器的内在限制,因此,在引入所提出的SiamRPN ++模型之前,我们首先对孪生网络进行更深入的分析以进行追踪。

3.1 Analysis on Siamese Networks for Tracking

基于Siamese网络的跟踪算法[42,1]将视觉跟踪形式化为互相关问题,并从具有Siamese网络结构的深度模型中学习跟踪相似度图,一个分支用于学习目标的特征表示,另一个分支用于搜索区域。通常在序列的第一帧中给出目标图像块,并且可以将其视为模板 z z z。目标是在语义嵌入空间 ϕ ( ⋅ ) \phi(\cdot) ϕ(⋅)中从后续帧中搜索到最相似的图像块(实例):

f ( z , x ) = ϕ ( z ) ∗ ϕ ( x ) + b f(\mathbf{z}, \mathbf{x})=\phi(\mathbf{z}) * \phi(\mathbf{x})+b f(z,x)=ϕ(z)∗ϕ(x)+b,其中 b b b用于建模相似度值的偏移量。

这种简单的匹配函数隐藏着在设计孪生追踪器时存在两个固有的限制。

(1)孪生追踪器中使用的收缩部分和特征提取对严格的平移不变性有固有的限制, f ( z , x [ △ τ j ] ) = f ( z , x ) [ △ τ j ] f\left(\mathbf{z}, \mathbf{x}\left[\triangle \tau_{j}\right]\right)=f(\mathbf{z}, \mathbf{x})\left[\triangle \tau_{j}\right] f(z,x[△τj])=f(z,x)[△τj],其中 [ △ τ j ] \left[\triangle \tau_{j}\right] [△τj]是平移变换子窗口操作算子,它能保证有效地训练和推断。(这是不是可以这样理解:目标在搜索图像中移动一定的距离 ,则目标经 f f f变换以后,在变换结果中也移动一定的距离。)

(2)收缩部分具有结构对称性的固有限制,例如, f ( z , x ′ ) = f ( x ′ , z ) f\left(\mathbf{z}, \mathbf{x}^{\prime}\right)=f\left(\mathbf{x}^{\prime}, \mathbf{z}\right) f(z,x′)=f(x′,z),这适合相似度的学习。(就是模板分支和搜索分支相互互换,不影响相似度 f f f的计算结果。)

经过详细分析,我们发现阻止使用深度网络应用于孪生跟踪器的主要原因与这两个方面有关。具体而言,原因之一是深层网络中的padding会破坏严格的平移不变性 (也就是说,padding会导致目标在原始图像中移动的距离和目标在经 f f f变换之后移动的距离不再相等。padding的引入会使得网络输出的响应对不同位置有了不同的认知)。另一个是RPN需要非对称特征进行分类和回归。我们将介绍空间感知采样策略以克服第一个问题,并在第3.4节中讨论第二个问题。

严格的平移不变性仅存在于没有填充网络(例如修改的AlexNet [1])中。以前的基于孪生网络[1、44、43、25、54]的追踪器被设计为较浅,可以满足此限制。但是,如果采用的网络被诸如ResNet或MobileNet之类的现代网络所取代,则不可避免地要进行填充以使网络更深,从而破坏了严格的平移不变性限制。我们的假设是违反平移不变性限制将导致空间偏差(spatial bias)。

我们通过在带有填充的网络上进行仿真实验来检验我们的假设。移位定义为数据增强中均匀分布所产生的最大平移范围。我们的仿真实验如下进行。首先,在三个单独的训练实验中,将目标放置在具有不同移动范围(0、16和32)的中心。收敛之后,我们汇总在测试数据集上生成的热图,然后在图1中可视化结果。在第一个零位移模拟中,边界区域上的概率降为零。这表明尽管出现了测试目标,但仍会习得强烈的中心偏移。其他两个模拟表明,增加平移范围将逐渐防止模型崩溃到这个复杂的解决方案中。定量结果表明,聚合的32-平移热图更接近测试对象的位置分布。证明了这种采样策略有效地缓解了填充网络对严格的翻译不变性的破坏。

为了避免在目标上施加剧烈的中心偏差,我们通过空间感知的采样策略通过在搜索图像上按均匀分布对目标进行采样,使用ResNet-50作为主干网络训练SiamRPN。如图2所示,在VOT2018上零偏移的性能降低到0.14,合适的偏移(±64像素)对于训练深度的孪生跟踪器至关重要。

3.2 ResNet-driven Siamese Tracking

根据以上分析,可以消除中心偏移的影响。一旦我们消除了对中心位置的学习偏移,在迁移学习后,任何现成的网络(例如MobileNet,ResNet)都可以用于执行视觉跟踪。此外,我们可以自适应地构建网络拓扑并揭示用于视觉跟踪的深层网络的性能。

在本小节中,我们将讨论如何将深度网络迁移到我们的跟踪算法中。特别是,我们主要针对ResNet-50 [15]进行实验。原始的ResNet具有32像素的大步幅,不适合密集的孪生网络预测。如图3所示,通过将conv4和conv5块修改为具有单位空间步长,我们将最后两个块的有效步幅从16个像素和32个像素减少到8个像素,并通过扩张卷积来增加其感受野[28] ]。额外的1×1卷积层附加到每个块输出,以将通道减少到256。

由于保留了所有图层的填充,因此模板特征的空间大小增加到15,这给相关模块带来了沉重的计算负担。因此,我们将中心的7×7区域[43]裁剪为模板特征,其中每个特征单元仍可以捕获整个目标区域。

继[25]之后,我们使用互相关层和全卷积层的组合来构建一个头模块,以计算分类分数(用 S \mathcal{S} S表示)和边界框回归器(用 B \mathcal{B} B表示)。 SiamRPN模块用 P \mathcal{P} P表示。

此外,我们发现,微调ResNet可以提高性能。通过将ResNet特征提取器的学习率设置为比RPN部件小10倍,特征表示可以更适合于跟踪任务。与传统的孪生方法不同,深度网络的参数以端到端的方式联合训练。据我们所知,我们的方法是第一个在深度孪生网络(> 20层)上进行视觉跟踪的端到端学习的方法。

3.3 Layer-wise Aggregation

利用像ResNet-50这样的深层网络后,可以聚合不同的深层特征。直观地,视觉跟踪需要丰富的表示形式,其范围从低到高,缩放范围从小到大,分辨率从精细到粗糙。即使卷积网络中的特征深度很大,但仅靠单独的特征层还是不够的:将这些特征表示进行组合和聚合可改善对识别和定位的推断。

在先前仅使用像AlexNet这样的浅层网络的工作中,多层特征不能提供完全不同的表示形式。但是,考虑到感受野的变化很大,ResNet中的不同层更有意义。较浅层的特征将主要集中在颜色、形状等底层信息上,这对于目标定位至关重要,但是缺少语义信息。 后面各层的特征具有丰富的语义信息,这些语义信息在某些挑战性场景(例如运动模糊,巨大变形)中可能是有益的。假设使用这种丰富的层级信息来帮助跟踪。

在我们的网络中,提取了多分支特征以协同推断目标定位。至于ResNet50,我们探索了从最后三个残差块提取的多层特征,以进行分层聚合。我们将这些输出分别称为 F 3 ( z ) \mathcal{F}_3(\bold{z}) F3(z), F 4 ( z ) \mathcal{F}_4(\bold{z}) F4(z)和 F 5 ( z ) \mathcal{F}_5(\bold{z}) F5(z)。如图3所示,conv3,conv4,conv5的输出分别输入三个孪生RPN模块。

由于三个RPN模块的输出大小具有相同的空间分辨率,因此加权总和直接用于RPN输出。加权融合层将所有输出组合在一起。

S a l l = ∑ l = 3 5 α i ∗ S l , B a l l = ∑ l = 3 5 β i ∗ B l \mathcal{S}_{a l l}=\sum_{l=3}^{5} \alpha_{i} * \mathcal{S}_{l}, \quad \mathcal{B}_{a l l}=\sum_{l=3}^{5} \beta_{i} * \mathcal{B}_{l} Sall=l=3∑5αi∗Sl,Ball=l=3∑5βi∗Bl

由于组合权重的域不同,因此将它们分开进行分类和回归。 权重与网络一起离线进行端到端优化。

与以前的作品相比,我们的方法没有明确地组合卷积特征,而是分别学习分类器和回归。 请注意,随着骨干网络深度的显着增加,我们可以从视觉语义层次结构的足够多样性中获得可观的收益。

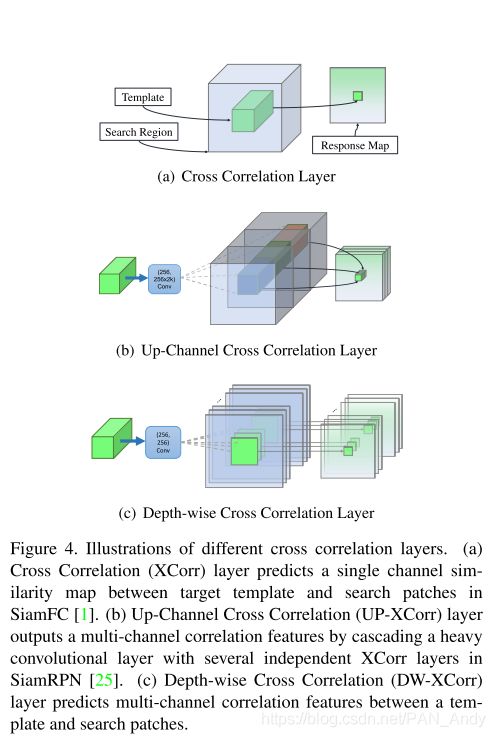

3.4 Depthwise Cross Correlation

互相关模块是嵌入两个分支信息的核心操作。SiamFC [1]利用CrossCorrelation层获得用于目标定位的单个通道响应图。在SiamRPN [25]中,通过添加巨大的卷积层来缩放通道(UP-Xcorr),互相关被扩展为嵌入更高级别的信息(例如锚)。复杂的上行通道模块严重导致参数分布失衡(即[25]中的RPN模块包含20M个参数,而特征提取器仅包含4M个参数),这使得在SiamRPN中难以进行训练优化。

在本小节中,我们将介绍一个轻型互相关层,称为深度互相关(DW-XCorr),以实现有效的信息关联。DW-XCorr层包含的参数比SiamRPN中使用的UP-XCorr少10倍,而性能却与之相当。

为此,采用了conv-bn块来调整每个残差块中的特征以适合跟踪任务。至关重要的是,边界框预测和基于锚的分类都是不对称的,这与SiamFC不同(请参阅第3.1节)。为了编码这种差异,模板分支和搜索分支通过两个非共享的卷积层。然后,具有相同通道数的两个特征图逐通道进行相关运算。添加了另一个conv-bn-relu模块以融合不同的通道输出。最后,添加用于分类或回归输出的最后一个卷积层。

通过将互相关替换为深度相关,我们可以大大降低计算成本和内存使用量。这样,模板和搜索分支上的参数数量是平衡的,从而使训练过程更加稳定。

此外,图5中显示了一个有趣的现象。同一类别的对象在相同的通道上具有较高的响应度(第148个通道中的汽车,第222个通道中的人和第226个通道中的人脸),而其余通道的响应受到抑制。可以理解该特性,因为深度互相关所产生的通道特征几乎是正交的,并且每个通道代表一些语义信息。当使用上行通道互相关时,我们还将分析热图,并且响应图的解释性较差。

4 Experiments

4.1 Training Dataset and Evaluation

Training. 我们架构[15]的骨干网络是在ImageNet[37]上预训练的用于图像标注的网络,它已经被证实了可以作为其他任务[14, 28]的一个非常好的初始化。我们在COCO [26],ImageNet DET [37],ImageNet VID和YouTube-BoundingBoxes数据集[36]的训练集上训练网络,学习用于视觉目标追踪任务的通用目标之间的相似度度量。在训练和测试中,我们使用固定比例的图像尺寸,其中模板图像大小为127,而搜索区域大小为255像素。

Evaluation. 我们使用OTB2015 [48],VOT2018 [22]和UAV123 [32]来评测短时单目标追踪,使用VOT2018-LT [22]来评估长时目标追踪。在长期追踪中,目标可能会长时间离开视野或完全被遮挡,这比短时追踪更具挑战性。我们还分析了我们的方法在LaSOT [10]和TrackingNet [31]上的推广性,这是最近针对单对象追踪的两个最大基准。

4.2 Implementation Details

**Network Architecture. ** 在实验中,我们遵循[54]进行训练和推理的设置。 我们将两个同级卷积层附加到经过stride-reduced的ResNet-50(第3.2节),以使用5个锚点执行候选区域分类和边界框回归。 将三个随机初始化的1×1卷积层附加到conv3,conv4,conv5,以将特征尺寸减小到256。

Optimization. SiamRPN ++使用随机梯度下降(SGD)训练。 我们在8个GPU上使用了同步SGD,每个小批量总共128个图像对(每个GPU 16个图像对),收敛共需要12个小时。 对于训练RPN分支的前5轮训练,我们使用0.001的学习率进行warmup learning。 对于最后15轮,整个网络进行了端到端的训练,学习率从0.005下降到0.0005。 训练使用0.0005的权重衰减和0.9的动量。 训练损失是分类损失和用于回归的standard smooth L 1 L_1 L1损失之和。

4.3 Ablation Experiments

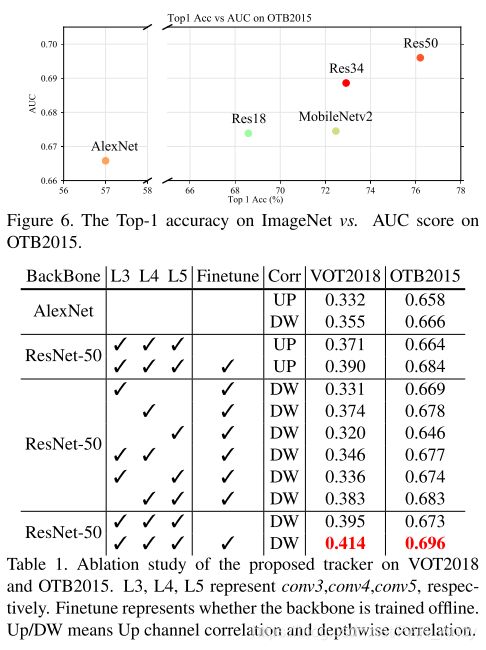

Backbone Architecture. 特征提取器的选择至关重要,因为参数的数量和层的类型会直接影响追踪器的内存、速度和性能。 我们将不同的网络体系结构用于视觉目标追踪。 Figure 6显示了使用AlexNet,ResNet-18,ResNet-34,ResNet-50和MobileNet-v2作为骨干网的性能。 我们报告了OTB2015成功曲线相对于ImageNet的top1精度 按曲线下面积(AUC) 的性能。 我们观察到我们的SiamRPN ++可以从更深的ConvNets中受益。 (Figure 6中的横轴Top 1 Acc(%)是指在ImageNet图像分类中To1的精度,它反映了主干网络的性能;AUC是在SiamRPN++中使用这一主干网络获得的追踪性能。由Figure6可以得出结果,在目前的深度网络中,卷积网络的层数越深,在SiamRPN++中使用这一网络可以获得的追踪性能越好。)

Table 1还表明,通过将AlexNet替换为ResNet-50,在VOT2018数据集上的性能有了很大提高。 此外,我们的实验表明,微调主干部分至关重要,这可以大大提高追踪性能。

Layer-wise Feature Aggregation. 为了研究逐层特征聚合的影响,首先我们在ResNet-50上训练了三个带有单个RPN模块的变体。 我们凭经验发现,单独的conv4可以在EAO中达到0.374的有竞争的性能,而较深层和较浅层的性能下降4%。 通过合并两个分支,conv4和conv5获得了改善,但是在其他两个组合上没有观察到改善。 即使如此,鲁棒性也提高了10%,这是我们追踪器的主要弱点。 这意味着我们的追踪器仍有改进的空间。 将所有三个层进行汇总后,准确性和鲁棒性都稳步提高,VOT和OTB的增益在3.1%至1.3%之间。 总的来说,逐层特征聚合在VOT2018上产生0.414的EAO分数,比单层基准的EAO分数高4.0%。

Depthwise Correlation. 我们将原始的UpChannel互相关层与提出的Depthwise互相关层进行比较。 如Table 1所示,提出的深度互相关在VOT2018上提高了2.3%,在OTB2015上提高了0.8%,这证明了深度互相关的重要性。 这些提升的部分原因是两个分支的参数分布均衡,使学习过程更加稳定,并且收敛得更好。

4.4 Comparison with the state-of-the-art

OTB-2015 Dataset. 标准化的OTB基准[48]为鲁棒性提供了一个公平的测试平台。 基于Siamese的跟踪器将追踪公式化为单次检测任务,而没有任何在线更新,因此导致在无重置设置基准上的性能较差。 然而,我们认为来自浅层网络的有限表示是阻止基于孪生网络的跟踪器超越其他性能最高的方法(例如C-COT变体)的主要障碍[9,5]。

我们将OTB2015上的SiamRPN ++跟踪器与最新的跟踪器进行了比较。 Figure 7显示我们的SiamRPN ++跟踪器在overlap success方面产生了领先的结果。 与最近的DaSiamRPN [54]相比,我们的SiamRPN ++从增加的深度中提高了3.8%的重叠率和3.4%的精度。 从深层ConvNets中提取的特征表示对光照变化和背景混杂不太敏感。 据我们所知,这是孪生跟踪器首次获得与OTB2015数据集上最新跟踪器相当的性能。

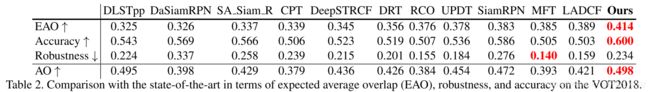

VOT-2018 Dataset. 与10种最新方法相比,我们在最新的VOT-2018数据集[22]上测试了SiamRPN ++跟踪器。 VOT-2018公共数据集是评估在线无模型单目标跟踪器的最新数据集之一,包括60个具有不同有挑战性因素的公共序列。 根据VOT-2018的评估协议,我们采用了预期平均重叠(EAO),准确性(A)和鲁棒性(R)以及基于无重置的平均重叠(AO)来比较不同的跟踪器。 Table 2列出了详细的比较。

从表2中,我们观察到,所提出的SiamRPN ++方法在EAO,A和AO标准上达到了顶级性能。特别是,我们的SiamRPN ++跟踪器的性能优于所有现有跟踪器,包括VOT2018挑战赛冠军。与VOT2018挑战赛中的最佳跟踪器(LADCF [22])相比,该方法的性能提高了2.5%。此外,我们的追踪器比竞赛获胜者(MFT [22])有了实质性的改进,准确率提高了9.5%。与基准跟踪器DaSiamRPN相比,

我们的方法在鲁棒性方面获得了10.3%的实质性增益,这是基于孪生网络的跟踪器与相关过滤器方法相比的常见不足。由于缺乏对模板的适应性,其健壮性仍与依赖在线更新的最新相关过滤器方法[2]有所差距。论文还采用了单次通过评估(OPE)来评估跟踪器,并报告AO值以证明其性能。从表2的最后一行,我们可以看到,与DLSTpp [22]相比,我们的方法可实现相当的性能,并且将DaSiamRPN [54]方法的绝对增益提高了10.0%。

Accuracy vs. Speed. 在Figure 8中,我们在帧率的基础上(FPS)可视化了VOT2018上的EAO。 报告的速度是在装有NVIDIA Titan Xp GPU的计算机上评估的,其他结果由VOT2018官方结果提供。 从图中可以看出,我们的SiamRPN ++具有最佳性能,同时仍以实时速度(35 FPS)运行。 值得注意的是,我们的两个变体在以超过70 FPS的速度运行时,与SiamRPN ++几乎达到了相同的精度,这使这两个变体具有很高的竞争力。

VOT2018 Long-term Dataset. 在最新的VOT2018挑战赛中,新引入了一项长期实验。 它由35个长序列组成,目标可能会长时间离开视野或被完全遮挡。 绩效指标是精度,召回率和综合F分数。 我们将所有这些指标与VOT2018-LT上的最新跟踪器[41,11]进行比较。

如图9所示,在为追踪器配备了从长期追踪策略之后,SiamRPN ++从DaSiam LT获得2.2%的增益,在Fscore中比最佳跟踪器高出1.9%。 ResNet提取的强大特征将TP和TR相对于我们的基准DaSiamRPN绝对提高了2%。 同时,SiamRPN ++的长期版本仍然能够以21 FPS的速度运行,这几乎是VOT2018-LT获奖者MBMD [22]的近8倍。

UAV123 Dataset. UAV123数据集包括123个序列,平均序列长度为915帧。 除了[30]中的最新跟踪器外,还添加了ECO [5],ECO-HC [5],DaSiamRPN [54],SiamRPN [25]。 图10说明了比较跟踪器的精度和成功图。 具体来说,我们的跟踪器获得0.613的成功分数,大大超过了DaSiamRPN(0.586)和ECO(0.525)。

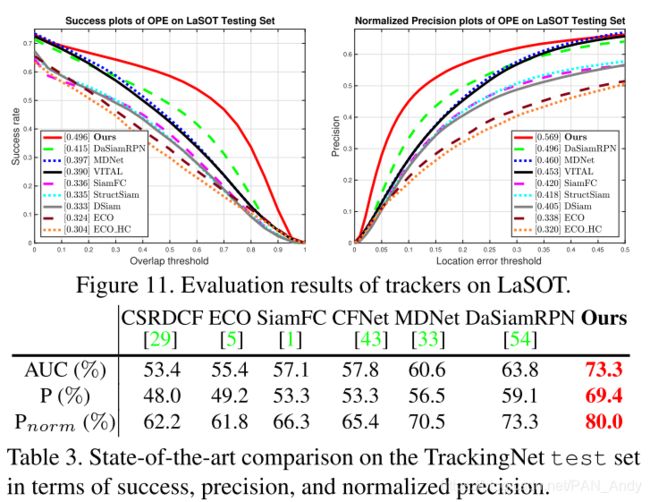

LaSOT Dataset. 为了在更大,更具挑战性的数据集上进一步验证提出的框架,我们在LaSOT上进行了实验[10]。 LaSOT数据集提供了大规模,高质量的密集标注,该数据集总共包含1,400个视频,并且在测试集中包含280个视频。 图11报告了我们在LaSOT测试集上的SiamRPN ++跟踪器的总体性能。 我们的SiamRPN ++模型就足以达到49.6%的最新AUC分数。 具体而言,SiamRPN ++相对于MDNet [33],将归一化的距离精度和AUC分别提高了23.7%和24.9%,这是原始论文中报告的最佳跟踪器。

TrackingNet Dataset. 最近发布的TrackingNet [31]提供了大量数据以评估野外的跟踪器。 我们用511个视频在其测试集上评估了SiamRPN ++。 根据[31],我们使用三个度量标准成功度(AUC),精度(P)和规范化精度(Pnorm)进行评估。 表3展示了与AUC得分最高的跟踪器的比较结果,表明SiamRPN ++在所有三个指标上均取得了最佳结果。 具体而言,SiamRPN ++的AUC得分为73.3%,P得分为69.4%,Pnorm得分为80.0%,优于第二好的追踪器DaSiamRPN [54],AUC得分为63.8%,P得分为59.1%,Pnorm得分为73.4。 分别增加9.5%,10.3%和6.6%。

总之,重要的是要注意,所有这些一致的结果都表明了SiamRPN ++的泛化能力。

5 Conclusions

在本文中,我们提出了一个统一的框架,称为SiamRPN ++,以端到端地训练用于视觉跟踪的深层Siamese网络。 我们显示了理论和经验证据,表明如何在孪生跟踪器上训练深层网络。 我们的网络由多层聚合模块组成,该模块将连接的层次结构组装在一起以聚合不同级别的表示形式,而深度相关层则使我们的网络减少计算成本和冗余参数,同时还可以实现更好的收敛。 使用SiamRPN ++,我们在VOT2018上获得了最新的结果,显示了SiamRPN ++的有效性。 SiamRPN ++还在LaSOT和TrackingNet等大型数据集上获得了最新的结果,显示了其可推广性。