爬虫从入门到入狱(4)——requests与正则表达式

声明:为什么没有3?问就是审核过不去,改了好几遍都过不去。但是问题不大,3是一个阶段案例,不影响之后的学习。

文章内容均出自《python爬虫开发》

文章目录

- 4.1 python第三方库

-

- 4.1.1 第三方库介绍

- 4.1.2 第三方库安装

- 4.1.3 requests的安装

- 4.2 requests获取网页源代码

-

- 4.2.1 GET方式

- 4.2.2 POST方法

- 4.3 requests与正则表达式的结合

4.1 python第三方库

4.1.1 第三方库介绍

在Python开发的过程中,常常需要将一些功能比较通用的代码抽离出来作为一个单独的模块,从而被多个工程调用。这种公共的模块称为Python的库(Library,Lib)。Python在发布时会自带一些由官方开发的常用的库,例如正则表达式“re”、时间“time”等。这些库称为“官方库”。而由非官方发布的库,则称为“第三方库”。Python之所以如此强大,正是由于它拥有非常多的第三方库。使用第三方库,可以轻易实现各种各样的功能。以获取网页内容为例,Python其实自带了两个模块,分别是urllib和urllib2。使用这两个模块也可以获取网页内容。但是这两个模块使用起来非常麻烦。而requests这个第三方库,让获取网页内容变得极其简单。

4.1.2 第三方库安装

win+r —输入cmd—pip install 库名称—回车

安装完第三方库以后,就可以在Python中使用了。使用第三方库,就像使用Python自带的库一样,首先需要使用“import”关键字将它导入,然后才能使用。还有一点需要特别强调,开发者自己写的.py文件的名字绝对不能和Python自带的模块或者已经安装的第三方库的名字相同,否则会产生问题。例如本章内容涉及requests和正则表达式,那么读者在测试代码的时候绝对不能自行创建名为“requests.py”或者“re.py”的文件。一旦创建,代码必定报错。

4.1.3 requests的安装

pip install requests

4.2 requests获取网页源代码

使用浏览器来访问网页,看起来只需要输入网址就可以。但其实网页有很多种打开方式,最常见的是GET方式和POST方式。在浏览器里面可以直接通过输入网址访问的页面,就是使用了GET方式。还有一些页面,只能通过从另一个页面单击某个链接或者某个按钮以后跳过来,不能直接通过在浏览器输入网址访问,这种网页就是使用了POST方式。

4.2.1 GET方式

对于使用GET方式的网页,在Python里面可以使用requests的get()方法获取网页的源代码:

import requests

html = requests.get('网址')

html_bytes=html.content

html_str=html_bytes.decode()

在这4行代码中,第1行导入了requests库,这样代码里面才能使用。第2行使用GET方法获取了网页,得到一个Response对象。此时如果直接打印HTML变量,得到的是:

第3行使用.content这个属性来显示bytes型网页的源代码。第4行代码将bytes型的网页源代码解码为字符串型的源代码。

对于上面的4行代码,可以将后3行合并,缩减为两行代码:

import requests

html_str=requests.get('网址').content.decode()

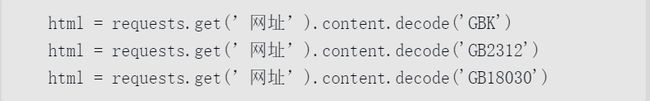

之所以需要把bytes型的数据解码为字符串型的数据,是因为在bytes型的数据类型下,中文是无法正常显示的。这个“解码”对应的英文为“decode”,因而我们需要使用.decode()这个方法。这个方法的参数可以省略。在省略的时候,默认使用UTF-8编码格式来把bytes型解码为字符串型的源代码。可能有一些中文网页,它的编码格式本身不是UTF-8,这就需要在括号里面写明目标编码格式的名字。

4.2.2 POST方法

网页的访问方式除了GET方式以外,还有POST方式。有一些网页,使用GET和POST方式访问同样的网址,得到的结果是不一样的。还有另外一些网页,只能使用POST方式访问,如果使用GET方式访问,网站会直接返回错误信息。

import requests

data={'key1':'value2','key2':'value2'}

html_data=requests.post('网址',data=data).content.decode()

data这个字典的内容和项数需要根据实际情况修改,Key和Value在不同的网站是不一样的。而做爬虫,构造这个字典是任务之一。

还有一些网址,提交的内容需要是JSON格式的,因此post()方法的参数需要进行一些修改:

html_json=requests.post('网址',json=data).content.decode()

这样写代码,requests可以自动将字典转换为JSON字符串,关于JSON格式,后面的章节将会有详细介绍。

4.3 requests与正则表达式的结合

只需要将得到的网址源代码赋给正则表达式的第二个参数即可。