远离欺骗和色情,如何负责地利用Deepfake工具“造福人类”?

![]()

全文共3088字,预计学习时长9分钟

图源:www.ifanr.com

ZAO、激萌、天天P图等一众换脸软件的“始祖”Deepfake可谓是造福无数当代青年。

Deepfake,又称为合成媒体技术。距离它诞生已有三年之久,2017年,一神秘男子将自己制作的换脸视频发布在网络上,并在接下来的一段时间里,他利用这一技术将国外女明星的照片与色情影片合成,几乎可以以假乱真,在当时掀起了不小的风浪。但随着以盖尔·加朵为代表的大量受害者投诉,最终该男子账号被封杀,视频被删光。一怒之下,该男子直接开源了其AI换脸项目的代码。

该男子就是“Deepfake”(用户ID)。也是我们现在的“Deepfake”,在它的催化下,衍生技术百花齐放。

图源:www.ifanr.com

其实,Deepfake益处良多。

例如,语音合成能使人们用自己的声音说出上百种语言。视频合成可用于模拟无人驾驶汽车事故以避免未来可能发生的错误。

但若不谨慎使用这项技术可能会付出巨大的代价:同样的底层技术可能导致全球性的欺骗。

值得庆幸的是,通过努力,可以在实现这项技术的光明前景的同时降低它的风险。

图源:Unsplash

“如果用户滥用我们的工具,我们也无能为力。”开发者可以这样说以逃避责任。

因为开发者可以做许多事,只是他们通常不愿意做。另一种观点是“这种技术无论如何都会出现”,这并不完全错误,但“如何”和“何时”才是重要的问题,而开发者的选择会改变这两大问题。

我们不能躲在“总会存在欺骗”的陈词滥调背后,而忽略程度和影响方面的重大差异。

Deepfake技术的代价已经产生。合成换脸视频使记者陷入沉默;合成语音被用于大型欺诈交易,而合成人脸据称支持间谍活动。所有这些都是目前使用有漏洞的公测软件所面临的挑战。对于大多数恶意攻击者来说,使用合成媒体技术的障碍仍然很大,不足以吸引他们。但从有漏洞的公测版本到软件正式发布期间,我们有责任通过提高非法利用deepfake的难度来避免最糟糕情形的出现。

说的容易,但具体如何去做呢?

可采取以下几种措施降低恶意使用的可能性。

方法1:限制工具的使用用户和使用方法

其中一种明显、简单而又有效的方法是仔细审查准入用户。这是Synthesia等公司目前的做法——实质上,他们仅与经过审查的企业客户合作。

另一种方法是限制使用:限制用户合成或操作的内容。例如,构建工具以确保仅能操作预先选择的特定的声音或面部。Humen的做法是——限制生成视频中的人的一系列动作。

然而很多系统可能不支持这样的限制方法。除此之外还能怎么做呢?

图源:Unsplash

方法2:支持合乎道德的Deepfake工具

当今的商业环境中竞争日渐激烈,除非发生不可逆转的灾难,否则很难证明有必要采取额外的工作让人们免受伤害。那么,如何确保及时地实施这些方法呢?以下是资助者、政府、记者和公众可以采取的四项措施,以支持那些使用合乎道德的合成媒体工具的人。

让做正确的事变简单

这意味着我们必须投资所有这些领域的研究,以使我们拥有广泛可用、资金充足的开源工具来实施这些方法。信息安全的历史表明,当使用简易的开源工具可以确保事情安全时,更多的事情都会以安全告终。此处可以使用相同的逻辑:至少,我们迫切的需要简化公开元数据、水印和日志记录的标准化。还需要研究探索在正式应用前将可检测性引入训练模型是否可行。如果没有这种基础设施和研究,许多善意的工具将会被恶意使用。

培养减少滥用的专业知识

与在隐私和安全方面相同,必须支持专注于强化系统并处理恶意攻击者的社区,公司必须出资请人来完成这项工作,不论是作为顾问还是公司内部人员。

避免资助、构建和分配不负责任的工具

如果公司或工具没有进行减少滥用的尝试,则出资者和开发者不应提供支持。未实施上述最佳做法的工具制造商必须有充分的理由,默认情况下,应用商店应对此作出要求。

通过使人们负起责任来建立规范

即使是投资方、同事、朋友或家人疏忽大意、不负责任,也应指出他们的错误。通过表扬做得好的人并督促做的不够好的人来建立道德规范。

推进Deepfake技术的组织,如Nvidia、Adobe、Facebook和Google,应在上述方面进行大量投资。风险资本家和基金会也应尽其所能来支持这项工作,并谨慎对待被支持者。

这只是所需的广泛努力中的一部分,而在许多情况下,这些努力只能为我们争取到一点时间。这意味着必须确保平台和政策制定者明智地利用这一时间,以使信息生态系统更具弹性。

之前大部分开发者都在后悔没有更谨慎地介绍引用他们的产品,而我们只有一个未来。不要搞砸它。

图源:Unsplash

方法3:阻止恶意使用

对于可以广泛使用的通用的合成媒体工具,仍有许多方法用于减少恶意使用。如下所示:

· 明确披露:明确表明合成媒体,尤其是可能用于误导的材料。工具可以通过在输出文件中包含清晰的视觉或听觉标注(如可视警告或口头披露)来实现这一点。元数据至少应指明媒体的合成或处理方式。

· 同意保护:征求被模仿者的同意。语音克隆工具“Lyrebird''要求用户说出特定的短语以模拟其声音。这使未经同意模仿他人变得困难,而不能仅通过使用提供的数据集生成声音。当然,这仅适用于允许模仿的工具。

· 检测友好性:确保合成介质不难被检测出来;使检测工具保持最新状态;与从事检测工作的人员合作,使他们掌握最新动态。

· 隐藏水印:通过强大的水印嵌入有关合成的内容(甚至原始媒体)中,可使用任何人都可以通过适当工具访问的方法,也可以使用私密且难以删除的方法。(例如,Modulate.ai给生成音频进行水印处理,Imatag等产品及其开源的同类产品为图像进行水印处理。)

· 使用日志:以研究人员和新闻工作者可访问的方式存储有关使用情况和媒体输出的信息,以识别如某个视频是否可能是由特定工具合成得到的。这可能包括使用可靠的哈希算法或媒体嵌入来存储合成的时间戳。

· 使用限制:提供并执行禁止并惩罚非法操作的合同使用条款,如试图删除披露或水印以及未经他人同意的操作。此方法更好的实施方式是,明确说明该技术允许的使用范围或产生输出。

这些策略并非适用于每个系统。一些策略可能有风险,且没有一种能尽善尽美。它们是“深度防御”的一部分,要尽可能结合多种方式来阻止恶意使用。即使有审查或约束,这些方法仍能使系统防御变得更加强大。虽然遵循这些规则可能最适用于“软件即服务”系统(该系统在交付时不透露任何源代码),但它们仍可为开源工具和模型提供价值:许多恶意使用者没有技术能力避开这些保护措施。

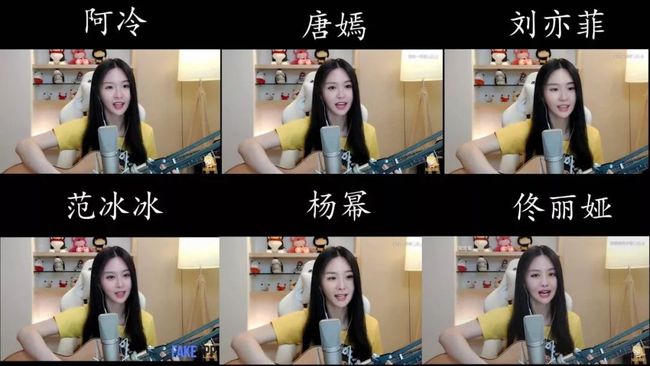

图源:B站

光提案没有,以上几点只有真正落实到行动中,才能发挥它应有的作用。

如何指导开发者运用该技术,无论是进行开创性研究、开发新产品,还是出于兴趣进行开源系统的研发。如何针对于该技术的投资者和赞助者、督促开发者严肃对待技术影响的新闻记者以及开发者的亲朋好友。如何呼吁人们采取行动,才是目前重中之重。

![]()

推荐阅读专题

![]()

![]()

![]()

![]()

![]()

留言 点赞 发个朋友圈

我们一起分享AI学习与发展的干货

编译组:郑雨晴、贺宇

相关链接:

https://medium.com/mit-technology-review/making-deepfake-tools-doesnt-have-to-be-irresponsible-here-s-how-5ac73f6222a

如需转载,请后台留言,遵守转载规范

推荐文章阅读

ACL2018论文集50篇解读

EMNLP2017论文集28篇论文解读

2018年AI三大顶会中国学术成果全链接

ACL2017 论文集:34篇解读干货全在这里

10篇AAAI2017经典论文回顾

长按识别二维码可添加关注

读芯君爱你