你应该知道的,十二大CNN算法

大家好,我是K同学啊!

今天和大家分享一下自1998~2022年来,涌现出来的那些优秀的图像识别算法模型。

目录(按出版年份排序)

- 1. LeNet-5 (1998)

- 2. AlexNet (2012)

- 3. VGG-16 (2014)

- 4. Inception-v1 (2014)

- 5. Inception-v3 (2015)

- 6. ResNet-50 (2015)

- 7. Xception (2016)

- 8. Inception-v4 (2016)

- 9. Inception-ResNet-V2 (2016)

- 10. ResNeXt-50 (2017)

- 11. RegNet(2020)

- 12. ConvNeXt(2022)

1. LeNet-5 (1998)

⭐️ 简介

LeNet-5模型是Yann LeCun教授于1998年在论文《Gradient-based learning applied to document recognition》中提出。它是第一个成功应用于手写数字识别问题并产生实际商业(邮政行业)价值的卷积神经网络。LeNet-5被誉为是卷积神经网络的“Hello Word”,它是最简单的架构之一。LeNet-5有 2 个卷积层和 3 个全连接层,有大约 60,000 个参数。

论文

- 论文:Gradient-Based Learning Applied to Document Recognition

- 作者:Yann LeCun、Léon Bottou、Yoshua Bengio 和 Patrick Haffner

- 发表于: IEEE Proceedings of the IEEE (1998)

实战案例

- 深度学习100例-卷积神经网络(LeNet-5)深度学习里的“Hello Word” | 第22天

2. AlexNet (2012)

AlexNet 由Alex Krizhevsky于2012年提出,夺得2012年ILSVRC比赛的冠军,top5预测的错误率为16.4%,远超第一名。AlexNet采用8层的神经网络结构,5个卷积层和3个全连接层(3个卷积层后面加了最大池化层),模型参数个数为60M。AlexNet主要的变化在于激活函数采用了Relu(是第一个将流线性单元 (ReLU) 实现为激活函数的模型)、使用Dropout代替正则降低过拟合。

论文

- 论文:ImageNet Classification with Deep Convolutional Neural Networks

- 作者:Alex Krizhevsky、Ilya Sutskever、Geoffrey Hinton。加拿大多伦多大学。

- 发表于:NeurIPS 2012

论文

- 深度学习100例-卷积神经网络(AlexNet)手把手教学 | 第11天

3. VGG-16 (2014)

截至到2014,由于加深网络成了提高深度神经网络性能最直接的方法,CNN开始变得越来越深入。Visual Geometry Group (VGG) 团队发明了 VGG-16,它有 13 个卷积层和 3 个全连接层,同时继承了 AlexNet 的 ReLU 传统。该网络在 AlexNet 上堆叠了更多层,并使用了更小的过滤器(2×2 和 3×3)。它由138M个参数组成,占用大约500MB的存储空间。与此同时,他们还设计了一个更深的变体,VGG-19。

论文

- 论文:Very Deep Convolutional Networks for Large-Scale Image Recognition

- 作者:Karen Simonyan、Andrew Zisserman。英国牛津大学。

- arXiv 预印本,2014

实战案例

- 深度学习100例-卷积神经网络(VGG-16)识别海贼王草帽一伙 | 第6天

- 深度学习100例-卷积神经网络(VGG-16)猫狗识别 | 第21天

4. Inception-v1 (2014)

Inception-v1 是 Inception 网络的第一个版本,Inception V1在GoogLeNet基础之上,为了减少5x5卷积的计算量,在3x3conv前、5x5conv前、3x3max pooling后分别加上1x1的卷积核,起到减少总的网络参数数量的作用(参数总量为5M)。其主体是Inception模块,Inception模块的体系结构设计是近似稀疏结构研究的产物。

Inception V1相比GoogLeNet原始版本进行了如下改进:

- 为了减少5x5卷积的计算量,在3x3conv前、5x5conv前、3x3max pooling后分别加上1x1的卷积核,减少了总的网络参数数量;

- 网络最后层采用平均池化(average pooling)代替全连接层,该想法来自NIN(Network in Network),事实证明这样可以将准确率提高0.6%。但是,实际在最后还是加了一个全连接层,主要是为了方便对输出进行灵活调整;

- 网络中仍然使用Dropout ;

- 为了避免梯度消失,网络额外增加了2个辅助的softmax用于向前传导梯度(辅助分类器)。辅助分类器是将中间某一层的输出用作分类,并按一个较小的权重(0.3)加到最终分类结果中,这样相当于做了模型融合,同时给网络增加了反向传播的梯度信号,也提供了额外的正则化,对于整个网络的训练很有裨益。在实际测试时,这两个额外的softmax会被去掉。

论文

- 论文:Going Deeper with Convolutions

- 作者:Christian Szegedy、Wei Liu、Yangqing Jia、Pierre Sermanet、Scott Reed、Dragomir Anguelov、Dumitru Erhan、Vincent Vanhoucke、Andrew Rabinovich。谷歌、密歇根大学、北卡罗来纳大学

- 发表于:2015 年 IEEE 计算机视觉和模式识别会议 (CVPR)

5. Inception-v3 (2015)

Inception-v3 是 Inception-v1 的继承者,有24M个参数。Inception-v2是 v3 的早期原型,因此它与 v3 非常相似但不常用。当作者提出 Inception-v2 时,他们对其进行了许多实验,并记录了一些成功的调整。Inception-v3 是包含这些调整的网络(调整优化器、损失函数以及向辅助网络中的辅助层添加批量归一化)

Inception-v2 和 Inception-v3 的动机是避免 代表性瓶颈 representational bottlenecks (这意味着大幅减少下一层的输入维度)并通过使用因子分解方法进行更有效的计算。

注意:

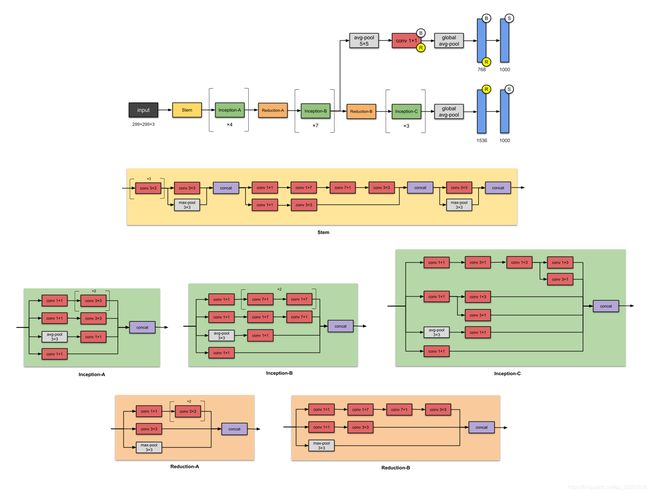

模块的名称(Stem,Inception-A,Inception-B等)直到其更高版本即Inception-v4和Inception-ResNets才用于此版本的Inception。

✨ 与之前的版本Inception-v1 相比有什么改进?

- 将

n×n卷积分解为非对称卷积:1×n和n×1卷积 - 将

5×5卷积分解为两个3×3卷积操作 - 将

7×7替换为一系列3×3的卷积 - 网络输入从

224x224变为了299x299

刊物

- 论文:Rethinking the Inception Architecture for Computer Vision

- 作者:Christian Szegedy、Vincent Vanhoucke、Sergey Ioffe、Jonathon Shlens、Zbigniew Wojna。谷歌,伦敦大学学院

- 发表于:2016 年 IEEE 计算机视觉和模式识别会议 (CVPR)

实战案例

- 深度学习100例 - 卷积神经网络(Inception V3)识别手语 | 第13天

6. ResNet-50 (2015)

从上面的几个 CNN 中,我们可以看到神经网络的层数越来越多,并获得了更好的性能。但是随着网络深度的增加,准确度会逐渐饱和然后迅速下降。微软研究院的人用 ResNet 解决了这个问题——使用跳过连接(又名快捷连接,残差),同时构建更深层次的模型。

ResNet 是批标准化的早期采用者之一(由 Ioffe 和 Szegedy 撰写的批规范论文于 2015 年提交给 ICML)。上图是 ResNet-50,有26M参数。

论文

- 论文:Deep Residual Learning for Image Recognition

- 作者:Kaiming He, Xiangyu Zhang, Shaoqing Ren, Jian Sun. Microsoft

- 发表于:2016 年 IEEE 计算机视觉和模式识别会议 (CVPR)

实战案例

- 深度学习100例 -卷积神经网络(ResNet-50)鸟类识别 | 第8天

7. Xception (2016)

Xception 是由 Inception 改进而来,其中 Inception 模块已替换为深度可分离卷积。它的参数数量也与 Inception-v1 ( 23M )大致相同。

- 首先,跨通道(或跨特征图)相关性由 1×1 卷积捕获。

- 因此,通过常规的 3×3 或 5×5 卷积捕获每个通道内的空间相关性。

将这个想法发挥到极致意味着对每个通道执行 1×1 ,然后对每个输出执行 3×3 。这与用深度可分离卷积替换 Inception 模块相同。

论文

- 论文:Xception: Deep Learning with Depthwise Separable Convolutions

- 作者:François Chollet. Google.

- 发表于:2017 IEEE 计算机视觉与模式识别会议 (CVPR)

实战案例

- 深度学习100例 | 第24天-卷积神经网络(Xception):动物识别

8. Inception-v4 (2016)

Inception-v4,参数量大小为43M,由谷歌在 Inception-v3 的基础上改进而来。主要区别在于 Stem 模块和 Inception-C 模块中的一些细微变化。

✨ 与之前的版本Inception-v3 相比有什么改进?

- Stem 模块的变化。

- 添加更多 Inception 模块。

- 对每个模块使用了相同数量的过滤器。

论文

- 论文:Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning

- 作者:Christian Szegedy, Sergey Ioffe, Vincent Vanhoucke, Alex Alemi. Google.

- 发表于: 第三十届 AAAI 人工智能会议论文集

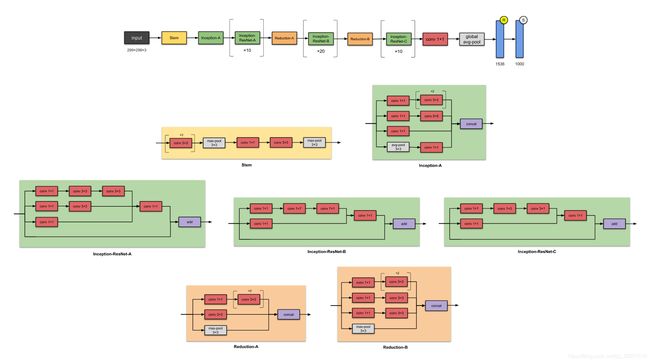

9. Inception-ResNet-V2 (2016)

在与Inception-v4相同的论文中,同一作者还介绍了Inception-ResNets系列Inception-ResNet-v1和Inception-ResNet-v2。

✨ 与之前的版本Inception-v3 相比有什么改进?

- 将 Inception 模块转换为Residual Inception 块。

- 添加更多 Inception 模块。

- 在 Stem 模块之后添加了一种新型的 Inception 模块(Inception-A)。

论文

- 论文:Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning

- 作者:Christian Szegedy, Sergey Ioffe, Vincent Vanhoucke, Alex Alemi. Google

- 发表于: 第三十届 AAAI 人工智能会议论文集

实战案例

- 深度学习100例-卷积神经网络(Inception-ResNet-v2)识别交通标志 | 第14天

10. ResNeXt-50 (2017)

ResNeXt-50是一个用于图像分类的简单、高度模块化的网络结构。

作者提出 ResNeXt-50 的主要原因在于:传统的要提高模型的准确率,都是加深或加宽网络,但是随着超参数数量的增加(比如channels数,filter size等等),网络设计的难度和计算开销也会增加。因此本文提出的 ResNeXt-50 结构可以在不增加参数复杂度的前提下提高准确率,同时还减少了超参数的数量。

论文

- 论文:Aggregated Residual Transformations for Deep Neural Networks

- 作者:Saining Xie, Ross Girshick, Piotr Dollár, Zhuowen Tu, Kaiming He. University of California San Diego, Facebook Research

- 发表于:2017 IEEE 计算机视觉与模式识别会议 (CVPR)

11. RegNet(2020)

⭐️ 简介

2020年以来,NAS(Neural Architecture Search) 网络搜索技术非常火,但这对计算资源要求也比较高(都是大厂玩的东西)。包括这篇论文中的RegNet也有使用到NAS技术。但在论文中作者一再强调这篇论文与之前的一些NAS论文不同(例如MobileNetv3,EfficientNet),之前的一些有关NAS的论文都是在给定的设计空间(designed search space)中通过搜索算法去搜索出一组最佳参数组合。但在这篇论文中作者要探究的是如何去设计设计空间(design design spaces)并发现一些网络的通用设计准则(network design principles),而不是仅仅去搜索出一组参数。

网络特点

- RegNet 比 RestNet 在小计算量情况下表现好

- RegNet 比 EfficientNet 在大计算时情况下表现好

论文

- Designing Network Design Spaces

官方代码

- https://github.com/facebookresearch/pycls

12. ConvNeXt(2022)

⭐️ 简介

ConvNeXt 靠卷积结构便达到了ImageNet Top-1的准确率,并没有特别复杂或者创新的结构,它的每一个网络细节都是已经在不止一个网络中被采用。而就是靠这些边角料的互相配合。

它的形式思路:Transformer或者Swin-Transformer怎么做,我也对应的调整,效果好就保留。当然这些边角料的摸索也是需要大量的实验数据支撑的,是一个耗时耗力耗资源的过程。

ConvNeXt提供了多个参数尺度的模型,他们的参数结构和在ImageNet-1K的Top-1的准确率如下表所示。

论文

- A ConvNet for the 2020s

官方代码

- https://github.com/facebookresearch/ConvNeXt

![]()

本文所提到的模型,你可以在下面的链接中找到调用方式

- https://pytorch.org/vision/stable/models.html

- https://www.tensorflow.org/api_docs/python/tf/keras/applications