Docker网络模式及配置(高级网络功能)

目录

一.Docker网络模式与参数配置

Docker网络模式

1.Bridge桥接模式

2.Host 网络模式:

3.Container 网络模式:

4.None 网络模式:

Docker网络相关的命令参数

二.配置容器DNS和主机名

1.相关配置文件

2.容器内修改配置文件

3.通过参数指定

三.容器与外界通信访问控制

1.容器访问外部实现

2.外部访问容器实现

映射所有接口地址

映射到指定地址的指定端口

映射到指定地址的任意端口

查看映射端口配置

3.容器之间的访问

四.配置docker0网桥

自定义网桥

五.Docker跨主机网络访问实现

使用OpenvSwitch网桥

1.环境

2.安装Docker

3.安装OpenvSwitch

4.配置容器连接到OpenvSwitch网桥

一.Docker网络模式与参数配置

docker容器的四种网络模式:bridge 桥接模式、host 模式、container 模式和 none 模式。启动容器时可以使用 –net 参数指定,默认是桥接模式。

-

Docker网络模式

1.Bridge桥接模式

Docker启动时会在主机上自动创建一个docker0虚拟网桥,实际上是一个Linux网桥,可以理解为一个软件交换机,它会在挂载其上的接口之间进行转发。

同时,Docker随机分配一个本地未占用的私有网段(在RFC1918中定义)中的一个地址给docker0接口。比如典型的172.17.42.1,掩码为255.255.0.0。此后启动的容器内的网口也会自动分配一个同一网段(172.17.0.0/16)的地址。

docker run -it --name vm3 ubuntu当创建一个容器的时候,docker和宿主机的通信原理如下:

(1) Docker Daemon 利用 veth pair 技术,在宿主机上创建两个虚拟网络接口设备,假设为 veth0 和 veth1。而 veth pair 技术的特性可以保证无论哪一个 veth 接收到网络报文,都会将 报文传输给另一方。

(2) Docker Daemon 将 veth0 附加到 Docker Daemon 创建的 docker0 网桥上。保证宿主机的网络报文可以发往 veth0;

(3) Docker Daemon 将 veth1 添加到 Docker Container 所属的 namespace 下,并被改名为 eth0。

如此一来,保证宿主机的网络报文若发往 veth0,则立即会被 eth0 接收,实现宿主机到Docker Container 网络的联通性;同时,也保证 Docker Container 单独使用 eth0,实现容器网络环境的隔离性。

bridge 桥接模式下的 Docker Container 在使用时,并非为开发者包办了一切。最明显的是, 该模式下 Docker Container 不具有一个公有 IP,即和宿主机的 eth0 不处于同一个网段。

导致的结果是宿主机以外的世界不能直接和容器进行通信。虽然 NAT 模式经过中间处理实现了这一点,但是 NAT 模式仍然存在问题与不便,如:容器均需要在宿主机上竞争端口,容器内部服务的访问者需要使用服务发现获知服务的外部端口等。另外 NAT 模式由于是在三层网络上的实现手段,故肯定会影响网络的传输效率。

2.Host 网络模式:

host 模式是 bridge 桥接模式很好的补充。采用 host 模式的 Docker Container,可以直接使用 宿主机的 IP 地址与外界进行通信,若宿主机的 eth0 是一个公有 IP,那么容器也拥有这个公有 IP。

同时容器内服务的端口也可以使用宿主机的端口,无需额外进行 NAT 转换。当然,有这样的方便,肯定会损失部分其他的特性,最明显的是 Docker Container 网络环境隔离性的弱化,即容器不再拥有隔离、独立的网络栈。

另外,使用 host 模式的 Docker Container 虽然可以让容器内部的服务和传统情况无差别、无改造的使用,但是由于网络隔离性的弱化,该容器会与宿主机共享竞争网络栈的使用;另外,容器内部将不再拥有所有的端口资源,原因是部分端口资源已经被宿主机本身的服务占用,还有部分端口已经用以 bridge 网络模式容器的端口映射。

docker run -it --name vm3 --net host ubuntu3.Container 网络模式:

(1) 查找 other container(即需要被共享网络环境的容器)的网络 namespace;

(2) 将新创建的 Docker Container(也是需要共享其他网络的容器)的 namespace,使用

other container 的 namespace。

Docker Container 的 other container 网络模式,可以用来更好的服务于容器间的通信。

在这种模式下的 Docker Container 可以通过 localhost 来访问 namespace 下的其他容器,传输

效率较高。虽然多个容器共享网络环境,但是多个容器形成的整体依然与宿主机以及其他

容器形成网络隔离。另外,这种模式还节约了一定数量的网络资源。但是需要注意的是,

它并没有改善容器与宿主机以外世界通信的情况。

docker run -it --name vm4 --net container:vm1 ubuntu

4.None 网络模式:

网络环境为 none,即不为 Docker Container 任何的网络环境。一旦 Docker Container 采用了none 网络模式,那么容器内部就只能使用 loopback 网络设备,不会再有其他的网络资源。可以说 none 模式为 Docker Container 做了极少的网络设定,但在没有网络配置的情况下,作为 Docker 开发者,才能在这基础做其他无限多可能的网络定制开发。这也恰巧体现了 Docker 设计理念的开放。

在 none 网络模式下分配固定 ip:

netns 是在 linux 中提供网络虚拟化的一个项目,使用 netns 网络空间虚拟化可以在本地虚拟化出多个网络环境,目前 netns 在 lxc 容器中被用来为容器提供网络。

使用 netns 创建的网络空间独立于当前系统的网络空间,其中的网络设备以及 iptables 规则等都是独立的,就好像进入了另外一个网络一样。

docker run -it --name vm5 --net none ubuntu

-

创建一个点到点连接(none模式容器互通)

默认情况下,Docker会将所有容器连接到由docker0提供的虚拟子网中。用户有时候需要两个容器之间可以直连通信,而不用通过主机网桥进行桥接。

解决办法很简单:创建一对peer接口,分别放到两个容器中,配置成点到点链路类型即可。

下面这个过程我们将手动执行Docker配置容器网络的大部分步骤。

首先启动两个容器:

$ docker run -i -t --rm --net=none base /bin/bash

$ docker run -i -t --rm --net=none base /bin/bash找到进程号,然后创建网络命名空间的跟踪文件:

$ docker inspect -f '{{.State.Pid}}' 1f1f4c1f931a

2989

$ docker inspect -f '{{.State.Pid}}' 12e343489d2f

3004

$ sudo mkdir -p /var/run/netns

$ sudo ln -s /proc/2989/ns/net /var/run/netns/2989

$ sudo ln -s /proc/3004/ns/net /var/run/netns/3004创建一对peer接口。

$ sudo ip link add A type veth peer name B添加IP地址和路由信息:

$ sudo ip link set A netns 2989

$ sudo ip netns exec 2989 ip addr add 10.1.1.1/32 dev A

$ sudo ip netns exec 2989 ip link set A up

$ sudo ip netns exec 2989 ip route add 10.1.1.2/32 dev A

$ sudo ip link set B netns 3004

$ sudo ip netns exec 3004 ip addr add 10.1.1.2/32 dev B

$ sudo ip netns exec 3004 ip link set B up

$ sudo ip netns exec 3004 ip route add 10.1.1.1/32 dev B现在这两个容器就可以相互ping通,并成功建立连接。点到点链路不需要子网和子网掩码。

此外,也可以不指定--net=none来创建点到点链路。这样容器还可以通过原先的网络来通信。

利用类似的办法,可以创建一个只跟主机通信的容器。但是一般情况下,更推荐使用--icc=false来关闭容器之间的通信。

-

Docker网络相关的命令参数

其中有些命令选项只有在Docker服务启动的时候才能配置,而且不能马上生效:

- -b BRIDGE or--bridge=BRIDGE——指定容器挂载的网桥;

- --bip=CIDR——定制docker0的掩码;

- -H SOCKET...or--host=SOCKET...——Docker服务端接收命令的通道;

- --icc=true|false——是否支持容器之间进行通信;

- --ip-forward=true|false——启用net.ipv4.ip_forward,即打开转发功能;

- --iptables=true|false——禁止Docker添加iptables规则;

- --mtu=BYTES——容器网络中的MTU。

下面2个命令选项既可以在启动服务时指定,也可以Docker容器启动(docker run)时候指定。在Docker服务启动的时候指定则会成为默认值,后续执行docker run时可以覆盖设置的默认值。

- --dns=IP_ADDRESS...——使用指定的DNS服务器;

- --dns-search=DOMAIN...——指定DNS搜索域。

最后这些选项只能在docker run执行时使用,因为它是针对容器的特性内容:

- -h HOSTNAME or--hostname=HOSTNAME——配置容器主机名;

- --link=CONTAINER_NAME:ALIAS——添加到另一个容器的连接;

- --net=bridge|none|container:NAME_or_ID|host|user_defined_network——配置容器的桥接模式;

- -p SPEC or--publish=SPEC——映射容器端口到宿主主机;

- -P or--publish-all=true|false——映射容器所有端口到宿主主机。

其中,--net选项支持五种模式,如下所示:

- --net=bridge——默认配置。为容器创建独立的网络命名空间,分配网卡、IP地址等网络配置,并通过veth接口对将容器挂载到一个虚拟网桥(默认为docker0)上;

- --net=none——为容器创建独立的网络命名空间,但不进行网络配置,即容器内没有创建网卡、IP地址等;

- --net=container:NAME_or_ID——意味着新创建的容器共享指定的已存在容器的网络命名空间,两个容器内的网络配置共享,但其他资源(进程空间、文件系统等)还是相互隔离的;

- --net=host——意味着不为容器创建独立的网络命名空间,容器内看到的网络配置(网卡信息、路由表、Iptables规则等)均与主机上保持一致。注意其他资源还是与主机隔离的;

- --net=user_defined_network——用户自行用network相关命令创建一个网络,同一个网络内的容器彼此可见,可以采用更多类型的网络插件。

二.配置容器DNS和主机名

Docker支持自定义容器的主机名和DNS配置。

1.相关配置文件

实际上,容器中主机名和DNS配置信息都是通过三个系统配置文件来维护的:/etc/resolv.conf、/etc/hostname和/etc/hosts。

启动一个容器,在容器中使用mount命令可以看到这三个文件挂载信息:

$ docker run -it ubuntu

root@75dbd6685305:/# mount/etc/resolv.conf文件在创建容器时候,默认会与宿主机/etc/resolv.conf文件内容保持一致:

root@75dbd6685305:/# cat /etc/resolv.conf/etc/hosts文件中默认只记录了容器自身的一些地址和名称:

root@75dbd6685305:/# cat /etc/hosts/etc/hostname文件则记录了容器的主机名。

root@75dbd6685305:/# cat /etc/hostname2.容器内修改配置文件

Docker 1.2.0开始支持在运行中的容器里直接编辑/etc/hosts,/etc/hostname和/etc/resolve.conf文件。

但是这些修改是临时的,只在运行的容器中保留,容器终止或重启后并不会被保存下来。也不会被docker commit提交。

3.通过参数指定

如果用户想要自定义容器的配置,可以在创建或启动容器时利用下面的参数指定:

- 指定主机名-h HOSTNAME或者--hostname=HOSTNAME。设定容器的主机名,它会被写到容器内的/etc/hostname和/etc/hosts。但这个主机名只有容器内能看到,在容器外部则看不到,既不会在docker ps中显示,也不会在其他的容器的/etc/hosts看到。

- 记录其他容器主机名--link=CONTAINER_NAME:ALIAS。选项会在创建容器的时候,添加一个所连接容器的主机名到容器内/etc/hosts文件中。这样,新创建容器可以直接使用主机名来与所连接容器通信。

- 指定DNS服务器--dns=IP_ADDRESS。添加DNS服务器到容器的/etc/resolv.conf中,容器会用指定的服务器来解析所有不在/etc/hosts中的主机名。

- 指定DNS搜索域--dns-search=DOMAIN。设定容器的搜索域,当设定搜索域为.example.com时,在搜索一个名为host的主机时,DNS不仅搜索host,还会搜索host.example.com。

三.容器与外界通信访问控制

容器的访问控制主要通过Linux上的iptables防火墙软件来进行管理和实现。iptables是Linux系统流行的防火墙软件,在大部分发行版中都自带。

1.容器访问外部实现

我们知道容器默认指定了网关为docker0网桥上的docker0内部接口。docker0内部接口同时也是宿主机的一个本地接口。因此,容器默认情况下是可以访问到宿主机本地的。更进一步,容器要想通过宿主机访问到外部网络,需要宿主机进行转发。

在宿主机Linux系统中,检查转发是否打开:

$ sudo sysctl net.ipv4.ip_forward如果为0,说明没有开启转发,则需要手动打开:

$ sudo sysctl -w net.ipv4.ip_forward=1更简单的,在启动Docker服务的时候设定--ip-forward=true,Docker服务会自动打开宿主机系统的转发服务。

假设容器内部的网络地址为172.17.0.2,本地网络地址为10.0.2.15。容器要能访问外部网络,源地址不能为172.17.0.2,需要进行源地址映射(Source NAT,SNAT),修改为本地系统的IP地址10.0.2.15。映射是通过iptables的源地址伪装操作实现的。

查看主机nat表上POSTROUTING链的规则。该链负责网包要离开主机前,改写其源地址。

$ sudo iptables -t nat -nvL POSTROUTINGChain POSTROUTING (policy ACCEPT 12 packets, 738 bytes)

pkts bytes target prot opt in out source destination

0 0 MASQUERADE all -- * !docker0 172.17.0.0/16 0.0.0.0/0

...其中,上述规则将所有源地址在172.17.0.0/16网段,且不是从docker0接口发出的数据包(即从容器中出来的数据包),动态伪装为从系统网卡(本机IP地址)发出。MASQUERADE行动跟传统SNAT行动相比,好处是它能从网卡动态获取地址。

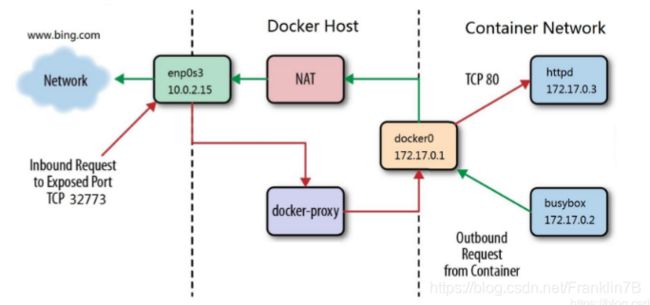

2.外部访问容器实现

容器中可以运行一些网络应用,要让外部也可以访问这些应用,可以通过 -P 或 -p 参数来指定端口映射。

当使用 -P 标记时,Docker 会随机映射一个 49000~49900 的端口到内部容器开放的网络端口。使用 docker container ls 可以看到,本地主机的 49155 被映射到了容器的 5000 端口。此时访问本机的 49155 端口即可访问容器内 web 应用提供的界面。

$ docker run -d -P training/webapp python app.py

$ docker ps -l

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS

NAMES

bc533791f3f5 training/webapp:latest python app.py 5 seconds ago Up 2 seconds 0.0.0

.0:49155->5000/tcp nostalgic_morse- 外网访问容器用到了docker-proxy和iptables DNAT

- 宿主机访问本机容器使用的是iptables DNAT

- 外部主机访问容器或容器之间的访问是docker-proxy实现

同样的,可以通过 docker logs 命令来查看应用的信息。

$ docker logs -f nostalgic_morse

* Running on http://0.0.0.0:5000/

10.0.2.2 - - [23/May/2014 20:16:31] "GET / HTTP/1.1" 200 -

10.0.2.2 - - [23/May/2014 20:16:31] "GET /favicon.ico HTTP/1.1" 404 -

-p 则可以指定要映射的端口,并且,在一个指定端口上只可以绑定一个容器。支持的格式有 :

ip : hostPort : containerPort | ip :: containerPort | hostPort : containerPort

-

映射所有接口地址

使用 hostPort:containerPort 格式本地的 5000 端口映射到容器的 5000 端口,可以执行

$ docker run -d -p 5000:5000 training/webapp python app.py

此时默认会绑定本地所有接口上的所有地址。

-

映射到指定地址的指定端口

可以使用 ip:hostPort:containerPort 格式指定映射使用一个特定地址,比如 localhost 地址 127.0.0.1

$ docker run -d -p 127.0.0.1:5000:5000 training/webapp python app.py

-

映射到指定地址的任意端口

使用 ip::containerPort 绑定 localhost 的任意端口到容器的 5000 端口,本地主机会自动分

配一个端口。

$ docker run -d -p 127.0.0.1::5000 training/webapp python app.py

还可以使用 udp 标记来指定 udp 端口

$ docker run -d -p 127.0.0.1:5000:5000/udp training/webapp python app.py

-

查看映射端口配置

使用 docker port 来查看当前映射的端口配置,也可以查看到绑定的地址

$ docker port nostalgic_morse 5000

127.0.0.1:49155.

注意:

- 容器有自己的内部网络和 ip 地址(使用 docker inspect 可以获取所有的变量,Docker还可以有一个可变的网络配置。)

- -p 标记可以多次使用来绑定多个端口

例如

$ docker run -d \

-p 5000:5000 \

-p 3000:80 \

training/webapp \

python app.py3.容器之间的访问

容器之间相互访问,需要两方面的支持:

- 网络拓扑是否已经连通。默认情况下,所有容器都会连接到docker0网桥上,这意味着默认情况下拓扑是互通的;

- 本地系统的防火墙软件iptables是否允许访问通过。这取决于防火墙的默认规则是允许(大部分情况)还是禁止。

下面分两种情况介绍容器之间的访问。

(1)访问所有端口

当启动Docker服务时候,默认会添加一条“允许”转发策略到iptables的FORWARD链上。通过配置--icc=true|false(默认值为true)参数可以控制默认的策略。

为了安全考虑,可以在Docker配置文件中配置DOCKER_OPTS=--icc=false来默认禁止容器之间的相互访问。

同时,如果启动Docker服务时手动指定--iptables=false参数则不会修改宿主机系统上的iptables规则。

(2)访问指定端口

在通过-icc=false禁止容器间相互访问后,仍可以通过--link=CONTAINER_NAME:ALIAS选项来允许访问指定容器的开放端口。

例如,在启动Docker服务时,可以同时使用icc=false--iptables=true参数来配置容器间禁止访问,并允许Docker自动修改系统中的iptables规则。

此时,系统中的iptables规则可能是类似如下规则,禁止所有转发流量:

$ sudo iptables -nL...

Chain FORWARD (policy ACCEPT)

target prot opt source destination

DROP all -- 0.0.0.0/0 0.0.0.0/0

...之后,启动容器(docker run)时使用--link=CONTAINER_NAME:ALIAS选项。Docker会在iptable中为两个互联容器分别添加一条ACCEPT规则,允许相互访问开放的端口(取决于Dockerfile中的EXPOSE行)。

此时,iptables的规则可能是类似如下规则:

$ sudo iptables -nL...

Chain FORWARD (policy ACCEPT)

target prot opt source destination

ACCEPT tcp -- 172.17.0.2 172.17.0.3 tcp spt:80

ACCEPT tcp -- 172.17.0.3 172.17.0.2 tcp dpt:80

DROP all -- 0.0.0.0/0 0.0.0.0/0--link=CONTAINER_NAME:ALIAS中的CONTAINER_NAME目前必须是Docker自动分配的容器名,或使用--name参数指定的名字。不能为容器-h参数配置的主机名。

映射容器端口到宿主主机的实现

默认情况下,容器可以主动访问到外部网络的连接,但是外部网络无法访问到容器。

四.配置docker0网桥

Docker服务默认会创建一个名称为docker0的Linux网桥(其上有一个docker0内部接口),它在内核层连通了其他的物理或虚拟网卡,这就将所有容器和本地主机都放到同一个物理网络。用户使用Docker创建多个自定义网络时可能会出现多个容器网桥。

Docker默认指定了docker0接口的IP地址和子网掩码,让主机和容器之间可以通过网桥相互通信,它还给出了MTU(接口允许接收的最大传输单元),通常是1500字节,或宿主主机网络路由上支持的默认值。这些值都可以在服务启动的时候进行配置:

- --bip=CIDR——IP地址加掩码格式,例如192.168.1.5/24;

- --mtu=BYTES——覆盖默认的Docker mtu配置。

也可以在配置文件中配置DOCKER_OPTS,然后重启服务。

由于目前Docker网桥是Linux网桥,用户可以使用brctl show来查看网桥和端口连接信息:

$ sudo brctl showbridge name bridge id STP enabled interfaces

docker0 8000.3a1d7362b4ee no veth65f9 vethdda6brctl命令如果系统中没有自带,可以使用sudo apt-get install bridge-utils来安装(Debian、Ubuntu系列系统)。

每次创建一个新容器的时候,Docker从可用的地址段中选择一个空闲的IP地址分配给容器的eth0端口。并且使用本地主机上docker0接口的IP作为容器的默认网关:

$ docker run -i -t --rm base /bin/bash

$ ip addr show eth0

24: eth0: mtu 1500 qdisc pfifo_fast state UP group

default qlen 1000

link/ether 32:6f:e0:35:57:91 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.3/16 scope global eth0

valid_lft forever preferred_lft forever

inet6 fe80::306f:e0ff:fe35:5791/64 scope link

valid_lft forever preferred_lft forever

$ ip routedefault via 172.17.42.1 dev eth0

172.17.0.0/16 dev eth0 proto kernel scope link src 172.17.0.3$ exit目前,Docker不支持在启动容器时候指定IP地址。实际上,Linux网桥自身功能已经十分完备,也可以替换为OpenvSwitch等功能更强大的网桥实现。

自定义网桥

除了默认的docker0网桥,用户也可以指定网桥来连接各个容器。

在启动Docker服务的时候,使用-b BRIDGE或--bridge=BRIDGE来指定使用的网桥。

如果服务已经运行,那需要先停止服务,并删除旧的网桥:

$ sudo service docker stop

$ sudo ip link set dev docker0 down

$ sudo brctl delbr docker0然后创建一个网桥bridge0:

$ sudo brctl addbr bridge0

$ sudo ip addr add 192.168.5.1/24 dev bridge0

$ sudo ip link set dev bridge0 up查看确认网桥创建并启动:

$ ip addr show bridge04: bridge0: mtu 1500 qdisc noop state UP group default

link/ether 66:38:d0:0d:76:18 brd ff:ff:ff:ff:ff:ff

inet 192.168.5.1/24 scope global bridge0

valid_lft forever preferred_lft forever 配置Docker服务,默认桥接到创建的网桥上:

$ echo 'DOCKER_OPTS="-b=bridge0"' >> /etc/default/docker

$ sudo service docker start启动Docker服务。新建一个容器,可以看到它已经桥接到了bridge0上。

可以继续用brctl show命令查看桥接的信息。另外,在容器中可以使用ip addr和ip route命令来查看IP地址配置和路由信息。

五.Docker跨主机网络访问实现

使用OpenvSwitch网桥

Docker默认使用的是Linux自带的网桥实现,实际上,OpenvSwitch项目作为一个成熟的虚拟交换机实现,具备更丰富的功能。将来会有越来越多的容器支持OpenvSwitch作为底层网桥实现。

1.环境

在Ubuntu 14.04系统中进行测试。操作流程也适用于RedHat/CentOS系列系统,但少数命令和配置文件可能略有差异。

2.安装Docker

安装最近版本的Docker并启动服务。默认情况下,Docker服务会创建一个名为docker0的Linux网桥,作为连接容器的本地网桥。

可以通过如下命令查看:

$ sudo brctl showbridge name bridge id STP enabled interfaces

docker0 8000.000000000000 no网桥docker0内部接口的默认地址可能为172.17.42.1。

$ ifconfig docker0

docker0 Link encap:Ethernet HWaddr 56:84:7a:fe:97:99

inet addr:172.17.42.1 Bcast:0.0.0.0 Mask:255.255.0.0

BROADCAST MULTICAST MTU:1500 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:0 (0.0 B) TX bytes:0 (0.0 B)

3.安装OpenvSwitch

通过如下命令安装OpenvSwitch:

$ sudo aptitude install openvswitch-switch测试添加一个网桥br0并查看:

$ sudo ovs-vsctl add-br br0

$ sudo ovs-vsctl show4.配置容器连接到OpenvSwitch网桥

目前OpenvSwitch网桥还不能直接支持挂载容器,需要手动在OpenvSwitch网桥上创建虚拟网口并挂载到容器中。

(1)创建无网口容器

启动一个ubuntu容器,并指定不创建网络,后面我们手动添加网络。较新版本的Docker默认不允许在容器内修改网络配置,需要在run的时候指定参数--privileged=true:

$ docker run --net=none --privileged=true -it ubuntu:14.04 bash

root@298bbb17c244:/#记住这里容器的id为298bbb17c244。

此时在容器内查看网络信息,只能看到一个本地网卡lo:

root@298bbb17c244:/# ifconfig

lo Link encap:Local Loopback

inet addr:127.0.0.1 Mask:255.0.0.0

inet6 addr: ::1/128 Scope:Host

UP LOOPBACK RUNNING MTU:65536 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:0 (0.0 B) TX bytes:0 (0.0 B)

(2)手动为容器添加网络

下载OpenvSwitch项目提供的支持Docker容器的辅助脚本ovs-docker:

$ wget https://github.com/openvswitch/ovs/raw/master/utilities/ovs-docker

$ sudo chmod a+x ovs-docker为容器添加网卡,并挂载到br0上,命令为:

$ sudo ./ovs-docker add-port br0 eth0 298bbb17c244 --ipaddress=172.17.0.2/16添加成功后,在容器内查看网络信息,多了一个新添加的网卡eth0,对应添加的IP地址:

root@298bbb17c244:/# ifconfig

eth0 Link encap:Ethernet HWaddr ae:3d:75:2c:18:ba

inet addr:172.17.0.2 Bcast:172.17.255.255 Mask:255.255.0.0

inet6 addr: fe80::ac3d:75ff:fe2c:18ba/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:187 errors:0 dropped:2 overruns:0 frame:0

TX packets:11 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:33840 (33.8 KB) TX bytes:1170 (1.1 KB)

lo Link encap:Local Loopback

inet addr:127.0.0.1 Mask:255.0.0.0

inet6 addr: ::1/128 Scope:Host

UP LOOPBACK RUNNING MTU:65536 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:0 (0.0 B) TX bytes:0 (0.0 B)

在容器外,配置OpenvSwitch的网桥br0内部接口地址为172.17.42.2/16(只要与所挂载容器IP在同一个子网内即可):

$ sudo ifconfig br0 172.17.42.2/16(3)测试连通

经过上面步骤,容器已经连接到了网桥br0上了,拓扑如下所示:

容器(172.17.0.2/16)<-->br0

网桥<-->br0

内部端口(172.17.42.2/16)

此时,在容器内就可以测试是否连通到网桥br0上了:

root@298bbb17c244:/# ping 172.17.42.2在容器内也可以配置默认网关为br0接口地址:

root@298bbb17c244:/# route add default gw 172.17.42.2另外,删除该接口的命令为:

$ sudo ./ovs-docker del-port br0 eth0实际上,Docker社区也已经讨论对OpenvSwitch进行原生支持了。在Docker原生支持OpenvSwitch之前,用户可以通过编写脚本或更高级的工具来让这一过程自动化。