Python爬虫入门教程32:爬取boss直聘招聘数据并做可视化展示

前言

本文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,如有问题请及时联系我们以作处理。

前文内容

Python爬虫入门教程01:豆瓣Top电影爬取

Python爬虫入门教程02:小说爬取

Python爬虫入门教程03:二手房数据爬取

Python爬虫入门教程04:招聘信息爬取

Python爬虫入门教程05:B站视频弹幕的爬取

Python爬虫入门教程06:爬取数据后的词云图制作

Python爬虫入门教程07:腾讯视频弹幕爬取

Python爬虫入门教程08:爬取csdn文章保存成PDF

Python爬虫入门教程09:多线程爬取表情包图片

Python爬虫入门教程10:彼岸壁纸爬取

Python爬虫入门教程11:新版王者荣耀皮肤图片的爬取

Python爬虫入门教程12:英雄联盟皮肤图片的爬取

Python爬虫入门教程13:高质量电脑桌面壁纸爬取

Python爬虫入门教程14:有声书音频爬取

Python爬虫入门教程15:音乐网站数据的爬取

Python爬虫入门教程17:音乐歌曲的爬取

Python爬虫入门教程18:好看视频的爬取

Python爬取入门教程19:YY短视频的爬取

Python爬虫入门教程20:IP代理的爬取使用

Python爬虫入门教程21:付费文档的爬取

Python爬虫入门教程22:百度翻译JS解密

Python爬虫入门教程23:A站视频的爬取,解密m3u8视频格式

Python爬虫入门教程24:下载某网站付费文档保存PDF

Python爬虫入门教程25:绕过JS加密参数,实现批量下载抖某音无水印视频内容

Python爬虫入门教程26:快手视频网站数据内容下载

Python爬虫入门教程27:爬取某电商平台数据内容并做数据可视化

Python爬虫入门教程28:爬取微博热搜榜并做动态数据展示

Python爬虫入门教程29:爬取某团烤肉店铺数据内容并做可视化展示

ython爬虫入门教程30:爬取拉勾网招聘数据信息

Python爬虫入门教程31:爬取猫咪交易网站数据并作数据分析

PS:如有需要 Python学习资料 以及 解答 的小伙伴可以加点击下方链接自行获取

python免费学习资料以及群交流解答点击即可加入

基本开发环境

- Python 3.8

- Pycharm

相关模块的使用

from selenium import webdriver

import csv

安装Python并添加到环境变量,pip安装需要的相关模块即可。

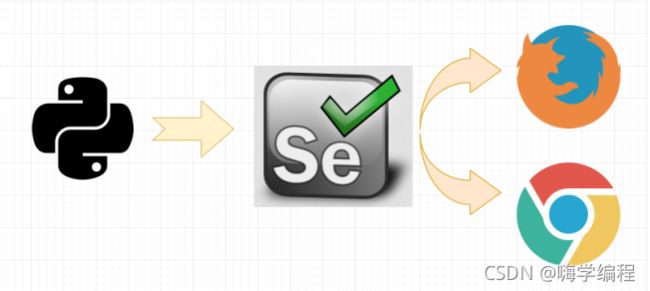

如图所示,通过 Python 来控制 Selenium,然后让 Selenium 控制浏览器,操纵浏览器,这样就实现了使用Python 间接的操控浏览器。

Selenium具体怎么就能操纵浏览器呢?这要归功于 浏览器驱动 ,Selenium可以通过API接口实现和浏览器驱动的交互,进而实现和浏览器的交互。所以要配置浏览器驱动。

本教材使用版本:

火狐驱动:geckodriver 0.23.0 ( 2018-10-04)

火狐驱动下载地址: http://npm.taobao.org/mirrors/geckodriver/

谷歌驱动:ChromeDriver 71.0.3578.33

谷歌驱动下载地址:

https://npm.taobao.org/mirrors/chromedriver/

http://chromedriver.storage.googleapis.com/index.html

配置浏览器驱动:

将下载好的浏览器驱动解压,将解压出的 exe 文件放到Python的安装目录下,也就是和python.exe同目录即可。

代码实现

from selenium import webdriver

import csv

f = open('data.csv', mode='a', encoding='utf-8', newline='')

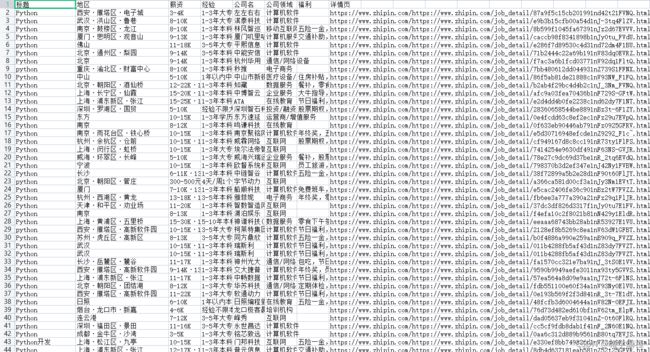

csv_writer = csv.DictWriter(f, fieldnames=[

'标题',

'地区',

'薪资',

'经验',

'公司名',

'公司领域',

'福利',

'详情页',

])

csv_writer.writeheader()

driver = webdriver.Chrome()

driver.get('https://www.zhipin.com/job_detail/?query=python&city=100010000&industry=&position=')

driver.implicitly_wait(10)

def get_job_info():

lis = driver.find_elements_by_css_selector('.job-list li')

for li in lis:

# 标题

title = li.find_element_by_css_selector('.job-name a').get_attribute('title')

# 地区

area = li.find_element_by_css_selector('.job-area').text

# 薪资

money = li.find_element_by_css_selector('.job-limit .red').text

# 经验

limit = li.find_element_by_css_selector('.job-limit p').text

# exp = limit[0].text

company_name = li.find_element_by_css_selector('.company-text .name a').text

company_type = li.find_element_by_css_selector('.company-text p a').text

desc = li.find_element_by_css_selector('.info-append .info-desc').text

href = 'https://www.zhipin.com/' + li.find_element_by_css_selector('.job-name a').get_attribute('href')

print(title, area, money, limit, company_name, company_type, desc, sep='|')

dit = {

'标题': title,

'地区': area,

'薪资': money,

'经验': limit,

'公司名': company_name,

'公司领域': company_type,

'福利': desc,

'详情页': href,

}

csv_writer.writerow(dit)

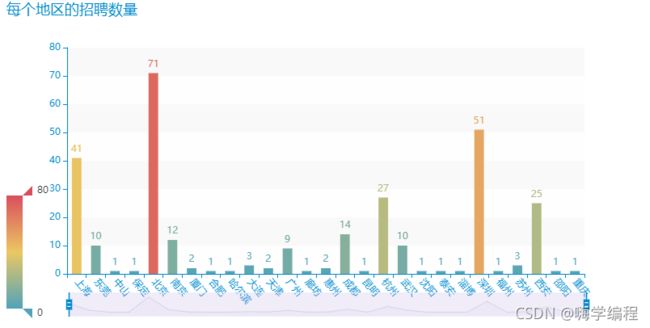

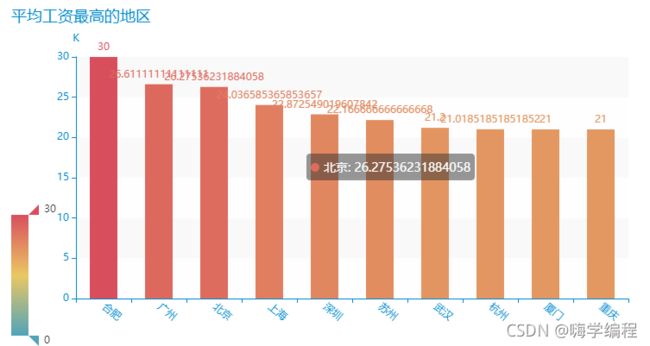

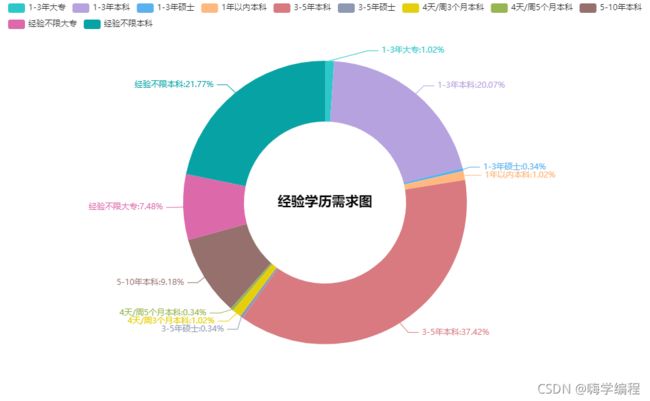

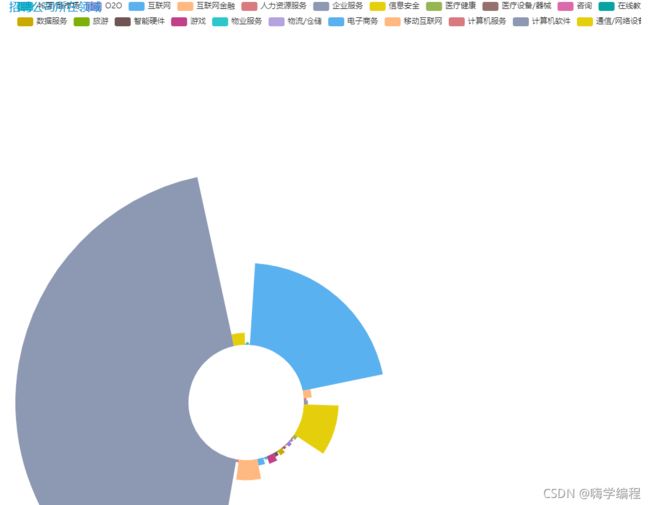

数据可视化

只是获取前10页的数据内容,总计是300条数据