AI模型风险评估 第1部分:动机

NIST人工智能风险评估框架 第1部分:动机

- 1.AI风险与谁有干系?

- 2.AI风险与可信AI的联系:

-

- (1)技术特征

-

- Accuracy

- Reliability

- Robustness

- Resilience or ML Security

- (2)社会技术特征:

-

- Explainability

- Interpretability

- Privacy

- Safety

- Managing bias

- 总结

- (3)指导原则

-

- Fairness

- Accountability

- Transparency

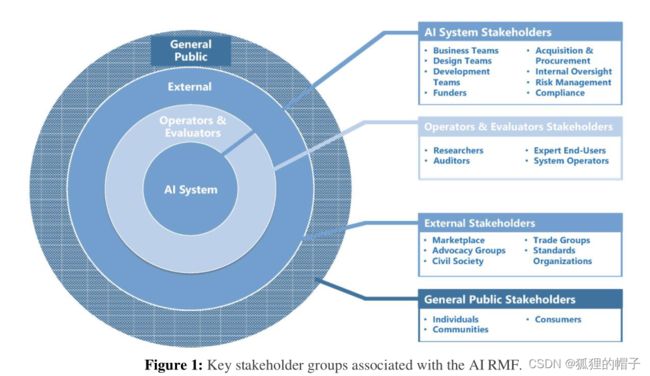

1.AI风险与谁有干系?

(1)AI系统利益相关者:对人工智能系统的设计、开发、部署和收购以及人工智能风险管理实践的实施拥有最多控制权和责任的人。

(2)运营者和评估者:对于技术和社会技术要求相关的系统性能的监测和正式/非正式测试、评估、验证和验证(TEVV)。可能是研究人员、审计员、评测人员、专家等。

(3)外部利益相关者:为指定和解决人工智能风险提供正式和/或准正式规范或指导。如标准制定组织、倡导团体和民间社会组织等。

(4)公众:公众最有可能直接体验AI 技术的正面和负面影响。它们可以为其他利益相关者采取的行动提供动机,包括开发或部署人工智能系统的个人、社区和消费者。

2.AI风险与可信AI的联系:

AI的可信度与风险是呈负相关的,因此提高可信度的方法有利于降低相对应的风险。AI风险管理框架使用图3所示的三类分类法,对识别和管理个人工智能系统相关风险的综合方法中应考虑的特征进行分类:技术特征、社会技术特征和指导原则。

(1)技术特征

人工智能RMF分类中的技术特征是指人工智能系统设计者和开发人员直接控制的因素,可以使用评估标准来衡量。技术特征包括收敛-判别效度(数据是否反映用户打算测量的内容,而不是其他事情)和统计可靠性(数据是否可能受到高水平统计噪声和测量偏差的影响)之间的权衡。人工智能的有效性,特别是机器学习(ML)模型,可以使用技术特征进行评估。部署的人工智能系统的有效性通常通过持续审计或监测来评估,以确认系统的行为符合预期。根据标准的统计或技术的变化,可以利用并自动执行显式测量,并在需求中指定阈值。从旨在评估系统性能的实验中生成的数据也属于这一类,可能包括因果假设的测试和对抗攻击鲁棒性评估。

Accuracy

精度表示ML模型正确捕捉训练数据中存在的关系的程度。与统计结论有效性类似,通过标准ML指标(例如假阳性率和假阴性率、F1分数、精度和召回率)以及模型欠拟合或过拟合的评估来检查准确性。确定与可接受风险相对应的准确度阈值对于人工智能风险管理至关重要,并且高度依赖于上下文。

Reliability

可靠性表示模型是否在可接受的统计误差范围内一致地生成相同的结果。设计用于缓解过度拟合(例如正则化)并在面临偏差/方差权衡时充分进行模型选择的技术可以提高模型的可靠性。可靠性指标可能提供与非文本化相关的风险的洞察,这是因为重复使用ML数据集或模型的常见做法会导致它们与社会环境及其创建的时间段脱节。与准确性一样,可靠性提供了对模型有效性的评估,因此可以作为确定可接受风险阈值的一个因素.

Robustness

稳健性是模型灵敏度的一种度量,表示模型是否对不可控因素的变化具有最低灵敏度。尽管其组件中存在故障,但鲁棒模型仍将继续工作。在纠正故障之前,模型的性能可能会降低或改变。稳健性度量的范围可能从模型输出的灵敏度到输入的微小变化,但也可能包括新数据集上的误差度量。稳健性有助于AI 风险管理过程中的敏感性分析。

Resilience or ML Security

能够承受对抗性攻击,或者更普遍地说,能够承受环境或使用中的意外变化的模型具有弹性或安全性。该属性与稳健性有一定关系,但它超越了数据的来源,涵盖了对模型或数据的意外或对抗性使用。其他常见的ML安全问题涉及通过AI系统端点对模型、训练数据或其他知识产权进行过滤。

(2)社会技术特征:

AI的RMF分类中的社会技术特征是指人工智能系统在个人、群体和社会环境中的使用和感知方式。

这包括模型的心理表征,提供的输出是否足以评估合规性(透明度),模型操作是否易于理解(可解释性),它们是否提供可用于做出有意义决策的输出(可解释性),以及输出是否与社会价值相一致。与技术特征不同,社会技术特征需要大量的人力投入,还不能通过自动化过程进行测量。在决定具体指标和这些指标的精确阈值时,必须采用人工判断。

事实上,在人工智能的整个生命周期中,需要来自广泛多样的利益相关者的输入,以确保在社会环境中产生的风险得到适当的管理。以下社会技术特征对解决人工智能风险具有影响:可解释性、可解释性、隐私、安全性和管理偏见。

Explainability

可解释性旨在为模型预测的生成提供程序性的、有时是因果性的描述。即使考虑到使模型完全透明所需的所有信息,如果人类想要了解模型的工作原理,也必须应用技术专业知识。可解释性是指用户对模型工作方式的感知,例如对于给定的输入,可能会有什么样的输出。解释技巧倾向于为技术受众总结或可视化模型行为或预测。解释有助于从机器学习中促进人类学习,解决透明度要求,或解决人工智能系统和训练数据的调试问题。然而,由于许多原因,可能会产生解释性风险,例如,解释方法缺乏保真度或一致性,或者万一人类错误地推断模型的操作,或者模型没有按预期操作。缺乏可解释性的风险可以通过描述模型如何工作到用户的技能水平来管理。可解释的系统可以更容易地调试和监控,有助于更彻底的文档、审计和治理。可解释性与透明度有关。通常,模型越不透明,其可解释性越低。然而,透明度并不能保证解释性,尤其是当用户缺乏对ML技术原理的理解时。

Interpretability

Interpretability旨在填补意义缺陷。尽管Interpretability和可解释性explainability经常互换使用,但可解释性是指算法操作背后的机制的表示,而**Interpretability是指其输出在其设计功能目的背景下的含义。**基本假设是,对风险的感知源于缺乏适当理解或语境化模型输出的能力。模型Interpretability是指用户能够确定遵守这一功能的程度,以及该输出对该用户其他重要决策的影响。Interpretability通常根据价值观进行语境化,并反映出简单的类别差异。例如,一个社会可能重视隐私和安全,但个人可能对安全阈值有不同的确定。Interpretability风险通常可以通过传达模型设计者的意图来解决,尽管这仍是一个开放的研究领域。使用心理测量工具可以很容易地测量不同解释的流行率。

Privacy

隐私通常指有助于维护人类自主和尊严等价值观的规范和做法。这些规范和实践通常涉及免受入侵、限制观察或个人对其身份各方面(例如身体、数据、声誉)的控制。人工智能系统的特定技术功能可能会促进隐私保护,评估人员可以确定数据处理如何会产生与隐私相关的问题。然而,对这些问题影响的可能性和严重性的确定是基于背景的,并且因文化和个人而异。

Safety

安全作为一个概念与风险高度相关,通常表示没有(或最小化)导致系统危险的故障或条件。例如,由于人工智能系统在工厂和道路上更直接地与人类交互,因此这些系统的安全性是人工智能风险管理的一个重要考虑因素。从法律角度来看,安全往往需要被考虑(尽管并非总是)。人工智能安全的实用方法通常涉及严格的模拟和域内测试、实时监控以及快速关闭或修改行为异常系统的能力。

Managing bias

NIST已经确定了人工智能中的三大类偏差:系统偏差、计算偏差和人为偏差。偏见以多种形式存在,在社会中无处不在,并可能在帮助我们做出生活决策的自动化系统中根深蒂固。虽然偏见并不总是一种消极现象,但人工智能模型和系统中表现出的某些偏见可能会持续并扩大对个人、组织和社会的负面影响,其速度和规模远远超过由隐含的人类或系统偏见导致的传统歧视做法。偏见与社会透明度和公平的概念密切相关。

总结

在管理人工智能系统中的风险时,重要的是要理解人工智能RMF风险分类的属性是相互关联的。高度安全但不公平的系统,准确但不透明且无法理解的系统,以及不准确但公平、安全、隐私保护且透明的系统都是不可取的。值得信赖的人工智能系统可以实现高度的风险控制,同时保持高水平的性能质量。实现这一困难目标需要一种全面的风险管理方法,在技术特征和社会技术特征之间进行权衡。

(3)指导原则

人工智能RMF分类法中的指导原则是指更广泛的社会规范和价值观,表示社会优先事项。虽然道德价值观没有客观标准,因为它们是以特定社会或文化的规范和法律期望为基础的,**但人们普遍认为,人工智能技术的开发和部署应符合相关规范和道德价值观。**当被指定为政策时,指导原则可以使人工智能利益相关者形成可操作的低级需求。一些要求将转化为绩效和有效性的定量指标,而一些要求可能仍然是定性的。与人工智能风险相关的指导原则包括公平、问责制和透明度。人工智能系统中的公平包括通过解决偏见和歧视等社会技术问题来关注平等和公平。个人操作员及其组织应对人工智能系统的结果负责,尤其是不利的结果。风险产生的影响。由于缺乏透明度,用户只能猜测这些因素,可能会对模型出处作出无根据和不可靠的假设。透明度通常对于与错误和不利人工智能系统输出相关的可采取行动的补救措施是必要的。

Fairness

公平标准可能很复杂,很难定义,因为不同文化对公平的看法不同。对于一种类型的公平性,即过程公平性,人工智能开发人员假设ML 算法本质上是公平的,因为无论用户如何,相同的过程都适用。然而,随着人们对有偏见的算法和有偏见的数据集的认识的增加,这种看法最近被削弱了。公平与有害制度的存在越来越相关,即使满足人口均等和其他公平措施,有时一个制度的危害仍存在。虽然公平性有许多技术定义,但公平性的确定通常不仅仅是一项技术活动。没有有害的偏见是公平的必要条件。

Accountability

在个人操作员及其组织应对人工智能系统的结果负责,尤其是风险产生的不利影响。与人工智能和技术系统相关的风险和责任之间的关系在文化、法律、部门和社会环境中更为广泛。将组织实践和治理减少伤害的结构(如风险管理)结合起来,可以帮助建立更负责任的系统。

Transparency

透明度旨在弥补人工智能系统运营商和人工智能系统消费者之间的常见信息不平衡。透明度反映了用户在与人工智能系统交互时可用信息的程度。**其范围从设计决策和训练数据到模型训练、模型的结构、其预期用例、如何和何时作出部署决策以及由谁作出等。**由于缺乏透明度,用户只能猜测这些因素,并且可能会对模型来源作出无据和不可靠的假设。透明度通常对于与错误和不利AI系统的输出相关的可采取行动的补救措施是必要的。透明系统不一定是公平、隐私保护、安全或健壮的系统。