一个网络两种用途!南开&哈工程提出TINet,通过细化纹理和边缘,在显著性目标检测和伪装目标检测上实现双SOTA!...

关注公众号,发现CV技术之美

本篇分享论文『Inferring Camouflaged Objects by Texture-Aware Interactive Guidance Network』,南开&哈工程提出TINet,通过细化纹理和边缘,在显著性目标检测和伪装目标检测上实现双SOTA!

详细信息如下:

论文地址:https://ojs.aaai.org/index.php/AAAI/article/view/16475

代码地址:未开源

01

摘要

类似于背景的伪装物体显示出无法定义的边界和欺骗性的纹理,这增加了检测任务的难度,并使模型依赖于具有更多信息的特征。在本文中,作者设计了一个纹理标签来促进本文的网络进行准确的伪装对象分割。

受纹理标签和伪装对象标签之间的互补关系的启发,作者提出了一种名为 TINet 的交互式引导框架,该框架专注于通过渐进式交互式引导来寻找无法定义的边界和纹理差异。它最大限度地提高了细化多级纹理线索对分割的引导效果。

具体而言,纹理感知解码器(TPD)对多尺度的纹理信息进行了综合分析。特征交互引导解码器(FGD)交互式地逐级细化伪装物体检测和纹理检测的多级特征。整体感知解码器(HPD)通过多层次的整体感知来增强 FGD 结果。

此外,作者提出了一个边界权重图,以帮助损失函数更加关注对象边界。在 COD 和 SOD 数据集上进行的充分实验表明,本文所提出的方法优于 23 种最先进的方法。

02

Motivation

显着对象检测 (SOD) 旨在估计视觉显着区域,而伪装对象检测 (COD) 旨在识别与其周围环境相似的隐藏对象,而伪装对象通常不易被发现。所以COD比SOD更容易出现严重的误判。

它们都可以用作许多图像理解和处理任务的初始步骤,例如图像编辑、图像检索、照片合成和目标跟踪。此外,COD研究将有助于医学影像、军事、农业和野生动物保护等领域的发展。示例包括肺炎分割、息肉分割、肿瘤分割、伪装敌人设施检测、埋地雷检测、蝗虫检测和稀有动物检测。

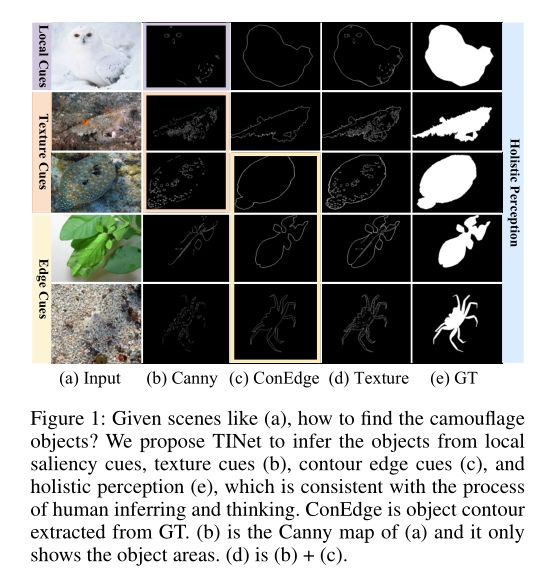

COD数据集中的大多数伪装物体都是动物,它们通常会调整身体的颜色以匹配周围环境或隐藏在接近其颜色的环境中以避免识别。伪装策略通过欺骗和误导观察者的视觉感知系统而起作用。如上图所示,可以通过尝试找到伪装对象并识别伪装对象的完整边界来感受该策略的效果。

显着物体对观察者的视觉感知系统有明显的刺激作用,可以瞬间识别。然而,伪装目标检测的过程是反欺骗的一个较长的思考过程,其中使用了更多类型的线索。例如,对于上图的第一行,首先找到猫头鹰的面部(局部显着性),然后按照这条线索确认整体轮廓。对于 2,3 行,当伪装物体的颜色是与环境相似的,边缘是模糊的,纹理特征(纹理线索)将是一个重要线索。

对于 4,5 行,目标的纹理具有欺骗性,几乎与背景相同,但相对清晰的边缘(边缘线索)和独特的形状有助于识别目标。此外,整体感知起着重要作用。受上述思想启发,作者改进了轮廓边缘标签,通过添加物体表面的详细信息来获得纹理标签,这有助于发现伪装物体的纹理与背景之间的差异。这里的纹理标签不仅仅代表纹理,它结合了多个线索:局部显着线索、纹理线索和边缘线索。

在本文中,作者提出的纹理感知交互式引导网络(TINet)侧重于多级纹理特征和多级分割特征的渐进式交互式引导。具体来说,TINet 具有三个解码器:纹理感知解码器(TPD)、特征交互引导解码器(FGD)和整体感知解码器(HPD)。TINet 是一个双任务模型。HPD 和 TPD 在各自的任务中相互补充。以分割任务为例,TPD对纹理信息进行了综合分析。FGD交互细化伪装物体检测和纹理检测的多层次特征,从底层到顶层逐级递进。FGD-T 和 FGD-S 是相互耦合的 FGD 的两个组成部分。

在 FGD-T 中,两类具有丰富语义信息和准确位置信息的高级特征可以有效抑制低级纹理特征的背景噪声。在 FGD-S 中,优化后的纹理特征包含足够的内部细节,有助于推断出更准确的分割特征。HPD 通过反馈和集成来增强 FGD 结果。

此外,作者使用权重图来优化损失函数。为了验证所提出方法的普遍性,作者分别针对 COD 和 SOD 任务训练了两个模型。根据 SOD 任务的特点,作者稍微调整了网络的结构,并使用轮廓边缘标签来获得最佳结果。

本文的贡献如下:

提出了一种具有多个线索的纹理标签,并设计了用于异构特征融合的 FGM 模块,该模块使用两种具有丰富语义信息的高级特征来引导一种具有丰富细节的低级特征。

引入了用于双向特征优化的 FGD 解码器,其中分割特征抑制纹理特征的背景噪声,并使用细化的纹理特征来推断更准确的分割特征。TPD和HPD解码器从纹理感知和整体感知的角度进一步优化了FGD的结果。

在 4 个 COD 和 5 个 SOD 数据集上进行的充分实验表明,所提出的方法在 8 个指标方面优于 13 种最先进的 COD 方法和 23 种最先进的 SOD 方法,这证明了本文方法的有效性。

03

方法

在本节中,我先探讨轮廓边缘图、纹理图和ground truth之间的逻辑相互关系。然后讨论特征交互引导解码器和感知解码器的功能。最后,详细比较了用于 SOD 和 COD 任务的 TINet 的两种交互结构,并介绍了边界像素权重图。

Texture Label of TINet

SOD中的物体边界清晰,前景色鲜明,可以作为寻找物体的线索。COD中的物体并不那么显眼,通常边界模糊,伪装颜色接近背景,伪装形状,甚至是伪装纹理。通过观察COD数据集,作者发现人类发现物体并确定其边界的思维过程可以概括为:通过局部显着区域、局部清晰边界或独特形状来推断整个物体;将物体的纹理与背景进行比较。

作者使用 Canny 算法寻找物体内部明显的线条并添加轮廓边缘得到纹理图,这可以帮助找到上述线索。制作纹理标签时,使用 9x9 高斯核对图像进行平滑处理,Canny 阈值为 50-150。注意这个称它们为纹理贴图,因为这些线条可以抽象地表示对象的纹理。轮廓边缘图(ConEdge)、纹理图(Texture)和GT的关系如下:

Perception Decoder

在训练阶段,感知解码器(PD)从不同角度感知被伪装的物体,包括整体感知、边缘感知和纹理感知。所有解码器都参与训练以帮助优化参数。在测试阶段,PDs 通过反馈和集成来细化特征交互引导解码器(FGD)的结果。有时高层特征在特征提取过程中会丢失一些重要的特征信息。

因此,由层间监督 (ILS) 监督的顶层 FGM 的输出特征被下采样并反馈到前一层以对其进行细化。在自上而下的反馈过程之后,TINet 使用感知模块 (PM) 从下到上逐步集成特征。此外,如果只需要一个分割任务,则左侧的 PD不参与计算,反之亦然。

感知模块(PM)实现同类型特征的融合。PM根据监督标签的不同可分为三种类型,分别是COD的纹理感知模块(TPM)、SOD的边缘感知模块(EPM)和整体感知模块(HPM)。一般来说,高层特征具有更丰富的语义信息,而低层特征保留更多细节,包括背景噪声和前景细节。

在上图中,HPM 利用高层分割特征 引导低层分割特征获得新的低层分割特征。新特征将提供给下一个 HPM。详细地说,HPM 有两个步骤:首先,通过逐元素乘法融合高级特征和低级特征,其中 的背景噪声被抑制,前景细节被保留。然后融合特征用于通过元素相加来引导低级特征。逐元素乘法相对粗糙。如果高层特征的语义信息不准确,就会错误地抑制低层特征的一些有用细节。

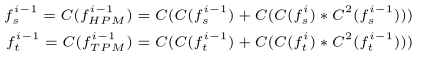

所以 element-wise 添加也可以理解为补充低层特征的细节,防止高层特征的错误融合。每次操作前后都有CBR(卷积、BatchNorm和Relu)。PM的过程可以表示为:

其中每个是 CBR。i 代表特征的级别。表示特征通过两个 CBR。是逐元素乘法。和特征在通过HPM,TPM 中的最后一个 CBR 之前的特征。

Feature Interaction Guidance Decoder

FGD-S 和 FGD-T 是由多个 FGM-S 和 FGM-T 模块组成的互补解码器,可以有效地利用多级分割特征和纹理特征,逐步细化伪装对象检测和纹理检测。对于FGD-S,具有丰富语义信息的高级分割和纹理特征有助于低级分割特征抑制背景噪声,并将详细信息保存在伪装对象区域中。伪装物体的内部高级纹理信息有助于定位和推断整个伪装物体。

对于 FGD-T,两个高级引导特征有效地抑制了背景噪声并约束了低级纹理特征的扩散。细化的纹理特征包含足够的内部细节,有助于推断出更准确的分割特征。上图 (f) (g) 显示了有无引导 S→T 之间的差异。

特征交互引导模块 (FGM) 是 PM 的增强版。FGM 模块在 PM 的基础上增加了另一种高级特征,实现了双重指导。FGM-S 将高级纹理特征的引导添加到低级分割特征中。逐元素乘法用于增强纹理特征对分割特征的定位效果。FGM-T 类似于 FGM-S。不同之处在于,FGM-T 使用concat操作将高级分割特征与通道轴上的低级纹理特征合并,以抑制背景噪声并防止不准确纹理特征的扩散。这里采用另一种CBR将128通道转回64通道:

和是FGM-S 和 FGM-T 的输出。FGM-S 和 FGM-T 都使用两类高级特征来引导和优化一类低级特征。整个过程表达如下:

Interactive Guidance Structure

本节比较 SOD 和 COD 任务的两种交互结构。在图 3 的右侧,作者通过将 FGM-S 模块的输入更改为,并比较 ConEdge 和纹理标签的监督效果。作者发现纹理标签和结构 1 在 COD 任务中的性能最好,而 ConEdge 标签和结构 2 在 SOD 任务中的性能最好。

在COD任务中,伪装物体的低层纹理特征不清晰,容易产生错误引导。但是,高级纹理特征有利于定位,因此高级纹理特征的引导效果更好。在 SOD 任务中,显着对象的边界比较清晰,低层边缘特征具有较高的可信度。因此,相对准确的低级边缘特征的引导效果更好。

上图 (b) (c) (f) (g) 显示了交互式引导的有效性。(d) 是通过显式建模生成的 EGNet 的边缘图,仅使用最低级别的边缘特征。(b) 展示了本文模型的多级交互优化的效果。(g) (h) 展示了 COD 中纹理特征相对于轮廓边缘特征的优势。

Boundary Pixel Perception Loss

边界的准确性直接影响检测结果,因此具有角点感知能力的 BPP loss 侧重于边界并对其周围的像素进行不同的训练。通常,直线的边界比较容易检测,明显的凸起和凹陷部分容易误判。

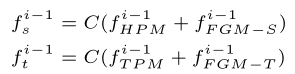

BPP 最初根据 GT 分配权重以得到,如公式 8 所示。在 公式9 中,得到了 ConEdge 像素的权重。加强边界两侧像素的训练有助于模型准确区分局部细节。公式10使用膨胀操作来扩展 ConEdge 权重的影响范围。最终的权重图 (g) 用于改进二元交叉熵 (BCE) 和 IoU 损失。IoU 损失有助于优化全局结构:

是一个边长为 25 的正方形,以 (i,j) 为中心,(m,n) 是 中的一个点。作者使用 max-pooling 和 avg-pooling 来实现dilation。在公式11 中,是指示函数,是像素标签。和 是 (i, j) 处像素的模型预测和ground truth。是指预测概率。 表示模型参数。在公式14 中,和是用于优化训练的多级监督。和 层间监督。

04

实验

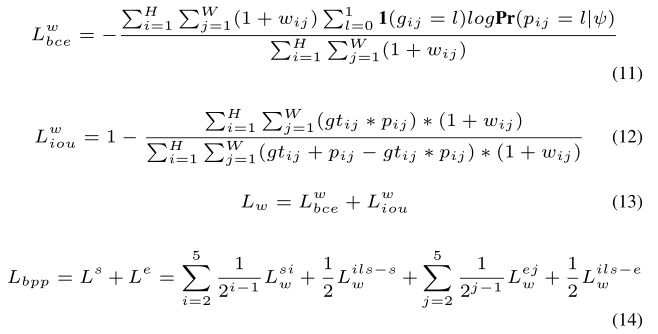

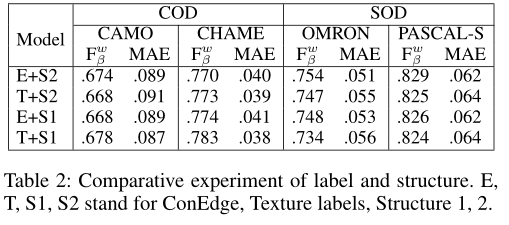

上表展示了COD和SOD的定量结果,作者在 4 个 COD 和 5 个 SOD 数据集上比较了 13 个 COD 和 23 个 SOD 方法,可以看出本文的方法在各个数据集和任务上都有明显的效果。

对于 COD 和 SOD,作者使用不同的标签和结构来比较不同组合的效果。COD数据集中对象的边界是模糊的,因此通过分割特征细化的高级纹理特征对低级分割特征具有更好的推理和引导效果。

但是SOD任务中的对象边界比较清晰,通过高级分割特征优化的低级边缘特征可以很好地引导同级分割特征。ConEdge+Stucture2 和 Texture+Struture1 分别是 SOD 和 COD 的最佳组合。

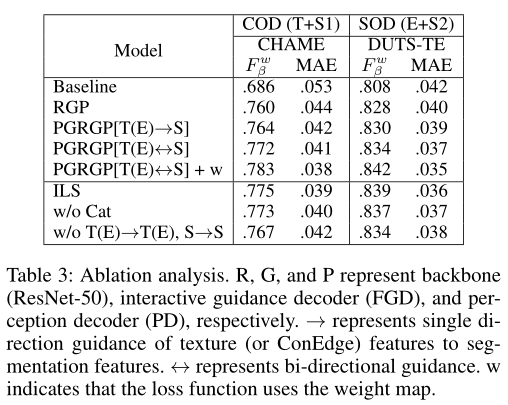

为了分析 TINet 各个组件的作用,一系列实验如上表所示。R、G 和 P 代表骨干网 (ResNet-50)、交互式引导解码器 (FGD) 和感知解码器 (PD)。RGP 由分割标签监督,交互式指导不起作用。在分割特征中加入纹理(边缘)特征的引导后,性能得到提升。

此时,由于纹理(边缘)特征没有被高级分割特征细化,可以进一步提高引导效果。在双向引导中,分割特征抑制了纹理特征的向外扩散,优化后的纹理特征可以有效地推断出分割特征。SOD 任务中的边缘特征也是如此。

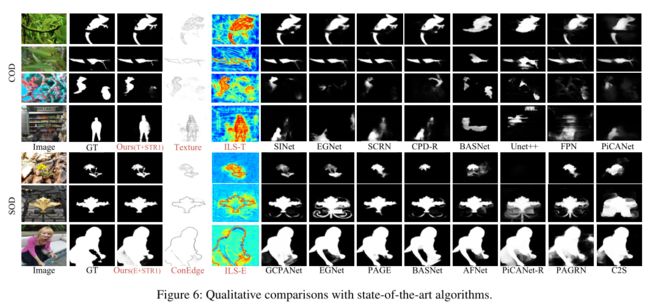

上图显示了本文的模型和其他模型产生的视觉示例。

05

总结

在本文中,作者提出了一个名为 TINet 的结构对称框架,它通过 FGD 解码器交互式地细化多级纹理和分割特征。HPD和TPD(EPD)解码器实现了集成功能,以提高FGD的结果。边缘权重图旨在帮助模型更加关注边界关键部分周围的像素。通过稍微调整结构和标签,本文的模型在 COD 和 SOD 数据集上的表现优于最先进的模型。

参考资料

[1]https://ojs.aaai.org/index.php/AAAI/article/view/16475

▊ 作者简介

研究领域:FightingCV公众号运营者,研究方向为多模态内容理解,专注于解决视觉模态和语言模态相结合的任务,促进Vision-Language模型的实地应用。

知乎/公众号:FightingCV

END

欢迎加入「目标检测」交流群备注:OD