Kubernetes:(五)Pod进阶(资源限制、健康检查)

目录

一:资源限制

1.1概念

1.2Pod和容器的资源请求和限制

1.3CPU资源单位

1.4内存资源单位

1.5CPU和内存的Requests和Limits的特点

1.6示例

1.7释放内存(node节点,以node01为例)

1.7.1查看内存

二:健康检查(探针Probe)

2.1探针的三种规则

2.2Probe支持的三种检查方法

2.3探测获得的三种结果

三:示例

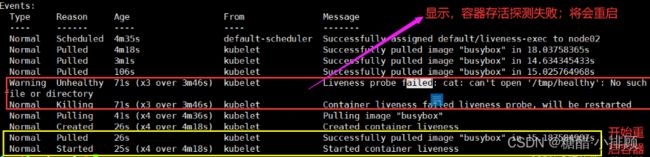

3.1示例1 exec方式

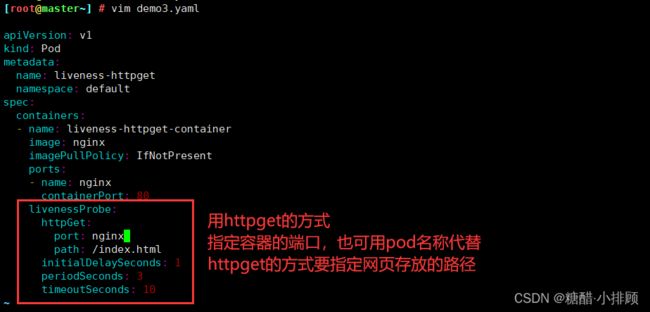

3.2示例2 httpGet方式

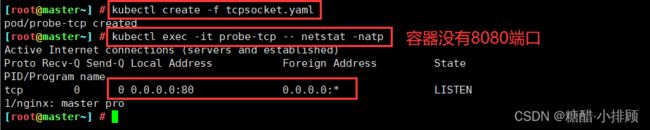

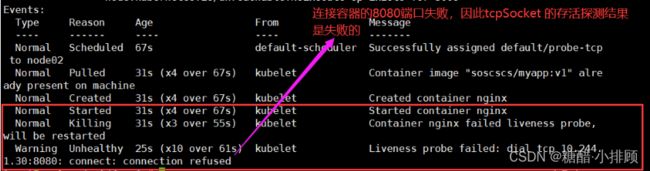

3.3示例3 tcpSocket 方式

3.4示例4 配置就绪探测 httpGet的方式

3.5就绪探测示例2

四:总结

4.1探针(3 种)

4.2检查方式(3种)

4.3探针可选的参数

4.4重启策略

一:资源限制

1.1概念

- 当定义 Pod 时可以选择性地为每个容器设定所需要的资源数量。最常见可设定资源是 CPU 和内存大小,以及其他类型的资源

- 当为 Pod 中的容器指定了 request资源时,调度器就使用该信息来决定将 Pod 调度到哪个节点上。当还为容器指定了limit资源时,kubelet 就会确保运行的容器不会使用超出所设的 limit 资源量。kubelet 还会为容器预留所设的 request 资源量,供该容器使用

- 如果 Pod 运行所在的节点具有足够的可用资源,容器可以使用超出所设置的 request 资源量。不过,容器不可以使用超出所设置的 limit 资源量

- 如果给容器设置了内存的 limit 值,但未设置内存的 request 值,Kubernetes 会自动为其设置与内存 limit 相匹配的 request值。类似的,如果给容器设置了 CPU 的 limit 值但未设置CPU 的 request 值,则 Kubernetes 自动为其设置 CPU 的 request 值 并使之与CPU 的 limit 值匹配

官网示例:

https://kubernetes.io/docs/concepts/configuration/manage-compute-resources-container/

1.2Pod和容器的资源请求和限制

定义创建容器时预分配的CPU资源

spec.containers[].resources.requests.cpu

定义创建容器时预分配的内存资源

spec.containers[].resources.requests.memory

定义创建容器时预分配的巨页资源

spec.containers[].resources.requests.hugepages-

定义cpu的资源上限

spec.containers[].resources.limits.cpu

定义内存的资源上限

spec.containers[].resources.limits.memory

定义巨页的资源上限

spec.containers[].resources.limits.hugepages- 1.3CPU资源单位

- CPU 资源的 request 和 limit 以 cpu 为单位。Kubernetes 中的一个 cpu 相当于1个 vCPU(1个超线程)

- Kubernetes 也支持带小数 CPU 的请求。spec.containers[].resources.requests.cpu 为0.5的容器能够获得一个 cpu 的一半 CPU资源(类似于Cgroup对CPU资源的时间分片)。表达式0.1等价于表达式 100m(毫秒),表示每1000毫秒内容器可以使用的CPU时间总量为0.1*1000 毫秒

1.4内存资源单位

- 内存的 request 和 limit 以字节为单位。 可以以整数表示,或者以10为底数的指数的单位(E、P、T、G、M、K)来表示,或者以2为底数的指数的单位(Ei、Pi、Ti、Gi、Mi、Ki)来表示。如1KB=103=1000,1MB=106=1000000=1000KB,1GB=10^9=1000000000=1000MB 1KiB=2^10=1024, 1MiB=2^20=1048576=1024KiB

- PS∶在买硬盘的时候,操作系统报的数量要比产品标出或商家号称的小一些,主要原因是标出的是以 MB、GB为单位的,1GB就是1,000,000,000Byte,而操作系统是以2进制为处理单位的,,因此检查硬盘容量时是以MiB、GiB为单位,1GB=2^30=1,073,741,824,相比较而言,1GiB要比1GB多出1,073,741,824-1,000,000,000=73,741,824Byte,所以检测实际结果要比标出的少—些

1.5CPU和内存的Requests和Limits的特点

- Requests和Limits都是可选的。在Pod创建和更新时,如果未设置Requests和Limits,则使用系统提供的默认值,该默认值取决于集群配置。

- 如果Requests没有配置,默认被设置等于Limits。

- requests 是创建容器时需要预留的资源量。如果无法满足,则pod 无法调度。但是,这不是容器运行实际使用的资源,容器实际运行使用的资源可能比这个大,也可能比这个小。

- Limit 是限制pod容器可以使用资源的上限。容器使用的资源无法高于这个限制任何情况下Limits都应该设置为大于或等于Requests。

1.6示例

[root@master ~]# vim demo1.yaml

apiVersion: v1

kind: Pod

metadata:

name: frontend

spec:

containers:

- name: web

image: nginx

env:

- name: WEB_ROOT_PASSWORD

value: "password"

resources:

#此容器预分配资源:内存为 64Mi ; 每个cpu 分配250m

requests:

memory: "64Mi"

cpu: "250m"

#此容器限制使用资源(最大): 内存最大使用128Mi,每个cpu最大分配500m

limits:

memory: "128Mi"

cpu: "500m"

- name: db

image: mysql

env:

- name: MYSQL_ROOT_PASSWORD

value: "abc123"

resources:

#此容器的预分配资源:内存预分配为512Mi;cpu预分配为每个cpu的50%,即1000*50%=500m

requests:

memory: "512Mi"

cpu: "0.5"

#此容器的限制使用资源配额为:内存最大使用1Gi;cpu最大使用1000m

limits:

memory: "1Gi"

cpu: "1"

#pod有两个容器,web 和db。所以,总的请求资源和限制资源为 web 和db 请求,限制资源总和。

#其中,cpu 的资源请求和限制,是以单个cpu 资源进行计算的。如果有多个cpu,则最终的结果是数值*NapiVersion: v1

kind: Pod

metadata:

name: frontend

spec:

containers:

- name: web

image: nginx

env:

- name: WEB_ROOT_PASSWORD

value: "password"

resources:

requests:

memory: "64Mi"

cpu: "250m"

limits:

memory: "128Mi"

cpu: "500m"

- name: db

image: mysql

env:

- name: MYSQL_ROOT_PASSWORD

value: "abc123"

resources:

requests:

memory: "512Mi"

cpu: "0.5"

limits:

memory: "1Gi"

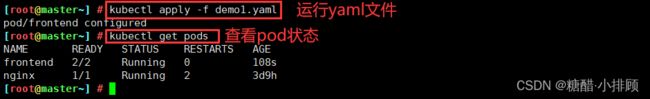

cpu: "1"kubectl apply -f demo1.yaml

#成功部署好后查看状态

kubectl get pods

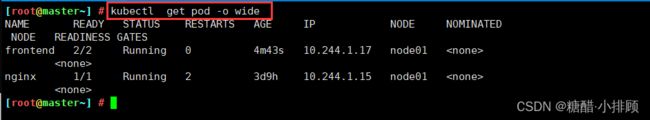

kubectl describe pod frontend#查看pod的详细信息,查看pod被调度到了哪个node节点

kubectl get pod -o wide

#查看node01 节点的信息

kubectl describe nodes node011.7释放内存(node节点,以node01为例)

由于mysql对于内存的使用要求比较高,因此需要先检查内存的可用空间是否能够满足mysql的正常运行,若剩余内存不够,可对其进行释放操作。

1.7.1查看内存

[root@node01 ~]# free -mh

total used free shared buff/cache available

Mem: 1.9G 1.0G 86M 26M 870M 663M

Swap: 0B 0B 0B内存总量为1.9G,实际使用1G,因此可有内存应该为0.9G左右。

但是由于有870M的内存被用于缓存,导致了free仅为86M。

86M剩余可用内存显然是不够用的,因此需要释放缓存。

手动释放缓存

echo [1\2\3] > /proc/sys/vm/drop_caches

[root@node01 ~]# cat /proc/sys/vm/drop_caches

0

[root@node01 ~]# echo 3 > /proc/sys/vm/drop_caches

[root@node01 ~]# free -mh

total used free shared buff/cache available

Mem: 1.9G 968M 770M 26M 245M 754M

0:0是系统默认值,默认情况下表示不释放内存,由操作系统自动管理

1:释放页缓存

2:释放dentries和inodes

3:释放所有缓存

注意:

如果因为是应用有像内存泄露、溢出的问题,从swap的使用情况是可以比较快速可以判断的,但free上面反而比较难查看。相反,如果在这个时候,我们告诉用户,修改系统的一个值,“可以”释放内存,free就大了。用户会怎么想?不会觉得操作系统“有问题”吗?所以说,既然核心是可以快速清空buffer或cache,也不难做到(这从上面的操作中可以明显看到),但核心并没有这样做(默认值是0),我们就不应该随便去改变它。

一般情况下,应用在系统上稳定运行了,free值也会保持在一个稳定值的,虽然看上去可能比较小。当发生内存不足、应用获取不到可用内存、OOM错误等问题时,还是更应该去分析应用方面的原因,如用户量太大导致内存不足、发生应用内存溢出等情况,否则,清空buffer,强制腾出free的大小,可能只是把问题给暂时屏蔽了。

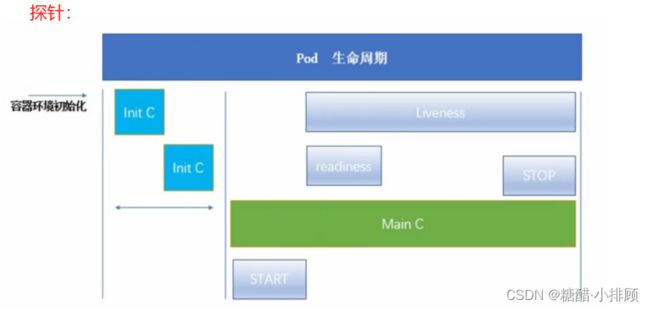

二:健康检查(探针Probe)

健康检查,又名探针(Probe):探针是由kubelet对容器执行定期诊断

2.1探针的三种规则

StartupProbe(1.17版本新增):判断容器内的应用程序是否已经启动,主要针对于不能确定具体启动时间应用。如果配置了startupProbe探测,则在startuProbe状态为success 之前,其他所有探针都处于无效状态,知道它成功后其他探针才起作用。如果startupProbe失败,kubelet将杀死容器你,容器将根据restartPolicy来重启。如果容器没有配置startupProbe,则默认状态为Success。

LivenessProbe(存活性探针):判断容器是否正在运行。如果探测失败,则kubectl 会杀死容器,并且容器将根据 restartPolicy 来设置 Pod 状态。如果容器不提供存活探针,则默认状态为Success。

- 存活性探测,判断pod是否需要重启

ReadinessProbe(就绪性探针):一般用于探测容器内的程序是否健康,它的返回值如果为success,那么就代表这个容器已经完成启动,并且程序已经是可以接受流量的状态。

- 就绪性探测,判断pod是否能够提供正常服务。

注:以上规则可以同时定义。在readinessProbe检测成功之前,Pod的running状态是不会变成ready状态。

startupProbe、livenessProbe、ReadinessProbe之间的区别:

startupProbe: pod只检测一次,剩下的两种只要你的pod存在就会一直去检测

livenessProbe、ReadinessProbe:建议使用接口级的健康检查

2.2Probe支持的三种检查方法

Exec:在容器内执行一个命令,如果返回值为0,则认为容器健康。

TCPSocket:通过TCP连接检查容器内的端口是否是通的,如果是通的就认为容器健康。

HTTPGet:通过应用程序暴露的API地址来检查程序是否是正常的,如果状态码为200~400之间,则认为容器健康。

2.3探测获得的三种结果

每次探测,都将会获得以下三种结果之一:

- 成功: 容器通过了诊断

- 失败: 容器未通过诊断

- 未知:诊断失败,因此不会采取任何行动

三:示例

3.1示例1 exec方式

exec 官网示例

配置存活、就绪和启动探测器 | Kubernetesvim demo2.yaml

==========================================================

apiVersion: v1

kind: Pod

metadata:

labels:

test: liveness

name: liveness-exec

spec:

containers:

- name: liveness

image: busybox

args:

- /bin/sh

- -c

- touch /tmp/healthy; sleep 30; rm -rf /tmp/healthy; sleep 60

livenessProbe:

exec:

command:

- cat

- /tmp/healthy

failureThreshold: 1

initialDelaySeconds: 5

periodSeconds: 5探针可选的参数:

- initialDelaySeconds∶指定 kubelet 在执行第一次探测前应该等待5秒,即第一次探测是在容器启动后的第6秒才开始执行。默认是 0 秒,最小值是 0。

- periodSeconds∶指定了 kubelet 应该每 5 秒执行一次存活探测。默认是 10 秒。最小值是 1。

- failureThreshold∶当探测失败时,Kubernetes 将在放弃之前重试的次数。存活探测情况下的放弃就意味着重新启动容器。就绪探测情况下的放弃 Pod 会被打上未就绪的标签。默认值是 3。最小值是 1。

- timeoutSeconds∶探测超时后等待多少秒。默认值是 1 秒。最小值是 1。(在 Kubernetes 1.20 版本之前,exec 探针会忽略timeoutSeconds 探针会无限期地持续运行,甚至可能超过所配置的限期,直到返回结果为止。)

在这个配置文件中,可以看到 Pod 中只有一个容器。

periodSeconds 字段指定了 kubelet 应该每 5 秒执行一次存活探测。

initialDelaySeconds 字段告诉 kubelet 在执行第一次探测前应该等待 5 秒。

kubelet 在容器内执行命令 cat /tmp/healthy 来进行探测。 如果命令执行成功并且返回值为 0,kubelet 就会认为这个容器是健康存活的。 如果这个命令返回非 0 值,kubelet 会杀死这个容器并重新启动它。

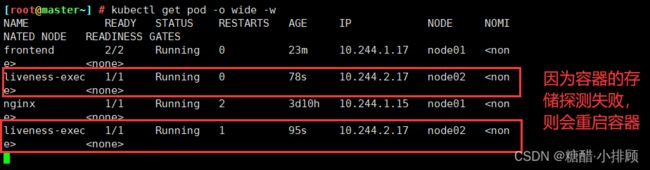

#创建pod

kubectl create -f demo2.yaml

#跟踪查看pod 信息

kubectl get pod -o wide -w

#新开一个终端,查看pod 的消息信息

kubectl describe pod liveness-exec3.2示例2 httpGet方式

vim demo3.yaml

==========================================================

apiVersion: v1

kind: Pod

metadata:

name: liveness-httpget

namespace: default

spec:

containers:

- name: liveness-httpget-container

image: nginx

imagePullPolicy: IfNotPresent

ports:

- name: nginx

containerPort: 80

livenessProbe:

httpGet:

port: nginx #指定端口,这里使用的是之前的ports里的name,也可以直接写端口

path: /index.html #指定路径

initialDelaySeconds: 1

periodSeconds: 3

timeoutSeconds: 10在这个配置文件中, 可以看到 Pod 也只有一个容器。initialDelaySeconds 字段告诉 kubelet 在执行第一次探测前应该等待 3秒。periodSeconds 字段指定了 kubelet 每隔 3 秒执行一次存活探测。 timeoutSeconds字段指定了超时等待时间为10S,kubelet 会向容器内运行的服务(服务会监听 80端口)发送一个HTTP GET 请求来执行探测。如果服务器上/index.html路径下的处理程序返回成功代码,则 kubelet 认为容器是健康存活的。如果处理程序返回失败代码,则 kubelet 会杀死这个容器并且重新启动它。

任何大于或等于 200 并且小于 400 的返回代码标示成功,其它返回代码都标示失败。

#加载yaml文件

kubectl create -f demo3.yaml

#进入容器删除网页文件进行测试

kubectl exec -it liveness-httpget -- rm -rf /usr/share/nginx/html/index.html

#查看pod的详细参数

kubectl get pod

kubectl describe pod liveness-httpget3.3示例3 tcpSocket 方式

官方示例:

apiVersion: v1

kind: Pod

metadata:

name: goproxy

labels:

app: goproxy

spec:

containers:

- name: goproxy

image: k8s.gcr.io/goproxy:0.1

ports:

- containerPort: 8080

readinessProbe:

tcpSocket:

port: 8080

initialDelaySeconds: 5

periodSeconds: 10

livenessProbe:

tcpSocket:

port: 8080

initialDelaySeconds: 15

periodSeconds: 20如你所见,TCP 检测的配置和 HTTP 检测非常相似。 下面这个例子同时使用就绪(readinessProbe)和存活(livenessProbe)探测器。

kubelet 会在容器启动 5 秒后发送第一个就绪探测。 这会尝试连接 goproxy 容器的 8080 端口。 如果探测成功,这个 Pod 会被标记为就绪状态,kubelet 将继续每隔 10 秒运行一次检测。

除了就绪探测,这个配置包括了一个存活探测。 kubelet 会在容器启动 15 秒后进行第一次存活探测。 与就绪探测类似,会尝试连接 goproxy 容器的 8080 端口。 如果存活探测失败,这个容器会被重新启动

编写tcpSocket 方式示例

[root@master ~]# vim tcpsocket.yaml

apiVersion: v1

kind: Pod

metadata:

name: probe-tcp

spec:

containers:

- name: nginx

image: soscscs/myapp:v1

livenessProbe:

initialDelaySeconds: 5

timeoutSeconds: 1

tcpSocket:

port: 8080

periodSeconds: 3kubectl create -f tcpsocket.yaml

#查看容器里的端口(查看有无8080端口)

kubectl exec -it probe-tcp -- netstat -natp

#查看pod的状态和详细信息

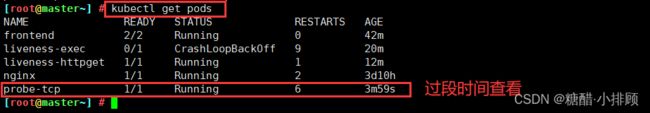

[root@master ~]# kubectl get pods

[root@master ~]# kubectl describe pod probe-tcp3.4示例4 配置就绪探测 httpGet的方式

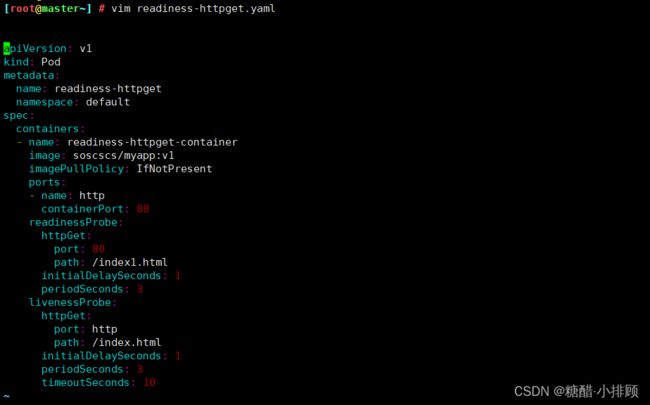

[root@master ~]# vim readiness-httpget.yaml

apiVersion: v1

kind: Pod

metadata:

name: readiness-httpget

namespace: default

spec:

containers:

- name: readiness-httpget-container

image: soscscs/myapp:v1

imagePullPolicy: IfNotPresent

ports:

- name: http

containerPort: 80

readinessProbe:

httpGet:

port: 80

path: /index1.html

initialDelaySeconds: 1

periodSeconds: 3

livenessProbe:

httpGet:

port: http

path: /index.html

initialDelaySeconds: 1

periodSeconds: 3

timeoutSeconds: 10#创建pod

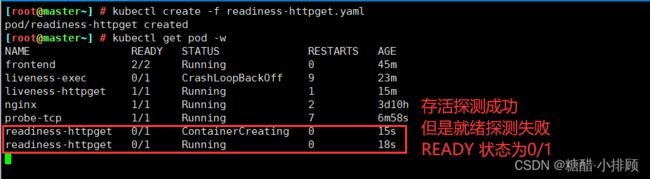

[root@master ~]# kubectl create -f readiness-httpget.yaml

#查看pod的详细信息

[root@master ~]# kubectl get pod -w

[root@master ~]# kubectl describe pod readiness-httpget

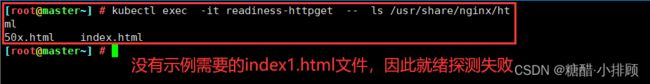

#此时,因为容器里没有 index1.html文件,所以,httpGet的就绪探测失败

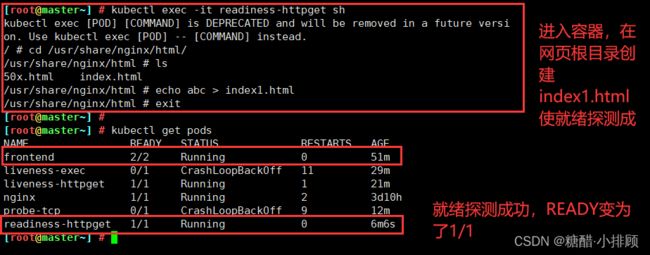

[root@master ~]# kubectl exec -it readiness-httpget -- ls /usr/share/nginx/html#进入容器,创建index1.html,让就绪探测成功

[root@master ~]# kubectl exec -it readiness-httpget sh

/ # cd /usr/share/nginx/html/

/usr/share/nginx/html # ls

50x.html index.html

/usr/share/nginx/html # echo abc > index1.html

/usr/share/nginx/html # exit

[root@master ~]# kubectl get pods3.5就绪探测示例2

[root@master ~]# vim readiness-myapp.yaml

apiVersion: v1

kind: Pod

metadata:

name: myapp1

labels:

app: myapp

spec:

containers:

- name: myapp

image: soscscs/myapp:v1

ports:

- name: http

containerPort: 80

readinessProbe:

httpGet:

port: 80

path: /index.html

initialDelaySeconds: 5

periodSeconds: 5

timeoutSeconds: 10

---

apiVersion: v1

kind: Pod

metadata:

name: myapp2

labels:

app: myapp

spec:

containers:

- name: myapp

image: soscscs/myapp:v1

ports:

- name: http

containerPort: 80

readinessProbe:

httpGet:

port: 80

path: /index.html

initialDelaySeconds: 5

periodSeconds: 5

timeoutSeconds: 10

---

apiVersion: v1

kind: Pod

metadata:

name: myapp3

labels:

app: myapp

spec:

containers:

- name: myapp

image: soscscs/myapp:v1

ports:

- name: http

containerPort: 80

readinessProbe:

httpGet:

port: 80

path: /index.html

initialDelaySeconds: 5

periodSeconds: 5

timeoutSeconds: 10

---

apiVersion: v1

kind: Service

metadata:

name: myapp

spec:

selector:

app: myapp

type: ClusterIP

ports:

- name: http

port: 80

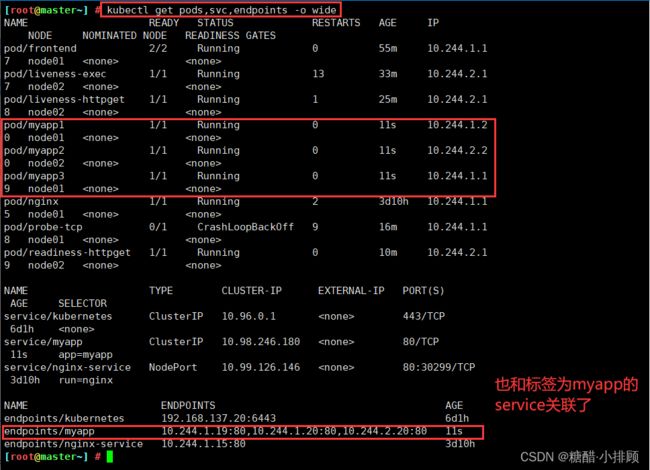

targetPort: 80所有的自主式Pod,name不可以相同。但是使用同一个标签myapp。 service通过标签选择器和对应标签的pod关联

[root@master ~]# kubectl create -f readiness-myapp.yaml

#查看这些资源的详细信息。

[root@master ~]# kubectl get pods,svc,endpoints -o wide

#删除myapp1的 index.html文件,让就绪探测 失败

[root@master ~]# kubectl exec -it myapp1 -- rm -rf /usr/share/nginx/html/index.html

# 查看发现,就绪探测失败的pod被从关联的service中移除ip

[root@master ~]# kubectl get pods,svc,endpoints -o wide![]()

四:总结

4.1探针(3 种)

- livenessProbe(存活探针)∶判断容器是否正常运行,如果失败则杀掉容器(不是pod),再根据重启策略是否重启容器

- readinessProbe(就绪探针)∶判断容器是否能够进入ready状态,探针失败则进入noready状态,并从service的endpoints中剔除此容器

- startupProbe∶判断容器内的应用是否启动成功,在success状态前,其它探针都处于无效状态

4.2检查方式(3种)

- exec∶使用 command 字段设置命令,在容器中执行此命令,如果命令返回状态码为0,则认为探测成功

- httpget∶通过访问指定端口和url路径执行http get访问。如果返回的http状态码为大于等于200且小于400则认为成功

- tcpsocket∶通过tcp连接pod(IP)和指定端口,如果端口无误且tcp连接成功,则认为探测成功

4.3探针可选的参数

- initialDelaySeconds∶ 容器启动多少秒后开始执行探测

- periodSeconds∶探测的周期频率,每多少秒执行一次探测

- failureThreshold∶探测失败后,允许再试几次

- timeoutSeconds ∶ 探测等待超时的时间

4.4重启策略

Pod在遇到故障之后“重启”的动作Pod在遇到故障之后“重启”的动作

Always:当容器终止退出后,总是“重启”容器,默认策略

OnFailure:当容器异常退出(退出状态码非0)时,重启容器

Never:当容器终止退出,从不“重启”容器。

(注意:k8s中不支持重启Pod资源,只有删除重建,重建)