Linux TCP/IP 协议栈调优

鸟窝大佬

原文地址 : https://colobu.com/2014/09/18...

https://colobu.com/2015/05/22...

最近忙于系统性能的DEBUG和调优。 有些性能瓶颈和Linux的TCP/IP的协议栈的设置有关,所以特别google了一下Linux TCP/IP的协议栈的参数意义和配置,记录一下。

如果想永久的保存参数的设置, 可以将参数加入到/etc/sysctl.conf中。如果想临时的更改参数的配置, 可以修改/proc/sys/net/ipv4/下的参数, 机器重启后更改失效。

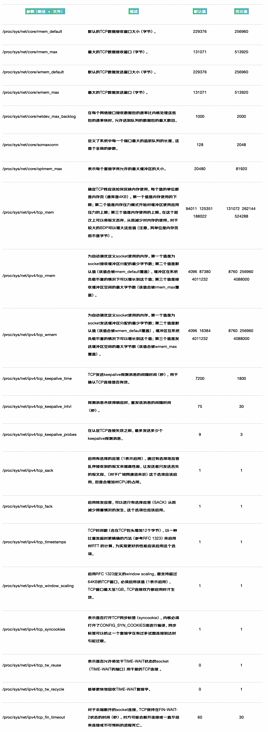

杨云1028整理的参数的说明:

参考文章:

linux内核TCP相关参数解释

linux内核参数注释

根据参数文件所处目录不同而进行分表整理

下列文件所在目录:/proc/sys/net/ipv4/

所处目录/proc/sys/net/ipv4/netfilter/

文件需要打开防火墙才会存在

两种修改内核参数方法

- 使用echo value方式直接追加到文件里如echo "1" >/proc/sys/net/ipv4/tcp_syn_retries,但这种方法设备重启后又会恢复为默认值

- 把参数添加到/etc/sysctl.conf中,然后执行sysctl -p使参数生效,永久生效

内核生产环境优化参数

生产中常用的参数:

net.ipv4.tcp_syn_retries = 1

net.ipv4.tcp_synack_retries = 1

net.ipv4.tcp_keepalive_time = 600

net.ipv4.tcp_keepalive_probes = 3

net.ipv4.tcp_keepalive_intvl =15

net.ipv4.tcp_retries2 = 5

net.ipv4.tcp_fin_timeout = 2

net.ipv4.tcp_max_tw_buckets = 36000

net.ipv4.tcp_tw_recycle = 1

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_max_orphans = 32768

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_max_syn_backlog = 16384

net.ipv4.tcp_wmem = 8192 131072 16777216

net.ipv4.tcp_rmem = 32768 131072 16777216

net.ipv4.tcp_mem = 786432 1048576 1572864

net.ipv4.ip_local_port_range = 1024 65000

net.core.netdev_max_backlog = 16384不同的生产环境需要优化的参数基本差不多,只是值有相应的变化。具体优化值要参考应用场景,这儿所列只是常用优化参数,是否适合,可在上面查看该参数描述,理解后,再根据自己生产环境而设。

其它相关linux内核参数调整文章:

Linux内核参数优化

http://flandycheng.blog.51cto...

优化linux的内核参数来提高服务器并发处理能力

http://www.ha97.com/4396.html

nginx做web服务器linux内核参数优化

http://blog.csdn.net/force_ea...

sudops网站提供的优化例子:

Linux下TCP/IP及内核参数优化有多种方式,参数配置得当可以大大提高系统的性能,也可以根据特定场景进行专门的优化,如TIME_WAIT过高,DDOS攻击等等。

如下配置是写在sysctl.conf中,可使用sysctl -p生效,文中附带了一些默认值和中文解释(从网上收集和翻译而来),确有些辛苦,转载请保留链接,谢谢~。

相关参数仅供参考,具体数值还需要根据机器性能,应用场景等实际情况来做更细微调整。

net.core.netdev_max_backlog = 400000

#该参数决定了,网络设备接收数据包的速率比内核处理这些包的速率快时,允许送到队列的数据包的最大数目。

net.core.optmem_max = 10000000

#该参数指定了每个套接字所允许的最大缓冲区的大小

net.core.rmem_default = 10000000

#指定了接收套接字缓冲区大小的缺省值(以字节为单位)。

net.core.rmem_max = 10000000

#指定了接收套接字缓冲区大小的最大值(以字节为单位)。

net.core.somaxconn = 100000

#Linux kernel参数,表示socket监听的backlog(监听队列)上限

net.core.wmem_default = 11059200

#定义默认的发送窗口大小;对于更大的 BDP 来说,这个大小也应该更大。

net.core.wmem_max = 11059200

#定义发送窗口的最大大小;对于更大的 BDP 来说,这个大小也应该更大。

net.ipv4.conf.all.rp_filter = 1

net.ipv4.conf.default.rp_filter = 1

#严谨模式 1 (推荐)

#松散模式 0

net.ipv4.tcp_congestion_control = bic

#默认推荐设置是 htcp

net.ipv4.tcp_window_scaling = 0

#关闭tcp_window_scaling

#启用 RFC 1323 定义的 window scaling;要支持超过 64KB 的窗口,必须启用该值。

net.ipv4.tcp_ecn = 0

#把TCP的直接拥塞通告(tcp_ecn)关掉

net.ipv4.tcp_sack = 1

#关闭tcp_sack

#启用有选择的应答(Selective Acknowledgment),

#这可以通过有选择地应答乱序接收到的报文来提高性能(这样可以让发送者只发送丢失的报文段);

#(对于广域网通信来说)这个选项应该启用,但是这会增加对 CPU 的占用。

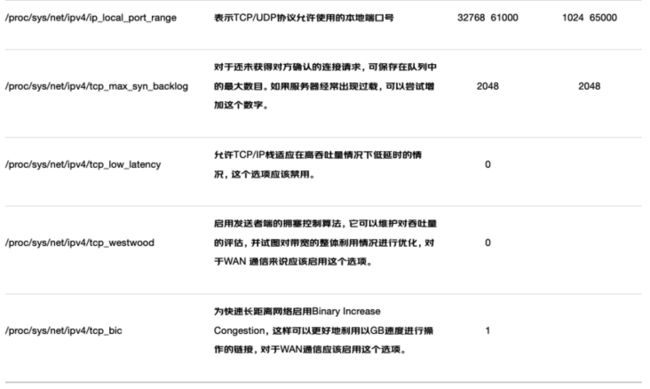

net.ipv4.tcp_max_tw_buckets = 10000

#表示系统同时保持TIME_WAIT套接字的最大数量

net.ipv4.tcp_max_syn_backlog = 8192

#表示SYN队列长度,默认1024,改成8192,可以容纳更多等待连接的网络连接数。

net.ipv4.tcp_syncookies = 1

#表示开启SYN Cookies。当出现SYN等待队列溢出时,启用cookies来处理,可防范少量SYN攻击,默认为0,表示关闭;

net.ipv4.tcp_timestamps = 1

#开启TCP时间戳

#以一种比重发超时更精确的方法(请参阅 RFC 1323)来启用对 RTT 的计算;为了实现更好的性能应该启用这个选项。

net.ipv4.tcp_tw_reuse = 1

#表示开启重用。允许将TIME-WAIT sockets重新用于新的TCP连接,默认为0,表示关闭;

net.ipv4.tcp_tw_recycle = 1

#表示开启TCP连接中TIME-WAIT sockets的快速回收,默认为0,表示关闭。

net.ipv4.tcp_fin_timeout = 10

#表示如果套接字由本端要求关闭,这个参数决定了它保持在FIN-WAIT-2状态的时间。

net.ipv4.tcp_keepalive_time = 1800

#表示当keepalive起用的时候,TCP发送keepalive消息的频度。缺省是2小时,改为30分钟。

net.ipv4.tcp_keepalive_probes = 3

#如果对方不予应答,探测包的发送次数

net.ipv4.tcp_keepalive_intvl = 15

#keepalive探测包的发送间隔

net.ipv4.tcp_mem

#确定 TCP 栈应该如何反映内存使用;每个值的单位都是内存页(通常是 4KB)。

#第一个值是内存使用的下限。

#第二个值是内存压力模式开始对缓冲区使用应用压力的上限。

#第三个值是内存上限。在这个层次上可以将报文丢弃,从而减少对内存的使用。对于较大的 BDP 可以增大这些值(但是要记住,其单位是内存页,而不是字节)。

net.ipv4.tcp_rmem

#与 tcp_wmem 类似,不过它表示的是为自动调优所使用的接收缓冲区的值。

net.ipv4.tcp_wmem = 30000000 30000000 30000000

#为自动调优定义每个 socket 使用的内存。

#第一个值是为 socket 的发送缓冲区分配的最少字节数。

#第二个值是默认值(该值会被 wmem_default 覆盖),缓冲区在系统负载不重的情况下可以增长到这个值。

#第三个值是发送缓冲区空间的最大字节数(该值会被 wmem_max 覆盖)。

net.ipv4.ip_local_port_range = 1024 65000

#表示用于向外连接的端口范围。缺省情况下很小:32768到61000,改为1024到65000。

net.ipv4.netfilter.ip_conntrack_max=204800

#设置系统对最大跟踪的TCP连接数的限制

net.ipv4.tcp_slow_start_after_idle = 0

#关闭tcp的连接传输的慢启动,即先休止一段时间,再初始化拥塞窗口。

net.ipv4.route.gc_timeout = 100

#路由缓存刷新频率,当一个路由失败后多长时间跳到另一个路由,默认是300。

net.ipv4.tcp_syn_retries = 1

#在内核放弃建立连接之前发送SYN包的数量。

net.ipv4.icmp_echo_ignore_broadcasts = 1

# 避免放大攻击

net.ipv4.icmp_ignore_bogus_error_responses = 1

# 开启恶意icmp错误消息保护

net.inet.udp.checksum=1

#防止不正确的udp包的攻击

net.ipv4.conf.default.accept_source_route = 0

#是否接受含有源路由信息的ip包。参数值为布尔值,1表示接受,0表示不接受。

#在充当网关的linux主机上缺省值为1,在一般的linux主机上缺省值为0。

#从安全性角度出发,建议你关闭该功能。最初的幸福ever也提供了一些参数的说明。

/proc/sys/net目录

所有的TCP/IP参数都位于/proc/sys/net目录下(请注意,对/proc/sys/net目录下内容的修改都是临时的,任何修改在系统重启后都会丢失),例如下面这些重要的参数:

服务器的参数调优

一般会修改两个文件,/etc/sysctl.conf和/etc/security/limits.conf, 用来配置TCP/IP参数和最大文件描述符。

TCP/IP参数配置

修改文件/etc/sysctl.conf,配置网络参数。

net.ipv4.tcp_wmem = 4096 87380 4161536

net.ipv4.tcp_rmem = 4096 87380 4161536

net.ipv4.tcp_mem = 786432 2097152 3145728数值根据需求进行调整。更多的参数可以看以前整理的一篇文章: Linux TCP/IP 协议栈调优 。

执行/sbin/sysctl -p即时生效。

最大文件描述符

Linux内核本身有文件描述符最大值的限制,你可以根据需要更改:

系统最大打开文件描述符数:/proc/sys/fs/file-max

- 临时性设置:echo 1000000 > /proc/sys/fs/file-max

- 永久设置:修改/etc/sysctl.conf文件,增加fs.file-max = 1000000

进程最大打开文件描述符数

- 使用ulimit -n查看当前设置。使用ulimit -n 1000000进行临时性设置。

- 要想永久生效,你可以修改/etc/security/limits.conf文件,增加下面的行:

- hard nofile 1000000

soft nofile 1000000

root hard nofile 1000000

root soft nofile 1000000还有一点要注意的就是hard limit不能大于/proc/sys/fs/nr_open,因此有时你也需要修改nr_open的值。

执行echo 2000000 > /proc/sys/fs/nr_open

查看当前系统使用的打开文件描述符数,可以使用下面的命令:

[root@localhost ~]# cat /proc/sys/fs/file-nr

1632 0 1513506其中第一个数表示当前系统已分配使用的打开文件描述符数,第二个数为分配后已释放的(目前已不再使用),第三个数等于file-max。

总结一下:

- 所有进程打开的文件描述符数不能超过/proc/sys/fs/file-max

- 单个进程打开的文件描述符数不能超过user limit中nofile的soft limit

- nofile的soft limit不能超过其hard limit

- nofile的hard limit不能超过/proc/sys/fs/nr_open

应用运行时调优

Java 应用内存调优

服务器使用12G内存,吞吐率优先的垃圾回收器:

JAVA_OPTS="-Xms12G -Xmx12G -Xss1M -XX:+UseParallelGC"V8引擎

node --nouse-idle-notification --expose-gc --max-new-space-size=1024 --max-new-space-size=2048 --max-old-space-size=8192 ./webserver.jsOutOfMemory Killer

如果服务器本身内存不大,比如8G,在不到100万连接的情况下,你的服务器进程有可能出现"Killed"的问题。 运行dmesg可以看到

Out of memory: Kill process 10375 (java) score 59 or sacrifice child这是Linux的OOM Killer主动杀死的。 开启oom-killer的话,在/proc/pid下对每个进程都会多出3个与oom打分调节相关的文件。临时对某个进程可以忽略oom-killer可以使用下面的方式:

echo -17 > /proc/$(pidof java)/oom_adj解决办法有多种,可以参看文章最后的参考文章,最好是换一个内存更大的机器。

客户端的参数调优

在一台系统上,连接到一个远程服务时的本地端口是有限的。根据TCP/IP协议,由于端口是16位整数,也就只能是0到 65535,而0到1023是预留端口,所以能分配的端口只是1024到65534,也就是64511个。也就是说,一台机器一个IP只能创建六万多个长连接。

要想达到更多的客户端连接,可以用更多的机器或者网卡,也可以使用虚拟IP来实现,比如下面的命令增加了19个IP地址,其中一个给服务器用,其它18个给client,这样

可以产生18 * 60000 = 1080000个连接。

ifconfig eth0:0 192.168.77.10 netmask 255.255.255.0 up

ifconfig eth0:1 192.168.77.11 netmask 255.255.255.0 up

ifconfig eth0:2 192.168.77.12 netmask 255.255.255.0 up

ifconfig eth0:3 192.168.77.13 netmask 255.255.255.0 up

ifconfig eth0:4 192.168.77.14 netmask 255.255.255.0 up

ifconfig eth0:5 192.168.77.15 netmask 255.255.255.0 up

ifconfig eth0:6 192.168.77.16 netmask 255.255.255.0 up

ifconfig eth0:7 192.168.77.17 netmask 255.255.255.0 up

ifconfig eth0:8 192.168.77.18 netmask 255.255.255.0 up

ifconfig eth0:9 192.168.77.19 netmask 255.255.255.0 up

ifconfig eth0:10 192.168.77.20 netmask 255.255.255.0 up

ifconfig eth0:11 192.168.77.21 netmask 255.255.255.0 up

ifconfig eth0:12 192.168.77.22 netmask 255.255.255.0 up

ifconfig eth0:13 192.168.77.23 netmask 255.255.255.0 up

ifconfig eth0:14 192.168.77.24 netmask 255.255.255.0 up

ifconfig eth0:15 192.168.77.25 netmask 255.255.255.0 up

ifconfig eth0:16 192.168.77.26 netmask 255.255.255.0 up

ifconfig eth0:17 192.168.77.27 netmask 255.255.255.0 up

ifconfig eth0:18 192.168.77.28 netmask 255.255.255.0 up修改/etc/sysctl.conf文件:

net.ipv4.ip_local_port_range = 1024 65535执行/sbin/sysctl -p即时生效。

服务器测试

实际测试中我使用一台AWS C3.4xlarge (16 cores, 32G memory)作为应用服务器,两台AWS C3.2xlarge (8 cores, 16G memory)服务器作为客户端。

这两台机器作为测试客户端绰绰有余,每台客户端机器创建了十个内网虚拟IP, 每个IP创建60000个websocket连接。

客户端配置如下:

/etc/sysctl.conf配置

fs.file-max = 2000000

fs.nr_open = 2000000

net.ipv4.ip_local_port_range = 1024 65535/etc/security/limits.conf配置

* soft nofile 2000000

* hard nofile 2000000

* soft nproc 2000000

* hard nproc 2000000服务端配置如下:

/etc/sysctl.conf配置

fs.file-max = 2000000

fs.nr_open = 2000000

net.ipv4.ip_local_port_range = 1024 65535/etc/security/limits.conf配置

* soft nofile 2000000

* hard nofile 2000000

* soft nproc 2000000

* hard nproc 2000000原文地址 : https://colobu.com/2014/09/18...

https://colobu.com/2015/05/22...

关注 vx golang技术实验室

获取更多好文

本文由mdnice多平台发布