2022图机器学习必读的11大研究趋势和方向: 微分方程/子图表示/图谱理论/非对称/动态性/鲁棒性/通用性/强化学习/图量子等...

来源:智源社区

本文约6900字,建议阅读10+分钟

本文为你总结了图机器学习过去一年中的研究亮点,并对该方向在 2022 年的发展趋势进行了展望。[ 导读 ]几何机器学习和基于图的机器学习是当前最热门的研究课题之一。在过去的一年中,该领域的研究发展迅猛。在本文中,几何深度学习先驱 Michael Bronstein 和 Petar Veličković 合作,采访了多位杰出的领域专家,总结了该领域过去一年中的研究亮点,并对该方向在 2022 年的发展趋势进行了展望。

作者:Michael Bronstein

牛津大学DeepMind人工智能教授、Twitter图机器学习负责人

编译:熊宇轩

一、要点概述

几何在机器学习中变得越来越重要。微分几何和同源场为机器学习研究引入了新的思想,包括利用了对称性和类似于图中的曲率的新等变图神经网络(GNN)架构,以及在深度学习模型中理解和利用不确定性。

消息传递仍然是 GNN 的主导范式。在 2020 年,研究社区意识到了消息传递 GNN 的不足之处,并寻求这种范式之外的更具表现力的架构。2021 年,很明显,消息传递仍然占据主导地位,因为有的研究工作表明,将 GNN 应用于子图可以获得更好的表达能力。

微分方程催生了新的 GNN 架构。NeuralODE 的趋势扩展到了图机器学习领域。一些工作说明了如何将 GNN 模型形式化定义为连续微分方程的离散形式。在短期内,这些工作将催生新的可以规避 GNN 中的常见问题(如过平滑和过压缩)的架构。从长远来看,我们可能会更好地理解 GNN 的工作原理,以及如何使它们更具表现力和可解释性。

信号处理、神经科学和物理学领域的旧思想焕发了新生。许多研究者认为,图信号处理重新点燃了最近对图机器学习的兴趣,并为该领域提供了第一套分析工具(例如,广义傅里叶变换和图卷积)。表征理论等其它经典信号处理和物理学中的基本技术已经在2021年取得了一些重要进展,并仍有很大的潜力。

为复杂系统建模不仅需要图。2021 年的诺贝尔物理学奖授予 Giorgio Parisi,以表彰他对复杂系统的研究。虽然,这样的系统通常可以被基本地抽象为图。但我们有时必须考虑非成对关系和动态行为等更复杂的结构。2021 年的多项工作讨论了动态关系系统,并展示了如何将 GNN 扩展到高阶结构(如传统上在代数拓扑领域处理的细胞和单纯复杂结构)。我们可能会看到机器学习更多地采用该领域的其它思想。

在图机器学习领域中,推理、公理化和泛化的问题仍然是重要的有待解决的问题。在这一年中,我们看到了受算法推理启发的 GNN 架构的持续进步,以及在图结构任务上更鲁棒的与分布外泛化(OOD)相关的工作。如今,我们有了与广义 Bellman-Ford 算法显式一致的知识图谱推理器,以及利用分布偏移的显式因果模型的图分类器。可以说,这些都是未来具有广阔前景的更鲁棒、更通用的 GNN 的发展方向。在2022年,这其中许多的课题可能将取得很大的进展。

图在强化学习中越来越流行,但可能还有很大的探索空间。也许并不令人意外的是,强化学习中存在许多有关图和对称性的问题(通常在强化学习智能体的结构中,或在对环境的表征中)。2021 年,有一些研究方向试图利用这种结构,并取得了不同程度的成功。我们现在对如何在强化学习中利用这些对称性有了更好的理解(包括在多智能体系统中)。然而,将智能体建模为图似乎不需要严格地使用图结构。尽管如此,我们相信,图和几何赋能的强化学习在 2022 年具有广阔的发展前景。

AlphaFold 2 是几何机器学习领域的重要成果,也是结构生物学领域的范式转变。20 世纪 70 年代,诺贝尔化学奖得主 Christian Anfinsen 提出了预测蛋白质三维折叠结构的可能性。这是一项非常困难的计算任务,是结构生物学领域的「圣杯」。2021年,DeepMind 的 AlphaFold 2 打破了该问题之前的纪录,取得了让领域专家们信服的准确率,并得到了广泛的应用。AlphaFold 2 的核心正是一个基于等变注意力机制的几何架构。

GNN 及其与 Transformer 模型的融合助力了药物研发和设计。实际上,GNN 的起源可以追溯到 20 世纪 90 年代的计算化学工作。因此,分子图的分析是最流行的 GNN 应用之一,也就不足为奇了。2021 年,这一领域取得了持续的显著进展,涌现出了数十个新架构和几项超越对比基准的成果。将 Transformer 应用于图数据也取得了巨大的成功,它有望模拟 Transformer 架构在自然语言处理领域成功的关键之处:能够跨任务泛化的大型预训练模型。

人工智能主导的药物发现技术越来越多地使用了几何和图机器学习。AlphaFold 2 和分子图神经网络的成功让人类距离通过人工智能设计新药的梦想更近了一步。Alphabet 的新公司 Isomorphic Labs 标志着工业界「压宝」于这项技术。然而,为了实现这类梦想,对分子间的相互作用建模是必须解决的重要前沿课题。

基于图的方法也助力了量子机器学习。对于机器学习领域的大多数专家来说,量子机器学习仍然是一个神器的小众方向,但随着量子计算硬件的逐渐普及,它很快就成为了现实。Alphabet X 最近的工作显示了图结构归纳偏置在量子机器学习架构中的优势,他们结合了这两个貌似不相关的领域。从长远来看,由于量子物理系统通常拥有丰富而深奥的群对称性,我们可以将这种性质用于量子结构设计,几何可能会扮演更重要的角色。

2021 年,几何和基于图的机器学习方法出现在一系列备受瞩目的应用中

二、几何在机器学习中的重要性与日俱增

如果我们必须选择一个词,它在 2021 年遍布图表示学习的几乎每个领域,毫无疑问,「几何」一词将是首选。

Melanie Weber:

「在过去的一年里,我们看到许多经典的几何思想以新的方式在图机器学习领域中得以应用」——Melanie Weber,牛津大学数学研究所 Hooke 研究员

Melanie 认为:值得注意的例子包括利用对称性更高效地学习模型,最优传输相关概念的应用,或在表示学习中使用微分几何中的曲率概念。

最近,人们对理解关系型数据的几何特性和利用这些信息学习良好的(欧氏或非欧)表征产生了浓厚的兴趣[1]。这催生了许多对特定几何编码的 GNN 架构。值得注意的例子是双曲 GNN 模型[2],该模型于 2019 年底作为学习层次化数据的高效表征的工具被首次提出。在过去的一年里,出现了大量的新模型和架构,它们能够更高效地学习双曲表征,或者能捕获更复杂的几何特征[3, 4]。此外,还有一类工作利用了等变性和对称性等几何信息[5]。

图注:今年,在图神经网络领域,我们看到了几何技术的激增。例如,等变信息传递在小分子性质预测、蛋白质折叠等生化应用中起到了关键作用。

Melanie 进一步研究了微分几何,指出它在 2022 年存在许多潜在的应用方向:离散微分几何(研究图或单纯复形等离散结构的几何)已被用于分析 GNN。离散曲率概念是表征离散结构局部和整体几何性质的重要工具。Topping 等人在论文「Understanding over-squashing and bottlenecks on graphs via curvature」中提出了曲率在图机器学习中的一种重要应用[6],在图重连的背景下研究离散 Ricci 曲率,作者提出了一种新的方法来缓解 GNN 中的过压缩效应。未来,离散曲率很可能与图机器学习中的其它结构和拓扑问题联系在一起。

Melanie 希望这些课题将在 2022 年继续影响该领域,被应用于更多的图机器学习任务。这可能会推动计算方面的进步,从而减轻实现非欧算法的计算挑战,传统的针对欧式数据设计的工具很难胜任这些工作。此外,离散曲率等几何工具的计算成本很高,因此很难将它们集成到大规模应用中。计算技术的进步或专用程序库的发展可以使相关从业者更容易使用这些几何思想。

Pim de Haan:

「图神经网络设计者越来越重视图丰富的对称结构。」——Pim de Haan,阿姆斯特丹大学博士生

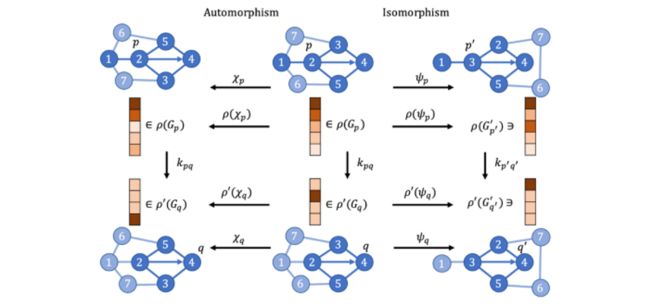

传统上,GNN 采用具有置换不变性的消息传递方式,后来的工作利用群与表示理论构造节点置换群表示之间的等变映射。最近,类比于流形的局部对称性(称为度规对称性),我们开始研究由同构子图产生的图的局部对称性。我们发现应该用对称理论而不是群分析某些图中的问题,将对称性整合到神经网络架构中可以提高某些图机器学习任务(例如,分子预测)的性能。

图注:图机器学习研究者利用图中丰富的对称结构。

Pim 预测道:在新的一年里,我希望看到范畴论成为一种广泛应用于神经网络的设计语言。这将给我们提供一种形式化的语言来讨论和利用比以前更复杂的对称。特别是,我很高兴看到它被用于处理图的局部和近似对称,结合点云的几何和组合结构,并帮助我们研究因果图的对称性。”

Francesco Di Giovanni:

「尽管图是不可微的,但是许多在流形分析中被成功应用的思想正逐渐出现在 GNN 领域中。」——Francesco Di Giovanni,Twitter 机器学习研究员

Francesco 对偏微分方程方法特别感兴趣,这种方法最初被用于研究曲面,Francesco 等人用它来处理图像。他们探索了「图重连」的思路,「图重连」指的是对底层邻接关系的修改,它属于对几何流方法的拓展。此外,他们还利用基于边的曲率的新概念来研究 GNN 中的过压缩问题,并提出了一种图重连方法。对于保持和破坏对称形式的分子,几何也被认为是将 GNN 应用于分子的关键因素。

Francesco 认为,这个领域的研究刚刚兴起。图重连技术将可能在解决消息传递的一些主要缺陷方面发挥作用,这些缺陷包括在异类数据集上的性能和处理长距离依赖关系。我们希望能很快弥平在图上的卷积和流形上的卷积之间的概念上的较大差异,这可能会导致下一代 GNN 的出现。最后,Francesco 很高兴看到几何变分方法进一步揭示了 GNN 内在的动力学,并希望能够提供更有原则的方法来设计新的 GNN 架构、比较现有的架构。

图注:Ricci 曲率、几何流等微分几何领域的概念被用于图机器学习,改进 GNN 中的信息流。

Aasa Feragen:

「人们希望通过微分几何等数学理论为那些精确的公式中存在非线性几何的问题给出有理有据的解决方案。」——Aasa Feragen,哥本哈根大学助理教授

Aasa 认为,微分几何在理解和利用深度学习模型的不确定性方面发挥着基础性的作用。例如,使用模型不确定性生成数据的几何表示,揭示在标准欧式表征下仍然十分模糊的生物信息。另一个例子是,利用由局部有向数据编码的黎曼几何对结构化的大脑连接的不确定性进行量化。

几何模型通常用于经过深度预处理的数据,揭示其几何结构。数据通常是根据原始数据估计的,而原始数据存在误差和不确定性。Aasa 希望 2022 年有更多工作开始评估原始数据的不确定性对我们直接处理的数据的影响,以及这种不确定性应该如何传播到模型上。Aasa 希望能够将测量误差纳入对非欧数据的分析,努力打破统计和深度学习之间的鸿沟。

三、消息传递仍然是 GNN 的主导范式

Haggai Maron:

「我希望子图 GNN 以及相应的重构猜想这一研究方向在新的一年里成果丰硕。」——Haggai Maron,英伟达研究科学家

由于等价于 Weisfeiler-Lehman 测试,图机器学习领域遭遇到了消息传递范式的根本限制。Michael Brostein 在 2021 年预测道:想要继续发展图机器学习,就需要脱离 2020 年及之前在占据主导地位的消息传递机制。如今,这一预测在一定程度上得以实现。然而,尽管 2021 年已经出现了一些表达能力更强的 GNN 架构,但其中大多数仍然停留在消息传递机制的范围内。

最近,一些研究者使用子图来提高 GNN 的表达能力。Haggai Maron 曾指出:「子图 GNN」底层的想法是将图表示为其子结构的集合,在 Kelly 和 Ulam 在上世纪 60 年代有关图重建猜想的工作就可以发现这一主题。如今,同样的思想被用来构造富有表达能力的 GNN,而 GNN 的相关工作反过来又催生了新的、更精细的重构猜想。

四、微分方程催生了新的 GNN 架构

图注:2021 年,一些研究工作通过离散扩散偏微分方程推导图神经网络。

Pierre Vandergheynst:

「这提出了一种新的观点,让我们可以使用 GNN 为下游机器学习任务提取有意义的信息,并将关注焦点从支撑信息的域转移到使用图作为针对信号的计算的支撑。」——Pierre Vandergheynst,洛桑联邦理工学院

通过用微分方程表示的物理系统动力学重新构建图上的学习,是 2021 年的另一个趋势。正如常微分方程是理解残差神经网络的强大工具一样(「Neural ODEs」被评为 NeurIPS 2019 的最佳论文),偏微分方程可以在图上建立信息传播的模型。我们可以通过迭代的数值计算求解这样的偏微分方程,从而恢复出许多标准的 GNN 架构。此时,我们将图看作对连续对象的离散化表示:

Pierre 认为,在 2022 年,使用图作为针对给定数据集执行局部连贯的计算、交换信息的机制,并且关注数据的整体属性,将成为一种新的趋势。这将在无监督、零样本学习领域激发人们的兴趣。

五、信号处理、神经科学和物理学领域的旧观点焕发新生

许多现代的 GNN 方法都起源于信号处理领域。图信号处理(GSP)之父 Pierre Vandergheynst 从这个角度为图机器学习方法的发展提供了一个有趣的视角:

图信号处理对数字信号处理的扩展体现在两个方面:(1)推广了支撑信息的域。传统的数字信号处理定义在低维欧式空间上,图信号处理将其定义在了复杂得多、但是结构化的对象上。我们可以用图(例如,网络、网格曲面)来表示这些对象。(2)使用图(某种最近邻),从而抛开结构化域,直接处理一些数据集,表示样本之间的相似性。这背后的思想是,标签域继承了一些可以使用图定义并通过适当转换捕获的规律。因此,图可以支撑整个数据集上的局部计算。GNN 中的一些有趣的思路可以追溯到这些早先的动机,2021 年有一些亮点工作延续了这一趋势。

Pierre Vandergheynst:

「经典线性变换(例如,傅里叶变换、小波变换)给出了一个具有某些数学特性(例如,平滑信号具有低频傅里叶系数,分段平滑信号具有稀疏、局部的小波稀疏)的通用潜空间」——Pierre Vandergheynst,洛桑联邦理工学院

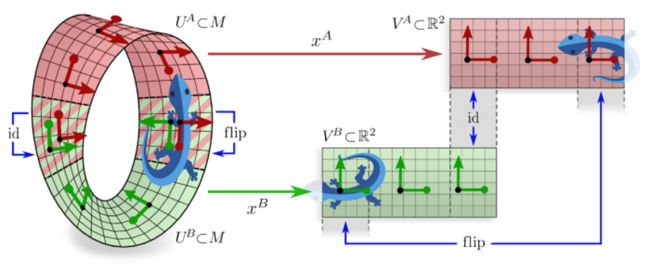

过去,研究者们通过构建线性变换来揭示信号的特性。物理学家在设计基于群作用的不同对称的等价变换方面尤为领先。这些群作用包括,仿射群上的小波变换、Weyl-Heisenberg 群的线性时频分析等。关于数学物理中相干态领域的工作提出了一种通用的解决方法:通过使用群表示对函数进行参数化,从而构建某种线性变换。2021 年,一些出色的论文进一步引入了非线性和可学习的参数化函数,赋予了 GNN 对称性,使它们在物理或化学问题中大放异彩:

图注:群表示是一种信号处理和物理学领域的传统工具,使我们可以推导出可以应用于流形的坐标无关的深度学习架构。

Pierre 认为,由于某些应用需求、适应性和可解释性之间权衡(结构化变换域适应性较差但可解释性很强,GNN 可以在二者之间取得很好的平衡),构建结构化潜空间的趋势将会在 2022 年得以延续。

在传统上,神经科学与信号处理密切相关。事实上,我们通过分析大脑传递的电信号来了解动物如何感知其周围的世界。

Kim Stachenfeld:

「我的研究背景是计算神经科学,我首次在研究中用到图是因为我希望表示任何动物如何学习结构。」——Kim Stachenfeld,DeepMind 研究科学家

我们可以通过图这种数学对象来分析任何动物如何表示通过独立的经验片段获取的相关概念,并将其拼接成一个全局连贯的、集成的知识体系。

2021 年,一些研究将神经网络的局部操作和底层或内在的集合表征相结合。例如,一些有关 GNN 中不变性的工作使 GNN 可以利用图结构以外的几何和对称性。此外,使用图拉普拉斯特征向量作为图 Transformer 的位置编码,使 GNN 可以在不受其约束的条件下,利用关于内在、低维几何性质的信息。

Kim 对 GNN 在神经科学和更广阔的领域中的应用感到十分兴奋,尤其是在超大规模真实数据上的应用。例如,使用 GNN 预测交通状况、对复杂物理动力学进行仿真、解决超大规模图上的问题。将 GNN 用于神经数据分析的工作也纷纷涌现。这些问题对现实世界产生影响,它们要求模型能够高效扩展并泛化,同时仍然能够捕获真正的复杂的动力学。GNN 的优化目标是对结构和表达能力的平衡。

六、对复杂系统建模不仅需要图

Tina Eliassi-Rad:

「2021 年诺贝尔物理学奖授予了对复杂系统的研究。从根本上说,复杂系统是由实体及其之间的交互组成的。复杂系统通常被表示为复杂网络,而这为图机器学习提供了动力。」——Tina Eliassi-Rad,东北大学教授

随着图机器学习逐渐成熟,我们需要仔细分析以不同形式体现的系统依赖(例如,子集、时间、空间),通用的数学表征(图、单纯复形、超图),它们的底层假设。没有完美的方法可以表示一个复杂系统,检验来袭一个系统的数据集时所做的建模决策可能并不一定能迁移到另一个系统上,甚至不能迁移到来自同一系统的另一个数据集上。然而,考虑与我们选择的数学表示法相关的系统依赖,为图机器学习指出了新的研究机会。

Pierre Vandergheynst:

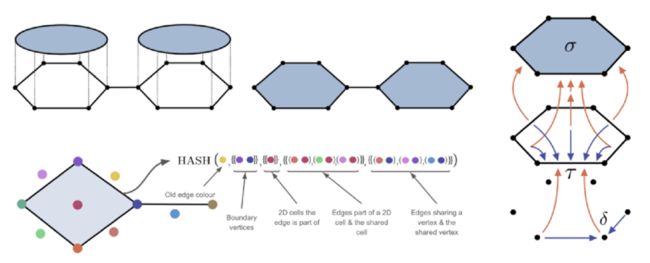

图并不能为所有的复杂系统提供适当的模型,我们需要图之外的方式。2021 年,一些优秀的论文提出了通过图的泛化获取的新的结构化信息域。使用单纯复形和代数拓扑的其它思想来构建新的神经网络在理论和实践上对 GNN 进行了提升。这一趋势在 2022 年会延续下去,我们会深入研究通过代数拓扑或微分几何提供的大量结构化数学对象。

图注:将图拓展到胞腔复形或单纯复形,可以传递更复杂的拓扑消息,从而产生超越 WL 测试表达能力的 GNN 架构。

Cristian Bodanr:

「我们很可能会看到采用更奇特的数学对象,这些数学对象迄今为止还鲜为探索。我相信这些拓扑方法降维分析和理解 GNN 提供一套新的数学工具。」——Cristian Bodnar,剑桥大学博士

Cristian Bodnar 热衷于代数研究拓扑和图机器学习之间的联系。在过去的一年中,单纯复形和胞腔复形上的卷积和消息传递模型解决了许多 GNN 的缺陷(例如,检测特定的子结构、捕获长距离和高阶交互、处理高阶特征、跳出 WL 测试的层次)。他们在分子相关的问题、轨迹预测和分类等任务中取得了目前最优的结果。

2022 年,Cristian 预计这些方法将会扩展到令人激动的新应用上,例如:计算代数拓扑、链接预测、计算机图形学,等。

Rose Yu:

「我对图机器学习在学习时空动力学中扮演的角色感到十分兴奋。」——Rose Yu,UCSD 助理教授

时空图是一种重要的复杂网络系统,它的结构会随着时间演变。Rose 认为,COVID-19 预测、交通预测、轨迹建模等应用需要捕获高度结构化的时序数据的复杂动力学。图机器学习有能力捕获时间序列、空间依赖之间的交互,以及动力学中的相关性。

2022 年,我们乐见时间序列和动态系统中的思想与图机器学习融合。希望这些思想将催生新的模型设计、训练算法,帮助我们更好地理解复杂动态系统的内在机制。图神经网络具有置换对称性(不变性或等变性),对称性发现是图表示学习领域中一个被忽视的重要问题。但这种全局对称性可能从根本上被限制,有一些优秀的工作将图神经网络推广到置换之外的对称群和局部对称中。我们希望看到更多关于图神经网络对称性的研究。

原文链接:

https://towardsdatascience.com/predictions-and-hopes-for-geometric-graph-ml-in-2022-aa3b8b79f5cc#0b34

编辑:黄继彦