JavaCV-FFmpeg软封装多线程实现录制或推送rtsp流

文章目录

- 前言

- 一、JavaCV和FFmpeg是什么?

- 二、录制和推流如何实现?

- 三、遇到的问题

- 四、如何实现

- 五、总结

前言

在一个月之前,有使用过FFmpeg录制过rtsp流的视频。但由于使用的是Frame来录制视频,会极大的消耗CPU和内存(CPU约为200%+,内存约为2.3G)。经研究得知grabber.grabFrame()会经过解码得到Frame,在record(frame)时又会通过编码生成对应的视频文件。

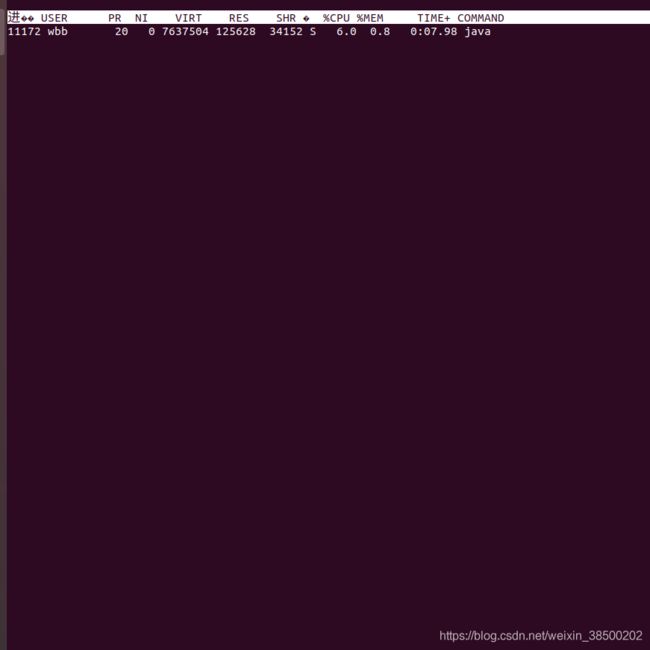

而如果使用AvPacket(转封装)来实现,在转封装的基础上还用到了多线程分别多拉流和推流进行处理。录制一个20Min的视频占用CPU约为5%,内存为200M

大概捣鼓了一个星期,终于弄好了。在此记录以下实现的方式和想法~

一、JavaCV和FFmpeg是什么?

JavaCV: Java视觉处理库,里面有很多很多的工具,包括了音视频相关的FFmpeg。可以通过JNI的方式直接调用方法

FFmpeg:Fmpeg 是领先的多媒体框架,能够解码、编码、转码、混合、解密、流媒体、过滤和播放人类和机器创造的几乎所有东西。关键FFmpeg开源!

二、录制和推流如何实现?

此处以RTSP流实现录制和推流为例

- 录制:拉流->录制,这样就可以将RTSP的流转为MP4或AVI的视频文件

- 推流:拉流->推流(推送RTMP流到nginx流媒体服务器),一般来说推一路RTMP到流媒体服务器,可以出RTMP和HttpFlv的流。这样就可以实现在浏览器通过flv.js来播放实时视频了。

实际测试,推流方式的延迟为1~2s

tips:

1.nginx本身是不支持流媒体的,要安装官方插件nginx-http-flv-module

2.在拉流的时候尽量不要做耗时操作,这会导致非常严重的调帧

3.使用FFmpeg的录制器推流时,Frame和AvPacket均可实现。Frame方便简单(无需关心PTS、DTS和帧的类型),直推即可,但因多了编解码过程性能较差。AvPacket性能好,但要考虑对齐Packet的PTS和DTS,不然无法正确推流

三、遇到的问题

1.录制的视频无法播放

A:大概率是没有正确关闭抓取器Grabber或录制器Recoder,一定要保证录制结束后先关闭grabber再关闭recoder。

2.non monotonically increasing dts to muxer in stream(流中的DTS为非递增)

第一种方法:在grabber.start()之后调用grabber.flush()。

查看源码可已发现,其实是多次抓帧进行初始化

grab方法的实现:

public void flush() throws FrameGrabber.Exception {

for(int i = 0; i < this.numBuffers + 1; ++i) {

this.grab();

}

}

实际调用的为FFmpegFrameGrabber中的grabFrame(true, true, true, false, true)方法,这样会导致丢失首个I帧关键帧,从而花屏。

第二种方法:拿到AvPacket后,自己处理PTS和DTS。目前我就是用的这种方式,具体实现可见下面代码

四、如何实现

代码我自认为还是比较规范的,应该不需要注释也能看懂~~

为了不影响拉流时因处理视频而掉帧,此处使用多线程进行了优化

1.局部变量

ExecutorService threadPool = Executors.newFixedThreadPool(3);

Semaphore semaphore = new Semaphore(0);

private static final ArrayBlockingQueue<AVPacket> blockingQueue = new ArrayBlockingQueue<>(60);

private volatile boolean stopRecording = false;

private volatile boolean stopPull = false;

2.开始录制

public void startSave(String userName, String psw, String ip, String videoOutPath) {

this.stopRecording = false;

this.stopPull = false;

String url = Tools.generateRtspUrl(userName, psw, ip);

// pull first!

threadPool.execute(() -> startPull(url, videoOutPath));

threadPool.execute(this::startRecord);

}

/**

* 开始拉流

*/

private void startPull(String url, String outPath) {

Map<Long, Long> timestampMap = new HashMap<>();

try {

VideoUtil.packetGrabberInit(url, outPath);

AVPacket packet = null;

int errIndex = 0;

while (!stopPull && errIndex < 10){

packet = VideoUtil.grabPacket();

// skip empty packet

if (packet == null || packet.size() <= 0 || packet.data() == null) {

log.info("discard empty packet");

errIndex++;

continue;

}

// check

checkPacket(timestampMap, packet);

AVPacket retPacket = avcodec.av_packet_alloc();

avcodec.av_packet_ref(retPacket, packet);

blockingQueue.put(retPacket);

log.trace(String.format("获取一帧:当前大小为%s,pts:%s, dts:%s, timestamp:%s", blockingQueue.size(), packet.pts(), packet.dts(), packet.duration()));

avcodec.av_packet_unref(packet);

}

avcodec.av_packet_free(packet);

} catch (IOException | InterruptedException e) {

e.printStackTrace();

throw new DHCameraException("pull rtsp error:" + e.getMessage());

}

}

private void startRecord( ) {

AVPacket avPacket;

try {

while(!stopRecording) {

avPacket = blockingQueue.poll(500, TimeUnit.MILLISECONDS);

if (avPacket == null) {

log.trace("queue is empty...");

continue;

}

log.trace("add one frame");

VideoUtil.recordPacket(avPacket);

}

} catch (InterruptedException | IOException e) {

e.printStackTrace();

throw new DHCameraException("record error:" + e.getMessage());

} finally {

try {

VideoUtil.release();

semaphore.release();

log.trace("discard frame size:" + blockingQueue.size());

} catch (FrameRecorder.Exception | FrameGrabber.Exception e) {

e.printStackTrace();

}

}

}

3.停止录制

public void stopSave() {

// stop pull first

this.stopPull = true;

try {

log.trace("acquire semaphore");

this.stopRecording = true;

semaphore.acquire();

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

blockingQueue.clear();

}

}

4.测试(录制20分钟)

@Test

public void saveVideoTest() throws InterruptedException {

c.startSave(userName, psw, ip, new Date() + "_rtsp.mp4");

Thread.sleep(20 * 60 * 1000);

c.stopSave();

}

4.实际效果(录制20分钟)

实际测试的效果还是不错的,录制的视频截图如下所示(已打码)

五、总结

在实现的过程中参考了许多博主的博文,不禁感叹JavaCV和FFmpeg相关的资料是真的少啊,书写不易,不妨给我点个❤吧~感谢以下博文,链接如下:

- https://www.banmajio.com/post/5b6e30dc.html

- https://www.cnblogs.com/yangxiayi1987/p/13223063.html?utm_source=tuicool

- https://blog.csdn.net/leixiaohua1020/article/details/18893769

- https://zhuanlan.zhihu.com/p/61747783

- https://blog.csdn.net/u012587637/article/details/80092527

- https://blog.csdn.net/BrookIcv/article/details/53490799

- https://blog.csdn.net/eguid_1/article/details/83663035

- https://blog.csdn.net/asd54090/article/details/80920487

- https://juejin.cn/post/6844903839091392525