JVM内存与垃圾回收篇

来自尚硅谷宋红康的JVM视频

一,JVM与Java体系结构

1,前言

作为Java工程师的你曾被伤害过吗?你是否也遇到过这些问题?

-

运行着的线上系统突然卡死,系统无法访问,甚至直接OOM

-

想解决线上JVM GC问题,但却无从下手

-

新项目上线,对各种JVM参数设置一脸茫然,直接默认吧然后就JJ了

-

每次面试之前都要重新背一遍JVM的一些原理概念性的东西,然而面试官却经常问你在实际项目中如何调优VM参数,如何解决GC、OOM等问题,一脸懵逼

我们大部分的程序员都只用上层的一些技术,可以熟练的使用各种框架,但是对于Java的核心Java虚拟机了解甚少。因为很多人认为只有上层的技术才是我们应该研究和钻研的,对于底层的实现并不在乎,这其实是一种快节奏社会的一种病态。

如果我们把核心类库的API比做数学公式的话,那么Java虚拟机的知识就好比公式的推导过程。

计算机系统体系对我们来说越来越远,在不了解底层实现方式的前提下,通过高级语言很容易编写程序代码。但事实上计算机并不认识高级语言。

我们为什么要学习JVM?

-

面试的需要(BATJ、TMD,PKQ等面试都爱问)

-

中高级程序员必备技能

- 项目管理、调优的需求

-

追求极客的精神

- 比如:垃圾回收算法、JIT、底层原理

Java vs C++

它们都是面向对象的语言,其最大的不同在于Java是因为有虚拟机的缘故,他是动态的分配内存,有着垃圾回收机制,不需要我们手动创建和删除内存。极大的节约了我们开发的效率。但是由于垃圾回收机制不是万能的,所以我们在一些大型项目中,必须要了解JVM内部的结构,工作机制,才能设计出高扩展性应用以及出现问题是可以及时解决。

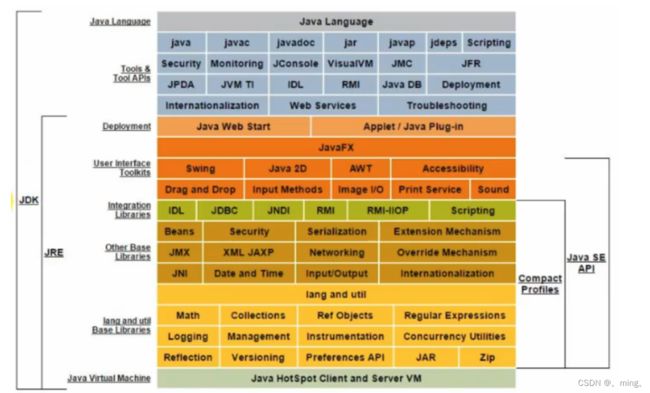

2,Java及JVM简介

TIOBE语言热度排行榜:index | TIOBE - The Software Quality Company

![]()

JVM:跨语言的平台

Java是目前应用最为广泛的软件开发平台之一。随着Java以及Java社区的不断壮大Java 也早已不再是简简单单的一门计算机语言了,它更是一个平台、一种文化、一个社区。

-

作为一个平台,Java虚拟机扮演着举足轻重的作用

- Groovy、Scala、JRuby、Kotlin等都是Java平台的一部分

-

作为灯种文化,Java几乎成为了“开源”的代名词。

-

第三方开源软件和框架。如Tomcat、Struts,MyBatis,Spring等。

-

就连JDK和JVM自身也有不少开源的实现,如openJDK、Harmony。

-

-

作为一个社区,Java拥有全世界最多的技术拥护者和开源社区支持,有数不清的论坛和资料。从桌面应用软件、嵌入式开发到企业级应用、后台服务器、中间件,都可以看到Java的身影。其应用形式之复杂、参与人数之众多也令人咋舌。

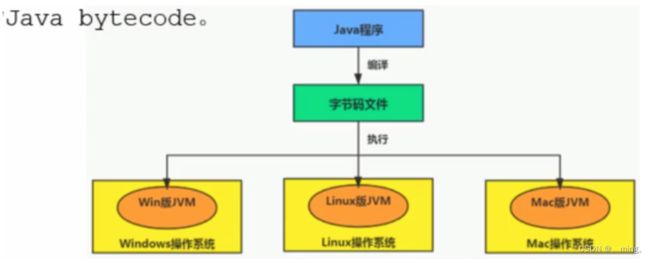

每个语言都需要转换成字节码文件,最后转换的字节码文件都能通过Java虚拟机进行运行和处理

-

随着Java7的正式发布,Java虚拟机的设计者们通过JSR-292规范基本实现在Java虚拟机平台上运行非Java语言编写的程序。

-

Java虚拟机根本不关心运行在其内部的程序到底是使用何种编程语言编写的,它只关心“字节码”文件。也就是说Java虚拟机拥有语言无关性,并不会单纯地与Java语言“终身绑定”,只要其他编程语言的编译结果满足并包含Java虚拟机的内部指令集、符号表以及其他的辅助信息,它就是一个有效的字节码文件,就能够被虚拟机所识别并装载运行。

-

因此Java虚拟机被称为最强大的虚拟机。

字节码

-

我们平时说的java字节码,指的是用java语言编译成的字节码。准确的说任何能在jvm平台上执行的字节码格式都是一样的。所以应该统称为:jvm字节码。

-

不同的编译器,可以编译出相同的字节码文件,字节码文件也可以在不同的JVM上运行。

-

Java虚拟机与Java语言并没有必然的联系,它只与特定的二进制文件格式—Class文件格式所关联,Class文件中包含了Java虚拟机指令集(或者称为字节码、Bytecodes)和符号表,还有一些其他辅助信息。

多语言混合编程

-

Java平台上的多语言混合编程正成为主流,通过特定领域的语言去解决特定领域的问题是当前软件开发应对日趋复杂的项目需求的一个方向。

-

试想一下,在一个项目之中,并行处理用Clojure语言编写,展示层使用JRuby/Rails,中间层则是Java,每个应用层都将使用不同的编程语言来完成,而且,接口对每一层的开发者都是透明的,各种语言之间的交互不存在任何困难,就像使用自己语言的原生API一样方便,因为它们最终都运行在一个虚拟机之上。

-

对这些运行于Java虚拟机之上、Java之外的语言,来自系统级的、底层的支持正在迅速增强,以JSR-292为核心的一系列项目和功能改进(如Da Vinci Machine项目、Nashorn引擎、InvokeDynamic指令、java.lang.invoke包等),推动Java虚拟机从“Java语言的虚拟机”向 “多语言虚拟机”的方向发展。

-

这也就是Java比较火的原因之一,现在很多项目都是微服务,SpringCloud将这种多语言编程的思维发挥到了极致。

3, Java发展的重大事件

-

1990年,在Sun计算机公司中,由Patrick Naughton、MikeSheridan及James Gosling领导的小组Green Team,开发出的新的程序语言,命名为oak,后期命名为Java

-

1995年,Sun正式发布Java和HotJava产品,Java首次公开亮相。

-

1996年1月23日,Sun Microsystems发布了JDK 1.0。

-

1998年,JDK1.2版本发布。同时,sun发布了JSP/Servlet、EJB规范,以及将Java分成了J2EE、J2SE和J2ME。这表明了Java开始向企业、桌面应用和移动设备应用3大领域挺进。

-

2000年,JDK1.3发布,Java HotSpot Virtual Machine正式发布,成为Java的默认虚拟机。

-

2002年,JDK1.4发布,古老的Classic虚拟机退出历史舞台。

-

2003年年底,Java平台的Scala正式发布,同年Groovy也加入了Java阵营。

-

2004年,JDK1.5发布。同时JDK1.5改名为JavaSE5.0。

-

2006年,JDK6发布。同年,Java开源并建立了OpenJDK。顺理成章,Hotspot虚拟机也成为了openJDK中的默认虚拟机。

-

2007年,Java平台迎来了新伙伴Clojure。

-

2008年,Oracle收购了BEA,得到了JRockit虚拟机。

-

2009年,Twitter宣布把后台大部分程序从Ruby迁移到Scala,这是Java平台的又一次大规模应用。

-

2010年,Oracle收购了Sun,获得Java商标和最具价值的HotSpot虚拟机。此时,Oracle拥有市场占用率最高的两款虚拟机HotSpot和JRockit,并计划在未来对它们进行整合:HotRockit

-

2011年,JDK7发布。在JDK1.7u4中,正式启用了新的垃圾回收器G1。

-

2017年,JDK9发布。将G1设置为默认Gc,替代CMS

-

同年,IBM的J9开源,形成了现在的Open J9社区

-

2018年,Android的Java侵权案判决,Google赔偿Oracle计88亿美元

-

同年,Oracle宣告JavaEE成为历史名词JDBC、JMS、Servlet赠予Eclipse基金会

-

同年,JDK11发布,LTS版本的JDK,发布革命性的ZGC,调整JDK授权许可

-

2019年,JDK12发布,加入RedHat领导开发的shenandoah GC

在JDK11之前,OracleJDK中还会存在一些OpenJDK中没有的、闭源的功能。但在JDK11中,我们可以认为OpenJDK和OracleJDK代码实质上已经完全一致的程度。

不过,主流的 JDK 8 在2019年01月之后就被宣布停止更新了。另外, JDK 11 及以后的版本也不再提供免费的长期支持(LTS),而且 JDK 15 和 JDK 16 也不是一个长期支持的版本,最新的 JDK 15 只支持 6 个月时间,到 2021 年 3 月,所以千万不要把 JDK 15 等非长期支持版本用在生产。

商用版和开源版本的区别在于,商用版没有一个长期支持的版本,他只要有新的版本你就必须去更新,但是这样他会有很多新的功能,其安全性也更高,可能你在开源版本上报错,商用版本上不报错。

4,虚拟机与Java虚拟机

虚拟机

所谓虚拟机(Virtual Machine),就是一台虚拟的计算机。它是一款软件,用来执行一系列虚拟计算机指令。大体上,虚拟机可以分为系统虚拟机和程序虚拟机。

-

大名鼎鼎的Visual Box,Mware就属于系统虚拟机,它们完全是对物理计算机的仿真,提供了一个可运行完整操作系统的软件平台。

-

程序虚拟机的典型代表就是Java虚拟机,它专门为执行单个计算机程序而设计,在Java虚拟机中执行的指令我们称为Java字节码指令。

无论是系统虚拟机还是程序虚拟机,在上面运行的软件都被限制于虚拟机提供的资源中。

Java虚拟机

-

Java虚拟机是一台执行Java字节码的虚拟计算机,它拥有独立的运行机制,其运行的Java字节码也未必由Java语言编译而成。

-

JVM平台的各种语言可以共享Java虚拟机带来的跨平台性、优秀的垃圾回器,以及可靠的即时编译器。

-

Java技术的核心就是Java虚拟机(JVM,Java Virtual Machine),因为所有的Java程序都运行在Java虚拟机内部。

作用

- Java虚拟机就是二进制字节码的运行环境,负责装载字节码到其内部,解释/编译为对应平台上的机器指令执行。每一条Java指令,Java虚拟机规范中都有详细定义,如怎么操作数,怎么处理作数,处理结果放在哪里。

特点

-

一次编译,到处运行

-

自动内存管理

-

自动垃圾回收机制(担忧,因为不需要去考虑回收的原理,长期的自动化会导致如果出现内存溢出是Java程序员无法解决)

JVM的位置

JVM是运行在操作系统之上的,它与硬件没有直接的交互(JVM是有不同系统区别的)

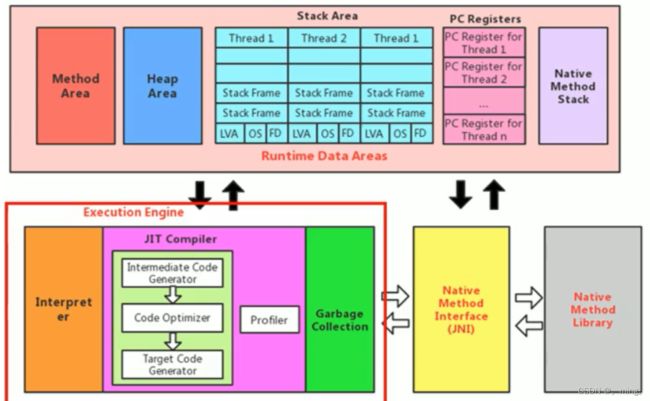

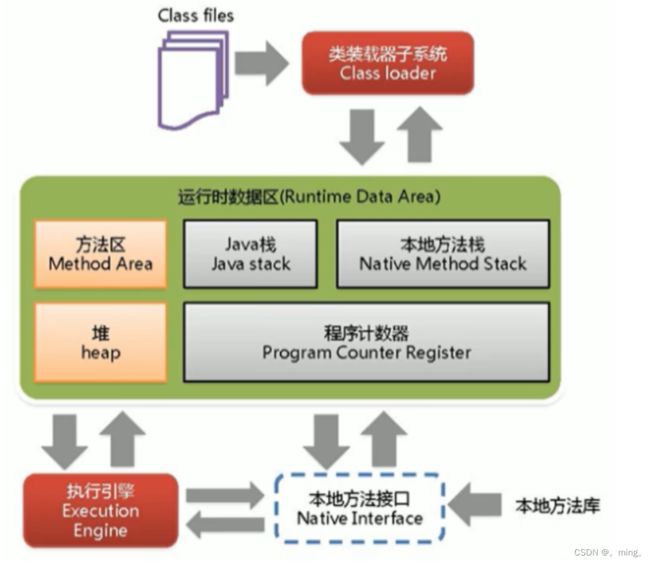

5,JVM的整体结构

-

HotSpot VM是目前市面上高性能虚拟机的代表作之一。

-

它采用解释器与即时编译器并存的架构。

-

在今天,Java程序的运行性能早已脱胎换骨,已经达到了可以和C/C++程序一较高下的地步。

6, Java代码执行流程

- Java的代码经过Java编译器变成了Java虚拟机可以识别字节码文件。

- 字节码文件再进过Java虚拟机变成了操作系统可以识别的机器指令。

- 操作系统再根据相关的机器指令做出对应的操作。

注意:

- 现在很多的虚拟机都是解释和编译并行的,在以前只有解释器的时候,我们发现其效率不太高,这也是早起Java的缺陷,但是人们发现很多的代码都是重复的,所以就多了一个编译器,去将一些热点代码保存到缓存中,这样子需要的时候直接去拿不用再通过解释器大大提高了效率。这也是为什么说Java是一门解释和编译并存的语言的原因所在。

7,JVM的架构模型

Java编译器输入的指令流基本上是一种基于栈的指令集架构,另外一种指令集架构则是基于寄存器的指令集架构。

具体来说:这两种架构之间的区别:

基于栈式架构的特点

-

设计和实现更简单,适用于资源受限的系统

-

避开了寄存器的分配难题:使用零地址指令方式分配

-

指令流中的指令大部分是零地址指令,其执行过程依赖于操作栈。指令集更小,编译器容易实现

-

不需要硬件支持,可移植性更好,更好实现跨平台

基于寄存器架构的特点

-

典型的应用是x86的二进制指令集:比如传统的PC以及Android的Davlik虚拟机

-

指令集架构则完全依赖硬件,可移植性差

-

性能优秀和执行更高效

-

花费更少的指令去完成一项操作

-

在大部分情况下,基于寄存器架构的指令集往往都以一地址指令、二地址指令和三地址指令为主,而基于栈式架构的指令集却是以零地址指令为主

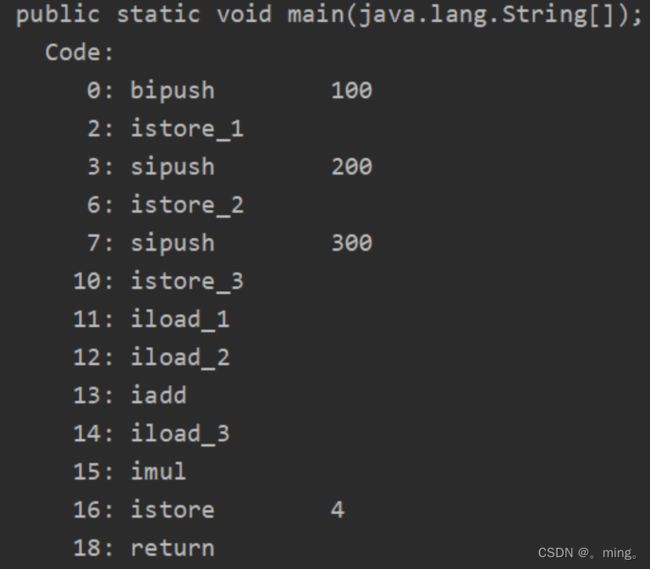

举例说明

package chapter1;

/**

* @version v1.0

* @ProjectName: JVM代码

* @ClassName: Test

* @Description: 栈操作的指令

* @Author: 赵先生

* @Date: 2022/1/27 16:32

*/

public class Test {

public static void main(String[] args) {

int a=100;

int b=200;

int c=300;

int d=(a + b) * c;

}

}

对于上述代码而言,使用栈操作的话,步骤如下(找到字节码文件,用javap -c 文件名):

而用寄存器的几步就可以完成。

总结:

由于跨平台性的设计,Java的指令都是根据栈来设计的。不同平台CPU架构不同,所以不能设计为基于寄存器的。优点是跨平台,指令集小,编译器容易实现,缺点是性能下降,实现同样的功能需要更多的指令。

8,JVM的生命周期

虚拟机的启动

Java虚拟机的启动是通过引导类加载器(bootstrap class loader)创建一个初始类(initial class)来完成的,这个类是由虚拟机的具体现指定的。

虚拟机的执行

-

一个运行中的Java虚拟机有着一个清晰的任务:执行Java程序。

-

程序开始执行时他才运行,程序结束时他就停止。

-

执行一个所谓的Java程序的时候,真真正正在执行的是一个叫做Java虚拟机的进程

虚拟机的退出

有如下的几种情况:

-

程序正常执行结束

-

程序在执行过程中遇到了异常或错误而异常终止

-

由于操作系统用现错误而导致Java虚拟机进程终止

-

某线程调用Runtime类或system类的exit方法,或Runtime类的halt方法,并且Java安全管理器也允许这次exit或halt操作。

-

除此之外,JNI(Java Native Interface)规范描述了用JNI Invocation API来加载或卸载 Java虚拟机时,Java虚拟机的退出情况。

9, JVM的发展历程

Sun Classic VM

-

早在1996年Java1.0版本的时候,Sun公司发布了一款名为sun classic VM的Java虚拟机,它同时也是世界上第一款商用Java虚拟机,JDK1.4时完全被淘汰。

-

这款虚拟机内部只提供解释器。现在还有及时编译器,因此效率比较低,而及时编译器会把热点代码缓存起来,那么以后使用热点代码的时候,效率就比较高。

-

如果使用JIT编译器,就需要进行外挂。但是一旦使用了JIT编译器,JIT就会接管虚拟机的执行系统。解释器就不再工作。解释器和编译器不能配合工作。

-

现在hotspot内置了此虚拟机。

Exact VM

-

为了解决上一个虚拟机问题,jdk1.2时,Sun提供了此虚拟机。

-

Exact Memory Management:准确式内存管理

-

- 也可以叫Non-Conservative/Accurate Memory Management

-

- 虚拟机可以知道内存中某个位置的数据具体是什么类型。

-

具备现代高性能虚拟机的维形

-

- 热点探测

-

- 编译器与解释器混合工作模式

-

只在solaris平台短暂使用,其他平台上还是classic vm

-

- 英雄气短,终被Hotspot虚拟机替换

HotSpot VM

-

HotSpot历史

-

- 最初由一家名为“Longview Technologies”的小公司设计

-

- 1997年,此公司被sun收购;2009年,Sun公司被甲骨文收购。

-

- JDK1.3时,HotSpot VM成为默认虚拟机

-

目前Hotspot占有绝对的市场地位,称霸武林。

-

- 不管是现在仍在广泛使用的JDK6,还是使用比例较多的JDK8中,默认的虚拟机都是HotSpot

-

- Sun / Oracle JDK 和 OpenJDK 的默认虚拟机

-

- 因此本课程中默认介绍的虚拟机都是HotSpot,相关机制也主要是指HotSpot的Gc机制。(比如其他两个商用虚机都没有方法区的概念)

-

从服务器、桌面到移动端、嵌入式都有应用。

-

名称中的HotSpot指的就是它的热点代码探测技术。

-

- 通过计数器找到最具编译价值代码,触发即时编译或栈上替换

-

- 通过编译器与解释器协同工作,在最优化的程序响应时间与最佳执行性能中取得平衡

JRockit

-

专注于服务器端应用

-

- 它可以不太关注程序启动速度,因此JRockit内部不包含解析器实现,全部代码都靠即时编译器编译后执行。

-

大量的行业基准测试显示,JRockit JVM是世界上最快的JVM。

-

- 使用JRockit产品,客户已经体验到了显著的性能提高(一些超过了70%)和硬件成本的减少(达50%)。

-

优势:全面的Java运行时解决方案组合

-

- JRockit面向延迟敏感型应用的解决方案JRockit Real Time提供以毫秒或微秒级的JVM响应时间,适合财务、军事指挥、电信网络的需要

-

- MissionControl服务套件,它是一组以极低的开销来监控、管理和分析生产环境中的应用程序的工具。

-

2008年,JRockit被oracle收购。

-

Oracle表达了整合两大优秀虚拟机的工作,大致在JDK8中完成。整合的方式是在HotSpot的基础上,移植JRockit的优秀特性。

-

高斯林:目前就职于谷歌,研究人工智能和水下机器人

IBM的J9

-

全称:IBM Technology for Java Virtual Machine,简称IT4J,内部代号:J9

-

市场定位与HotSpot接近,服务器端、桌面应用、嵌入式等多用途VM

-

广泛用于IBM的各种Java产品。

-

目前,有影响力的三大商用虚拟机之一,也号称是世界上最快的Java虚拟机。

-

2017年左右,IBM发布了开源J9VM,命名为openJ9,交给EClipse基金会管理,也称为Eclipse OpenJ9

KVM和CDC / CLDC Hotspot

-

Oracle在Java ME产品线上的两款虚拟机为:CDC/CLDC HotSpot Implementation VM

-

KVM(Kilobyte)是CLDC-HI早期产品

-

目前移动领域地位尴尬,智能机被Android和iOS二分天下。

-

KVM简单、轻量、高度可移植,面向更低端的设备上还维持自己的一片市场

-

- 智能控制器、传感器

-

- 老人手机、经济欠发达地区的功能手机

-

所有的虚拟机的原则:一次编译,到处运行。

Azul VM

-

前面三大“高性能Java虚拟机”使用在通用硬件平台上这里Azul VW和BEA Liquid VM是与特定硬件平台绑定、软硬件配合的专有虚拟机

-

- 高性能Java虚拟机中的战斗机。

-

Azul VM是Azul Systems公司在HotSpot基础上进行大量改进,运行于Azul Systems公司的专有硬件Vega系统上的Java虚拟机。

-

每个Azul VM实例都可以管理至少数十个CPU和数百GB内存的硬件资源,并提供在巨大内存范围内实现可控的GC时间的垃圾收集器、专有硬件优化的线程调度等优秀特性。

-

2010年,AzulSystems公司开始从硬件转向软件,发布了自己的Zing JVM,可以在通用x86平台上提供接近于Vega系统的特性。

Liquid VM

-

高性能Java虚拟机中的战斗机。

-

BEA公司开发的,直接运行在自家Hypervisor系统上

-

Liquid VM即是现在的JRockit VE(Virtual Edition),Liquid VM不需要操作系统的支持,或者说它自己本身实现了一个专用操作系统的必要功能,如线程调度、文件系统、网络支持等。

-

随着JRockit虚拟机终止开发,Liquid vM项目也停止了。

Apache Harmony

-

Apache也曾经推出过与JDK1.5和JDK1.6兼容的Java运行平台Apache Harmony。

-

它是IBM和Intel联合开发的开源JVM,受到同样开源的OpenJDK的压制,Sun坚决不让Harmony获得JCP认证,最终于2011年退役,IBM转而参与OpenJDK

-

虽然目前并没有Apache Harmony被大规模商用的案例,但是它的Java类库代码吸纳进了Android SDK。

Micorsoft JVM

-

微软为了在IE3浏览器中支持Java Applets,开发了Microsoft JVM。

-

只能在Windows平台下运行。但确是当时Windows下性能最好的Java VM。

-

1997年,Sun以侵犯商标、不正当竞争罪名指控微软成功,赔了Sun很多钱。微软WindowsXP SP3中抹掉了其VM。现在Windows上安装的jdk都是HotSpot。

Taobao JVM

-

由AliJVM团队发布。阿里,国内使用Java最强大的公司,覆盖云计算、金融、物流、电商等众多领域,需要解决高并发、高可用、分布式的复合问题。有大量的开源产品。

-

基于OpenJDK 开发了自己的定制版本AlibabaJDK,简称AJDK。是整个阿里Java体系的基石。

-

基于OpenJDK Hotspot VM发布的国内第一个优化、深度定制且开源的高性能服务器版Java虚拟机。

-

- 创新的GCIH(GC invisible heap)技术实现了off-heap,即将生命周期较长的Java对象从heap中移到heap之外,并且GC不能管理GCIH内部的Java对象,以此达到降低GC的回收频率和提升GC的回收效率的目的。

-

- GCIH中的对象还能够在多个Java虚拟机进程中实现共享

-

- 使用crc32指令实现JVM intrinsic 降低JNI 的调用开销

-

- PMU hardware 的Java profiling tool 和诊断协助功能

-

- 针对大数据场景的ZenGc

-

taobao vm应用在阿里产品上性能高,硬件严重依赖intel的cpu,损失了兼容性,但提高了性能

-

- 目前已经在淘宝、天猫上线,把oracle官方JvM版本全部替换了。

Dalvik VM

-

谷歌开发的,应用于Android系统,并在Android2.2中提供了JIT,发展迅猛。

-

Dalvik VM只能称作虚拟机,而不能称作“Java虚拟机”,它没有遵循 Java虚拟机规范,不能直接执行Java的Class文件

-

基于寄存器架构,不是jvm的栈架构。

-

执行的是编译以后的dex(Dalvik Executable)文件。执行效率比较高。

-

- 它执行的dex(Dalvik Executable)文件可以通过class文件转化而来,使用Java语法编写应用程序,可以直接使用大部分的Java API等。

-

Android 5.0使用支持提前编译(Ahead of Time Compilation,AoT)的ART VM替换Dalvik VM。

Graal VM

-

2018年4月,oracle Labs公开了Graal VM,号称 “Run Programs Faster Anywhere”,野心勃勃。与1995年java的”write once,run anywhere"遥相呼应。

-

Graal VM在HotSpot VM基础上增强而成的跨语言全栈虚拟机,可以作为“任何语言” 的运行平台使用。语言包括:Java、Scala、Groovy、Kotlin;C、C++、Javascript、Ruby、Python、R等

-

支持不同语言中混用对方的接口和对象,支持这些语言使用已经编写好的本地库文件

-

工作原理是将这些语言的源代码或源代码编译后的中间格式,通过解释器转换为能被Graal VM接受的中间表示。Graal VM提供Truffle工具集快速构建面向一种新语言的解释器。在运行时还能进行即时编译优化,获得比原生编译器更优秀的执行效率。

-

如果说HotSpot有一天真的被取代,Graal VM希望最大。但是Java的软件生态没有丝毫变化。

总结

具体JVM的内存结构,其实取决于其实现,不同厂商的JVM,或者同一厂商发布的不同版本,都有可能存在一定差异。主要以Oracle HotSpot VM为默认虚拟机。

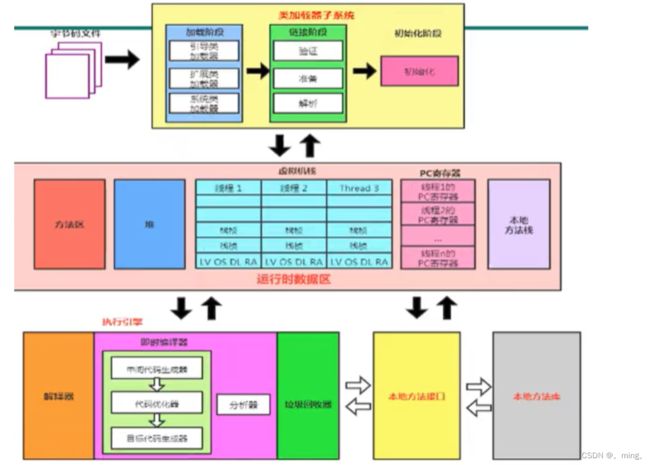

二,类加载子系统

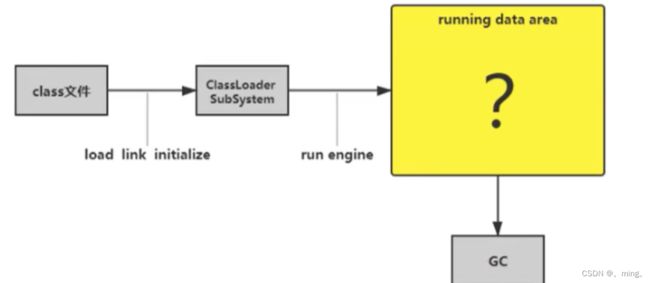

1,内存结构概述

-

Class文件

-

类加载子系统

-

运行时数据区

-

方法区

-

堆

-

程序计数器

-

虚拟机栈

-

本地方法栈

-

-

执行引擎

-

本地方法接口

-

本地方法库

如果自己想手写一个Java虚拟机的话,主要考虑哪些结构呢?

-

类加载器(转化为虚拟机可以识别的字节码文件)

-

执行引擎

2,类加载器与类的加载过程

类加载器子系统作用

- 类加载器子系统负责从文件系统或者网络中加载Class文件,class文件在文件开头都有特定的文件标识。

- ClassLoader只负责class文件的加载,至于他是否可以运行,则是由Execution Engine决定。

- 加载的类信息存放于一块称为方法区的内存空间。除了类信息外,方法区中还会有存放运行时常量信息,可能还包含字符串字面量和数字常量(这部分常量信息是Class文件中常量池部分的内存映射)

- 我自己的理解:类加载器是从硬盘中找到.class文件(是通过特定文件标识找),然后以二进制流的形式加载到内存中,当一个类被加载后,他是否能够运行是有执行引擎去负责的,和类加载器没有关系。且我们加载进去的类的信息都存放在方法区中,同时方法区中还有运行时常量信息等信息。如果实例化对象了,他们这个对象存放到堆中,但是对象的引用在栈里面。

类加载器ClasLoader角色

- class file存在于本地硬盘上,可以理解为设计师画在纸上的模板,而最终这个模板在执行的时候是要加载到JVM当中来根据这个文件实例化出n个一模一样的实例。

- class file加载到JVM中,被称为DNA元数据模板,存放在方法区,

- 在.class文件-> JVM->最终成为元数据模板,此过程需要一个运输根据(类加载器Class Loader),扮演一个快递员的角色。

类的加载过程

/**

*示例代码

*/

public class HelloLoader {

public static void main(String[] args) {

System.out.println("Hello World!");

}

}

用流程图表示上述示例代码:

![]()

加载阶段

- 通过一个类的全限定明获取定义次此类的二进制字节流

- 将这个字节流所代表的静态存储结构转化为方法区的运行时数据结构。

- 在内存中存放一个代表这个类的java.lang.Class对象,作为方法区这个类的各种数据的访问入口。(也就是说,Class对象是在加载阶段就生成的)

补充:加载class文件的方式

-

从本地系统中直接加载

-

通过网络获取,典型场景:Web Applet

-

从zip压缩包中读取,成为日后jar、war格式的基础

-

运行时计算生成,使用最多的是:动态代理技术

-

由其他文件生成,典型场景:JSP应用

-

从专有数据库中提取.class文件,比较少见

-

从加密文件中获取,典型的防Class文件被反编译的保护措施

链接阶段

- 验证(Verify):

- 目的在子确保Class文件的字节流文件包含信息符合当前虚拟机的要求,保证被加载类的正确性,不会危害到虚拟机自身安全。

- 主要包括四种验证:文件格式验证,元数据验证,字节码验证,符号引用验证。

- 准备(Prepare):

- 为类变量分配内存并设置该变量的默认初始值,例如:int类型为0。

- 这里是指的是变量,如果是常量就直接赋值,即显示初始化。例如:用final修饰的static值。

- 这里不会为实例变量分配初始化,类变量会在分配方法区中,而实例变量是会随着对象一起分配到堆中。

- 解析(Resolve)

- 将常量池捏的符号引用转化为直接引用的过程。

- 事实上,解析操作往往会伴随着JVM在执行完初始化之后在执行。

- 符号引用就是一组符号来描述所引用的目标。符号引用的字面量形式明确定义在《java虚拟机规范》的Class文件格式中。直接引用就是直接指向目标的指针、相对偏移量或一个间接定位到目标的句柄。

- 解析动作主要针对类或接口、字段、类方法、接口方法、方法类型等。对应常量池中的CONSTANT_Class_info,CONSTANT_Fieldref_info、CONSTANT_Methodref_info等。

初始化阶段

- 初始化阶段就是执行类构造方法()的过程

- 此方法不需要定义,,是javac编译器自动收集类中的所有类变量的赋值动作和静态代码块中的语句合并而来的。(如果没有静态代码就没有

() - 构造器方法中指令按照语句在源文件中出现的顺序执行。

() - 若该类有父类,JVM会保证子类的

() () - 虚拟机必须保证一个类的()方法在多线程下被同步加锁。

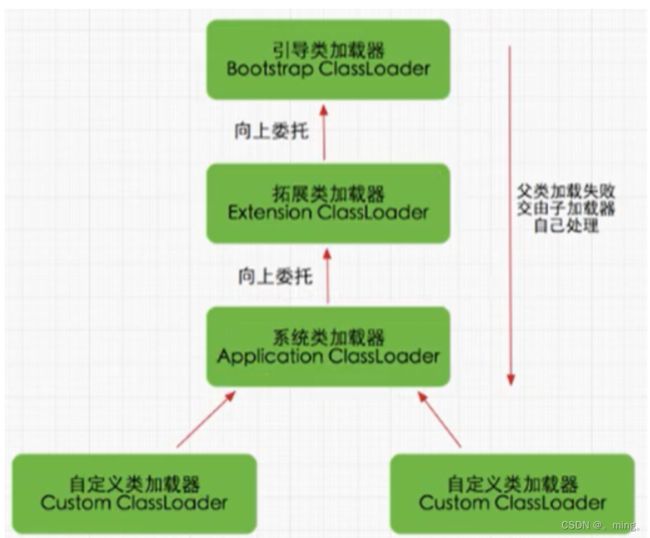

3,类加载器分类

JVM支持两种类型的类加载器。分别为引导类加载器(Bootstrap ClassLoader)和自定义加载器(User-Defined ClassLoader)。

从概念上讲,自定义类加载器一般是指程序员中有开发人员自定义的一类类加载器,但是Java虚拟机规范却没有这么定义,而是将所有派生于抽象类ClassLoader的类加载器都划分为自定义类加载器。

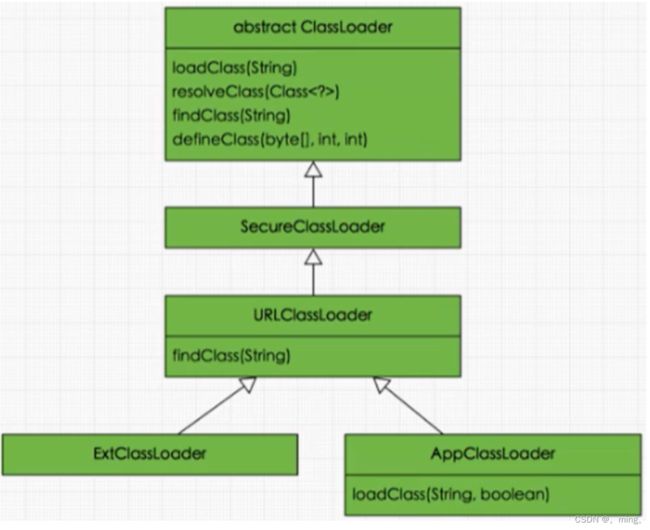

无论类加载器如何划分,在程序中我们最常见的类加载器只有三种,如图所示:

- Bootstrap ClassLoader:引导类加载器

- Extension ClassLoader:扩展类加载器

- System ClassLoader:系统类加载器

- User Defined ClassLoader:用户自定义加载器

- 这里的四者之间的关系是包含关系。不是上层下层,也不是子父类的继承关系。

3.1,虚拟机自带的加载器

启动类加载器(引导类加载器,Bootstrap ClassLoader)

-

这个类加载使用C/C++语言实现的,嵌套在JVM内部。

-

它用来加载Java的核心库(JAVA_HOME/jre/lib/rt.jar、resources.jar或sun.boot.class.path路径下的内容),用于提供JVM自身需要的类

-

并不继承自Java.lang.ClassLoader,没有父加载器。(因为他是c写的所以不存在这些)

-

加载扩展类和应用程序类加载器,并指定为他们的父类加载器。

-

出于安全考虑,Bootstrap启动类加载器只加载包名为java、javax、sun等开头的类

扩展类加载器(Extension ClassLoader)

-

Java语言编写,由sun.misc.Launcher$ExtClassLoader实现。

-

派生于ClassLoader类

-

父类加载器为启动类加载器

-

从java.ext.dirs系统属性所指定的目录中加载类库,或从JDK的安装目录的jre/1ib/ext子目录(扩展目录)下加载类库。如果用户创建的JAR放在此目录下,也会自动由扩展类加载器加载。

应用程序类加载器(系统类加载器,AppClassLoader)

-

java语言编写,由sun.misc.LaunchersAppClassLoader实现

-

派生于ClassLoader类

-

父类加载器为扩展类加载器

-

它负责加载环境变量classpath或系统属性java.class.path指定路径下的类库

-

该类加载是程序中默认的类加载器,一般来说,Java应用的类都是由它来完成加载

-

通过ClassLoader#getSystemclassLoader() 方法可以获取到该类加载器

package chapter1;

import com.sun.tracing.Provider;

import sun.misc.Launcher;

import java.net.URL;

/**

* @version v1.0

* @ProjectName: JVM代码

* @ClassName: ClassLoaderTest1

* @Description: 启动类加载器和扩展类加载器

* @Author: 赵先生

* @Date: 2022/1/30 16:37

*/

public class ClassLoaderTest1 {

public static void main(String[] args) {

System.out.println("*********启动类加载器***********");

//获取启动类加载器能够加载的路径

URL[] urLs = Launcher.getBootstrapClassPath().getURLs();

for (URL urL : urLs) {

//到外部形式file:/C:/Program%20Files/Java/jdk1.8.0_281/jre/lib/rt.jar

System.out.println(urL.toExternalForm());

}

//从上面的路径中随意选择一个类,看它的加载器是什么。若是为空则是启动类加载器(引导类加载器)

ClassLoader classLoader = Provider.class.getClassLoader();

System.out.println(classLoader);

System.out.println("*********扩展类加载器**************");

//获取属性

String extDirs = System.getProperty("java.ext.dirs");

for (String path : extDirs.split(";")) {

//得到的值是扩展类加载器能够加载的路径

System.out.println(path);

}

}

}

3.2,用户自定义类加载器

在Java的日常应用程序开发中,类的加载几乎是由上述3种类加载器相互配合执行的,在必要时,我们还可以自定义类加载器,来定制类的加载方式。 为什么要自定义类加载器?

-

隔离加载类

-

修改类加载的方式

-

扩展加载源

-

防止源码泄漏

用户自定义类加载器实现步骤:

- 开发人员可以通过继承抽象类ava.lang.ClassLoader类的方式,实现自己的类加载器,以满足一些特殊的需求

- 在JDK1.2之前,在自定义类加载器时,总会去继承ClassLoader类并重写loadClass() 方法,从而实现自定义的类加载类,但是在JDK1.2之后已不再建议用户去覆盖loadclass() 方法,而是建议把自定义的类加载逻辑写在findClass()方法中

- 在编写自定义类加载器时,如果没有太过于复杂的需求,可以直接继承URLClassLoader类,这样就可以避免自己去编写findClass() 方法及其获取字节码流的方式,使自定义类加载器编写更加简洁。

代码演示:

package chapter1;

import java.io.FileNotFoundException;

/**

* @version v1.0

* @ProjectName: JVM代码

* @ClassName: CustomClassLoader

* @Description: 自定义类加载器

* @Author: 赵先生

* @Date: 2022/1/30 16:55

*/

public class CustomClassLoader extends ClassLoader{

@Override

protected Class<?> findClass(String name) throws ClassNotFoundException {

try {

byte[] result = getClassFromCustomPath(name);

if (result == null) {

throw new FileNotFoundException();

}else {

return defineClass(name,result,0,result.length);

}

} catch (Exception e) {

e.printStackTrace();

}

throw new ClassNotFoundException(name);

}

private byte[] getClassFromCustomPath(String name) {

//从自定义路径中加载指定类:细节忽略

//如果指定路径的字节码进行了加密,则需要再次方法进行解码操作。

return null;

}

public static void main(String[] args) {

//创建一个自定义类加载器

CustomClassLoader customClassLoader = new CustomClassLoader();

try {

Class<?> clazz = Class.forName("one", true, customClassLoader);

//通过类创建一个实例

Object obj = clazz.newInstance();

System.out.println(obj.getClass().getClassLoader());

} catch (ClassNotFoundException e) {

e.printStackTrace();

} catch (IllegalAccessException e) {

e.printStackTrace();

} catch (InstantiationException e) {

e.printStackTrace();

}

}

}

4,ClassLoader的使用说明

ClassLoader类是一个抽象类,其后所有的类加载器都继承自ClassLoader(不包括启动类加载器)这也就是为什么说加载器分为引导类加载器和自定义类加载器的原因。

sun.misc.Launcher 它是一个java虚拟机的入口应用

获取ClassLoader的途径

● 方式一:获取当前ClassLoader

clazz.getClassLoader()

● 方式二:获取当前线程上下文的ClassLoader

Thread.currentThread().getContextClassLoader()

● 方式三:获取系统的ClassLoader

ClassLoader.getSystemClassLoader()

● 方式四:获取调用者的ClassLoader

DriverManager.getCallerClassLoader()

5,双亲委派机制

Java虚拟机对class文件采用的是按需加载的方式,也就是说当需要使用该类时才会将它的class文件加载到内存生成class对象。而且加载某个类的class文件时,Java虚拟机采用的是双亲委派模式,即把请求交由父类处理,它是一种任务委派模式。

工作原理

- 如果一个类加载器收到了类加载请求,它并不会自己先去加载,而是把这个请求委托给父类的加载器去执行;

- 如果父类加载器还存在其父类加载器,则进一步向上委托,依次递归,请求最终将到达顶层的启动类加载器;

- 如果父类加载器可以完成类加载任务,就成功返回,倘若父类加载器无法完成此加载任务,子加载器才会尝试自己去加载,这就是双亲委派模式。

举例

当我们加载jdbc.jar 用于实现数据库连接的时候,首先我们需要知道的是 jdbc.jar是基于SPI接口进行实现的,所以在加载的时候,会进行双亲委派,最终从根加载器中加载 SPI核心类,然后在加载SPI接口类,接着在进行反向委派,通过线程上下文类加载器进行实现jdbc.jar的加载。

优势

-

避免类的重复加载

- 比如说一个类你要加载,他首先到了顶层,如果顶层可以加载就进行加载,不能加载就往下推,这样保证只加载一次

-

保护程序安全,防止核心API被随意篡改

-

自定义类:java.lang.String

- 放篡改,就是说如果你自定义了一个String类,那么在加载的时候,因为双亲委派机制的存在,他会先交给引用类加载器加载,这样子就跳过了你自定义的类加载器。

-

自定义类:java.lang.ShkStart(报错:阻止创建 java.lang开头的类)

- 这样子就保证没有外部程序威胁到Java虚拟机的安全运行,起到了保护作用。

-

沙箱安全机制

自定义String类,但是在加载自定义String类的时候会率先使用引导类加载器加载,而引导类加载器在加载的过程中会先加载jdk自带的文件(rt.jar包中java\lang\String.class),报错信息说没有main方法,就是因为加载的是rt.jar包中的string类。这样可以保证对java核心源代码的保护,这就是沙箱安全机制。

就是说,我们把最重要的东西放在一个盒子里,别的恶意代码无法进入,这样子就保证他的安全性。

6,其他

如何判断两个class对象是否相同

在JVM中表示两个class对象是否为同一个类存在两个必要条件:

-

类的完整类名必须一致,包括包名。

-

加载这个类的ClassLoader(指ClassLoader实例对象)必须相同。

换句话说,在JVM中,即使这两个类对象(class对象)来源同一个Class文件,被同一个虚拟机所加载,但只要加载它们的ClassLoader实例对象不同,那么这两个类对象也是不相等的。

对类加载器的引用

JVM必须知道一个类型是由启动加载器加载的还是由用户类加载器加载的。如果一个类型是由用户类加载器加载的,那么JVM会将这个类加载器的一个引用作为类型信息的一部分保存在方法区中。当解析一个类型到另一个类型的引用的时候,JVM需要保证这两个类型的类加载器是相同的。

类的主动使用和被动使用

Java程序对类的使用方式分为:主动使用和被动使用。

主动使用,又分为七种情况:

-

创建类的实例

-

访问某个类或接口的静态变量,或者对该静态变量赋值

-

调用类的静态方法

-

反射(比如:Class.forName(“com.atguigu.Test”))

-

初始化一个类的子类

-

Java虚拟机启动时被标明为启动类的类

-

JDK 7 开始提供的动态语言支持:

java.lang.invoke.MethodHandle实例的解析结果

REF_getStatic、REF_putStatic、REF_invokeStatic句柄对应的类没有初始化,则初始化

除了以上七种情况,其他使用Java类的方式都被看作是对类的被动使用,都不会导致类的初始化。

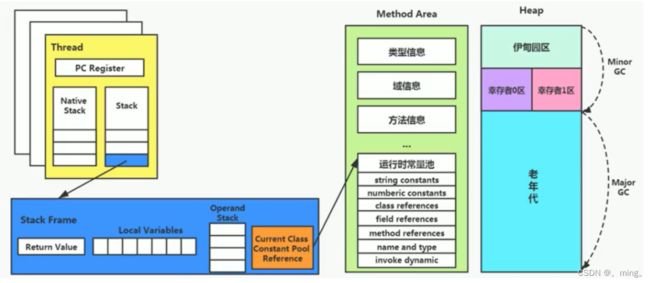

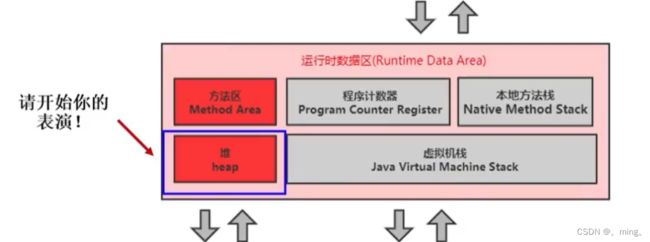

三,运行时数据区及程序计数器

1,运行时数据区

1.1,概述

当我们通过前面的:类的加载-> 验证 -> 准备 -> 解析 -> 初始化 这几个阶段完成后(类加载器),就会用到执行引擎对我们的类进行使用,同时执行引擎将会使用到我们运行时数据区。

内存是非常重要的系统资源,是硬盘和CPU的中间仓库及桥梁,承载着操作系统和应用程序的实时运行,JVM内存布局规定了Java在运行过程中内存申请,分配,管理的政策,保证了JVM的高效稳定的运行。不同的JVM对于内存的划分方式和管理机制存在着部分差异。结合JVM虚拟机规范,来探讨一下经典的JVM内存布局。

我们可以把大厨比作执行引擎,而后面的东西就是我们的运行时数据区,也就是说,大厨要炒菜,他必须要把食材准备好,这样子就可以在需要的时候进行即时的调整和使用。

我们通过磁盘或者网络IO得到的数据,都需要先加载到内存中,然后CPU从内存中获取数据进行读取,也就是说内存充当了CPU和磁盘之间的桥梁

Java虚拟机定义了若干种程序运行期间会使用到的运行时数据区,其中有一些会随着虚拟机的启动而创建,随着虚拟机的销毁而销毁,有些则是与线程一一对应的,这些与线程对应的数据区域会随着线程的开始和结束而创建和销毁。

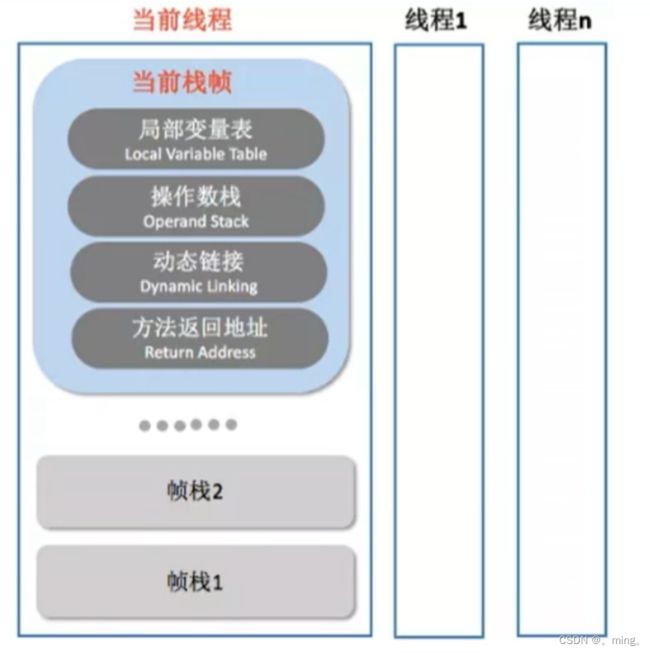

- 每个线程单独拥有的是程序计数器,栈,本地栈。

- 线程共享:堆,堆外内存(永久代或者元空间,代码缓存)

每个JVM只有一个Runtime实例。即为运行时环境,相当于内存结构的中间的那个框框:运行时环境。

1.2,线程

线程是一个程序里的运行单元。JVM允许一个应用有多个线程并行的执行。 在Hotspot JVM里,每个线程都与操作系统的本地线程直接映射。

当一个Java线程准备好执行以后,此时一个操作系统的本地线程也同时创建。Java线程执行终止后,本地线程也会回收。

操作系统负责所有线程的安排调度到任何一个可用的CPU上。一旦本地线程初始化成功,它就会调用Java线程中的run()方法。

1.3,JVM系统线程

如果你使用console或者是任何一个调试工具,都能看到在后台有许多线程在运行。这些后台线程不包括调用public static void main(String[] args)的main线程以及所有这个main线程自己创建的线程。

这些主要的后台系统线程在Hotspot JVM里主要是以下几个:

-

虚拟机线程:这种线程的操作是需要JVM达到安全点才会出现。这些操作必须在不同的线程中发生的原因是他们都需要JVM达到安全点,这样堆才不会变化。这种线程的执行类型包括"stop-the-world"的垃圾收集,线程栈收集,线程挂起以及偏向锁撤销。

-

周期任务线程:这种线程是时间周期事件的体现(比如中断),他们一般用于周期性操作的调度执行。

-

GC线程:这种线程对在JVM里不同种类的垃圾收集行为提供了支持。

-

编译线程:这种线程在运行时会将字节码编译成到本地代码。

-

信号调度线程:这种线程接收信号并发送给JVM,在它内部通过调用适当的方法进行处理。

2,程序计数器(PC寄存器)

JVM中的程序计数寄存器(Program Counter Register)中,Register的命名源于CPU的寄存器,寄存器存储指令相关的现场信息。CPU只有把数据加载到寄存器中才能够运行。这里,并不是广义上所指的物理寄存器,或许将其翻译为PC计数器(或指令计数器)更为贴切(也称为程序钩子),并且也不容易引起一些不必要的误会。JVM中的PC寄存器是对物理PC寄存器的一种抽象模拟(软件层次)。

作用

PC寄存器用来存储指向下一条指令的地址,也即将要执行的指令代码。由执行引擎读取下一条指令。

它是一块很小的内存空间,几乎可以忽略不记。也是运行速度最快的存储区域。

在JVM规范中,每个线程都有它自己的程序计数器,是线程私有的,生命周期与线程的生命周期保持一致。

任何时间一个线程都只有一个方法在执行,也就是所谓的当前方法。程序计数器会存储当前线程正在执行的Java方法的JVM指令地址;或者,如果是在执行native方法,则是未指定值(undefined)。

它是程序控制流的指示器,分支、循环、跳转、异常处理、线程恢复等基础功能都需要依赖这个计数器来完成。

字节码解释器工作时就是通过改变这个计数器的值来选取下一条需要执行的字节码指令。

它是唯一一个在Java虚拟机规范中没有规定任何OutofMemoryError情况的区域。

举例说明

public int minus(){

intc = 3;

intd = 4;

return c - d;

}

字节码文件:

0: iconst_3

1: istore_1

2: iconst_4

3: istore_2

4: iload_1

5: iload_2

6: isub

7: ireturn

使用PC寄存器存储字节码指令地址有什么用呢?为什么使用PC寄存器记录当前线程的执行地址呢?

因为CPU需要不停的切换各个线程,这时候切换回来以后,就得知道接着从哪开始继续执行。

JVM的字节码解释器就需要通过改变PC寄存器的值来明确下一条应该执行什么样的字节码指令。

PC寄存器为什么被设定为私有的?

我们都知道所谓的多线程在一个特定的时间段内只会执行其中某一个线程的方法,CPU会不停地做任务切换,这样必然导致经常中断或恢复,如何保证分毫无差呢?为了能够准确地记录各个线程正在执行的当前字节码指令地址,最好的办法自然是为每一个线程都分配一个PC寄存器,这样一来各个线程之间便可以进行独立计算,从而不会出现相互干扰的情况。

由于CPU时间片轮限制,众多线程在并发执行过程中,任何一个确定的时刻,一个处理器或者多核处理器中的一个内核,只会执行某个线程中的一条指令。

这样必然导致经常中断或恢复,如何保证分毫无差呢?每个线程在创建后,都会产生自己的程序计数器和栈帧,程序计数器在各个线程之间互不影响。

PU时间片

CPU时间片即CPU分配给各个程序的时间,每个线程被分配一个时间段,称作它的时间片。

在宏观上:俄们可以同时打开多个应用程序,每个程序并行不悖,同时运行。

但在微观上:由于只有一个CPU,一次只能处理程序要求的一部分,如何处理公平,一种方法就是引入时间片,每个程序轮流执行。

四,虚拟机栈

1, 虚拟机栈概述

1.1,虚拟机栈出现的背景

由于跨平台性的设计,Java的指令都是根据栈来设计的。不同平台的cpu架构不同,所以不能设计成基于寄存器的。

优点是跨平台,指令集小,编译器容易实现。

缺点是性能下降,实现同样的功能需要更多地指令。

1.2,初步印象

有不少Java开发人员一提到Java内存结构,就会非常粗粒度地将JVM中的内存区理解为仅有Java堆(heap)和Java栈(stack)?为什么?

1.3, 内存中的栈与堆

栈是运行时的单位,而不是存储的单位。

- 栈解决的是运行问题,即程序如何执行, 或者说是如何处理数据。

- 对解决的是数据存储的问题,即数据怎么放,放在哪里。

1.4,虚拟机栈的基本内容

Java虚拟机栈是什么

Java虚拟机栈,早期也叫作Java栈。每个线程在创建时都会创建一个虚拟机栈,其内部保存一个个的栈帧,对应着一次次的Java方法调用。

生命周期

生命周期和线程一致。

作用

主管Java程序的运行,他保存方法的局部变量,部分结果,并参与方法的调用和返回。

栈的特点

栈是一种快速有效的存储方式,访问速度仅次于程序计数器。

JVM直接对Java栈的操作只有两个:

- 每个方法执行,伴随着进栈(入栈,压栈)

- 执行结束后的出栈工作。

对于栈来说不存在垃圾回收的问题(但是可能会出现栈溢出的情况)

面试题:开发中遇到哪些异常?

栈中可能出现的异常

-

Java虚拟机栈规范允许Java栈的大小是动态的或者是固定不变的。

- 如果采用固定的大小,那么每一个线程的Java虚拟机栈容量可以在线程创建的时候独立选定。如果线程请求分配的栈容量超过Java虚拟机栈允许的最大容量,Java虚拟机栈将会抛出一个Stack Overflow Error的异常。

- 如果采用的动态扩展,并尝试扩展的时候无法申请到做足够的内存,或者在创建新的线程时没有足够的内存去创建对应的虚拟机栈,那么Java虚拟机将会抛出一个OutOfMemoryError的异常。

public static void main(String[] args) { test(); } public static void test() { test(); } //抛出异常:Exception in thread"main"java.lang.StackoverflowError //程序不断的进行递归调用,而且没有退出条件,就会导致不断地进行压栈。 -

设置栈内存大小

- 我们可以使用参数 -Xss选项来设置线程的最大栈空间,栈的大小直接决定了函数调用的最大可达深度

public class StackDeepTest{ private static int count=0; public static void recursion(){ count++; recursion(); } public static void main(String args[]){ try{ recursion(); } catch (Throwable e){ System.out.println("deep of calling="+count); e.printstackTrace(); } } }

2,栈的存储单位

2.1,栈中存储什么?

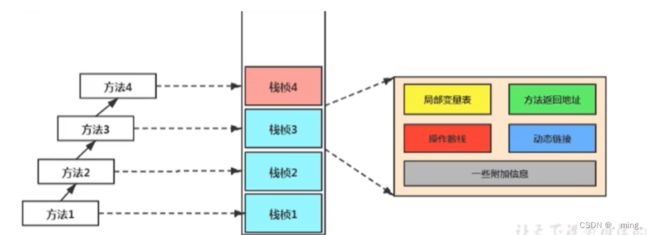

每个线程都有自己的栈,栈中的数据都是以栈帧(Stack Frame)的格式存在的。

在这个线程上正在执行的每个方法都有一个栈帧(一一对应)。

栈帧是一个内存区块,是一个数据集,维系着方法执行过程中的各种数据信息。

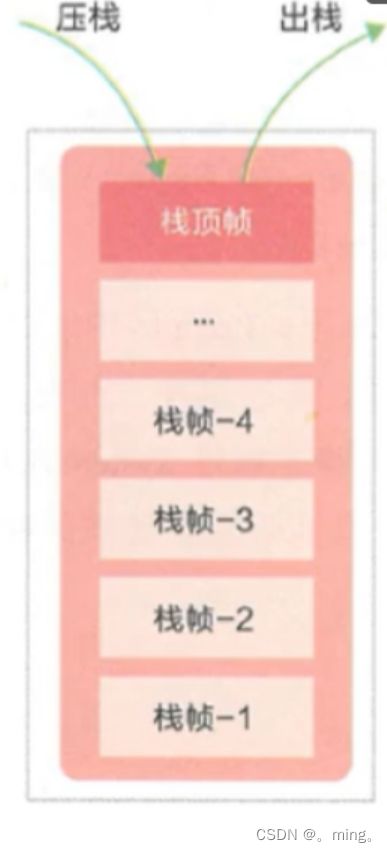

2.3,栈运行原理

JVM直接对Java栈的操作只有两个,就是对栈帧的压栈和出栈,遵循“先进后出”/“后进先出”原则。

在一条活动线程中,一个时间点上,只会有一个活动的栈帧。即只有当前正在执行的方法的栈帧(栈顶栈帧)是有效的,这个栈帧被称为当前栈帧(Current Frame),与当前栈帧相对应的方法就是当前方法(Current Method),定义这个方法的类就是当前类(Current Class)。

执行引擎运行的所有字节码指令只针对当前栈帧进行操作。

果在该方法中调用了其他方法,对应的新的栈帧会被创建出来,放在栈的顶端,成为新的当前帧。

不同线程中所包含的栈帧是不允许存在相互引用的,即不可能在一个栈帧之中引用另外一个线程的栈帧。

如果当前方法调用了其他方法,方法返回之际,当前栈帧会传回此方法的执行结果给前一个栈帧,接着,虚拟机会丢弃当前栈帧,使得前一个栈帧重新成为当前栈帧。

Java方法有两种返回函数的方式,一种是正常的函数返回,使用return指令;另外一种是抛出异常。不管使用哪种方式,都会导致栈帧被弹出。

public class CurrentFrameTest{

public void methodA(){

system.out.println("当前栈帧对应的方法->methodA");

methodB();

system.out.println("当前栈帧对应的方法->methodA");

}

public void methodB(){

System.out.println("当前栈帧对应的方法->methodB");

}

2.4, 栈帧的内部结构

每个栈帧中存储着:

-

局部变量表(Local Variables)

-

操作数栈(operand Stack)(或表达式栈)

-

动态链接(DynamicLinking)(或指向运行时常量池的方法引用)

-

方法返回地址(Return Address)(或方法正常退出或者异常退出的定义)

-

一些附加信息

并行每个线程下的栈都是私有的,因此每个线程都有自己各自的栈,并且每个栈里面都有很多栈帧,栈帧的大小主要由局部变量表 和 操作数栈决定的。

3,局部变量表(Local Variables)

局部变量表也被称为局部变量数组或者本地变量表

- 应以为一个数字数组,主要用于存储方法参数和定义在方法体内的局部变量,这些数据类型包括各类的基本数据类型没对象引用(reference),以及returnAddress类型。

- 由于局部变量表是建立在线程的栈上,是线程的私有数据,因此不存在数据安全问题。

- 局部变量表所需要的容量的大小是在编译时期确定下来的,并保存在方法的Code属性的maximun local variable数据项中。在方法运行期间是不会改变局部变量表的大小的。

- 方法嵌套调用的次数由栈的大小决定的。一般来说,栈越大,方法嵌套调用的次数越多。对于一个函数而言,他的参数和局部变量越多,使得局部变量表膨胀,他的栈帧就越大,以满足方法调用锁需传递的信息增大的需求。进而函数调用就会占有更多的栈空间,导致其嵌套调用次数就会减少。

- 局部变量表中的变量只在当前方法调用中有效。在方法执行时,虚拟机通过使用局部变量表完成参数值到参数变量列表的传递过程。当方法调用结束后,随着方法栈帧的销毁,局部变量表也会随之销毁。

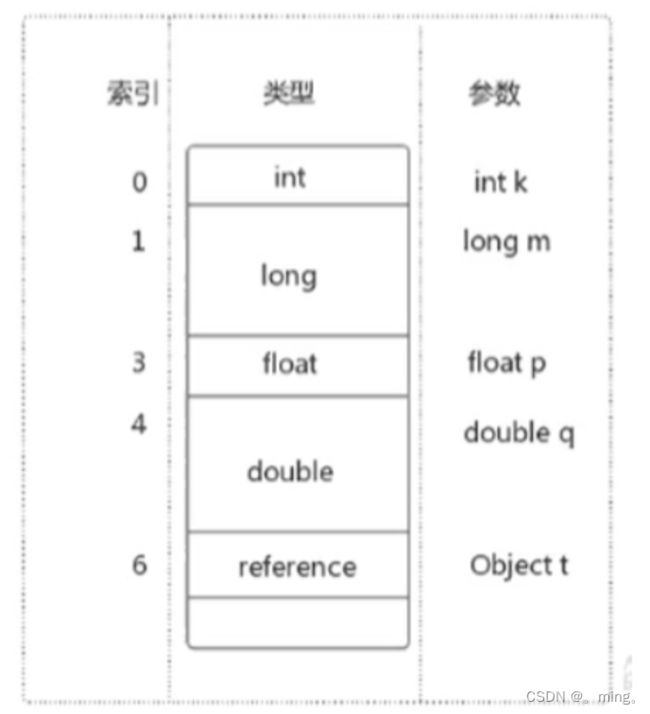

3.1,关于Slot的理解

-

局部变量表,最基本的存储单元是Slot(变量槽)

-

参数值的存放总是在局部变量数组的index0开始,到数组长度-1的索引结束。

-

局部变量表中存放编译期可知的各种基本数据类型(8种),引用类型(reference),returnAddress类型的变量。

-

在局部变量表里,32位以内的类型只占用一个slot(包括returnAddress类型),64位的类型(long和double)占用两个slot。

-

byte、short、char 在存储前被转换为int,boolean也被转换为int,0表示false,非0表示true。

-

JVM会为局部变量表中的每一个Slot都分配一个访问索引,通过这个索引即可成功访问到局部变量表中指定的局部变量值

-

当一个实例方法被调用的时候,它的方法参数和方法体内部定义的局部变量将会按照顺序被复制到局部变量表中的每一个slot上

-

如果需要访问局部变量表中一个64bit的局部变量值时,只需要使用前一个索引即可。(比如:访问long或doub1e类型变量)

-

如果当前帧是由构造方法或者实例方法创建的,那么该对象引用this将会存放在index为0的slot处,其余的参数按照参数表顺序继续排列。

3.2,Slot的重复利用

栈帧中的局部变量表中的槽位是可以重用的,如果一个局部变量过了其作用域,那么在其作用域之后申明的新的局部变就很有可能会复用过期局部变量的槽位,从而达到节省资源的目的。

public class SlotTest {

public void localVarl() {

int a = 0;

System.out.println(a);

int b = 0;

}

public void localVar2() {

{

int a = 0;

System.out.println(a);

}

//此时的就会复用a的槽位

int b = 0;

}

}

3.3,静态变量与局部变量的对比

参数表分配完毕后,在根据方法体内部定义的变量的顺序和作用域分配。

我们知道类变量有两次初始化机会,一次是在准备阶段,在执行系统初始化,对类变量设置为零,另外一次则是在初始化阶段,赋予程序员在代码中定义的初始值。

和类变量初始化不同的是,局部变量表不存在系统初始化的过程,这就意味着一旦定义了局部变量,必须要人为的初始化,否则无法使用。

public void test(){

int i;

System. out. println(i);

}

上面的代码就会报错,显示无法使用变量i,需要为他赋值。

3.4,补充说明

在栈帧中,与性能调优关系最为密切的部分就是前面提到的局部变量表。在方法执行时,虚拟机使用局部变量表完成方法的传递。

局部变量表中的变量也是重要的垃圾回收根节点,只要被局部变量表中直接或间接引用的对象都不会被回收。

4,操作数栈(Operand Stack)

每一个独立的栈帧处理包含局部变量表以外,还包含了一个后进先出的操作数栈,也可以称为表达式栈(Expression Stack)

操作数栈,在方法执行过程中,根据字节码指令,往栈中写入数据或者提取数据,即入栈操作(push)和出栈(pop)

-

某些字节码指令将值压入操作数栈,其余的字节码指令将操作数取出栈。使用它们后再把结果压入栈

-

比如:执行复制、交换、求和等操作

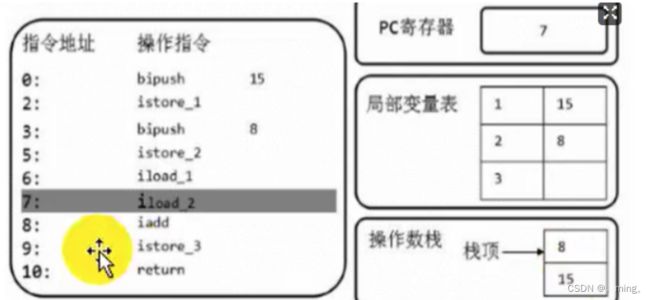

代码举例

public void testAddOperation(){

byte i = 15;

int j = 8;

int k = i + j;

}

字节码指令信息

public void testAddOperation();

Code:

0: bipush 15

2: istore_1

3: bipush 8

5: istore_2

6:iload_1

7:iload_2

8:iadd

9:istore_3

10:return

操作数栈,主要用于保存计算过程的中间结果,同时作为计算出过程中变量临时的存储空间。

操作数栈就是JVM执行引擎的一个工作区,当一个方法刚开始执行的时候,一个新的栈帧也会随之被创建出来,这个方法的操作数栈是空的。

每一个操作数栈都会拥有一个明确的栈深度用于存储数值,其所需的最大深度在编译期就定义好了,保存在方法的Code属性中,为max_stack的值。

栈中的任何一个元素都是可以任意的Java数据类型

-

32bit的类型占用一个栈单位深度

-

64bit的类型占用两个栈单位深度

操作数栈并非采用访问索引的方式来进行数据访问的,而是只能通过标准的入栈和出栈操作来完成一次数据访问。

如果被调用的方法带有返回值的话,其返回值将会被压入当前栈帧的操作数栈中,并更新PC寄存器中下一条需要执行的字节码指令。

操作数栈中元素的数据类型必须与字节码指令的序列严格匹配,这由编译器在编译器期间进行验证,同时在类加载过程中的类检测阶段的数据流分析阶段要再次验证。

另外,我们说Java虚拟机的解释引擎是基于栈的执行引擎,其中的栈指的就是操作数栈。

5,代码追踪

package chapter5;

/**

* @version v1.0

* @ProjectName: JVM代码

* @ClassName: Stack

* @Description: 操作数栈

* @Author: 赵先生

* @Date: 2022/2/10 17:51

*/

public class Stack {

public void testAddOperation() {

byte i = 15;

int j = 8;

int k = i + j;

}

}

使用javap 命令反编译class文件:javap -v 类名.class

public void testAddoperation();

Code:

0: bipush 15

2: istore_1

3: bipush 8

5: istore_2

6: iload_1

7: iload_2

8: iadd

9: istore_3

10: return

-

现将 byte i = 15的15入栈操作

-

在将这个值存入局部变量表中,同时出栈。(为什么局部变量表的0位置不存放15呢?是因为我们0的位置存放的this)

-

将j=8,存放如操作数栈中

-

再将8这个值存入局部变量表中,同时将其进行出栈操作。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-58xklvT8-1653787446404)(JVM.assets/image-20220210180954394.png)]](http://img.e-com-net.com/image/info8/f88f94c6421e49b98f01ef3e6d95588d.jpg)

-

将15入栈,为了后面的加运算。

-

将8也入栈。

-

最后Java的执行引擎将其进行解释出栈操作,进行相加,计算出的结果存放如栈中。

-

在将这个值赋予k,同时出栈。

6,栈顶缓存技术(Top Of Stack Cashing)技术

前面提过,基于栈式架构的虚拟机所使用的零地址指令更加紧凑,但完成一项操作的时候必然需要使用更多的入栈和出栈指令,这同时也就意味着将需要更多的指令分派(instruction dispatch)次数和内存读/写次数。

由于操作数是存储在内存中的,因此频繁地执行内存读/写操作必然会影响执行速度。为了解决这个问题,HotSpot JVM的设计者们提出了栈顶缓存(Tos,Top-of-Stack Cashing)技术,将栈顶元素全部缓存在物理CPU的寄存器中,以此降低对内存的读/写次数,提升执行引擎的执行效率。

7,动态链接(Dynamic Linking)

动态链接、方法返回地址、附加信息 : 有些地方被称为帧数据区

每一个栈帧内部都包含了一个指向运行时常量池中该栈帧所属方法的引用。包含这个引用的目的就是为了支持当前方法的代码能够实现动态链接。比如:invokedynamic指令。

在java源文件被编译到字节码文件中时,所有的变量和方法引用都作为符号引用(Symbolic Reference)保存在class文件的常量池里面。比如:描述一个方法调用了另外的其他方法时,就是通过常量池中指向方法的符号引用来表示的,那么动态连接的作用就是为了将这些符号引用转换为调用方法的直接引用。

/**

* @version v1.0

* @ProjectName: JVM代码

* @ClassName: DynamicLinking

* @Description: 动态链接

* @Author: 赵先生

* @Date: 2022/2/12 15:44

*/

public class DynamicLinking {

int num = 10;

public void methodA() {

System.out.println("methodA...");

}

public void methodB() {

System.out.println("methodB...");

num++;

}

}

动态链接指向的是方法区运行时常量池,产生这种引用的原因是节省了内存,就像我们要在方法中使用一个对象,我们就直接通过对象名找,而不用每次将这个对象的所有属性再次声明。

为什么需要运行时常量池呢?

常量池的作用:就是为了提供一些符号和常量,便于指令的识别

8,方法的调用:解析与分配

在JVM中,将符号引用转换为调用方法的直接引用与方法的绑定机制相关

8.1,静态链接

当一个字节码文件被装载进JVM内部时,如果被调用的目标方法在编译期可知,且运行期保持不变时,这种情况下将调用方法的符号引用转换为直接引用的过程称之为静态链接。

8.2,动态链接

如果被调用的方法在编译期无法被确定下来,只能够在程序运行期将调用的方法的符号转换为直接引用,由于这种引用转换过程具备动态性,因此也被称之为动态链接。

静态链接和动态链接不是名词,而是动词,这是理解的关键。

对应的方法的绑定机制为:早期绑定(Early Binding)和晚期绑定(Late Binding)。绑定是一个字段、方法或者类在符号引用被替换为直接引用的过程,这仅仅发生一次。

8.3,早期绑定

早期绑定就是指被调用的目标方法如果在编译期可知,且运行期保持不变时,即可将这个方法与所属的类型进行绑定,这样一来,由于明确了被调用的目标方法究竟是哪一个,因此也就可以使用静态链接的方式将符号引用转换为直接引用。

8.4,晚期绑定

如果被调用的方法在编译期无法被确定下来,只能够在程序运行期根据实际的类型绑定相关的方法,这种绑定方式也就被称之为晚期绑定。

随着高级语言的横空出世,类似于Java一样的基于面向对象的编程语言如今越来越多,尽管这类编程语言在语法风格上存在一定的差别,但是它们彼此之间始终保持着一个共性,那就是都支持封装、继承和多态等面向对象特性,既然这一类的编程语言具备多态特悄,那么自然也就具备早期绑定和晚期绑定两种绑定方式。

Java中任何一个普通的方法其实都具备虚函数的特征,它们相当于C语言中的虚函数(C中则需要使用关键字virtual来显式定义)。如果在Java程序中不希望某个方法拥有虚函数的特征时,则可以使用关键字final来标记这个方法。

8.5,虚方法和非虚方法

如果方法在编译期就确定了具体的调用版本,这个版本在运行时是不可变的。这样的方法称为非虚方法。

静态方法、私有方法、final方法、实例构造器、父类方法都是非虚方法。其他方法称为虚方法。

在类加载的解析阶段就可以进行解析,如下是非虚方法举例:

class Father{

public static void print(String str){

System. out. println("father "+str);

}

private void show(String str){

System. out. println("father"+str);

}

}

class Son extends Father{

public class VirtualMethodTest{

public static void main(String[] args){

Son.print("coder");

//Father fa=new Father();

//fa.show("atguigu.com");

}

}

虚拟机中提供了以下几条方法调用指令:

普通调用指令:

-

invokestatic:调用静态方法,解析阶段确定唯一方法版本

-

invokespecial:调用方法、私有及父类方法,解析阶段确定唯一方法版本

-

invokevirtual:调用所有虚方法

-

invokeinterface:调用接口方法

动态调用指令:

- invokedynamic:动态解析出需要调用的方法,然后执行

前四条指令固化在虚拟机内部,方法的调用执行不可人为干预,而invokedynamic指令则支持由用户确定方法版本。其中invokestatic指令和invokespecial指令调用的方法称为非虚方法,其余的(fina1修饰的除外)称为虚方法。

关于invokednamic指令

-

JVM字节码指令集一直比较稳定,一直到Java7中才增加了一个invokedynamic指令,这是Java为了实现「动态类型语言」支持而做的一种改进。

-

但是在Java7中并没有提供直接生成invokedynamic指令的方法,需要借助ASM这种底层字节码工具来产生invokedynamic指令。直到Java8的Lambda表达式的出现,invokedynamic指令的生成,在Java中才有了直接的生成方式。

-

Java7中增加的动态语言类型支持的本质是对Java虚拟机规范的修改,而不是对Java语言规则的修改,这一块相对来讲比较复杂,增加了虚拟机中的方法调用,最直接的受益者就是运行在Java平台的动态语言的编译器。

动态类型语言和静态类型语言

动态类型语言和静态类型语言两者的区别就在于对类型的检查是在编译期还是在运行期,满足前者就是静态类型语言,反之是动态类型语言。

说的再直白一点就是,静态类型语言是判断变量自身的类型信息;动态类型语言是判断变量值的类型信息,变量没有类型信息,变量值才有类型信息,这是动态语言的一个重要特征。

8.6,方法重写的本质

Java 语言中方法重写的本质:

- 找到操作数栈顶的第一个元素所执行的对象的实际类型,记作C。

- 如果在类型C中找到与常量中的描述符合简单名称都相符的方法,则进行访问权限校验,如果通过则返回这个方法的直接引用,查找过程结束;如果不通过,则返回java.lang.IllegalAccessError 异常。

- 否则,按照继承关系从下往上依次对C的各个父类进行第2步的搜索和验证过程。

- 如果始终没有找到合适的方法,则抛出java.1ang.AbstractMethodsError异常。

IllegalAccessError介绍

程序试图访问或修改一个属性或调用一个方法,这个属性或方法,你没有权限访问。一般的,这个会引起编译器异常。这个错误如果发生在运行时,就说明一个类发生了不兼容的改变。

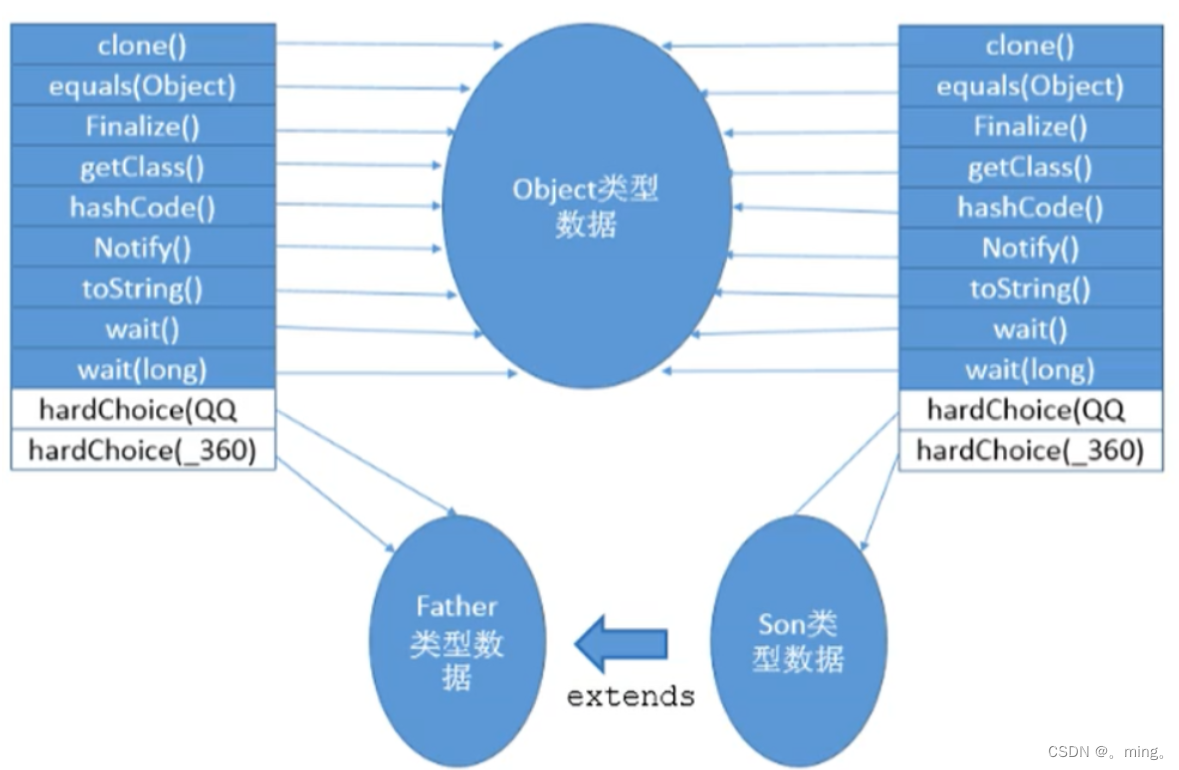

8.7,方法的调用:虚方法表

在面向对象的编程中,会很频繁的使用到动态分派,如果在每次动态分派的过程中都要重新在类的方法元数据中搜索合适的目标的话就可能影响到执行效率。因此,为了提高性能,JVM采用在类的方法区建立一个虚方法表 (virtual method table)(非虚方法不会出现在表中)来实现。使用索引表来代替查找。

每个类中都有一个虚方法表,表中存放着各个方法的实际入口。

虚方法表是什么时候被创建的呢?

虚方法表会在类加载的链接阶段被创建并开始初始化,类的变量初始值准备完成之后,JVM会把该类的方法表也初始化完毕。

举例1:

举例2:

interface Friendly{

void sayHello();

void sayGoodbye();

}

class Dog{

public void sayHello(){

}

public String tostring(){

return "Dog";

}

}

class Cat implements Friendly {

public void eat() {

}

public void sayHello() {

}

public void sayGoodbye() {

}

protected void finalize() {

}

}

class CockerSpaniel extends Dog implements Friendly{

public void sayHello() {

super.sayHello();

}

public void sayGoodbye() {

}

}

总结:

虚方法表出现的原因就是因为虚方法是通过一层层找的,在刚开始的时候不清楚具体是由谁进行实现的,但是我们想可以找到一次然后存放在表中,这样子再次调用这个方法的时候就不需要一层层的查找了,所以就有了虚方法表。他的产生时间就是我们在类加载的链接阶段的初始化是进行初始化的。

9,方法返回地址(return address)

存放调用该方法的pc寄存器的值。一个方法的结束,有两种方式:

-

正常执行完成

-

出现未处理的异常,非正常退出

无论通过哪种方式退出,在方法退出后都返回到该方法被调用的位置。方法正常退出时,调用者的pc计数器的值作为返回地址,即调用该方法的指令的下一条指令的地址。而通过异常退出的,返回地址是要通过异常表来确定,栈帧中一般不会保存这部分信息。

当一个方法开始执行后,只有两种方式可以退出这个方法:

-

执行引擎遇到任意一个方法返回的字节码指令(return),会有返回值传递给上层的方法调用者,简称正常完成出口;

-

一个方法在正常调用完成之后,究竟需要使用哪一个返回指令,还需要根据方法返回值的实际数据类型而定。

-

在字节码指令中,返回指令包含ireturn(当返回值是boolean,byte,char,short和int类型时使用),lreturn(Long类型),freturn(Float类型),dreturn(Double类型),areturn。另外还有一个return指令声明为void的方法,实例初始化方法,类和接口的初始化方法使用。

-

-

在方法执行过程中遇到异常(Exception),并且这个异常没有在方法内进行处理,也就是只要在本方法的异常表中没有搜索到匹配的异常处理器,就会导致方法退出,简称异常完成出口。

方法执行过程中,抛出异常时的异常处理,存储在一个异常处理表,方便在发生异常的时候找到处理异常的代码

Exception table:

from to target type

4 16 19 any

19 21 19 any

本质上,方法的退出就是当前栈帧出栈的过程。此时,需要恢复上层方法的局部变量表、操作数栈、将返回值压入调用者栈帧的操作数栈、设置PC寄存器值等,让调用者方法继续执行下去。

正常完成出口和异常完成出口的区别在于:通过异常完成出口退出的不会给他的上层调用者产生任何的返回值。

10,一些附加信息

栈帧中还允许携带与Java虚拟机实现相关的一些附加信息。例如:对程序调试提供支持的信息。

11,栈的相关面试题

-

举例栈溢出的情况?(StackOverflowError)

- 通过 -Xss设置栈的大小

-

调整栈大小,就能保证不出现溢出么?

- 不能保证不溢出

-

分配的栈内存越大越好么?

- 不是,一定时间内降低了OOM概率,但是会挤占其它的线程空间,因为整个空间是有限的。

-

垃圾回收是否涉及到虚拟机栈?

- 不会

-

方法中定义的局部变量是否线程安全?

- 具体问题具体分析。如果对象是在内部产生,并在内部消亡,没有返回到外部,那么它就是线程安全的,反之则是线程不安全的。

五,本地方法接口和本地方法栈

1,什么是本地方法?

简单地讲,一个Native Method是一个Java调用非Java代码的接囗。一个Native Method是这样一个Java方法:该方法的实现由非Java语言实现,比如C。这个特征并非Java所特有,很多其它的编程语言都有这一机制,比如在C中,你可以用extern “c” 告知c编译器去调用一个c的函数。

A native method is a Java method whose implementation is provided by non-java code.

在定义一个native method时,并不提供实现体(有些像定义一个Java interface),因为其实现体是由非java语言在外面实现的。

本地接口的作用是融合不同的编程语言为Java所用,它的初衷是融合C/C++程序。

举例

public class IHaveNatives{

public native void methodNative1(int x);

public native static long methodNative2();

private native synchronized float methodNative3(Object o);

native void methodNative4(int[] ary) throws Exception;

}

标识符native可以与其它java标识符连用,但是abstract除外

2,为什么使用Native Method?

Java使用起来非常方便,然而有些层次的任务用Java实现起来不容易,或者我们对程序的效率很在意时,问题就来了。

与Java环境的交互

有时Java应用需要与Java外面的环境交互,这是本地方法存在的主要原因。你可以想想Java需要与一些底层系统,如操作系统或某些硬件交换信息时的情况。本地方法正是这样一种交流机制:它为我们提供了一个非常简洁的接口,而且我们无需去了解Java应用之外的繁琐的细节。

与操作系统的交互

JVM支持着Java语言本身和运行时库,它是Java程序赖以生存的平台,它由一个解释器(解释字节码)和一些连接到本地代码的库组成。然而不管怎样,它毕竟不是一个完整的系统,它经常依赖于一底层系统的支持。这些底层系统常常是强大的操作系统。通过使用本地方法,我们得以用Java实现了jre的与底层系统的交互,甚至JVM的一些部分就是用c写的。还有,如果我们要使用一些Java语言本身没有提供封装的操作系统的特性时,我们也需要使用本地方法。

Sun’s Java

Sun的解释器是用C实现的,这使得它能像一些普通的C一样与外部交互。jre大部分是用Java实现的,它也通过一些本地方法与外界交互。例如:类java.lang.Thread的setPriority()方法是用Java实现的,但是它实现调用的是该类里的本地方法setPriority()。这个本地方法是用C实现的,并被植入JVM内部,在Windows 95的平台上,这个本地方法最终将调用Win32 setPriority() ApI。这是一个本地方法的具体实现由JVM直接提供,更多的情况是本地方法由外部的动态链接库(external dynamic link library)提供,然后被JVw调用。

现状

目前该方法使用的越来越少了,除非是与硬件有关的应用,比如通过Java程序驱动打印机或者Java系统管理生产设备,在企业级应用中已经比较少见。因为现在的异构领域间的通信很发达,比如可以使用Socket通信,也可以使用Web Service等等,不多做介绍。

3,本地方法栈

Java虚拟机栈于管理Java方法的调用,而本地方法栈用于管理本地方法的调用。

本地方法栈,也是线程私有的。

允许被实现成固定或者是可动态扩展的内存大小。(在内存溢出方面是相同的)

-

如果线程请求分配的栈容量超过本地方法栈允许的最大容量,Java虚拟机将会抛出一个StackOverflowError 异常。

-

如果本地方法栈可以动态扩展,并且在尝试扩展的时候无法申请到足够的内存,或者在创建新的线程时没有足够的内存去创建对应的本地方法栈,那么Java虚拟机将会抛出一个OutOfMemoryError异常。

本地方法是使用C语言实现的。

它的具体做法是Native Method Stack中登记native方法,在Execution Engine 执行时加载本地方法库。

当某个线程调用一个本地方法时,它就进入了一个全新的并且不再受虚拟机限制的世界。它和虚拟机拥有同样的权限。

-

本地方法可以通过本地方法接口来访问虚拟机内部的运行时数据区。

-

它甚至可以直接使用本地处理器中的寄存器

-

直接从本地内存的堆中分配任意数量的内存。

并不是所有的JVM都支持本地方法。因为Java虚拟机规范并没有明确要求本地方法栈的使用语言、具体实现方式、数据结构等。如果JVM产品不打算支持native方法,也可以无需实现本地方法栈。

在Hotspot JVM中,直接将本地方法栈和虚拟机栈合二为一。

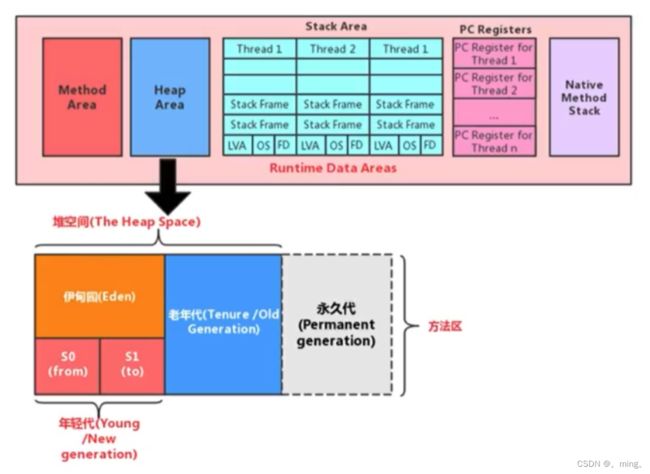

六, 堆

1,堆(Heap)的核心概述

堆针对一个JVM进程来说是唯一的,也就是一个进程只有一个JVM,但是进程包含多个线程,他们是共享同一堆空间的。

一个JVM实例只存在一个堆内存,堆也是Java内存管理的核心区域。

Java堆区在JVM启动的时候即被创建,其空间大小也就确定了。是JVM管理的最大一块内存空间。

- 堆内存的大小是可以调节的。

《Java虚拟机规范》规定,堆可以处于物理上不连续的内存空间中,但在逻辑上它应该被视为连续的。

所有的线程共享Java堆,在这里还可以划分线程私有的缓冲区(Thread Local Allocation Buffer,TLAB)。

《Java虚拟机规范》中对Java堆的描述是:所有的对象实例以及数组都应当在运行时分配在堆上。(The heap is the run-time data area from which memory for all class instances and arrays is allocated)

数组和对象可能永远不会存储在栈上,因为栈帧中保存引用,这个引用指向对象或者数组在堆中的位置。

在方法结束后,堆中的对象不会马上被移除,仅仅在垃圾收集的时候才会被移除。

堆,是GC(Garbage Collection,垃圾收集器)执行垃圾回收的重点区域。

1.1,堆内存细分

Java 7及之前堆内存逻辑上分为三部分:新生区+养老区+永久区

-

Young Generation Space 新生区 Young/New 又被划分为Eden区和Survivor区

-

Tenure generation space 养老区 Old/Tenure

-

Permanent Space 永久区 Perm

Java 8及之后堆内存逻辑上分为三部分:新生区+养老区+元空间

-

Young Generation Space 新生区 Young/New 又被划分为Eden区和Survivor区

-

Tenure generation space 养老区 Old/Tenure

-

Meta Space 元空间 Meta

约定:新生区(代)<=>年轻代 、 养老区<=>老年区(代)、 永久区<=>永久代

1.2,堆空间内部结构(JDK7)

1.3,堆空间内部结构(JDK8)

2,设置堆内存大小与OOM

2.1,堆空间大小的设置

Java堆区用于存储Java对象实例,那么堆的大小在JVM启动时就已经设定好了,大家可以通过选项"-Xmx"和"-Xms"来进行设置。

-

“-Xms"用于表示堆区的起始内存,等价于

-XX:InitialHeapSize -

“-Xmx"则用于表示堆区的最大内存,等价于

-XX:MaxHeapSize

一旦堆区中的内存大小超过“-Xmx"所指定的最大内存时,将会抛出OutOfMemoryError异常。

通常会将-Xms和-Xmx两个参数配置相同的值,其目的是为了能够在Java垃圾回收机制清理完堆区后不需要重新分隔计算堆区的大小,从而提高性能。

默认情况下

-

初始内存大小:物理电脑内存大小 / 64

-

最大内存大小:物理电脑内存大小 / 4

2.2,OutOfMemory举例

/**

-Xms 用来设置堆空间(年轻代+老年代)的初始化内存大小

-X 是Jvm的运行参数

ms 是memory start

-Xmx 用来设计堆空间的最大内存的大小

*/

public class OOMTest {

public static void main(String[]args){

ArrayList<Picture> list = new ArrayList<>();

while(true){

try {

Thread.sleep(20);

} catch (InterruptedException e){

e.printStackTrace();

}

list.add(new Picture(new Random().nextInt(1024*1024)));

}

}

}

Exception in thread "main" java.lang.OutofMemoryError: Java heap space

at com.atguigu. java.Picture.<init>(OOMTest. java:25)

at com.atguigu.java.O0MTest.main(OOMTest.java:16)

3,年轻代与老年代

存储在JVM中的Java对象可以被划分为两类:

-

一类是生命周期较短的瞬时对象,这类对象的创建和消亡都非常迅速

-

另外一类对象的生命周期却非常长,在某些极端的情况下还能够与JVM的生命周期保持一致

Java堆区进一步细分的话,可以划分为年轻代(YoungGen)和老年代(oldGen)

其中年轻代又可以划分为Eden空间、Survivor0空间和Survivor1空间(有时也叫做from区、to区)

下面这参数开发中一般不会调:

配置新生代与老年代在堆结构的占比。

-

默认

-XX:NewRatio=2,表示新生代占1,老年代占2,新生代占整个堆的1/3 -

可以修改

-XX:NewRatio=4,表示新生代占1,老年代占4,新生代占整个堆的1/5

在HotSpot中,Eden空间和另外两个survivor空间缺省所占的比例是8:1:1

当然开发人员可以通过选项“-xx:SurvivorRatio”调整这个空间比例。比如-xx:SurvivorRatio=8

几乎所有的Java对象都是在Eden区被new出来的。绝大部分的Java对象的销毁都在新生代进行了。

- IBM公司的专门研究表明,新生代中80%的对象都是“朝生夕死”的。

可以使用选项"-Xmn"设置新生代最大内存大小,这个参数一般使用默认值就可以了。配置新生代与老年代在堆结构的占比。

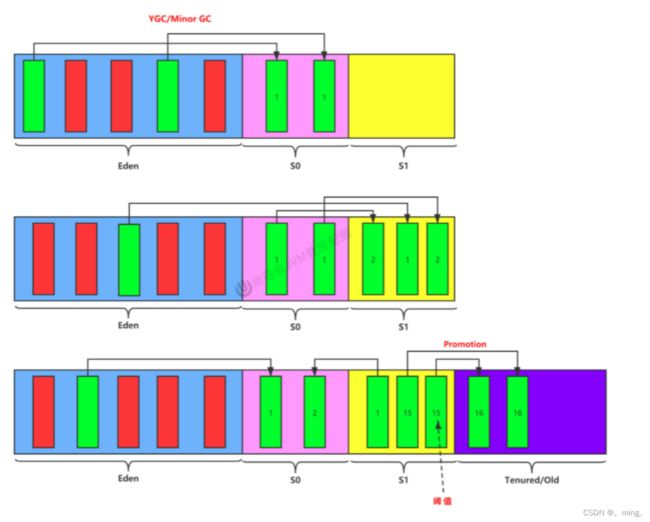

4,图解对象分配过程

为新对象分配内存是一件非常严谨和复杂的任务,JVM的设计者们不仅需要考虑内存如何分配、在哪里分配等问题,并且由于内存分配算法与内存回收算法密切相关,所以还需要考虑GC执行完内存回收后是否会在内存空间中产生内存碎片。

- new的对象先放伊甸园区。此区有大小限制。

- 当伊甸园的空间填满时,程序又需要创建对象,JVM的垃圾回收器将对伊甸园区进行垃圾回收(MinorGC),将伊甸园区中的不再被其他对象所引用的对象进行销毁。再加载新的对象放到伊甸园区

- 然后将伊甸园中的剩余对象移动到幸存者0区。

- 如果再次触发垃圾回收,此时上次幸存下来的放到幸存者0区的,如果没有回收,就会放到幸存者1区。

- 如果再次经历垃圾回收,此时会重新放回幸存者0区,接着再去幸存者1区。

- 啥时候能去养老区呢?可以设置次数。默认是15次。

- 可以设置参数:进行设置

-Xx:MaxTenuringThreshold= N

- 可以设置参数:进行设置

- 在养老区,相对悠闲。当养老区内存不足时,再次触发GC:Major GC,进行养老区的内存清理

- 若养老区执行了Major GC之后,发现依然无法进行对象的保存,就会产生OOM异常。

java.lang.OutofMemoryError: Java heap space

流程图

总结

-

针对幸存者s0,s1区的总结:复制之后有交换,谁空谁是to

-

关于垃圾回收:频繁在新生区收集,很少在老年代收集,几乎不再永久代和元空间进行收集

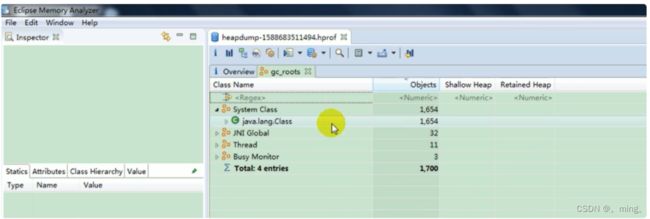

常用调优工具(在JVM下篇:性能监控与调优篇会详细介绍)

-

JDK命令行

-

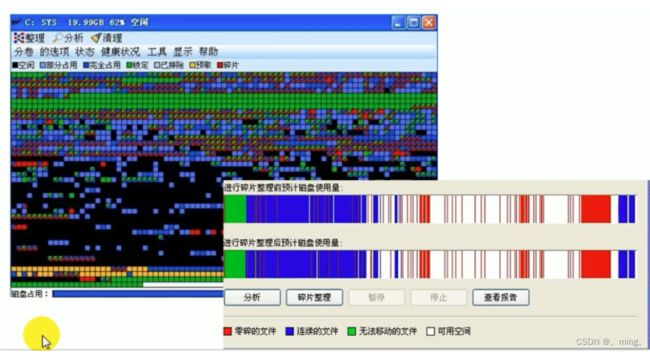

Eclipse:Memory Analyzer Tool

-

Jconsole

-

VisualVM

-

Jprofiler

-

Java Flight Recorder

-

GCViewer

-

GC Easy

5,Minor GC,MajorGC、Full GC

JVM在进行GC时,并非每次都对上面三个内存区域一起回收的,大部分时候回收的都是指新生代。

针对Hotspot VM的实现,它里面的GC按照回收区域又分为两大种类型:一种是部分收集(Partial GC),一种是整堆收集(FullGC)

-

部分收集:不是完整收集整个Java堆的垃圾收集。其中又分为:

-

新生代收集(Minor GC / Young GC):只是新生代的垃圾收集

-

老年代收集(Major GC / Old GC):只是老年代的圾收集。

-

目前,只有CMSGC会有单独收集老年代的行为。

-

注意,很多时候Major GC会和Full GC混淆使用,需要具体分辨是老年代回收还是整堆回收。

-

-

混合收集(MixedGC):收集整个新生代以及部分老年代的垃圾收集。

- 目前,只有G1 GC会有这种行为

-

-

整堆收集(Full GC):收集整个java堆和方法区的垃圾收集。

5.1,最简单的分代式GC策略的触发条件

年轻代GC(Minor GC)触发机制

-

当年轻代空间不足时,就会触发MinorGC,这里的年轻代满指的是Eden代满,Survivor满不会引发GC。(每次Minor GC会清理年轻代的内存。)

-

因为Java对象大多都具备朝生夕灭的特性.,所以Minor GC非常频繁,一般回收速度也比较快。这一定义既清晰又易于理解。

-

Minor GC会引发STW,暂停其它用户的线程,等垃圾回收结束,用户线程才恢复运行

老年代GC(Major GC / Full GC)触发机制

-

指发生在老年代的GC,对象从老年代消失时,我们说 “Major GC” 或 “Full GC” 发生了

-

出现了Major Gc,经常会伴随至少一次的Minor GC(但非绝对的,在Paralle1 Scavenge收集器的收集策略里就有直接进行MajorGC的策略选择过程)

- 也就是在老年代空间不足时,会先尝试触发Minor Gc。如果之后空间还不足,则触发Major GC

-

Major GC的速度一般会比Minor GC慢10倍以上,STW的时间更长

-

如果Major GC后,内存还不足,就报OOM了

Full GC触发机制(后面细讲):

触发Full GC执行的情况有如下五种:

- 调用System.gc()时,系统建议执行Full GC,但是不必然执行

- 老年代空间不足

- 方法区空间不足

- 通过Minor GC后进入老年代的平均大小大于老年代的可用内存

- 由Eden区、survivor space0(From Space)区向survivor space1(To Space)区复制时,对象大小大于To Space可用内存,则把该对象转存到老年代,且老年代的可用内存小于该对象大小

说明:Full GC 是开发或调优中尽量要避免的。这样暂时时间会短一些

6,堆空间分代思想

为什么要把Java堆分代?不分代就不能正常工作了吗?

经研究,不同对象的生命周期不同。70%-99%的对象是临时对象。

-

新生代:有Eden、两块大小相同的survivor(又称为from/to,s0/s1)构成,to总为空。

-

老年代:存放新生代中经历多次GC仍然存活的对象。

其实不分代完全可以,分代的唯一理由就是优化GC性能。如果没有分代,那所有的对象都在一块,就如同把一个学校的人都关在一个教室。GC的时候要找到哪些对象没用,这样就会对堆的所有区域进行扫描。而很多对象都是朝生夕死的,如果分代的话,把新创建的对象放到某一地方,当GC的时候先把这块存储“朝生夕死”对象的区域进行回收,这样就会腾出很大的空间出来。

7,内存分配策略

如果对象在Eden出生并经过第一次Minor GC后仍然存活,并且能被Survivor容纳的话,将被移动到survivor空间中,并将对象年龄设为1。对象在survivor区中每熬过一次MinorGC,年龄就增加1岁,当它的年龄增加到一定程度(默认为15岁,其实每个JVM、每个GC都有所不同)时,就会被晋升到老年代

对象晋升老年代的年龄阀值,可以通过选项-XX:MaxTenuringThreshold来设置

针对不同年龄段的对象分配原则如下所示:

-

优先分配到Eden

-

大对象直接分配到老年代(尽量避免程序中出现过多的大对象)

-

长期存活的对象分配到老年代

-

动态对象年龄判断:如果survivor区中相同年龄的所有对象大小的总和大于Survivor空间的一半,年龄大于或等于该年龄的对象可以直接进入老年代,无须等到

MaxTenuringThreshold中要求的年龄。 -

空间分配担保:

-XX:HandlePromotionFailure

8,为对象分配内存:TLAB

8.1,为什么有TLAB(Thread Local Allocation Buffer)?

-

堆区是线程共享区域,任何线程都可以访问到堆区中的共享数据

-

由于对象实例的创建在JVM中非常频繁,因此在并发环境下从堆区中划分内存空间是线程不安全的

-

为避免多个线程操作同一地址,需要使用加锁等机制,进而影响分配速度。

8.2,什么是TLAB?

-

从内存模型而不是垃圾收集的角度,对Eden区域继续进行划分,JVM为每个线程分配了一个私有缓存区域,它包含在Eden空间内。

-

多线程同时分配内存时,使用TLAB可以避免一系列的非线程安全问题,同时还能够提升内存分配的吞吐量,因此我们可以将这种内存分配方式称之为快速分配策略。

-

据我所知所有OpenJDK衍生出来的JVM都提供了TLAB的设计。

8.3,TLAB的再说明

-

尽管不是所有的对象实例都能够在TLAB中成功分配内存,但JVM确实是将TLAB作为内存分配的首选。

-

在程序中,开发人员可以通过选项“

-XX:UseTLAB”设置是否开启TLAB空间。 -

默认情况下,TLAB空间的内存非常小,仅占有整个Eden空间的1%,当然我们可以通过选项 “

-XX:TLABWasteTargetPercent” 设置TLAB空间所占用Eden空间的百分比大小。 -

一旦对象在TLAB空间分配内存失败时,JVM就会尝试着通过使用加锁机制确保数据操作的原子性,从而直接在Eden空间中分配内存。

9,小结:堆空间的参数设置

// 详细的参数内容会在JVM下篇:性能监控与调优篇中进行详细介绍,这里先熟悉下

-XX:+PrintFlagsInitial //查看所有的参数的默认初始值

-XX:+PrintFlagsFinal //查看所有的参数的最终值(可能会存在修改,不再是初始值)

-Xms //初始堆空间内存(默认为物理内存的1/64)

-Xmx //最大堆空间内存(默认为物理内存的1/4)

-Xmn //设置新生代的大小。(初始值及最大值)

-XX:NewRatio //配置新生代与老年代在堆结构的占比

-XX:SurvivorRatio //设置新生代中Eden和S0/S1空间的比例

-XX:MaxTenuringThreshold //设置新生代垃圾的最大年龄

-XX:+PrintGCDetails //输出详细的GC处理日志

//打印gc简要信息:①-Xx:+PrintGC ② - verbose:gc

-XX:HandlePromotionFalilure://是否设置空间分配担保

在发生Minor GC之前,虚拟机会检查老年代最大可用的连续空间是否大于新生代所有对象的总空间。

-

如果大于,则此次Minor GC是安全的

-

如果小于,则虚拟机会查看

-XX:HandlePromotionFailure设置值是否允担保失败。-

如果

HandlePromotionFailure=true,那么会继续检查老年代最大可用连续空间是否大于历次晋升到老年代的对象的平均大小。-

如果大于,则尝试进行一次Minor GC,但这次Minor GC依然是有风险的;

-

如果小于,则改为进行一次Full GC。

-

-

如果

HandlePromotionFailure=false,则改为进行一次Full Gc。

-

在JDK6 Update24之后,HandlePromotionFailure参数不会再影响到虚拟机的空间分配担保策略,观察openJDK中的源码变化,虽然源码中还定义了HandlePromotionFailure参数,但是在代码中已经不会再使用它。JDK6 Update 24之后的规则变为只要老年代的连续空间大于新生代对象总大小或者历次晋升的平均大小就会进行Minor GC,否则将进行FullGC。

10,堆是分配对象的唯一选择么?

在《深入理解Java虚拟机》中关于Java堆内存有这样一段描述:

随着JIT编译期的发展与逃逸分析技术逐渐成熟,栈上分配、标量替换优化技术将会导致一些微妙的变化,所有的对象都分配到堆上也渐渐变得不那么“绝对”了。

在Java虚拟机中,对象是在Java堆中分配内存的,这是一个普遍的常识。但是,有一种特殊情况,那就是如果经过逃逸分析(Escape Analysis)后发现,一个对象并没有逃逸出方法的话,那么就可能被优化成栈上分配.。这样就无需在堆上分配内存,也无须进行垃圾回收了。这也是最常见的堆外存储技术。

此外,前面提到的基于OpenJDK深度定制的TaoBaoVM,其中创新的GCIH(GC invisible heap)技术实现off-heap,将生命周期较长的Java对象从heap中移至heap外,并且GC不能管理GCIH内部的Java对象,以此达到降低GC的回收频率和提升GC的回收效率的目的。

10.1,逃逸分析概述

如何将堆上的对象分配到栈,需要使用逃逸分析手段。

这是一种可以有效减少Java程序中同步负载和内存堆分配压力的跨函数全局数据流分析算法。

通过逃逸分析,Java Hotspot编译器能够分析出一个新的对象的引用的使用范围从而决定是否要将这个对象分配到堆上。

逃逸分析的基本行为就是分析对象动态作用域:

-

当一个对象在方法中被定义后,对象只在方法内部使用,则认为没有发生逃逸。

-

当一个对象在方法中被定义后,它被外部方法所引用,则认为发生逃逸。例如作为调用参数传递到其他地方中。

举例1

public void my_method() {

V v = new V();

// use v

// ....

v = null;

}

没有发生逃逸的对象,则可以分配到栈上,随着方法执行的结束,栈空间就被移除,每个栈里面包含了很多栈帧

public static StringBuffer createStringBuffer(String s1, String s2) {

StringBuffer sb = new StringBuffer();

sb.append(s1);

sb.append(s2);

return sb;

}

上述方法如果想要StringBuffer sb不发生逃逸,可以这样写

public static String createStringBuffer(String s1, String s2) {

StringBuffer sb = new StringBuffer();

sb.append(s1);

sb.append(s2);

return sb.toString();

}

举例2

public class EscapeAnalysis {

//判断逃逸分析:看这个值是否在方法外被调用

public EscapeAnalysis obj;

/**

* 方法返回EscapeAnalysis对象,发生逃逸

* @return

*/

public EscapeAnalysis getInstance() {

return obj == null ? new EscapeAnalysis() : obj;

}

/**

* 为成员属性赋值,发生逃逸

*/

public void setObj() {

this.obj = new EscapeAnalysis();

}

/**

* 对象的作用于仅在当前方法中有效,没有发生逃逸

*/

public void useEscapeAnalysis() {

EscapeAnalysis e = new EscapeAnalysis();

}

/**

* 引用成员变量的值,发生逃逸

*/

public void useEscapeAnalysis2() {

EscapeAnalysis e = getInstance();

}

}

参数设置

在JDK 6u23 版本之后,HotSpot中默认就已经开启了逃逸分析

如果使用的是较早的版本,开发人员则可以通过:

-

选项“

-XX:+DoEscapeAnalysis"显式开启逃逸分析 -

通过选项“

-XX:+PrintEscapeAnalysis"查看逃逸分析的筛选结果

结论:开发中能使用局部变量的,就不要使用在方法外定义。

10.2,逃逸分析:代码优化

使用逃逸分析,编译器可以对代码做如下优化:

一、栈上分配:将堆分配转化为栈分配。如果一个对象在子程序中被分配,要使指向该对象的指针永远不会发生逃逸,对象可能是栈上分配的候选,而不是堆上分配

二、同步省略:如果一个对象被发现只有一个线程被访问到,那么对于这个对象的操作可以不考虑同步。

三、分离对象或标量替换:有的对象可能不需要作为一个连续的内存结构存在也可以被访问到,那么对象的部分(或全部)可以不存储在内存,而是存储在CPU寄存器中。

栈上分配

JIT编译器在编译期间根据逃逸分析的结果,发现如果一个对象并没有逃逸出方法的话,就可能被优化成栈上分配。分配完成后,继续在调用栈内执行,最后线程结束,栈空间被回收,局部变量对象也被回收。这样就无须进行垃圾回收了。

常见的栈上分配的场景

在逃逸分析中,已经说明了。分别是给成员变量赋值、方法返回值、实例引用传递。

同步省略

线程同步的代价是相当高的,同步的后果是降低并发性和性能。

在动态编译同步块的时候,JIT编译器可以借助逃逸分析来判断同步块所使用的锁对象是否只能够被一个线程访问而没有被发布到其他线程。如果没有,那么JIT编译器在编译这个同步块的时候就会取消对这部分代码的同步。这样就能大大提高并发性和性能。这个取消同步的过程就叫同步省略,也叫锁消除。

举例

public void f() {

Object hellis = new Object();

synchronized(hellis) {

System.out.println(hellis);

}

}

代码中对hellis这个对象加锁,但是hellis对象的生命周期只在f()方法中,并不会被其他线程所访问到,所以在JIT编译阶段就会被优化掉,优化成:

public void f() {

Object hellis = new Object();

System.out.println(hellis);

}

标量替换

标量(scalar)是指一个无法再分解成更小的数据的数据。Java中的原始数据类型就是标量。

相对的,那些还可以分解的数据叫做聚合量(Aggregate),Java中的对象就是聚合量,因为他可以分解成其他聚合量和标量。

在JIT阶段,如果经过逃逸分析,发现一个对象不会被外界访问的话,那么经过JIT优化,就会把这个对象拆解成若干个其中包含的若干个成员变量来代替。这个过程就是标量替换。

举例

public static void main(String args[]) {

alloc();

}

private static void alloc() {

Point point = new Point(1,2);

System.out.println("point.x" + point.x + ";point.y" + point.y);

}

class Point {

private int x;

private int y;

}

以上代码,经过标量替换后,就会变成

private static void alloc() {

int x = 1;

int y = 2;

System.out.println("point.x = " + x + "; point.y=" + y);

}

可以看到,Point这个聚合量经过逃逸分析后,发现他并没有逃逸,就被替换成两个标量了。那么标量替换有什么好处呢?就是可以大大减少堆内存的占用。因为一旦不需要创建对象了,那么就不再需要分配堆内存了。 标量替换为栈上分配提供了很好的基础。

标量替换参数设置

参数-XX:EliminateAllocations:开启了标量替换(默认打开),允许将对象打散分配到栈上。

上述代码在主函数中进行了1亿次alloc。调用进行对象创建,由于User对象实例需要占据约16字节的空间,因此累计分配空间达到将近1.5GB。如果堆空间小于这个值,就必然会发生GC。使用如下参数运行上述代码:

-server -Xmx100m -Xms100m -XX:+DoEscapeAnalysis -XX:+PrintGC -XX:+EliminateAllocations

这里设置参数如下:

-

参数

-server:启动Server模式,因为在server模式下,才可以启用逃逸分析。 -

参数

-XX:+DoEscapeAnalysis:启用逃逸分析 -

参数

-Xmx10m:指定了堆空间最大为10MB -

参数

-XX:+PrintGC:将打印Gc日志 -

参数

-XX:+EliminateAllocations:开启了标量替换(默认打开),允许将对象打散分配在栈上,比如对象拥有id和name两个字段,那么这两个字段将会被视为两个独立的局部变量进行分配

10.3,逃逸分析小结:逃逸分析并不成熟

关于逃逸分析的论文在1999年就已经发表了,但直到JDK1.6才有实现,而且这项技术到如今也并不是十分成熟。

其根本原因就是无法保证逃逸分析的性能消耗一定能高于他的消耗。虽然经过逃逸分析可以做标量替换、栈上分配、和锁消除。但是逃逸分析自身也是需要进行一系列复杂的分析的,这其实也是一个相对耗时的过程。

一个极端的例子,就是经过逃逸分析之后,发现没有一个对象是不逃逸的。那这个逃逸分析的过程就白白浪费掉了。

虽然这项技术并不十分成熟,但是它也是即时编译器优化技术中一个十分重要的手段。

注意到有一些观点,认为通过逃逸分析,JVM会在栈上分配那些不会逃逸的对象,这在理论上是可行的,但是取决于JVM设计者的选择。据我所知,Oracle Hotspot JVM中并未这么做,这一点在逃逸分析相关的文档里已经说明,所以可以明确所有的对象实例都是创建在堆上。

目前很多书籍还是基于JDK7以前的版本,JDK已经发生了很大变化,intern字符串的缓存和静态变量曾经都被分配在永久代上,而永久代已经被元数据区取代。但是,intern字符串缓存和静态变量并不是被转移到元数据区,而是直接在堆上分配,所以这一点同样符合前面一点的结论:对象实例都是分配在堆上。

本章小结

年轻代是对象的诞生、成长、消亡的区域,一个对象在这里产生、应用,最后被垃圾回收器收集、结束生命。

老年代放置长生命周期的对象,通常都是从survivor区域筛选拷贝过来的Java对象。当然,也有特殊情况,我们知道普通的对象会被分配在TLAB上;如果对象较大,JVM会试图直接分配在Eden其他位置上;如果对象太大,完全无法在新生代找到足够长的连续空闲空间,JVM就会直接分配到老年代。

当GC只发生在年轻代中,回收年轻代对象的行为被称为MinorGc。

当GC发生在老年代时则被称为MajorGc或者FullGC。一般的,MinorGc的发生频率要比MajorGC高很多,即老年代中垃圾回收发生的频率将大大低于年轻代。

七,方法区

从线程共享与否的角度来看

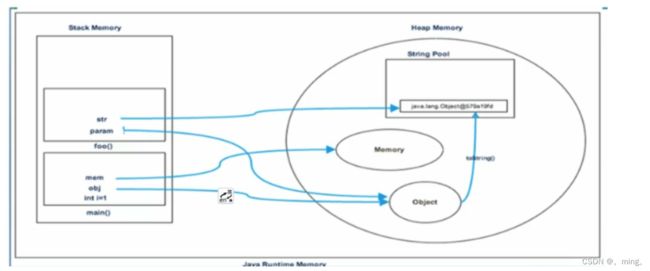

1,栈、堆、方法区的交互关系

2,方法区的理解

官方文档:Chapter 2. The Structure of the Java Virtual Machine (oracle.com)

2.1,方法区在哪里?

《Java虚拟机规范》中明确说明:“尽管所有的方法区在逻辑上是属于堆的一部分,但一些简单的实现可能不会选择去进行垃圾收集或者进行压缩。”但对于HotSpotJVM而言,方法区还有一个别名叫做Non-Heap(非堆),目的就是要和堆分开。

所以,方法区看作是一块独立于Java堆的内存空间。

2.2,方法区的基本理解

-

方法区(Method Area)与Java堆一样,是各个线程共享的内存区域。

-

方法区在JVM启动的时候被创建,并且它的实际的物理内存空间中和Java堆区一样都可以是不连续的。

-

方法区的大小,跟堆空间一样,可以选择固定大小或者可扩展。

-

方法区的大小决定了系统可以保存多少个类,如果系统定义了太多的类,导致方法区溢出,虚拟机同样会抛出内存溢出错误:

java.lang.OutOfMemoryError: PermGen space或者java.lang.OutOfMemoryError: Metaspace- 加载大量的第三方的jar包;Tomcat部署的工程过多(30~50个);大量动态的生成反射类

-

关闭JVM就会释放这个区域的内存。

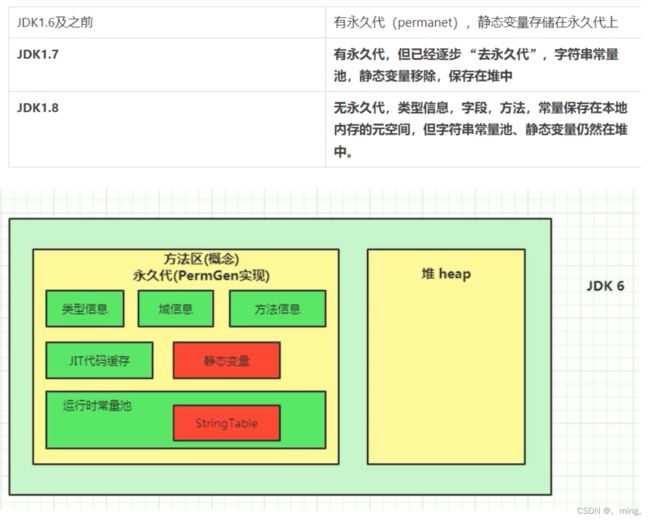

2.3,HotSpot中方法区的演进

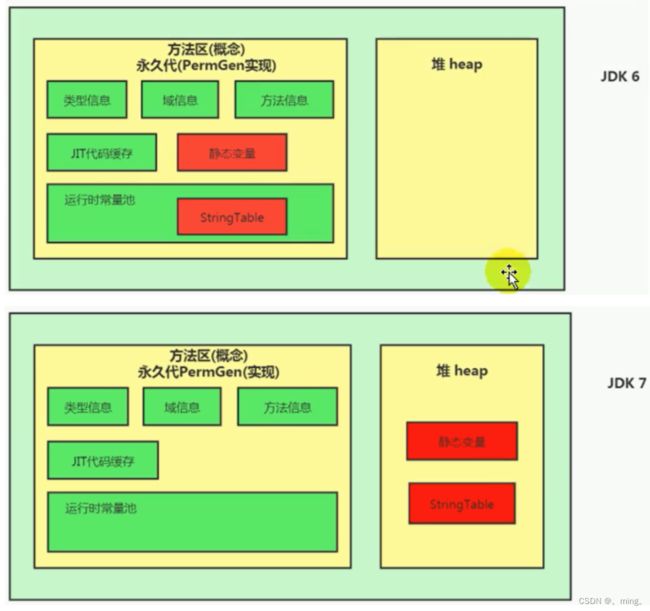

在jdk7及以前,习惯上把方法区称为永久代。jdk8开始,使用元空间取代了永久代。

本质上,方法区和永久代并不等价。仅是对hotspot而言的。《Java虚拟机规范》对如何实现方法区,不做统一要求。例如:BEA JRockit / IBM J9 中不存在永久代的概念。

现在来看,当年使用永久代,不是好的idea。导致Java程序更容易OOM(超过-XX:MaxPermsize上限)

而到了JDK8,终于完全废弃了永久代的概念,改用与JRockit、J9一样在本地内存中实现的元空间(Metaspace)来代替

元空间的本质和永久代类似,都是对JVM规范中方法区的实现。不过元空间与永久代最大的区别在于:元空间不在虚拟机设置的内存中,而是使用本地内存。

永久代、元空间二者并不只是名字变了,内部结构也调整了。

根据《Java虚拟机规范》的规定,如果方法区无法满足新的内存分配需求时,将抛出OOM异常。

3,设置方法区大小与OOM

3.1,设置方法区内存的大小

方法区的大小不必是固定的,JVM可以根据应用的需要动态调整。

jdk7及以前

-

通过来设置永久代初始分配空间。默认值是20.75M

-XX:Permsize -

通过来设定永久代最大可分配空间。32位机器默认是64M,64位机器模式是82M

-XX:MaxPermsize -

当JVM加载的类信息容量超过了这个值,会报异常

OutOfMemoryError:PermGen space。

JDK8以后

-

元数据区大小可以使用参数

-XX:MetaspaceSize和-XX:MaxMetaspaceSize指定 -

默认值依赖于平台。windows下,

-XX:MetaspaceSize=21M -XX:MaxMetaspaceSize=-1//即没有限制。 -

与永久代不同,如果不指定大小,默认情况下,虚拟机会耗尽所有的可用系统内存。如果元数据区发生溢出,虚拟机一样会抛出异常

OutOfMemoryError:Metaspace -

-XX:MetaspaceSize:设置初始的元空间大小。对于一个64位的服务器端JVM来说,其默认的-XX:MetaspaceSize值为21MB。这就是初始的高水位线,一旦触及这个水位线,Full GC将会被触发并卸载没用的类(即这些类对应的类加载器不再存活),然后这个高水位线将会重置。新的高水位线的值取决于GC后释放了多少元空间。如果释放的空间不足,那么在不超过MaxMetaspaceSize时,适当提高该值。如果释放空间过多,则适当降低该值。 -

如果初始化的高水位线设置过低,上述高水位线调整情况会发生很多次。通过垃圾回收器的日志可以观察到Full GC多次调用。为了避免频繁地GC,建议将

-XX:MetaspaceSize设置为一个相对较高的值。

举例1:《深入理解Java虚拟机》的例子

举例2

/**

* jdk8中:

* -XX:MetaspaceSize=10m-XX:MaxMetaspaceSize=10m

* jdk6中:

* -XX:PermSize=10m-XX:MaxPermSize=10m

*/

public class OOMTest extends ClassLoader{

public static void main(String[] args){

int j = 0;

try{

OOMTest test = new OOMTest();

for (int i=0;i<10000;i++){

//创建Classwriter对象,用于生成类的二进制字节码

ClassWriter classWriter = new ClassWriter(0);

//指明版本号,public,类名,包名,父类,接口

classWriter.visit(Opcodes.V1_6, Opcodes.ACC_PUBLIC, "Class" + i, nu1l, "java/lang/Object", null);

//返回byte[]

byte[] code = classWriter.toByteArray();

//类的加载

test.defineClass("Class" + i, code, 0, code.length); //CLass对象

j++;

}

} finally{

System.out.println(j);

}

}

}

3.2,如何解决这些OOM

- 要解决OOM异常或heap space的异常,一般的手段是首先通过内存映像分析工具(如Eclipse Memory Analyzer)对dump出来的堆转储快照进行分析,重点是确认内存中的对象是否是必要的,也就是要先分清楚到底是出现了内存泄漏(Memory Leak)还是内存溢出(Memory Overflow)

- 如果是内存泄漏,可进一步通过工具查看泄漏对象到GC Roots的引用链。于是就能找到泄漏对象是通过怎样的路径与GCRoots相关联并导致垃圾收集器无法自动回收它们的。掌握了泄漏对象的类型信息,以及GCRoots引用链的信息,就可以比较准确地定位出泄漏代码的位置。

- 如果不存在内存泄漏,换句话说就是内存中的对象确实都还必须存活着,那就应当检查虚拟机的堆参数(

-Xmx与-Xms),与机器物理内存对比看是否还可以调大,从代码上检查是否存在某些对象生命周期过长、持有状态时间过长的情况,尝试减少程序运行期的内存消耗。

4,方法区的内部结构

4.1,方法区(Method Area)存储什么

《深入理解Java虚拟机》书中对方法区(Method Area)存储内容描述如下:

它用于存储已被虚拟机加载的类型信息、常量、静态变量、即时编译器编译后的代码缓存等。

4.2,方法区的内部结构

类型信息

对每个加载的类型(类class、接口interface、枚举enum、注解annotation),JVM必须在方法区中存储以下类型信息:

- 这个类型的完整有效名称(全名=包名.类名)

- 这个类型直接父类的完整有效名(对于interface或是java.lang.object,都没有父类)

- 这个类型的修饰符(public,abstract,final的某个子集)

- 这个类型直接接口的一个有序列表

域(Field)信息

JVM必须在方法区中保存类型的所有域的相关信息以及域的声明顺序。

域的相关信息包括:域名称、域类型、域修饰符(public,private,protected,static,final,volatile,transient的某个子集)

方法(Method)信息

JVM必须保存所有方法的以下信息,同域信息一样包括声明顺序:

-

方法名称

-

方法的返回类型(或void)

-

方法参数的数量和类型(按顺序)

-

方法的修饰符(public,private,protected,static,final,synchronized,native,abstract的一个子集)

-

方法的字节码(bytecodes)、操作数栈、局部变量表及大小(abstract和native方法除外)

-

异常表(abstract和native方法除外)

- 每个异常处理的开始位置、结束位置、代码处理在程序计数器中的偏移地址、被捕获的异常类的常量池索引

non-final的类变量

-

静态变量和类关联在一起,随着类的加载而加载,他们成为类数据在逻辑上的一部分

-

类变量被类的所有实例共享,即使没有类实例时,你也可以访问它

public class MethodAreaTest {

public static void main(String[] args) {

Order order = new Order();

order.hello();

System.out.println(order.count);

}

}

class Order {

public static int count = 1;

public static void hello() {

System.out.println("hello!");

}

}

补充说明:全局常量(static final)

被声明为final的类变量的处理方法则不同,每个全局常量在编译的时候就会被分配了。

4.3,运行时常量池 VS 常量池

-

方法区,内部包含了运行时常量池

-

字节码文件,内部包含了常量池

-

要弄清楚方法区,需要理解清楚ClassFile,因为加载类的信息都在方法区。

-

要弄清楚方法区的运行时常量池,需要理解清楚ClassFile中的常量池。

官方文档:https://docs.oracle.com/javase/specs/jvms/se8/html/jvms-4.html

一个有效的字节码文件中除了包含类的版本信息、字段、方法以及接口等描述符信息外,还包含一项信息就是常量池表(Constant Pool Table),包括各种字面量和对类型、域和方法的符号引用

为什么需要常量池?

一个java源文件中的类、接口,编译后产生一个字节码文件。而Java中的字节码需要数据支持,通常这种数据会很大以至于不能直接存到字节码里,换另一种方式,可以存到常量池,这个字节码包含了指向常量池的引用。在动态链接的时候会用到运行时常量池,之前有介绍。

比如:如下的代码:

public class SimpleClass {

public void sayHello() {

System.out.println("hello");

}

}

虽然只有194字节,但是里面却使用了String、System、PrintStream及Object等结构。这里的代码量其实很少了,如果代码多的话,引用的结构将会更多,这里就需要用到常量池了。

常量池中有什么?

击中常量池内存储的数据类型包括:

-

数量值

-

字符串值

-

类引用

-

字段引用

-

方法引用

例如下面这段代码:

public class MethodAreaTest2 {

public static void main(String args[]) {

Object obj = new Object();

}

}

Object obj = new Object();将会被翻译成如下字节码:

0: new #2 // Class java/lang/Object

1: dup

2: invokespecial // Method java/lang/Object ""() V

小结

常量池、可以看做是一张表,虚拟机指令根据这张常量表找到要执行的类名、方法名、参数类型、字面量等类型

4.4, 运行时常量池

-

运行时常量池(Runtime Constant Pool)是方法区的一部分。

-

常量池表(Constant Pool Table)是Class文件的一部分,用于存放编译期生成的各种字面量与符号引用,这部分内容将在类加载后存放到方法区的运行时常量池中。

-

运行时常量池,在加载类和接口到虚拟机后,就会创建对应的运行时常量池。

-

JVM为每个已加载的类型(类或接口)都维护一个常量池。池中的数据项像数组项一样,是通过索引访问的。

-

运行时常量池中包含多种不同的常量,包括编译期就已经明确的数值字面量,也包括到运行期解析后才能够获得的方法或者字段引用。此时不再是常量池中的符号地址了,这里换为真实地址。

-

运行时常量池,相对于Class文件常量池的另一重要特征是:具备动态性。

-

运行时常量池类似于传统编程语言中的符号表(symboltable),但是它所包含的数据却比符号表要更加丰富一些。

-

当创建类或接口的运行时常量池时,如果构造运行时常量池所需的内存空间超过了方法区所能提供的最大值,则JVM会抛OutOfMemoryError异常

5,方法区使用举例

public class MethodAreaDemo {

public static void main(String args[]) {

int x = 500;

int y = 100;

int a = x / y;

int b = 50;

System.out.println(a+b);

}

}

6,方法区的演进细节

-

首先明确:只有Hotspot才有永久代。BEA JRockit、IBMJ9等来说,是不存在永久代的概念的。原则上如何实现方法区属于虚拟机实现细节,不受《Java虚拟机规范》管束,并不要求统一

-

Hotspot中方法区的变化:

6.1,为什么永久代要被元空间替代?

官网地址:JEP 122: Remove the Permanent Generation (java.net)

JRockit是和HotSpot融合后的结果,因为JRockit没有永久代,所以他们不需要配置永久代

随着Java8的到来,HotSpot VM中再也见不到永久代了。但是这并不意味着类的元数据信息也消失了。这些数据被移到了一个与堆不相连的本地内存区域,这个区域叫做元空间(Metaspace)。

由于类的元数据分配在本地内存中,元空间的最大可分配空间就是系统可用内存空间。

这项改动是很有必要的,原因有:

-

为永久代设置空间大小是很难确定的。在某些场景下,如果动态加载类过多,容易产生Perm区的oom。比如某个实际Web工 程中,因为功能点比较多,在运行过程中,要不断动态加载很多类,经常出现致命错误。

而元空间和永久代之间最大的区别在于:元空间并不在虚拟机中,而是使用本地内存。 因此,默认情况下,元空间的大小仅受本地内存限制。"Exception in thread 'dubbo client x.x connector' java.lang.OutOfMemoryError:PermGen space" -

对永久代进行调优是很困难的。

有些人认为方法区(如HotSpot虚拟机中的元空间或者永久代)是没有垃圾收集行为的,其实不然。《Java虚拟机规范》对方法区的约束是非常宽松的,提到过可以不要求虚拟机在方法区中实现垃圾收集。事实上也确实有未实现或未能完整实现方法区类型卸载的收集器存在(如JDK 11时期的ZGC收集器就不支持类卸载)。 一般来说这个区域的回收效果比较难令人满意,尤其是类型的卸载,条件相当苛刻。但是这部分区域的回收有时又确实是必要的。以前Sun公司的Bug列表中,曾出现过的若干个严重的Bug就是由于低版本的HotSpot虚拟机对此区域未完全回收而导致内存泄漏

方法区的垃圾收集主要回收两部分内容:常量池中废弃的常量和不再使用的类型

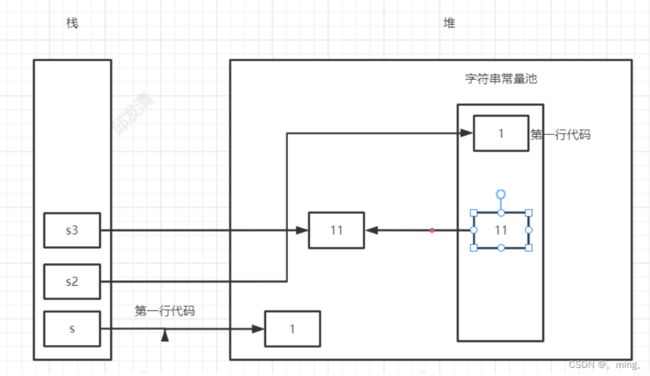

6.2,StringTable为什么要调整位置?

jdk7中将StringTable放到了堆空间中。因为永久代的回收效率很低,在full gc的时候才会触发。而full gc是老年代的空间不足、永久代不足时才会触发。

这就导致StringTable回收效率不高。而我们开发中会有大量的字符串被创建,回收效率低,导致永久代内存不足。放到堆里,能及时回收内存。

6.3,静态变量存放在那里?

/**

* 静态引用对应的对象实体始终都存在堆空间

* jdk7:

* -Xms200m -Xmx200m -XX:PermSize=300m -XX:MaxPermSize=300m -XX:+PrintGCDetails

* jdk8:

* -Xms200m -Xmx200m-XX:MetaspaceSize=300m -XX:MaxMetaspaceSize=300m -XX:+PrintGCDetails

*/

public class StaticFieldTest {

private static byte[] arr = new byte[1024 * 1024 * 100];

public static void main(String[] args) {

System.out.println(StaticFieldTest.arr);

try {

Thread.sleep(1000000);

} catch (InterruptedException e){

e.printStackTrace();

}

}

}

/**

* staticobj、instanceobj、Localobj存放在哪里?

*/

public class StaticobjTest {

static class Test {

static ObjectHolder staticobj = new ObjectHolder();

ObjectHolder instanceobj = new ObjectHolder();

void foo(){

ObjectHolder localobj = new ObjectHolder();

System.out.println("done");

}

}

private static class ObjectHolder{

public static void main(String[] args) {

Test test = new StaticobjTest.Test();

test.foo();

}

}

}

使用JHSDB工具进行分析,这里细节略掉

staticobj随着Test的类型信息存放在方法区,instanceobj随着Test的对象实例存放在Java堆,localobject则是存放在foo()方法栈帧的局部变量表中。

![]()

测试发现:三个对象的数据在内存中的地址都落在Eden区范围内,所以结论:只要是对象实例必然会在Java堆中分配。

接着,找到了一个引用该staticobj对象的地方,是在一个java.lang.Class的实例里,并且给出了这个实例的地址,通过Inspector查看该对象实例,可以清楚看到这确实是一个java.lang.Class类型的对象实例,里面有一个名为staticobj的实例字段:

从《Java虚拟机规范》所定义的概念模型来看,所有Class相关的信息都应该存放在方法区之中,但方法区该如何实现,《Java虚拟机规范》并未做出规定,这就成了一件允许不同虚拟机自己灵活把握的事情。JDK7及其以后版本的HotSpot虚拟机选择把静态变量与类型在Java语言一端的映射class对象存放在一起,存储于Java堆之中,从我们的实验中也明确验证了这一点

7,方法区的垃圾回收

有些人认为方法区(如Hotspot虚拟机中的元空间或者永久代)是没有垃圾收集行为的,其实不然。《Java虚拟机规范》对方法区的约束是非常宽松的,提到过可以不要求虚拟机在方法区中实现垃圾收集。事实上也确实有未实现或未能完整实现方法区类型卸载的收集器存在(如JDK11时期的zGC收集器就不支持类卸载)。

一般来说这个区域的回收效果比较难令人满意,尤其是类型的卸载,条件相当苛刻。但是这部分区域的回收有时又确实是必要的。以前sun公司的Bug列表中,曾出现过的若干个严重的Bug就是由于低版本的HotSpot虚拟机对此区域未完全回收而导致内存泄漏。

方法区的垃圾收集主要回收两部分内容:常量池中废弃的常量和不再使用的类型。

先来说说方法区内常量池之中主要存放的两大类常量:字面量和符号引用。字面量比较接近Java语言层次的常量概念,如文本字符串、被声明为final的常量值等。而符号引用则属于编译原理方面的概念,包括下面三类常量:

-

类和接口的全限定名

-

字段的名称和描述符

-

方法的名称和描述符

HotSpot虚拟机对常量池的回收策略是很明确的,只要常量池中的常量没有被任何地方引用,就可以被回收。

回收废弃常量与回收Java堆中的对象非常类似。

判定一个常量是否“废弃”还是相对简单,而要判定一个类型是否属于“不再被使用的类”的条件就比较苛刻了。需要同时满足下面三个条件:

-

该类所有的实例都已经被回收,也就是Java堆中不存在该类及其任何派生子类的实例。

-

加载该类的类加载器已经被回收,这个条件除非是经过精心设计的可替换类加载器的场景,如OSGi、JSP的重加载等,否则通常是很难达成的。

-

该类对应的java.lang.Class对象没有在任何地方被引用,无法在任何地方通过反射访问该类的方法。

Java虚拟机被允许对满足上述三个条件的无用类进行回收,这里说的仅仅是“被允许”,而并不是和对象一样,没有引用了就必然会回收。关于是否要对类型进行回收,HotSpot虚拟机提供了-Xnoclassgc参数进行控制,还可以使用-verbose:class 以及 -XX:+TraceClassLoading、-XX:+TraceClassUnLoading查看类加载和卸载信息

在大量使用反射、动态代理、CGLib等字节码框架,动态生成JSP以及OSGi这类频繁自定义类加载器的场景中,通常都需要Java虚拟机具备类型卸载的能力,以保证不会对方法区造成过大的内存压力。

8,总结

常见面试题

百度:

说一下JVM内存模型吧,有哪些区?分别干什么的?

蚂蚁金服:

Java8的内存分代改进 JVM内存分哪几个区,每个区的作用是什么?

一面:JVM内存分布/内存结构?栈和堆的区别?堆的结构?为什么两个survivor区?

二面:Eden和survior的比例分配

小米:

jvm内存分区,为什么要有新生代和老年代

字节跳动:

二面:Java的内存分区

二面:讲讲Jvm运行时数据库区 什么时候对象会进入老年代?

京东:

JVM的内存结构,Eden和Survivor比例。

JVM内存为什么要分成新生代,老年代,持久代。

新生代中为什么要分为Eden和survivor。

天猫:

一面:Jvm内存模型以及分区,需要详细到每个区放什么。

一面:JVM的内存模型,Java8做了什么改

拼多多:

JVM内存分哪几个区,每个区的作用是什么?

美团:

java内存分配 jvm的永久代中会发生垃圾回收吗?

一面:jvm内存分区,为什么要有新生代和老年代?

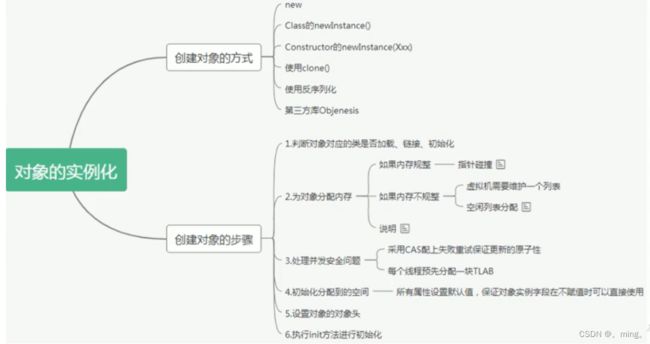

八,对象实例化及直接内存

1,对象实例化

面试题

美团:

对象在JVM中是怎么存储的?

对象头信息里面有哪些东西?

蚂蚁金服:

Java对象头有什么?

1.1,创建对象的方式

-

new:最常见的方式、Xxx的静态方法,XxxBuilder/XxxFactory的静态方法

-

Class的newInstance方法:反射的方式,只能调用空参的构造器,权限必须是public

-

Constructor的newInstance(XXX):反射的方式,可以调用空参、带参的构造器,权限没有要求

-

使用clone():不调用任何的构造器,要求当前的类需要实现Cloneable接口,实现clone()

-

使用反序列化:从文件中、从网络中获取一个对象的二进制流

-

第三方库 Objenesis

1.2,创建对象的步骤

前面所述是从字节码角度看待对象的创建过程,现在从执行步骤的角度来分析:

1. 判断对象对应的类是否加载、链接、初始化

虚拟机遇到一条new指令,首先去检查这个指令的参数能否在Metaspace(元空间)的常量池中定位到一个类的符号引用,并且检查这个符号引用代表的类是否已经被加载,解析和初始化(即判断类元信息是否存在)。

如果没有,那么在双亲委派模式下,使用当前类加载器以ClassLoader + 包名 + 类名为key进行查找对应的 .class文件;

-

如果没有找到文件,则抛出ClassNotFoundException异常

-

如果找到,则进行类加载,并生成对应的Class对象

2. 为对象分配内存

首先计算对象占用空间的大小,接着在堆中划分一块内存给新对象。如果实例成员变量是引用变量,仅分配引用变量空间即可,即4个字节大小

如果内存规整:虚拟机将采用的是指针碰撞法(Bump The Point)来为对象分配内存。

- 意思是所有用过的内存在一边,空闲的内存放另外一边,中间放着一个指针作为分界点的指示器,分配内存就仅仅是把指针指向空闲那边挪动一段与对象大小相等的距离罢了。如果垃圾收集器选择的是Serial ,ParNew这种基于压缩算法的,虚拟机采用这种分配方式。一般使用带Compact(整理)过程的收集器时,使用指针碰撞。

如果内存不规整:虚拟机需要维护一个空闲列表(Free List)来为对象分配内存。

- 已使用的内存和未使用的内存相互交错,那么虚拟机将采用的是空闲列表来为对象分配内存。意思是虚拟机维护了一个列表,记录上那些内存块是可用的,再分配的时候从列表中找到一块足够大的空间划分给对象实例,并更新列表上的内容。

选择哪种分配方式由Java堆是否规整所决定,而Java堆是否规整又由所采用的垃圾收集器是否带有压缩整理功能决定。

3. 处理并发问题

-

采用CAS失败重试、区域加锁保证更新的原子性

-

每个线程预先分配一块TLAB:通过设置

-XX:+UseTLAB参数来设定

4. 初始化分配到的内存

所有属性设置默认值,保证对象实例字段在不赋值时可以直接使用

5. 设置对象的对象头

将对象的所属类(即类的元数据信息)、对象的HashCode和对象的GC信息、锁信息等数据存储在对象的对象头中。这个过程的具体设置方式取决于JVM实现。

6. 执行init方法进行初始化

在Java程序的视角看来,初始化才正式开始。初始化成员变量,执行实例化代码块,调用类的构造方法,并把堆内对象的首地址赋值给引用变量。

因此一般来说(由字节码中跟随invokespecial指令所决定),new指令之后会接着就是执行方法,把对象按照程序员的意愿进行初始化,这样一个真正可用的对象才算完成创建出来。

给对象属性赋值的操作

-

属性的默认初始化

-

显式初始化

-

代码块中初始化

-

构造器中初始化

-

后三种初始化是在执行init方法进行初始化的时候完成的

对象实例化的过程

- 加载类元信息

- 为对象分配内存

- 处理并发问题

- 属性的默认初始化(零值初始化)

- 设置对象头信息

- 属性的显示初始化、代码块中初始化、构造器中初始化

2,对象内存布局

2.1,对象头(Header)

对象头包含了两部分,分别是运行时元数据(Mark Word)和类型指针。如果是数组,还需要记录数组的长度

运行时元数据

-

哈希值(HashCode)

-

GC分代年龄

-

锁状态标志

-

线程持有的锁

-

偏向线程ID

-

翩向时间戳

类型指针

指向类元数据InstanceKlass(实例类),确定该对象所属的类型。

2.2,实例数据(Instance Data)

它是对象真正存储的有效信息,包括程序代码中定义的各种类型的字段(包括从父类继承下来的和本身拥有的字段)

-

相同宽度的字段总是被分配在一起

-

父类中定义的变量会出现在子类之前

-

如果CompactFields参数为true(默认为true):子类的窄变量可能插入到父类变量的空隙

2.3,对齐填充(Padding)

不是必须的,也没有特别的含义,仅仅起到占位符的作用

举例

public class Customer{

int id = 1001;

String name;

Account acct;

{

name = "匿名客户";

}

public Customer() {

acct = new Account();

}

}

public class CustomerTest{

public static void main(string[] args){

Customer cust=new Customer();

}

}

图示

小结

3,对象的访问定位

JVM是如何通过栈帧中的对象引用访问到其内部的对象实例呢?

3.1,句柄访问

reference中存储稳定句柄地址,对象被移动(垃圾收集时移动对象很普遍)时只会改变句柄中实例数据指针即可,reference本身不需要被修改

3.2,直接指针(HotSpot采用)

直接指针是局部变量表中的引用,直接指向堆中的实例,在对象实例中有类型指针,指向的是方法区中的对象类型数据。

4,直接内存(Direct Memory)

4.1,直接内存概述

不是虚拟机运行时数据区的一部分,也不是《Java虚拟机规范》中定义的内存区域。直接内存是在Java堆外的、直接向系统申请的内存区间。来源于NIO,通过存在堆中的DirectByteBuffer操作Native内存。通常,访问直接内存的速度会优于Java堆,即读写性能高。

-

因此出于性能考虑,读写频繁的场合可能会考虑使用直接内存。

/** 这个例子是通过对比IO和NIO的速度,从而知道了NIO的访问数读块 */ public class BufferTest1 { private static final String TO = "F:\\test\\异界BD中字.mp4"; private static final int _100Mb = 1024 * 1024 * 100; public static void main(String[] args) { long sum = 0; String src = "F:\\test\\异界BD中字.mp4"; for (int i = 0; i < 3; i++) { String dest = "F:\\test\\异界BD中字_" + i + ".mp4"; // sum += io(src,dest);//54606 sum += directBuffer(src,dest);//50244 } System.out.println("总花费的时间为:" + sum ); } private static long directBuffer(String src,String dest) { long start = System.currentTimeMillis(); FileChannel inChannel = null; FileChannel outChannel = null; try { inChannel = new FileInputStream(src).getChannel(); outChannel = new FileOutputStream(dest).getChannel(); ByteBuffer byteBuffer = ByteBuffer.allocateDirect(_100Mb); while (inChannel.read(byteBuffer) != -1) { byteBuffer.flip();//修改为读数据模式 outChannel.write(byteBuffer); byteBuffer.clear();//清空 } } catch (IOException e) { e.printStackTrace(); } finally { if (inChannel != null) { try { inChannel.close(); } catch (IOException e) { e.printStackTrace(); } } if (outChannel != null) { try { outChannel.close(); } catch (IOException e) { e.printStackTrace(); } } } long end = System.currentTimeMillis(); return end - start; } private static long io(String src,String dest) { long start = System.currentTimeMillis(); FileInputStream fis = null; FileOutputStream fos = null; try { fis = new FileInputStream(src); fos = new FileOutputStream(dest); byte[] buffer = new byte[_100Mb]; while (true) { int len = fis.read(buffer); if (len == -1) { break; } fos.write(buffer, 0, len); } } catch (IOException e) { e.printStackTrace(); } finally { if (fis != null) { try { fis.close(); } catch (IOException e) { e.printStackTrace(); } } if (fos != null) { try { fos.close(); } catch (IOException e) { e.printStackTrace(); } } } long end = System.currentTimeMillis(); return end - start; } } -

Java的NIO库允许Java程序使用直接内存,用于数据缓冲区

4.2,非直接缓存区

使用IO读写文件,需要与磁盘交互,需要由用户态切换到内核态。在内核态时,需要两份内存存储重复数据,效率低。

4.3,直接缓存区

使用NIO时,操作系统划出的直接缓存区可以被java代码直接访问,只有一份。NIO适合对大文件的读写操作。

也可能导致OutOfMemoryError异常

/**

* 本地内存的OOM: OutOfMemoryError: Direct buffer memory

* 需要设置直接内存为10MB

* @author shkstart [email protected]

* @create 2020 0:09

*/

public class BufferTest2 {

private static final int BUFFER = 1024 * 1024 * 20;//20MB

public static void main(String[] args) {

ArrayList<ByteBuffer> list = new ArrayList<>();

int count = 0;

try {

while(true){

ByteBuffer byteBuffer = ByteBuffer.allocateDirect(BUFFER);

list.add(byteBuffer);

count++;

try {

Thread.sleep(100);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

} finally {

System.out.println(count);

}

}

}

Exception in thread "main" java.lang.OutOfMemoryError: Direct buffer memory

at java.nio.Bits.reserveMemory(Bits.java:693)

at java.nio.DirectByteBuffer.<init>(DirectByteBuffer.java:123)

at java.nio.ByteBuffer.allocateDirect(ByteBuffer.java:311)

at com.atguigu.java.BufferTest2.main(BufferTest2.java:20)

由于直接内存在Java堆外,因此它的大小不会直接受限于-Xmx指定的最大堆大小,但是系统内存是有限的,Java堆和直接内存的总和依然受限于操作系统能给出的最大内存。

-

分配回收成本较高

-

不受JVM内存回收管理

直接内存大小可以通过MaxDirectMemorySize设置。如果不指定,默认与堆的最大值-Xmx参数值一致

Java进程内存=java堆+本机内存

九,执行引擎

1,执行引擎概述

执行引擎属于JVM的下层,里面包括解释器、及时编译器、垃圾回收器

执行引擎是Java虚拟机核心的组成部分之一。

“虚拟机”是一个相对于“物理机”的概念,这两种机器都有代码执行能力,其区别是物理机的执行引擎是直接建立在处理器、缓存、指令集和操作系统层面上的,而虚拟机的执行引擎则是由软件自行实现的,因此可以不受物理条件制约地定制指令集与执行引擎的结构体系,能够执行那些不被硬件直接支持的指令集格式。

JVM的主要任务是负责装载字节码到其内部,但字节码并不能够直接运行在操作系统之上,因为字节码指令并非等价于本地机器指令,它内部包含的仅仅只是一些能够被JVM所识别的字节码指令、符号表,以及其他辅助信息。

那么,如果想要让一个Java程序运行起来,执行引擎(Execution Engine)的任务就是将字节码指令解释/编译为对应平台上的本地机器指令才可以(后端编译)。简单来说,JVM中的执行引擎充当了将高级语言翻译为机器语言的译者。

9.1,执行引擎的工作流程

- 执行引擎在执行的过程中究竟需要执行什么样的字节码指令完全依赖于PC寄存器。

- 每当执行完一项指令操作后,PC寄存器就会更新下一条需要被执行的指令地址。

- 当然方法在执行的过程中,执行引擎有可能会通过存储在局部变量表中的对象引用准确定位到存储在Java堆区中的对象实例信息,以及通过对象头中的元数据指针定位到目标对象的类型信息。

从外观上来看,所有的Java虚拟机的执行引擎输入,输出都是一致的:输入的是字节码二进制流,处理过程是字节码解析执行的等效过程,输出的是执行过程。

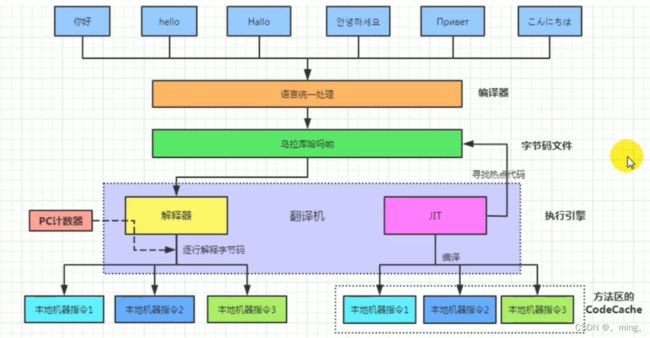

2,Java代码编译和执行过程

大部分的程序代码转换成物理机的目标代码或虚拟机能执行的指令集之前,都需要经过上图中的各个步骤

Java代码编译是由Java源码编译器(前端编译器)来完成,流程图如下所示:

Java字节码的执行是由JVM执行引擎(后端编译器)来完成,流程图如下所示

2.1, 什么是解释器(Interpreter)?什么是JIT编译器?

解释器:当Java虚拟机启动时会根据预定义的规范对字节码采用逐行解释的方式执行,将每条字节码文件中的内容“翻译”为对应平台的本地机器指令执行。

JIT(Just In Time Compiler)编译器:就是虚拟机将源代码直接编译成和本地机器平台相关的机器语言。

2.2,为什么Java是半编译半解释型语言?

JDK1.0时代,将Java语言定位为“解释执行”还是比较准确的。再后来,Java也发展出可以直接生成本地代码的编译器。现在JVM在执行Java代码的时候,通常都会将解释执行与编译执行二者结合起来进行。

图示

3,机器码、指令、汇编语言

3.1,机器码

各种用二进制编码方式表示的指令,叫做机器指令码。开始,人们就用它采编写程序,这就是机器语言。

机器语言虽然能够被计算机理解和接受,但和人们的语言差别太大,不易被人们理解和记忆,并且用它编程容易出差错。

用它编写的程序一经输入计算机,CPU直接读取运行,因此和其他语言编的程序相比,执行速度最快。

机器指令与CPU紧密相关,所以不同种类的CPU所对应的机器指令也就不同。

3.2,指令

由于机器码是有0和1组成的二进制序列,可读性实在太差,于是人们发明了指令。

指令就是把机器码中特定的0和1序列,简化成对应的指令(一般为英文简写,如mov,inc等),可读性稍好

由于不同的硬件平台,执行同一个操作,对应的机器码可能不同,所以不同的硬件平台的同一种指令(比如mov),对应的机器码也可能不同。

3.3,指令集

不同的硬件平台,各自支持的指令,是有差别的。因此每个平台所支持的指令,称之为对应平台的指令集。 如常见的

-

x86指令集,对应的是x86架构的平台

-

ARM指令集,对应的是ARM架构的平台

3.4,汇编语言

由于指令的可读性还是太差,于是人们又发明了汇编语言。

在汇编语言中,用助记符(Mnemonics)代替机器指令的操作码,用地址符号(Symbol)或标号(Label)代替指令或操作数的地址。

在不同的硬件平台,汇编语言对应着不同的机器语言指令集,通过汇编过程转换成机器指令。

由于计算机只认识指令码,所以用汇编语言编写的程序还必须翻译成机器指令码,计算机才能识别和执行。

3.5,高级语言

为了使计算机用户编程序更容易些,后来就出现了各种高级计算机语言。高级语言比机器语言、汇编语言更接近人的语言

当计算机执行高级语言编写的程序时,仍然需要把程序解释和编译成机器的指令码。完成这个过程的程序就叫做解释程序或编译程序。

高级语言也不是直接翻译成机器指令,而是翻译成汇编语言码,如下面说的C和C++。

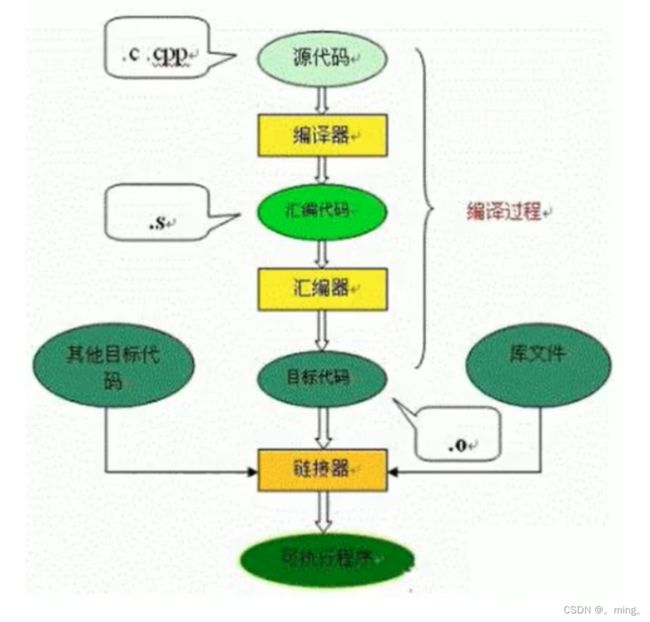

C、C++源程序执行过程

编译过程又可以分成两个阶段:编译和汇编。

编译过程:是读取源程序(字符流),对之进行词法和语法的分析,将高级语言指令转换为功能等效的汇编代码

汇编过程:实际上指把汇编语言代码翻译成目标机器指令的过程。

3.6,字节码

字节码是一种中间状态(中间码)的二进制代码(文件),它比机器码更抽象,需要直译器转译后才能成为机器码

字节码主要为了实现特定软件运行和软件环境、与硬件环境无关。

字节码的实现方式是通过编译器和虚拟机器。编译器将源码编译成字节码,特定平台上的虚拟机器将字节码转译为可以直接执行的指令。字节码典型的应用为:Java bytecode

4,解释器

JVM设计者们的初衷仅仅只是单纯地为了满足Java程序实现跨平台特性,因此避免采用静态编译的方式直接生成本地机器指令,从而诞生了实现解释器在运行时采用逐行解释字节码执行程序的想法。

为什么Java源文件不直接翻译成JMV,而是翻译成字节码文件?可能是因为直接翻译的代价是比较大的

4.1,解释器工作机制

解释器真正意义上所承担的角色就是一个运行时“翻译者”,将字节码文件中的内容“翻译”为对应平台的本地机器指令执行。

当一条字节码指令被解释执行完成后,接着再根据PC寄存器中记录的下一条需要被执行的字节码指令执行解释操作。

4.2,解释器分类

在Java的发展历史里,一共有两套解释执行器,即古老的字节码解释器、现在普遍使用的模板解释器。

-

字节码解释器在执行时通过纯软件代码模拟字节码的执行,效率非常低下。

-

而模板解释器将每一条字节码和一个模板函数相关联,模板函数中直接产生这条字节码执行时的机器码,从而很大程度上提高了解释器的性能。

在HotSpot VM中,解释器主要由Interpreter模块和Code模块构成。

-

Interpreter模块:实现了解释器的核心功能

-

Code模块:用于管理HotSpot JVM在运行时生成的本地机器指令

4.3,现状

由于解释器在设计和实现上非常简单,因此除了Java语言之外,还有许多高级语言同样也是基于解释器执行的,比如Python、Perl、Ruby等。但是在今天,基于解释器执行已经沦落为低效的代名词,并且时常被一些C/C++程序员所调侃。

为了解决这个问题,JVM平台支持一种叫作即时编译的技术。即时编译的目的是避免函数被解释执行,而是将整个函数体编译成为机器码,每次函数执行时,只执行编译后的机器码即可,这种方式可以使执行效率大幅度提升。

不过无论如何,基于解释器的执行模式仍然为中间语言的发展做出了不可磨灭的贡献。

5,JIT编译器

5.1,Java代码的执行分类

-

第一种是将源代码编译成字节码文件,然后在运行时通过解释器将字节码文件转为机器码执行

-

第二种是编译执行(直接编译成机器码,但是要知道不同机器上编译的机器码是不一样,而字节码是可以跨平台的)。现代虚拟机为了提高执行效率,会使用即时编译技术(JIT,Just In Time)将方法编译成机器码后再执行

HotSpot VM是目前市面上高性能虚拟机的代表作之一。它采用解释器与即时编译器并存的架构。在Java虚拟机运行时,解释器和即时编译器能够相互协作,各自取长补短,尽力去选择最合适的方式来权衡编译本地代码的时间和直接解释执行代码的时间。

在今天,Java程序的运行性能早已脱胎换骨,已经达到了可以和C/C++ 程序一较高下的地步。

问题来了

有些开发人员会感觉到诧异,既然HotSpot VM中已经内置JIT编译器了,那么为什么还需要再使用解释器来“拖累”程序的执行性能呢?比如JRockit VM内部就不包含解释器,字节码全部都依靠即时编译器编译后执行。

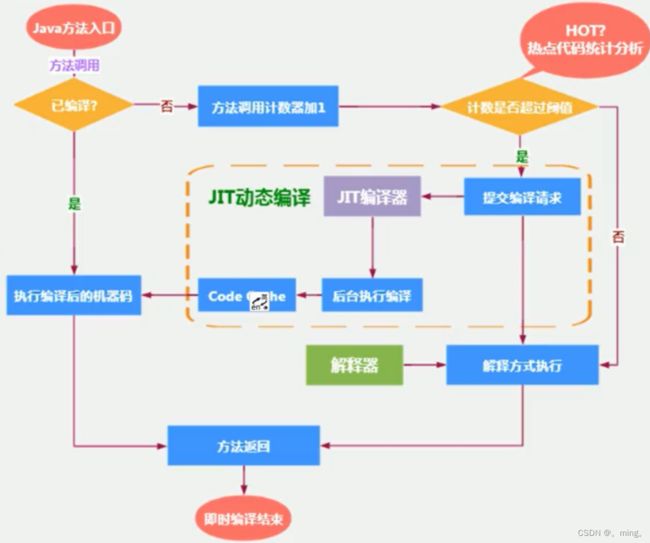

首先明确: 当程序启动后,解释器可以马上发挥作用,省去编译的时间,立即执行。 编译器要想发挥作用,把代码编译成本地代码,需要一定的执行时间。但编译为本地代码后,执行效率高。

所以: 尽管JRockit JVM中程序的执行性能会非常高效,但程序在启动时必然需要花费更长的时间来进行编译。对于服务端应用来说,启动时间并非是关注重点,但对于那些看中启动时间的应用场景而言,或许就需要采用解释器与即时编译器并存的架构来换取一个平衡点。在此模式下,当Java虚拟器启动时,解释器可以首先发挥作用,而不必等待即时编译器全部编译完成后再执行,这样可以省去许多不必要的编译时间。随着时间的推移,编译器发挥作用,把越来越多的代码编译成本地代码,获得更高的执行效率。

同时,解释执行在编译器进行激进优化不成立的时候,作为编译器的“逃生门”。

5.2,HotSpot JVM执行方式

当虚拟机启动的时候,解释器可以首先发挥作用,而不必等待即时编译器全部编译完成再执行,这样可以省去许多不必要的编译时间。并且随着程序运行时间的推移,即时编译器逐渐发挥作用,根据热点探测功能,将有价值的字节码编译为本地机器指令,以换取更高的程序执行效率。

案例来了

注意解释执行与编译执行在线上环境微妙的辩证关系。机器在热机状态可以承受的负载要大于冷机状态。如果以热机状态时的流量进行切流,可能使处于冷机状态的服务器因无法承载流量而假死。

在生产环境发布过程中,以分批的方式进行发布,根据机器数量划分成多个批次,每个批次的机器数至多占到整个集群的1/8。曾经有这样的故障案例:某程序员在发布平台进行分批发布,在输入发布总批数时,误填写成分为两批发布。如果是热机状态,在正常情况下一半的机器可以勉强承载流量,但由于刚启动的JVM均是解释执行,还没有进行热点代码统计和JIT动态编译,导致机器启动之后,当前1/2发布成功的服务器马上全部宕机,此故障说明了JIT的存在。—阿里团队

5.3,概念解释

Java 语言的“编译期”其实是一段“不确定”的操作过程,因为它可能是指一个前端编译器(其实叫“编译器的前端”更准确一些)把.java文件转变成.class文件的过程;

也可能是指虚拟机的后端运行期编译器(JIT编译器,Just In Time Compiler)把字节码转变成机器码的过程。

还可能是指使用静态提前编译器(AOT编译器,Ahead of Time Compiler)直接把.java文件编译成本地机器代码的过程。

-

前端编译器:Sun的Javac、Eclipse JDT中的增量式编译器(ECJ)。

-

JIT编译器:HotSpot VM的C1、C2编译器。

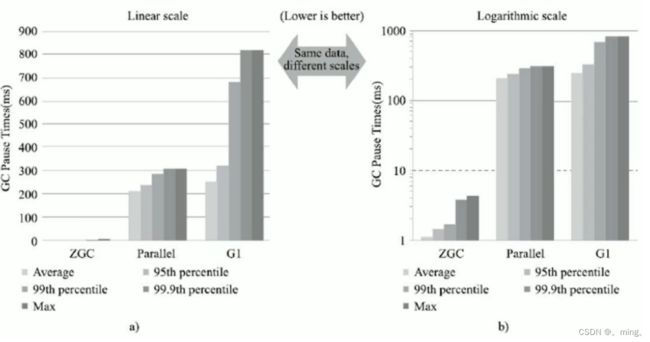

-