NLP领域的机器阅读理解方向的数据集总结

一、cloze-style(完形填空样式)

1.CNN / Daily Mail数据集(英文)

出自论文Hermann et al., 2015的《Teaching machines to read and comprehend.》

这是一个使用启发式方法从CNN和Daily Mail新闻文章中创建的完形填空样式的阅读理解数据集(英文)。Close-style表示必须推断出一个缺失的单词。在本例中,“问题”是通过从总结本文一个或多个方面的要点替换实体而创建的。用实体标记@entityn替换了Coreferent实体,其中n是一个不同的索引。该模型的任务是根据相应文章的内容推断出项目符号中缺失的实体,并根据accuracy对模型进行评价。

这个数据集是nlp的机器阅读理解领域比较经典的数据集,很多机器阅读理论文提出的模型都使用了该数据集进行验证比较。

2.Children’s Book Test(英文)

来自论文[Hill et al., 2016]的《The goldilocks principle: Reading children’s books with explicit memory representations.》

从一本儿童读物中选出21个连续的句子。然后,将前20个句子视为上下文,问题就是为了推断第21个句子中缺少的单词。

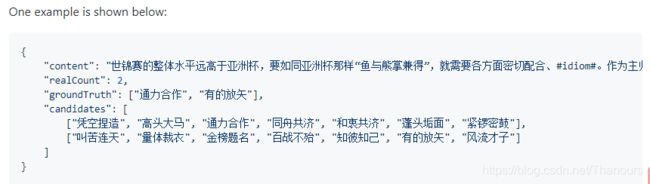

3. ChiD(中文)

一个用于完形填空测试的大规模汉语成语数据集 ,有官方数据集和比赛数据集两个。

数据集下载链接:GitHub - chujiezheng/ChID-Dataset: ChID: A Large-scale Chinese IDiom Dataset for Cloze Test

论文:ChID: A Large-scale Chinese IDiom Dataset for Cloze Test - ACL Anthology

比赛链接:Chinese Idiom Understanding Contest - Biendata

4.The LAMBADA dataset

论文:The LAMBADA dataset: Word prediction requiring a broad discourse context(论文链接)

英文完形填空式数据集

数据集下载:The LAMBADA dataset | Zenodo

二、Muti-Choice(多项选择题)

1. MCTest(英文)

Richardson等人于2013年构建了自神经网络浪潮以来的第一个综合性阅读理解数据集MCTest,该数据集包含660个虚构故事,每个故事有4个问题和4个候选答案。

论文:Mctest: A challenge dataset for the open-domain machine comprehension of text.

2.RACE(英文)

Lai等人于2017年收集了2万多篇文章和10万多道题目来自中国初高中学生的英语考试,涉及的领域非常广泛。这些问题是由专家提出的,最初是为了检验人类的阅读理解水平。因此,回答这个问题需要机器具备一定的推理能力。

论文:RACE: large-scale reading comprehension dataset from examinations.

3. AI2 Reasoning Challenge (ARC)数据集(英文)

这是一个问题回答的英文考试数据集,其中包含7787个真正的小学水平的多项选择科学问题。 每个问题都有一个选择结构(通常是4个答案选项)。 这些问题被分为一个由2590个“困难”问题(检索和共现方法都不能正确回答的问题)组成的挑战集和一个由5197个问题组成的简单集。 每一个都预先划分为Train、Development和Test集。模型的评估基于accuracy。

获得ARC数据集网址:AI2 Reasoning Challenge (ARC) 2018 Dataset — Allen Institute for AI (公开网址)

4. CommonsenseQA(英文)

来自于ConceptNet,其包含大约12000个需要结合背景知识的问题。在该数据集中,标注者根据ConceptNet中的实体概念来自由构造问题,来使问题包含人类所具有的、但难以在网络资源中检索到的背景知识,故回答问题需要利用问题、候选答案,以及仅仅使用检索策略无法检索到的背景知识。

论文:https://arxiv.org/abs/1811.00937

三、Span-Prediction(片段抽取式)

1. SQuAD(英文)

由Rajpurkar等人《Squad: 100, 000+ questions for machine comprehension of text.》2016年提出的英文阅读理解数据集。SQuAD数据集是问答题而非选择题,因此其没有候选答案可以参考,但是其限定了答案为原文中连续的片段。其包含的数据量大于体力劳动者在536个维基百科中发现了10万个问题。每个问题对应一个特定的段落,问题的答案位于段落的一个跨度上。基于小队的挑战极大地促进了MRC的繁荣。

Rajpurkar等人于2018年发布了SQuAD 2.0版数据集。SQuAD是目前阅读理解领域中最为经典的机器阅读理解英文数据集。许多优秀的论文或者SOTA模型(例如BERT)都是使用SQuAD数据集。

获取SQuAD 1.0与2.0版官方来源:https://rajpurkar.github.io/SQuAD-explorer/

2. DuReader(中文)

DuReader是百度在自然语言处理国际顶会 ACL 2018 发布的中文机器阅读理解数据集,所有的问题、原文都来源于百度搜索引擎数据和百度知道问答社区,答案是由人工整理的。实验是在 DuReader 的单文档、抽取类的子集上进行的,训练集包含15763个文档和问题,验证集包含1628个文档和问题,目标是从篇章中抽取出连续片段作为答案。[链接: https://arxiv.org/pdf/1711.05073.pdf]

3. DRCD(繁体中文)

DRCD是台达研究院发布的繁体中文阅读理解数据集,目标是从篇章中抽取出连续片段作为答案。我们在实验时先将其转换成简体中文。

下载链接: https://github.com/DRCKnowledgeTeam/DRCD

论文:https://arxiv.org/abs/1806.00920

4.TriviaQA(英文)

包含超过650K个问题-答案-证据三元组。与其他数据集相比,TriviaQA在问题和相应的答案-证据句之间具有相当大的句法和词汇可变性,需要更多的跨句推理才能找到答案。

论文:Triviaqa: A large scale distantly supervised challenge dataset for reading comprehension.

四、生成式阅读理解

1. NarrativeQA(英文)

[Kocisky ' et al., 2018]提出了NarrativeQA,一种更困难的数据集,旨在增加问题的难度,使其不容易找到答案。数据集包含1567个完整的图书和剧本故事。问题和答案是由人类书写的,而且大多是更复杂的形式,比如“当/哪里/谁/为什么”。

2.CoQA(英文)

对话式阅读理解数据集,这跟现实生活又近了一步,是现在研究的热点。CoQA包含约8000轮对话,问题的答案有五种类型,分别为Yes、No、Unknown,文章中的一个span和生成式答案。当根据文章和之前的对话信息无法回答当前问题时,答案为Unknown。该数据集不仅提供答案,而且给出了答案的依据,每一种类型的答案的依据都是文章中的一个span。

可应用于片段抽取式和生成式阅读理解

论文地址

五、其他形式

1. NLPCC2016-DBQA(中文)

NLPCC2016-DBQA是由国际自然语言处理和中文计算会议 NLPCC 于 2016 年举办的评测任务,其目标是从候选中找到合适的文档作为问题的答案。[链接: http://tcci.ccf.org.cn/conference/2016/dldoc/evagline2.pdf]

六、Reference

[1] A Survey on Neural Machine Reading Comprehension

[2] 阅读理解数据集综述

继续更新中。。。