【AI周报】英伟达新架构发布,AI芯片上限提升九倍;GNN for Science: 腾讯AI Lab、清华发文:等变图神经网络

01 行业大事件

英伟达新架构发布,AI芯片上限提升了九倍,20块带宽就等于全球互联网

黄仁勋:芯片每代性能都翻倍,而且下个「TensorFlow」级 AI 工具可是我英伟达出的。

每年春天,AI 从业者和游戏玩家都会期待英伟达的新发布,今年也不例外。

北京时间 3 月 22 日晚,新一年度的 GTC 大会如期召开,英伟达创始人、CEO 黄仁勋这次走出了自家厨房,进入元宇宙进行 Keynote 演讲:

「我们已经见证了 AI 在科学领域发现新药、新化合物的能力。人工智能现在学习生物和化学,就像此前理解图像、声音和语音一样。」黄仁勋说道「一旦计算机能力跟上,像制药这样的行业就会经历此前科技领域那样的变革。」

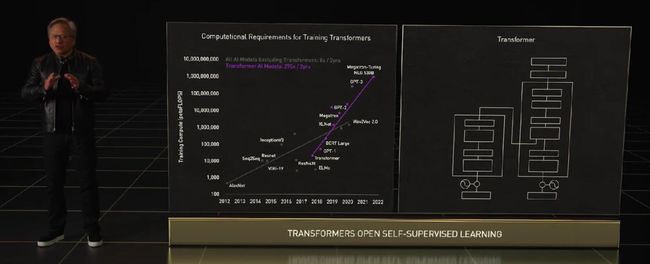

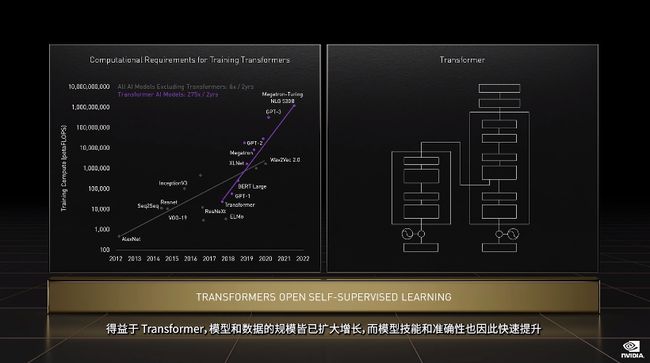

GPU 发展引爆的 AI 浪潮从开始到今天还没过去十年,Transformer 这样的预训练模型和自监督学习模型,已经不止一次出现「算不起」的情况了。

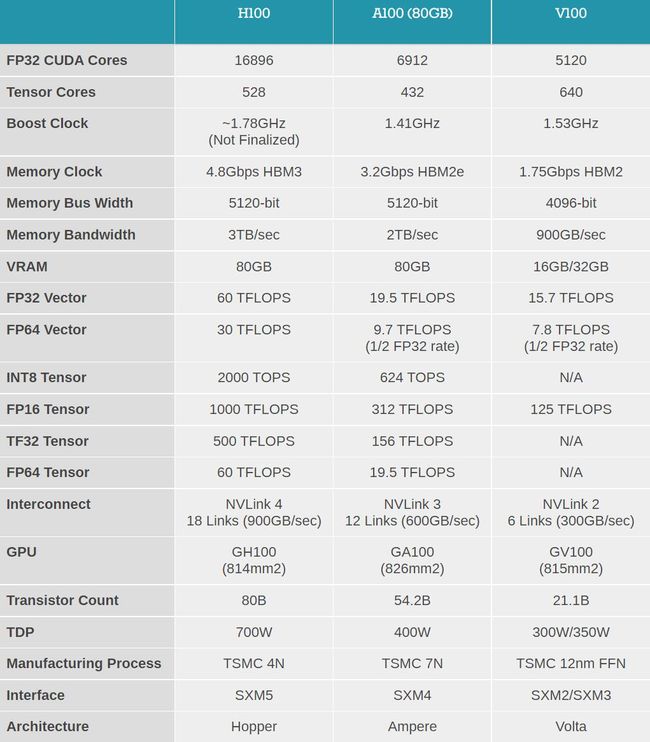

算力需求因为大模型呈指数级上升,老黄这次拿出的是面向高性能计算(HPC)和数据中心的下一代 Hopper 架构,搭载新一代芯片的首款加速卡被命名为 H100,它就是 A100 的替代者。

Hopper 架构的名称来自于计算机科学先驱 Grace Hopper,其延续英伟达每代架构性能翻倍的「传统」,还有更多意想不到的能力。

为 GPT-3 这样的大模型专门设计芯片

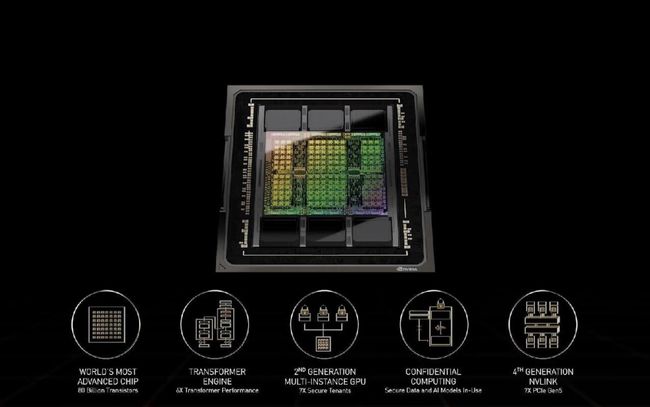

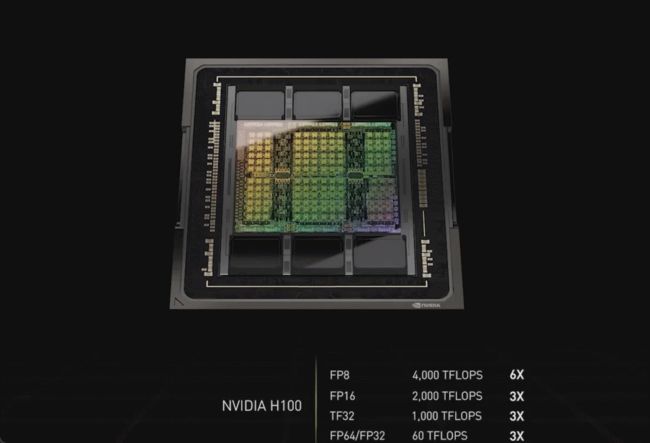

H100 使用台积电 5nm 定制版本制程(4N)打造,单块芯片包含 800 亿晶体管。它同时也是全球首款 PCI-E 5 和 HBM 3 显卡,一块 H100 的 IO 带宽就是 40 terabyte 每秒。

「为了形象一点说明这是个什么数字,20 块英伟达 H100 带宽就相当于全球的互联网通信,」黄仁勋说道。

黄仁勋列举了 Hopper 架构相对上代安培的五大革新:

首先是性能的飞跃式提升,这是通过全新张量处理格式 FP8 实现的。H100 的 FP8 算力是 4PetaFLOPS,FP16 则为 2PetaFLOPS,TF32 算力为 1PetaFLOPS,FP64 和 FP32 算力为 60TeraFLOPS。

虽然比苹果 M1 Ultra 的 1140 亿晶体管数量要小一些,但 H100 的功率可以高达 700W——上代 A100 还是 400W。「在 AI 任务上,H100 的 FP8 精度算力是 A100 上 FP16 的六倍。这是我们历代最大的性能提升,」黄仁勋说道。

Transformer 类预训练模型是当前 AI 领域里最热门的方向,英伟达甚至以此为目标专门优化 H100 的设计,提出了 Transformer Engine,它集合了新的 Tensor Core、FP8 和 FP16 精度计算,以及 Transformer 神经网络动态处理能力,可以将此类机器学习模型的训练时间从几周缩短到几天。

Transformer 引擎名副其实,是一种新型的、高度专业化的张量核心。简而言之,新单元的目标是使用可能的最低精度来训练 Transformer 而不损失最终模型性能。

针对服务器实际应用,H100 也可以虚拟化为 7 个用户共同使用,每个用户获得的算力相当于两块全功率的 T4 GPU。而且对于商业用户来说更好的是,H100 实现了业界首个基于 GPU 的机密计算。

Hopper 还引入了 DPX 指令集,旨在加速动态编程算法。动态编程可将复杂问题分解为子问题递归解决,Hopper DPX 指令集把这种任务的处理时间缩短了 40 倍。

Hopper 架构的芯片和 HBM 3 内存用台积电 CoWoS 2.5D 工艺封装在板卡上,形成「超级芯片模组 SXM」,就是一块 H100 加速卡:

这块显卡拿着可得非常小心——它看起来整体异常紧凑,整个电路板上塞满各种元器件。另一方面,这样的结构也适用于液冷——H100 设计 700W 的 TDP 已经非常接近散热处理的上限了。

自建全球第一 AI 超算

「科技公司处理、分析数据,构建 AI 软件,已经成为智能的制造者。他们的数据中心就是 AI 的工厂,」黄仁勋说道。

基于 Hopper 架构的 H100,英伟达推出了机器学习工作站、超级计算机等一系列产品。8 块 H100 和 4 个 NVLink 结合组成一个巨型 GPU——DGX H100,它一共有 6400 亿晶体管,AI 算力 32 petaflops,HBM3 内存容量高达 640G。

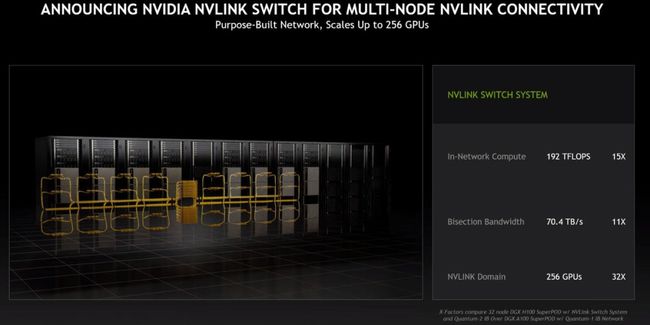

新的 NVLINK Swith System 又可以最多把 32 台 DGX H100 直接并联,形成一台 256 块 GPU 的 DGX POD。

「DGX POD 的带宽是每秒 768 terbyte,作为对比,目前整个互联网的带宽是每秒 100 terbyte,」黄仁勋说道。

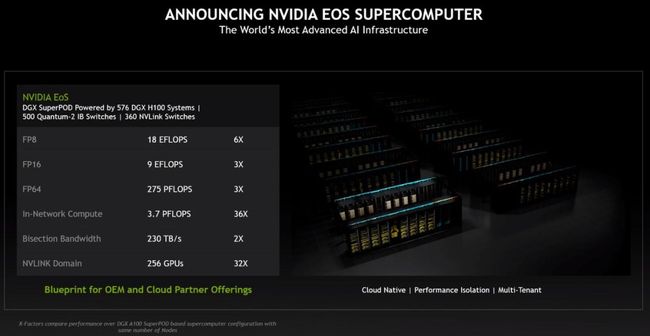

基于新 superPOD 的超级计算机也在路上,英伟达宣布基于 H100 芯片即将自建一个名叫 EoS 的超级计算机,其由 18 个 DGX POD 组成,一共 4608 个 H100 GPU。以传统超算的标准看,EoS 的算力是 275petaFLOPS,是当前美国最大超算 Summit 的 1.4 倍,Summit 目前是基于 A100 的。

从 AI 计算的角度来看,EoS 输出 18.4 Exaflops,是当今全球第一超算富岳的四倍。

总而言之,EoS 将会是世界上最快的 AI 超级计算机,英伟达表示它将会在几个月之后上线。

GNN for Science: 腾讯AI Lab、清华共同发文综述等变图神经网络

一文了解等变图神经网络的结构和相关任务。

近年来,越来越多的人工智能方法在解决传统自然科学等问题上大放异彩, 在一些重要的学科问题(例如蛋白质结构预测)上取得了令人瞩目的进展。在物理领域的研究中,非常多的物理问题都会涉及建模物体的的一些几何特征,例如空间位置,速度,加速度等。这种特征往往可以使用几何图这一形式来表示。不同于一般的图数据,几何图一个非常重要的特征是额外包含旋转,平移,翻转对称性。这些对称性往往反应了某些物理问题的本质。因此,最近以来,大量工作利用了几何图中的对称性,基于经典图神网络设计了很多具有等变性质的模型去解决对几何图建模问题。尽管在这一领域,等变图神经网络模型取得了长足的发展,但是还缺乏一个系统性的对这一领域的调研。为此,腾讯 AI Lab, 清华 AIR & 计算机系在综述:《Geometrically Equivariant Graph Neural Networks: A Survey》中,对等变图神经网络的结构和相关任务进行了一个系统梳理。

综述论文链接:https://arxiv.org/abs/2202.07230

在物理和化学领域,很多问题需要去处理带有几何特征的图。例如,化学小分子和蛋白质都可以建模成一个有原子和其化学键关系组成的几何图。在这个图中,除了包含原子的一些内在特征以外,我们还需要考虑到每个原子在空间的三维坐标这一几何特征。而在物理学的多体问题中,每个粒子的几何特征则包括坐标,速度,旋转等。不同于一般特征,这些几何特征往往都具备着一些对称性和等变性。正因为如此,基于对对称性的建模,大量基于图神经网络的改进模型在近年来被提出。这一类模型,因为克服了传统图神经网络无法很好处理这类具有等变对称性质的特征的缺点,被统称为等变图神经网络。

在这篇综述里面,我们系统性的梳理了近年等变图神经网络的发展脉络,并且提供了一个简洁的视角帮助读者能够很快的理解这类网络的内涵。基于消息传播和聚合函数的不同,我们将现有的等变图神经网络分为三类。与此同时,我们还详尽阐释了当前的挑战和未来的可能方向。

02 程序员专区

ICLR 2022 优质论文分享

1.cosFormer:重新思考注意力机制中的Softmax

论文题目:

cosFormer : Rethinking Softmaxin Attention

论文摘要:

我们(商汤多模态研究组)认为,近似操作本身存在的误差使得其效果很难超越Softmax Attention。我们的观点是,与其近似Softmax,不如设计一种方式代替Softmax,并且同时降低时间空间复杂度。因此,本文提出了名为cosFormer的方法,在时间空间复杂度关于序列长度为线性复杂度的同时,其性能接近或者超越Softmax Attention,并在LRA benchmark上取得SOTA结果。我们的设计核心理念基于两点,首先是注意力矩阵的非负性,其次是对局部注意力的放大(非极大值抑制)。

论文地址:

https://arxiv.org/abs/2202.08791

部分开源代码:

https://github.com/OpenNLPLab/cosFormer

2.提高子网络「中奖」准确率,美国东北大学、Meta等提出对偶彩票假说

论文题目:

DUAL LOTTERY TICKET HYPOTHESIS

论文摘要

来自美国东北大学、圣克拉拉大学和 Meta 的研究者提出对偶彩票假说(Dual Lottery Ticket Hypothesis,DLTH),随机的子网络都可以被转换成中奖彩票。

稀疏网络训练一直是深度学习中训练神经网络的难点。随着网络规模和数据量的不断增加,训练成本也不断提升。如何有效的训练稀疏网络来维持合理的训练开销变得十分重要。另一方面,找到有效的稀疏网络训练方法对理解神经网络的工作原理同样很有帮助。

近日,来自美国东北大学,圣克拉拉大学和 Meta 的研究者提出对偶彩票假说(Dual Lottery Ticket Hypothesis,DLTH)。不同于彩票假说(Lottery Ticket Hypothesis,LTH)验证了随机网络中存在好的子网络(中奖彩票),DLTH 验证了在给定的随机网络中,随机的子网络都可以被转换成中奖彩票。

论文地址:

https://arxiv.org/abs/2203.04248

OpenReview:

https://openreview.net/forum?id=fOsN52jn25l

论文代码:

https://github.com/yueb17/DLTH

更多前言论文/模型解析,尽在极链AI云

邀请新用户/新注册完成学生认证更可领取超大使用券

参与模型复现,奖励更丰厚哦~

极链AI云是极链科技集团下属专为AI科研与学习而设计的一站式开发平台。为开发者提供全流程的AI科研服务,让每一位用户都能拥有撬动AI变革的力量。