CVPR 2021 | 涨点神器!IC-Conv:使用高效空洞搜索的Inception卷积,全方位提升!

点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

本文转载自:AI人工智能初学者

Inception Convolution with Efficient Dilation Search

本文提出一种空洞卷积的新变体:Inception卷积,并提出一种基于统计优化的简单而高效(零成本)的空洞搜索算法(EDO,Effective Dilation Search),将其应用于检测、分割和姿态估计任务,性能大幅度提升!

作者单位:北航, 商汤, 牛津大学, 悉尼大学

1 简介

空洞卷积(Dilation convolution)是标准卷积神经网络的关键变体,可以控制有效的感受野并处理对象的大尺度方差,而无需引入额外的计算。但是,在文献中很少讨论将有效感受野适合于具有卷积的数据。为了充分挖掘其潜力,我们提出了一种新的空洞卷积变体,即inception (dilated)卷积,其中卷积在不同轴,通道和层之间具有独立的空洞。为了探索一种将复杂的初始卷积拟合到数据的实用方法,开发了一种基于统计优化的简单而高效的空洞搜索算法(EDO,effective dilation search)。该搜索方法以零成本方式运行,该方法极其快速地应用于大规模数据集。

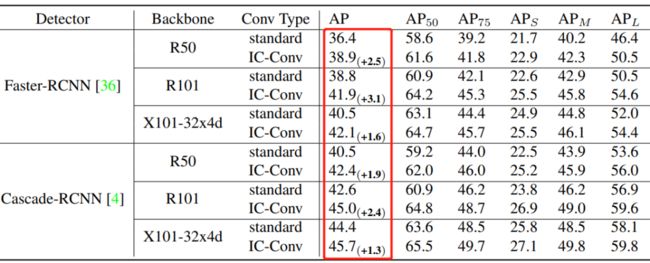

实证结果表明,本文方法在广泛的Baseline测试中获得了一致的性能提升。例如,通过简单地将ResNet-50主干中的3x3标准卷积替换为Inception Conv,将Faster-RCNN在MS-COCO上的mAP从36.4%提高到39.2%。此外,在ResNet-101骨干网中使用相同的替代方法,在自下而上的人体姿势估计上将AP得分从COCO val2017的AP得分从60.2%大幅提高到68.5%。

2 前人铺路

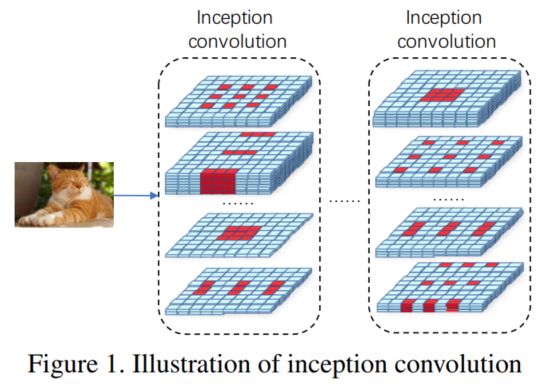

感受野是卷积神经网络的一个重要概念,也得到了广泛的研究。有学者证明了感受野的激活强度分布大致为高斯分布,只有感受野中心部分周围的少数像素有效地有助于输出神经元的响应。此外,有效感受野(ERF)已经在不同的任务中得到了测试和使用。

在不同的任务中,由于输入图像的大小差异和感兴趣对象的尺度范围不同,对ERF的要求也不同。例如,在图像分类中,输入的尺寸往往比较小(例如:而在目标检测中,输入的尺寸要大得多,目标尺度范围也很大。即使对于固定网络的同一任务,某一卷积层的最优ERF也可能与标准卷积运算不同。由于ERF的要求不断变化,需要针对不同的任务提出一种通用的、实用的ERF优化算法。

膨胀卷积核的膨胀系数是一个非常有效的超参数,可以调节不同任务之间的ERFs分布。LG等人的工作提出在一个CNN的不同阶段分配不同的膨胀值,并取得了一致的改进。NATS更进一步,将卷积分成不同的组,每个组都有独立的扩张值。但是在相对粗糙的搜索空间中使用骨架网络架构的搜索方法,忽略了扩张卷积的细粒度内部结构。因此,在本研究中重点探讨了在膨胀域的搜索问题,以有效地调整ERFs。

3 本文方法动机

3.1 Inception卷积

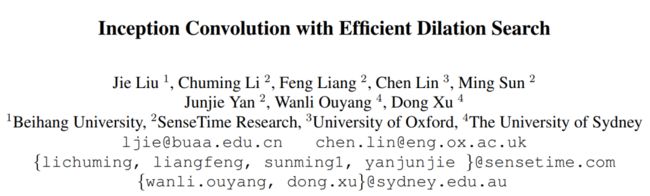

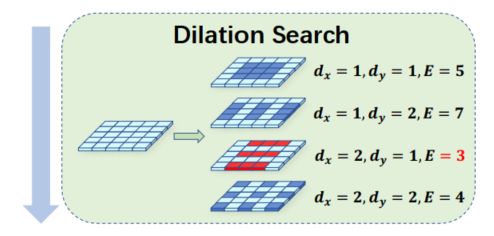

首先,希望有一个更灵活的搜索空间,可以使得模型能够具备将ERFs拟合到不同数据集的能力。于是本文提出一种新的膨胀卷积突变体,即Inception卷积,它包含尽可能多的膨胀模式,如图1所示。

在Inception卷积空间中,每个轴、每个通道和每个卷积层的膨胀都是独立定义的。Inception卷积提供了一个密集的ERF范围。

3.2 搜索空间优化

对于搜索空间的优化,本文主要参考了神经结构搜索(NAS)中的工作,它能够自动优化神经网络操作符组合。DARTS和single path one-shot(SPOS)是NAS方法的两大主要家族。

DART训练一个超网络,其中离散操作选择被放松为所有候选操作输出的连续加权和。训练后,在每个块中选择体系结构权重最大的操作。

SPOS在超网络的每个训练步骤中随机选择一个操作序列(子网),不同序列中的相同操作具有相同的权值。训练后,SPOS通过对多个继承sharedweights的序列进行采样和评估,选择最佳的操作序列。

然而,DART和SPOS都不适合本文方法的搜索空间。在DART中,Block中的所有操作在训练期间应用到输入,以使体系结构权值意识到每个操作的重要性,但卷积层(block)的膨胀模式的数量很大,即16个,如果两个轴各有4个选择。这意味着DART需要16次连续计算,因此具有较低的GPU效用和较大的计算成本。

SPOS在训练过程中对操作序列进行采样。然而,在本文方法的搜索空间中,即使在单个卷积层中,膨胀模式的数量也是巨大的 ,其中 是通道数, 是最大膨胀。大量的膨胀模式给为SPOS设计好的的抽样策略带来了极大的困难。

本文提出了一种简单而高效的膨胀优化算法(EDO)。在EDO中,超网络的每一层都是一个标准的卷积操作,其内核覆盖了所有可能的膨胀模式。在对超网络进行预训练后,通过求解一个统计优化问题,为每个卷积层中的每个通道选择膨胀模式。对于每一层,通过原始卷积层的输出期望与裁剪出来的与所选膨胀模式的膨胀卷积的L1误差最小,使用预先训练好的权值来解决选择问题。

EDO以一种非常简单的方式支持完全扩张域搜索空间进行高效的通道扩张优化。与基于搜索的方法相比,EDO的搜索代价几乎为零。与差分方法相比EDO将不同模式的顺序计算转换为并行方式,计算成本更低,GPU利用率更高。此外,与SPOS相比,EDO不需要设计复杂的机制来保证抽样的公平性和子网的准确排序。

4. 方法原理

4.1 问题数学描述

为了充分探索ERF拟合中膨胀的灵活性,本文考虑一个完整的膨胀域,即Inception卷积。Inception卷积对每个通道中的两个轴有独立的膨胀,其形式上表示为:

其中 和 是滤波器在第 个输出通道的 轴和 轴上从1到 的膨胀, 为输出通道数。单个Inception卷积的候选结构号是 。

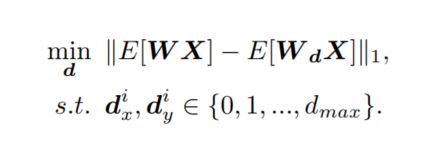

本文的目标是开发出一种新的算法,通过选择集合 来有效地拟合不同任务之间的ERF。

4.2 问题的解决之道

DART和SPOS是NAS方法的两大主流家族。然而,由于Inception卷积包含 种膨胀模式和 个候选项,因此DART和SPOS都不能像前面所讨论的那样应用在本方法的领域中进行有效的搜索。

有实验证明DART在两个单独的数据集上交替训练体系结构权重和操作权重,并使用体系结构权重来表示相应操作的重要性。尽管得到的体系结构权重可能在操作之间均匀分布,但以这种方式获得的操作仍然包含一个良好的网络。预先训练的超网络中的权值具有指导操作选择的信息。在这项工作中作者遵循这一思想,并制定一个统计优化问题。

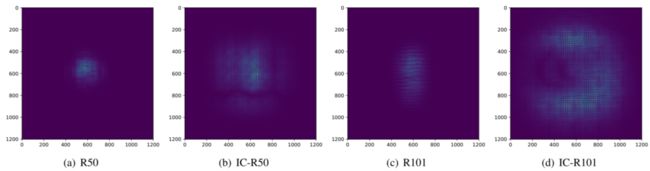

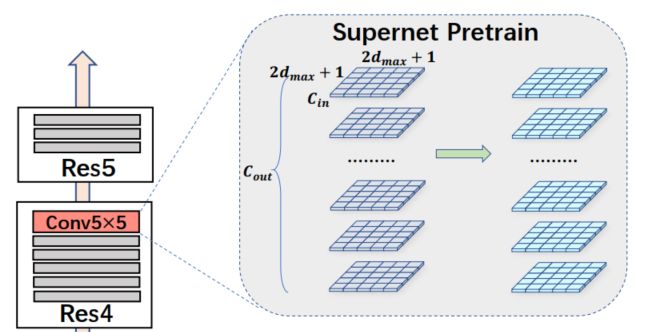

1 超网络

给定一个网络体系结构和它需要适应的任务,用设计超网络保留它的体系结构,同时改变内核大小以覆盖所有候选膨胀模式。形式上,对于核大小为 的卷积层,在超网络中将其替换为 ,这是所有候选膨胀模式的最大宽度和高度。超网络在给定的任务上进行了预训练。

2 统计优化

对于每一个权值为的卷积层,将定义为在超网络中展开的第 个卷积核的权值,表示从 裁剪出来的膨胀式卷积核,其位置由 和 确定。这里将膨胀选择表述为一个优化问题,在此问题中,预训练的膨胀权值 的输出期望与裁剪的膨胀权值 之间的 误差最小,正式表达为:

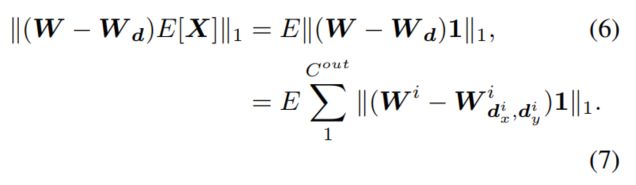

上式, 是Batch为 、高为 、宽为 卷积层的输入,由于 和 与 无关,优化目标进一步表示为:

要准确地解决上述问题,需要进行进一步的计算,在整个训练数据集上平均 。假设 经过了BN操作,并且每个通道的 都有相同的 和 值来参与计算和训练。结合 和 之间的移位不变性以及 之间的置换不变性,可以得出 在所有位置之间的分布相同,目标也可以更加简化:

其中 为 中所有位置的期望, 为与 shape相同的全1矩阵。通过以上推导,可以通过独立遍历所有的膨胀模式 。

4.3 方法讨论

1、与DART的关系

在DART算法种 操作是串行计算的,总cost为。然而,在EDO算法中 操作是并行计算的,总cost为。对于大多数CNN来说 通常为1,于是仅为在 设置为 时的56%。

因此,EDO比DART的计算效率更高。此外,在某些情况下,由于结构参数 的 矩阵主特征值较大,使得DART退化为随机抽样。然而EDO在预训练的网络权值上直接定义了统计优化问题,而不是引入不鲁棒的结构参数 。

2、与NATS和CRNAS的关系

CRNAS在每个阶段独立搜索扩张,因此是基于SPOS的。

NATS将卷积分成若干组,并在几个扩张模式(通常为5个模式)中为每组用DART搜索。

Inception卷积是通道式的,包含所有在最大膨胀 下的膨胀模式(至少16种)。提议的方法的流程如图所示:

5 实验

5.1 图像识别

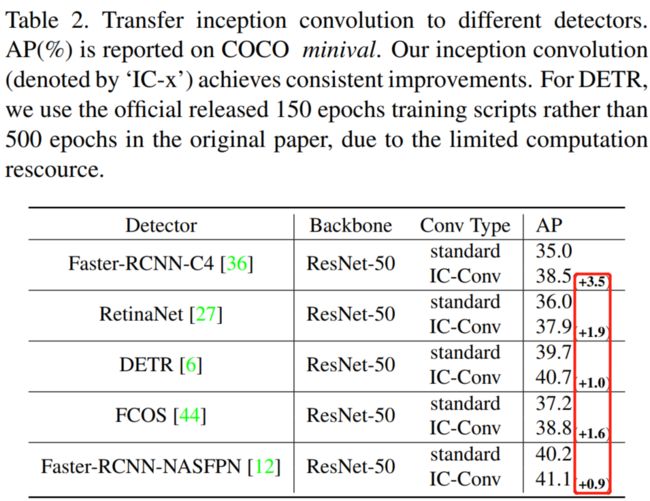

5.2 目标检测

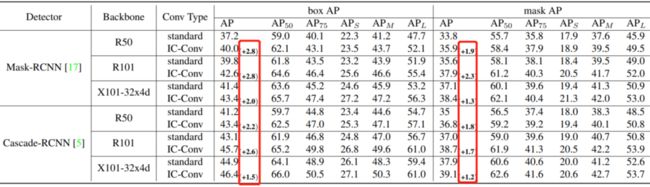

5.3 实例分割

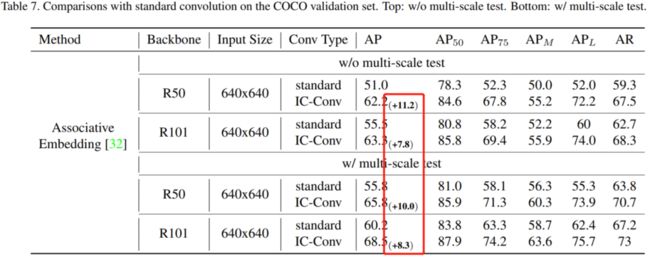

5.4 人体姿态估计

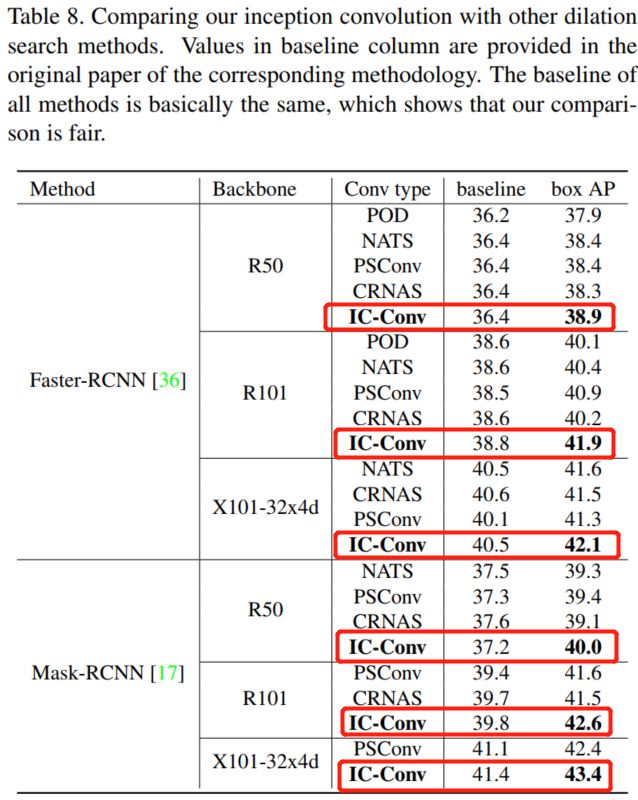

5.5 与其他dilation search对比

只想说一句话总结,太厉害了,全领域提升!!!!

参考

[1].Inception Convolution with Efficient Dilation Search

IC-Conv论文下载

后台回复:0304,即可下载上述论文PDF

后台回复:CVPR2021,即可下载CVPR 2021论文和开源代码合集

点击下方卡片并关注,了解CV最新动态![]()

重磅!CVer-论文写作与投稿交流群成立

扫码添加CVer助手,可申请加入CVer-论文写作与投稿 微信交流群,目前已满2400+人,旨在交流顶会(CVPR/ICCV/ECCV/NIPS/ICML/ICLR/AAAI等)、顶刊(IJCV/TPAMI/TIP等)、SCI、EI、中文核心等写作与投稿事宜。

同时也可申请加入CVer大群和细分方向技术群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如论文写作+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

![]()

▲长按加小助手微信,进交流群

▲点击上方卡片,关注CVer公众号

整理不易,请给CVer点赞和在看!![]()