SVD分解

一、SVD简介

奇异值分解(SVD)是在机器学习领域广泛运用的算法,他不光可以用在降维算法中的特征值分解,还可以用于推荐系统,以及自然语言处理等领域,是很多算法的基石。

二、特征值和特征向量

我们首先回顾下特征值和特征向量的定义如下:

Ax=λx

其中A是一个n X n的矩阵,x是一个n维向量,则我们说入是矩阵A的一个特征值,而x是矩阵A的特征值入所对应的特征向量。

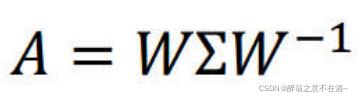

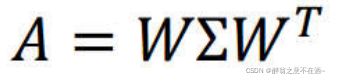

求出特征值和特征向量有什么好处呢?就是我们可以将矩阵A特征分解。如果我们求出了矩阵A的n个特征值λ1≤λ2 <...≤λn,以及这n个特征值所对应的特征向量{w1, w2,... wn},那么矩阵A就可以用下式的特征分解表示:

其中W是这n个特征向量所张成的n X n维矩阵,而Σ为这n个特征值为主对角线的n X n维矩阵。

一般我们会把W的这n 个特征向量标准化,即满足||wi||2 = 1,或者说wi.Twi = 1,此时W的n个特征向量为标准正交基,满足W.TW = 1,即W.T = w-1,也就是说W为酉矩阵。

这样我们的特征分解表达式可以写成:

特征值分解只可以在方阵中进行处理,不能应用的非方阵中,如果我们要对非方阵进行特征分解,这是我们就要用到SVD。

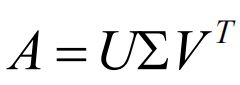

三、SVD的定义

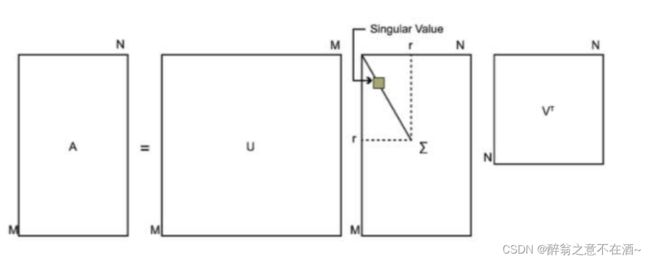

SVD也是对矩阵进行分解,但是和特征分解不同,SVD并不要求矩阵为方阵。假设我们的矩阵A是一个m×n的矩阵,那么我们定义矩阵A的SVD为:

其中U是一个m x m的矩阵,Σ是一个m x n的矩阵,除了主对角线上的元素以外全为0 ,主对角线上的每个元素都称为奇异值,V是一 个n x n的矩阵。U和V都是酉矩阵,即满U.TU= I,V.TV= I。下图可以很形象的看出上面SVD的定义:

四、求解SVD矩阵

那么我们如何求出SVD分解后的U, Σ,V这三个矩阵呢?

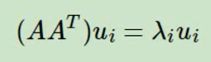

如果我们将A的转置和A做矩阵乘法,那么会得到n X n的一个方阵AT A。既然AT A是方阵,那么我们就可以进行特征分解,得到的特征值和特征向量满足下式:

这样我们就可以得到矩阵AT A的n个特征值和对应的n个特征向量v了。将AT A的所有特征向量张成一个n X n的矩阵V ,就是我们SVD公式里面的V矩阵了。一般我们将V中的每 个特征向量叫做A的右奇异向量。

如果我们将A和A的转置做矩阵乘法,那么会得到m x m的一一个方阵AAT。 既然AAT是方阵,那么我们就可以进行特征分解,得到的特征值和特征向量满足下式:

这样我们就可以得到矩阵AAT的m个特征值和对应的m个特征向量u了。将AAT的所有特征向量张成一个m x m的矩阵U ,就是我们SVD公式里面的U矩阵了。-般我们将U中的每个特征向量叫做A的左奇异向量。

U和V我们都求出来了, 现在就剩下奇异值矩阵习没有求出了。由于乙除了对角线上是奇异值其他位置都是0 ,那我们只需要求出每个奇异值σ就可以了。

这样我们可以求出每个奇异值,进而求出奇异矩阵。

在上述中为什么A*A.T为U矩阵,而A.T*A为V矩阵?

原因如下:

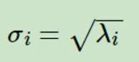

进一步我们还可以看出我们的特征值矩阵等于奇异值矩阵的平方,也就是说特征值和奇异值满足如下关系:

这样也就是说,我们可以不用σi = Avi/u;来计算奇异值,也可以通过求出AT A的特征值取平方根来求奇异值。(奇异矩阵是从大到小排序)

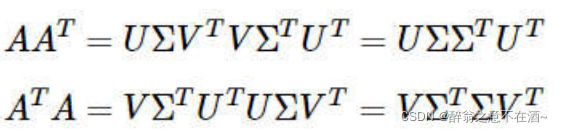

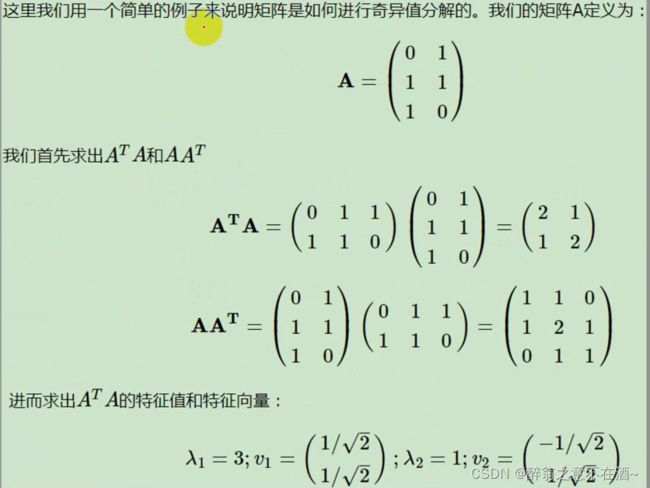

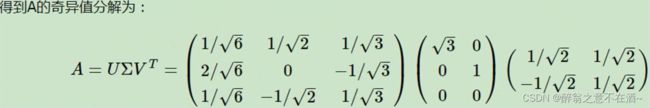

五、求解实例

六、SVD性质

对于奇异值,它跟我们特征分解中的特征值类似,在奇异值矩阵中也是按照从大到小排列,而且奇异值的减少特别的快,在很多情况下,前10%甚至1 %的奇异值的和就占了全部的奇异值之和的99%以上的比例。也就是说,我们也可以用最大的k个的奇异值和对应的左右奇异向量来近似描述矩阵。

由于这个重要的性质,SVD可以用于PCA降维,来做数据压缩和去噪。也可以用于推荐算法,将用户和喜好对应的矩阵做特征分解,进而得到隐含的用户需求来做推荐。同时也可以用于NLP中的算法,比如潜在语义索引(LSI) 。

七、SVD用于PCA降维

实际上SVD在PCA降维上只是使用了U矩阵(左奇异矩阵),其原因就是U矩阵(左奇异矩阵)是进行列压缩,而V矩阵(右奇异矩阵)是对行进行压缩,而PCA降维只需要减少特征从而进行降维,所以PCA只用到了SVD的U矩阵(左奇异矩阵)。具体解释可参照上文推导过程(左奇异矩阵的由来)。

八、SVD总结

SVD作为一个很基本的算法,在很多机器学习算法中都有它的身影,特别是在现在的大数据时代,由于SVD可以实现并行化,因此更是大展身手。SVD的原理不难,只 要有基本的线性代数知识就可以理解,实现也很简单因此值得仔细的研究。当然,SVD的缺点是分解出的矩阵解释性往往不强,有点黑盒子的味道,不过这不影响它的使用。