Linux内核详解与内核优化方案

一、Linux历史

1、Unix

UNIX 与 Linux 之间的关系是一个很有意思的话题。在目前主流的服务器端操作系统中,UNIX 诞生于 20 世纪 60 年代末,Windows 诞生于 20 世纪 80 年代中期,Linux 诞生于 20 世纪 90 年代初,可以说 UNIX 是操作系统中的"老大哥",后来的 Windows 和 Linux 都参考了 UNIX。

UNIX 操作系统由肯•汤普森(Ken Thompson)和丹尼斯•里奇(Dennis Ritchie)发明。它的部分技术来源可追溯到从 1965 年开始的 Multics 工程计划,该计划由贝尔实验室、美国麻省理工学院和通用电气公司联合发起,目标是开发一种交互式的、具有多道程序处理能力的分时操作系统,以取代当时广泛使用的批处理操作系统。

说明:分时操作系统使一台计算机可以同时为多个用户服务,连接计算机的终端用户交互式发出命令,操作系统采用时间片轮转的方式处理用户的服务请求并在终端上显示结果(操作系统将CPU的时间划分成若干个片段,称为时间片)。操作系统以时间片为单位,轮流为每个终端用户服务,每次服务一个时间片。

可惜,由于 Multics 工程计划所追求的目标太庞大、太复杂,以至于它的开发人员都不知道要做成什么样子,最终以失败收场。

以肯•汤普森为首的贝尔实验室研究人员吸取了 Multics 工程计划失败的经验教训,于 1969 年实现了一种分时操作系统的雏形,1970 年该系统正式取名为 UNIX。

有意思的是,肯•汤普森当年开发 UNIX 的初衷是运行他编写的一款计算机游戏 Space Travel,这款游戏模拟太阳系天体运动,由玩家驾驶飞船,观赏景色并尝试在各种行星和月亮上登陆。他先后在多个系统上试验,但运行效果不甚理想,于是决定自己开发操作系统,就这样,UNIX 诞生了。

自 1970 年后,UNIX 系统在贝尔实验室内部的程序员之间逐渐流行起来。1971-1972 年,肯•汤普森的同事丹尼斯•里奇发明了传说中的C语言,这是一种适合编写系统软件的高级语言,它的诞生是 UNIX 系统发展过程中的一个重要里程碑,它宣告了在操作系统的开发中,汇编语言不再是主宰。

到了 1973 年,UNIX 系统的绝大部分源代码都用C语言进行了重写,这为提高 UNIX 系统的可移植性打下了基础(之前操作系统多采用汇编语言,对硬件依赖性强),也为提高系统软件的开发效率创造了条件。可以说,UNIX 系统与C语言是一对孪生兄弟,具有密不可分的关系。

20 世纪 70 年代初,计算机界还有一项伟大的发明——TCP/IP 协议,这是当年美国国防部接手 ARPAnet 后所开发的网络协议。美国国防部把 TCP/IP 协议与 UNIX 系统、C语言捆绑在一起,由 AT&T 发行给美国各个大学非商业的许可证,这为 UNIX 系统、C语言、TCP/IP 协议的发展拉开了序幕,它们分别在操作系统、编程语言、网络协议这三个领域影响至今。肯•汤普森和丹尼斯•里奇因在计算机领域做出的杰出贡献,于 1983 年获得了计算机科学的最高奖——图灵奖。

随后出现了各种版本的 UNIX 系统,目前常见的有 Sun Solaris、FreeBSD、IBM AIX、HP-UX 等。

2、Solaris 和 FreeBSD

Solaris是UNIX系统的一个重要分支。Solaris 除可以运行在 SPARC CPU 平台上外,还可以运行在 x86 CPU 平台上。在服务器市场上,Sun 的硬件平台具有高可用性和高可靠性,是市场上处于支配地位的 UNIX 系统。Solaris x86 用于实际生产应用的服务器,在遵守 Sun 的有关许可条款的情况下,Solaris x86 可以免费用于学习研究或商业应用。

FreeBSD源于美国加利福尼亚大学伯克利分校开发的 UNIX 版本,它由来自世界各地的志愿者开发和维护,为不同架构的计算机系统提供了不同程度的支持。FreeBSD 在 BSD 许可协议下发布,允许任何人在保留版权和许可协议信息的前提下随意使用和发行,并不限制将 FreeBSD 的代码在另一协议下发行,因此商业公司可以自由地将 FreeBSD 代码融入它们的产品中。苹果公司的 OS X 就是基于 FreeBSD 的操作系统。

FreeBSD 与 Linux 的用户群有相当一部分是重合的,二者支持的硬件环境也比较一致,所采用的软件也比较类似。FreeBSD 的最大特点就是稳定和高效,是作为服务器操作系统的不错选择;但其对硬件的支持没有 Linux 完备,所以并不适合作为桌面系统。

3、Linux的诞生

Linux 内核最初是由李纳斯•托瓦兹(Linus Torvalds)在赫尔辛基大学读书时出于个人爱好而编写的,当时他觉得教学用的迷你版 UNIX 操作系统 Minix 太难用了,于是决定自己开发一个操作系统。第 1 版本于 1991 年 9 月发布,当时仅有 10 000 行代码。

李纳斯•托瓦兹没有保留 Linux 源代码的版权,公开了代码,并邀请他人一起完善 Linux。与 Windows 及其他有专利权的操作系统不同,Linux 开放源代码,任何人都可以免费使用它。

据估计,现在只有 2% 的 Linux 核心代码是由李纳斯•托瓦兹自己编写的,虽然他仍然拥有 Linux 内核(操作系统的核心部分),并且保留了选择新代码和需要合并的新方法的最终裁定权。现在大家所使用的 Linux,我更倾向于说是由李纳斯•托瓦兹和后来陆续加入的众多 Linux 好者共同开发完成的。

开源软件是不同于商业软件的一种模式,从字面上理解,就是开放源代码,大家不用担心里面会搞什么猫腻,这会带来软件的革新和安全。

Linux 受至旷大计算机爱好者的喜爱,主要原因也有两个:

- 它属于开源软件,用户不用支付可费用就可以获得它和它的源代码,并且可以根据自己的需要对它进行必要的修改,无偿使用,无约束地继续传播;

- 它具有 UNIX 的全部功能,任何使用 UNIX 操作系统或想要学习 UNIX 操作系统的人都可以从 Linux 中获益。

另外,开源其实并不等同于免费,而是一种新的软件盈利模式。目前很多软件都是开源软件,对计算机行业与互联网影响深远。

二、Linux kernel 简介

1、计算机系统组成

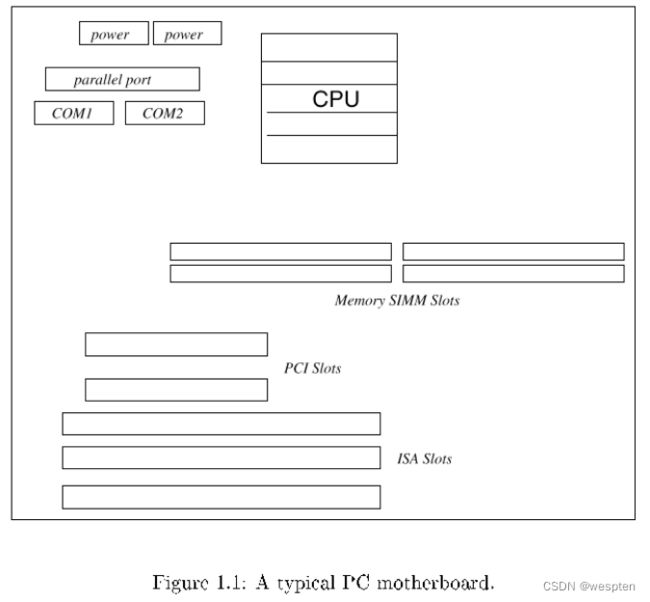

一个计算机系统是一个硬件和软件的共生体,它们互相依赖,不可分割。

计算机的硬件,含有外围设备、处理器、内存、硬盘和其他的电子设备组成计算机的发动机,但是没有软件来操作和控制它,自身是不能工作的。

完成这个控制工作的软件就称为操作系统。操作系统是管理计算机硬件与软件资源的系统软件,同时也是计算机系统的内核与基石。操作系统需要处理如管理与配置内存、决定系统资源供需的优先次序、控制输入与输出设备、操作网络与管理文件系统等基本事务。操作系统也提供一个让用户与系统交互的操作界面。

操作系统的的组成:

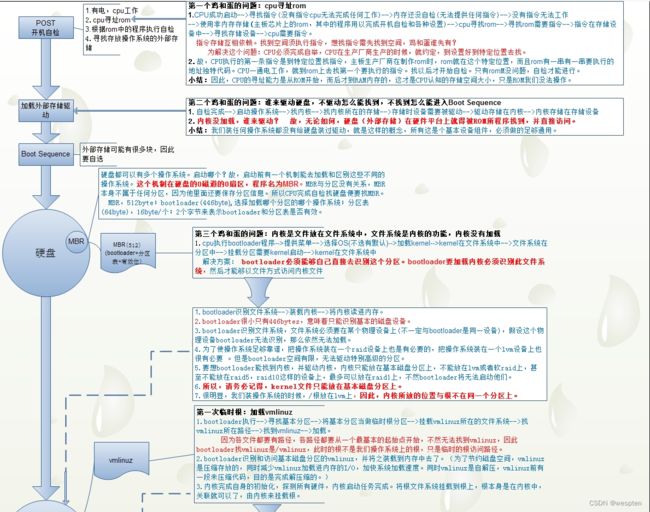

· Bootloader:它主要负责设备的启动过程。

· Shell:Shell是一种编程语言,它可以控制其他文件,进程以及所有其他程序。

· Kernel:它是操作系统的主要组件,管理内存,CPU和其他相关组件。

· Desktop Environment:这是用户通常与之交互的环境。

· Graphical server(图形服务器):它是操作系统的子系统,用于在屏幕上显示图形

· Applications:这些是执行不同用户任务(例如word,excel等)的程序集。

· Daemons :后台服务提供商。

2、何为内核(Kernel)

内核是操作系统的关键组成部分,因为它控制系统中的所有程序。它借助进程间通信和系统调用,在硬件级别上充当应用程序和数据处理之间的桥梁。

当设备启动时,会将操作系统加载到内存,这时内核会经历一个初始化的过程,它负责内存分配部分,并将其保留在那里,直到操作系统关闭。并创建了一个运行应用程序的环境,在该环境中内核负责处理低级任务,例如任务管理,内存管理,风险管理等。

内核相当于服务提供者,因此程序可以请求内核完成多项任务,例如请求使用磁盘,网卡或其他硬件,并且内核为CPU设置中断以启用多任务处理。它不让错误的程序进入其他程序的操作功能,从而保护了计算环境。它通过不允许存储空间来阻止未经授权的程序进入入口,并限制它们消耗的

CPU时间。

简而言之:

1. 从技术层面讲,内核是硬件与软件之间的一个中间层。作用是将应用层序的请求传递给硬件,并充当底层驱动程序,对系统中的各种设备和组件进行寻址。

2. 从应用程序的层面讲,应用程序与硬件没有联系,只与内核有联系,内核是应用程序知道的层次中的最底层。在实际工作中内核抽象了相关细节。

3. 内核是一个资源管理程序。负责将可用的共享资源(CPU时间、磁盘空间、网络连接等)分配得到各个系统进程。

4. 内核就像一个库,提供了一组面向系统的命令。系统调用对于应用程序来说,就像调用普通函数一样。

3、内核的分类

内核通常有三类:

1. Monolithic kernel:它包含许多设备驱动程序,可在设备的硬件和软件之间创建通信接口。

它是操作系统广泛使用的内核。在单片架构中,内核由可以动态加载和卸载的各种模块组成。这种体系结构将扩展OS的功能,并允许轻松扩展内核。

使用单片式体系结构,内核的维护变得容易,因为当需要修复特定模块中的错误时,它允许相关模块进行加载和卸载。因此,它消除了繁琐的工作,即降低并重新编译整个内核以进行很小的更改。在单片内核中,卸载不再使用的模块更加容易。

2. Micro kernel:它只能执行基本功能。

微内核已经发展成为单片内核的替代产品,以解决单片内核无法做到的内核代码不断增长的问题。这种体系结构允许某些基本服务(例如协议栈,设备驱动程序管理,文件系统等)在用户空间中运行。这样可以以最少的代码增强OS的功能,提高安全性并确保稳定性。

它通过使系统的其余部分正常运行而不会造成任何中断,从而限制了对受影响区域的损坏。在微内核体系结构中,所有基本OS服务都可以通过进程间通信(IPC)提供给程序。微内核允许设备驱动程序和硬件之间的直接交互。

3. Hybrid kernel:它结合了单片内核和微内核的各个方面。

混合内核可以决定要在用户模式和主管模式下运行什么。通常,在混合内核环境中,设备驱动程序,文件系统I / O之类的内容将在用户模式下运行,而服务器调用和IPC则保持在管理者模式下。

4、内核设计流派

1. 微内核。最基本的功能由中央内核(微内核)实现。Windows NT采用的就是微内核体系结构。对于微内核体系结构特点,操作系统的核心部分是一个很小的内核,实现一些最基本的服务,如创建和删除进程、内存管理、中断管理等等。而文件系统、网络协议等其它部分都在微内核外的用户空间里运行。这些功能都委托给一些独立进程,这些进程通过明确定义的通信接口与中心内核通信。

2. 宏(单)内核。内核的所有代码,包括子系统(如内存管理、文件管理、设备驱动程序)都打包到一个文件中。所有功能都做在一起,都在内核中,也就是说,整个内核是一个单独的非常大的程序。内核中的每一个函数都可以访问到内核中所有其他部分。目前支持模块的动态装卸(裁剪),Linux内核就是基于这个策略实现的。

使用微内核的操作系统具有很好的可扩展性而且内核非常的小,但这样的操作系统由于不同层次之间的消息传递要花费一定的代价所以效率比较低。对单一体系结构的操作系统来说,所有的模块都集成在一起,系统的速度和性能都很好,但是可扩展性和维护性就相对比较差。

按道理来说,Linux微内核结构实现的,但恰恰不是,Linux是单内核(monolithic)结构。这意味着虽然Linux被划分成控制系统各种组件(例如内存管理和进程管理)的多个子系统,但所有的子系统都紧密集成在一起,从而构成整个内核。

与之相反,微内核(microkernel)操作系统提供了最少量的功能集合,而所有其他的操作系统层次都在微内核之上以进程方式执行。由于各个层次之间存在着消息传递,微内核操作系统的效率通常较低,但这类操作系统非常便于扩展。

从根本上讲,将一个事情拆成各个小问题,然后每个小问题只负责一个任务是linux的设计哲学之一,Linux内核可通过模块方式进行扩展。

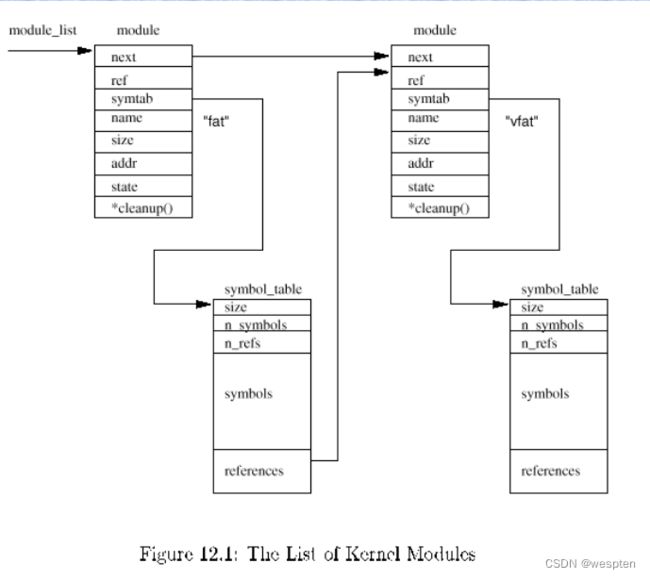

模块是在内核空间运行的程序,实际上是一种目标对象文件,没有链接,不能独立运行,但是其代码可以在运行时链接到系统中作为内核的一部分运行或从内核中取下,从而可以动态扩充内核的功能。

这种目标代码通常由一组函数和数据结构组成,用来实现一种文件系统,一个驱动程序,或其它内核上层的功能。模块机制的完整叫法应该是动态可加载内核模块(Loadable Kernel Module)或 LKM,一般就简称为模块。与前面讲到的运行在微内核体系操作系统的外部用户空间的进程不同,模块不是作为一个进程执行的,而像其他静态连接的内核函数一样,它在内核态代表当前进程执行。由于引入了模块机制,Linux的内核可以达到最小,即内核中实现一些基本功能,如从模块到内核的接口,内核管理所有模块的方式等等,而系统的可扩展性就留给模块来完成。

模块具有既提供了微内核的优点却又没有额外开销的内核特性。

5、内核职能

Linux 内核实现了很多重要的体系结构属性。在或高或低的层次上,内核被划分为多个子系统。

Linux 也可以看作是一个整体,因为它会将所有这些基本服务都集成到内核中。这与微内核的体系结构不同,后者会提供一些基本的服务,例如通信、I/O、内存和进程管理,更具体的服务都是插入到微内核层中的。

内核主要的任务有:

· 用于应用程序执行的流程管理。

· 内存和I / O(输入/输出)管理。

· 系统调用控制(内核的核心行为)。

· 借助设备驱动程序进行设备管理。

· 为应用程序提供运行环境。

6、内核所具备的核心功能

Linux内核主要负责的功能有:存储管理、CPU和进程管理、文件系统、设备管理和驱动、网络通信,以及系统的初始化(引导)、系统调用等。

主要功能有以下:

- 系统内存管理

- 软件程序管理

- 硬件设备管理

- 文件系统管理

1)系统内存管理

操作系统内核的主要功能之一就是内存管理。内核不仅管理服务器上的可用物理内存,还可以创建和管理虚拟内存(即实际并不存在的内存)。

内核通过硬盘上的存储空间来实现虚拟内存,这块区域称为交换空间(swap space)。内核不断地在交换空间和实际的物理内存之间反复交换虚拟内存中的内容。这使得系统以为它拥有比物理内存更多的可用内存。

内存存储单元按组划分成很多块,这些块称作页面(page)。内核将每个内存页面放在物理内存或交换空间。然后,内核会维护一个内存页面表,指明哪些页面位于物理内存内,哪些页面被换到了磁盘上。

2)软件程序管理

Linux操作系统将运行中的程序称为进程。进程可以在前台运行,将输出显示在屏幕上,也可以在后台运行,隐藏到幕后。内核控制着Linux系统如何管理运行在系统上的所有进程。

内核创建了第一个进程(称为init进程)来启动系统上所有其他进程。当内核启动时,它会

将init进程加载到虚拟内存中。内核在启动任何其他进程时,都会在虚拟内存中给新进程分配一块专有区域来存储该进程用到的数据和代码。

一些Linux发行版使用一个表来管理在系统开机时要自动启动的进程。在Linux系统上,这个表通常位于专门文件/etc/inittab中。

另外一些系统(比如现在流行的Ubuntu Linux发行版)则采用/etc/init.d目录,将开机时启动

或停止某个应用的脚本放在这个目录下。这些脚本通过/etc/rcX.d目录下的入口(entry)启动,这里的X代表运行级(run level)。

Linux操作系统的init系统采用了运行级。运行级决定了init进程运行/etc/inittab文件或/etc/rcX.d目录中定义好的某些特定类型的进程。 Linux操作系统有5个启动运行级。

- 运行级为1时,只启动基本的系统进程以及一个控制台终端进程。我们称之为单用户模式。单用户模式通常用来在系统有问题时进行紧急的文件系统维护。显然,在这种模式下,仅有一个人(通常是系统管理员)能登录到系统上操作数据。

- 标准的启动运行级是3。在这个运行级上,大多数应用软件,比如网络支持程序,都会启动。另一个Linux中常见的运行级是5。在这个运行级上系统会启动图形化的X Window系统,允许用户通过图形化桌面窗口登录系统。

可以使用ps命令查看当前运行在Linux系统上的进程。

3)硬件设备管理

内核的另一职责是管理硬件设备。任何Linux系统需要与之通信的设备,都需要在内核代码

中加入其驱动程序代码。驱动程序代码相当于应用程序和硬件设备的中间人,允许内核与设备之间交换数据。在Linux内核中有两种方法用于插入设备驱动代码:

- 编译进内核的设备驱动代码

- 可插入内核的设备驱动模块

以前,插入设备驱动代码的唯一途径是重新编译内核。每次给系统添加新设备,都要重新编译一遍内核代码。随着Linux内核支持的硬件设备越来越多,这个过程变得越来越低效。不过好在Linux开发人员设计出了一种更好的将驱动代码插入运行中的内核的方法。

开发人员提出了内核模块的概念。它允许将驱动代码插入到运行中的内核而无需重新编译内

核。同时,当设备不再使用时也可将内核模块从内核中移走。这种方式极大地简化和扩展了硬件设备Linux上的使用。

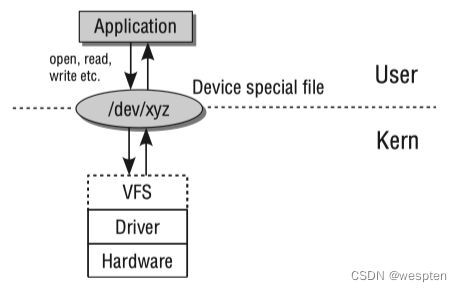

Linux系统将硬件设备当成特殊的文件,称为设备文件。设备文件有3种分类:

- 字符型设备文件:指处理数据时每次只能处理一个字符的设备 ,比如大多数类型的调制解调器和

终端 。 - 块设备文件: 指处理数据时每次能处理大块数据的设备,比如硬盘。

- 网络设备文件:指采用数据包发送和接收数据的设备,包括各种网卡和一个特殊的回环设备。

4)文件系统管理

不同于其他一些操作系统, Linux内核支持通过不同类型的文件系统从硬盘中读写数据。除

了自有的诸多文件系统外, Linux还支持从其他操作系统(比如Microsoft Windows)的文件

系统中读写数据。内核必须在编译时就加入对所有可能用到的文件系统的支持。下表列出了Linux系统用来读写数据的标准文件系统。

Linux服务器所访问的所有硬盘都必须格式化成上表所列文件系统类型中的一种。

随着时间的流逝,Linux 内核在内存和 CPU 使用方面具有较高的效率,并且非常稳定。但是对于 Linux 来说,最为有趣的是在这种大小和复杂性的前提下,依然具有良好的可移植性。Linux 编译后可在大量处理器和具有不同体系结构约束和需求的平台上运行。一个例子是 Linux 可以在一个具有内存管理单元(MMU)的处理器上运行,也可以在那些不提供MMU的处理器上运行。Linux 内核的uClinux移植提供了对非 MMU 的支持。

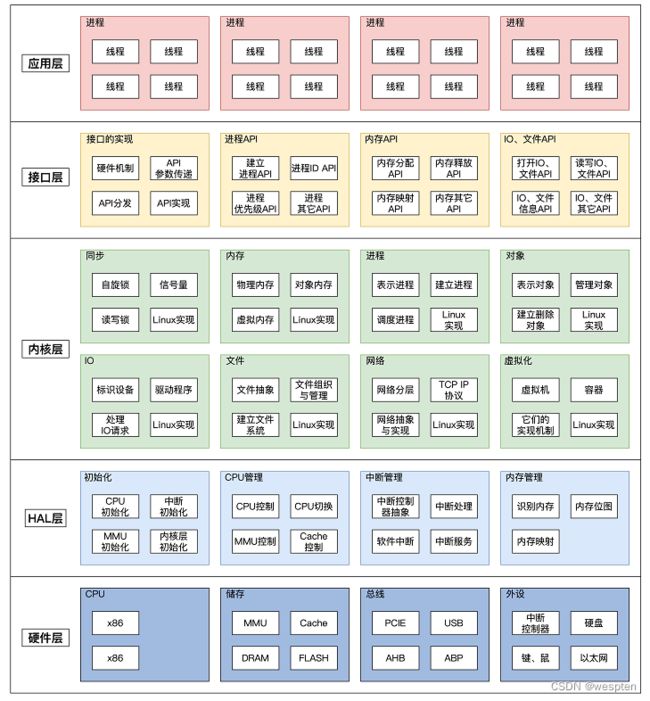

三、Linux内核整体架构

1、Linux内核体系结构

UNIX/Linux 系统可以粗糙地抽象为 3 个层次,底层是系统内核(Kernel);中间层是Shell层,即命令解释层;高层则是应用层。

(1)内核层

内核层是 UNIX/Linux 系统的核心和基础,它直接附着在硬件平台之上,控制和管理系统内各种资源(硬件资源和软件资源),有效地组织进程的运行,从而扩展硬件的功能,提高资源的利用效率,为用户提供方便、高效、安全、可靠的应用环境。

(2)Shell层

Shell 层是与用户直接交互的界面。用户可以在提示符下输入命令行,由 Shell 解释执行并输出相应结果或者有关信息,所以我们也把 Shell 称作命令解释器,利用系统提供的丰富命令可以快捷而简便地完成许多工作。

(3)应用层

应用层提供基于 X Window 协议的图形环境。X Window 协议定义了一个系统所必须具备的功能。

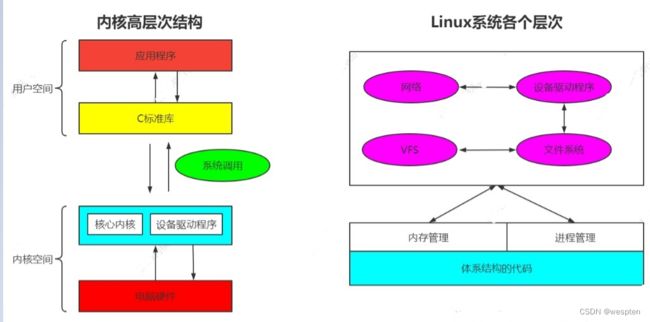

Linux内核只是Linux操作系统一部分。对下,它管理系统的所有硬件设备;对上,它通过系统调用,向Library Routine(例如C库)或者其它应用程序提供接口。

1)内核空间:

内核空间包括系统调用,内核,以及与平台架构相关的代码。内核处于提升的系统状态,其中包括受保护的内存空间以及对设备硬件的完全访问权限。此系统状态和内存空间统称为内核空间。在内核空间内,对硬件和系统服务的核心访问进行管理,并作为服务提供给系统的其余部分。

2)用户空间:

用户空间中又包含了,用户的应用程序,C库。用户空间或用户域是在操作系统内核环境之外运行的代码,用户空间定义为操作系统用来与内核连接的各种应用程序或程序或库。

用户的应用程序是在用户空间中执行的,它们可以通过内核系统调用访问计算机可用资源的一部分。通过使用内核提供的核心服务,可以创建用户级别的应用程序,例如游戏或办公软件。

内核为在用户模式中运行的应用程序提供了一组与系统进行交互的接口。这些接口也称为系统调用,应用程序可以通过接口访问硬件和其他内核资源。系统调用不仅为应用程序提供了抽象化的硬件层次,还确保了系统的安全和稳定性。

大多数应用程序并不直接使用系统调用。相反,在编程时采用了应用程序接口(API)。需要注意的是,在API和系统调用之间不存在关联。API是作为库文件的组成部分提供给应用程序使用的,这些API一般通过一个或多个系统调用来实现。

2、Linux内核架构

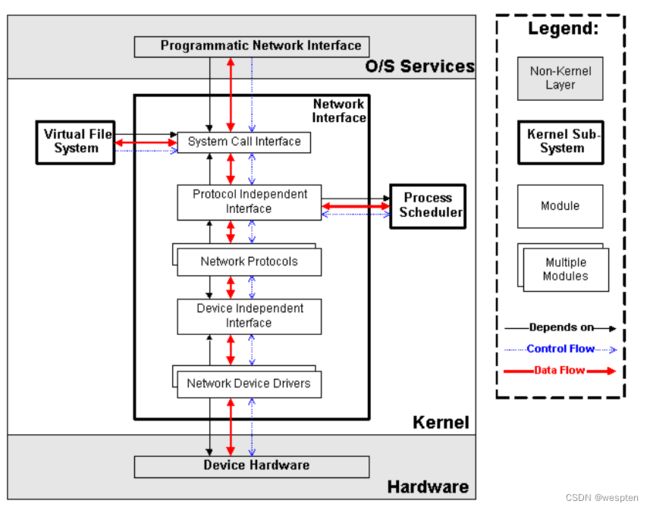

为了管理以上的各种资源与设备,Linux内核提出了如下的架构:

根据内核的核心功能,Linux内核提出了5个子系统:

1. Process Scheduler,也称作进程管理、进程调度。负责管理CPU资源,以便让各个进程可以以尽量公平的方式访问CPU。

2. Memory Manager,内存管理。负责管理Memory(内存)资源,以便让各个进程可以安全地共享机器的内存资源。另外,内存管理会提供虚拟内存的机制,该机制可以让进程使用多于系统可用Memory的内存,不用的内存会通过文件系统保存在外部非易失存储器中,需要使用的时候,再取回到内存中。

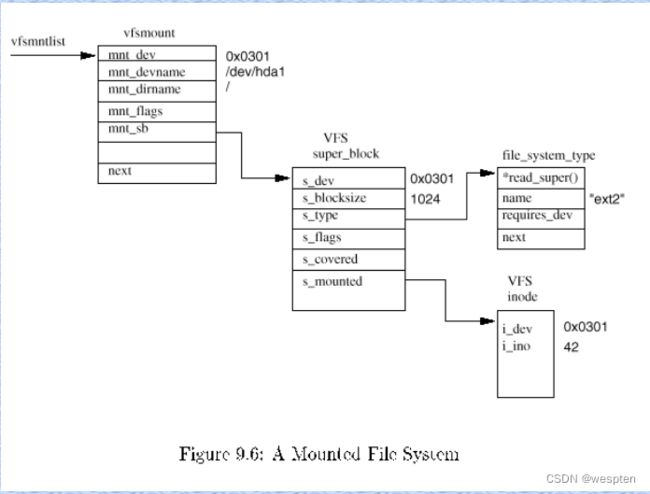

3. VFS(Virtual File System),虚拟文件系统。Linux内核将不同功能的外部设备,例如Disk设备(硬盘、磁盘、NAND Flash、Nor Flash等)、输入输出设备、显示设备等等,抽象为可以通过统一的文件操作接口(open、close、read、write等)来访问。这就是Linux系统“一切皆是文件”的体现(其实Linux做的并不彻底,因为CPU、内存、网络等还不是文件,如果真的需要一切皆是文件,还得看贝尔实验室正在开发的"Plan 9”的)。

4. Network,网络子系统。负责管理系统的网络设备,并实现多种多样的网络标准。

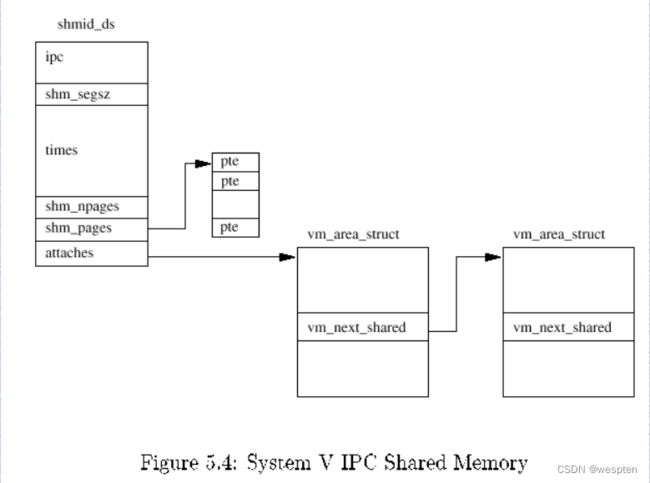

5. IPC(Inter-Process Communication),进程间通信。IPC不管理任何的硬件,它主要负责Linux系统中进程之间的通信。

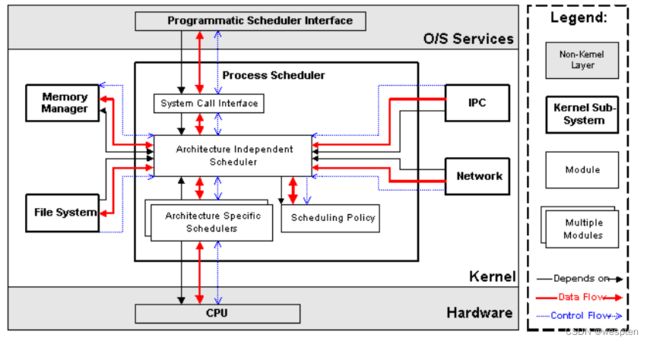

进程调度(Process Scheduler)

进程调度是Linux内核中最重要的子系统,它主要提供对CPU的访问控制。因为在计算机中,CPU资源是有限的,而众多的应用程序都要使用CPU资源,所以需要“进程调度子系统”对CPU进行调度管理。

进程调度子系统包括4个子模块(见下图),它们的功能如下:

- Scheduling Policy,实现进程调度的策略,它决定哪个(或哪几个)进程将拥有CPU。

- Architecture-specific Schedulers,体系结构相关的部分,用于将对不同CPU的控制,抽象为统一的接口。这些控制主要在suspend和resume进程时使用,牵涉到CPU的寄存器访问、汇编指令操作等。

- Architecture-independent Scheduler,体系结构无关的部分。它会和“Scheduling Policy模块”沟通,决定接下来要执行哪个进程,然后通过“Architecture-specific Schedulers模块”resume指定的进程。

- System Call Interface,系统调用接口。进程调度子系统通过系统调用接口,将需要提供给用户空间的接口开放出去,同时屏蔽掉不需要用户空间程序关心的细节。

内存管理(Memory Manager, MM)

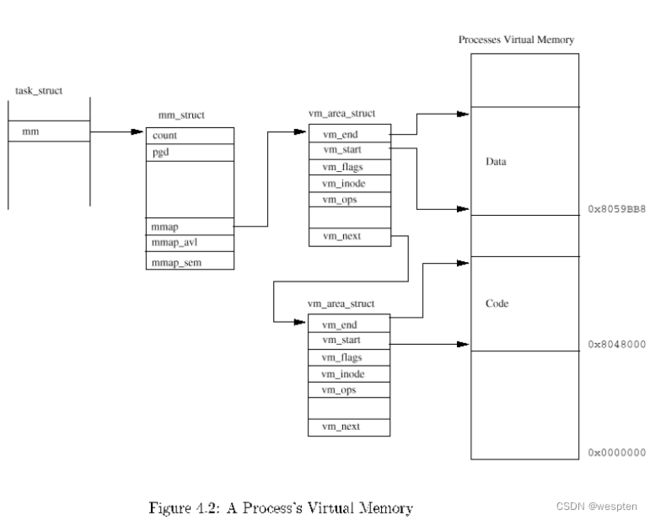

内存管理同样是Linux内核中最重要的子系统,它主要提供对内存资源的访问控制。Linux系统会在硬件物理内存和进程所使用的内存(称作虚拟内存)之间建立一种映射关系,这种映射是以进程为单位,因而不同的进程可以使用相同的虚拟内存,而这些相同的虚拟内存,可以映射到不同的物理内存上。

内存管理子系统包括3个子模块(见下图),它们的功能如下:

- Architecture Specific Managers,体系结构相关部分。提供用于访问硬件Memory的虚拟接口。

- Architecture Independent Manager,体系结构无关部分。提供所有的内存管理机制,包括:以进程为单位的memory mapping;虚拟内存的Swapping。

- System Call Interface,系统调用接口。通过该接口,向用户空间程序应用程序提供内存的分配、释放,文件的map等功能。

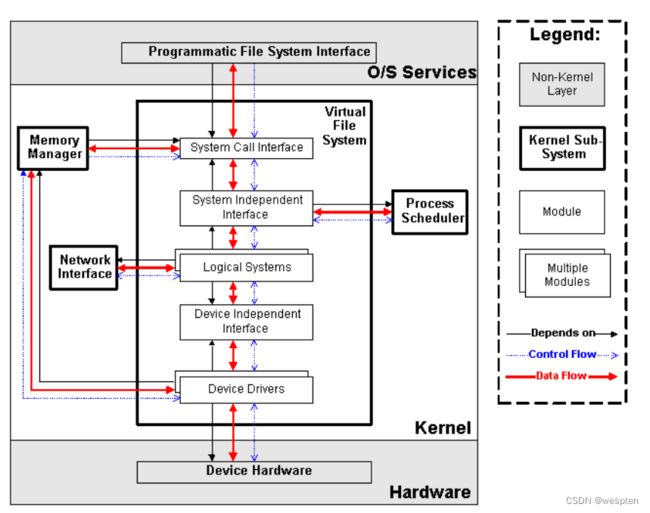

虚拟文件系统(Virtual Filesystem, VFS)

传统意义上的文件系统,是一种存储和组织计算机数据的方法。它用易懂、人性化的方法(文件和目录结构),抽象计算机磁盘、硬盘等设备上冰冷的数据块,从而使对它们的查找和访问变得容易。因而文件系统的实质,就是“存储和组织数据的方法”,文件系统的表现形式,就是“从某个设备中读取数据和向某个设备写入数据”。

随着计算机技术的进步,存储和组织数据的方法也是在不断进步的,从而导致有多种类型的文件系统,例如FAT、FAT32、NTFS、EXT2、EXT3等等。而为了兼容,操作系统或者内核,要以相同的表现形式,同时支持多种类型的文件系统,这就延伸出了虚拟文件系统(VFS)的概念。VFS的功能就是管理各种各样的文件系统,屏蔽它们的差异,以统一的方式,为用户程序提供访问文件的接口。

我们可以从磁盘、硬盘、NAND Flash等设备中读取或写入数据,因而最初的文件系统都是构建在这些设备之上的。这个概念也可以推广到其它的硬件设备,例如内存、显示器(LCD)、键盘、串口等等。我们对硬件设备的访问控制,也可以归纳为读取或者写入数据,因而可以用统一的文件操作接口访问。Linux内核就是这样做的,除了传统的磁盘文件系统之外,它还抽象出了设备文件系统、内存文件系统等等。这些逻辑,都是由VFS子系统实现。

VFS子系统包括6个子模块(见下图),它们的功能如下:

- Device Drivers,设备驱动,用于控制所有的外部设备及控制器。由于存在大量不能相互兼容的硬件设备(特别是嵌入式产品),所以也有非常多的设备驱动。因此,Linux内核中将近一半的Source Code都是设备驱动,大多数的Linux底层工程师(特别是国内的企业)都是在编写或者维护设备驱动,而无暇估计其它内容(它们恰恰是Linux内核的精髓所在)。

- Device Independent Interface, 该模块定义了描述硬件设备的统一方式(统一设备模型),所有的设备驱动都遵守这个定义,可以降低开发的难度。同时可以用一致的形势向上提供接口。

- Logical Systems,每一种文件系统,都会对应一个Logical System(逻辑文件系统),它会实现具体的文件系统逻辑。

- System Independent Interface,该模块负责以统一的接口(快设备和字符设备)表示硬件设备和逻辑文件系统,这样上层软件就不再关心具体的硬件形态了。

- System Call Interface,系统调用接口,向用户空间提供访问文件系统和硬件设备的统一的接口。

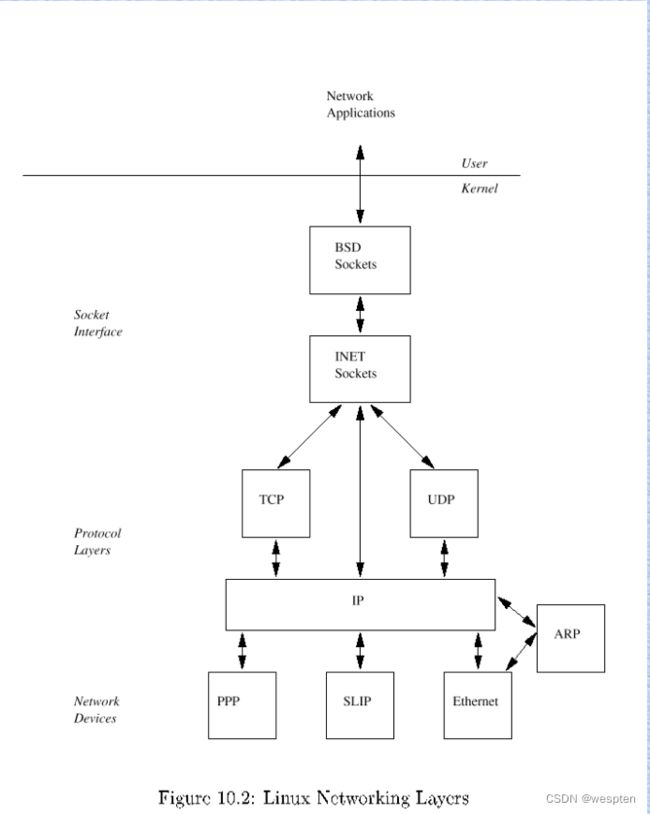

网络子系统(Net)

网络子系统在Linux内核中主要负责管理各种网络设备,并实现各种网络协议栈,最终实现通过网络连接其它系统的功能。在Linux内核中,网络子系统几乎是自成体系,它包括5个子模块(见下图),它们的功能如下:

- Network Device Drivers,网络设备的驱动,和VFS子系统中的设备驱动是一样的。

- Device Independent Interface,和VFS子系统中的是一样的。

- Network Protocols,实现各种网络传输协议,例如IP, TCP, UDP等等。

- Protocol Independent Interface,屏蔽不同的硬件设备和网络协议,以相同的格式提供接口(socket)。

- System Call interface,系统调用接口,向用户空间提供访问网络设备的统一的接口。

IPC子系统,请参考:

Linux进程管理和计划任务与系统备份恢复_wespten的博客-CSDN博客

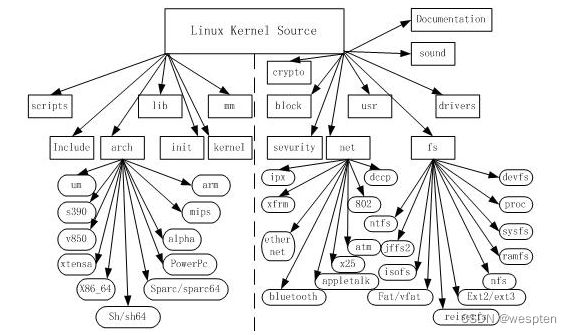

3、Linux内核源代码的目录结构

Linux内核源代码包括三个主要部分:

1. 内核核心代码,包括各个子系统和子模块,以及其它的支撑子系统,例如电源管理、Linux初始化等

2. 其它非核心代码,例如库文件(因为Linux内核是一个自包含的内核,即内核不依赖其它的任何软件,自己就可以编译通过)、固件集合、KVM(虚拟机技术)等

3. 编译脚本、配置文件、帮助文档、版权说明等辅助性文件

下面内核目录以linux-3.14内核作为讲解:

1. documentation:

提供文档帮助。关于内核的一些说明信息,在这个目录下会有帮助手册。

比如linux-3.14-fs4412/Documentation/devicetree/bindings/interrupt-controller/interrupts.txt

该文件讲解了关于设备数节点 中断设备interrupts属性的cell的详细说明。

只要根据文件夹名字,便可查找到我们所需的说明文档。

2. arch:

arch是architecture的缩写。所有与体系结构相关的代码都在这个目录以

include/asm-*/目录中。Linux支持的每种体系结构在arch目录下都有对应的目录,又进一

步分解为boot,mm,kernel等子目录:

|--arm arm及与之相兼容体系结构的子目录

|--boot 引导程序,以及在这种硬件平台上启动内核所使用的内存管理程序的实现。

|--compressed 内核解压缩

|--tools 生成压缩内核映像的程序

| --kernel: 存放支持体系结构特有的诸如信号量处理和SMP之类特征的实现。

| --lib: 存放体系结构特有的对诸如strlen和memcpy之类的通用函数的实现。

| --mm: 存放体系结构特有的内存管理程序的实现。

除了这3个子目录以外,大多数体系结构在必要的情况下还有一个boot子目录,包括了在这种硬件平台上启动内核所使用的内存管理程序的实现。

3. drivers:

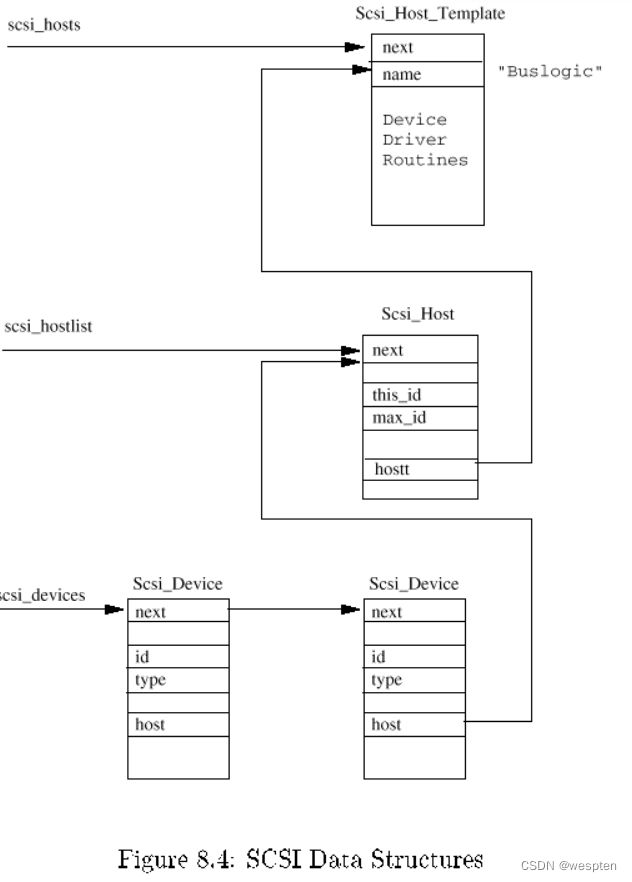

驱动代码,驱动是一个控制硬件的软件。这个目录是内核中最庞大的一个目录,显卡、网卡、SCSI适配器、PCI总线、USB总线和其他任何Linux支持的外围设备或总线的驱动程序都可以在这儿找到。

4. fs:

虚拟文件系统(VFS)的代码,和各个不同文件系统的代码都在这个目录中。Linux支持的所有文件系统在fs目录下面都有一个对应的子目录。比如ext2文件系统对应的是fs/ext2目录。

一个文件系统是存储设备和需要访问存储设备的进程之间的媒介。存储设备可能是本地的物理上可以访问的,比如硬盘或者CD-ROM驱动器,他们分别使用而系统ext2/ext3和isofs文件系统。

还有一些虚拟文件系统(proc),它是一个标准文件系统出现。然而,他其中的文件只存在于内存中,并不占磁盘空间。

5. include:

这个目录包含了内核中大部分的头文件,它按照下面的子目录进行分组。要修改处理器结构则只需编辑核心的makefile并重新运行Linux核心配置程序。

| include/asm-*/ 每一个对应着一个arch的子目录,比如include/asm-alpha、

Include/asm-arm等。每个子目录中的文件都定义了支持给定体系结构所必要的预处理函数和内联函数,这些内联函数多数都是全部或者部分的汇编语言实现。

| include/linux 与平台无关的头文件都在这个目录下,它通常会被链接到目录

/usr/include/linux(或者它里面的所有文件都会被复制到/usrinclude/linux目录下边)

6. init:

内核的初始化代码。包括main.c、创建早起用户空间的代码及其他初始化代码。

7. ipc:

IPC(进程间通信)。它包含了共享内存、信号量及其他形式的IPC代码。

8. kernel:

内核中最核心的部分,包括进程的调度(sched.c),以及进程的创建和撤销(fork.c和exit.c)和平台相关的另外一部分核心代码在arch/*/kernel目录下。

9. mm

此目录包含了与体系无关的部分内存管理代码。与体系结构相关的内存管理代码位于arch/*/mm下。

10. net

核心的网络部分代码,实现了各种常见的网络协议,入TCP/IP、IPX等。

11. lib

此目录包含了核心的库代码。实现了一个标准C库的通用子集,包括字符串和内存操作的函数(strlen、mmcpy等)以及有关sprintf和atoi系列函数。与arch/lib下的代码不同,这里的库代码都是C编写的,在内核新的移植版本中可以直接使用。与处理器结构相关库代码被放在arch/mm中。

12. block:

块设备驱动包括IDE(在ide.c中)驱动。块设备是以数据块方式接收和发送的数据的设备。最初block层代码一部分位于drivers目录,一部分位于fs目录。从2.6.15开始,block层的核心代码就被提取出来放在顶层的block目录中。如果你想寻找这些可包含文件系统的设备的初始化过程则应该在drivers/block/genhd.c中的device_setup()。当安装一个nfs文件系统时不但要初始化硬盘还需初始化网络。块设备包括IDE与SCSI设备。

13. firmware

fireware中包含了让计算机读取和理解从设备发来的信号的代码。举例来说,一个摄像头管理它自己的硬件,但计算机必须了解摄像头给计算机发送的信号。Linux系统会使用vicam固件(firmware)来理解摄像头的通讯。否则,没有了固件,Linux系统将不知道如何处理摄像头发来的信息。另外,固件同样有助于将Linux系统发送消息给该设备。这样Linux系统可以告诉摄像头重新调整或关闭摄像头。

13. usr:

实现用于打包和压缩的cpio等。这个文件夹中的代码在内核编译完成后创建这些文件。

14. securtity:

这个目录下包含了不同的Linux安全模型的代码。它对计算机免于受到病毒和黑客的侵害很重要。否则,Linux系统可能会遭到损坏。

15. crypto:

内核本身所用的加密API,实现了常用的加密和散列算法,还有一些压缩和CRC校验算法。例:“sha1_generic.c”这个文件包含了SHA1加密算法的代码。

16. scripts:

该目录下没有内核代码,只是包含了用来配置内核的脚本文件。当运行make menuconfig或者make xconfig之类的命令配置内核时,用户就是和位于这个目录下的脚本进行交互的。

17. sound:

声卡驱动以及其他声音相关的源码。

18. samples

一些内核编程的范例

19. virt

此文件夹包含了虚拟化代码,它允许用户一次运行多个操作系统。通过虚拟化,客户机操作系统就像任何其他运行在Linux主机的应用程序一样运行。

20. tools

这个文件夹中包含了和内核交互的工具。

COPYING:许可和授权信息。Linux内核在GPLv2许可证下授权。该许可证授予任何人有权免费去使用、修改、分发和共享源代码和编译代码。然而,没有人可以出售源代码。

CREDITS : 贡献者列表

Kbuild : 这是一个设置一些内核设定的脚本。打个比方,这个脚本设定一个ARCH变量,这是开发者想要生成的内核支持的处理器类型。

Kconfig: 这个脚本会在开发人员配置内核的时候用到

MAINTAINERS : 这是一个目前维护者列表,他们的电子邮件地址,主页,和他们负责开发和维护的内核的特定部分或文件。当一个开发者在内核中发现一个问题,并希望能够报告给能够处理这个问题的维护者时,这是是很有用的。

Makefile :这个脚本是编译内核的主要文件。这个文件将编译参数和编译所需的文件和必要的信息传给编译器。

README : 这个文档提供给开发者想要知道的如何编译内核的信息。

REPORTING-BUGS : 这个文档提供如何报告问题的信息。

内核的代码是以“.c”或“.h”为扩展名的文件。 “.c”的扩展名表明内核是用众多的编程语言之一的C语言写的, “h”的文件是头文件,而他们也是用C写成。头文件包含了许多“.c”文件需要使用的代码,因为他们可以引入已有的代码而不是重新编写代码,这节省了程序员的时间。否则,一组执行相同的动作的代码,将存在许多或全部都是“c”文件。这也会消耗和浪费硬盘空间。(译注:头文件不仅仅可节省重复编码,而且代码复用也会降低代码错误的几率)

Linux内核整体架构总结:

Linux内核体系结构:

(1)系统调用接口

SCI 层提供了某些机制执行从用户空间到内核的函数调用。正如前面讨论的一样,这个接口依赖于体系结构,甚至在相同的处理器家族内也是如此。SCI 实际上是一个非常有用的函数调用多路复用和多路分解服务。在 ./linux/kernel 中您可以找到 SCI 的实现,并在 ./linux/arch 中找到依赖于体系结构的部分。

(2)进程管理

进程管理的重点是进程的执行。在内核中,这些进程称为线程,代表了单独的处理器虚拟化(线程代码、数据、堆栈和 CPU 寄存器)。在用户空间,通常使用进程 这个术语,不过 Linux 实现并没有区分这两个概念(进程和线程)。内核通过 SCI 提供了一个应用程序编程接口(API)来创建一个新进程(fork、exec 或 Portable Operating System Interface [POSIX] 函数),停止进程(kill、exit),并在它们之间进行通信和同步(signal 或者 POSIX 机制)。

进程管理还包括处理活动进程之间共享 CPU 的需求。内核实现了一种新型的调度算法,不管有多少个线程在竞争 CPU,这种算法都可以在固定时间内进行操作。这种算法就称为 O(1) 调度程序,这个名字就表示它调度多个线程所使用的时间和调度一个线程所使用的时间是相同的。O(1) 调度程序也可以支持多处理器(称为对称多处理器或 SMP)。您可以在 ./linux/kernel 中找到进程管理的源代码,在 ./linux/arch 中可以找到依赖于体系结构的源代码。

(3)内存管理

内核所管理的另外一个重要资源是内存。为了提高效率,如果由硬件管理虚拟内存,内存是按照所谓的内存页 方式进行管理的(对于大部分体系结构来说都是 4KB)。Linux 包括了管理可用内存的方式,以及物理和虚拟映射所使用的硬件机制。不过内存管理要管理的可不止 4KB 缓冲区。Linux 提供了对 4KB 缓冲区的抽象,例如 slab 分配器。这种内存管理模式使用 4KB 缓冲区为基数,然后从中分配结构,并跟踪内存页使用情况,比如哪些内存页是满的,哪些页面没有完全使用,哪些页面为空。这样就允许该模式根据系统需要来动态调整内存使用。为了支持多个用户使用内存,有时会出现可用内存被消耗光的情况。由于这个原因,页面可以移出内存并放入磁盘中。这个过程称为交换,因为页面会被从内存交换到硬盘上。内存管理的源代码可以在 ./linux/mm 中找到。

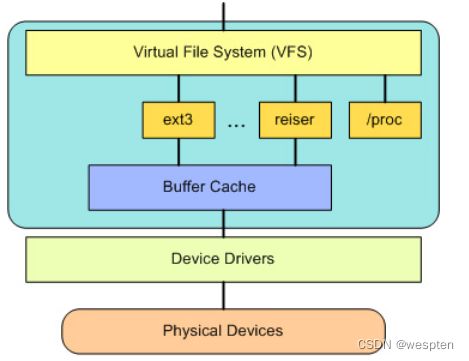

(4)虚拟文件系统

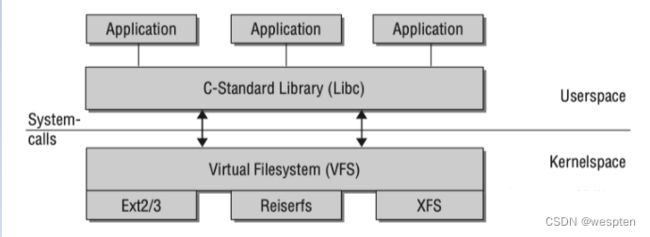

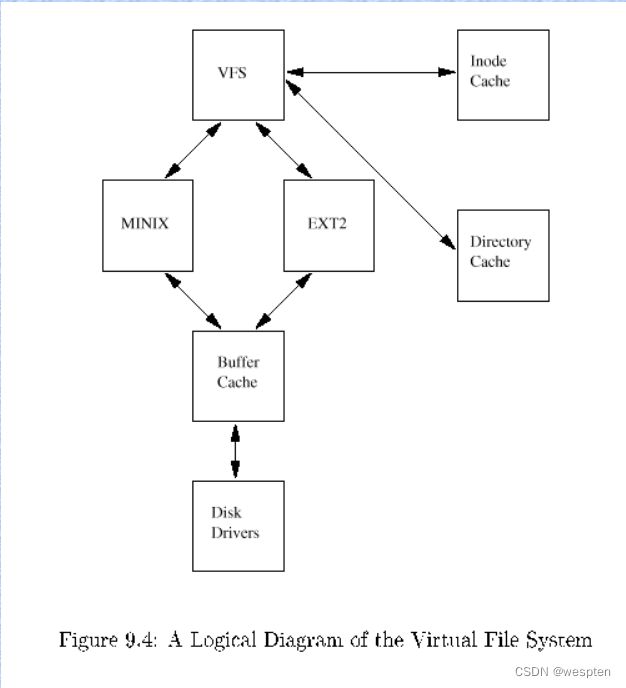

虚拟文件系统(VFS)是 Linux 内核中非常有用的一个方面,因为它为文件系统提供了一个通用的接口抽象。VFS 在 SCI 和内核所支持的文件系统之间提供了一个交换层。

文件系统层次结构:

在 VFS 上面,是对诸如 open、close、read 和 write 之类的函数的一个通用 API 抽象。在 VFS 下面是文件系统抽象,它定义了上层函数的实现方式。它们是给定文件系统(超过 50 个)的插件。文件系统的源代码可以在 ./linux/fs 中找到。文件系统层之下是缓冲区缓存,它为文件系统层提供了一个通用函数集(与具体文件系统无关)。这个缓存层通过将数据保留一段时间(或者随即预先读取数据以便在需要时就可用)优化了对物理设备的访问。缓冲区缓存之下是设备驱动程序,它实现了特定物理设备的接口。

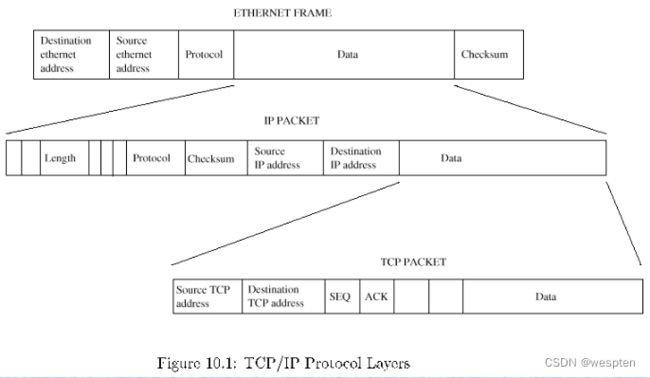

(5)网络堆栈

网络堆栈在设计上遵循模拟协议本身的分层体系结构。回想一下,Internet Protocol (IP) 是传输协议(通常称为传输控制协议或 TCP)下面的核心网络层协议。TCP 上面是 socket 层,它是通过 SCI 进行调用的。socket 层是网络子系统的标准 API,它为各种网络协议提供了一个用户接口。从原始帧访问到 IP 协议数据单元(PDU),再到 TCP 和 User Datagram Protocol (UDP),socket 层提供了一种标准化的方法来管理连接,并在各个终点之间移动数据。内核中网络源代码可以在 ./linux/net 中找到。

(6)设备驱动程序

Linux 内核中有大量代码都在设备驱动程序中,它们能够运转特定的硬件设备。Linux 源码树提供了一个驱动程序子目录,这个目录又进一步划分为各种支持设备,例如 Bluetooth、I2C、serial 等。设备驱动程序的代码可以在 ./linux/drivers 中找到。

(7)依赖体系结构的代码

尽管 Linux 很大程度上独立于所运行的体系结构,但是有些元素则必须考虑体系结构才能正常操作并实现更高效率。./linux/arch 子目录定义了内核源代码中依赖于体系结构的部分,其中包含了各种特定于体系结构的子目录(共同组成了 BSP)。对于一个典型的桌面系统来说,使用的是 x86 目录。每个体系结构子目录都包含了很多其他子目录,每个子目录都关注内核中的一个特定方面,例如引导、内核、内存管理等。这些依赖体系结构的代码可以在 ./linux/arch 中找到。

如果 Linux 内核的可移植性和效率还不够好,Linux 还提供了其他一些特性,它们无法划分到上面的分类中。作为一个生产操作系统和开源软件,Linux 是测试新协议及其增强的良好平台。Linux 支持大量网络协议,包括典型的 TCP/IP,以及高速网络的扩展(大于 1 Gigabit Ethernet [GbE] 和 10 GbE)。Linux 也可以支持诸如流控制传输协议(SCTP)之类的协议,它提供了很多比 TCP 更高级的特性(是传输层协议的接替者)。

Linux 还是一个动态内核,支持动态添加或删除软件组件。被称为动态可加载内核模块,它们可以在引导时根据需要(当前特定设备需要这个模块)或在任何时候由用户插入。

Linux 最新的一个增强是可以用作其他操作系统的操作系统(称为系统管理程序)。最近,对内核进行了修改,称为基于内核的虚拟机(KVM)。这个修改为用户空间启用了一个新的接口,它可以允许其他操作系统在启用了 KVM 的内核之上运行。除了运行 Linux 的其他实例之外, Microsoft Windows也可以进行虚拟化。惟一的限制是底层处理器必须支持新的虚拟化指令。

四、内核整体架构设计

1、内核机制

将各个功能做成不同的内核子系统,若子系统要通信,则必须设计一种机制可以让子系统彼此间通信时是安全可靠且高效的。

linux在一步步的发展中吸取了微内核的设计经验,虽然是单内核,但是兼具微内核的特性。

linux通过使用模块化内核设计来兼具微内核特性,但这样的模块化设化设计并不是像微内核一样是各个子系统,而是由核心加外围的功能性模块组成内核。而微内核子系统都是各自独立运行的,不需要依赖其他部分就能工作,而linux各模块必许依赖核心,只是能在使用时进行装载,不用时被动态卸载。linux下的模块外在表现为类型程序的库文件,只是程序库文件为.so,而内核模块为.ko(kernel object),被内核调用。

假设,如果驱动是内核提供的,想象下,编译好一个内核,装在主机上,万一后来发现他无法驱动我们后来新添加的新硬件设备。由于各种硬件都是由内核驱动的,内核没有提供这个程序,是不是得重新编译内核,这对用户和厂商来说是非常麻烦的一件事。

模块化设计得以避免这种情况,各厂商以模块化的形式开发自己的驱动,只需针对某一特定设备开发自己驱动程序的即可。

Linux内核开发人员所做的一件事就是使内核模块可以在运行时加载和卸载,这意味着您可以动态地添加或删除内核的特性。这不仅可以向内核添加硬件功能,还可以包括运行服务器进程的模块,比如低级别虚拟化,但也可以替换整个内核,而不需要在某些情况下重启计算机。

需要时我们编译这些模块即可,不需要某一功能时,可自行拆卸,并不影响核心的运行。想象一下,如果您可以升级到Windows服务包,而不需要重新启动,这就是模块化的好处和优势之一。

1)CPU工作机制

CPU工作模式

现代CPU通常都实现了不同的工作模式,以ARM为例:ARM实现了7种工作模式,不同模式下CPU可以执行的指令或者访问的寄存器不同:

(1)用户模式 usr

(2)系统模式 sys

(3)管理模式 svc

(4)快速中断 fiq

(5)外部中断 irq

(6)数据访问终止 abt

(7)未定义指令异常

以(2)X86为例:X86实现了4个不同级别的权限,Ring0—Ring3 ;Ring0下可以执行特权指令,可以访问IO设备;Ring3则有很多的限制

所以,Linux从CPU的角度出发,为了保护内核的安全,把系统分成了用户空间和内核空间。

用户空间和内核空间是程序执行的两种不同状态,我们可以通过“系统调用”和“硬件中断“来完成用户空间到内核空间的转移。

应用程序运行在内核上,只是逻辑上的情况。但实际是直接工作在硬件上的,任意应用程序数据都在内存中,数据处理都是CPU,只是他们不能随意使用而已,要接受内核的管理。

但CPU只有一颗,应用程序工作的时候,内核就暂停了,应用程序也在内存空间中,一旦应用程序想要访问其他硬件资源时,即要执行I/O指令时,但却不能执行。因为应用程序看不见硬件,应用程序是基于系统调用的程序,当应用程序需要访问硬件资源时时,就向CPU发起特权请求,一旦CPU收到特权请求,CPU就会唤醒内核,从而执行内核中的某段代码(非完整的内核程序),然后将结果返回给应用程序,而后内核代码退出,内核程序暂停。

在这期间CPU就从用户模式转换成了内核模式,内核模式就好似能够执行特权的模式。

所有的应用程序时在硬件上直接执行的,只是在必要时接受内核的管理和监控,故内核也是监控器,监控程序,是资源和进程的监控程序。

内核没有生产力,生产力是由个被调用的应用程序产生,故我们应该尽量让系统运行在应用程序模式中,故内核占据的时间越少越好。而内核主要在进程切换、中断处理等相关功能上,占据时间,模式切换到目的也是为了生产完成,但进程切换与生产就没有任何意义了,中断处理可以认为与生产本身相关,因为应用要执行I/O。

内核的主要目的是完成硬件管理,而linux中有一个思想,各进程都是由其父进程衍生的,由父进程fork()而来的,那么由谁来fork()以及管理这些进程,于是有了大管家程序init,统筹管理用户空间的所有进程。

用户空间的管理工作都不会由内核执行,故我们启动完内核之后,要想启动用户空间首先需要启动init,故init的PID号永远为1。 init也是由其父进程fork()而来,是内核空间中的用来专门引导用户空间进程的机制。init是一个应用程序,在/sbin/init下,是一个可执行文件。

CPU的时间

因为内存中每一个进程都直接是独占CPU的,故内核即是将CPU虚拟化,提供给进程,CPU在内核级别就已经虚拟化了,通过将CPU切成时间片,随着时间流逝而完成在个进程之间分派计算能力的,CPU是以时间提供其计算能力的。

在单位时间内要能够提供的计算能力越大,必须速度越快,否则只能延长时间。这也就是我们需要更快的CPU,以节约时间。

CPU的运算特性

I/O是最慢的设备,我们CPU有大量时间都拿来等待I/O完成,为避免空余的没有任何意义的等待,需要等待时,就让CPU运行别的进程或线程。

我们应该最大能力榨取CPU的计算能力,因为CPU的计算能力是随着时间时钟频率的振荡器在震荡,你用或者不用他都在跑。

如果你让CPU空闲着,他依然耗电,而且随时间流逝,计算能力白白消逝了,因此能够让CPU工作在80-90%的利用率下,这就意味着他的生产能力得到了充分的发挥。CPU是用不坏的,没有什么磨损很消耗,是电器设备,除了功率大是发热量大,散热足够就好了,对于电器设备而言不用反而会坏。

Linux内核中9种同步机制

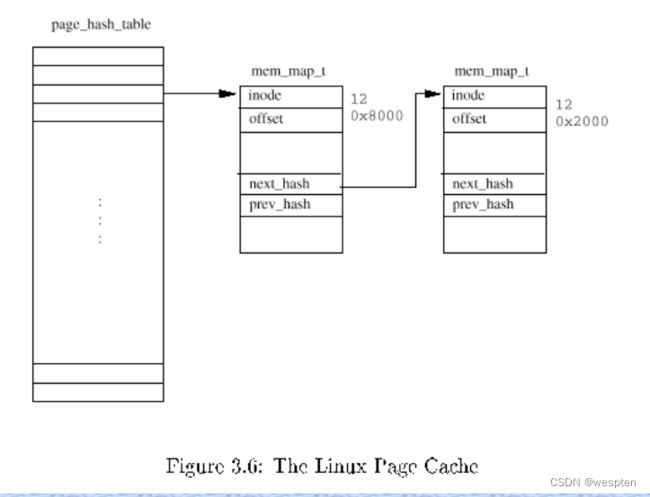

Linux经常使用散列表来实现高速缓存(Cache),高速缓存是需要快速访问的信息。

在操作系统引入了进程概念,进程成为调度实体后,系统就具备了并发执行多个进程的能力,但也导致了系统中各个进程之间的资源竞争和共享。

另外,由于中断、异常机制的引入,以及内核态抢占都导致了这些内核执行路径(进程)以交错的方式运行。对于这些交错路径执行的内核路径,如不采取必要的同步措施,将会对一些关键数据结构进行交错访问和修改,从而导致这些数据结构状态的不一致,进而导致系统崩溃。因此,为了确保系统高效稳定有序地运行,linux必须要采用同步机制。

在linux系统中,我们把对共享的资源进行访问的代码片段称为临界区。把导致出现多个进程对同一共享资源进行访问的原因称为并发源。

Linux系统下并发的主要来源有:

中断处理:例如,当进程在访问某个临界资源的时候发生了中断,随后进入中断处理程序,如果在中断处理程序中,也访问了该临界资源。虽然不是严格意义上的并发,但是也会造成了对该资源的竞态。

内核态抢占:例如,当进程在访问某个临界资源的时候发生内核态抢占,随后进入了高优先级的进程,如果该进程也访问了同一临界资源,那么就会造成进程与进程之间的并发。

多处理器的并发:多处理器系统上的进程与进程之间是严格意义上的并发,每个处理器都可以独自调度运行一个进程,在同一时刻有多个进程在同时运行 。

如前所述可知:采用同步机制的目的就是避免多个进程并发并发访问同一临界资源。

9种同步机制:

1)每CPU变量

主要形式是数据结构的数组,系统中的每个CPU对应数组的一个元素。

使用情况:数据应在逻辑上是独立的

使用原则:应在内核控制路径禁用抢占的情况下访问每CPU变量。

2)原子操作

原理:是借助于汇编语言指令中对“读--修改--写”具有原子性的汇编指令来实现。

3)内存屏障

原理:使用内存屏障原语确保在原语之后的操作开始之前,原语之前的操作已经完成。

4)自旋锁

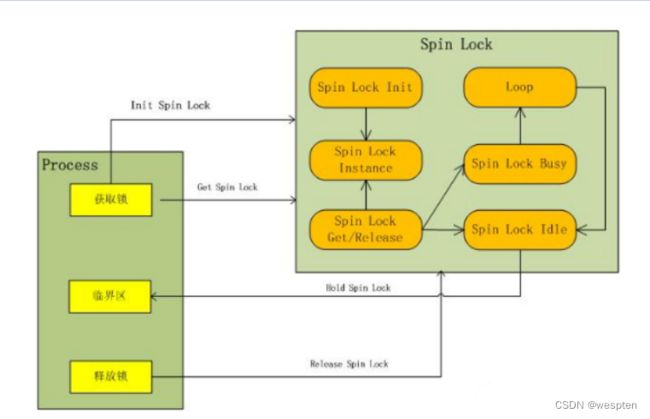

主要用于多处理器环境中。

原理:如果一个内核控制路径发现所请求的自旋锁已经由运行在另一个CPU上的内核控制路径“锁着”,就反复执行一条循环指令,直到锁被释放。

说明:自旋锁一般用于保护禁止内核抢占的临界区。

在单处理器上,自旋锁的作用仅是禁止或启用内核抢占功能。

5)顺序锁

顺序锁与自旋锁非常相似,仅有一点不同,即顺序锁中的写者比读者有较高的优先级,也就意味着即使读者正在读的时候也允许写者继续运行。

6)RCU

主要用于保护被多个CPU读的数据结构。

允许多个读者和写者同时运行,且RCU是不用锁的。

使用限制:

1)RCU只保护被动态分配并通过指针引用的数据结构

2)在被RCU保护的临界区中,任何内核控制路径都不能睡眠。

原理:

当写者要更新数据时,它通过引用指针来复制整个数据结构的副本,然后对这个副本进行修改。修改完毕后,写者改变指向原数据结构的指针,使它指向被修改后的副本,(指针的修改是原子的)。

7)信号量:

原理: 当内核控制路径试图获取内核信号量所保护的忙资源时,相应的进程被挂起;只有在资源被释放时,进程才再次变为可运行。

使用限制:只有可以睡眠的函数才能获取内核信号量 ;

中断处理程序和可延迟函数都不能使用内核信号量。

8)本地中断禁止

原理:本地中断禁止可以保证即使硬件设备产生了一个IRQ信号时,内核控制路径也会继续运行,从而使中断处理例程访问的数据结构受到保护。

不足:禁止本地中断并不能限制运行在另一个CPU上的中断处理程序对共享数据结构的并发访问,

故在多处理器环境中,禁止本地中断需要与自旋锁一起使用。

9)本地软中断的禁止

方法1:

由于软中断是在硬件中断处理程序结束时开始运行的,所以最简单的方式是禁止那个CPU上的中断。

因为没有中断处理例程被激活,故软中断就没有机会运行。

方法2:

通过操纵当前thread_info描述符preempt_count字段中存放的软中断计数器,可以在本地CPU上激活或禁止软中断。因为内核有时只需要禁止软中断而不禁止中断。

2)内存机制

Linux的内存机制包括地址空间、物理内存、内存映射、分页机制及交换机制。

地址空间

虚存的优点之一是每个进程都认为自己拥有所需的全部地址空间。虚存的大小可以是系统中物理内存大小的许多倍。系统中的每个进程都有自己的虚址空间,这些虚址空间相互之间完全独立。运行某个应用程序的进程不会影响到其他进程,应用程序之间也是相互保护的。虚址空间由操作系统映射至物理内存。从应用程序的角度来说,这个地址空间是一个线性的平面地址空间;但内核对用户虚址空间的处理则有很大的不同。

线性地址空间被划分为两部分:用户地址空间和内核地址空间。用户地址空间不会在每次发生上下文切换时都改变,而内核地址空间则始终保持不变。为用户空间和内核空间分配的空间容量主要取决于系统是32位还是64位的体系结构。例如,x86是32位的体系结构,它只支持4GB的地址空间,其中3GB为用户空间保留,1GB分配给内核地址空间。具体的划分大小由内核配置变量PAGE_OFFSET决定。

物理内存

为了支持多种体系结构,Linux使用与体系结构无关的方式来描述物理内存。

物理内存可以组织成内存体(bank)的结构,每个内存体与处理器的距离都是特定的。随着越来越多的机器采用非一致性内存访问(Nonuniform Memory Access,NUMA)技术,这种类型的内存布局已非常普遍。Linux VM以节点来表示这种排列方式。每个节点划分为许多称为管理区(zone)的内存块,它们代表了内存中的地址范围。有三种不同的管理区:ZONE_DMA、ZONE_NORMAL和ZONE_HIGHMEM。例如,x86具有以下内存管理区:

ZONE_DMA 内存地址的前16MB

ZONE_NORMAL 16MB~896MB

ZONE_HIGHMEM 896MB~内存结束地址

每个管理区都有各自的用途。从前的一些ISA设备对于可以在哪些地址上执行I/O操作具有限制条件,而ZONE_DMA可以消除这些限制。

ZONE_NORMAL用于所有的内核操作和分配。它对于系统性能是极为重要的。

ZONE_HIGHMEM是系统中其余的内存。需要注意的是,ZONE_HIGHMEM无法用于内核的分配和数据结构,只能用于保存用户数据。

内存映射

为了更好地理解内核内存的映射机制,下面以x86为例加以说明。前文提过,内核只有1GB的虚址空间可用,其他3GB保留给用户空间。内核将ZONE_DMA 和 ZONE_NORMAL中的物理内存直接映射到其地址空间。这意味着系统中最前面的896MB物理内存被映射到内核虚址空间,从而只剩下128MB的虚址空间。这128MB的虚址空间用于诸如vmalloc和kmap等操作。

如果物理内存容量较小(少于1GB),这种映射机制运作良好。然而,目前的所有服务器都支持数十千兆字节的内存。Intel公司在其Pentium处理器中引入了物理地址扩展(Physical Address Extension,PAE)机制,能够支持最多64GB物理内存。前述的内存映射机制使得如何处理高达数十千兆字节的物理内存成为x86 Linux的一个主要问题来源。Linux内核按照如下方式处理高端内存(896MB以上的所有内存):当Linux内核需要寻址高端内存中的某个页面时,通过kmap操作将该页面映射到一个小的虚址空间窗口中,在该页面上执行操作,然后解除对该页面的映射。64位体系结构的地址空间非常巨大,因此这类系统不存在这个问题。

分页机制

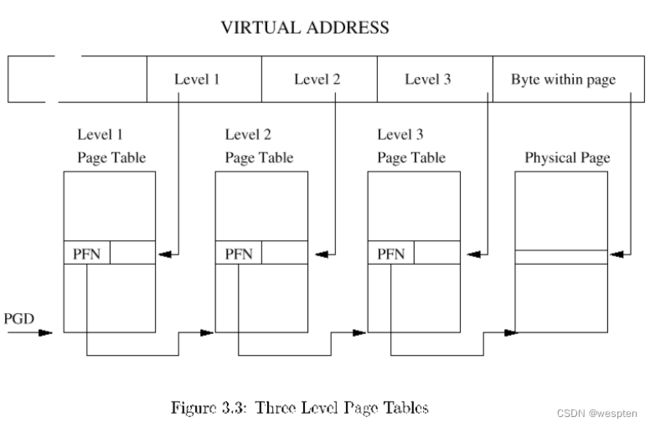

虚存可以有多种实现方式,其中最有效的方式是基于硬件的方案。虚址空间被划分成固定大小的内存块,称之为页面。虚存访问通过页表被转换成物理内存地址。为了支持各种体系结构和页面尺寸,Linux采用了三级分页机制。它提供了如下三种页表类型:

页面全局目录(Page Global Directory,PGD)

页面中层目录(Page Middle Directory,PMD)

页表(Page Table,PTE)

地址转换提供了一种将进程的虚址空间与物理地址空间分离的方法。每个虚存页面都可以在主内存中标记为“存在”或“不存在”。如果进程访问某个不存在的虚存地址,硬件就会产生一个页面错误,并由内核对其进行处理。内核处理该错误时将该页面置于主内存中。在这个过程中,系统可能需要将现有的某个页面替换掉,以便为新页面提供空间。

替换策略是分页系统最关键的内容之一。Linux 2.6版本修补了以前Linux版本中关于各种页面选择和替换的问题。

交换机制

交换是当主存容量不足时将整个进程移入或移出辅助存储器的过程。由于上下文切换的开销非常大,许多现代的操作系统,包括Linux,都不采用这种方法,而是采用分页机制。在Linux中,交换是在页面层次而不是在进程层次上执行的。交换的主要优点是扩展了进程可用的地址空间。当内核需要释放内存以便为新页面提供空间时,可能需要丢弃一些较少使用的或未用的页面。某些页面因为未被磁盘备份而不容易释放,需要被复制到后备存储器(交换区)中,在必要时还要从后备存储器中读回。交换机制的主要缺点是速度慢。磁盘的读写速度通常都非常缓慢,因此应该尽量消除交换操作。

3)进程机制

进程、任务与内核线程

任务只是一种“需要完成的工作的一般性描述”,可以是一个轻权的线程,也可以是一个完整的进程。

线程是最轻权的任务实例。在内核中创建线程的成本可能很高,也可能较低,这取决于线程需要拥有的特征。最简单的情形是线程与其父线程共享所有资源,包括代码、数据以及许多内部数据结构,而仅在区分该线程与其他线程上有一点点差异。

Linux中的进程是一个“重权的”数据结构。如果有必要的话,多个线程可以在单个进程中运行(并共享该进程的一些资源)。在Linux中,进程只是一个拥有全部重权特征的线程。线程和进程由调度器以相同方式进行调度。

内核线程是始终在内核模式中运行且没有用户上下文的线程。内核线程通常针对某个特定功能而存在,很容易在内核中处理它。内核线程经常具有所期望的作用:能够像其他任何进程一样进行调度;当其他进程需要该功能发挥作用时,为这些进程提供实现该功能的目标线程(通过发送信号)。

调度与上下文切换

进程调度是确保每个进程能公平分享CPU的一门科学(有人称之为艺术)。对于“公平”的定义,人们总是存在着不同的看法,因为调度器往往根据并不明显的可见的信息来做出选择。

需要注意的是,许多Linux用户都认为,一个在所有时候大部分正确的调度器要比一个在大多数时候完全正确的调度器更为重要,即缓慢运行的进程要优于因过于精心选择调度策略或错误而停止运行的进程。Linux当前的调度器程序就遵循了这个原则。

当一个进程停止运行,被另一个进程替换时,称为上下文切换。通常,这个操作的开销是很高的,内核程序员和应用程序员总是试图尽量减少系统执行上下文切换的数量。进程可以因为等待某个事件或资源而主动停止运行,或者因为系统决定应将CPU分配给另一个进程而被动地放弃运行。对于第一种情况,如果没有其他进程等待执行,CPU实际上可能进入空闲状态。在第二种情况下,该进程或者被另一个等待进程所替换,或者分配到一个新的运行时间片或时间周期继续执行。

即使在某个进程正按照有序的方式调度和执行时,也可以被其他更高优先级的任务中断。例如,假若磁盘为磁盘读操作准备好了数据后,就向CPU发送信号,并期望CPU从磁盘上获取数据。内核必须及时地处理这个情况,否则就会降低磁盘的传输率。信号、中断和异常是不同的异步事件,但在许多方面却类似,并且即使CPU已处于忙状态,它们也都必须被迅速处理。

例如,准备好了数据的磁盘会导致一个中断。内核调用该特定设备的中断处理程序,中断当前运行的进程并使用其众多资源。当中断处理程序执行结束后,当前运行的进程恢复执行。这实际上是侵占当前运行进程的CPU时间,因为当前版本的内核只测量自从该进程进入CPU之后所经过的时间,却忽略了中断会耗用该进程的宝贵时间这一事实。

中断处理程序通常是非常快速和简洁的,因而能够快速处理和清除以便使后续数据能够进入。但有时一个中断可能需要处理的工作比在中断处理程序中所期望的短时间内完成的工作更多。中断也需要一个定义良好的环境来完成其工作(要记住,中断利用了某个随机进程的资源)。在这种情况下,要收集足够信息,将工作延迟提交至bottom half处理程序进行处理。bottom half处理程序会不时地被调度执行。尽管在Linux早期版本中普遍使用了bottom half机制,但当前的Linux版本中不鼓励使用这种机制。

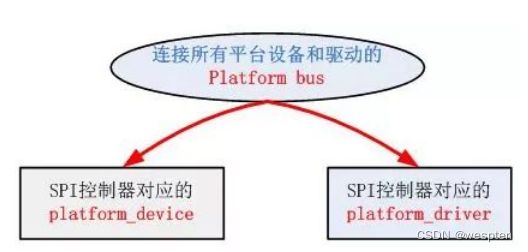

4)Linux驱动的platform机制

Linux的这种platform driver机制和传统的device_driver机制相比,一个十分明显的优势在于platform机制将本身的资源注册进内核,由内核统一管理,在驱动程序中使用这些资源时通过platform_device提供的标准接口进行申请并使用。这样提高了驱动和资源管理的独立性,并且拥有较好的可移植性和安全性。下面是SPI驱动层次示意图,Linux中的SPI总线可理解为SPI控制器引出的总线:

和传统的驱动一样,platform机制也分为三个步骤:

1、总线注册阶段:

内核启动初始化时的 main.c 文件中的 kernel_init()→do_basic_setup() →driver_init()→ platform_bus_init()→bus_register(&platform_bus_type) ,注册了一条 platform 总线(虚拟总线,platform_bus)。

2、添加设备阶段:

设备注册的时候 Platform_device_register()→platform_device_add()→ (pdev→dev.bus = &platform_bus_type)→device_add() ,就这样把设备给挂到虚拟的总线上。

3、驱动注册阶段:

Platform_driver_register() →driver_register() →bus_add_driver() →driver_attach()→bus_for_each_dev(), 对在每个挂在虚拟的platform bus的设备作 __driver_attach()→driver_probe_device(),判断 drv→bus→match() 是否执行成功,此时通过指针执行 platform_match→strncmp(pdev→name , drv→name , BUS_ID_SIZE ),如果相符就调用really_probe(实际就是执行相应设备的 platform_driver→probe(platform_device) 。)开始真正的探测,如果probe成功,则绑定设备到该驱动。

从上面可以看出,platform机制最后还是调用了bus_register() , device_add() , driver_register()这三个关键的函数。

下面看几个结构体:

struct platform_device

(/include/linux/Platform_device.h)

{

const char * name;

int id;

struct device dev;

u32 num_resources;

struct resource * resource;

};Platform_device结构体描述了一个platform结构的设备,在其中包含了一般设备的结构体 struct device dev; 设备的资源结构体 struct resource * resource; 还有设备的名字const char * name。(注意,这个名字一定要和后面platform_driver.driver àname相同,原因会在后面说明。)

该结构体中最重要的就是resource结构,这也是之所以引入platform机制的原因。

struct resource

( /include/linux/ioport.h)

{

resource_size_t start;

resource_size_t end;

const char *name;

unsigned long flags;

struct resource *parent, *sibling, *child;

};其中 flags位表示该资源的类型,start和end分别表示该资源的起始地址和结束地址(/include/linux/Platform_device.h):

struct platform_driver

{

int (*probe)(struct platform_device *);

int (*remove)(struct platform_device *);

void (*shutdown)(struct platform_device *);

int (*suspend)(struct platform_device *, pm_message_t state);

int (*suspend_late)(struct platform_device *, pm_message_t state);

int (*resume_early)(struct platform_device *);

int (*resume)(struct platform_device *);

struct device_driver driver;

};

Platform_driverPlatform_driver结构体描述了一个platform结构的驱动。其中除了一些函数指针外,还有一个一般驱动的device_driver结构。

名字要一致的原因:

上面说的驱动在注册的时候会调用函数bus_for_each_dev(), 对在每个挂在虚拟的platform bus的设备作__driver_attach()→driver_probe_device() ,在此函数中会对dev和drv做初步的匹配,调用的是 drv->bus->match 所指向的函数。 platform_driver_register 函数中 drv-> driver.bus = &platform_bus_type ,所以 drv->bus->matc 就为platform_bus_type→match, 为platform_match 函数,该函数如下:

static int platform_match(struct device * dev, struct device_driver * drv)

{

struct platform_device *pdev = container_of(dev, struct platform_device, dev);

return (strncmp(pdev->name, drv->name, BUS_ID_SIZE) == 0);

}是比较dev和drv的name,相同则会进入really_probe()函数,从而进入自己写的probe函数做进一步的匹配。所以dev→name和driver→drv→name在初始化时一定要填一样的。

不同类型的驱动,其match函数是不一样的,这个platform的驱动,比较的是dev和drv的名字,还记得usb类驱动里的match吗?它比较的是Product ID和Vendor ID。

Platform机制的好处:

1、提供platform_bus_type类型的总线,把那些不是总线型的soc设备都添加到这条虚拟总线上。使得,总线——设备——驱动的模式可以得到普及。

2、提供platform_device和platform_driver类型的数据结构,将传统的device和driver数据结构嵌入其中,并且加入resource成员,以便于和Open Firmware这种动态传递设备资源的新型bootloader和kernel 接轨。

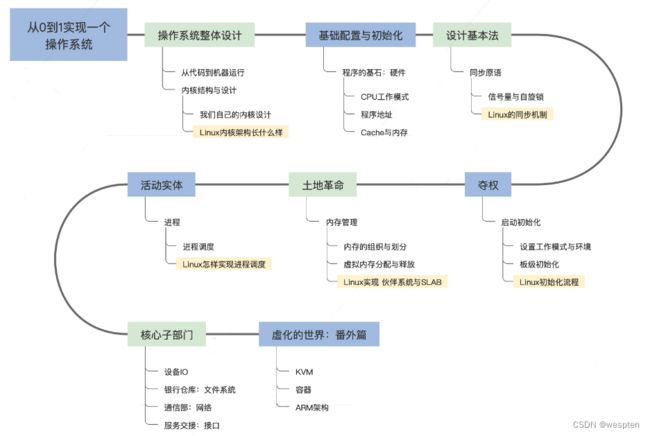

2、自己编写一个操作系统

跟各种应用程序一样,内核也是一种应用程序,只不过,这种应用程序是直接操作硬件的。内核直接面对的是硬件,调用的是硬件接口,是通过个硬件厂商和CPU厂商提供的指令集进行开发。开发应用程序则面对的是内核,系统调用,或库调用进行的,故简单得多。

为编写内核级的应用程序,又为了避免过于底层,固有很多库文件,可以让内核编译时使用。

内核是直接面向硬件的,故可用资源权限很大,但内核是工作在有限地址空间内的,就linux而言,32位系统上,线性地址空间中,内核只认为自己有1G的,虽然可以掌握4G,但是自己的运行只能使用1G,剩下的3G给其他应用程序。win是各2G。故我们开发内核时可用的内存空间很有限,尤其是开发驱动,要明白自己的可用空间很有限,故需高效。

内核的架构也非常清晰,从硬件层,硬件抽象层,内核基础模块(进程调度,内存管理,网络协议栈等)到应用层,这个基本上也是各类软硬件结合的系统架构的基础设计,例如物联网系统(从单片机,MCU等小型嵌入式系统,到智能家居,智慧社区甚至智慧城市)在接入端设备的可参考架构模型。

Linux最初是运行在PC机上的,使用的x86架构处理器相对来说比较强大,各类指令和模式也比较齐全。例如我们看到的用户态和内核态,在一般的小型嵌入式处理器上是没有的,它的好处是通过将代码和数据段(segment)给予不同的权限,保护内核态的代码和数据(包括硬件资源)必须通过类似系统调用(SysCall)的方式才能访问,确保内核的稳定。

编写操作系统的流程:

想象一下,如果需要你写一个操作系统,有哪些因素需要考虑?

进程管理:如何在多任务系统中按照调度算法分配CPU的时间片。

内存管理:如何实现虚拟内存和物理内存的映射,分配和回收内存。

文件系统:如何将硬盘的扇区组织成文件系统,实现文件的读写等操作。

设备管理:如何寻址,访问,读,写设备配置信息和数据。

进程管理

进程在不同的操作系统中有些称为process,有些称为task。操作系统中进程数据结构包含了很多元素,往往用链表连接。

进程相关的内容主要包括:虚拟地址空间,优先级,生命周期(阻塞,就绪,运行等),占有的资源(例如信号量,文件等)。

CPU在每个系统滴答(Tick)中断产生的时候检查就绪队列里面的进程(遍历链表中的进程结构体),如有符合调度算法的新进程需要切换,保存当前运行的进程的信息(包括栈信息等)后挂起当前进程,选择新的进程运行,这就是进程调度。

进程的优先级差异是CPU调度的基本依据,调度的终极目标是让高优先级的活动能够即时得到CPU的计算资源(即时响应),低优先级的任务也能公平分配到CPU资源。因为需要保存进程运行的上下文(process context)等,进程的切换本身是有成本的,调度算法在进程切换频率上也需要考虑效率。

在早期的Linux操作系统中,主要采用的是时间片轮转算法(Round-Robin),内核在就绪的进程队列中选择高优先级的进程运行,每次运行相等的时间。该算法简单直观,但仍然会导致某些低优先级的进程长时间无法得到调度。为了提高调度的公平性,在Linux 2.6.23之后,引入了称为完全公平调度器CFS(Completely Fair Scheduler)。

CPU在任何时间点只能运行一个程序,用户在使用优酷APP看视频时,同时在微信中打字聊天,优酷和微信是两个不同的程序,为什么看起来像是在同时运行?CFS的目标就是让所有的程序看起来都是以相同的速度在多个并行的CPU上运行,即nr_running 个运行的进程,每个进程以1/nr_running的速度并发执行,例如如有2个可运行的任务,那么每个以50%的CPU物理能力并发执行。

CFS引入了"虚拟运行时间"的概念,虚拟运行时间用p->se.vruntime (nanosec-unit) 表示,通过它记录和度量任务应该获得的"CPU时间"。在理想的调度情况下,任何时候所有的任务都应该有相同的p->se.vruntime值(上面提到的以相同的速度运行)。因为每个任务都是并发执行的,没有任务会超过理想状态下应该占有的CPU时间。CFS选择需要运行的任务的逻辑基于p->se.vruntime值,非常简单:它总是挑选p->se.vruntime值最小的任务运行(最少被调度到的任务)。

CFS使用了基于时间排序的红黑树来为将来任务的执行排时间线。所有的任务按p->se.vruntime关键字排序。CFS从树中选择最左边的任务执行。随着系统运行,执行过的任务会被放到树的右边,逐步地地让每个任务都有机会成为最左边的任务,从而在一个可确定的时间内获得CPU资源。

总结来说,CFS首先运行一个任务,当任务切换(或者Tick中断发生的时候)时,该任务使用的CPU时间会加到p->se.vruntime里,当p->se.vruntime的值逐渐增大到别的任务变成了红黑树最左边的任务时(同时在该任务和最左边任务间增加一个小的粒度距离,防止过度切换任务,影响性能),最左边的任务被选中执行,当前的任务被抢占。

CFS红黑树

一般来说,调度器处理单个任务,且尽可能为每个任务提供公平的CPU时间。某些时候,可能需要将任务分组,并为每个组提供公平的CPU时间。例如,系统可以为每个用户分配平均的CPU时间后,再为每个用户的每个任务分配平均的CPU时间。

内存管理

内存本身是一个外部存储设备,系统需要对内存区域寻址,找到对应的内存单元(memory cell),读写其中的数据。

内存区域通过指针寻址,CPU的字节长度(32bit机器,64bit机器)决定了最大的可寻址地址空间。在32位机器上最大的寻址空间是4GBtyes。在64位机器上理论上有2^64Bytes。

最大的地址空间和实际系统有多少物理内存无关,所以称为虚拟地址空间。对系统中所有的进程来说,看起来每个进程都独立占有这个地址空间,且它无法感知其它进程的内存空间。事实上操作系统让应用程序无需关注其它应用程序,看起来每个任务都是这个电脑上运行的唯一进程。

Linux将虚拟地址空间分为内核空间和用户空间。每个用户进程的虚拟空间范围从0到TASK_SIZE。从TASK_SIZE到2^32或2^64的区域保留给内核,不能被用户进程访问。TASK_SIZE可以配置,Linux系统默认配置3:1,应用程序使用3GB的空间,内核使用1GB的空间,这个划分并不依赖实际RAM的大小。在64位机器上,虚拟地址空间的范围可以非常大,但实际上只使用其中42位或47位(2^42 或 2^47)。

虚拟地址空间

绝大多数情况下,虚拟地址空间比实际系统可用的物理内存(RAM)大,内核和CPU必须考虑如何将实际可用的物理内存映射到虚拟地址空间。

一个方法是通过页表(Page Table)将虚拟地址映射到物理地址。虚拟地址与进程使用的用户&内核地址相关,物理地址用来寻址实际使用的RAM。

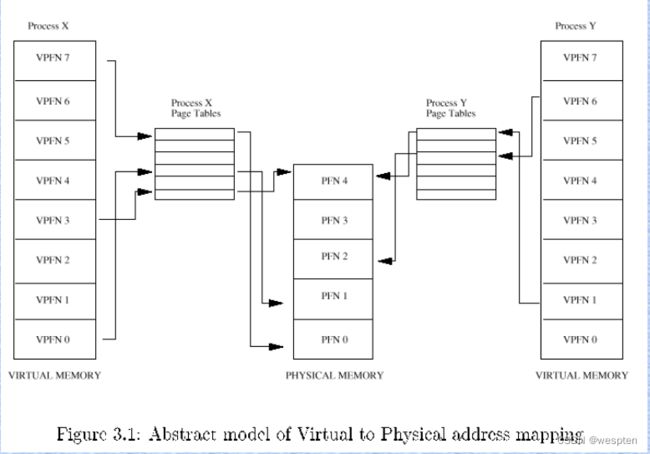

如下图所示,进程A和B的虚拟地址空间被分为大小相等的部分,称为页(page)。物理内存同样被分割为大小相等的页(page frame)。

![]()

虚拟和物理地址空间映射

进程A第1个内存页映射到物理内存(RAM)的第4页;进程B第1个内存页映射到物理内存第5页。进程A第5个内存页和进程B第1个内存页都映射到物理内存的第5页(内核可决定哪些内存空间被不同进程共享)。

如图所示,并不是每个虚拟地址空间的页都与某个page frame关联,该页可能并未使用或者数据还没有被加载到物理内存(暂时不需要),也可能因为物理内存页被置换到了硬盘上,后续实际再需要的时候再被置换回内存。

页表(page table)将虚拟地址空间映射到物理地址空间。最简单的做法是用一个数组将虚拟页和物理页一一对应,但是这样做可能需要消耗整个RAM本身来保存这个页表,假设每个页大小为4KB,虚拟地址空间大小为4GB,需要一个1百万个元素的数组来保存页表。

因为虚拟地址空间的绝大多数区域实际并没有使用,这些页实际并没有和page frame关联,引入多级页表(multilevel paging)能极大降低页表使用的内存,提高查询效率。关于多级也表的细节描述可以参考xxx。

内存映射(memory mapping)是一个重要的抽象方法,被运用在内核和用户应用程序等多个地方。映射是将来自某个数据源的数据(也可以是某个设备的I/O端口等)转移到某个进程的虚拟内存空间。对映射的地址空间的操作可以使用处理普通内存的方法(对地址内容直接进行读写)。任何对内存的改动会自动转移到原数据源,例如将某个文件的内容映射到内存中,只需要通过读该内存来获取文件的内容,通过将改动写到该内存来修改文件的内容,内核确保任何改动都会自动体现到文件里。

另外,在内核中,实现设备驱动时,外设(外部设备)的输入和输出区域可以被映射到虚拟地址空间,读写这些空间会被系统重定向到设备,从而对设备进行操作,极大地简化了驱动的实现。

内核必须跟踪哪些物理页已经被分配了,哪些还是空闲的,避免两个进程使用RAM中的同一个区域。内存的分配和释放是非常频繁的任务,内核必须确保完成的速度尽量快,内核只能分配整个page frame,它将内存分为更小的部分的任务交给了用户空间,用户空间的程序库可以将从内核收到的page frame分成更小的区域后分配给进程。

虚拟文件系统

Unix系统是建立在一些有见地的理念上的,一个非常重要的隐喻是:

Everything is a file.

即系统几乎所有的资源都可以看成是文件。为了支持不同的本地文件系统,内核在用户进程和文件系统实现间包含了一层虚拟文件系统(Virtual File System)。大多数的内核提供的函数都能通过VFS(Virtual File System)定义的文件接口访问。例如内核子系统:字符和块设备,管道,网络Socket,交互输入输出终端等。

另外用于操作字符和块设备的设备文件是在/dev目录下的真实文件,当读写操作执行的时候,其的内容会被对应的设备驱动动态创建。

VFS系统

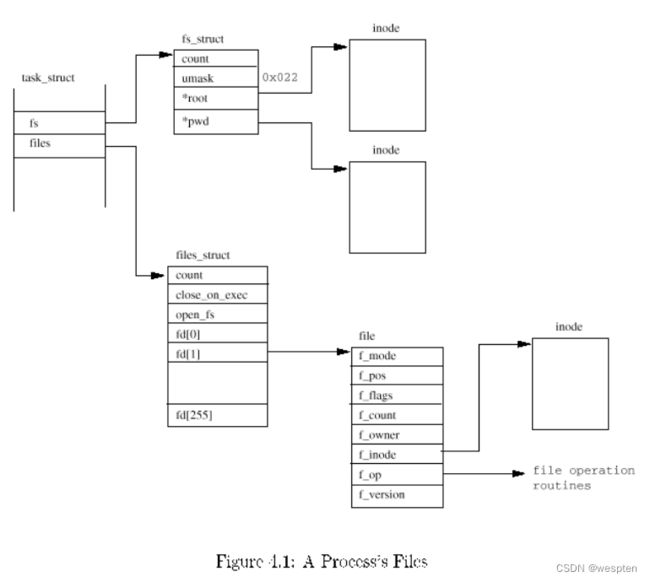

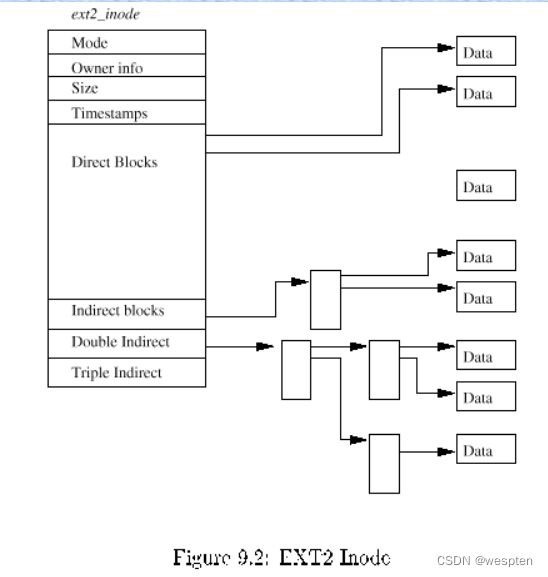

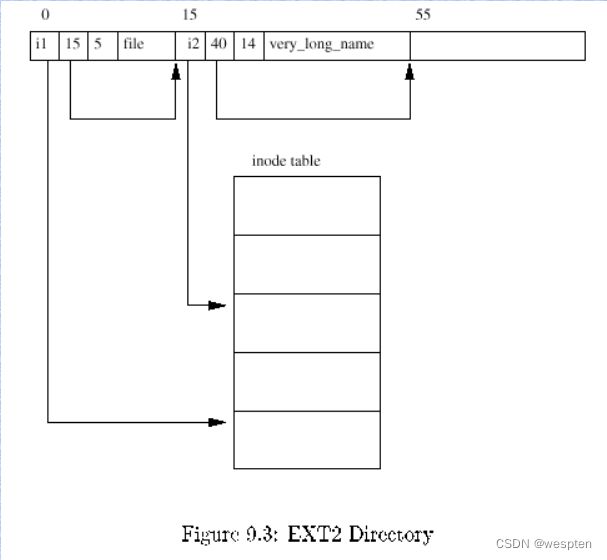

在虚拟文件系统中,inode用来表示文件和文件目录(对于系统来说,目录是一种特殊的文件)。inode的元素包含两类:1. Metadata用于描述文件的状态,例如读写权限。2. 用于保存文件内容的数据段。

每个inode都有一个特别的号码用于唯一识别,文件名和inode的关联建立在该编号基础上。以内核查找/usr/bin/emacs为例,讲解inodes如何组成文件系统的目录结构。从根inode开始查找(即根目录‘/’),该目录使用一个inode表示,inode的数据段没有普通的数据,只包含了根目录存的一些文件/目录项,这些项可以表示文件或其它目录,每项包含两个部分:1. 下一个数据项所在的inode编号 2. 文件或目录名

首先扫描根inode的数据区域直到找到一个名为‘usr’的项,查找子目录usr的inode。通过‘usr’ inode编号找到关联的inode。重复以上步骤,查找名为‘bin’的数据项,然后在其数据项的‘bin’对应的inode中搜索名字‘emacs’的数据项,最后返回的inode表示一个文件而不是一个目录。最后一个inode的文件内容不同于之前,前三个每个都表示了一个目录,包含了它的子目录和文件清单,和emacs文件关联的inode在它的数据段保存了文件的实际内容。

尽管在VFS查找某个文件的步骤和上面的描述一样,但细节上还是有些差别。例如因为频繁打开文件是一个很慢的操作,引入缓存加速查找。

通过inode机制查找某个文件:

设备驱动

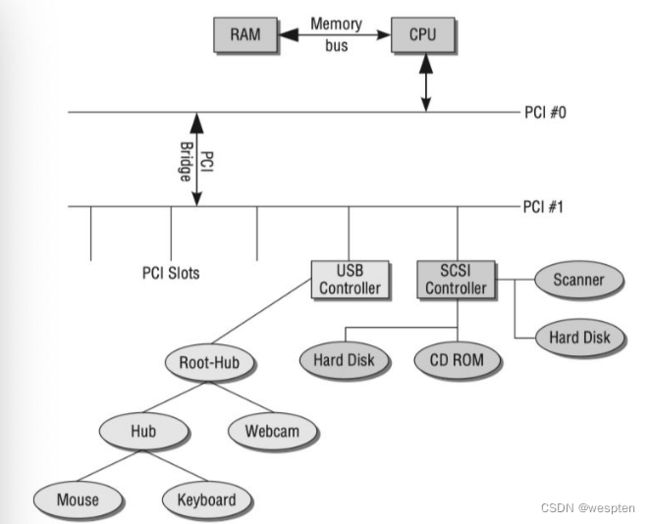

与外设通信往往指的是输入(input)和输出(output)操作,简称I/O。实现外设的I/O内核必须处理三个任务:第一,必须针对不同的设备类型采用不同的方法来寻址硬件。第二,内核必须为用户应用程序和系统工具提供操作不同设备的方法,且需要使用一个统一的机制来确保尽量有限的编程工作,和保证即使硬件方法不同应用程序也能互相交互。第三,用户空间需要知道在内核中有哪些设备。

与外设通信的层级关系如下:

设备通信层级图

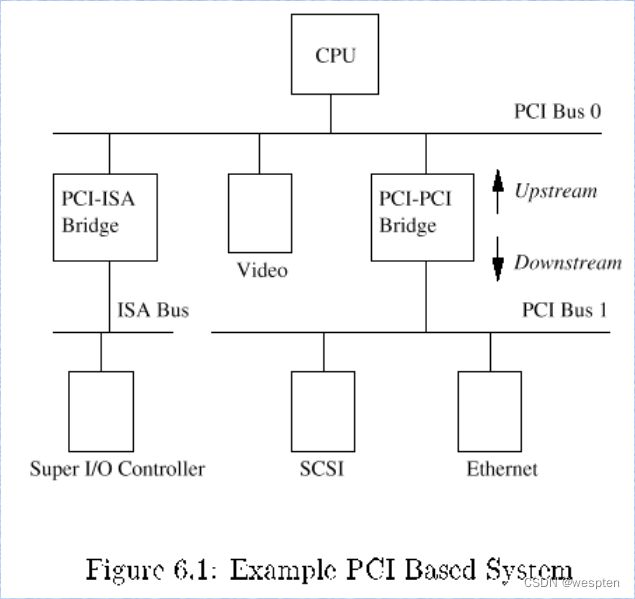

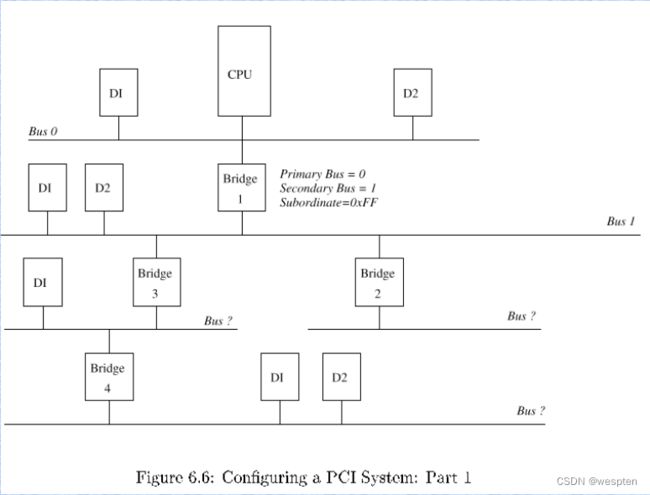

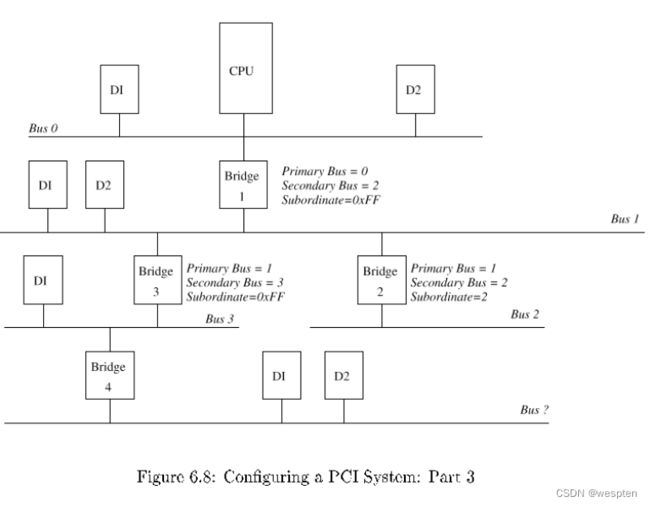

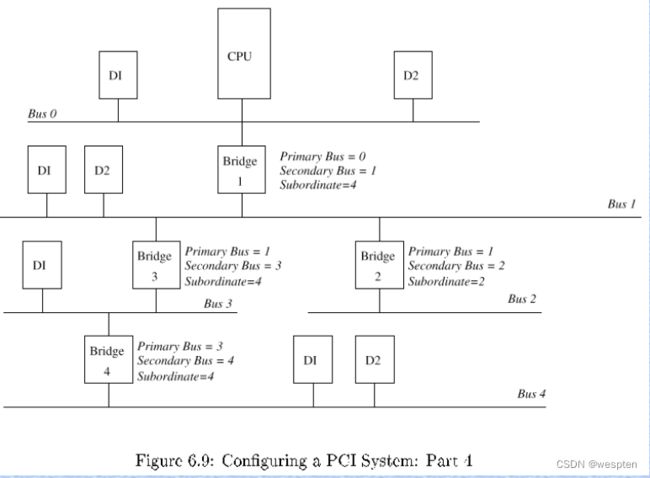

外部设备大多通过总线与CPU连接,系统往往不止一个总线,而是总线的集合。在很多PC设计中包含两个通过一个bridge相连的PCI总线。某些总线例如USB不能当作主总线使用,需要通过一个系统总线将数据传递给处理器。下图显示不同的总线是如何连接到系统的。

系统总线拓扑图

系统与外设交互主要有以下方式:

I/O端口:使用I/O端口通信的情况下,内核通过一个I/O控制器发送数据,每个接收设备有唯一的端口号,且将数据转发给系统附着的硬件。有一个由处理器管理的单独的虚拟地址空间用来管理所有的I/O地址。

I/O地址空间并不总是和普通的系统内存关联,考虑到端口能够映射到内存中,这往往不好理解。

端口有不同的类型。一些是只读的,一些是只写的,一般情况下它们是可以双向操作的,数据能够在处理器和外设间双向交换。

在IA-32架构体系中,端口的地址空间包含了2^16个不同的8位地址,这些地址可以通过从0x0到0xFFFFH间的数唯一识别。每个端口都有一个设备分配给它,或者空闲没有使用,多个外设不能共享一个端口。很多情况下,交换数据使用8位是不够用的,基于这个原因,可以将两个连续的8位端口绑定为一个16位的端口。两个连续的16位端口能够被当作一个32位的端口,处理器可以通过组装语句来做输入输出操作。

不同处理器类型在实现操作端口时有所不同,内核必须提供一个合适的抽象层,例如outb(写一个字节),outw(写一个字)和inb(读一个字节)这些命令可以用来操作端口。

I/O内存映射:必须能够像访问RAM内存一样寻址许多设备。因此处理器提供了将外设对应的I/O端口映射到内存中,这样就能像操作普通内存一样操作设备了。例如显卡使用这样的机制,PCI也往往通过映射的I/O地址寻址。

为了实现内存映射,I/O端口必须首先被映射到普通系统内存中(使用处理器特有的函数)。因为平台间的实现方式差异比较大,所以内核提供了一个抽象层来映射和去映射I/O区域。

除了如何访问外设,什么时候系统会知道是否外设有数据可以访问?主要通过两种方式:轮询和中断。

轮询周期性地访问查询设备是否有准备好的数据,如果有,便获取数据。这种方法需要处理器在设备没有数据的情况下也不断去访问设备,浪费了CPU时间片。

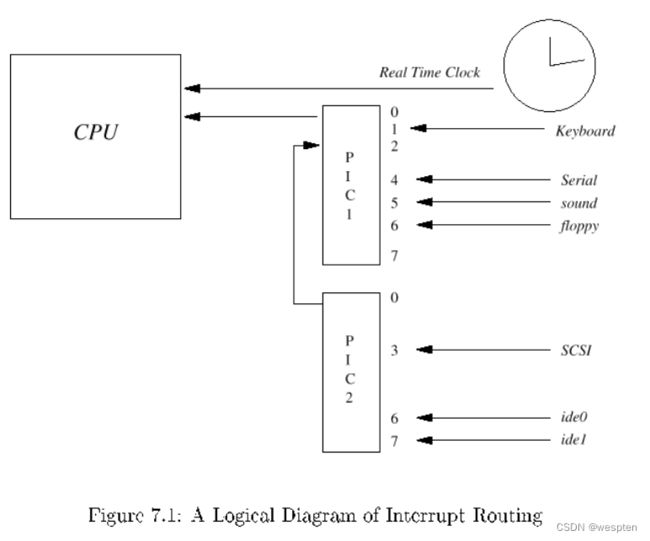

另一种方式是中断,它的理念是外设把某件事情做完了后,主动通知CPU,中断的优先级最高,会中断CPU的当前进程运行。每个CPU都提供了中断线(可被不同的设备共享),每个中断由唯一的中断号识别,内核为每个使用的中断提供一个服务方法(ISR,Interrupt Service Routine,即中断发生后,CPU调用的处理函数),中断本身也可以设置优先级。

中断会挂起普通的系统工作。当有数据已准备好可以给内核或者间接被一个应用程序使用的时候,外设出发一个中断。使用中断确保系统只有在外设需要处理器介入的时候才会通知处理器,有效提高了效率。

通过总线控制设备:不是所有的设备都是直接通过I/O语句寻址操作的,很多情况下是通过某个总线系统。

不是所有的设备类型都能直接挂接在所有的总线系统上,例如硬盘挂到SCSI接口上,但显卡不可以(显卡可以挂到PCI总线上)。硬盘必须通过IDE间接挂到PCI总线上。

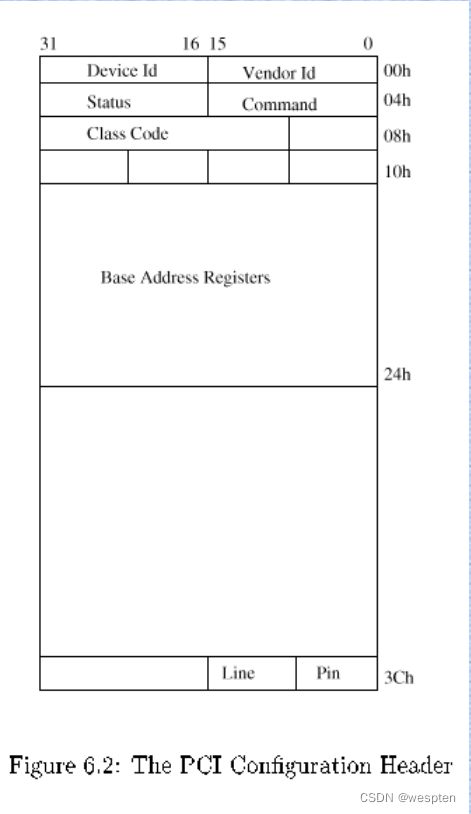

总线类型可分为系统总线和扩展总线。硬件上的实现差别对内核来说并不重要,只有总线和它附着的外设如何被寻址才相关。对于系统总线来说,例如PCI总线,I/O语句和内存映射用来与总线通信,也用于和它附着的设备通信。内核还提供了一些命令供设备驱动来调用总线函数,例如访问可用的设备列表,使用统一的格式读写配置信息。

扩展总线例如USB,SCSI通过清晰定义的总线协议与附着的设备来交换数据和命令。内核通过I/O语句或内存映射来与总线通信,通过平台无关的函数来使总线与附着的设备通信。

与总线附着的设备通信不一定需要通过在内核空间的驱动进行,在某些情况下也可以通过用户空间实现。一个主要的例子是SCSI Writer,通过cdrecord工具来寻址。这个工具产生所需要的SCSI命令,在内核的帮助下通过SCSI总线将命令发送到对应的设备,处理和回复设备产生或返回的信息。

块设备(block)和字符设备(character)在3个方面显著不同:

块设备中的数据能够在任何点操作,而字符设备不能也没这个要求。

块设备数据传输的时候总是使用固定大小的块。即使只请求一个字节的情况下,设备驱动也总是从设备获取一个完整的块。相反,字符设备能够返回单个字节。

读写块设备会使用缓存。读操作方面,数据缓存在内存中,能够在需要的时候重新访问。写操作方面,也会被缓存,延时写入设备。使用缓存对于字符设备(例如键盘)来说不合理,每个读请求都必须被可靠地交互到设备。

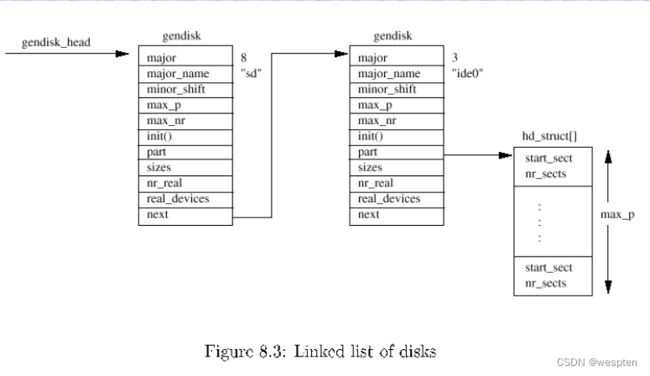

块和扇区的概念:块是一个指定大小的字节序列,用于保存在内核和设备间传输的数据,块的大小可以被设置。扇区是固定大小的,能被设备传输的最小的数据量。块是一段连续的扇区,块大小是扇区的整数倍。

网络

Linux的网络子系统为互联网的发展提供了坚实的基础。网络模型基于ISO的OSI模型,如下图右半部分。但在具体应用中,往往会把相应层级结合以简化模型,下图左半部分为Linux运用的TCP/IP参考模型。(由于介绍Linux网络部分的资料比较多,在本文中只对大的层级简单介绍,不展开说明。)

Host-to-host层(Physical Layer和Data link layer,即物理层和数据链路层)负责将数据从一个计算机传输到另一台计算机。这一层处理物理传输介质的电气和编解码属性,也将数据流拆分成固定大小的数据帧用于传输。如多个电脑共享一个传输路线,网络适配器(网卡等)必须有一个唯一的ID(即MAC地址)来区分。从内核的角度,这一层是通过网卡的设备驱动实现的。

OSI模型的网络层在TCP/IP模型中称为网络层,网络层使网络中的计算机之间能交换数据,而这些计算机不一定是直接相连的。

如果物理上并没有直接相连,所以也没有直接的数据交换。网络层的任务是为网络中各机器之间通信找到路由。

网络连接的电脑

网络层也负责将要传输的包分成指定的大小,因为包在传输路径上每个电脑支持的最大的数据包大小可能不一样,在传输时,数据流被分割成不同的包,在接收端再被组合。

网络层为网络中的电脑分配了唯一的网络地址以便他们能互相通信(不同于硬件的MAC地址,因为网络往往由子网络组成)。在互联网中,网络层由IP网络组成,有V4和V6版本。

传输层的任务是规范在两个连接的电脑上运行的应用程序之间的数据传输。例如两台电脑上的客户端和服务端程序,包括TCP或UDP连接,通过端口号来识别通信的应用程序。例如端口号80用于web server,浏览器的客户端必须将请求发送到这个端口来获取需要的数据。而客户端也需要有一个唯一的端口号以便web server能将回复发送给它。

这一层还负责为数据的传输提供一个可靠的连接(TCP情况下)。

TCP/IP模型中的应用层在OSI模型中包含(session层,展现层,应用层)。当通信连接在两个应用之间建立起来后,这一层负责实际内容的传输。例如web server与它的客户端传输时的协议和数据,不同与mail server与它的客户端之间。

大多数的网络协议在RFC(Request for Comments)中定义。

网络实现分层模型:内核对网络层的实现类似TCP/IP参考模型。它是通过C代码实现的,每个层只能和它的上下层通信,这样的好处是可以将不同的协议和传输机制结合。如下图所示:

四、Linux内核模块详解

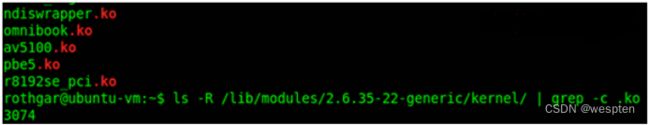

内核并不神奇,但对于任何正常运行的计算机来说,它都是必不可少的。Linux内核不同于OS X和Windows,因为它包含内核级别的驱动程序,并使许多东西“开箱即用”。

如果Windows已经安装了所有可用的驱动程序,而您只需要打开所需的驱动程序怎么办?这本质上就是内核模块为Linux所做的。内核模块,也称为可加载内核模块(LKM),对于保持内核在不消耗所有可用内存的情况下与所有硬件一起工作是必不可少的。

模块通常向基本内核添加设备、文件系统和系统调用等功能。lkm的文件扩展名是.ko,通常存储在/lib/modules目录中。由于模块的特性,您可以通过在启动时使用menuconfig命令将模块设置为load或not load,或者通过编辑/boot/config文件,或者使用modprobe命令动态地加载和卸载模块,轻松定制内核。

第三方和封闭源码模块在一些发行版中是可用的,比如Ubuntu,默认情况下可能无法安装,因为这些模块的源代码是不可用的。该软件的开发人员(即nVidia、ATI等)不提供源代码,而是构建自己的模块并编译所需的.ko文件以便分发。虽然这些模块像beer一样是免费的,但它们不像speech那样是免费的,因此不包括在一些发行版中,因为维护人员认为它通过提供非免费软件“污染”了内核。

使用模块的优点:

1. 使得内核更加紧凑和灵活

2. 修改内核时,不必全部重新编译整个内核,可节省不少时间,避免人工操作的错误。系统中如果 需要使用新模块,只要编译相应的模块然后使用特定用户空间的程序将模块插入即可。

3.模块可以不依赖于某个固定的硬件平台。

4. 模块的目标代码一旦被链接到内核,它的作用和静态链接的内核目标代码完全等价。 所以,当调用模块的函数时,无须显式的消息传递。

但是,内核模块的引入也带来一定的问题:

1. 由于内核所占用的内存是不会被换出的,所以链接进内核的模块会给整个系统带来一定的性能和内存利用方面的损失。

2. 装入内核的模块就成为内核的一部分,可以修改内核中的其他部分,因此,模块的使用不当会导致系统崩溃。

3. 为了让内核模块能访问所有内核资源,内核必须维护符号表,并在装入和卸载模块时修改符号表。

4. 模块会要求利用其它模块的功能,所以,内核要维护模块之间的依赖性。

模块是和内核在同样的地址空间运行的,模块编程在一定意义上说也就是内核编程。但是并不是内核中所有的地方都可以使用模块。 一般是在设备驱动程序、文件系统等地方使用模块,而对Linux内核中极为重要的地方,如进程管理和内存管理等,仍难以通过模块来实现,通常必须直接对内核进行修改。

在Linux内核源程序中,经常利用内核模块实现的功能,有文件系统,SCSI高级驱动程序,大多数的SCSI驱动程序,多数CD-ROM驱动程序,以太网驱动程序等等。

1、编译安装Linux内核

Linux内核的组成部分:

-

kernel:内核核心,一般为bzImage,通常在/boot目录

vmlinuz-VERSION-RELEASE -

kernel object:内核对象,一般放置于

/lib/modules/VERSION-RELEASE/ -

辅助文件:ramdisk

initrd-VERSION-RELEASE.img:从CentOS 5 版本以前 initramfs-VERSION-RELEASE.img:从CentOS6 版本以后

内核版本查看:

uname -r

-r 显示VERSION-RELEASE

-n 打印网络节点主机名

-a 打印所有信息内核模块命令

系统调用当然是将内核模块插入到内核的可行方法。但是毕竟太底层了。此外,Linux环境里还有两种方法可达到此目的。一种方法稍微自动一些,可以做到需要时自动装入,不需要时自动卸载。这种方法需要执行modprobe程序。

另一种是用insmod命令,手工装入内核模块。在前面分析helloworld例子的时候,我们提到过insmod的作用就是将需要插入的模块以目标代码的形式插入到内核中。注意,只有超级用户才能使用这个命令。

Linux内核模块机制提供的系统调用大多数都是为modutils程序使用的。可以说,是Linux的内核模块机制和modutils两者的结合提供了模块的编程接口。modutils(modutils-x.y.z.tar.gz)可以在任何获得内核源代码的地方获得, 选择最高级别的patchlevel x.y.z等于或者小于当前的内核版本,安装后在/sbin目录下就会有insmod、rmmod、ksyms、lsmod、modprobe等等实用程序。当然,通常我们在加载Linux内核的时候,modutils已经被装入了。

lsmod命令:

- 显示由核心已经装载的内核模块

- 显示的内容来自于: /proc/modules文件

实际上这个程序的功能就是读取/proc文件系统中的文件/proc/modules中的信息。所以这个命令和cat /proc/modules等价。它的格式就是:

[root@centos8 ~]#lsmod

Module Size Used by

uas 28672 0

usb_storage 73728 1 uas

nls_utf8 16384 0

isofs 45056 0 #显示:名称、大小,使用次数,被哪些模块依赖ksyms命令:

显示内核符号和模块符号表的信息,可以读取/proc/kallsyms文件。

modinfo命令:

功能:管理内核模块

配置文件:

/etc/modprobe.conf, /etc/modprobe.d/*.conf- 显示模块的详细描述信息

modinfo [ -k kernel ] [ modulename|filename... ]常用选项:

-n:只显示模块文件路径

-p:显示模块参数

-a:作者

-d:描述案例:

lsmod |grep xfs

modinfo xfsinsmod命令:

指定模块文件,不自动解决依赖模块。将模块插入Linux内核的简单程序。

语法:

insmod [ filename ] [ module options... ]案例:

insmod

modinfo –n exportfs

lnsmod

modinfo –n xfsinsmod其实是一个modutils模块实用程序,当我们以超级用户的身份使用这个命令的时候,这个程序完成下面一系列工作:

1. 从命令行中读入要链接的模块名,通常是扩展名为“.ko”,elf格式的目标文件。

2. 确定模块对象代码所在文件的位置。通常这个文件都是在lib/modules的某个子目录中。

3. 计算存放模块代码、模块名和module对象所需要的内存大小。

4. 在用户空间中分配一个内存区,把module对象、模块名以及为正在运行的内核所重定位的模块代码拷贝到这个内存里。其中,module对象中的init域指向这个模块的入口函数重新分配到的地址;exit域指向出口函数所重新分配的地址。

5. 调用init_module(),向它传递上面所创建的用户态的内存区的地址,其实现过程我们已经详细分析过了。

6. 释放用户态内存, 整个过程结束。

modprobe命令:

- 在Linux内核中添加和删除模块

modprobe [ -C config-file ] [ modulename ] [ module parame-ters... ] modprobe [ -r ] modulename…常用选项:

-C:使用文件

-r:删除模块用法:

装载:modprobe 模块名

卸载: modprobe -r 模块名 # rmmod命令:卸载模块modprobe是由modutils提供的根据模块之间的依赖性自动插入模块的程序。前面讲到的按需装入的模块加载方法会调用这个程序来实现按需装入的功能。举例来讲,如果模块A依赖模块B,而模块B并没有加载到内核里,当系统请求加载模块A时,modprobe程序会自动将模块B加载到内核。

与insmod类似,modprobe程序也是链接在命令行中指定的一个模块,但它还可以递归地链接指定模块所引用到的其他模块。从实现上讲,modprobe只是检查模块依赖关系,真正的加载的工作还是由insmod来实现的。那么,它又是怎么知道模块间的依赖关系的呢? 简单的讲,modprobe通过另一个modutils程序depmod来了解这种依赖关系。而depmod是通过查找内核中所有的模块并把它们之间的依赖关系写入/lib/modules/2.6.15-1.2054_FC5目录下,一个名为modules.dep的文件。

kmod命令:

在以前版本的内核中,模块机制的自动装入通过一个用户进程kerneld来实现,内核通过IPC和内核通信,向kerneld发送需要装载的模块的信息,然后kerneld调用modprobe程序将这个模块装载。 但是在最近版本的内核中,使用另外一种方法kmod来实现这个功能。kmod与kerneld比较,最大的不同在于它是一个运行在内核空间的进程,它可以在内核空间直接调用modprobe,大大简化了整个流程。

depmod命令:

内核模块依赖关系文件及系统信息映射文件的生成工具,生成模块.dep和map文件。

rmmod命令:

卸载模块,从Linux内核中删除模块的简单程序。

rmmod程序将已经插入内核的模块从内核中移出,rmmod会自动运行在内核模块自己定义的出口函数。它的格式是:

rmmod xfs

rmmod exportfs当然,它最终还是通过delete_module()系统调用实现的。

编译内核

编译安装内核准备:

(1) 准备好开发环境;

(2) 获取目标主机上硬件设备的相关信息;

(3) 获取目标主机系统功能的相关信息,例如:需要启用相应的文件系统;

(4) 获取内核源代码包,www.kernel.org;

编译准备

目标主机硬件设备相关信息

CPU:

cat /proc/cpuinfo

x86info -a

lscpuPCI设备:lspci -v ,-vv:

[root@centos8 ~]#lspci

00:00.0 Host bridge: Intel Corporation 440BX/ZX/DX - 82443BX/ZX/DX Host bridge (rev 01)

00:01.0 PCI bridge: Intel Corporation 440BX/ZX/DX - 82443BX/ZX/DX AGP bridge (rev 01)

00:07.0 ISA bridge: Intel Corporation 82371AB/EB/MB PIIX4 ISA (rev 08)

00:07.1 IDE interface: Intel Corporation 82371AB/EB/MB PIIX4 IDE (rev 01)

00:07.3 Bridge: Intel Corporation 82371AB/EB/MB PIIX4 ACPI (rev 08)

00:07.7 System peripheral: VMware Virtual Machine Communication Interface (rev 10)

00:0f.0 VGA compatible controller: VMware SVGA II Adapter

00:10.0 SCSI storage controller: Broadcom / LSI 53c1030 PCI-X Fusion-MPT Dual Ultra320 SCSI (rev 01)

00:11.0 PCI bridge: VMware PCI bridge (rev 02)

00:15.0 PCI bridge: VMware PCI Express Root Port (rev 01)

00:15.1 PCI bridge: VMware PCI Express Root Port (rev 01)USB设备:lsusb -v,-vv:

[root@centos8 ~]#dnf install usbutils -y

[root@centos8 ~]#lsusb

Bus 001 Device 004: ID 0951:1666 Kingston Technology DataTraveler 100 G3/G4/SE9 G2

Bus 001 Device 001: ID 1d6b:0002 Linux Foundation 2.0 root hub

Bus 002 Device 003: ID 0e0f:0002 VMware, Inc. Virtual USB Hub

Bus 002 Device 002: ID 0e0f:0003 VMware, Inc. Virtual Mouse

Bus 002 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub

[root@centos8 ~]#lsmod |grep usb

usb_storage 73728 1 uaslsblk 块设备

全部硬件设备信息:hal-device:CentOS 6

开发环境相关包

gcc make ncurses-devel flex bison openssl-devel elfutils-libelf-devel- 下载源码文件

- 准备文本配置文件/boot/.config

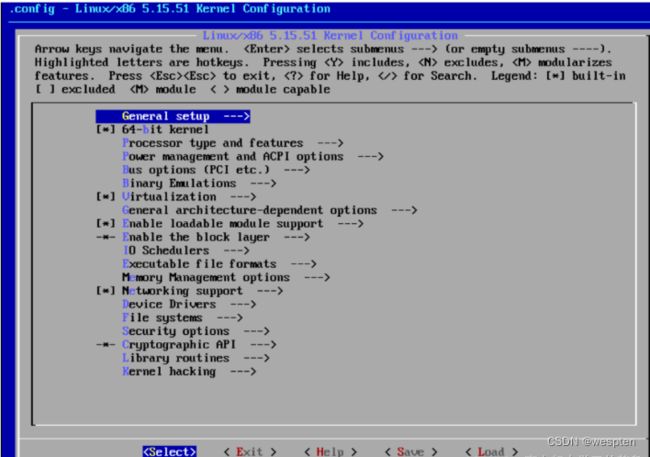

- make menuconfig:配置内核选项

- make [-j #] 或者用以下两步实现:

make -j # bzImage make -j # modules - 安装模块:make modules_install

- 安装内核相关文件:make install

- 安装bzImage为 /boot/vmlinuz-VERSION-RELEASE

- 生成initramfs文件

- 编辑grub的配置文件

编译安装内核实战案例:

[root@centos7 ~]#yum -y install gcc gcc-c++ make ncurses-devel flex bison openssl-devel elfutils-libelf-devel

[root@centos7 ~]#tar xvf linux-5.15.51.tar.xz -C /usr/local/src

[root@centos7 ~]#cd /usr/local/src

[root@centos7 src]#ls

linux-5.15.51

[root@centos7 src]#du -sh *

1.2G linux-5.15.51

[root@centos7 src]#cd linux-5.15.51/

[root@centos7 linux-5.15.51]#ls

arch COPYING Documentation include Kbuild lib Makefile README security usr

block CREDITS drivers init Kconfig LICENSES mm samples sound virt

certs crypto fs ipc kernel MAINTAINERS net scripts tools

[root@centos7 linux-5.15.51]#cp /boot/config-3.10.0-1160.el7.x86_64 .config

[root@centos7 linux-5.15.51]#vim .config

#修改下面三行

#CONFIG_MODULE_SIG=y #注释此行

CONFIG_SYSTEM_TRUSTED_KEYRING="" #修改此行

#CONFIG_DEBUG_INFO=y #linux-5.8.5版本后需要注释此行

#升级gcc版本,可以到清华的镜像站上下载相关的依赖包

#https://mirrors.tuna.tsinghua.edu.cn/gnu/gcc/gcc-9.1.0/

#https://mirrors.tuna.tsinghua.edu.cn/gnu/gmp/

#https://mirrors.tuna.tsinghua.edu.cn/gnu/mpc/

#https://mirrors.tuna.tsinghua.edu.cn/gnu/mpfr/

[root@centos7 linux-5.15.51]#cd ..

[root@centos7 src]#tar xvf gcc-9.1.0.tar.gz

[root@centos7 src]#tar xvf gmp-6.1.2.tar.bz2 -C gcc-9.1.0/

[root@centos7 src]#cd gcc-9.1.0/

[root@centos7 gcc-9.1.0]#mv gmp-6.1.2 gmp

[root@centos7 gcc-9.1.0]#cd ..

[root@centos7 src]#tar xvf mpc-1.1.0.tar.gz -C gcc-9.1.0/

[root@centos7 src]#cd gcc-9.1.0/

[root@centos7 gcc-9.1.0]#mv mpc-1.1.0 mpc

[root@centos7 gcc-9.1.0]#cd ..

[root@centos7 src]#tar xvf mpfr-4.0.2.tar.gz -C gcc-9.1.0/

[root@centos7 src]#cd gcc-9.1.0/

[root@centos7 gcc-9.1.0]#mv mpfr-4.0.2 mpfr

#编译安装gcc

[root@centos7 gcc-9.1.0]#./configure --prefix=/usr/local/ --enable-checking=release --disable-multilib --enable-languages=c,c++ --enable-bootstrap

[root@centos7 gcc-9.1.0]#make -j 2 #CPU核数要多加,不然编译会很慢

[root@centos7 gcc-9.1.0]#make install

[root@centos7 gcc-9.1.0]#cd ..

[root@centos7 src]#cd linux-5.15.51/

[root@centos7 linux-5.15.51]#make help

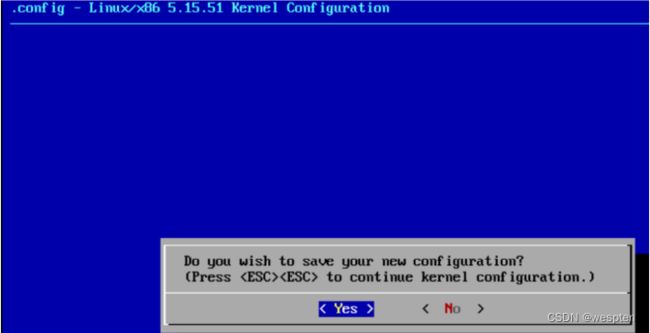

[root@centos7 linux-5.15.51]#make menuconfig

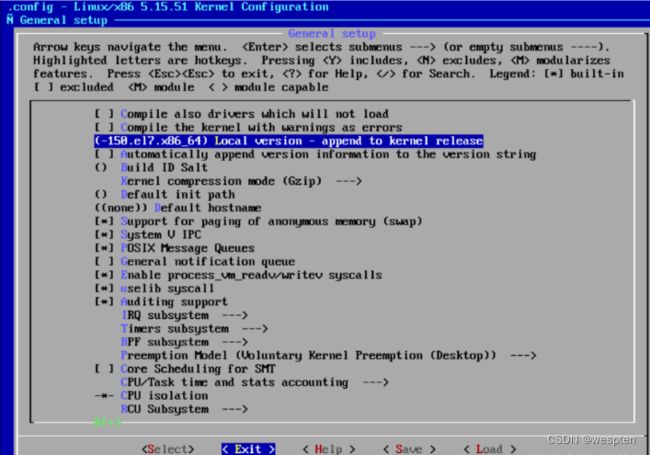

进入【常规设置】回车:

添加内核版本,回车:

输入自定义内核版本,回车:

按【Tab键】,选择【Exit】退出:

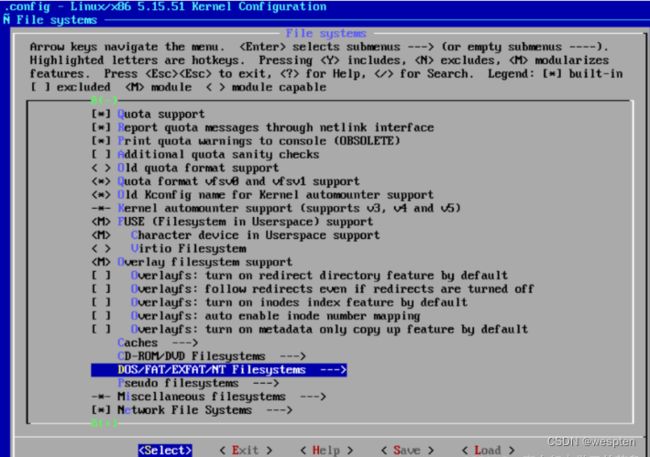

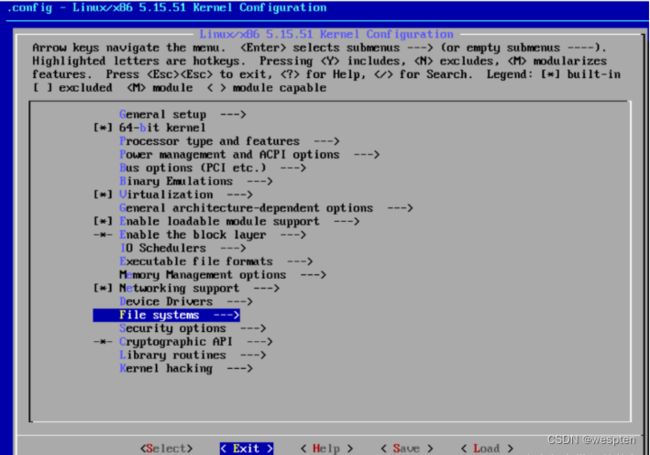

选择【文件系统】,回车:

选择【NT 文件系统】,回车:

选择【NTFS 文件系统】,按【空格键】,M表示模块化方式:

选择【支持调试和写】,按【空格键】选中,按【Tab键】,选择【Exit】,回车退出:

按【Tab键】,选择【Exit】,回车退出:

按【Tab键】,选择【Exit】,回车退出:

保存配置,回车:

[root@centos7 linux-5.15.51]#grep -i ntfs .config

CONFIG_NTFS_FS=m

CONFIG_NTFS_DEBUG=y

CONFIG_NTFS_RW=y

# CONFIG_NTFS3_FS is not set

[root@centos7 linux-5.15.51]#make -j 2 #CPU核数要多加,不然编译会很慢

[root@centos7 linux-5.15.51]#pwd

/usr/local/src/linux-5.15.51

[root@centos7 linux-5.15.51]#du -sh .

3.0G .

[root@centos7 linux-5.15.51]#make modules_install

[root@centos7 linux-5.15.51]#ls /lib/modules

3.10.0-1160.el7.x86_64 5.15.51-150.el7.x86_64

[root@centos7 linux-5.15.51]#du -sh /lib/modules/*

45M /lib/modules/3.10.0-1160.el7.x86_64

224M /lib/modules/5.15.51-150.el7.x86_64

[root@centos7 linux-5.15.51]#make install

[root@centos7 linux-5.15.51]#ls /boot/

config-3.10.0-1160.el7.x86_64 System.map

efi System.map-3.10.0-1160.el7.x86_64

grub System.map-5.15.51-150.el7.x86_64

grub2 vmlinuz

initramfs-0-rescue-afe373e8a26e45c681032325645782c8.img vmlinuz-0-rescue-afe373e8a26e45c681032325645782c8

initramfs-3.10.0-1160.el7.x86_64.img vmlinuz-3.10.0-1160.el7.x86_64

initramfs-5.15.51-150.el7.x86_64.img vmlinuz-5.15.51-150.el7.x86_64

symvers-3.10.0-1160.el7.x86_64.gz

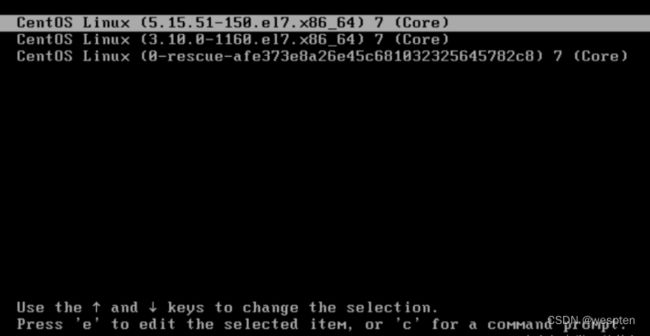

选择Linux5.15内核启动:

[root@centos7 linux-5.15.51]#reboot

[root@centos7 ~]#uname -r

5.15.51-150.el7.x86_64内核编译说明

配置内核选项:

支持“更新”模式进行配置,make help:

(a) make config:基于命令行以遍历的方式配置内核中可配置的每个选项

(b) make menuconfig:基于curses的文本窗口界面

(c) make gconfig:基于GTK (GNOME)环境窗口界面

(d) make xconfig:基于QT(KDE)环境的窗口界面

支持“全新配置”模式进行配置:

(a) make defconfig:基于内核为目标平台提供的“默认”配置进行配置

(b) make allyesconfig: 所有选项均回答为“yes“

(c) make allnoconfig: 所有选项均回答为“no“

编译内核

- 全编译:

make [-j #]- 编译内核的一部分功能:

(a) 只编译某子目录中的相关代码

cd /usr/src/linux

make dir/(b) 只编译一个特定的模块

cd /usr/src/linux

make dir/file.ko

只为e1000编译驱动:

make drivers/net/ethernet/intel/e1000/e1000.ko交叉编译内核

编译的目标平台与当前平台不相同:

make ARCH=arch_name要获取特定目标平台的使用帮助:

make ARCH=arch_name help重新编译需要事先清理操作:

make clean:清理大多数编译生成的文件,但会保留.config文件等

make mrproper: 清理所有编译生成的文件、config及某些备份文件

make distclean:包含 make mrproper,并清理patches以及编辑器备份文件卸载内核:

1. 删除/usr/src/linux/目录下不需要的内核源码;

2. 删除/lib/modules/目录下不需要的内核库文件;

3. 删除/boot目录下启动的内核和内核映像文件;

4. 更改grub的配置文件,删除不需要的内核启动列表 grub2-mkconfig -o /boot/grub2/grub.cfg

CentOS 8 还需要删除 /boot/loader/entries/5b85fc7444b240a992c42ce2a9f65db5-新内核版本.conf;

2、Linux内核模块的实现机制

在深入研究模块之前,我们有必要回顾一下内核模块与我们熟悉的应用程序之间的区别。

最主要的一点,我们必须明确,内核模块是在“内核空间”中运行的,而应用程序运行在“用户空间”。内核空间和用户空间是操作系统中最基本的两个概念,也许你还不是很清楚它们之间的区别,那么我们先一起复习一下。

操作系统的作用之一,就是为应用程序提供资源的管理,让所有的应用程序都可以使用它需要的硬件资源。然而,目前的常态是,主机往往只有一套硬件资源;现代操作系统都能利用这一套硬件,支持多用户系统。为了保证内核不受应用程序的干扰,多用户操作系统都实现了对硬件资源的授权访问,而这种授权访问机制的实现,得益于在CPU内部实现不同的操作保护级别。以INTEL的CPU为例,在任何时候,它总是在四个特权级当中的一个级别上运行,如果需要访问高特权级别的存储空间,必须通过有限数目的特权门。 Linux系统就是充分利用这个硬件特性设计的,它只使用了两级保护级别(尽管i386系列微处理器提供了四级模式)。

在Linux系统中,内核在最高级运行。在这一级,对任何设备的访问都可以进行。而应用程序则运行在最低级。在这一级,处理器禁止程序对硬件的直接访问和对内核空间的未授权访问。所以,对应于在最高级运行的内核程序,它所在的内存空间是内核空间。而对应于在最低级运行的应用程序,它所在的内存空间是用户空间。Linux通过系统调用或者中断,完成从用户空间到内核空间的转换。执行系统调用的内核代码在进程上下文中运行,它代表调用进程完成在内核空间上的操作,而且还可以访问进程的用户地址空间的数据。但对中断来说,它并不存在于任何进程上下文中,而是由内核来运行的。

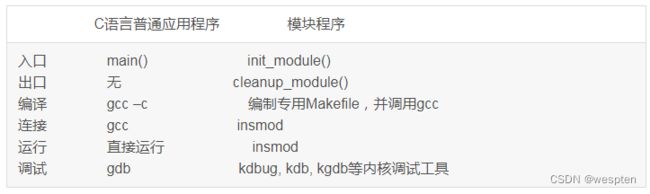

好了,下面我们可以比较具体地分析内核模块与应用程序的异同。让我们看一下表6-1。

应用程序和内核模块程序编程方式的比较:

这个表里,我们看到内核模块必须通过init_module()函数告诉系统,“我来了”;通过cleanup_module()函数告诉系统,“我走了”。这也就是模块最大的特点,可以被动态地装入和卸载。insmod是内核模块操作工具集modutils中,把模块装入内核的命令,我们会在后面详细介绍。因为地址空间的原因,内核模块不能像应用程序那样自由地使用在用户空间定义的函数库如libc,例如printf();模块只能使用在内核空间定义的那些资源受到限制的函数,例如printk()。应用程序的源代码,可以调用本身没有定义的函数,只需要在连接过程中用相应的函数库解析那些外部引用。应用程序可调用的函数printf(),是在stdio.h中声明,并在libc中存在目标可连接代码。然而对于内核模块来说,它无法使用这个打印函数,而只能使用在内核空间中定义的printk()函数。printk()函数不支持浮点数的输出,而且输出数据量受到内核可用内存空间的限制。

内核模块的另外一个困难,是内核失效对于整个系统或者对于当前进程常常是致命的,而在应用程序的开发过程中,缺段(segment fault)并不会造成什么危害,我们可以利用调试器轻松地跟踪到出错的地方。所以在内核模块编程的过程中,必须特别的小心。

下面我们可以具体地看一看内核模块机制究竟是怎么实现的。

内核符号表

首先,我们来了解一下内核符号表这个概念。内核符号表是一个用来存放所有模块可以访问的那些符号以及相应地址的特殊的表。模块的连接就是将模块插入到内核的过程。模块所声明的任何全局符号都成为内核符号表的一部分。内核模块根据系统符号表从内核空间中获取符号的地址,从而确保在内核空间中正确地运行。

这是一个公开的符号表,我们可以从文件/proc/kallsyms中以文本的方式读取。在这个文件中存放数据地格式如下:

内存地址 属性 符号名称 【所属模块】

在模块编程中,可以利用符号名称从这个文件中检索出该符号在内存中的地址,然后直接对该地址内存访问从而获得内核数据。对于通过内核模块方式导出的符号,会包含第四列“所属模块”,用来标志这个符号所属的模块名称;而对于从内核中释放出的符号就不存在这一列的数据了。

内核符号表处于内核代码段的_ksymtab部分,其开始地址和结束地址是由C编译器所产生的两个符号来指定:__start___ksymtab和__stop___ksymtab。

模块依赖

内核符号表记录了所有模块可以访问的符号及相应地址。一个内核模块被装入后,它所声明的符号就会被记录到这个表里,而这些符号当然就可能会被其他模块所引用。这就引出了模块依赖这个问题。

一个模块A引用另一个模块B所导出的符号,我们就说模块B被模块A引用,或者说模块A装载到模块B的上面。如果要链接模块A,必须先要链接模块B。否则,模块B所导出的那些符号的引用就不可能被链接到模块A中。这种模块间的相互关系就叫做模块依赖。

内核代码分析

内核模块机制的源代码实现,来自于Richard Henderson的贡献。2002年后,由Rusty Russell重写。较新版本的Linux内核,采用后者。

1)数据结构

跟模块有关的数据结构存放在include/linux/module.h中,当然,首推struct module:

include/linux/module.h

232 struct module

233 {

234 enum module_state state;

235

236 /* Member of list of modules */

237 struct list_head list;

238

239 /* Unique handle for this module */

240 char name[MODULE_NAME_LEN];

241

242 /* Sysfs stuff. */

243 struct module_kobject mkobj;

244 struct module_param_attrs *param_attrs;

245 const char *version;

246 const char *srcversion;

247

248 /* Exported symbols */

249 const struct kernel_symbol *syms;

250 unsigned int num_syms;

251 const unsigned long *crcs;

252

253 /* GPL-only exported symbols. */

254 const struct kernel_symbol *gpl_syms;

255 unsigned int num_gpl_syms;

256 const unsigned long *gpl_crcs;

257

258 /* Exception table */

259 unsigned int num_exentries;

260 const struct exception_table_entry *extable;

261

262 /* Startup function. */

263 int (*init)(void);

264

265 /* If this is non-NULL, vfree after init() returns */

266 void *module_init;

267

268 /* Here is the actual code + data, vfree'd on unload. */

269 void *module_core;

270

271 /* Here are the sizes of the init and core sections */

272 unsigned long init_size, core_size;

273

274 /* The size of the executable code in each section. */

275 unsigned long init_text_size, core_text_size;

276

277 /* Arch-specific module values */

278 struct mod_arch_specific arch;

279

280 /* Am I unsafe to unload? */

281 int unsafe;

282

283 /* Am I GPL-compatible */

284 int license_gplok;

285

286 /* Am I gpg signed */

287 int gpgsig_ok;

288

289 #ifdef CONFIG_MODULE_UNLOAD

290 /* Reference counts */

291 struct module_ref ref[NR_CPUS];

292

293 /* What modules depend on me? */

294 struct list_head modules_which_use_me;

295

296 /* Who is waiting for us to be unloaded */

297 struct task_struct *waiter;

298

299 /* Destruction function. */

300 void (*exit)(void);

301 #endif

302

303 #ifdef CONFIG_KALLSYMS

304 /* We keep the symbol and string tables for kallsyms. */

305 Elf_Sym *symtab;

306 unsigned long num_symtab;

307 char *strtab;

308

309 /* Section attributes */

310 struct module_sect_attrs *sect_attrs;

311 #endif

312

313 /* Per-cpu data. */

314 void *percpu;

315

316 /* The command line arguments (may be mangled). People like

317 keeping pointers to this stuff */

318 char *args;

319 };

在内核中,每一个内核模块信息都由这样的一个module对象来描述。所有的module对象通过list链接在一起。链表的第一个元素由static LIST_HEAD(modules)建立,见kernel/module.c第65行。如果阅读include/linux/list.h里面的LIST_HEAD宏定义,你很快会明白,modules变量是struct list_head类型结构,结构内部的next指针和prev指针,初始化时都指向modules本身。对modules链表的操作,受module_mutex和modlist_lock保护。

下面就模块结构中一些重要的域做一些说明:

234 state表示module当前的状态,可使用的宏定义有:

MODULE_STATE_LIVE

MODULE_STATE_COMING

MODULE_STATE_GOING

240 name数组保存module对象的名称。

244 param_attrs指向module可传递的参数名称,及其属性

248-251 module中可供内核或其它模块引用的符号表。num_syms表示该模块定义的内核模块符号的个数,syms就指向符号表。

300 init和exit 是两个函数指针,其中init函数在初始化模块的时候调用;exit是在删除模块的时候调用的。

294 struct list_head modules_which_use_me,指向一个链表,链表中的模块均依靠当前模块。在介绍了module{}数据结构后,也许你还是觉得似懂非懂,那是因为其中有很多概念和相关的数据结构你还不了解。

例如kernel_symbol{} (见include/linux/module.h):

struct kernel_symbol

{

unsigned long value;

const char *name;

};这个结构用来保存目标代码中的内核符号。在编译的时候,编译器将该模块中定义的内核符号写入到文件中,在读取文件装入模块的时候通过这个数据结构将其中包含的符号信息读入。

value定义了内核符号的入口地址;

name指向内核符号的名称;

实现函数

接下来,我们要研究一下源代码中的几个重要的函数。正如前段所述,操作系统初始化时,static LIST_HEAD(modules)已经建立了一个空链表。之后,每装入一个内核模块,则创建一个module结构,并把它链接到modules链表中。

我们知道,从操作系统内核角度说,它提供用户的服务,都通过系统调用这个唯一的界面实现。那么,有关内核模块的服务又是怎么做的呢?请参看arch/i386/kernel/syscall_table.S,2.6.15版本的内核,通过系统调用init_module装入内核模块,通过系统调用delete_module卸载内核模块,没有其它途径。这下,代码阅读变得简单了。

kernel/module.c:

1931 asmlinkage long

1932 sys_init_module(void __user *umod,

1933 unsigned long len,

1934 const char __user *uargs)

1935 {

1936 struct module *mod;

1937 int ret = 0;

1938

1939 /* Must have permission */

1940 if (!capable(CAP_SYS_MODULE))

1941 return -EPERM;

1942

1943 /* Only one module load at a time, please */

1944 if (down_interruptible(&module_mutex) != 0)

1945 return -EINTR;

1946

1947 /* Do all the hard work */

1948 mod = load_module(umod, len, uargs);

1949 if (IS_ERR(mod)) {

1950 up(&module_mutex);

1951 return PTR_ERR(mod);

1952 }

1953

1954 /* Now sew it into the lists. They won't access us, since

1955 strong_try_module_get() will fail. */

1956 stop_machine_run(__link_module, mod, NR_CPUS);

1957

1958 /* Drop lock so they can recurse */

1959 up(&module_mutex);

1960

1961 down(¬ify_mutex);

1962 notifier_call_chain(&module_notify_list, MODULE_STATE_COMING, mod);

1963 up(¬ify_mutex);

1964

1965 /* Start the module */

1966 if (mod->init != NULL)

1967 ret = mod->init();

1968 if (ret < 0) {

1969 /* Init routine failed: abort. Try to protect us from

1970 buggy refcounters. */

1971 mod->state = MODULE_STATE_GOING;

1972 synchronize_sched();

1973 if (mod->unsafe)

1974 printk(KERN_ERR "%s: module is now stuck!\n",

1975 mod->name);

1976 else {

1977 module_put(mod);

1978 down(&module_mutex);

1979 free_module(mod);

1980 up(&module_mutex);

1981 }

1982 return ret;

1983 }

1984

1985 /* Now it's a first class citizen! */

1986 down(&module_mutex);

1987 mod->state = MODULE_STATE_LIVE;

1988 /* Drop initial reference. */

1989 module_put(mod);

1990 module_free(mod, mod->module_init);

1991 mod->module_init = NULL;

1992 mod->init_size = 0;

1993 mod->init_text_size = 0;

1994 up(&module_mutex);

1995

1996 return 0;

1997 }

函数sys_init_module()是系统调用init_module( )的实现。入口参数umod指向用户空间中该内核模块image所在的位置。image以ELF的可执行文件格式保存,image的最前部是elf_ehdr类型结构,长度由len指示。uargs指向来自用户空间的参数。系统调用init_module( )的语法原型为:

long sys_init_module(void *umod, unsigned long len, const char *uargs);说明:

1940-1941 调用capable( )函数验证是否有权限装入内核模块。

1944-1945 在并发运行环境里,仍然需保证,每次最多只有一个module准备装入。这通过down_interruptible(&module_mutex)实现。

1948-1952 调用load_module()函数,将指定的内核模块读入内核空间。这包括申请内核空间,装配全程量符号表,赋值__ksymtab、__ksymtab_gpl、__param等变量,检验内核模块版本号,复制用户参数,确认modules链表中没有重复的模块,模块状态设置为MODULE_STATE_COMING,设置license信息,等等。

1956 将这个内核模块插入至modules链表的前部,也即将modules指向这个内核模块的module结构。

1966-1983 执行内核模块的初始化函数,也就是表6-1所述的入口函数。

1987 将内核模块的状态设为MODULE_STATE_LIVE。从此,内核模块装入成功。/kernel/module.c:

573 asmlinkage long

574 sys_delete_module(const char __user *name_user, unsigned int flags)

575 {

576 struct module *mod;

577 char name[MODULE_NAME_LEN];

578 int ret, forced = 0;

579

580 if (!capable(CAP_SYS_MODULE))

581 return -EPERM;

582

583 if (strncpy_from_user(name, name_user, MODULE_NAME_LEN-1) < 0)

584 return -EFAULT;

585 name[MODULE_NAME_LEN-1] = '\0';

586

587 if (down_interruptible(&module_mutex) != 0)

588 return -EINTR;

589

590 mod = find_module(name);

591 if (!mod) {

592 ret = -ENOENT;

593 goto out;

594 }

595

596 if (!list_empty(&mod->modules_which_use_me)) {

597 /* Other modules depend on us: get rid of them first. */

598 ret = -EWOULDBLOCK;

599 goto out;

600 }

601

602 /* Doing init or already dying? */

603 if (mod->state != MODULE_STATE_LIVE) {

604 /* FIXME: if (force), slam module count and wake up

605 waiter --RR */

606 DEBUGP("%s already dying\n", mod->name);

607 ret = -EBUSY;

608 goto out;

609 }

610

611 /* If it has an init func, it must have an exit func to unload */

612 if ((mod->init != NULL && mod->exit == NULL)

613 || mod->unsafe) {

614 forced = try_force_unload(flags);

615 if (!forced) {

616 /* This module can't be removed */

617 ret = -EBUSY;

618 goto out;

619 }

620 }

621

622 /* Set this up before setting mod->state */

623 mod->waiter = current;

624

625 /* Stop the machine so refcounts can't move and disable module. */

626 ret = try_stop_module(mod, flags, &forced);

627 if (ret != 0)

628 goto out;

629

630 /* Never wait if forced. */

631 if (!forced && module_refcount(mod) != 0)

632 wait_for_zero_refcount(mod);

633

634 /* Final destruction now noone is using it. */

635 if (mod->exit != NULL) {

636 up(&module_mutex);

637 mod->exit();

638 down(&module_mutex);

639 }

640 free_module(mod);

641

642 out:

643 up(&module_mutex);

644 return ret;

645 }函数sys_delete_module()是系统调用delete_module()的实现。调用这个函数的作用是删除一个系统已经加载的内核模块。入口参数name_user是要删除的模块的名称。

说明:

580-581 调用capable( )函数,验证是否有权限操作内核模块。

583-585 取得该模块的名称

590-594 从modules链表中,找到该模块

597-599 如果存在其它内核模块,它们依赖该模块,那么,不能删除。

635-638 执行内核模块的exit函数,也就是表6-1所述的出口函数。

640 释放module结构占用的内核空间。源代码的内容就看到这里。kernel/module.c文件里还有一些其他的函数。

尝试着分析一下,top命令显示的进程名包含中括号"[]"的含义

在执行top/ps命令的时候,在COMMAND一列,我们会发现,有些进程名被[]括起来了,例如:

PID PPID USER STAT VSZ %VSZ %CPU COMMAND

1542 928 root R 1064 2% 5% top

1 0 root S 1348 2% 0% /sbin/procd

928 1 root S 1060 2% 0% /bin/ash --login

115 2 root SW 0 0% 0% [kworker/u4:2]

6 2 root SW 0 0% 0% [kworker/u4:0]

4 2 root SW 0 0% 0% [kworker/0:0]

697 2 root SW 0 0% 0% [kworker/1:3]

703 2 root SW 0 0% 0% [kworker/0:3]

15 2 root SW 0 0% 0% [kworker/1:0]

27 2 root SW 0 0% 0% [kworker/1:1]应用代码逻辑分析

关键字:COMMAND

获取busybox的源码后,试试简单粗暴的检索关键字:

[GMPY@12:22 busybox-1.27.2]$grep "COMMAND" -rnw *结果发现,太多匹配的数据:

applets/usage_pod.c:79: printf("=head1 COMMAND DESCRIPTIONS\n\n");

archival/cpio.c:100: --rsh-command=COMMAND Use remote COMMAND instead of rsh

docs/BusyBox.html:1655:which [COMMAND]...

docs/BusyBox.html:1657:Locate a COMMAND

docs/BusyBox.txt:93:COMMAND DESCRIPTIONS

docs/BusyBox.txt:112: brctl COMMAND [BRIDGE [INTERFACE]]

docs/BusyBox.txt:612: ip ip [OPTIONS] address|route|link|neigh|rule [COMMAND]

docs/BusyBox.txt:614: OPTIONS := -f[amily] inet|inet6|link | -o[neline] COMMAND := ip addr

docs/BusyBox.txt:1354: which [COMMAND]...

docs/BusyBox.txt:1356: Locate a COMMAND

......此时我发现,第一次匹配时因为存在大量非源码文件,所以显得很多,那么我能不能只检索C文件呢?

[GMPY@12:25 busybox-1.27.2]$find -name "*.c" -exec grep -Hn --color=auto "COMMAND" {} \;这次结果只有71行,简单扫了下匹配的文件,有个有意思的发现:

......

./shell/ash.c:9707: if (cmdentry.u.cmd == COMMANDCMD) {

./editors/vi.c:1109: // get the COMMAND into cmd[]

./procps/lsof.c:31: * COMMAND PID USER FD TYPE DEVICE SIZE NODE NAME

./procps/top.c:626: " COMMAND");

./procps/top.c:701: /* PID PPID USER STAT VSZ %VSZ [%CPU] COMMAND */

./procps/top.c:841: strcpy(line_buf, HDR_STR " COMMAND");

./procps/top.c:854: /* PID VSZ VSZRW RSS (SHR) DIRTY (SHR) COMMAND */

./procps/ps.c:441: { 16 , "comm" ,"COMMAND",func_comm ,PSSCAN_COMM },

......在busybox中,每一个命令都是单独一个文件,这代码逻辑结构好,我们直接进入procps/top.c文件626行

函数:display_process_list

procps/top.c的626行属于函数display_process_list,简单看一下代码逻辑:

static NOINLINE void display_process_list(int lines_rem, int scr_width)

{

......

/* 打印表头 */

printf(OPT_BATCH_MODE ? "%.*s" : "\033[7m%.*s\033[0m", scr_width,

" PID PPID USER STAT VSZ %VSZ"

IF_FEATURE_TOP_SMP_PROCESS(" CPU")

IF_FEATURE_TOP_CPU_USAGE_PERCENTAGE(" %CPU")

" COMMAND");

......

/* 遍历每一个进程对应的描述 */

while (--lines_rem >= 0) {

if (s->vsz >= 100000)

sprintf(vsz_str_buf, "%6ldm", s->vsz/1024);

else

sprintf(vsz_str_buf, "%7lu", s->vsz);

/*打印每一行中除了COMMAND之外的信息,例如PID,USER,STAT等 */

col = snprintf(line_buf, scr_width,

"\n" "%5u%6u %-8.8s %s%s" FMT

IF_FEATURE_TOP_SMP_PROCESS(" %3d")

IF_FEATURE_TOP_CPU_USAGE_PERCENTAGE(FMT)

" ",

s->pid, s->ppid, get_cached_username(s->uid),

s->state, vsz_str_buf,

SHOW_STAT(pmem)

IF_FEATURE_TOP_SMP_PROCESS(, s->last_seen_on_cpu)

IF_FEATURE_TOP_CPU_USAGE_PERCENTAGE(, SHOW_STAT(pcpu))

);

/* 关键在这,读取cmdline */

if ((int)(col + 1) < scr_width)

read_cmdline(line_buf + col, scr_width - col, s->pid, s->comm);

......

}

}剔除无关代码后,函数逻辑就清晰了

- 在此函数之前的代码中已经遍历了所有进程,并构建了描述结构体

- 在display_process_list中遍历描述结构体,并按规定顺序打印信息

- 通过read_cmdline,获取并打印进程名

我们进入到函数read_cmdline

函数:read_cmdline

void FAST_FUNC read_cmdline(char *buf, int col, unsigned pid, const char *comm)

{

......

sprintf(filename, "/proc/%u/cmdline", pid);

sz = open_read_close(filename, buf, col - 1);

if (sz > 0) {

......

while (sz >= 0) {

if ((unsigned char)(buf[sz]) < ' ')

buf[sz] = ' ';

sz--;

}

......

if (strncmp(base, comm, comm_len) != 0) {

......

snprintf(buf, col, "{%s}", comm);

......

} else {

snprintf(buf, col, "[%s]", comm ? comm : "?");

}

}剔除无关代码后,我发现

- 通过

/proc/获取进程名/cmdline - 如果

/proc/为空时,则使用/cmdline comm,此时用[]括起来 - 如果

cmdline的basename与comm不一致,则用{}括起来

为了方便阅读,不再展开分析cmdline和comm。

我们把问题聚焦在,什么情况下,/proc/为空?

内核代码逻辑分析

关键字:cmdline

/proc挂载的是proc,一种特殊的文件系统,cmdline也肯定是其特有的功能。

假设我们是内核小白,此时我们可以做的就是 在内核proc源码中检索关键字cmdline。

[GMPY@09:54 proc]$cd fs/proc && grep "cmdline" -rnw *发现有两个关键的匹配文件 base.c 和 cmdline.c

array.c:11: * Pauline Middelink : Made cmdline,envline only break at '\0's, to

base.c:224: /* Check if process spawned far enough to have cmdline. */

base.c:708: * May current process learn task's sched/cmdline info (for hide_pid_min=1)

base.c:2902: REG("cmdline", S_IRUGO, proc_pid_cmdline_ops),

base.c:3294: REG("cmdline", S_IRUGO, proc_pid_cmdline_ops),

cmdline.c:26: proc_create("cmdline", 0, NULL, &cmdline_proc_fops);

Makefile:16:proc-y += cmdline.o

vmcore.c:1158: * If elfcorehdr= has been passed in cmdline or created in 2nd kernel,cmdline.c的代码逻辑非常简单,很容易发现其是/proc/cmdline的实现,并不是我们的需求

让我们把目光聚焦到base.c,相关代码

REG("cmdline", S_IRUGO, proc_pid_cmdline_ops),经验的直觉告诉我,

- cmdline:是文件名

- S_IRUGO:是文件权限

- proc_pid_cmdline_ops:是文件对应的操作结构体

果不其然,进入proc_pid_cmdline_ops我们发现其定义为:

static const struct file_operations proc_pid_cmdline_ops = {

.read = proc_pid_cmdline_read,

.llseek = generic_file_llseek,

}函数:proc_pid_cmdline_read

static ssize_t proc_pid_cmdline_read(struct file *file, char __user *buf,

size_t _count, loff_t *pos)

{

......

/* 获取进程对应的虚拟地址空间描述符 */

mm = get_task_mm(tsk);

......

/* 获取argv的地址和env的地址 */

arg_start = mm->arg_start;

arg_end = mm->arg_end;

env_start = mm->env_start;

env_end = mm->env_end;

......

while (count > 0 && len > 0) {

......

/* 计算地址偏移 */

p = arg_start + *pos;

while (count > 0 && len > 0) {

......

/* 获取进程地址空间的数据 */

nr_read = access_remote_vm(mm, p, page, _count, FOLL_ANON);

......

}

}

}小白此时可能就疑惑了,你怎么知道access_remote_vm是干嘛的?

很简单,跳转到access_remote_vm函数中,可以看到此函数是有注释的

/**

* access_remote_vm - access another process' address space

* @mm: the mm_struct of the target address space

* @addr: start address to access

* @buf: source or destination buffer

* @len: number of bytes to transfer

* @gup_flags: flags modifying lookup behaviour

*

* The caller must hold a reference on @mm.

*/

int access_remote_vm(struct mm_struct *mm, unsigned long addr,

void *buf, int len, unsigned int gup_flags)

{

return __access_remote_vm(NULL, mm, addr, buf, len, gup_flags);

}Linux内核源码中,很多函数都有很规范的功能说明,参数说明,注意事项等等,我们要充分利用这些资源学习代码。

扯远了,让我们回到主题上。

从proc_pid_cmdline_read中我们发现,读/proc/实际上就是读取arg_start开始的的地址空间数据。所以,当这地址空间数据为空时,当然就读不到任何数据了。那么问题来了,什么时候arg_start标识的地址空间数据为空?

关键字:arg_start

地址空间相关的,绝对不仅仅是proc的事儿,我们试着在内核源码全局检索关键字:

[GMPY@09:55 proc]$find -name "*.c" -exec grep --color=auto -Hnw "arg_start" {} \;匹配不少,不想一个一个看,且从检索出来的代码找不到方向:

./mm/util.c:635: unsigned long arg_start, arg_end, env_start, env_end;

......

./kernel/sys.c:1747: offsetof(struct prctl_mm_map, arg_start),

......

./fs/exec.c:709: mm->arg_start = bprm->p - stack_shift;

./fs/exec.c:722: mm->arg_start = bprm->p;

......

./fs/binfmt_elf.c:301: p = current->mm->arg_end = current->mm->arg_start;

./fs/binfmt_elf.c:1495: len = mm->arg_end - mm->arg_start;

./fs/binfmt_elf.c:1499: (const char __user *)mm->arg_start, len))

......

./fs/proc/base.c:246: len1 = arg_end - arg_start;

......但是从匹配的文件名给了我灵感:

/proc/

进一步联想到在用户空间创建进程不外乎两个步骤:

- fork

- exec

在fork时只是创建新的task_struct,父子进程共用一份mm_struct,只有在exec的时候,才会独立出mm_struct,所以arg_start一定是在exec时被修改!而匹配arg_start的文件中,刚好有exec.c。

查看了fs/exec.c中关键字所在函数setup_arg_pages后,并没找到关键代码,于是继续查看匹配的文件名,产生了进一步联想:

exec执行一个新的程序,实际是加载新程序的bin文件,关键字匹配的文件中刚好也有binfmt_elf.c!

定位问题不仅仅要看得懂代码,联想有时候也是非常有效的

函数:create_elf_tables

binfmt_elf.c中匹配关键字arg_start的是函数create_elf_tables,函数挺长,我们精简一下:

static int

create_elf_tables(struct linux_binprm *bprm, struct elfhdr *exec,

unsigned long load_addr, unsigned long interp_load_addr)

{

......

/* Populate argv and envp */

p = current->mm->arg_end = current->mm->arg_start;

while (argc-- > 0) {

......

if (__put_user((elf_addr_t)p, argv++))

return -EFAULT;

......

}

......

current->mm->arg_end = current->mm->env_start = p;

while (envc-- > 0) {

......

if (__put_user((elf_addr_t)p, envp++))

return -EFAULT;

......

}

......

}在此函数中,实现了把argv和envp方别存入arg_start和env_start的地址空间。

接下来,我们试试溯本逐源,一起追溯函数create_elf_tables的调用

首先,create_elf_tables声明为static,表示其有效范围不可能超过所在文件。在文件中检索,发现上级函数为:

static int load_elf_binary(struct linux_binprm *bprm)竟然还是static,进而继续在本文件中检索load_elf_binary,找到了以下代码:

static struct linux_binfmt elf_format = {

.module = THIS_MODULE,

.load_binary = load_elf_binary,

.load_shlib = load_elf_library

.core_dump = elf_core_dump,

.min_coredump = ELF_EXEC_PAGESIZE,

};

static int __init init_elf_binfmt(void)

{

register_binfmt(&elf_format);

return 0;

}

core_initcall(init_elf_binfmt);检索到这里,代码结构非常清晰了,load_elf_binary函数赋值于struct linux_binfmt,通过`register_binfmt向上层注册,提供上层回调。

关键字:load_binary

为什么要锁定关键字load_binary呢?既然.load_binary = load_elf_binary,,表示上层的调用应该是XXX->load_binary(...),因此锁定关键字load_binary即可定位,哪里调用了此回调。

[GMPY@09:55 proc]$ grep "\->load_binary" -rn *非常幸运,此回调只有fs/exec.c调用:

fs/exec.c:78: if (WARN_ON(!fmt->load_binary))

fs/exec.c:1621: retval = fmt->load_binary(bprm);进入fs/exex.c的1621行,归属于函数search_binary_handler,而不幸的是EXPORT_SYMBOL(search_binary_handler);的存在,表示很可能此函数会有多处被调用,此时继续正向分析显然非常困难,为什么不试试逆向分析呢?

道路走不通的时候,换个角度看问题,答案就在眼前

既然从search_binary_handler继续分析不容易,我们不妨看看execve的系统调用是否可以一步步到search_binary_handler?

关键字:exec

在Linux-4.9上,系统调用的定义一般是SYSCALL_DEFILNE<参数数量>(<函数名>...,因此我们全局检索关键字,先确定系统调用定义在哪里?

[GMPY@09:55 proc]$ grep "SYSCALL_DEFINE.*exec" -rn *定位到文件fs/exec.c:

fs/exec.c:1905:SYSCALL_DEFINE3(execve,

fs/exec.c:1913:SYSCALL_DEFINE5(execveat,

fs/exec.c:1927:COMPAT_SYSCALL_DEFINE3(execve, const char __user *, filename,

fs/exec.c:1934:COMPAT_SYSCALL_DEFINE5(execveat, int, fd,

kernel/kexec.c:187:SYSCALL_DEFINE4(kexec_load, unsigned long, entry, unsigned long, nr_segments,

kernel/kexec.c:233:COMPAT_SYSCALL_DEFINE4(kexec_load, compat_ulong_t, entry,

kernel/kexec_file.c:256:SYSCALL_DEFINE5(kexec_file_load, int, kernel_fd, int, initrd_fd,后面跟进函数的调用不再累赘,总结其调用关系为:

execve -> do_execveat -> do_execveat_common -> exec_binprm -> search_binary_handler终究是回归到了search_binary_handler

分析到这,我们确定了赋值逻辑:

-

在

execve执行新程序时,会初始化mm_struct -

把

execve中传递的argv和envp保存到arg_start和env_start指定的地址中 -

在

cat /proc/时则从arg_start的虚拟地址获取数据/cmdline

因此,只要是用户空间创建的进程经过execve的系统调用,都会有/proc/,但依然没澄清,什么时候会cmdline会为空?

我们知道,在Linux中,进程可分为用户空间进程和内核空间进程,既然用户空间进程cmdline非空,我们再看看内核进程。

函数:kthread_run

内核驱动中,经常通过kthread_run创建内核进程,我们以此函数为切入口,分析创建内核进程时,是否会赋值cmdline?

直接从kthread_run开始,跟踪调用关系,发现真正干活的是函数__kthread_create_on_node:

kthread_run -> kthread_create -> kthread_create_on_node -> __kthread_create_on_node去掉冗余代码,专注于函数做了什么:

static struct task_struct *__kthread_create_on_node(int (*threadfn)(void *data),

void *data, int node, const char namefmt[], va_list args)

{

/* 把新进程相关的属性存于 kthread_create_info 的结构体中 */

struct kthread_create_info *create = kmalloc(sizeof(*create), GFP_KERNEL);

create->threadfn = threadfn;

create->data = data;

create->node = node;

create->done = &done;

/* 把初始化后的create加入到链表,并唤醒kthreadd_task进程来完成创建工作 */

list_add_tail(&create->list, &kthread_create_list);

wake_up_process(kthreadd_task);

/* 等待创建完成 */

wait_for_completion_killable(&done)

......

task = create->result;

if (!IS_ERR(task)) {

......

/* 创建后,设置进程名,此处的进程名属性为comm,不同于cmdline */

vsnprintf(name, sizeof(name), namefmt, args);

set_task_comm(task, name);

......

}

}分析方法跟上文相似,不在累述。总结来说,函数做了两件事

-

唤醒进程

kthread_task来创建新进程 -

设置进程的属性,其中属性包括comm,但不包括cmdline

回顾用户代码分析,如果/proc/为空时,则使用comm,此时用[]括起来**

因此,经过kthread_run/ktrhread_create创建的内核进程,/proc/内容为空。

本次分析过程中,主要用了以下几种分析方法

- 关键字检索 - 从top程序的COMMAND到内核源码的arg_start、load_binary、exec

- 函数注释 - 函数access_remote_vm的功能说明

- 联想 - 从进程属性联想到用户空间创建进程,进而定位到arg_start关键字的处理函数

- 逆向思维 - 从search_binary_handler向上推导调用关系困难,改为分析execve的系统调用是否可以一步步到search_binary_handler?

根据本次分析,我们得出以下结论:

-

用户空间创建的进程在top/ps显示不需要[];

-

内核空间创建的进程在top/ps显示会有[];

模块单元是怎样与系统内核交互的?

内核模块的make文件:

首先我们来看一看模块程序的make文件应该怎么写。自2.6版本之后,Linux对内核模块的相关规范,有很大变动。例如,所有模块的扩张名,都从“.o”改为“.ko”。详细信息,可参看Documentation/kbuild/makefiles.txt。针对内核模块而编辑Makefile,可参看Documentation/kbuild/modules.txt。

我们练习“helloworld.ko”时,曾经用过简单的Makefile:

TARGET = helloworld

KDIR = /usr/src/linux

PWD = $(shell pwd)

obj-m += $(TARGET).o

default:

make -C $(KDIR) M=$(PWD) modules$(KDIR)表示源代码最高层目录的位置。

“obj-m += $(TARGET).o”告诉kbuild,希望将$(TARGET),也就是helloworld,编译成内核模块。

“M=$(PWD)”表示生成的模块文件都将在当前目录下。

多文件内核模块的 make文件

现在,我们把问题引申一下,对于多文件的内核模块该如何编译呢?同样以“Hello,world”为例,我们需要做以下事情:

在所有的源文件中,只有一个文件增加一行#define __NO_VERSION__。这是因为module.h一般包括全局变量kernel_version的定义,该全局变量包含模块编译的内核版本信息。如果你需要version.h,你需要自己把它包含进去,因为定义了 __NO_VERSION__后module.h就不会包含version.h。

下面给出多文件的内核模块的范例。

Start.c:

/* start.c

*

* "Hello, world" –内核模块版本

* 这个文件仅包括启动模块例程

*/

/* 必要的头文件 */

/* 内核模块中的标准 */

#include /*我们在做内核的工作 */

#include

/*初始化模块 */

int init_module()

{

printk("Hello, world!\n");

/* 如果我们返回一个非零值, 那就意味着

* init_module 初始化失败并且内核模块

* 不能加载 */

return 0;

} stop.c:

/* stop.c

*"Hello, world" -内核模块版本

*这个文件仅包括关闭模块例程

*/

/*必要的头文件 */

/*内核模块中的标准 */

#include /*我们在做内核的工作 */

#define __NO_VERSION__

#include

#include /* 不被module.h包括,因为__NO_VERSION__ */

/* Cleanup - 撤消 init_module 所做的任何事情*/

void cleanup_module()

{

printk("Bye!\n");

}

/*结束*/ 这一次,helloworld内核模块包含了两个源文件,“start.c”和“stop.c”。再来看看对于多文件内核模块,该怎么写Makefile文件

Makefile:

TARGET = helloworld

KDIR = /usr/src/linux

PWD = $(shell pwd)

obj-m += $(TARGET).o

$(TARGET)-y := start.o stop.o

default:

make -C $(KDIR) M=$(PWD) modules相比前面,只增加一行:

$(TARGET)-y := start.o stop.o编写内核模块

我们试着写一个非常简单的模块程序,它可以在2.6.15的版本上实现,对于低于2.4的内核版本可能还需要做一些调整。

helloworld.c

#include /* Needed by all modules */

#include /* Needed for KERN_INFO */

int init_module(void)

{

printk(KERN_INFO “Hello World!\n”);

return 0;

}

void cleanup_module(void)

{

printk(KERN_INFO “Goodbye!\n”);

}

MODULE_LICENSE(“GPL”); 说明:

1. 任何模块程序的编写都需要包含linux/module.h这个头文件,这个文件包含了对模块的结构定义以及模块的版本控制。文件里的主要数据结构我们会在后面详细介绍。

2. 函数init_module()和函数cleanup_module( )是模块编程中最基本的也是必须的两个函数。init_module()向内核注册模块所提供的新功能;cleanup_module()负责注销所有由模块注册的功能。

3. 注意我们在这儿使用的是printk()函数(不要习惯性地写成printf),printk()函数是由Linux内核定义的,功能与printf相似。字符串KERN_INFO表示消息的优先级,printk()的一个特点就是它对于不同优先级的消息进行不同的处理。

接下来,我们就要编译和加载这个模块了。还要注意的一点就是:确定你现在是超级用户。因为只有超级用户才能加载和卸载模块。在编译内核模块前,先准备一个Makefile文件: