C/C++ FFmepeg Qt音视频开发录屏摄像机

C/C++ FFmepeg音视频开发录屏摄像机

- 导入FFmepeg库文件:FFmepegSDK可以去官网下载

- mp4_to_mov

- rgb_to_mp4

- pcm_to_aac

- rgb_pcm_to_mp4

- TestDirectx

- qt_audio_input

- XScreen(这个源码文件是以上面做为集合开发出来的软件)

以下为本人学习所做的开发笔记,不喜勿喷,谢谢各位大哥

导入FFmepeg库文件:FFmepegSDK可以去官网下载

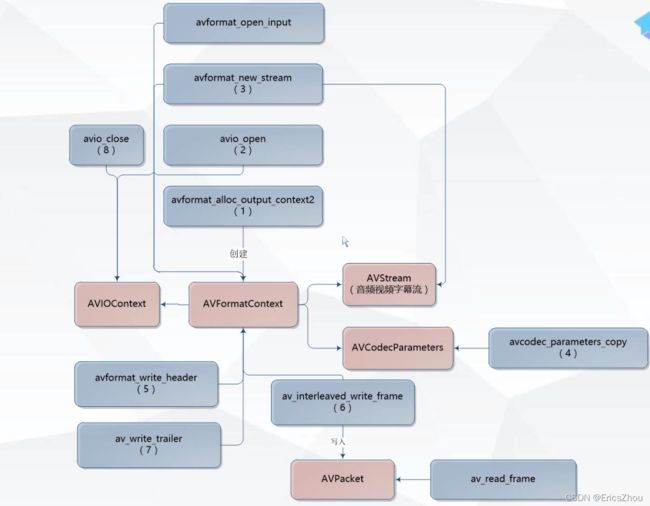

mp4_to_mov

extern "C"

{

#include rgb_to_mp4

extern "C"

{

#include pcm_to_aac

//extern "C"

//{

// #include rgb_pcm_to_mp4

#include "XVideoWriter.h"

#include TestDirectx

#include qt_audio_input

#include XScreen(这个源码文件是以上面做为集合开发出来的软件)

#include "xscreen.h"

#include