Python 接口并发测试详解

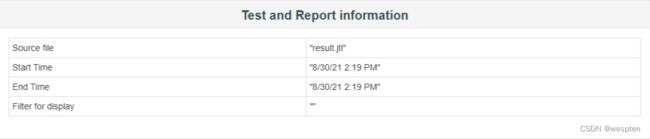

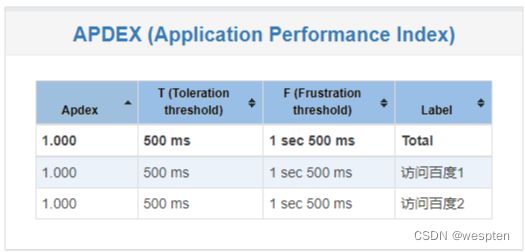

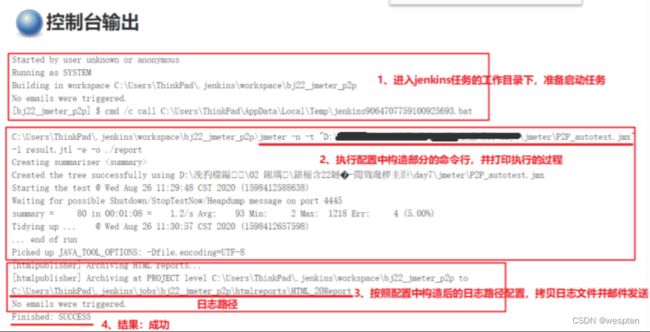

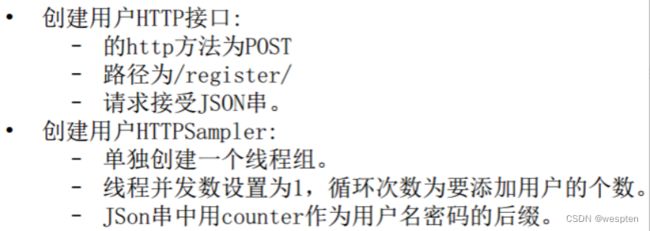

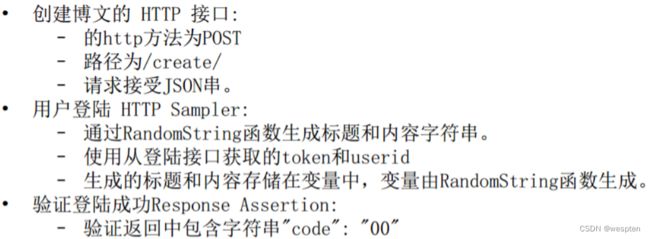

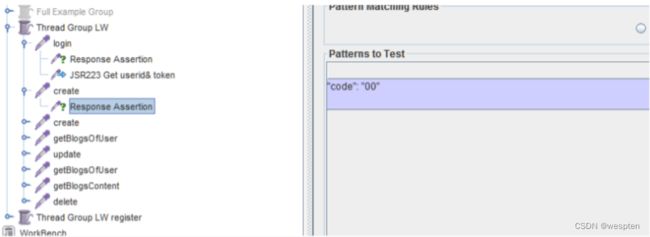

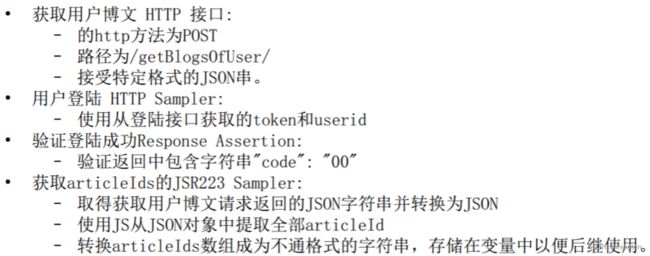

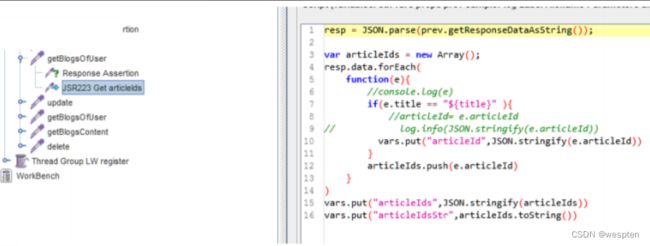

一、接口并发测试简介

1、性能测试简介

性能测试是通过自动化测试工具模拟多种正常、峰值及异常负载条件对系统的各项性能指标进行的测试。负载测试和压力测试都属于性能测试,两者可以结合进行。通过负载测试,确定在各种工作负载下系统的性能,目标是测试当负载逐渐增加时,系统各项性能指标的变化情况。压力测试是通过确定一个系统的瓶颈或者不能接受的性能点,来获得系统能提供的最大服务级别的测试。

性能测试的重点是测试在并发条件下服务或系统的瓶颈所在,从而优化相关功能,可能涉及软件及硬件的多方面改进。由此可见,性能测试对整个产品非常重要,甚至可以决定一个产品是否能长久发展。

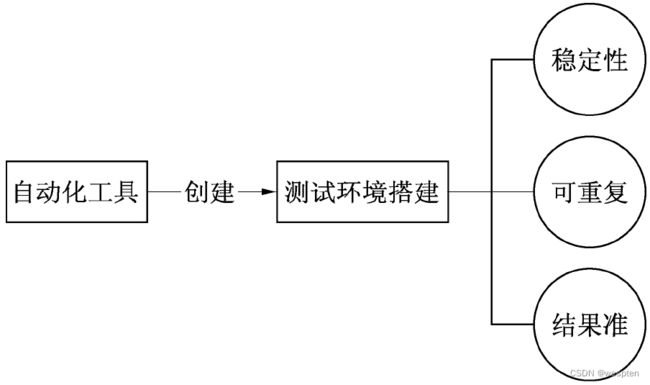

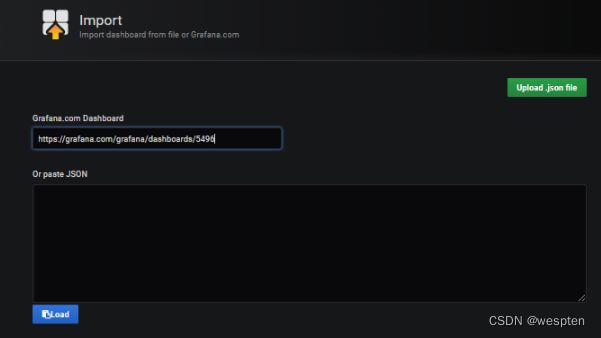

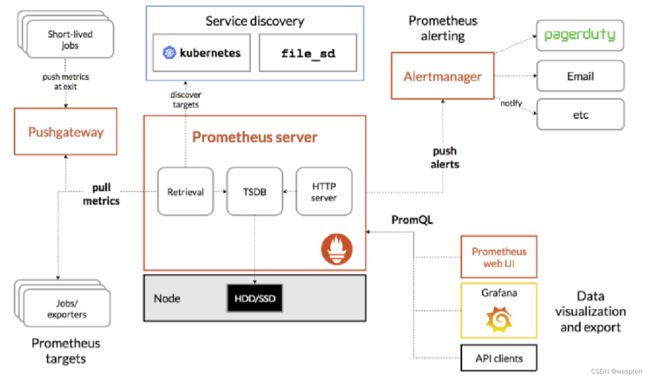

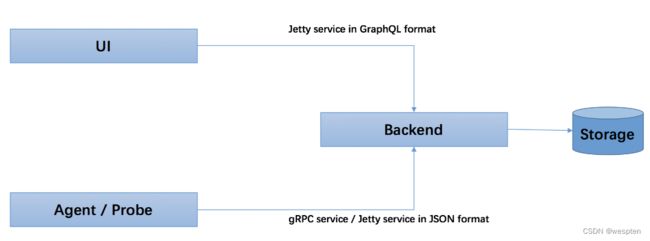

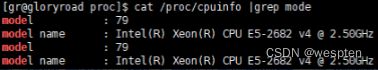

构建一个性能测试环境需要做一些准备,如图所示:

一般情况下都是使用自动化测试工具来构建性能测试环境,需要必要的服务器、软件和客户端等软硬件的支持。

一个良好的性能测试环境需要满足以下条件:

- 稳定、可重复的测试环境,能够保证测试结果的准确性。

- 保证达到测试执行的技术需求。

- 保证得到正确、可重复及易理解的测试结果。

有时候找到测试的基线(基本功能版本的产品线),能够更快地定义问题所在。通过不断地加压,测试服务或系统的最大承压能力。

根据不同的目的,可以把性能测试分成以下两个方面。

- 负载测试(Load Testing):在负载状态下对服务器系统的性能进行测试,目标是测试当前负载逐渐增加时,系统组成部分的相应输出项,如正常请求的接收数、响应时间、CPU负载、内存使用等,从而判断系统的性能。

- 压力测试(Stress Testing):通过确定一个系统的瓶颈或者不能接受的性能点,获得系统能提供的最大服务级别的测试行为。

关于压力测试,可以用一个具体的例子来理解。

例如,现在有600个用户可以在13s内完成支付交易,而650个用户完成支付交易的时间却超过了13s,则说明该支付服务已经不能再接收更多的业务请求了,从而估算出该项支付服务的最大承受范围是600个用户左右。所谓最大承受的压力点,就是通常意义上的瓶颈点。

后续会介绍一些热门的自动化性能测试工具,以便更准确地找到系统和服务性能的瓶颈点。这种性能测试在一些情况下能给团队和公司产生巨大的价值,包括商业价值。

2、并发测试简介

提到并发测试,测试人员总是会直接想到性能测试。除了在单元测试中会涉及一部分并发情况,测试人员可以根据开发模式及项目需求针对具体功能提取响应时间作为性能指标的参考。测试行业中的大多数人都认为性能测试包括并发测试、压力测试等,但并发测试一定是性能测试。所以并发测试与性能测试是包含于的关系。

其实测试人员的这种想法是错的,并发测试不等同于性能测试,性能测试也只是并发测试中的一小类而已。并发测试中除了耳熟能详的性能测试外,另一个与测试人员更密切相关的问题。

随着技术时代的发展,由于性能导致的问题项目组可以通过扩容、分布式缓存等方式有效地解决。并且从项目成本的角度看,虚拟服务器的发展已经让扩容不再需要很大的人力及物力,甚至由于解决性能问题导致的成本代价要远远小于因为执行大型性能测试而产生的成本代价。在这样的大形势下,除了真正有业务需求的公司,大多数大中小公司对于专职性能测试工程师的需求量会下降。他们真正需要的已不是系统测试完成后上线前的大型性能测试,而是并发测试。

接口并发测试是以并发为手段的接口测试行为,通过测试行为发现接口在并发场景下导致的功能问题就是接口并发测试最主要的目的。测试人员所做的功能测试真的完美了吗?没有!由于并发而导致的功能缺陷已然成为了项目上线后的主要遗留缺陷。

二、常见的性能问题

当下流行一种时尚的软件设计理念“微服务”,把复杂功能组合拆分成若干个独立的服务进行开发,然后有选择地组合执行各服务。微服务开发框架更有利于并发测试设计,每个服务都是测试切入口,可以单独执行。测试切入口越多,越有利于测试场景的设计,有效地执行并发用例。

测试切入口从三个方面查找统计:客户端操作、系统间接口调用、内置的定时任务。

客户端可以使用工具捕获提交到服务器的请求,分析链接、参数进行测试。

系统接口可以查相关接口文档,开发并模拟其他系统功能进行测试。

定时任务视开发框架,可能需要二次开发,以接口形式进行测试。

并发测出的问题是一种综合症,往往由多种错误交织在一起,切不可头痛医头脚痛医脚。

解决这类问题通常分为以下5个步骤:

- 通过并发测试找到故障点。

- 以故障点的现象分析问题原因。

- 确定产生原因后讨论解决方案。

- 根据解决方案实施修复。

- 通过并发测试验证修复情况。

在团队内进行专业的分析讨论,得出结论,是一种硬实力。除了开发以外,希望测试人员也要多多参与技术讨论,提升自身发现定位问题的能力。

接下来先了解下因为容易被忽视而导致的常见并发问题。

1、事务并发的问题

由于事务处理而导致的并发问题,测试人员需要先理解事务是什么意思。举个例子来阐述事务的概念。

故事场景:开心用手机通过定电影票系统购买电影票,找到自己喜欢的电影,选择自己想坐的位置,确认后点击下方的“确认选座”,进入订单支付画面。随后开心进入了订单支付画面,勾上了满减活动、现金抵用券,选择使用支付宝去支付,支付成功后收到平台短信。

结合以上场景,先讨论下系统内部的事务控制。事务的控制好坏往往取决于程序员们的开发技术能力、业务理解能力、专注程度,由于这类错误而导致的bug是非常低级且严重的。

将故事场景进行以下切分。

故事场景的上半部分:开心用手机购买电影票,找到自己喜欢的电影,选择自己想坐的位置,确认后点击下方的“确认选座”,进入订单支付画面。

“确认选座”与“生成订单”对于定电影票系统是内部接口。

将“确认选座”与“生成订单”定义为一个事务,有以下四个特性。

- 原子性的操作:要么都做,要么都不做。

- 状态保持一致性:系统锁定座位时必须生成订单,取消订单时必须解锁座位。

- 与其他事务互相隔离,不被干扰:座位被其他人选定、操作日志记录失败、断网等。

- 事务提交后永久存在,不会受到任何故障影响。只能另起一个新事务去修改已存在的数据。

这个例子的事务比较简单,想象下违反这些特性可能出现的问题。而这些问题就是测试人员在对“确认选座”与“生成订单”接口进行并发测试时,所需要考虑的测试用例覆盖点。

- 一个座位被多个账号同时锁定,生成了订单。

- 座位锁定成功,但是订单没生成。

- 订单取消成功,座位解锁失败。

- 生成重复的订单号。

- 操作日志没有完整地记录所有行为。

故事场景的下半部分:开心进入了订单支付画面,勾上了满减活动、现金抵用券,选择使用支付宝去支付,支付成功后收到平台短信。

“支付成功”对于定电影票系统是外部接口。对于外部接口的事务控制,就需要考虑两个系统的设计。在这里我们假设支付机构接口是成熟、稳定、无问题的。考虑针对订电影票系统的支付接口的事务控制就是外部接口测试的重点。

对支付接口进行并发接口测试,要考虑的事务问题如下:

- 同一笔订单,不能同时选择多种方式,不能进行多次支付。

- 重复通知商城支付结果(支付成功、支付超时),只能处理一次订单。

- 日志记录完整记录发送、接受的支付信息,与测试用例内容相匹配。

2、极限值并发的问题

由于极限值而导致的并发问题,先举个例子来阐述极限值的概念。

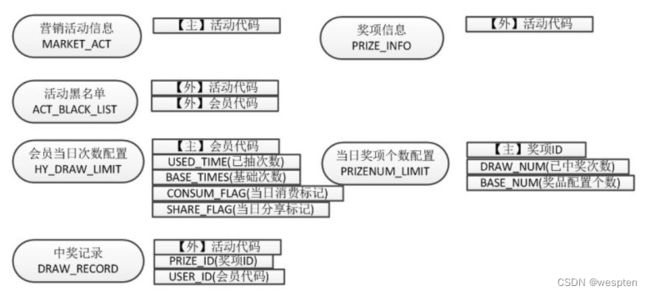

故事场景:最近开心测试团队接到一个周年庆营销活动项目的测试任务。营销活动的具体安排为每日9:00-21:00给予每个用户一份惊喜。每人每日可获得两次抽奖机会,会员可通过转发抽奖活动至朋友圈额外获得一次抽奖机会。已经获得一等奖或二等奖的用户不可再获得三四等奖;中奖概率按预估概率进行设定,如果已中奖数量达到每日设定奖品数量上限,该奖项停止。

周年庆营销活动的具体安排就是测试需求,开心将营销活动的具体安排进行拆分,得出并发测试场景。

- 每日9:00-21:00给予每个用户一份惊喜。

- 每人每日可获得两次抽奖机会,

- 会员可通过转发抽奖活动至朋友圈额外获得一次抽奖机会。

- 已经获得一等奖或二等奖的用户不可再获得三四等奖。

- 中奖概率按预估概率进行设定。

- 已中数量达到每日设定奖品数量上限,该奖项停止。

这个场景中处处都是极限值,让我们一起来字字品味,理清测试的切入口。

在这个场景中,先分析测试对象分别有:活动时间、抽奖次数、中奖概率、奖品数量上限、中奖规则。

针对这些对象结合测试场景,分析这些测试对象如果“越界”可能导致的问题作为并发测试的用例覆盖点。

- 测试活动:不在活动时间范围内,也能参与抽奖。

- 抽奖次数:活动分享至朋友圈,抽奖机会增加次数超过一次。

- 抽奖次数:每日抽奖次数超过上限。

- 中奖概率:中奖概率分配不足100%,或超过100%。

- 中奖概率:设置中奖概率有效的小数位数。

- 奖品数量上限:奖项数量上限控制。

- 中奖规则:已中一等奖或二等奖的用户,是否还能中奖。

3、压力并发的问题

由于压力负载而导致的并发问题,此类问题可以归类于性能问题。

在此类中,并发测试等同于性能测试,通常被称为压力测试,它是为了了解系统能提供的最大服务级别,获知系统响应时间、错误率等指标。通过增加并发数实现压力并发的测试行为,除了能发现系统中的性能问题,更是为了能发现系统功能上的缺陷。

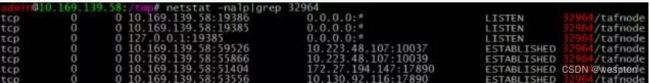

关于此类并发测试需考虑的测试点,希望测试人员要明白数据处理的本质。我从数据库对于事务处理的角度进行分析,需要测试人员先掌握数据库事务隔离级别的知识。

事务的概念在事务并发问题中已经说明。在理解事务含义的基础上,再看数据库事务的隔离级别。

数据库事务的隔离级别有4个,由低到高依次如下:

1)Read uncommitted(未授权读取、读未提交)

如果一个事务已经开始写数据,则另外一个事务不允许同时进行写操作,但允许其他事务读此行数据。该隔离级别可以通过“排他写锁”实现。

该隔离级别避免了更新丢失,却可能出现脏读,也就是说事务B读取到了事务A未提交的数据。

2)Read committed(授权读取、读提交)

读取数据的事务允许其他事务继续访问该行数据,但是未提交的写事务将会禁止其他事务访问该行。

该隔离级别避免了脏读,但是却可能出现不可重复读。事务A事先读取了数据,事务B紧接着更新了数据,并提交了事务,而事务A再次读取该数据时,数据已经发生了改变。

3)Repeatable read(可重复读取)

读取数据的事务将会禁止写事务(但允许读事务),写事务则禁止任何其他事务。

该隔离级别避免了不可重复读取和脏读,但是有时可能出现幻读。这可以通过“共享读锁”和“排他写锁”实现。

4)Serializable(序列化)

提供严格的事务隔离。它要求事务序列化执行,事务只能一个接着一个地执行,但不能并发执行。如果仅仅通过“行级锁”是无法实现事务序列化的,必须通过其他机制保证新插入的数据不会被刚执行查询操作的事务访问到。

序列化是最高的事务隔离级别,同时代价也花费最高,性能很低,一般很少使用。在该级别下,事务顺序执行,不仅可以避免脏读、不可重复读,还避免了幻像读。

这 4 个级别可以逐个解决脏读、不可重复读、幻读这 3 类问题。

以下解释这 3 类情况的含义:

- 脏读

一个事务读取到了另一个事务未提交的数据操作结果。

- 更新丢失

更新丢失包括以下两种情况。

(1)回滚丢失

当2个事务更新相同的数据源时,如果第一个事务被提交,而另外一个事务却被撤销,那么会连同第一个事务所做的更新也被撤销,也就是说第一个事务做的更新丢失了。

(2)覆盖丢失

当2个或多个事务查询同样的记录然后各自基于最初的查询结果更新该行时,会造成覆盖丢失,因为每个事务都不知道其他事务的存在,最后一个事务对记录做的修改将覆盖其他事务对该记录做的已提交的更新。

- 不可重复读(Non-repeatable Reads)

一个事务对同一行数据重复读取两次,但是却得到了不同的结果,包括以下情况。

(1)虚读:事务T1读取某一数据后,事务T2对其做了修改,当事务T1再次读该数据时得到与前一次不同的值。

(2)幻读:事务在操作过程中进行两次查询,第二次查询的结果包含了第一次查询中未出现的数据或者缺少了第一次查询中出现的数据(这里并不要求两次查询的SQL语句相同)。这是由在两次查询过程中有另外一个事务插入数据造成的。

通常数据库设置默认隔离级别为Read committed(授权读取、读提交),仅支持使用事务并防止脏读。隔离级别越高,越能保证数据的完整性和一致性,但同时对并发性能的影响也会非常越大。当项目需求对系统性能有要求时,程序员就不能通过提高数据库设置级别保证并发事务处理的正确性。如果事务处理不正确,会直接导致功能出错,如资金计算错误等。提高隔离级别导致数据库访问效率急剧下降,为了保证系统性能不受影响,大部分的业务隔离将由程序逻辑进行处理。

下面以故事的形式,介绍测试人员在处理该并发测试需求时要关注的测试用例覆盖点。

最常见的覆盖点就是第二类更新丢失(覆盖丢失)产生的问题。

故事场景如下:

开心在网上开店卖鞋子,每时每刻库存都发生着变化:开心上架补货,开心下架撤货,买家下单买鞋,买家撤单取消。

考虑库存情况,可以根据以上场景建立一个基础公式,来校验测试结果是否正确。

- 剩余鞋子数量=上架数量−下架数量−成功下单数量

再进一步,建立公式二:

- 剩余鞋子数量=上架的数量−下架数量−下单数量+撤单数量

这些相互对立、交叉的操作都会影响到商品库存,任意两种组合或几种组合,可能打破公式平衡。例如,两个用户同时买一款鞋子,两个都下单成功。但第二个用户突然发现另一款鞋子更适合,她要求退款处理(减1后加1操作)。这样就导致与退款处理同时产生的事务计算出现问题,计算剩余鞋子数量与实际剩余鞋子数量不符,引发资金对账不平等情况。这种情况测试人员可以通过直接读取数据库值,再通过计算公式验证测试结果是否满足预期结果。

其次,在剩余鞋子数量发生变化的同时,测试人员要确定客户看到的情况是否与事务处理结果相符。此类问题可以通过校验买卖过程中的异常情况进行测试。例如,测试场景为:用户在客户端买了鞋子,但前端反馈由于网络问题购买失败,测试人员需要通过检查请求成功或失败的结果数量判定是否与预期结果相符。

同时通过公式记录每次请求后的商品数量变化,将其与前端显示的相关数量作对比。

- 下架数量 = 下架请求总数量 – 下架请求失败数量

说到测试人员判定请求是否成功,要提到另外一个概念:同步请求与异步请求。这两者的区别会造成测试人员判定请求状态与实际请求状态有差异,以至测试结果出错。

举个例子说明什么是同步请求和异步请求。

上班日中午天气太热,开心不想出办公室,让同事帮忙买一下比目鱼盖饭。同事塞着耳机没反应,开心拍拍他继续说,同事听到后不答应。于是开心提出请同事吃比目鱼盖饭,同事欢快地答应出门了。结果比目鱼餐厅今天不营业,同事空手而归。

这个例子有3次请求失败情况,同步请求失败2次,异步请求失败1次。

- 同步请求:由于同事塞着耳机,环境太吵,根本没听到开心的请求。(网络异常,没收到)

- 同步请求:同事听到了请求,但是没答应。(参数异常,条件不对,拒绝执行)

- 异步请求:同事没买到饭空手而归。(执行过程中发现资源冲突,执行失败)

同步请求:开心等待同事的回答,期间未做其他事情一直是等待回应状态。

异步请求:开心得到同事的第一次回答,过了一段时间后得到第二次回答。此期间开心可以做其他事情。

如果是异步请求,可能会出现两种情况:

- 即使测试人员在第一次得到“好的”的状态,也不能说明这个请求是成功的。因为“好的”并不说明“饭真的买回来”了。

- 即使测试人员在第一次得到“失败”的状态,也不能说明这个请求是失败的。因为“失败”可能是由于网络异常造成的没收到回复,实际同事“已经买到了比目鱼饭!”开心可以欢快地吃饭了。

说完以上内容,总结一下测试人员在处理此类并发测试时需要重点考虑以下几点:

- 先确定请求是同步,还是异步。

- 测试场景中的异常结果前后端处理数据是否相符。

- 并发产生的数据运算是否正确。

4、异常数据干扰并发的问题

异常数据导致的并发问题,除了并发测试外,测试人员可以通过另一种测试发现问题。对于此类情况的异常数据测试也可以称为系统健壮性测试。此类测试的重点是要根据业务逻辑或系统相关的配置情况构建能够造成异常的测试数据,要求这些数据不能被当作正常数据处理,也不能影响其他正常数据。

例如,测试人员构建测试场景为不断触发定时批处理任务,如果程序员在代码中忽视对异常数据逻辑处理,就会造成数据库连接池爆满、内存溢出、遇到异常数据直接报错中断(待执行任务队列越积越多)等问题。

此类并发测试关注点不是同步并发,而是逐步加压的并发数量,需要测试人员对系统架构配置及数据流逻辑具有非常清晰的认识,才能构建符合测试需求的异常测试场景。

三、性能问题解决方案

1、程序三高

1. 高并发

高并发(High Concurrency)是互联网分布式系统架构设计中必须考虑的因素之一。当多个进程或线程同时(或着说在同一段时间内)访问同一资源时会产生并发问题,因此需要通过专门的设计来保证系统能够同时(并发)正确处理多个请求。

2. 高性能

简单地说,高性能(High Performance)就是指程序处理速度快、耗能少。与性能相关的一些指标如下:

- 响应时间:系统对请求做出响应的时间。例如系统处理一个 HTTP 请求需要 200ms,这个 200ms 就是系统的响应时间。

- 吞吐量:单位时间内处理的请求数量。

- TPS:每秒响应事务数。

- 并发用户数:同时承载能正常使用系统功能的用户数量。

高并发和高性能是紧密相关的,提高应用的性能,可以提高系统的并发能力。

应用性能优化时,对于计算密集型和 I/O 密集型还是有很大差别,需要分开来考虑。

水平扩展(Scale Out):只要增加服务器数量,就能线性扩充系统性能。通常增加服务器资源(CPU、内存、服务器数量),大部分时候是可以提高应用的并发能力和性能 (前提是应用能够支持多任务并行计算和多服务器分布式计算才行)。但水平扩展对系统架构设计是有要求的,难点在于:如何在架构各层进行可水平扩展的设计。

3. 高可用

高可用性(High Availability)指一个系统经过专门的设计,从而减少停工时间,保证服务的持续可用。

如高可用集群就是保证业务连续性的有效解决方案。

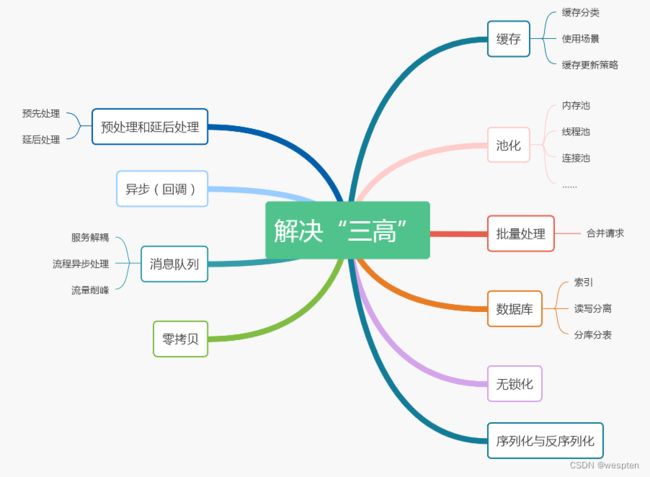

2、三高解决方案

主要粗浅地介绍了一些系统设计、系统优化的套路和最佳实践。

其实从缓存、消息队列到 CAS……很多看起来很牛逼的架构设计其实都来源于操作系统、体系结构。

这些底层的基础知识,看似古老的技术,却是经过时间洗礼留下来的好东西。现在很多的新技术、框架看似非常厉害,实则不少都是新瓶装旧酒,每几年又会被淘汰一批。

1. 缓存

1)什么是缓存

在计算机中,缓存是存储数据的硬件或软件组件,以便可以更快地满足将来对该数据的请求。存储在缓存中的数据可能是之前计算结果,也可能是存储在其他位置的数据副本。 ——维基百科

缓存本质来说是用空间换时间的思想,它在计算机世界中无处不在, 比如 CPU 就自带 L1、L2、L3 Cache,这在一般应用开发中关注较少,但在一些实时系统、大规模计算模拟、图像处理等追求极致性能的领域,就特别注重编写缓存友好的代码。

2)什么是缓存友好

简单来说,就是代码在访问数据的时候,尽量使用缓存命中率高的方式。

3)缓存为什么有效

缓存之所以能够大幅提高系统的性能,关键在于数据的访问具有局部性,也就是二八定律:「80% 的数据访问集中在 20% 的数据上」。这部分数据也被叫做热点数据。

缓存一般使用内存作为存储,内存读写速度快于磁盘,但容量有限,十分宝贵,不可能将所有数据都缓存起来。

如果应用访问数据没有热点,不遵循二八定律,即大部分数据访问并没有集中在小部分数据上,那么缓存就没有意义,因为大部分数据还没有被再次访问就已经被挤出缓存了。每次访问都会回源到数据库查询,那么反而会降低数据访问效率。

4)缓存分类

- 本地缓存

使用进程内成员变量或者静态变量,适合简单的场景,不需要考虑缓存一致性、过期时间、清空策略等问题。

可以直接使用语言标准库内的容器来做存储。

- 分布式缓存

当缓存的数据量增大以后,单机不足以承载缓存服务时,就要考虑对缓存服务做水平扩展,引入缓存集群。

将数据分片后分散存储在不同机器中,如何决定每个数据分片存放在哪台机器呢?一般是采用一致性 Hash 算法,它能够保证在缓存集群动态调整,在不断增加或者减少机器时,客户端访问时依然能够根据 key 访问到数据。

常用的中间件有 Memcache、 Redis Cluster 等。也可以在 Redis 的基础上,提供分布式存储的解决方案。

5)适合缓存的场景

- 读多写少

比如电商里的商品详情页面,访问频率很高,但是一般写入只在店家上架商品和修改信息的时候发生。如果把热点商品的信息缓存起来,这将拦截掉很多对数据库的访问,提高系统整体的吞吐量。

因为一般数据库的 QPS 由于有「ACID」约束、并且数据是持久化在硬盘的,所以比 Redis 这类基于内存的 NoSQL 的效率低不少,这常常是一个系统的瓶颈,如果我们把大部分的查询都在 Redis 缓存中命中了,那么系统整体的 QPS 也就上去了。

- 计算耗时大,且实时性不高

比如王者荣耀里的全区排行榜,一般一周更新一次,并且计算的数据量也比较大,所以计算后缓存起来,请求排行榜直接从缓存中取出,就不用实时计算了。

6)不适合缓存的场景

- 写多读少,频繁更新。

- 对数据一致性要求严格: 因为缓存会有更新策略,所以很难做到和数据库实时同步。

- 数据访问完全随机: 因为这样会导致缓存的命中率极低。

7)缓存更新的策略

如何更新缓存其实已经有总结得非常好的「最佳实践」,我们按照套路来,大概率不会犯错。策略主要分为两类:

- Cache-Aside

- Cache-As-SoR:SoR(System Of Record,记录系统)表示数据源,一般就是指数据库。

- Cache-Aside

这应该是最容易想到的模式了,获取数据时先从缓存读,如果 cache hit(缓存命中)则直接返回,若没命中就从数据源获取,然后更新缓存。

写数据的时候则先更新数据源,然后设置缓存失效,那么下一次获取数据的时候必然 cache miss,然后触发回源。

可以看出这种方式对于缓存的使用者是不透明的,需要使用者手动维护缓存。

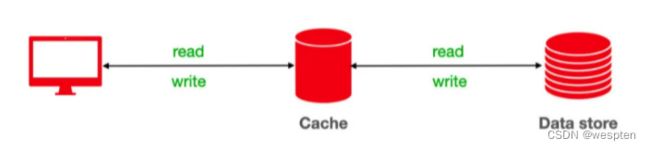

- Cache-As-SoR

从字面上来看,就是把 Cache 当作 SoR,也就是数据源,所以一切读写操作都是针对 Cache 的,由 Cache 内部自己维护和数据源的一致性。这样对于使用者来说就和直接操作 SoR 没有区别了,完全感知不到 Cache 的存在。

CPU 内部的 L1、L2、L3 Cache 就是这种方式,作为数据的使用方(应用程序),是完全感知不到在内存和我们之间还存在几层的 Cache,但是我们之前又提到编写 “缓存友好”的代码。这种策略不是透明的吗?这是不是冲突呢?

其实不然,缓存友好是指我们通过学习了解缓存内部实现、更新策略之后,通过调整数据访问顺序提高缓存的命中率。

Cache-As-SoR 又分为以下三种方式:

- Read Through:这种方式和 Cache-Aside 非常相似,都是在查询时发生 cache miss 去更新缓存,但是区别在于 Cache-Aside 需要调用方手动更新缓存,而 Cache-As-SoR 则是由缓存内部实现自己负责,对应用层透明。

- Write Through:直写式,就是在将数据写入缓存的同时,缓存也去更新后面的数据源,并且必须等到数据源被更新成功后才可返回。这样保证了缓存和数据库里的数据一致性。

- Write Back:回写式,数据写入缓存即可返回,缓存内部会异步的去更新数据源,这样好处是写操作特别快,因为只需要更新缓存。并且缓存内部可以合并对相同数据项的多次更新,但是带来的问题就是数据不一致,可能发生写丢失。

2. 预处理与延后处理

预先延后,这其实是一个事物的两面,两者的核心思想都是将本来该在实时链路上处理的事情剥离,要么提前处理、要么延后处理,以降低实时链路的路径长度, 这样能有效提高系统性能。

1)预处理

案例:

前段时间支付宝联合杭州市政府发放消费劵,但是要求只有杭州市常驻居民才能领取,那么需要在抢卷请求进入后台的时候就判断一下用户是否是杭州常驻居民。

而判断用户是否是常驻居民这个是另外一个微服务接口,如果直接实时的去调用那个接口,短时的高并发很有可能把这个服务也拖挂,最终导致整个系统不可用,并且 RPC 本身也是比较耗时的,所以就考虑在这里进行优化。

解决思路:

那么该怎么做呢?很简单的一个思路,提前将杭州所有常驻居民的 user_id 存到缓存中, 比如可以直接存到 Redis,大概就是千万量级。这样,当请求到来的时候我们直接通过缓存可以快速判断是否来自杭州常驻居民,如果不是则直接在这里返回前端。

这里通过预先处理减少了实时链路上的 RPC 调用,既减少了系统的外部依赖,也极大地提高了系统的吞吐量。

预处理在 CPU 和操作系统中也广泛使用,比如 CPU 基于历史访存信息,将内存中的指令和数据预取到 Cache 中,这样可以大大提高 Cache 命中率。 还比如在 Linux 文件系统中,预读算法会预测即将访问的 page,然后批量加载比当前读请求更多的数据缓存在 page cache 中,这样当下次读请求到来时可以直接从 cache 中返回,大大减少了访问磁盘的时间。

2)延后处理

还是支付宝的案例:

这是支付宝春节集五福活动开奖当晚。大家发现没有,这类活动中奖奖金一般会显示 「稍后到账」,为什么呢?那当然是到账这个操作不简单!

到账即转账,等于 A 账户给 B 账户转钱,A 减钱时,B 就必须要同时加上钱。也就是说不能 A 减了钱但 B 没有加上,这就会导致资金损失。资金安全是支付业务的生命线,这可不行。

这两个动作必须一起成功或是一起都不成功,不能只成功一半,这是保证数据一致性,保证两个操作同时成功或者失败就需要用到事务。

如果去实时的做到账,那么大概率数据库的 TPS(每秒处理的事务数) 会是瓶颈。通过产品提示,将到账操作延后处理,解决了数据库 TPS 瓶颈。

延后处理还有一个非常著名的例子,COW(Copy On Write,写时复制)。如 Linux 创建进程时调用 fork,fork 产生的子进程只会创建虚拟地址空间,而不会分配真正的物理内存,子进程共享父进程的物理空间,只有当某个进程需要写入的时候,才会真正分配物理页,拷贝该物理页,通过 COW 减少了很多不必要的数据拷贝。

3. 池化

后台开发过程中你一定离不开各种 「池子」: 内存池、连接池、线程池、对象池……

内存、连接、线程这些都是资源,创建线程、分配内存、数据库连接这些操作都有一个特征, 那就是创建和销毁过程都会涉及到很多系统调用或者网络 I/O,每次都在请求中去申请创建这些资源,就会增加请求处理耗时。如果我们用一个“容器(池)”把它们保存起来,下次需要的时候,直接拿出来使用,就可以避免重复创建和销毁所浪费的时间。

1)内存池

在 C/C++ 中经常会使用 malloc、new 等 API 动态申请内存。由于申请的内存块大小不一,如果频繁的申请、释放会导致大量的内存碎片,并且这些 API 底层依赖系统调用,会有额外的开销。

内存池就是在使用内存前,先向系统申请一块空间留做备用,使用者需要内池时则向内存池申请,用完后还回来。

内存池的思想非常简单,实现却不简单,难点在于以下几点:

- 如何快速分配内存

- 降低内存碎片率

- 维护内存池所需的额外空间尽量少

如果不考虑效率,我们完全可以将内存分为不同大小的块,然后用链表连接起来,分配的时候找到大小最合适的返回,释放的时候直接添加进链表。如:

![]()

当然这只是玩具级别的实现,业界有性能非常好的实现了,我们可以直接拿来学习和使用。

比如 Google 的“tcmalloc”和 Facebook 的“jemalloc”,如果感兴趣可以搜来看看,也推荐去看看被誉为神书的 CSAPP(《深入理解计算机系统》)那里也讲到了动态内存分配算法。

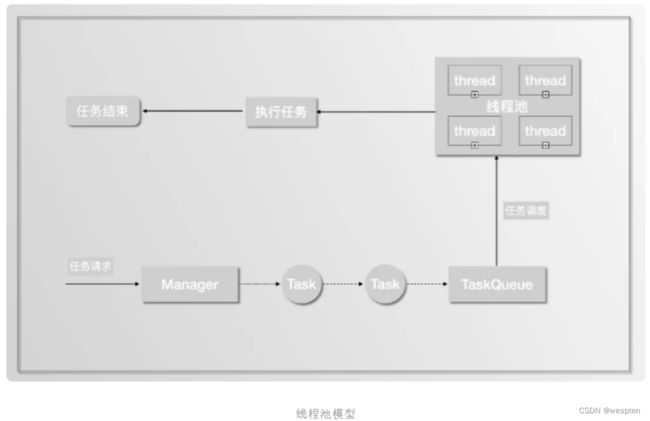

2)线程池

线程是干嘛的?线程就是我们程序执行的实体。在服务器开发领域,我们经常会为每个请求分配一个线程去处理,但是线程的创建销毁、调度都会带来额外的开销,线程过多也会导致系统整体性能下降。在这种场景下,我们通常会提前创建若干个线程,通过线程池来进行管理。当请求到来时,只需从线程池选一个线程去执行处理任务即可。

线程池常常和队列一起使用来实现任务调度,主线程收到请求后将创建对应的任务,然后放到队列里,线程池中的工作线程等待队列里的任务。

线程池实现上一般有四个核心组成部分:

- 管理器(Manager): 用于创建并管理线程池。

- 工作线程(Worker): 执行任务的线程。

- 任务接口(Task): 每个具体的任务必须实现任务接口,工作线程将调用该接口来完成具体的任务。

- 任务队列(TaskQueue): 存放还未执行的任务。

3)连接池

顾名思义,连接池是创建和管理连接的。

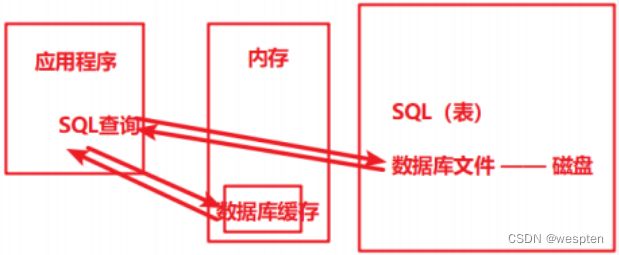

大家最熟悉的莫过于数据库连接池,这里我们简单分析下如果不用数据库连接池,一次 SQL 查询请求会经过哪些步骤:

- 和 MySQL server 建立 TCP 连接:三次握手

- MySQL 权限认证:

- Server 向 Client 发送密钥

- Client 使用密钥加密用户名、密码等信息,将加密后的报文发送给 Server

- Server 根据 Client 请求包,验证是否是合法用户,然后给 Client 发送认证结果

- Client 发送 SQL 语句

- Server 返回语句执行结果

- MySQL 关闭

- TCP 连接断开:四次挥手

可以看出不使用连接池的话,为了执行一条 SQL,会花很多时间在安全认证、网络 I/O 上。

如果使用连接池,执行一条 SQL 就省去了建立连接和断开连接所需的额外开销。

还能想起哪里用到了连接池的思想吗?HTTP 长链接也算一个变相的链接池,虽然它本质上只有一个连接,但是思想却和连接池不谋而合,都是为了复用同一个连接发送多个 HTTP 请求,避免建立和断开连接的开销。

池化实际上也是预处理和延后处理的一种应用场景,通过池子将各类资源的创建提前和销毁延后。

4. 异步(回调)

对于处理耗时的任务,如果采用同步的方式,会增加任务耗时,降低系统并发度。此时可以通过将同步任务变为异步进行优化。

- 同步:比如我们去 KFC 点餐,遇到排队的人很多,当点完餐后,大多情况下我们会隔几分钟就去问好了没,反复去问了好几次才拿到,在这期间我们也没法干活了,这个就叫同步轮循, 这样效率显然太低了。

- 异步:服务员被问烦了,就在点完餐后给我们一个号码牌,每次准备好了就会在服务台叫号,这样我们就可以在被叫到的时候再去取餐,中途可以继续干自己的事。

在很多编程语言中有异步编程的库,比如 C++ 的 std::future、Python 的 asyncio 等,但是异步编程往往需要回调函数(Callback function),如果回调函数的层级太深,这就是回调地狱(Callback hell)。回调地狱如何优化又是一个庞大的话题……

这个例子相当于函数调用的异步化,还有的情况是处理流程异步化,这个会在接下来消息队列中讲到。

5. 消息队列

![]()

这是一个非常简化的消息队列模型,上游生产者将消息通过队列发送给下游消费者。在这之间,消息队列可以发挥很多作用,比如:

1)服务解耦

有些服务被其它很多服务依赖,比如一个论坛网站,当用户成功发布一条帖子后,系统会有一系列的流程要做,有积分服务计算积分、推送服务向发布者的粉丝推送一条消息等,对于这类需求,常见的实现方式是直接调用:

但是如果此时需要新增一个数据分析的服务,那么又得改动发布服务,这违背了依赖倒置原则,即上层服务不应该依赖下层服务,那么怎么办呢?

引入消息队列作为中间层,当帖子发布完成后,发送一个事件到消息队列里,而关心帖子发布成功这件事的下游服务就可以订阅这个事件,这样即使后续继续增加新的下游服务,只需要订阅该事件即可,完全不用改动发布服务,完成系统解耦。

2)异步处理

有些业务涉及到的处理流程非常多,但是很多步骤并不要求实时性,那么我们就可以通过消息队列异步处理。

比如淘宝下单,一般包括了风控、锁库存、生成订单、短信/邮件通知等步骤,但是核心的就风控和锁库存,只要风控和扣减库存成功,那么就可以返回结果通知用户成功下单了。后续的生成订单,短信通知都可以通过消息队列发送给下游服务异步处理,这样可以大大提高系统响应速度。

这就是处理流程异步化。

3)流量削峰

一般像秒杀、抽奖、抢卷这种活动都会伴随短时间内海量的请求, 一般都超过后端的处理能力,那么我们就可以在接入层将请求放到消息队列里,后端根据自己的处理能力不断从队列里取出请求进行业务处理,起到平均流量的作用。

就像长江汛期,上游短时间大量的洪水汇聚直奔下游,但是通过三峡大坝将这些水缓存起来,然后匀速的向下游释放,起到了很好的削峰作用。

消息队列的核心思想就是把同步的操作变成异步处理,而异步处理会带来相应的好处,比如:

- 服务解耦。

- 提高系统的并发度,将非核心操作异步处理,这样不会阻塞主流程。

但是软件开发没有银弹,所有的方案选择都是一种 trade-off(权衡、取舍)。 同样,异步处理也不全是好处,也会导致一些问题:

- 降低了数据一致性,从强一致性变为最终一致性。

- 有消息丢失的风险,比如宕机,需要有容灾机制。

6. 批量处理

在涉及到网络连接、I/O 等情况时,将操作批量进行处理能够有效提高系统的传输速率和吞吐量。

在前后端通信中,通过合并一些频繁请求的小资源可以获得更快的加载速度。

比如我们后台 RPC 框架,经常有更新数据的需求,而有的数据更新的接口往往只接受一项,这个时候我们往往会优化下更新接口,使其能够接受批量更新的请求,这样可以将批量的数据一次性发送,大大缩短网络 RPC 调用耗时。

7. 数据库

我们常把后台开发调侃为“CRUD”(增删改查),可见数据库在整个应用开发过程中的重要性不言而喻。

而且很多时候系统的瓶颈也往往处在数据库这里,慢的原因也有很多,比如没用索引、没用对索引、读写锁冲突等等。

那么如何使用数据才能又快又好呢?下面这几点需要重点关注:

1)索引

索引可能是我们平时在使用数据库过程中接触得最多的优化方式。索引好比图书馆里的书籍索引号,想象一下,如果我让你去一个没有书籍索引号的图书馆找《人生》这本书,你是什么样的感受?当然是怀疑人生,同理,你应该可以理解当你查询数据却不用索引的时候,数据库该有多崩溃了吧。

数据库表的索引就像图书馆里的书籍索引号一样,可以提高我们检索数据的效率。索引能提高查找效率,可是你有没有想过为什么呢?这是因为索引一般而言是一个排序列表,排序意味着可以基于二分思想进行查找,将查询时间复杂度做到 O(logn),从而快速地支持等值查询和范围查询。

二叉搜索树的查询效率无疑是最高的,因为平均来说每次比较都能缩小一半的搜索范围,但是一般在数据库索引的实现上却会选择 B 树或 B+ 树而不用二叉搜索树,为什么呢?

这就涉及到数据库的存储介质了,数据库的数据和索引都是存放在磁盘,并且是 InnoDB 引擎是以页为基本单位管理磁盘的,一页一般为 16 KB。AVL 或红黑树的搜索效率虽然非常高,但是同样的数据项,它也会比 B、B+ 树(高度)更高,高就意味着平均来说会访问更多的节点,即磁盘 I/O 次数!

所以表面上来看我们使用 B、B+ 树没有二叉查找树效率高,但是实际上由于 B、B+ 树降低了树高,减少了磁盘 I/O 次数,反而大大提升了速度。

这也告诉我们,没有绝对的快和慢,系统分析要抓主要矛盾,先分析出决定系统瓶颈的到底是什么,然后才是针对瓶颈的优化。

下面是索引必知必会的知识,大家可以查漏补缺:

- 主键索引和普通索引,以及它们之间的区别

- 最左前缀匹配原则

- 索引下推

- 覆盖索引、联合索引

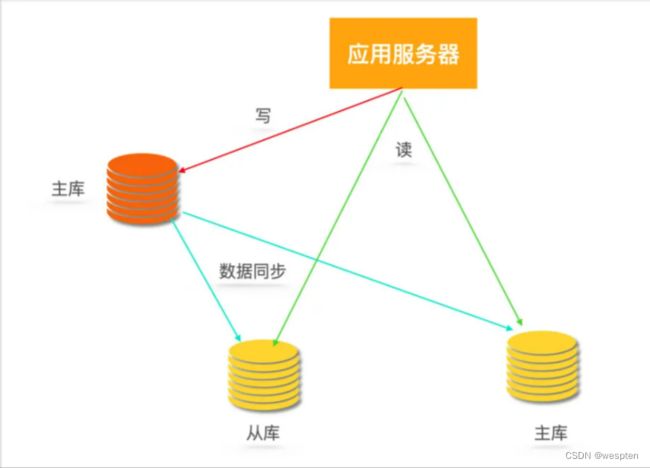

2)读写分离

一般业务刚上线的时候,直接使用单机数据库就够了,但是随着用户量上来之后,系统就面临着大量的写操作和读操作,单机数据库处理能力有限,容易成为系统瓶颈。

由于存在读写锁冲突,并且很多大型互联网业务往往读多写少,读操作会首先成为数据库瓶颈,我们希望消除读写锁冲突从而提升数据库整体的读写能力。

那么就需要采用读写分离的数据库集群方式,如一主多从,主库会同步数据到从库,写操作都到主库,读操作都去从库。

读写分离之后就避免了读写锁争用,这里解释一下,什么叫读写锁争用:

MySQL 中有两种锁:

- 排它锁(X 锁): 事务 T 对数据 A 加上 X 锁时,只允许事务 T 读取和修改数据 A。

- 共享锁(S 锁): 事务 T 对数据 A 加上 S 锁时,其他事务只能再对数据 A 加 S 锁,而不能加 X 锁,直到 T 释放 A 上的 S 锁。

读写分离解决问题的同时也会带来新问题,比如主库和从库数据不一致。

MySQL 的主从同步依赖于 binlog,binlog(二进制日志)是 MySQL Server 层维护的一种二进制日志,是独立于具体的存储引擎。它主要存储对数据库更新(insert、delete、update)的 SQL 语句,由于记录了完整的 SQL 更新信息,所以 binlog 是可以用来数据恢复和主从同步复制的。

从库从主库拉取 binlog 然后依次执行其中的 SQL 即可达到复制主库的目的,由于从库拉取 binlog 存在网络延迟等,所以主从数据同步存在延迟问题。

那么这里就要看业务是否允许短时间内的数据不一致,如果不能容忍,那么可以通过如果读从库没获取到数据就去主库读一次来解决。

3)分库分表

如果用户越来越多,写请求暴涨,对于上面的单 Master 节点肯定扛不住,那么该怎么办呢?多加几个 Master?不行,这样会带来更多的数据不一致的问题,且增加系统的复杂度。那该怎么办?就只能对库表进行拆分了。

常见的拆分类型有垂直拆分和水平拆分。

以拼夕夕电商系统为例,一般有订单表、用户表、支付表、商品表、商家表等,最初这些表都在一个数据库里。后来随着砍一刀带来的海量用户,拼夕夕后台扛不住了!于是紧急从阿狸粑粑那里挖来了几个 P8、P9 大佬对系统进行重构。

- P9 大佬第一步先对数据库进行垂直分库,根据业务关联性强弱,将它们分到不同的数据库,比如订单库,商家库、支付库、用户库。

- 第二步是对一些大表进行垂直分表,将一个表按照字段分成多表,每个表存储其中一部分字段。比如商品详情表可能最初包含了几十个字段,但是往往最多访问的是商品名称、价格、产地、图片、介绍等信息,所以我们将不常访问的字段单独拆成一个表。

由于垂直分库已经按照业务关联切分到了最小粒度,但数据量仍然非常大,于是 P9 大佬开始水平分库,比如可以把订单库分为订单 1 库、订单 2 库、订单 3 库……那么如何决定某个订单放在哪个订单库呢?可以考虑对主键通过哈希算法计算放在哪个库。

分完库,单表数据量任然很大,查询起来非常慢,P9 大佬决定按日或者按月将订单分表,叫做日表、月表。

分库分表同时会带来一些问题,比如平时单库单表使用的主键自增特性将作废,因为某个分区库表生成的主键无法保证全局唯一,这就需要引入全局 UUID 服务了。

经过一番大刀阔斧的重构,拼夕夕恢复了往日的活力,大家又可以愉快的在上面互相砍一刀了。

(分库分表会引入很多问题,并没有一一介绍,这里只是为了讲解什么是分库分表。)

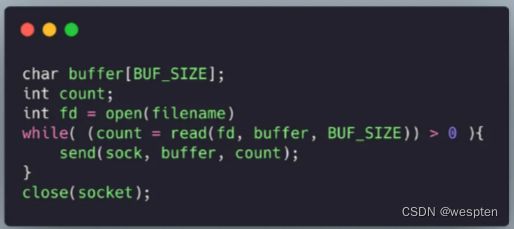

8. 零拷贝

高性能的服务器应当避免不必要数据复制,特别是在用户空间和内核空间之间的数据复制。 比如 HTTP 静态服务器发送静态文件的时候,一般我们会这样写:

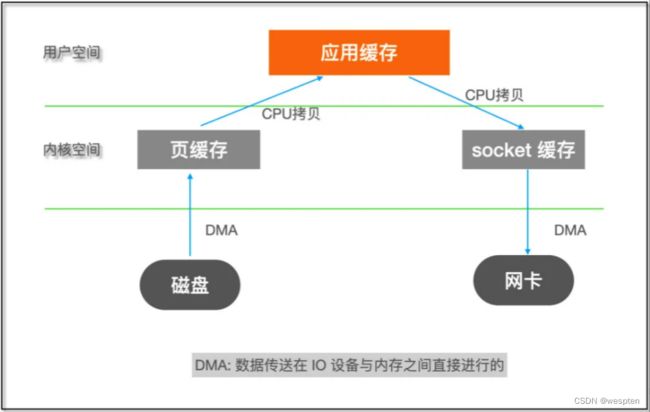

如果了解 Linux I/O 的话就知道这个过程包含了内核空间和用户空间之间的多次拷贝:

内核空间和用户空间之间数据拷贝需要 CPU 亲自完成,但是对于这类数据不需要在用户空间进行处理的程序来说,这样的两次拷贝显然是浪费。什么叫“不需要在用户空间进行处理”?

比如 FTP 或者 HTTP 静态服务器,它们的作用只是将文件从磁盘发送到网络,不需要在中途对数据进行编解码之类的计算操作。

如果能够直接将数据在内核缓存之间移动,那么除了减少拷贝次数以外,还能避免内核态和用户态之间的上下文切换。

而这正是零拷贝(Zero copy)干的事,主要就是利用各种零拷贝技术,减少不必要的数据拷贝,将 CPU 从数据拷贝这样简单的任务解脱出来,让 CPU 专注于别的任务。

常用的零拷贝技术

1)mmap

mmap 通过内存映射,将文件映射到内核缓冲区,同时,用户空间可以共享内核空间的数据。这样,在进行网络传输时,就可以减少内核空间到用户空间的拷贝次数。

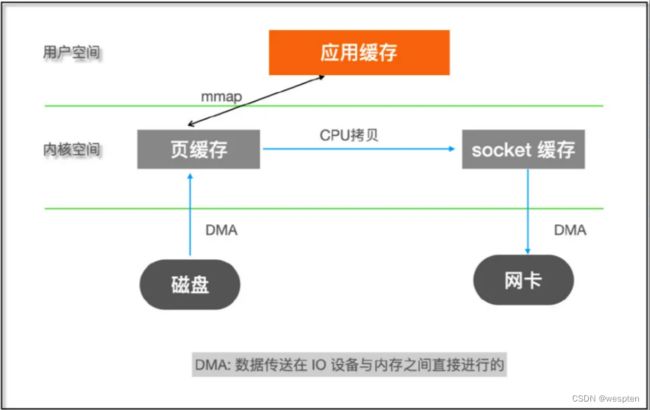

2)sendfile

sendfile 是 Linux 2.1 版本提供的,数据不经过用户态,直接从页缓存拷贝到 socket 缓存,同时由于和用户态完全无关,就减少了一次上下文切换。

在 Linux 2.4 版本,对 sendfile 进行了优化,直接通过 DMA 将磁盘文件数据读取到 socket 缓存,真正实现了“0”拷贝。前面 mmap 和 2.1 版本的 sendfile 实际上只是消除了用户空间和内核空间之间拷贝,而页缓存和 socket 缓存之间的拷贝依然存在。

9. 无锁化

在多线程环境下,为了避免竞态条件(race condition),我们通常会采用加锁来进行并发控制。锁的代价也是比较高的,锁会导致上下文切换,甚至被挂起直到锁被释放。

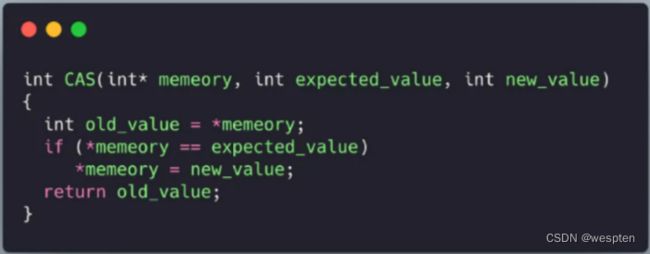

基于硬件提供的原子操作“CAS(Compare And Swap)”实现了一些高性能无锁的数据结构,比如无锁队列,可以在保证并发安全的情况下,提供更高的性能。

首先需要理解什么是 CAS,CAS 有三个操作数,内存里当前值 M、预期值 E、修改的新值 N,CAS 的语义就是:

如果当前值等于预期值,则将内存修改为新值,否则不做任何操作。

用 C 语言来表达就是:

注意,上面的 CAS 函数实际上是一条原子指令,那么该如何使用呢?

假设我需要实现这样一个功能:对一个全局变量 global 在两个不同线程分别对它加 100 次,这里多线程访问一个全局变量存在 race condition,所以我们需要采用线程同步操作,下面分别用锁和 CAS 的方法来实现这个功能。

CAS 和锁示范:

通过使用原子操作大大降低了锁冲突的可能性,提高了程序的性能。

除了 CAS,还有一些硬件原子指令:

- Fetch-And-Add:对变量原子性 + 1。

- Test-And-Set:这是各种锁算法的核心,在 AT&T/GNU 汇编语法下,叫 xchg 指令。

10. 序列化与反序列化

所有的编程一定是围绕数据展开的,而数据呈现形式往往是结构化的,比如结构体(Struct)、类(Class)。 但是当我们通过网络、磁盘等传输、存储数据的时候却要求是二进制流。 比如 TCP 连接,它提供给上层应用的是面向连接的可靠字节流服务。那么如何将这些结构体和类转化为可存储和可传输的字节流呢?这就是序列化要干的事情,反之,从字节流如何恢复为结构化的数据就是反序列化。

序列化解决了对象持久化和跨网络数据交换的问题。

序列化一般按照序列化后的结果是否可读,而分为以下两类:

1)文本类型

如 JSON、XML,这些类型可读性非常好,语义是自解释的。也常常用在前后端数据交互上,如接口调试时可读性高,非常方便。但是缺点就是信息密度低,序列化后占用空间大。

2)二进制类型

如 Protocol Buffer、Thrift 等,这些类型采用二进制编码,数据组织得更加紧凑,信息密度高,占用空间小,但是带来的问题就是基本不可读。

像 Java、Python 便内置了序列化方法,比如在 Java 里实现了 Serializable 接口即表示该对象可序列化。

四、性能测试流程设计

1、性能测试理论

1. 性能测试概念

性能:就是软件质量属性中的“效率”特性。

效率的特性:

-

时间特性:指系统处理用户请求的响应时间。

-

资源特性:指系统在运行过程中,系统资源的消耗情况。

- CPU 使用率

- 内存使用率

- 磁盘 I/O

- 网络带宽使用率

- ...

什么是性能测试?

性能测试是指通过自动化测试工具模拟正常、峰值以及异常的负载条件,来对系统的各项性能指标进行测试和评估的过程。

- 后台程序的处理性能(代码性能)

- 中间件、数据库、架构设计等是否存在瓶颈

- 服务器资源消耗(CPU、内存、磁盘、网络)

- ...

2. 性能测试目的

-

评估当前系统能力。

- 例如:验收第三方提供的软件。

- 例如:获取关键的性能指标,与其他类似产品进行比较。

-

基于性能需求目标的测试验证。

-

精准容量规划,并验证系统容量的可扩展性。

- 根据各模块的承载量进行适当地收缩,来让出更多的可用资源

3. 性能测试策略

主要分为:

- 基准测试

- 负载测试

- 稳定性测试

- 其他:并发测试、压力测试、容量测试等

1)基准测试

狭义:也就是单用户测试。在测试环境确定以后,对业务模型中的重要业务做单独的测试,获取单用户运行时的各项性能指标,以进行基础的数据采集。

- 如:一个用户迭代 100 次,关注响应时间(事务成功率需 100%)。

广义:是一种测量和评估软件性能指标的活动。你可以在某个时刻通过基准测试建立一个已知的性能水平(称为基准线),当系统的软硬件环境发生变化之后再进行一次基准测试以确定那些变化对性能的影响。

- 如:先在 V1.0 版本的生产环境上进行性能测试收集所有的性能指标作为基准测试。

- 再在 V1.1 的开发版本上,使用与 V1.0 基准测试时相同的环境、配置、用户量等进行性能测试,再收集性能指标。

- 查看 V1.1 版本的性能是否比 V1.0 有所提升。

基准测试数据的用途:

- 为多用户并发测试和综合场景测试等性能分析提供参考依据。

- 识别系统或环境的配置变更对性能响应带来的影响。

- 为系统优化前后的性能提升/下降提供参考指标。

2)负载测试

含义:负载测试是指获取各个事务在不同负载条件下的性能表现。通过逐步增加系统负载量,测试系统性能的变化,并最终确定在满足系统的性能指标情况下,系统所能够承受的最大负载量的测试。

- 负载:指向服务器发送的请求数量。请求越多,负载越高。

- 负载测试关注的重点是逐步增加压力。如:分别用 10、20、30、...个并发用户跑 10 分钟。

- 通过负载测试,一般能找到系统的最优负载和最大负载。

示例:健身举哑铃

- 10斤哑铃,举起10个,需要15s

- 20斤哑铃,举起10个,需要15s

- 30斤哑铃,举起10个,需要15s —— 最优负载

- 40斤哑铃,举起10个,需要20s —— 最优负载

- 50斤哑铃,举起10个,需要40s

- 60斤哑铃,举起10个,需要100s —— 最大负载

- 70斤哑铃,举不起来

3)稳定性测试

含义:稳定性测试是指在服务器稳定运行(用户正常的业务负载下)的情况下进行长时间测试,并最终保证服务器能满足线上业务需求。时长一般为一天、一周等。

4)其他类型

并发测试:

-

广义:在极短的时间内发送多个请求,来验证服务器对并发的处理能力。如:抢红包、抢购、秒杀活动等。

-

狭义:模拟多用户在同一时间访问同一应用(进行同一具体操作)的测试,用于发现并发问题,例如线程锁、资源争用、数据库死锁等。

容量测试:

关注软件在极限压力下的各个参数值。例如:最大 TPS、最大连接数、最大并发数、最大数据条数等。

压力测试:

压力测试是在强负载(大数据量、大量并发用户等)下的测试,查看应用系统在峰值使用情况下操作行为,从而有效地发现系统的某项功能隐患、系统是否具有良好的容错能力和可恢复能力。

压力测试分为高负载下的长时间(如 24 小时以上)的稳定性压力测试,和极限负载情况下导致系统崩溃的破坏性压力测试。

-

稳定性压力测试:在系统高负载的情况下(下图中接近 C 点),长时间运行(24 小时),查看系统的处理能力。

-

破坏性压力测试:在系统极限负载的情况下(下图中 C-D 点),对系统进行压力测试,查看系统容错能力和错误恢复能力。

4. 性能测试指标

性能指标:在性能测试的过程中,记录一系列的测试数据值,用这些实际记录的数据值与需求中的性能要求做对比,达标则表示性能测试通过;未达标则可能是性能 Bug。

不同人群关注的性能指标各有侧重。前台服务接口的调用者一般只关心吞吐量、响应时间等外部指标。后台服务的所有者则不仅仅关注外部指标,还会关注 CPU、内存、负载等内部指标。

拿某打车平台来说,用户所关心的是智能提示服务的外部指标能不能抗住因大波优惠所导致的流量激增;而对于智能提示服务的开发、运维、测试人员,不仅仅关注外部指标,还会关注 CPU、内存、IO 等内部指标,以及部署方式、服务器软硬件配置等运维相关事项。

常见的性能指标:响应时间、并发数、吞吐量、错误率、点击数、PV/UV、系统资源利用率等。

-

3 个关键的业务指标:

- 响应时间

- 并发数

- TPS/QPS(吞吐量)

-

系统资源指标:

- CPU

- 内存

- 磁盘 I/O

- 网络带宽使用率

1)响应时间

含义:系统处理一个请求或一个事务的耗时(客户端从发起请求到获取响应)。

响应时间是终端用户对系统性能的最直观印象,包括了系统响应时间和前端展现时间。

- 系统响应时间:反应的是系统能力,又可以进一步细分为应用系统处理时间、数据库处理时间和网络传输时间等。

- 前端展现时间:取决于客户端收到服务器返回的数据后渲染页面所消耗的时间。

因此,性能测试又分为后端(服务器端)的性能测试和前端(通常是浏览器端)的性能测试。

系统响应时间 = 应用程序处理时间(A1+A2+A3) + 网络传输时间(N1+N2+N3+N4)

响应时间的指标取决于具体的服务类型。

- 如智能提示一类的服务,返回的数据有效周期短(用户多输入一个字母就需要重新请求),且对实时性要求比较高,则响应时间的上限一般在 100ms 以内。

- 而导航一类的服务,由于返回结果的使用周期比较长(整个导航过程中),响应时间的上限一般在 2-5s。

对于响应时间的统计,应从均值、.90、.99 等多个分布的角度统计,而不仅仅是给出均值。

50 th(60/70/80/90/95 th):如果把响应时间从小到大顺序排序,那么 50% 的请求的响应时间在这个范围之内。后面的 60/70/80/90/95 th 也是同样的含义。

常见瓶颈:同一请求/事务的响应时间忽大忽小。

在正常吞吐量下发生此问题,可能的原因有两方面:

- 服务对资源的加锁逻辑有问题,导致处理某些请求过程中花了大量的时间等待资源解锁。

- 硬件服务器本身分配给服务的资源有限,某些请求需要等待其他请求释放资源后才能继续执行。

2)并发数

含义:在同一时刻与服务器正常进行交互的用户数量。

- 系统用户数:系统注册的总用户数。

- 在线用户数:某段时间内访问系统的用户数,这些用户并不一定同时向系统提交请求。

- 并发用户数:某一物理时刻同时向系统提交请求的用户数。

3)吞吐量

含义:吞吐量(Throughput)是指在单位时间内,系统处理客户端请求的数量。

吞吐量 = 并发数 / 响应时间

从不同维度来描述:

- “Bytes/Second”和“Pages/Second”表示的吞吐量,主要受网络设置、服务器架构、应用服务器制约。

- “Requests/Second”和“Transactions/Second”表示的吞吐量,主要受应用服务器和应用本身实现的制约。

吞吐量是衡量服务器性能好坏的直接指标,通常表现如下:

-

在系统处于轻压力区(未饱和)时,并发用户数上升,平均响应时间(基本不变),系统吞吐量(上升)。

-

在系统处于重压力区(基本饱和)时,并发用户数上升,平均响应时间(上升),系统吞吐量(基本不变)。

-

在系统处于崩溃区(压力过载)时,并发用户数上升,平均响应时间(上升),系统吞吐量(下降)。

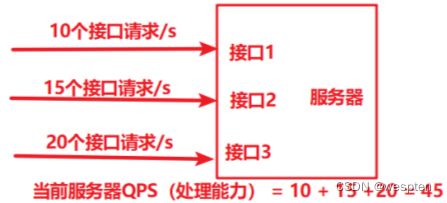

QPS

含义:服务器每秒钟处理的接口请求数量(一个服务器中有多个接口,QPS 指的是所有接口在同一个单位时间内的被处理数量之和)。

TPS

含义:服务器每秒钟处理的事务请求数量。

一个事务通常指的是界面上的一个业务场景操作。一个事务可以包含一个或者多个接口请求。

一个业务请求发送给服务器后,最终会定位到服务器对应的业务请求的代码,既有可能是一段代码也有可能是多段代码。

示例:

- 登录操作:发送一个登录请求 —— 则登录事务对应 1 个接口请求

- 支付操作:查询用户余额请求 + 支付安全校验请求 + 支付请求 —— 则支付事务对应 3 个接口请求

结论:

- 对于登录事务而言,当 TPS 为 10 时,服务器的 QPS 也是 10。

- 对于支付事务而言,当 TPS 为 10 时,服务器的 QPS 就是 30。

吞吐量计算方法:

- 均值计算

TPS = 总的请求数 / 总的时间

问题:对于同一天的时间内,不同的时间段,请求速率会有波动,这样计算会被平均掉,法测试负载高的情况。

- 二八原则

含义:80% 的请求数会集中在 20% 的时间内完成。

TPS = 总的请求数 * 80% / 总的时间 * 20%

通常二八原则的计算方法会比平均的计算方式更具代表性和准确。

- 按照每天的具体业务数据进行计算(稳定性测试 TPS)

当获取每天的具体业务统计数据时,就可以统计出业务请求集中的时间段作为有效业务时间;并统计有效业务时间内的总请求数

TPS = 有效业务时间的总请求数 * 80% / 有效业务时间 * 20%

- 模拟用户峰值业务操作的并发量:(压力测试 TPS)

获取每天的交易峰值的时间段,及这个时间段内的所有请求的数量。

TPS = 峰值时间内的请求数 / 峰值时间段 * 系数(倍数)

系数可以是 2、3、6、10,根据要达成的性能指标而定。

5. 案例

某购物商城,经过运营统计,正常一天成交额为 100 亿,客单价平均为 300 元,交易时间主要为 10:00-14:00 以及 17:00-24:00,其中 19:00-20:00 的成交量最大,大约成交 20 亿。

现升级系统,需要进行性能测试,保证软件在上线后能稳定运行。

请计算出系统稳定性测试时的并发(负载)量,及保证系统峰值业务时的并发(负载)量。

稳定性分析:

- 有效的交易时间为 10:00-14:00、17:00-24:00,一共为 7 个小时

- 有效的请求数:100e / 300

- 稳定性 TPS = 100e / 300 * 80% / (7 * 3600 * 20%)

压力分析:

- 峰值的交易时间为 19:00-20:00,一共为 1 个小时

- 有效的请求数:20e / 300

- 峰值 TPS = 20e / 300 / 3600 * 系数

6. 系统资源利用率

含义:指系统各种资源的使用情况。一般用“资源的使用量/总的资源可用量×100%”形成资源利用率的数据。

建议:没有特殊需求时,通常要求如下:

- CPU 不高于 80%(±5)

- 内存不高于 80%

- 磁盘不高于 90%

- 网络不高于 80%

7. 其他指标

1)点击数

点击数是衡量 Web 服务器处理能力的一个重要指标。

- 点击数不是通常一般人认为的访问一个页面就是 1 次点击数,而是指该页面包含的元素(图片、链接、框架等)向 Web 服务器发出的请求数量。

- 通常我们也用每秒点击次数(Hits per Second)指标来衡量 Web 服务器的处理能力。

- 注意:只有 Web 项目才有此指标。

2)错误率

含义:指系统在负载情况下,失败业务(取决于断言结果)的占比。

错误率=(失败业务数/业务总数)*100%

- 不同系统对错误率要求不同,但一般不超过千分之五。

- 稳定性较好的系统,其错误率应该由超时引起,即为超时率。

2、性能需求分析

性能需求分析是整个性能测试工作开展的基础,性能需求分析做的好不好直接影响到性能测试的结果。

性能需求分析通常包含的内容如下:

-

熟悉被测系统

- 熟悉系统的业务功能

- 熟悉系统的技术架构

-

确定性能测试指标

- 有需求:按照需求进行测试

- 没有需求:查找相关资料、与同类型软件对比、对未来数据进行预估等

-

明确性能测试内容

- 从业务角度,挑选核心业务进行测试

- 从技术角度,挑选逻辑复杂度高、数据量大的业务进行测试

-

确定性能测试策略

- 负载测试、稳定性测试等

1. 测试指标

性能测试指标要可测量,如定量指标给出具体数值,定性指标要给出具体描述。

- 吞吐量(TPS/QPS)

- 事务响应时间

- 用户并发数

- 数据库的数据量

- 系统的稳定运行时间要求

- 是否需要考虑系统支持水平扩展

- 考虑系统的最大容量

性能测试指标的来源一般如下:

1)需求文档

-

客户明确需求:通常情况,客户有明确的需求,提出一些性能测试指标。例如:每秒登录用户量多少,用户在线总量多少等。

-

客户隐形需求:基于客户明确指标下,会有一些隐性指标,例:100 万在线用户的查询在 5 秒响应,我们也许纳入性能测试指标内。

-

用户模型确定:有了上述性能测试指标后,就可以创建我们的用户模型了。如下:

- 用户指标:用户登录 TPS 需达到 50;

- 用户总量:总用户量 100 万;

- 用户模型:系统每天用户在线量在 100 万左右,平均在早晨 08:00-11:00 期间登录,其中登录与查询的比例为 1:5。

2)运营数据

根据历史运营数据收集、分析业务数据,如:

- 注册用户数、日活、月活等?计算用户的增长速度

- 每月、每周、每天的峰值业务量是多少?

- 用户频繁使用的功能模块、业务场景是哪些?

2. 测试内容

测试范围:

- 哪些接口要进行性能测试和稳定性测试。

- 哪些页面业务逻辑要进行性能测试和稳定性测试。

关注重点:

-

针对新增或重构模块:进行全面的测试,优先覆盖典型场景。典型场景如下示例:

- 核心业务功能

- 用户频繁使用的业务功能

- 特殊交易日或峰值交易的业务功能

- 发生过性能问题的业务功能

- 资源占用高的业务功能

- 代码优化过的业务功能

- ...

-

针对继承模块:进行回归验证即可,不做探索性的性能测试。

3. 测试策略

分析步骤:

- 根据上述性能测试内容的提取方法,整理出需要进行性能测试的测试点。

- 根据性能指标计算方法,得到每个测试点要满足的性能。

案例:

- 针对每个核心的业务功能(接口)都要达到对应的性能指标要求。

- 基于业务流程(多个接口的组合)来测试是否达到性能指标的要求。

- 模拟用户真实的业务场景,进行长时间的稳定性测试。

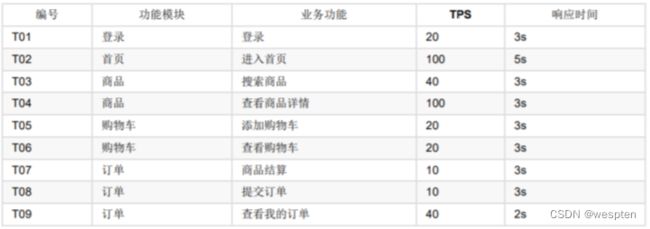

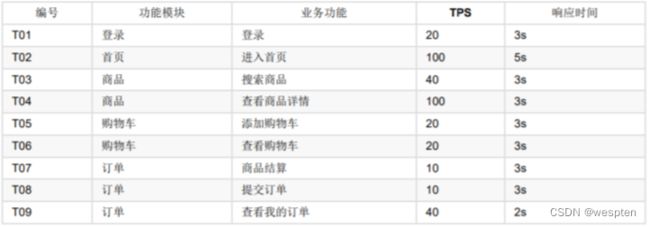

期望的 TPS 和最大响应时间,如下:

3、性能测试计划

在实际工作中,通常有性能测试的计划模板,对照模板进行编写即可。

通常包含内容如下:

- 测试背景 —— 背景介绍

- 测试目的 —— 需求分析阶段确定的项目需要达成的性能目标

- 测试范围 —— 需求分析阶段确定的性能测试点

- 测试策略 —— 结合前面的测试范围,考虑使用什么样的方式来进行性能测试,可以达成对应的测试目标

- 风险控制 —— 管理型分析(从技术、人员、时间、进度各个方面考虑可能会出现的问题及如何解决这些问题)

- 进度与分工 —— 说明性能测试工作要分为哪几个步骤进行,每个步骤的开始/结束时间,及对应的负责人

- 交付清单 —— 对应进度安排中每个阶段的阶段产物

案例如下:

1. 测试背景

轻商城是公司新开发的一个电商项目,为了保证项目上线后能够稳定的运行,且在后期推广中能够承受用户的增长,需要对项目进行性能测试。

2. 测试目的

对新电商项目进行性能测试的核心目的包括:

- 确定核心业务功能的 TPS。

- 对业务流程(多接口组合)进行压测。

- 系统能在实际系统运行压力的情况下,稳定的运行 24 小时。

3. 测试范围

通过对性能测试需求的调研和分析,确定被测系统的测试范围如下:

4. 测试策略

1. 基准测试

- 先做基准测试,确定估算的标准。

2. 负载测试

-

通过逐步增加系统负载,测试系统性能的变化,并最终确定在满足系统的性能指标情况下,系统所能够承受的最大负载量的测试。

-

分别模拟 5、10、30、50、100 个用户对系统进行负载测试,查看不同并发时系统软件各项指标是否符合需求。

3. 稳定性测试

-

用 200 个用户对系统进行 7*24 小时不间断的稳定性测试,验证系统在长时间的正常负载下的表现是否正常。

- 是否发生内存、句柄、连接等泄露;

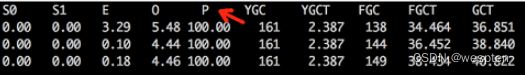

- 是否正常触发 fullgc(JVM 调优就是为了减少 fullgc 频率);

- 数据库的容量问题;

- ...

5. 风险控制

| 风险类型 | 风险描述 | 风险级别 | 应对方案 |

|---|---|---|---|

| 环境风险 | 找不到合适的软硬件等资源 | 高 | 测试前期阶段识别,并使用相近配置进行验证,后期需在测试报告中提出 |

| 环境风险 | 部署出现问题,联调进度缓慢 | 高 | 更换环境;增加资源配置 |

| 人力风险 | 测试周期紧张,需要多名测试人员同时进行测试,但具备性能测试能力的人员不足 | 高 | 延长测试周期,或在前期培训相应人员 |

| 数据风险 | 构造测试数据时间较长 | 高 | 开发人员协助 |

| 交付风险 | 发现比较严重的 Bug | 高 | 延长测试时间,增加对应人员 |

6. 交付清单

性能测试计划、性能测试脚本、性能缺陷统计和性能测试报告等。

7. 进度与分工

4、性能测试用例设计

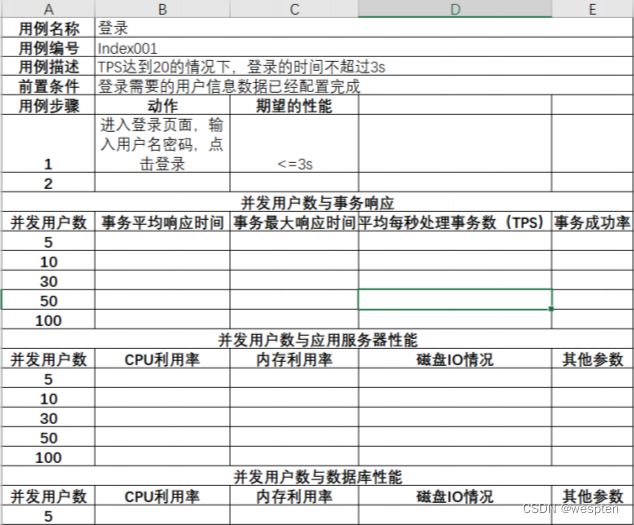

可参考如下性能测试用例的模板来编写:

- 对于单个业务功能(接口)的性能测试,每个测试点编写一个测试用例(如果多个接口有强关联,可以将多个接口放入同一个用例)。

- 对于多个业务功能的组合测试,需按照用户实际的业务场景,挑选出有代表性的业务流程编写测试用例。

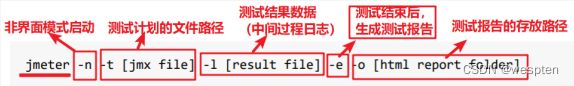

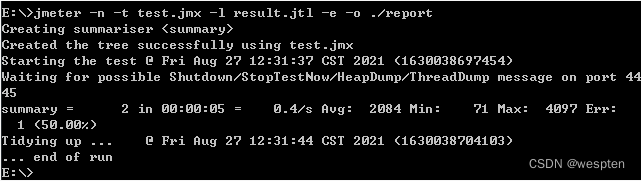

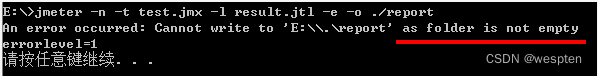

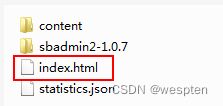

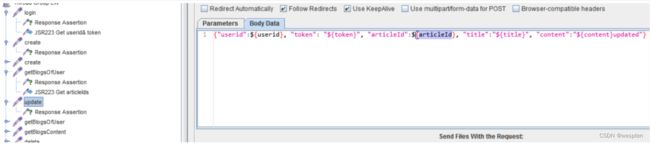

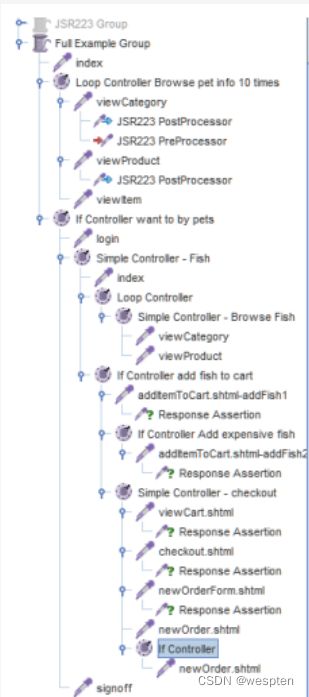

5、性能测试脚本开发

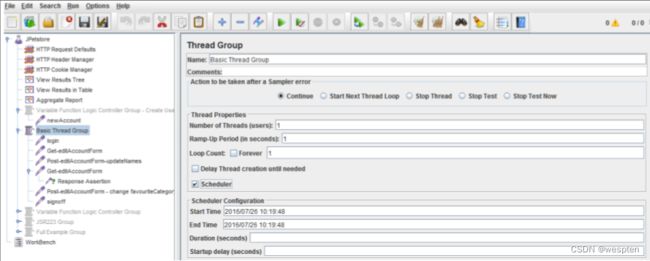

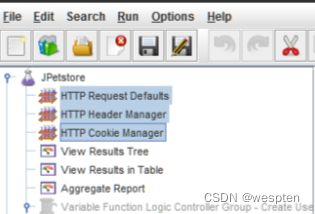

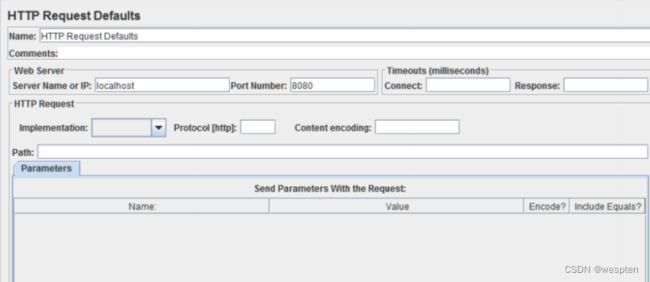

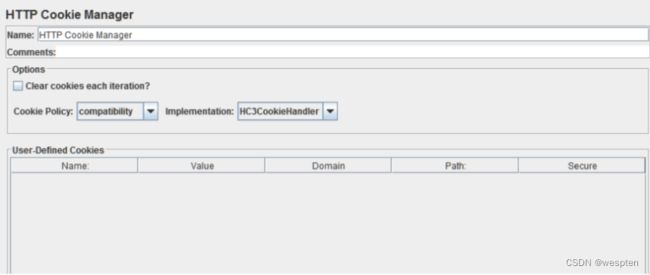

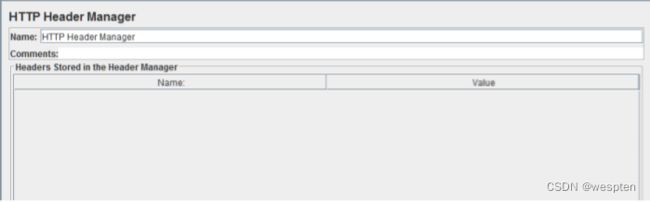

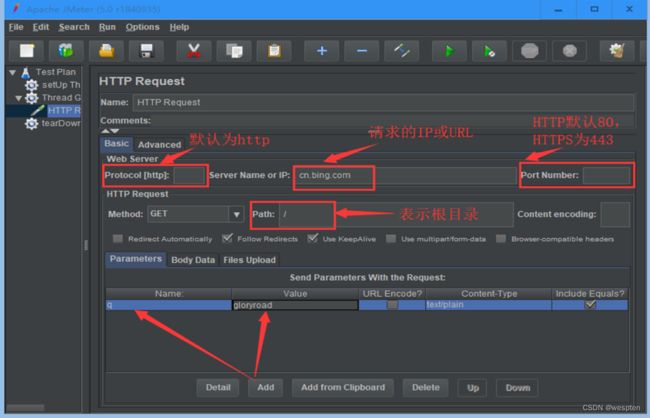

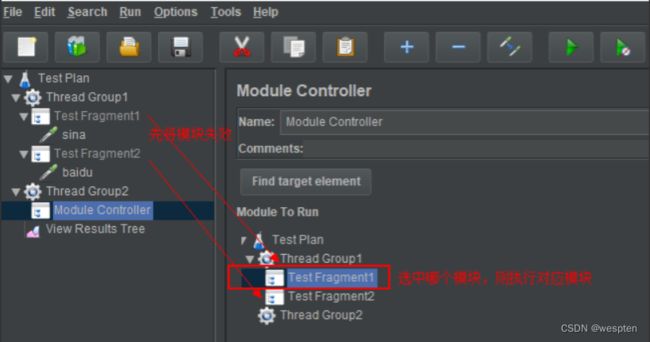

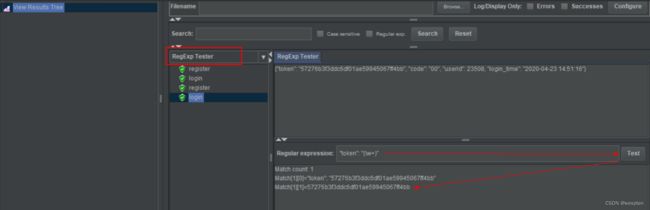

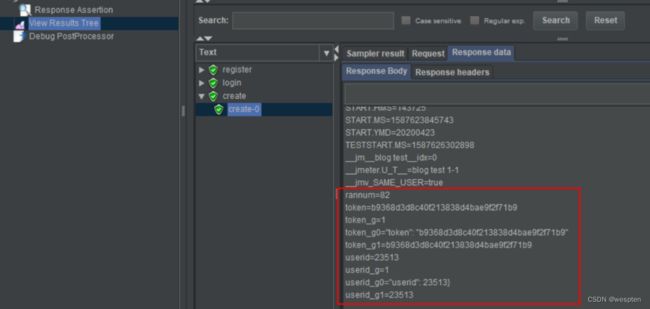

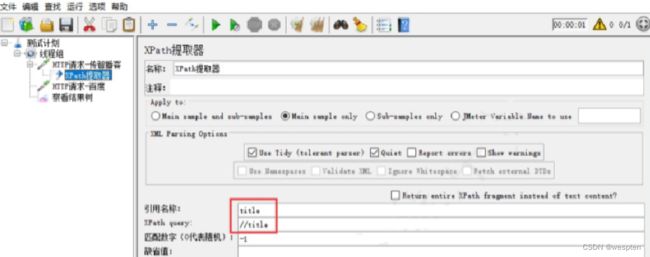

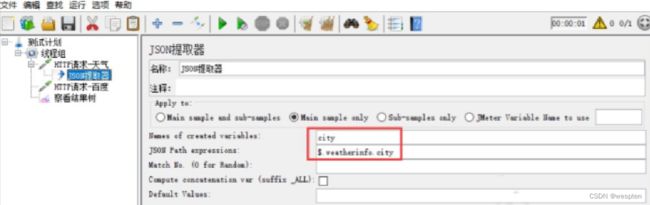

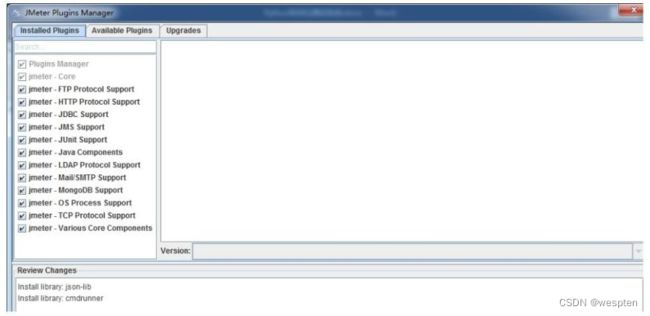

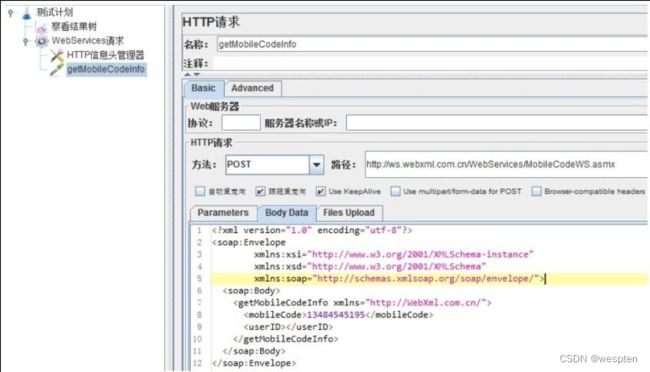

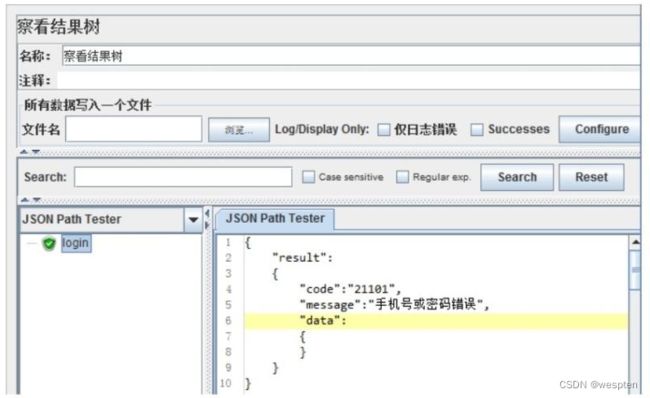

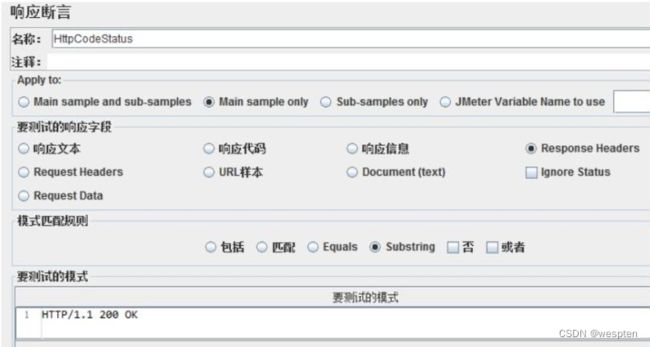

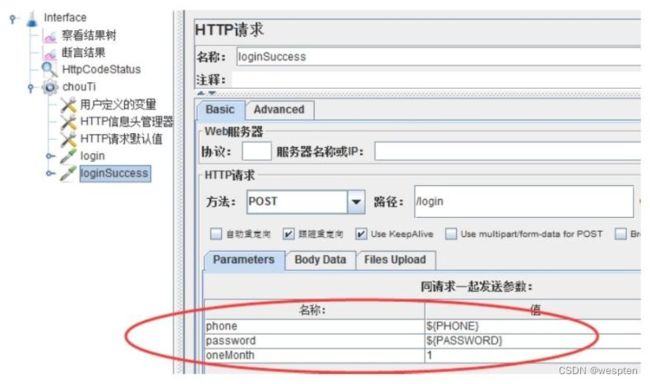

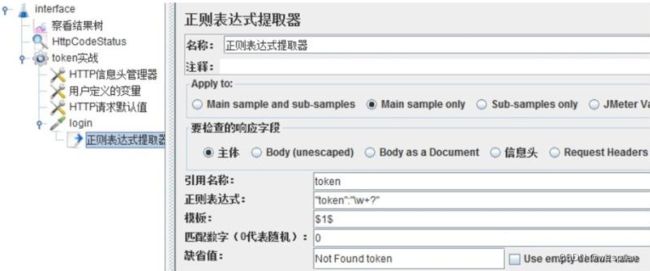

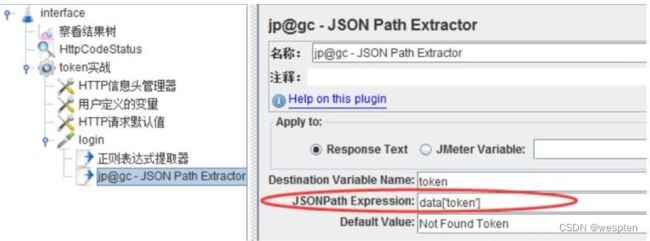

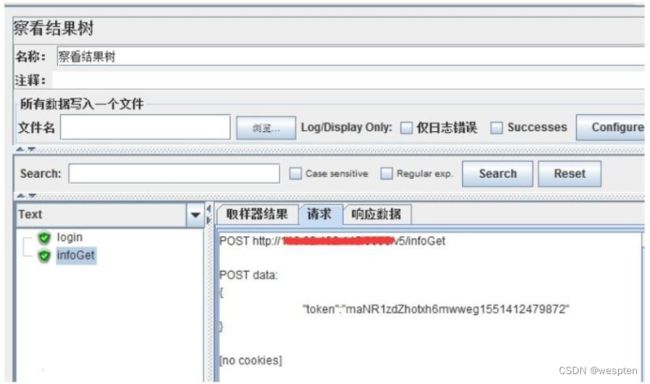

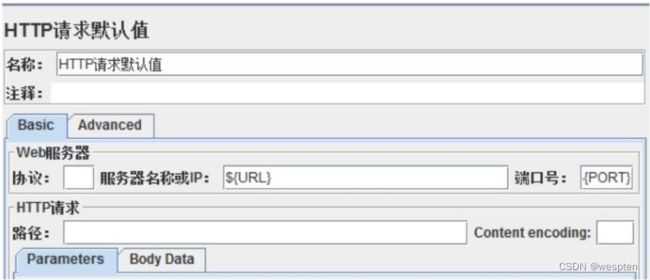

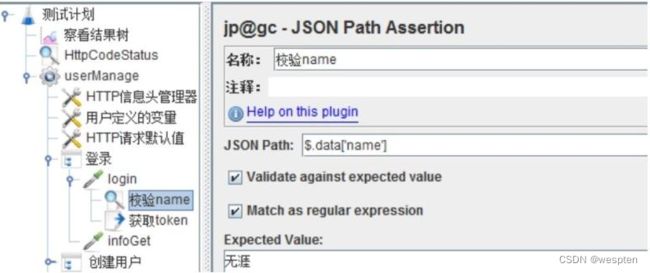

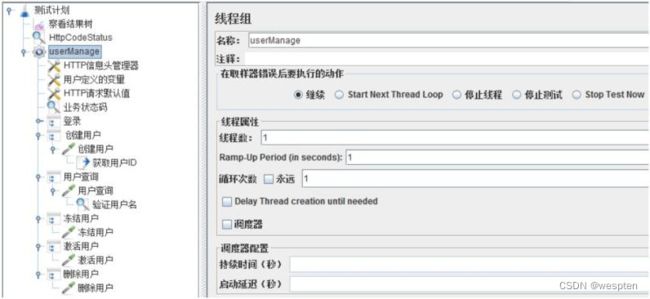

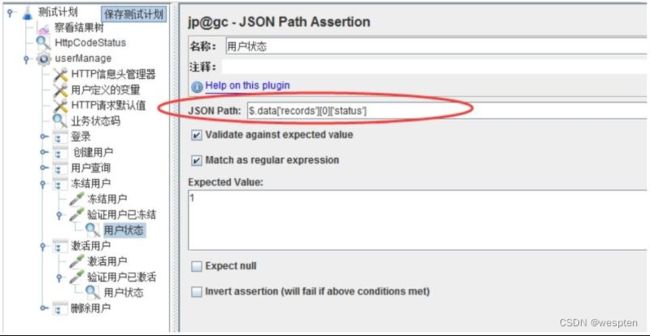

示例:使用 JMeter 编写测试脚本并调试,常用测试元件如下:

- 取样器 —— HTTP 请求

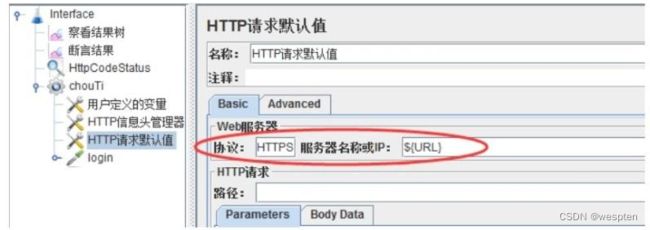

- 配置元件 —— HTTP 请求默认值

- 配置元件 —— 用户定义的变量

- 后置处理器 —— JSON 提取器

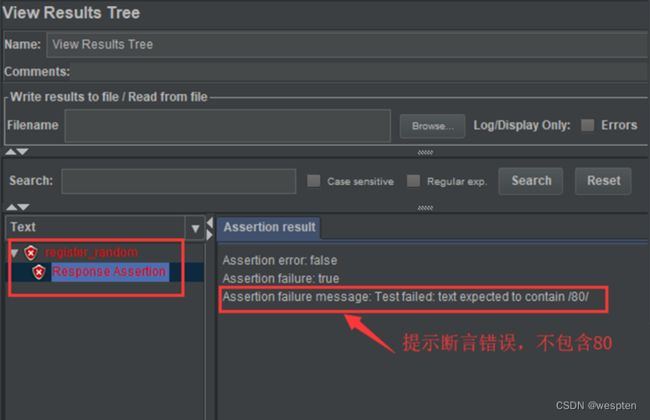

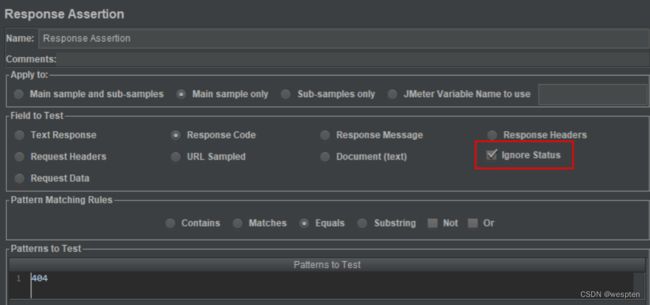

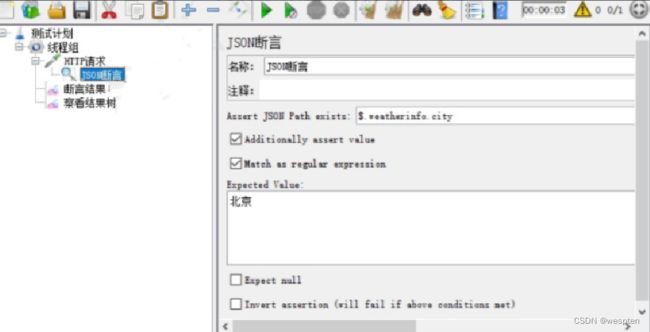

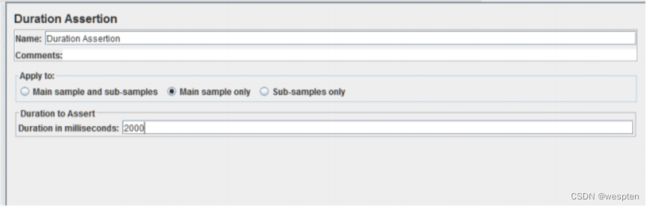

- 断言 —— 响应断言

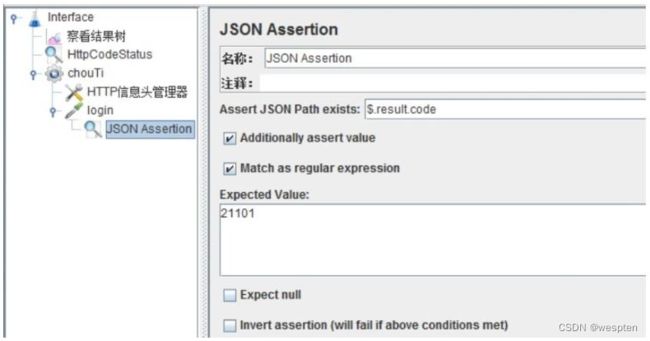

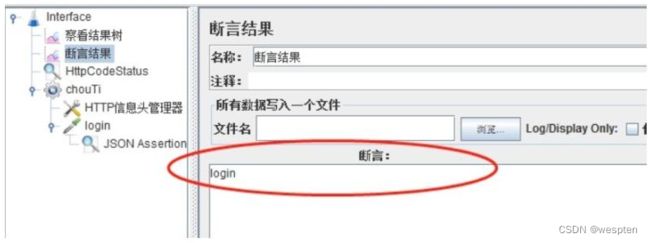

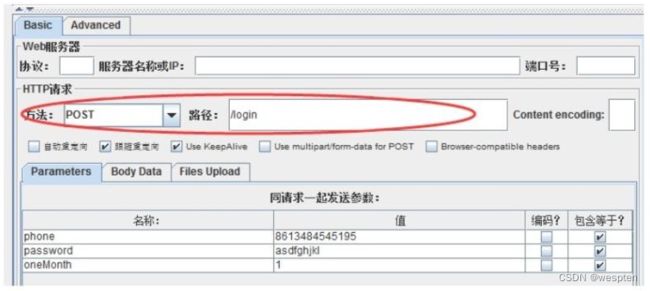

- 断言 —— JSON 断言

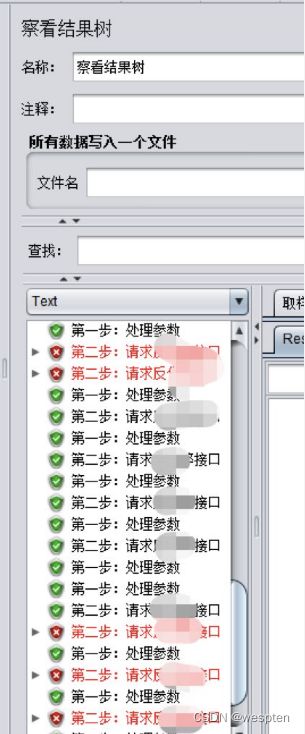

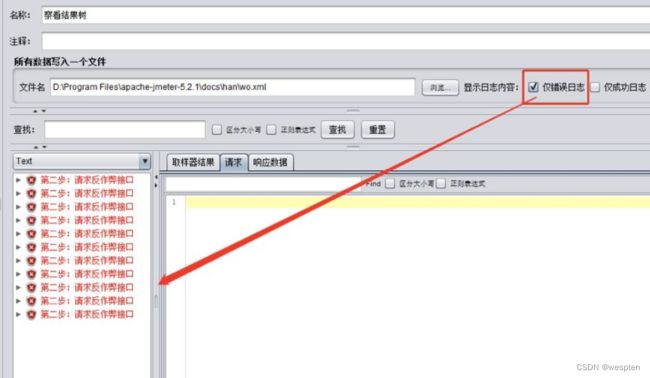

- 监听器 —— 察看结果树

- 监听器 —— 聚合报告

基础结构如下:

6、性能测试资源准备

1. 测试环境

在进行性能则试之前,需要先完成性能测试环境的搭建工作,测试环境一般包括硬件环境、软件环境及网络环境。

性能测试环境的特点:

- 性能测试对测试环境的独立性要求更高,更为严格。

- 如果某环境下运行多个系统,就很难判断其中的某个环境对资源的占用情况。

尽量保持性能测试环境与真实生产环境的一致性:

- 硬件环境

- 包括服务器环境、网络环境等

- 软件环境

- 版本一致性:包括操作系统、数据库、被测应用程序、第三方软件等

- 配置一致性:包括操作系统、数据库、被测应用程序、第三方软件等

- 使用场景的一致性

- 基础业务数据的一致性:尽量模拟真实场景下的业务数据使用情况

- 业务操作模式的一致性:尽量模拟真实场景下用户的业务功能使用情况

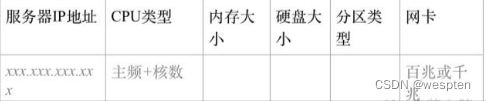

2. 性能测试环境的建模

主要分为网络拓扑图、硬件、软件、参数配置、测试数据等。描述清楚几个要点:

- 有几台测试服务器?

- 每台服务都有什么服务?(前台 Web 服务、Redis、数据库等)

- 各服务器间的连接关系?

3. 建模思路

- 分析系统真实运行的网络拓扑环境;

- 明确公司可对性能测试进行投入的软硬件资源;

- 最好的性能测试环境就是待发布的生产环境;

- 次好的性能测试环境就是 1:1 复制的生产环境;

- 对于软硬件资源不足情况下,同比例缩小系统每一层结构中的机器数量。注意:系统中的每一层必须要有机器(至少可验证分库、分布式的处理正确性);

- 测试环境的搭建最好让运维人员负责,即使硬件不同,但在软件版本和配置上也可以尽可能跟生产环境保持一致。

思考:低配测试环境的性能测试意义。

即使测试环境较 low,但性能测试还是能起到意义的,至少能够:

- 验证业务流程的处理正确性。

- 验证程序没有明显的性能问题。

- 验证单台机器的处理能力。

4. 测试数据

构造方法:

压测环境中的数据量尽量与生产环境中的数据量一致。为了快速创建大量数据,通常使用如下方法:

- 通过接口构造

- 通过数据库构造

数据量:

数据库中该有多少测试数据才是合理的呢?

-

需要考虑、中长期系统运营的数据出现的可能性

-

和性能测试干系人讨论,讨论得出数据

-

需要考虑数据库配置文件、缓存参数的设置情况

-

明确 Cache 预 load 的数据说明

缓存数据:

-

业务正确性:如 HTTP 请求中的 cookies 贯穿整个业务交互过程,在测试脚本中应该缓存 cookies,保证业务正常,同时考虑后台对 cookies 的存取方式,保证大并发下不会出现 cookies 丢失或者写满的情况。

-

性能表现:关注冷启动和热启动这两种场景下的性能表现。

-

现象:

- 很多时候,在我们搭建完性能测试的基准环境,开始执行性能基准测试的时候,往往会发现系统刚开始运行时业务处理的响应时间都会相对比较长,只有当性能测试执行了一段时间后,系统的各项指标以及事务的响应时间才逐渐趋于正常。

- 另外,在做前端性能测试的时候,我们对于一个页面的打开时间通常会去统计两个指标,一个是首次打开时间,另一个是多次打开的时间。而且,通常来讲首次打开时间会远大于后面再次打开的时间。

-

原因:

- 服务器端会对“热点”数据进行缓存,而不是每次访问都直接从数据库中获取数据。那么,系统刚开始运行时,由于没有任何之前的访问记录,所有数据都需要访问数据库,所以前期的事务响应时间都会比较长。但是,随着缓存的建立,后续的访问就会比较快了。这个前期对系统的“预热”过程其实是在“预热”缓存。

- 浏览器端也会缓存从服务器端拿到的各种静态资源,在第一次访问时这些资源都需要从服务器端获取,而后面再访问时,这些静态资源已经在浏览器的缓存中了,所以访问速度会大大加快。

-

为此,在做性能基准测试的时候,有经验的工程师通常都会先用性能场景对系统进行一下“预热”,然后再真正开始测试。

5. 测试工具和监控工具

- Loadrunner

- Jmeter

- Siege

- Apache Bench

- 自写工具

6. 测试桩

测试桩作用:用于性能瓶颈定位时,规避测试中一些非主要的流程,通常由研发人员提供。

-

模块之间的测试桩:流程中包含 AB 模块,性能定位 AB 模块性能瓶颈时,需在 AB 模块之间做桩,让其支持单压 A,或者单压 B 模块。

-

辅助测试桩:测试流程中的一些非主要流程,且测试脚本不易实现。例:登录时安全校验输入验证,可适当地让研发人员进行前段安全校验的屏蔽。

7、性能测试脚本执行

先保证脚本调试通过之后,才能进入正式压测阶段。

正式执行性能测试前,需要根据要模拟的业务负载量来选择适当的测试机。

1. 压测机

通常会选择 Windows 或者 Linux 环境来执行脚本:

- Windows 环境:操作界面化、直观、易上手,但是软件占用机器资源较多,导致资源可使用率不高,降低了可支持并发数。

- Linux 环境:命令行操作,结果查看不太方便,但资源可使用率相对较高,可支持较高并发。

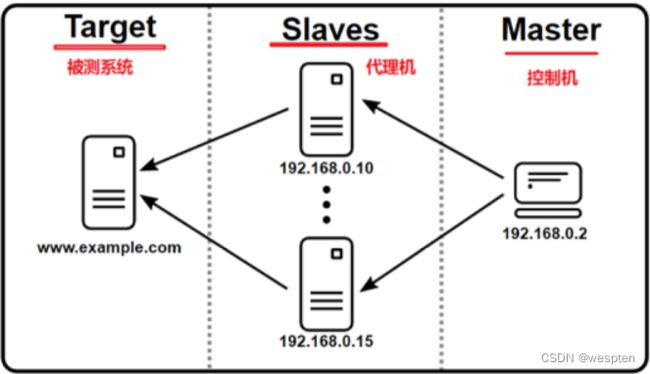

2. 分布式执行

如果单台压测机的并发量不能够满足负载要求,则可以通过分布式压测来提高并发量。如 JMeter 工具支持分布式压测,即多台机器同时执行同一个脚本,然后统计结果。

注意事项:

-

性能测试环境一定要是干净的:后台服务器除了自己没有其他人在用;测试元素不能有其他;本机一切影响网络的都要关掉。

-

如果是在生产环境压测,则注意是否有脏数据,以及测试后的数据清理机制。

-

最好每轮性能测试都重启机器,这样垃圾回收和缓存的影响能降到最小。

8、性能测试监控

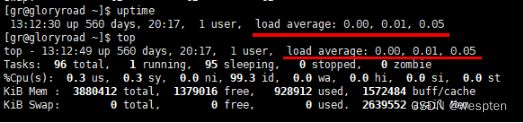

1. 监控指标

-

业务指标:并发数、响应时间、吞吐量等

-

系统资源指标:

- CPU:CPU 使用率、CPU 使用类型(用户态、内核态)

- 内存利用率:实际内存、虚拟内存

- 磁盘:I/O 速度、磁盘等待队列

- 网络:带宽使用率

-

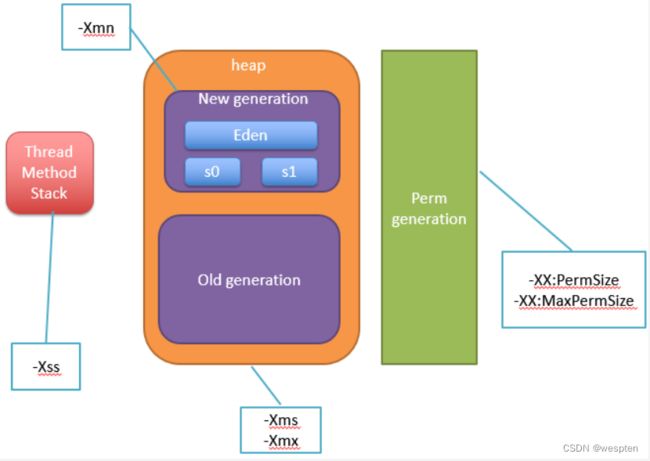

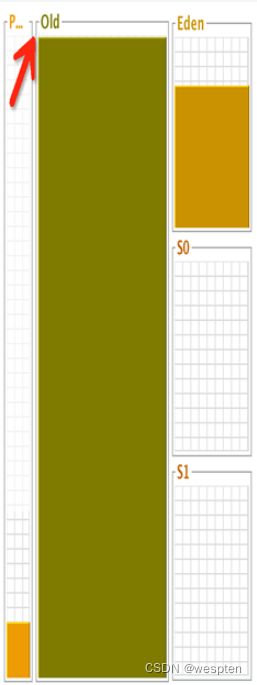

Java 应用:JVM 监控、JVM 内存(堆区)、Full GC 频率等

-

数据库:慢查询、连接数、锁、缓存命中率

-

压测机资源:CPU 使用率、内存使用率、磁盘空间使用率(测试日志的产生)、网络带宽使用率

一般情况下,测试人员只需要关注 1、2、5,来判断系统是否存在性能问题。

而开发人员要定位性能问题时,一般会再次复现场景,并监控所有的性能指标,来进行分析并调优。

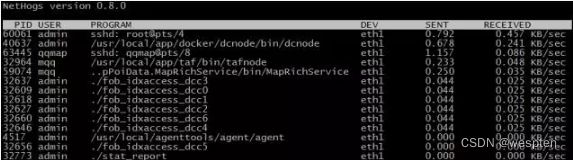

2. 监控工具

要对性能测试指标进行监控,可以使用系统自带的监控工具,也可以使用第三方监控工具或者监控平台。

-

业务指标

- 通过性能测试工具(如 LoadRunner、JMeter 等)以图形化方式监控。

-

系统资源指标

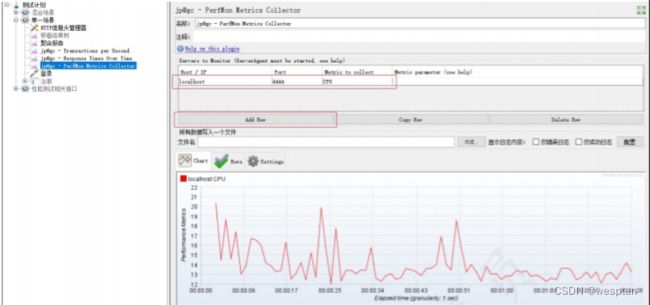

- 使用 Jmeter 插件 PerfMon 进行服务器的系统资源监控。

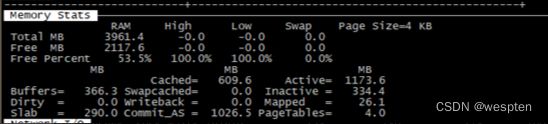

- 使用 Linux 命令监控:top、free、vmstat、sar、iostat 等。

- 使用 Nmon 工具:全面监控 linux 系统资源使用情况,包括 CPU、内存、I/O 等,可独立于应用进行监控。

-

Java 应用

- jvisualvm

-

数据库

- SQL 查询

- SQL 日志

-

压测机资源

- Windows 自带“任务管理器”

- Linux 命令

3. 使用 Jmeter 客户端监控业务及系统资源指标

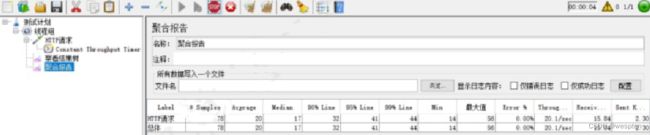

- 如使用 JMeter“聚合报告”组件监控业务指标。

- 如使用 JMeter 性能监控插件“PerfMon Metrics Collector”监控服务器资源指标。

4. 使用 nmon 监控系统资源指标

nmon 是一款快速获取 linux 系统资源的小工具。

下载与安装:

- 下载 rpm 包:http://mirror.ghettoforge.org/distributions/gf/el/6/gf/x86_64/nmon-14i-1.gf.el6.x86_64.rpm

- 安装 rpm 包:rpm -ivh nmon-14i-1.gf.el6.x86_64.rpm

- 执行 ./nmon 即可运行

前台运行使用

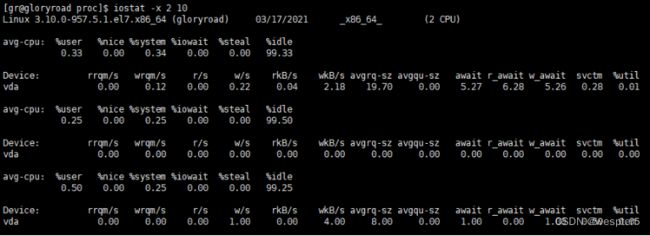

键入“c”查看系统 CPU 使用情况:

键入“m”查看系统内存使用情况:

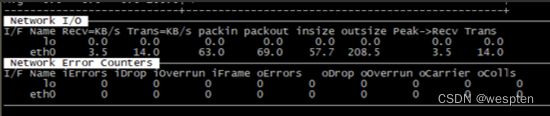

键入“n”查看网络使用情况使用情况:

5. JVM 监控

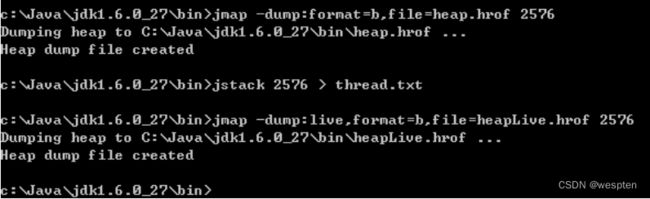

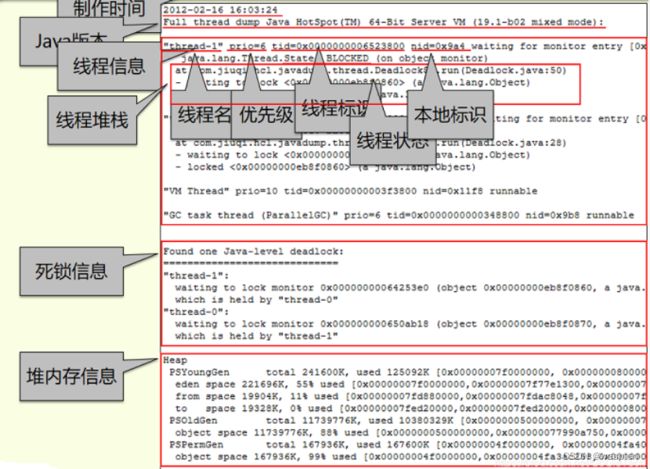

1)JVM dump

很多情况下,都会出现 dump 这个字眼,jvm 中也不例外,其中主要包括内存 dump、线程 dump。

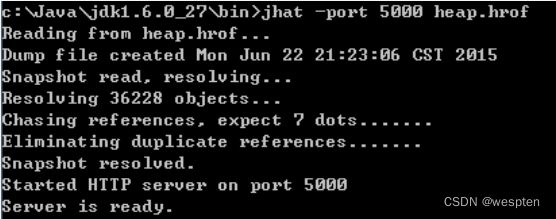

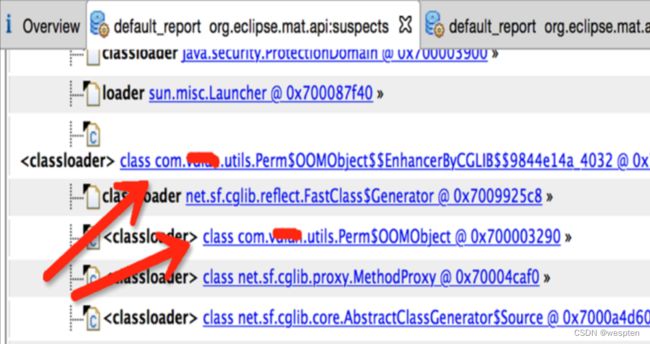

首先,内存dump是指通过 jmap -dump

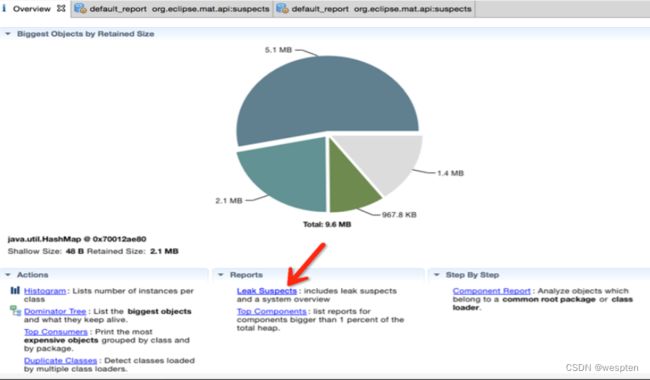

-

当发现应用内存溢出或长时间使用内存很高的情况下,通过内存 dump 进行分析可找到原因。

-

当发现 cpu 使用率很高时,通过线程 dump 定位具体哪个线程在做哪个工作占用了过多的资源。

2)jvisualvm

使用本地 jvisualvm 远程监控服务器的步骤如下:

(1)修改 Tomcat 的启动脚本(catalina.sh 或 catalina.bat),并启动 Tomcat 服务

-Dcom.sun.management.jmxremote

-Djava.rmi.server.hostname=182.92.91.137

-Dcom.sun.management.jmxremote.port=10086

-Dcom.sun.management.jmxremote.ssl=false

-Dcom.sun.management.jmxremote.authenticate=false(2)进入本地 jdk 安装目录的 bin 目录,找到 jvisualvm.exe 并启动

(3)右键“远程”选择“添加远程主机”,并输入步骤 1 配置的远程服务器 IP

(4)点击刚刚添加的主机,右键点击“添加JMX连接”,填写端口号(步骤 1 配置的端口号)

(5)点击 JMX 连接,选择监控,看 JVM 对应的监控指标。(重点关注:CPU 使用、堆的内存使用)

9、性能测试瓶颈调优

性能调优的步骤:

-

确定问题:根据性能监控的数据和性能分析的结果,确定性能存在的问题。

-

确定原因:确定问题之后,对问题进行分析,找出问题的原因。

-

确定解决方案(改服务器参数配置/增加硬件资源配置/修改代码)。

-

验证解决方案,分析调优结果。

注意:性能测试调优并不是一次完成的过程,针对同一个性能问题,上面的步骤可能要经过多次循环才能最终完成性能调优的目标(即:测试发现问题 -> 找原因 -> 调整 -> 验证 -> 分析 -> 再测试 ...)

10、输出性能测试报告

按照测试报告模板来进行编写。通常包含内容如下:

- 测试目标

- 测试结论(通过/不通过)

- 性能测试的过程记录:如测试范围、指标数据、发现的问题、调优结果等

- 性能测试过程中的风险,当前是否还存在风险

- 本次性能测试的复盘总结

五、常用压测工具

压力测试工具很多,如Locust工具、AB工具、webbench工具和http_load工具等,它们各有特色和最适合的场景。

1、轻量级http_load工具的使用

http_load是一款基于Linux平台的Web服务器性能测试工具,用于测试Web服务器的吞吐量与负载,以及Web页面的性能。对于Windows用户,官方没有提供exe版本用于直接安装,一些爱好者提供了一种通过Cygwin移植到Windows系统上的方法。

http_load工具的安装方式十分简单,在网站acme.com上下载tar.gz包,然后使用make和make install命令进行安装即可。到目前为止,最新的tar包为http_load-09Mar2016.tar。

在安装的过程中,使用make install命令时可能遇到的报错如下:

make install

rm -f /usr/local/bin/http_load

cp http_load /usr/local/bin

rm -f /usr/local/man/man1/http_load.1

cp http_load.1 /usr/local/man/man1

cp: /usr/local/man/man1: No such file or directory处理方式是先创建/usr/local/man文件夹,然后再重新运行make install命令。

完整的命令如下:

sudo mkdir -p /usr/local/man

make install使用http_load做压力测试的方法简单、直接,语法如下:

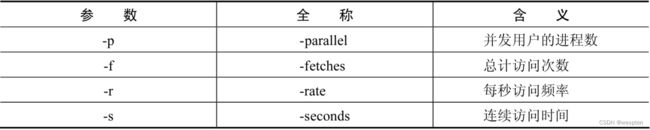

http_load -p user_process_number -s second_number url_file其中的参数介绍如下表所示:

另外,url_file为要设置测试的网址文件,需要提前创建好,如在当前目录下创建以下内容的文件urls:

http://soso.com执行命令后的输出结果如下:

~/install_soft/http_load-09Mar2016/http_load -rate 5 -seconds 10 urls

45 fetches, 5 max parallel, 261720 bytes, in 10.004 seconds

5816 mean bytes/connection

4.49818 fetches/sec, 26161.4 bytes/sec

msecs/connect: 365.563 mean, 388.459 max, 361.376 min

msecs/first-response: 518.561 mean, 557.724 max, 504.79 min

HTTP response codes:

code 200 -- 45对结果进行分析:这是执行了一个持续时间为10s的测试,频率为每秒5个用户;最终结果有45个请求,最大并发数为5个进程,总计传输的数据是261 720字节;最后一行也很关键,它表示打开响应页面的类型,200是正常的HTTP状态码,如果是403比较多或者有50X,那么说明服务存在一定的问题,系统可能遇到了瓶颈。

下面总结使用http_load时的常见错误:

- byte count wrong:http_load在处理时会关注每次访问同一个URL的返回结果(即字节数)是否一致,若不一致就会抛出该错误。

- Too many open files:系统限制的open files太小,通过ulimit -n修改open files值即可。

- 无法发送最大请求(请求长度大于600个字符):可以将默认接收请求的buf值调整为更大的值。

- Cannot assign requested address:客户端频繁地连服务器,由于每次连接都在很短的时间内结束,导致出现很多的TIME_WAIT,以致用尽了可用的端口号,使新的连接没有办法绑定端口,所以要修改客户端机器的配置。

可以在sysctl.conf中添加以下配置:

- net.ipv4.tcp_tw_reuse = 1:表示开启重用,允许将TIME-WAIT sockets重新用于新的TCP连接,默认为0,表示关闭。

- net.ipv4.tcp_timestamps=1:表示开启对TCP时间戳的支持,若该项设置为0,则下面一项设置不起作用。

- net.ipv4.tcp_tw_recycle=1:表示开启TCP连接中对TIME-WAIT sockets的快速回收。

2、webbench工具的使用

除了Locust之外,另外一款流行的Web性能测试工具是webbench,它是轻量级的网站测压工具,最多可以对网站进行3万并发量的模拟请求测试。webbench可以控制持续时间、是否使用缓存、是否等待服务器响应等参数,对中小型网站的测试有明显的效果,可以很容易测试出网站的承压极限。但webbench对于大型网站的测试效果不是很明显,因为这种网站(如百度)的承压能力非常强。

webbench工具最重要的两个测试指标是每秒响应的请求数和每秒传输的数据量。

webbench的安装方式和http_load类似,可以到官方网上下载对应的tar.gz包,然后使用命令make和make install进行安装即可。到目前为止,webbench工具已经很久没有更新了,最新版本为webbench 1.5。

例如,CentOS系统上进行安装,安装命令如下:

wget http://www.ha97.com/code/webbench-1.5.tar.gz

tar xf webbench-1.5.tar.gz

yum install gcc* ctags* -y

make && make installwebbench的使用方式很简单,语法如下:

webbench -c [并发数] -t [运行时间] [访问的URL]下面使用webbench测试之前的tinyBBS项目。先启动该项目服务,然后执行如下命令:

webbench -c 300 -t 10 http://127.0.0.1:5000/

Webbench - Simple Web Benchmark 1.5

Copyright (c) Radim Kolar 1997-2004, GPL Open Source Software.

Benchmarking: GET http://127.0.0.1:5000/

300 clients, running 10 sec.使用webbench工具进行压力测试时应注意:

- 压力测试会对服务器性能产生一些影响,如会消耗CPU和内存资源,因此为了测试的准确性,应尽量找一个相对稳定的服务器进行测试。

- 压力测试应该逐步增加。例如,在并发数量增加到50的时候看看负载情况,增加到100的时候再观察一下情况,然后再进一步增加到200并发、300并发等,最后测出网站变慢甚至打不开网页时的负载量。

- 针对一些访问量大的页面进行压力测试效果更佳,因此应有的放矢,对重要的页面和功能接口进行压力测试。

3、AB工具的使用

比起webbench,开发者更熟悉AB工具。

AB工具是Apache超文本传输协议(HTTP)的性能测试工具。它的设计意图是描绘当前所安装的Apache的执行性能,显示用户安装的Apache每秒可以处理多少个请求。它是和Apche服务一起捆绑安装的,有Apache服务就有AB工具。

AB工具的安装很简单,只需要到Apache官网上下载对应操作系统的安装包即可,这个工具针对Windows也有专门的版本,并且在不断维护和更新中。如果之前已经在计算机上安装过Apache服务,可以在执行文件的相同目录下找到AB工具的可执行exe文件。

1. Windows系统的安装方式

1)Apache下载

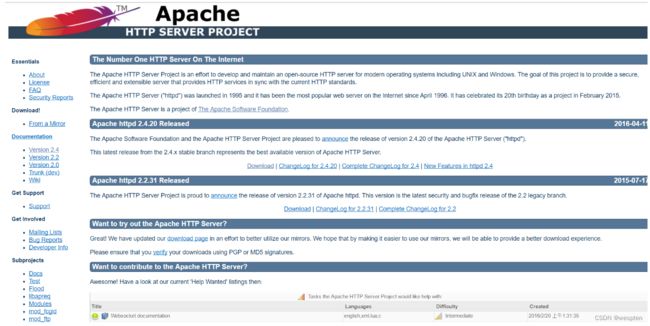

选择一个版本,点击Download:

点击File For Microsoft Windows:

由于Apache HTTP Server官方不提供二进制(可执行)的发行版,所以我们选择一些贡献者编译完成的版本,我们选择第一个Apache Haus。

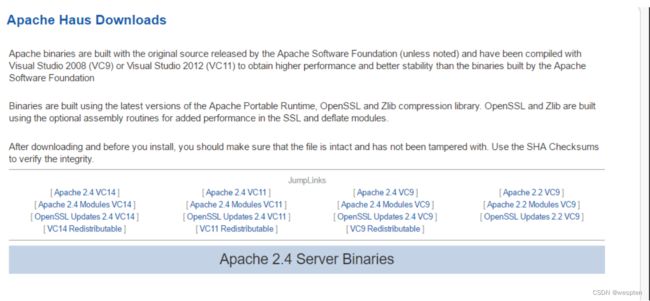

点击ApacheHaus,进入下载页:

选择其中一个版本,如果你的Windows还没安装对应的VC环境的话,选择对应的VCRedistribute版本下载安装。我选择Apache 2.4VC9版,因为我的电脑中已经安装了VC9的环境。

点击JumpLinks下第一行的某一个版本,下载对应压缩包。

2)配置Apache

解压后进入里面Apache22(最后两位数字可能不同)文件夹,使用文本编辑器(推荐ultraedit)打开conf文件夹中的httpd.conf配置文件

找到ServerRoot选项,设置Apache目录,大约在35行左右,将其改成你的Apache程序的文件夹,例:

ServerRoot "C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22"找到Listen选项,设置端口,大约46行,一般不修改,使用默认80,在开启服务器前请保证80端口未被占用

找到DocumentRoot选项,修改服务器根目录,例:

DocumentRoot "F:/"请保证此目录存在,否则服务器无法正常启动。

修改Directory,保证其与服务器根目录相同,只修改下面的第一行中引号部分:

#

# Possible values for the Options directive are "None", "All",

# or any combination of:

# Indexes Includes FollowSymLinks SymLinksifOwnerMatch ExecCGI MultiViews

#

# Note that "MultiViews" must be named *explicitly* --- "Options All"

# doesn't give it to you.

#

# The Options directive is both complicated and important. Please see

# http://httpd.apache.org/docs/2.2/mod/core.html#options

# for more information.

#

Options Indexes FollowSymLinks

#

# AllowOverride controls what directives may be placed in .htaccess files.

# It can be "All", "None", or any combination of the keywords:

# Options FileInfo AuthConfig Limit

#

AllowOverride None

#

# Controls who can get stuff from this server.

#

Order allow,deny

Allow from all

找到ScriptAlias选项,设置服务器脚本目录,大约326行,一般将其设置为Apache目录下的cgi-bin文件夹:

ScriptAlias /cgi-bin/ "C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/cgi-bin"找到随后的Directory选项,设置脚本目录,大约342行,需要将其设置为和前面的ScriptAlias目录相同:

AllowOverride None

Options None

Order allow,deny

Allow from all

3)ssl配置

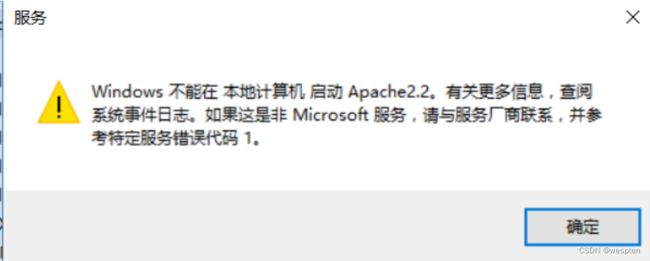

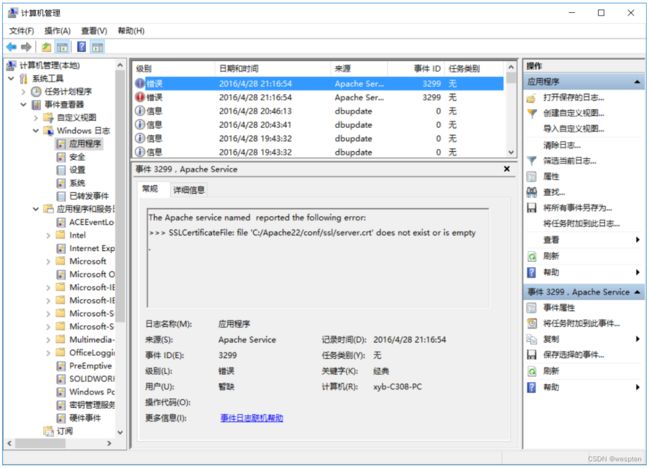

如果你这使启动服务,一般会出现下面的消息对话框:

提示:

Windows不能在本地计算机启动Apache2.2。有关更多信息,查阅系统日志文件。如果这是非Microsoft服务,请与厂商联系,并参考特定服务器错误代码1。

确定此问题的原因:

右键 计算机,点击管理->Windows日志->应用程序,显示如下

这是由于SSL配置不正确所产生的,下面说一下解决办法。

打开Apache程序目录下的conf/extra/httpd-ahssl.conf文件,配置VirtualHost选项,有三处名为VirtualHost的选项,均需修改。

第一个在107行左右。

在110行左右,将其中的SSLCertificateFile改为:Apache所在目录/conf/ssl/server.crt

在111行左右,将SSLCertificateKeyFile改为:Apache所在目录/conf/ssl/server.key

在112行左右,将DocumentRoot改为你的服务器根目录

在126行左右,将CustomLog改为:Apache所在目录/logs/ssl_request.log,这个不改的话也会错。一般会出现如下错误:

Apache2.2服务由于下列服务特定错误而终止:函数不正确。

改成的效果:

SSLEngine on

ServerName localhost:443

SSLCertificateFile C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/conf/ssl/server.crt

SSLCertificateKeyFile C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/conf/ssl/server.key

DocumentRoot F:/

# openssl req -new > server.csr

# openssl rsa -in privkey.pem -out server.key

# openssl x509 -in server.csr -out server.crt -req -signkey server.key -days 2048

SSLOptions +StdEnvVars

SSLOptions +StdEnvVars

BrowserMatch "MSIE [2-5]"

nokeepalive ssl-unclean-shutdown

downgrade-1.0 force-response-1.0

CustomLog "C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/logs/ssl_request.log"

"%t %h %{SSL_PROTOCOL}x %{SSL_CIPHER}x "%r" %b"

主要改上文四处地方。

在130行和152行还有另外两个VirtualHost,均需修改上述的四个选项。

例:

130行

SSLEngine on

ServerName serverone.tld:443

SSLCertificateFile C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/conf/ssl/serverone.crt

SSLCertificateKeyFile C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/conf/ssl/serverone.key

DocumentRoot F:/

# openssl req -new > serverone.csr

# openssl rsa -in privkey.pem -out serverone.key

# openssl x509 -in serverone.csr -out serverone.crt -req -signkey serverone.key -days 2048

SSLOptions +StdEnvVars

SSLOptions +StdEnvVars

BrowserMatch "MSIE [2-5]"

nokeepalive ssl-unclean-shutdown

downgrade-1.0 force-response-1.0

CustomLog "C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/logs/ssl_request.log"

"%t %h %{SSL_PROTOCOL}x %{SSL_CIPHER}x "%r" %b" env=HTTPS

第152行:

SSLEngine on

ServerName servertwo.tld:443

SSLCertificateFile C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/conf/ssl/servertwo.crt

SSLCertificateKeyFile C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/conf/ssl/servertwo.key

DocumentRoot F:/

# openssl req -new > servertwo.csr

# openssl rsa -in privkey.pem -out servertwo.key

# openssl x509 -in servertwo.csr -out servertwo.crt -req -signkey servertwo.key -days 2048

SSLOptions +StdEnvVars

SSLOptions +StdEnvVars

BrowserMatch "MSIE [2-5]"

nokeepalive ssl-unclean-shutdown

downgrade-1.0 force-response-1.0

CustomLog "C:/Users/myPC/Downloads/httpd-2.2.31-x86-r3/Apache22/ssl_request.log"

"%t %h %{SSL_PROTOCOL}x %{SSL_CIPHER}x "%r" %b"

上述的两个VirtualHost均需修改四处

这样,Apache就算配置完了,如果还有问题,可能还需配置./conf/extra/httpd-ssl.conf,配置方法和配置VirtualHost的相似

4)启动Apache HTTP Server

使用Windows命令行以管理员身份进入Apache程序的文件夹下的bin文件夹,输入httpd -k install,完成Apache服务的安装。

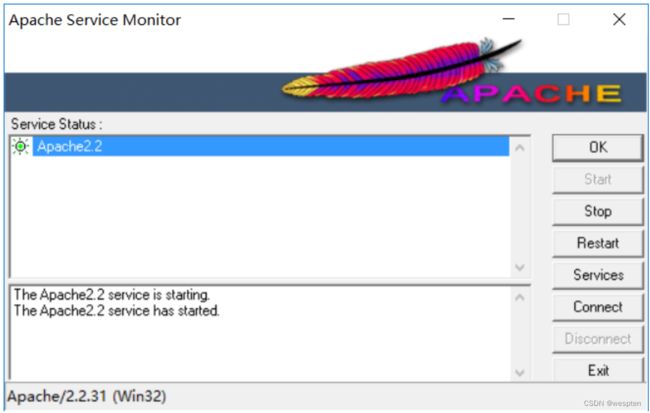

然后双击bin目录下的ApacheMonitor.exe,点击右边的start启动服务器,如果正常,如下图:

测试一下:

2. Mac OS系统的安装与使用

同样也是在官网上找到对应的版本,选择httpd-2.4.41.tar.gz包即可(版本为2.4.41),如图所示。然后再通过“编译三板斧”(即预配置、编译、编译安装3个步骤)来安装,对应的命令为:

./configure

make

make install安装好后,在终端中输入ab,输出信息如下:

ab: wrong number of arguments

Usage: ab [options] [http[s]://]hostname[:port]/path

Options are:

-n requests Number of requests to perform

-c concurrency Number of multiple requests to make at a time

-t timelimit Seconds to max. to spend on benchmarking

This implies -n 50000

-s timeout Seconds to max. wait for each response

Default is 30 seconds

-b windowsize Size of TCP send/receive buffer, in bytes

-B address Address to bind to when making outgoing connections

-p postfile File containing data to POST. Remember also to set -T

-u putfile File containing data to PUT. Remember also to set -T

-T content-type Content-type header to use for POST/PUT data, eg.

'application/x-www-form-urlencoded'

Default is 'text/plain'

-v verbosity How much troubleshooting info to print

-w Print out results in HTML tables

-i Use HEAD instead of GET

-x attributes String to insert as table attributes

-y attributes String to insert as tr attributes

-z attributes String to insert as td or th attributes

-C attribute Add cookie, eg. 'Apache=1234'. (repeatable)

-H attribute Add Arbitrary header line, eg. 'Accept-Encoding: gzip'

Inserted after all normal header lines. (repeatable)

-A attribute Add Basic WWW Authentication, the attributes

are a colon separated username and password.

-P attribute Add Basic Proxy Authentication, the attributes

are a colon separated username and password.

-X proxy:port Proxyserver and port number to use

-V Print version number and exit

-k Use HTTP KeepAlive feature

-d Do not show percentiles served table.

-S Do not show confidence estimators and warnings.

-q Do not show progress when doing more than 150 requests

-l Accept variable document length (use this for dynamic

pages)

-g filename Output collected data to gnuplot format file.

-e filename Output CSV file with percentages served

-r Don't exit on socket receive errors.

-m method Method name

-h Display usage information (this message)

-I Disable TLS Server Name Indication (SNI) extension

-Z ciphersuite Specify SSL/TLS cipher suite (See openssl ciphers)

-f protocol Specify SSL/TLS protocol

(TLS1, TLS1.1, TLS1.2 or ALL)例如,要对百度首页进行并发测试,命令如下:

ab -n 5 -c 2 https://www.baidu.com/其中,-n表示选择多少个请求,-c表示并发数。执行命令后,输出结果如下:

This is ApacheBench, Version 2.3 <$Revision: 1826891 $>

Copyright 1996 Adam Twiss, Zeus Technology Ltd, http://www.zeustech.net/

Licensed to The Apache Software Foundation, http://www.apache.org/

Benchmarking www.baidu.com (be patient).....done

Server Software: BWS/1.1

Server Hostname: www.baidu.com

Server Port: 443

SSL/TLS Protocol: TLSv1.2,ECDHE-RSA-AES128-GCM-SHA256,2048,128

TLS Server Name: www.baidu.com

Document Path: /

Document Length: 166943 bytes

Concurrency Level: 2

Time taken for tests: 6.506 seconds

Complete requests: 5

Failed requests: 4

(Connect: 0, Receive: 0, Length: 4, Exceptions: 0)

Total transferred: 839184 bytes

HTML transferred: 833016 bytes

Requests per second: 0.77 [#/sec] (mean)

Time per request: 2602.435 [ms] (mean)

Time per request: 1301.218 [ms] (mean, across all concurrent requests)

Transfer rate: 125.96 [Kbytes/sec] received

Connection Times (ms)

min mean[+/-sd] median max

Connect: 621 703 58.1 723 775

Processing: 1241 1448 246.4 1485 1775

Waiting: 372 425 93.9 392 592

Total: 1916 2151 233.5 2183 2493

Percentage of the requests served within a certain time (ms)

50% 2096

66% 2270

75% 2270

80% 2493

90% 2493

95% 2493

98% 2493

99% 2493

100% 2493 (longest request)其中比较重要的参数如下。

- ·Requests per second:吞吐率

公式为:吞吐率=总完成请求数量/测试消耗时间

- Concurrency Level:并发数。

- Time per request:用户平均请求等待时间。

公式为:用户平均请求等待时间=处理完成请求的总时间/并发用户数

- Time per request:服务器平均请求等待时间。

公式为:服务器平均请求等待时间=处理完所有请求所用时间/总请求数

AB工具还可以将post数据存储在JSON文件中,具体命令如下:

ab -c 10 -n 200 -t 5 -p ./post.json -T 'application/json' http://httpbin.org/post其中,post.json文件的内容也很简单,就是JSON格式的数据,具体如下:

{

'key1':'value',

'key2':'value2'

}3. 利用Python操作AB工具

有时候会觉得AB工具不够灵活,需要在它的基础上根据实际需求进行封装。下面我们就尝试编写一个Python脚本来操作AB工具。

#-*- coding: utf-8 -*-

import os

import json

class AbTool(object):

def __init__(self, url, child_process, request_num):

self.url = url

self.child_process = child_process

self.request_num = request_num

def set_url(self, url):

self.url = url

def set_child_process(self, child_process):

self.child_process = child_process

def set_request_num(self, request_num):

self.request_num = request_num

def set_time(self, seconds):

self.seconds = seconds

def runAndStore(self):

cmd = "ab -n " + str(self.request_num) + " -c " + str(self.child_process) + " -t 5 " + self.url

print(cmd)

os.system(cmd)

tool = AbTool('https://www.soso.com/', 2, 100)

tool.runAndStore()其实ab命令的参数设置非常不“智能”,基本都是硬编码,当参数需要调整的时候,要在脚本里修改相应代码,因此可以考虑把参数写入一个配置文件中,通过读取配置文件来设置参数。配置文件的格式有很多种,如传统的ini和XML,也有比较流行的YAML。这里推荐使用YAML格式的配置文件,因其可读性更高。

下面介绍一下YAML方面的知识。

YAML是一种用来表达数据序列化的格式,具有较高的可读性。YAML参考了其他多种语言,包括C语言、Python和Perl,并从XML和电子邮件的数据格式(RFC 2822)中获得灵感。目前已经有数种编程语言和脚本语言支持(或者说解析)YAML。

YAML的数据结构类似于大纲的缩进方式,例如:

items:

prod_id: ST002321

price: 37.00

rank: 4

service:

service_name: nginx

port: 8081

pid: 555345Python中也有用于解析YAML格式数据的包,安装方式如下:

pip install yaml下面编写一个测试脚本,代码如下:

# coding:utf-8

import yaml

file_path = './test.yaml'

with open(file_path, 'rb') as f:

data = yaml.load(f)

print(data)test.yaml文件的内容如下:

stock:

code_no: 000977

name: lcxx

price: 44.38

market: SZ执行命令python test_yml.py,输出结果如下:

python test_yml.py

test_yml.py:6: YAMLLoadWarning: calling yaml.load() without Loader=... is

deprecated, as the default Loader is unsafe. Please read https://msg.pyyaml.

org/load for full details.

data = yaml.load(f)

{'stock': {'code_no': '000977', 'name': 'lcxx', 'price': 44.38, 'market':

'SZ'}}可以看出,yaml包将YAML文件内容解析成可读性更强的字典结构,后续就可以像普通字典一样进行操作。下面将之前的ab_tool.py(代码6.3)改编为解析YAML文件的ab_tool2.py,代码如下:

# -*- coding: utf-8 -*-

import os

import yaml

class AbTool(object):

def __init__(self):

config_data = self.load_config()

self.url = config_data['config']['url']

self.child_process = config_data['config']['child_process']

self.request_num = config_data['config']['request_num']

# 执行持续的时间

self.running_time = config_data['config']['running_time']

# 从YAML文件中获取config

def load_config(self):

config_data = {}

file_path = './ab_config.yaml'

with open(file_path, 'rb') as f:

config_data = yaml.load(f)

return config_data

def set_url(self, url):

self.url = url

def set_child_process(self, child_process):

self.child_process = child_process

def set_request_num(self, request_num):

self.request_num = request_num

def set_time(self, seconds):

self.seconds = seconds

def runAndStore(self):

cmd = "ab -n " + str(self.request_num) + " -c " + str(self.child_

process) + " -t " + str(self.running_time) + "" + self.url

print(cmd)

os.system(cmd)

tool = AbTool()

tool.runAndStore()在与代码同级目录下的ab_config.yaml文件是配置文件,其内容如下:

config:

url: https://soso.com/

child_process: 3

request_num: 100

running_time: 5执行python ab_tool2.py,输出结果如下:

ab -n 100 -c 3 -t 5 https://soso.com/

This is ApacheBench, Version 2.3 <$Revision: 1826891 $>

Copyright 1996 Adam Twiss, Zeus Technology Ltd, http://www.zeustech.net/

Licensed to The Apache Software Foundation, http://www.apache.org/

Benchmarking soso.com (be patient)

Finished 65 requests

Server Software: nginx

Server Hostname: soso.com

Server Port: 443

SSL/TLS Protocol: TLSv1.2,ECDHE-RSA-AES256-GCM-SHA384,2048,256

TLS Server Name: soso.com

Document Path: /

Document Length: 5816 bytes

Concurrency Level: 3

Time taken for tests: 5.020 seconds

Complete requests: 65

Failed requests: 0

Total transferred: 427895 bytes

HTML transferred: 378040 bytes

Requests per second: 12.95 [#/sec] (mean)

Time per request: 231.686 [ms] (mean)

Time per request: 77.229 [ms] (mean, across all concurrent requests)

Transfer rate: 83.24 [Kbytes/sec] received

Connection Times (ms)

min mean[+/-sd] median max

Connect: 125 154 22.2 156 260

Processing: 44 55 7.8 56 83

Waiting: 43 54 7.7 55 82

Total: 170 209 25.9 213 304

Percentage of the requests served within a certain time (ms)

50% 212

66% 220

75% 224

80% 229

90% 243

95% 249

98% 252

99% 304

100% 304 (longest request)4、Locust工具的使用

性能测试的工具非常多,有针对Web服务的并发工具,也有针对客户端的工具,还有针对数据库读写I/O的检测工具。这里介绍Python技术栈下的性能测试工具——Locust,并用它进行实践。

Locust是使用Python语言编写的开源性能测试工具,其简洁、轻量、高效的并发机制基于Gevent协程,可以实现单机模拟生成较高的并发压力。使用该工具可以节省实际的物理机资源,通过单机达到并发的效果,从而进行压力测试,找到最大的承压点。Locust用于对网站(或其他系统)进行负载测试,并确定系统可以处理多少个并发用户。

Locust的主要优点如下:

- 测试人员可以使用普通的Python脚本进行用户场景测试,而无须具备其他编程语言和技能。

- 具有分布式和可扩展的特性,支持上万个用户。

- 使用者可以基于Web的用户界面实时监控脚本运行的状态,可视化地进行分析,以方便使用和管理。

- 几乎可以测试任何类型的系统,除了常规的Web HTTP接口外,还可自定义客户端,测试其他类型的系统。

1. 环境搭建

Locust目前支持Python 2.7/3.4/3.5/3.6及以上版本,安装也十分方便,可以使用pip命令进行安装:

pip install locustio在安装的过程中可能出现超时下载并导致失败的情况,这是因为部分依赖包资源在国外的网站上,有条件的朋友可以访问外网进行安装,或者使用豆瓣网的镜像库在国内网络环境下安装。

安装完毕后可以检查一下安装的版本,命令如下:

pip show locustio在计算机上执行该命令后输出结果如下:

Name: locustio

Version: 0.14.4

Summary: Website load testing framework

Home-page: https://locust.io/

Author: Jonatan Heyman, Carl Bystrom, Joakim Hamrén, Hugo Heyman

Author-email:

License: MIT

Location: /Library/Frameworks/Python.framework/Versions/3.7/lib/python3.7/

site-packages

Requires: flask, gevent, msgpack-python, psutil, ConfigArgParse, pyzmq,

geventhttpclient-wheels, requests, six

Required-by:想了解更多的Locust命令,可以输入locust --help命令,输出结果如下:

usage: locust [-h] [-H HOST] [--web-host WEB_HOST] [-P PORT] [-f LOCUSTFILE]

[--csv CSVFILEBASE] [--csv-full-history] [--master] [--slave]

[--master-host MASTER_HOST] [--master-port MASTER_PORT]

[--master-bind-host MASTER_BIND_HOST]

[--master-bind-port MASTER_BIND_PORT]

[--heartbeat-liveness HEARTBEAT_LIVENESS]

[--heartbeat-interval HEARTBEAT_INTERVAL]

[--expect-slaves EXPECT_SLAVES] [--no-web] [-c NUM_CLIENTS]

[-r HATCH_RATE] [-t RUN_TIME] [--skip-log-setup] [--step-load]

[--step-clients STEP_CLIENTS] [--step-time STEP_TIME]

[--loglevel LOGLEVEL] [--logfile LOGFILE] [--print-stats]

[--only-summary] [--no-reset-stats] [--reset-stats] [-l]

[--show-task-ratio] [--show-task-ratio-json] [-V]

[--exit-code-on-error EXIT_CODE_ON_ERROR] [-s STOP_TIMEOUT]

[LocustClass [LocustClass ...]]

Args that start with '--' (eg. -H) can also be set in a config file

(~/.locust.conf or locust.conf). Config file syntax allows: key=value,

flag=true, stuff=[a,b,c] (for details, see syntax at https://goo.gl/R74nmi).

If an arg is specified in more than one place, then commandline values

override config file values which override defaults.

positional arguments:

LocustClass

optional arguments:

-h, --help show this help message and exit

-H HOST, --host HOST Host to load test in the following format:

http://10.21.32.33

--web-host WEB_HOST Host to bind the web interface to. Defaults to '' (all

interfaces)

-P PORT, --port PORT, --web-port PORT

Port on which to run web host

-f LOCUSTFILE, --locustfile LOCUSTFILE

Python module file to import, e.g. '../other.py'.

Default: locustfile

--csv CSVFILEBASE, --csv-base-name CSVFILEBASE

Store current request stats to files in CSV format.

--csv-full-history Store each stats entry in CSV format to

_stats_history.csv file

--master Set locust to run in distributed mode with this

process as master

--slave Set locust to run in distributed mode with this

process as slave

--master-host MASTER_HOST

Host or IP address of locust master for distributed

load testing. Only used when running with --slave.

Defaults to 127.0.0.1.

--master-port MASTER_PORT

The port to connect to that is used by the locust

master for distributed load testing. Only used when

running with --slave. Defaults to 5557. Note that

slaves will also connect to the master node on this

port + 1.

--master-bind-host MASTER_BIND_HOST

Interfaces (hostname, ip) that locust master should

bind to. Only used when running with --master.

Defaults to * (all available interfaces).

--master-bind-port MASTER_BIND_PORT

Port that locust master should bind to. Only used when

running with --master. Defaults to 5557. Note that

Locust will also use this port + 1, so by default the

master node will bind to 5557 and 5558.

--heartbeat-liveness HEARTBEAT_LIVENESS

set number of seconds before failed heartbeat from

slave

--heartbeat-interval HEARTBEAT_INTERVAL

set number of seconds delay between slave heartbeats

to master

--expect-slaves EXPECT_SLAVES

How many slaves master should expect to connect before

starting the test (only when --no-web used).

--no-web Disable the web interface, and instead start running

the test immediately. Requires -c and -t to be

specified.

-c NUM_CLIENTS, --clients NUM_CLIENTS

Number of concurrent Locust users. Only used together

with --no-web

-r HATCH_RATE, --hatch-rate HATCH_RATE

The rate per second in which clients are spawned. Only

used together with --no-web

-t RUN_TIME, --run-time RUN_TIME

Stop after the specified amount of time, e.g. (300s,

20m, 3h, 1h30m, etc.). Only used together with --no-

web

--skip-log-setup Disable Locust's logging setup. Instead, the

configuration is provided by the Locust test or Python

defaults.

--step-load Enable Step Load mode to monitor how performance

metrics varies when user load increases. Requires

--step-clients and --step-time to be specified.

--step-clients STEP_CLIENTS

Client count to increase by step in Step Load mode.

Only used together with --step-load

--step-time STEP_TIME

Step duration in Step Load mode, e.g. (300s, 20m, 3h,

1h30m, etc.). Only used together with --step-load

--loglevel LOGLEVEL, -L LOGLEVEL

Choose between DEBUG/INFO/WARNING/ERROR/CRITICAL.

Default is INFO.

--logfile LOGFILE Path to log file. If not set, log will go to

stdout/stderr

--print-stats Print stats in the console

--only-summary Only print the summary stats

--no-reset-stats [DEPRECATED] Do not reset statistics once hatching has

been completed. This is now the default behavior. See

--reset-stats to disable

--reset-stats Reset statistics once hatching has been completed.

Should be set on both master and slaves when running

in distributed mode

-l, --list Show list of possible locust classes and exit

--show-task-ratio print table of the locust classes' task execution

ratio

--show-task-ratio-json

print json data of the locust classes' task execution

ratio

-V, --version show program's version number and exit

--exit-code-on-error EXIT_CODE_ON_ERROR

sets the exit code to post on error

-s STOP_TIMEOUT, --stop-timeout STOP_TIMEOUT

Number of seconds to wait for a simulated user to

complete any executing task before exiting. Default is

to terminate immediately. This parameter only needs to

be specified for the master process when running

Locust distributed.Locust主要由下面几个库构成:

- gevent:一种基于协程的Python网络库,它用到了Greenlet提供的封装了libevent事件循环的高层同步API。

- Flask:使用Python编写的轻量级Web应用框架。

- requests:Python HTTP库。

- msgpack-python:MessagePack是一种快速、紧凑的二进制序列化格式,适用于类似于JSON的数据格式。msgpack-python主要提供MessagePack数据序列化及反序列化的方法。

- six:Python 2和Python 3的兼容库,用来封装Python 2和Python 3之间的差异性。

- pyzmq:是zeromq(一种通信队列)的Python绑定,主要用来实现Locust的分布式运行。

Locust的官方网站上有一个最简单的用例,其代码如下:

#coding:utf-8

from locust import HttpLocust, TaskSet, task

class UserBehavior(TaskSet):

def on_start(self):

""" on_start is called when a Locust start before any task is scheduled """

self.login()

def login(self):

self.client.post("/login", {"username":"ellen_key", "password":

"education"})

@task(2)

def index(self):

self.client.get("/")

@task(1)

def profile(self):

self.client.get("/profile")

class WebsiteUser(HttpLocust):

task_set = UserBehavior

host='http://example.com'

min_wait = 5000

max_wait = 9000上述程序对网站example.com进行测试,先模拟用户登录系统,然后随机访问index(/)和profile页面(/profile),请求比例为2∶1,两次请求之间的时间间隔随机,介于5s~9s。

运行上述脚本很简单,先通过cd命令跳转到该脚本所在的目录,然后执行如下命令:

locust如果locust脚本不在当前目录下,那么需要使用-f指定文件,并使用--host指定测试主机地址,具体命令如下:

locust -f /path/to/file_name.py --host=http://example.com如果要运行分布在多个进程上的locust脚本,则需要使用--master启动主进程,具体命令如下:

locust -f /path/to/file_name.py --master --host=http://example.com然后再使用--slave启动任意数量的从进程,具体命令如下:

locust -f /path/to/file_name.py --slave --host=http://example.com如果要在多台机器上分布式运行locust脚本,需要执行以下命令:

locust -f /path/to/file_name.py --slave --master-host=192.168.1.24 --host=

http://example.com2. Locust快速入门

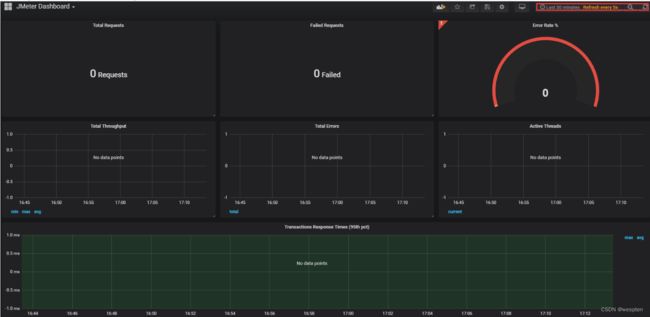

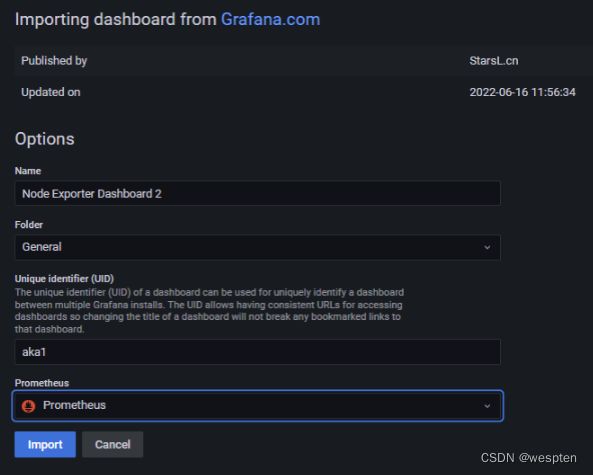

Locust可以先在Web界面进行设置,然后可以很方便地进行性能测试。默认使用Web模式,访问http://localhost:8089即可,如图所示。在该页面中可以设置模拟的用户数量、需要持续执行的时间及需要测试的网页地址等。

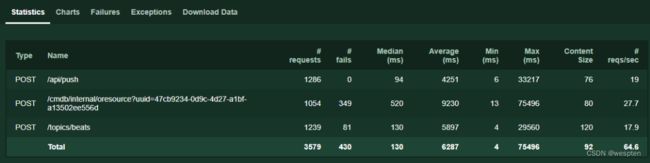

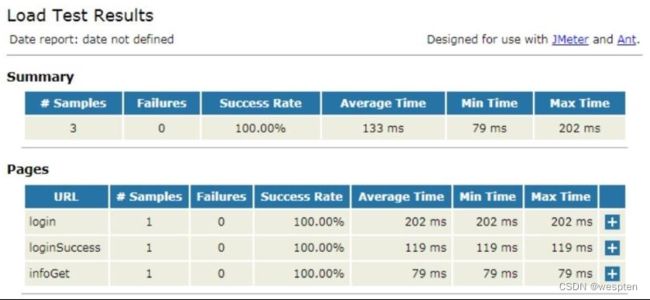

当单击Start swarming按钮后,Locust会执行脚本程序中的代码,随机访问设置的路由地址(URL),并形成结果写入CSV文件中,执行结果如图示。

整个操作非常人性化,可视化界面让人耳目一新,能方便地统计失败的情况和异常的捕获。同时,Locust也提供柱状图形式的统计,如每秒总请求数的变化统计、返回延迟时间统计和用户数量统计等,从多个维度全方位地展示测试结果。

图中的报表中各字段含义如下:

- Type:请求类型;

- Name:请求路径;

- Requests:当前请求的数量;

- Fails:当前请求失败的数量;

- Median:中间值,单位是ms,一半服务器的响应时间低于该值,而另一半服务器的响应时间高于该值;

- Average:所有请求的平均响应时间,单位为ms;

- Min:请求的最小服务器响应时间,单位为ms;

- Max:请求的最大服务器响应时间,单位为ms;

- Content Size:单个请求的大小,单位是字节;

- reqs/sec:每秒请求的个数;

在上图中,RPS和平均响应时间这两个指标显示的值都是根据最近2秒请求响应数据计算得到的统计值,我们也可以理解为瞬时值。

如果想看性能指标数据的走势,就可以在Charts栏查看。在这里,可以查看到RPS和平均响应时间在整个运行过程中的波动情况。

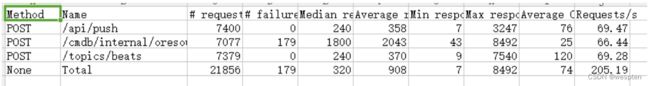

除了以上数据,Locust还提供了整个运行过程数据的百分比统计值,例如我们常用的90%响应时间、响应时间中位值;平均响应时间和错误数的统计,该数据可以通过Download response time distribution CSV和Download request statistics CSV获得,数据展示效果如下所示。

![]()

除此之外,Locust也可以使用no-web模式进行性能测试,命令如下:

locust -f /path/to/file_name.py --no-web - csv=locust -c10 -r2 --run-time 2h30m其中,--no-web表示使用no-web模式运行,--csv表示执行结果文件名,-c表示并发用户数,-r表示每秒请求数,--run_time表示运行时间。

3. 编写接口压测脚本文件

Locust类的client属性是一种需要被调用者初始化的属性。在使用Locust时,需要先继承Locust类,然后在子类的client属性中绑定客户端的实现类。

对于常见的HTTP或HTTPS,Locust已经实现了HttpLocust类,其client属性绑定了HttpSession类,而HttpSession又继承自requests.Session,因此在测试HTTP(S)的Locust脚本中,可以通过client属性调用Python requests库的所有方法,包括GET、POST、HEAD、PUT、DELETE和PATCH等,调用方式与requests完全一致。另外,由于使用了requests. Session,因此client方法的调用过程就自动具有了状态记忆的功能。常见的场景是当登录系统后可以维持登录状态的Session,从而使后续的HTTP请求操作都能带上登录状态。

对于HTTP或HTTPS以外的协议,同样可以使用Locust进行测试,只是需要我们自行实现客户端。在客户端的具体实现上,首先可通过注册事件的方式,在请求成功时触发events.request_success,在请求失败时触发events.request_failure即可。然后创建一个继承自Locust类的类,对其设置一个client属性并与我们实现的客户端进行绑定。

这样就可以像使用HttpLocust类一样测试其他协议类型的系统了。

在Locust类中,除了client属性,还需要关注以下几个属性:

- task_set:指向一个TaskSet类,该类定义了用户的任务信息。该属性为必填项。

- max_wait/min_wait:每个用户执行两个任务间隔时间的上下限(单位是ms),具体数值在上下限中随机取值,若不指定则默认间隔时间固定为1s。

- host:被测系统的主机IP地址(host),当在终端中启动Locust的过程中没有指定--host参数时才会用到。

- weight:同时运行多个Locust类时会用到,用于控制不同类型任务的执行权重。

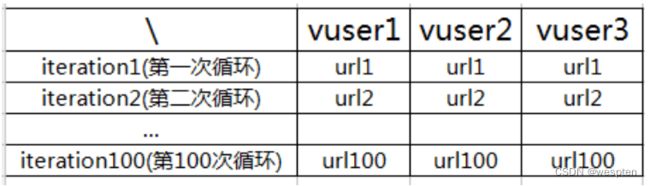

测试开始后,每个虚拟用户(Locust实例)的运行逻辑都会遵循如下规律:

- 执行WebsiteTasks中的on_start(只执行一次),进行初始化。

- 从WebsiteTasks中随机挑选一个任务执行,如果定义了任务间的权重关系,那么就按照权重关系随机挑选。

- 在Locust类中的min_wait和max_wait定义的间隔时间范围(如果TaskSet类中也定义了min_wait或者max_wait,以TaskSet中的优先)内随机取一个值,休眠等待。

- 重复(2)~(3)步,直至测试任务终止。

在上面介绍的属性和类中,建议先学习TaskSet类,该类实现了虚拟用户所执行任务的调度算法,包括规划任务执行顺序(schedule_task)、挑选下一个任务(execute_next_task)、执行任务(execute_task)、休眠等待(wait)及中断控制(interrupt)等。

在此基础上的TaskSet子类可以顺利完成需要的操作,具体代码如下:

from locust import TaskSet, task

class UserBehavior(TaskSet):

@task(1)

def test_job1(self):

self.client.get('/job1')

@task(2)

def test_job2(self):

self.client.get('/job2')采用tasks属性定义任务信息时,编写代码如下:

from locust import TaskSet

def test_job1(obj):

obj.client.get('/job1')

def test_job2(obj):

obj.client.get('/job2')

class UserBehavior(TaskSet):

tasks = {test_job1:1, test_job2:2}

# tasks = [(test_job1,1), (test_job1,2)]下面编写一个接口压力测试的程序,具体代码如下:

from locust import HttpLocust, TaskSet, task

class UserBehavior(TaskSet):

def setup(self):

print('task has been setup')

def teardown(self):

print('task has been teardown')

def on_start(self):

# 虚拟用户启动任务时运行

print('starting')

def on_stop(self):

# 虚拟用户结束任务时运行

print('ending')

@task(2)

def index(self):

self.client.get("/")

@task(1)

def profile(self):

self.client.get("/profile")

class WebsiteUser(HttpLocust):

def setup(self):

print('locust setup')

def teardown(self):

print('locust teardown')

host = ‘http: // XXXXX.com’

task_set = UserBehavior

min_wait = 4000

max_wait = 8000

if __name__ == '__main__':

pass一般来说,Locust用于HTTP类型的服务测试,但是也可以自定义客户端来测试其他类型的服务,如App等。只需要编写一个触发request_success和request_failure事件的自定义客户端即可,并且官网上已经提供了一个完整的用例,代码如下:

import time

from locust import Locust, TaskSet, events, task

import requests

class TestHttpbin(object):

def status(self):

try:

r = requests.get('http://httpbin.org/status/200')

status_code = r.status_code

print status_code

assert status_code == 200, 'Test Index Error: {0}'.format(status_

code)

except Exception as e:

print e

class CustomClient(object):

def test_custom(self):

start_time = time.time()

try:

# 添加测试方法

TestHttpbin().status()

name = TestHttpbin().status.__name__

except Exception as e:

total_time = int((time.time() - start_time) * 1000)

events.request_failure.fire(request_type="Custom",name=name,

response_time=total_time, exception=e)

else:

total_time = int((time.time() - start_time) * 1000)

events.request_success.fire(request_type="Custom",name=name,

response_time=total_time, response_length=0)

class CustomLocust(Locust):

def __init__(self, *args, **kwargs):

super(CustomLocust, self).__init__(*args, **kwargs)

self.client = CustomClient()

class ApiUser(CustomLocust):

min_wait = 100

max_wait = 1000

class task_set(TaskSet):

@task(1)

def test_custom(self):

self.client.test_custom()在上述代码中,自定义了一个测试类TestHttpbin,其中,status()方法用于校验接口返回码。因此只需要在CustomClient类的test_custom()方法中添加需要的测试方法TestHttp-bin().status(),然后再利用注解的功能就可以使用Locust对该方法进行负载测试。

下面讲解一个登录GitHub的具体案例,代码如下:

# -*- coding: utf-8 -*-

from locust import HttpLocust, TaskSet, task

# 继承TaskSet类

class WebsiteTasks(TaskSet):

def on_start(self): # 初始化工作

payload = {

"username": "test_me",

"password": "123456",

}

header = {

"User-Agent": "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/

537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36"

}

self.client.post("/login", data=payload,headers=header)

@task(5)

def index(self):

self.client.get("/")

@task(1)

def about(self):

self.client.get("/about/")

class WebsiteUser(HttpLocust):

host = https://github.com/ # 提供给--host的参数

task_set = WebsiteTasks # TaskSet类

# 每个用户的间隔时间,单位是ms,是在max和min之间的随机时间

min_wait = 5000

max_wait = 15000 # 最大间隔时间4. Locust运行模式

运行Locust时,通常会使用到两种运行模式:单进程运行和多进程分布式运行。

1)单进程运行模式

Locust所有的虚拟并发用户均运行在单个Python进程中,具体从使用形式上,又分为no_web和web两种形式。该种模式由于单进程的原因,并不能完全发挥压力机所有处理器的能力,因此主要用于调试脚本和小并发压测的情况。

当并发压力要求较高时,就需要用到Locust的多进程分布式运行模式。从字面意思上看,大家可能第一反应就是多台压力机同时运行,每台压力机分担负载一部分的压力生成。的确,Locust支持任意多台压力机(一主多从)的分布式运行模式,但这里说到的多进程分布式运行模式还有另外一种情况,就是在同一台压力机上开启多个slave的情况。

这是因为当前阶段大多数计算机的CPU都是多处理器(multiple processor cores),单进程运行模式下只能用到一个处理器的能力,而通过在一台压力机上运行多个slave,就能调用多个处理器的能力了。比较好的做法是,如果一台压力机有N个处理器内核,那么就在这台压力机上启动一个master,N个slave。当然,我们也可以启动N的倍数个slave,但是根据我的试验数据,效果跟N个差不多,因此只需要启动N个slave即可。

no_web形式启动locust:

如果采用no_web形式,则需使用--no-web参数,并会用到如下几个参数。

-c, --clients:指定并发用户数;-n, --num-request:指定总执行测试次数;-r, --hatch-rate:指定并发加压速率,默认值位1。

示例:

$ locust -f locustfile.py --host = xxxxx.com --no-web -c 1 -n 2在此基础上,当我们想要调试Locust脚本时,就可以在脚本中需要调试的地方通过print打印日志,然后将并发数和总执行次数都指定为1

$ locust -f locustfile.py --host = xxxxx.com --no-web -c 1 -n 1执行测试

通过这种方式,我们就能很方便地对Locust脚本进行调试了。

Locust脚本调试通过后,就算是完成了所有准备工作,可以开始进行压力测试了。

web形式启动locust:

如果采用web形式,,则通常情况下无需指定其它额外参数,Locust默认采用8089端口启动web;如果要使用其它端口,就可以使用如下参数进行指定。

-P, --port:指定web端口,默认为8089.- 终端中--->进入到代码目录: locust -f locustfile.py --host = xxxxx.com

- -f 指定性能测试脚本文件

- -host 被测试应用的URL地址【如果不填写,读取继承(HttpLocust)类中定义的host】

- 如果

Locust运行在本机,在浏览器中访问http://localhost:8089即可进入Locust的Web管理页面;如果Locust运行在其它机器上,那么在浏览器中访问http://locust_machine_ip:8089即可。

2)多进程分布式运行

不管是单机多进程,还是多机负载模式,运行方式都是一样的,都是先运行一个master,再启动多个slave。

启动master时,需要使用--master参数;同样的,如果要使用8089以外的端口,还需要使用-P, --port参数。

D:workSpacesApiAutoTestTestCasesOpsUltraAPITestMonitorAPITest>locust -f monitorAgent.py --master --port=8089

[2018-06-05 15:36:30,654] dengshihuang/INFO/locust.main: Starting web monitor at *:8089

[2018-06-05 15:36:30,684] dengshihuang/INFO/locust.main: Starting Locust 0.8.1启动slave时需要使用--slave参数;在slave中,就不需要再指定端口了。master启动后,还需要启动slave才能执行测试任务。

D:workSpacesApiAutoTestTestCasesOpsUltraAPITestMonitorAPITest>locust -f monitorAgent.py --slave

[2018-06-05 15:36:30,654] dengshihuang/INFO/locust.main: Starting web monitor at *:8089

[2018-06-05 15:36:30,684] dengshihuang/INFO/locust.main: Starting Locust 0.8.1D:workSpacesApiAutoTestTestCasesOpsUltraAPITestMonitorAPITest>locust -f monitorAgent.py --slave --master-host=

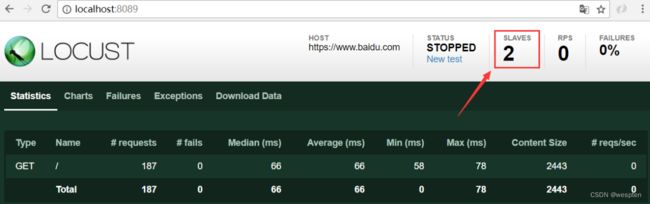

master和slave都启动完毕后,就可以在浏览器中通过http://locust_machine_ip:8089进入Locust的Web管理页面了。使用方式跟单进程web形式完全相同,只是此时是通过多进程负载来生成并发压力,在web管理界面中也能看到实际的slave数量。

如果slave与master不在同一台机器上,还需要通过--master-host参数再指定master的IP地址。

Number of users to simulate:虚拟用户数,对应中no_web模式的-c, --clients参数;

Hatch rate(users spawned/second):每秒产生(启动)的虚拟用户数 , 对应着no_web模式的-r, --hatch-rate参数,默认为1。点击Start swarming 按钮,开始运行性能测试;

5. Locust类高级用法

locustfile.py:

1 from locust import HttpLocust, TaskSet, task

2

3 class ScriptTasks(TaskSet):

4 def on_start(self):

5 self.client.post("/login", {

6 "username": "test",

7 "password": "123456"

8 })

9

10 @task(2)

11 def index(self):

12 self.client.get("/")

13

14 @task(1)

15 def about(self):

16 self.client.get("/about/")

17

18 @task(1)

19 def demo(self):

20 payload={}

21 headers={}

22 self.client.post("/demo/",data=payload, headers=headers)

23

24 class WebsiteUser(HttpLocust):

25 task_set = ScriptTasks

26 host = "http://example.com"

27 min_wait = 1000

28 max_wait = 5000脚本解读:

1、创建ScriptTasks()类继承TaskSet类: 用于定义测试业务。

2、创建index()、about()、demo()方法分别表示一个行为,访问http://example.com。用@task() 装饰该方法为一个任务。1、2表示一个Locust实例被挑选执行的权重,数值越大,执行频率越高。在当前ScriptTasks()行为下的三个方法得执行比例为2:1:1

3、WebsiteUser()类: 用于定义模拟用户。

4、task_set : 指向一个定义了的用户行为类。

5、host: 指定被测试应用的URL的地址

6、min_wait : 用户执行任务之间等待时间的下界,单位:毫秒。

7、max_wait : 用户执行任务之间等待时间的上界,单位:毫秒。脚本使用场景解读:

在这个示例中,定义了针对http://example.com网站的测试场景:先模拟用户登录系统,然后随机地访问首页(/)和关于页面(/about/),请求比例为2:1,demo方法主要用来阐述client对post接口的处理方式;并且,在测试过程中,两次请求的间隔时间为1->5秒间的随机值。

从脚本中可以看出,脚本主要包含两个类,一个是WebsiteUser(继承自HttpLocust,而HttpLocust继承自Locust),另一个是ScriptTasks(继承自TaskSet)。事实上,在Locust的测试脚本中,所有业务测试场景都是在Locust和TaskSet两个类的继承子类中进行描的。

那如何理解Locust和TaskSet这两个类呢?简单地说,Locust类就好比是一群蝗虫,而每一只蝗虫就是一个类的实例。相应的,TaskSet类就好比是蝗虫的大脑,控制着蝗虫的具体行为,即实际业务场景测试对应的任务集。

1)伪代码

from locust import HttpLocust, TaskSet, task

class WebsiteTasks(TaskSet):

def on_start(self): #进行初始化的工作,每个Locust用户开始做的第一件事

payload = {

"username": "test_user",

"password": "123456",

}

header = {

"User-Agent":"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36",

}

self.client.post("/login",data=payload,headers=header)#self.client属性使用Python request库的所有方法,调用和使用方法和requests完全一致;

@task(5) #通过@task()装饰的方法为一个事务,方法的参数用于指定该行为的执行权重,参数越大每次被虚拟用户执行的概率越高,默认为1

def index(self):

self.client.get("/")

@task(1)

def about(self):

self.client.get("/about/")

class WebsiteUser(HttpLocust):

host = "https://github.com/" #被测系统的host,在终端中启动locust时没有指定--host参数时才会用到

task_set = WebsiteTasks #TaskSet类,该类定义用户任务信息,必填。这里就是:WebsiteTasks类名,因为该类继承TaskSet;

min_wait = 5000 #每个用户执行两个任务间隔时间的上下限(毫秒),具体数值在上下限中随机取值,若不指定默认间隔时间固定为1秒

max_wait = 15000伪代码中对https://github.com/网站的测试场景,先模拟用户登录系统,然后随机访问首页/和/about/,请求比例5:1,并且在测试过程中,两次请求的间隔时间1-5秒的随机值;

on_start方法,在正式执行测试前执行一次,主要用于完成一些初始化的工作,例如登录操作;

WebsiteTasks类中如何去调用 WebsiteUser(HttpLocust)类中定义的字段和方法呢?

通过在WebsiteTasks类中self.locust.xxoo xxoo就是我们在WebsiteUser类中定义的字段或方法;

伪代码:

from locust import HttpLocust, TaskSet, task

import hashlib

import queue

class WebsiteTasks(TaskSet):

@task(5)

def index(self):

data = self.locust.user_data_queue #获取WebsiteUser里面定义的ser_data_queue队列

md5_data=self.locust.md5_encryption() #获取WebsiteUser里面定义的md5_encryption()方法

self.client.get("/")

class WebsiteUser(HttpLocust):

host = "https://github.com/"

task_set = WebsiteTasks

min_wait = 5000

max_wait = 15000

user_data_queue = queue.Queue()

def md5_encryption(self,star):

'''md5加密方法'''

obj = hashlib.md5()

obj.update(bytes(star,encoding="utf-8"))

result = obj.hexdigest()

return result伪代码中测试场景如何表达?

代码主要包含两个类:

- WebsiteUser继承(HttpLocust,而HttpLocust继承自Locust)

- WebsiteTasks继承(TaskSet)

在Locust测试脚本中,所有业务测试场景都是在Locust和TaskSet两个类的继承子类中进行描述;

简单说:Locust类就类似一群蝗虫,而每只蝗虫就是一个类的实例。TaskSet类就类似蝗虫的大脑,控制蝗虫的具体行为,即实际业务场景测试对应的任务集;

源码中:class Locust(object)和class HttpLocust(Locust)

1 class Locust(object):

2 """

3 Represents a "user" which is to be hatched and attack the system that is to be load tested.

4

5 The behaviour of this user is defined by the task_set attribute, which should point to a

6 :py:class:`TaskSet ` class.

7

8 This class should usually be subclassed by a class that defines some kind of client. For

9 example when load testing an HTTP system, you probably want to use the

10 :py:class:`HttpLocust ` class.

11 """

12

13 host = None

14 """Base hostname to swarm. i.e: http://127.0.0.1:1234"""

15

16 min_wait = 1000

17 """Minimum waiting time between the execution of locust tasks"""

18

19 max_wait = 1000

20 """Maximum waiting time between the execution of locust tasks"""

21

22 task_set = None

23 """TaskSet class that defines the execution behaviour of this locust"""

24

25 stop_timeout = None

26 """Number of seconds after which the Locust will die. If None it won't timeout."""

27

28 weight = 10

29 """Probability of locust being chosen. The higher the weight, the greater is the chance of it being chosen."""

30

31 client = NoClientWarningRaiser()

32 _catch_exceptions = True

33

34 def __init__(self):

35 super(Locust, self).__init__()

36

37 def run(self):

38 try:

39 self.task_set(self).run()

40 except StopLocust:

41 pass

42 except (RescheduleTask, RescheduleTaskImmediately) as e:

43

44 class HttpLocust(Locust):

45 """

46 Represents an HTTP "user" which is to be hatched and attack the system that is to be load tested.

47

48 The behaviour of this user is defined by the task_set attribute, which should point to a

49 :py:class:`TaskSet ` class.

50

51 This class creates a *client* attribute on instantiation which is an HTTP client with support

52 for keeping a user session between requests.

53 """

54

55 client = None

56 """

57 Instance of HttpSession that is created upon instantiation of Locust.

58 The client support cookies, and therefore keeps the session between HTTP requests.

59 """

60 def __init__(self):

61 super(HttpLocust, self).__init__()

62 if self.host is None:

63 raise LocustError("You must specify the base host. Either in the host attribute in the Locust class, or on the command line using the --host option.")

64 self.client = HttpSession(base_url=self.host) 在Locust类中,静态字段client即客户端的请求方法,这里的client字段没有绑定客户端请求方法,因此在使用Locust时,需要先继承Locust类class HttpLocust(Locust),然后在self.client =HttpSession(base_url=self.host)绑定客户端请求方法;

对于常见的HTTP(s)协议,Locust已经实现了HttpLocust类,其self.client=HttpSession(base_url=self.host),而HttpSession继承自requests.Session。因此在测试HTTP(s)的Locust脚本中,可以通过client属性来使用Python requests库的所 有方法,调用方式与 reqeusts完全一致。另外,由于requests.Session的使用,client的方法调用之间就自动具有了状态记忆功能。常见的场景就是,在登录系统后可以维持登录状态的Session,从而后续HTTP请求操作都能带上登录状态;

Locust类中,除了client属性,还有几个属性需要关注:

- task_set ---> 指向一个TaskSet类,TaskSet类定义了用户的任务信息,该静态字段为必填;