(2018ECCV)CBAM:卷积块注意模块

摘要

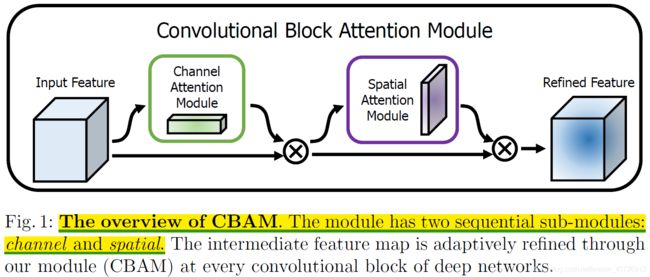

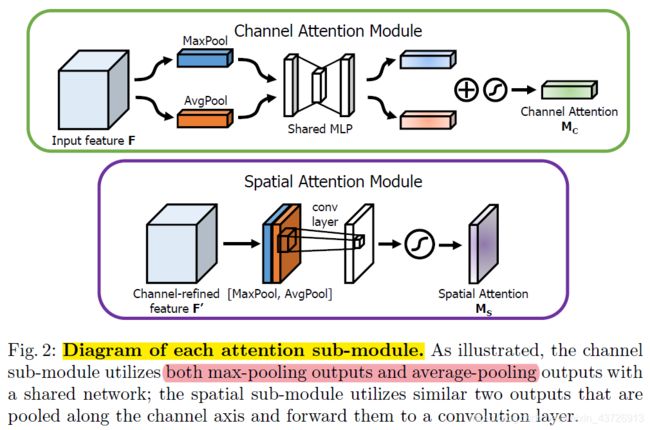

给定一个中间特征图,我们的模块将沿着通道和空间两个独立的维度依次推断出注意力图,然后将注意力图乘以输入特征图进行自适应特征细化。

引言

为了提高CNN的性能,最近的研究主要研究了网络的三个重要因素:深度、宽度和基数(cardinality)。

出了上述三种因素,我们探究了网络架构设计的另一方面:注意力机制。专注于重要的特性并抑制不必要的特性。

相关工作

网络工程。加深网络渐近饱和,由于梯度传播较为困难。

ResNet采用跳层连接来解决此问题。

基于ResNet,

WideResNet提出了一种具有较多卷积滤波器和较低深度的残差网络;

PyramidNet是对WideResNet的严格推广,其中网络的宽度逐渐增加;

ResNeXt[7]建议使用分组卷积,并表明增加基数会导致更好的分类精度;

DenseNet迭代地将输入特征与输出特征连接起来,使每个卷积块能够接收到来自所有前面块的原始信息。

现有工作主要集中在深度、宽度、二者兼有之上,而我们的工作则聚焦于注意力机制。

注意力机制。模仿人类的一种机制,Residual Attention Network使用了编码器-解码器风格的注意模块。通过优化特征图,该网络不仅性能良好,而且对噪声输入具有鲁棒性。

我们把注意力机制分解为空间维度和通道维度,并且做到了即插即用模块化。

Squeeze-and-Excitation使用全局平均池化特性来计算通道上的注意力。然而,我们证明这些是次优特征当用于推断精细的通道注意,我们建议也使用最大池化特征。并且他们丢失了空间注意力。

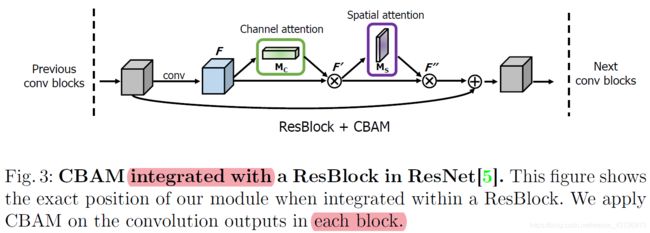

BAM将三维注意图推理分解为通道和空间。他们在网络的每个bottleneck处放置BAM模块,而我们在每个卷积块处插入。

CBAM

输入:中间特征图

输出:1D通道注意图

2D空间注意图

整个注意过程:

![]() 表示element-wise乘法。

表示element-wise乘法。

在乘法过程中,注意值被相应地传播(复制):通道注意值沿着空间维度传播,反之亦然。

F’'是最后的输出。图2描述了计算过程。

通道注意力模块。对于空间信息的聚集,目前普遍采用平均池的方法。除了之前的工作,我们认为最大池收集了关于不同物体特征的另一个重要线索,以推断更精细的通道注意。因此,我们同时使用平均池和最大池特性。

空间注意力模块。

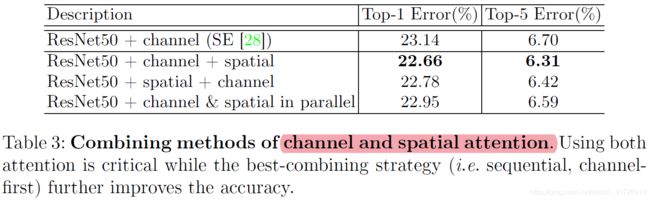

注意模块的安置。两个模块可以以并行或顺序的方式放置。我们发现顺序排列比平行排列的结果更好。对于顺序过程的安排,我们的实验结果表明信道优先比空间优先略好。

实验

消融研究

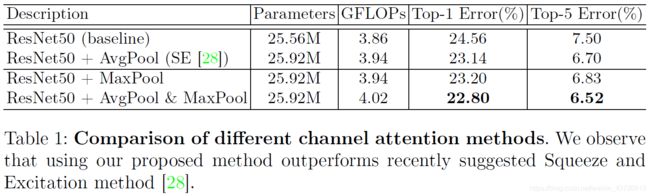

通道注意。在本实验中,我们只使用通道注意模块,并将reduction ratio固定为16。我们认为,对最显著部分进行编码的最大池特征可以补偿对全局统计量进行软编码的平均池特征。我们的经验表明,我们的通道注意方法是一种有效的方式来进一步推动性能从SE[28]没有额外的可学习参数。作为一个简短的结论,我们在接下来的实验中使用了平均和最大池的特征在我们的通道注意模块,减少比率为16。

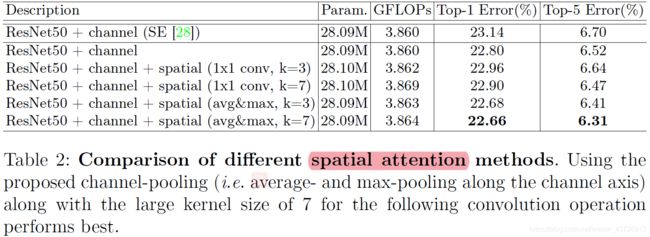

空间注意。考虑到通道的细化特征,我们探索了一种计算空间注意力的有效方法。设计理念与通道关注分支对称。为了生成一个二维空间注意力地图,我们首先计算一个二维描述符,该描述符在所有空间位置上的每个像素上编码通道信息。然后我们将一个卷积层应用于2D描述符,获得原始的注意力地图。最后的注意图由sigmoid函数归一化。

我们可以观察到,通道池化产生了更好的准确性,这表明显式建模池导致更精细的注意推断,而不是可学习的加权通道池(实现为1 × 1卷积)。通过比较不同的卷积核大小,我们发现在两种情况下,采用更大的核大小都能产生更好的精度。这意味着需要一个广阔的视野(即大的接受域)来决定空间上重要的区域。考虑到这一点,我们采用通道池方法和具有大核大小的卷积层来计算空间注意力。一个简短的结论,我们使用平均和最大池特征横跨通道轴与卷积核大小7作为我们的空间注意模块。

通道注意、空间注意的安排。

从结果中,我们可以发现依次生成注意力地图比并行生成更精细的注意力地图。此外,通道一阶的性能略好于空间一阶。请注意,所有的排列方法都优于单独使用通道注意,这表明利用两个注意是至关重要的,而最佳排列策略进一步推动性能。

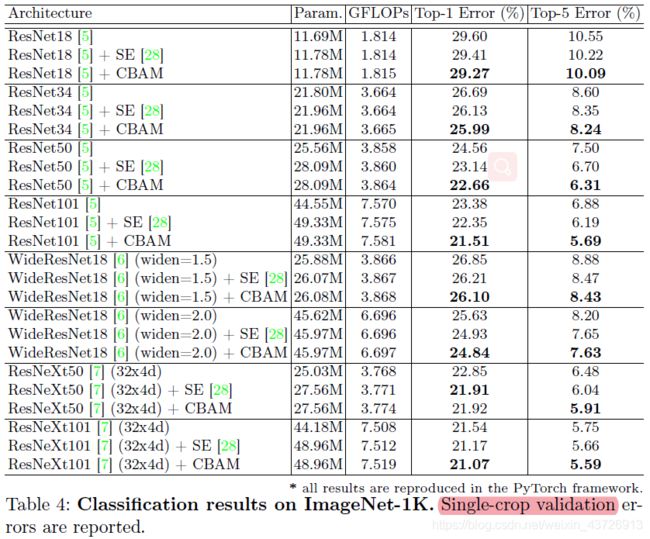

在ImageNet-1K上图像分类

我们还发现CBAM的总体开销在参数和计算方面都非常小。

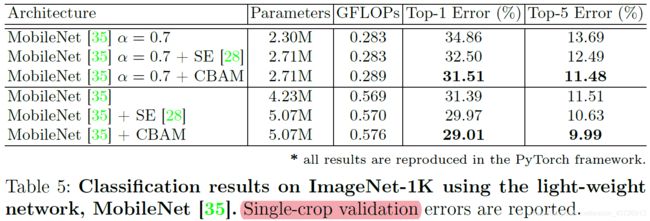

我们将CBAM放置在两个模型中,基本模型和容量降低模型(即调整宽度乘数()为0.7)。我们观察到类似的现象如表4所示。CBAM不仅显著提高了基线的准确性,而且很好地改善了SE[28]的性能。这显示了CBAM对于低端设备上的应用程序的巨大潜力。

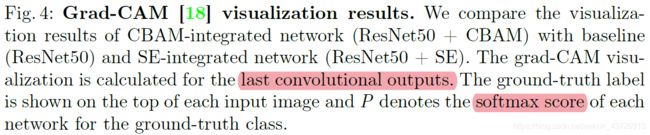

用Grad-CAM进行网络可视化

改进的可解释性的定量评价

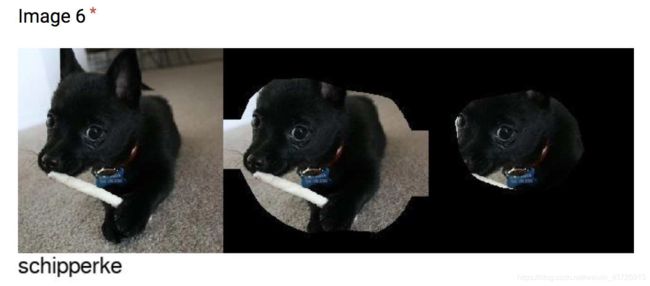

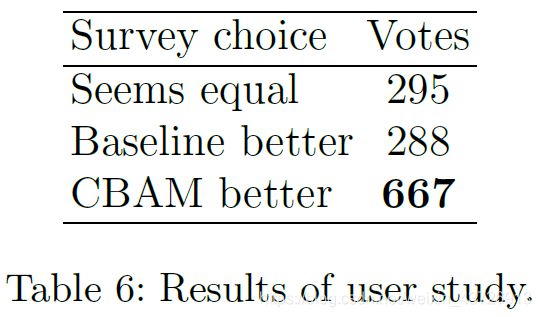

按照grado - cam论文5.1节的内容,我们进行了一个基于grado - cam可视化的用户研究。我们随机选取了50张用两种方法都能正确分类的图像。基线和CBAM)从ImageNet验证集。用户研究是在谷歌Forms平台上进行的。对于每个问题,随机打乱的可视化显示给受访者。对于可视化,将显示图像中grade - cam值为0.6或更大的区域。在实际操作中,受访者分别获得完整输入的图像、ground-truth标签以及每种方法的两个图像区域(见图5)。比较标准为“给定class标签,哪个区域似乎更具有class discriminative?”受访者可以选择其中一个更好,或两者相似。总共有50个问题集和25个受访者,总共有1250张选票。结果如表6所示。我们可以清楚地看到,CBAM优于基线,显示出改进的可解释性。

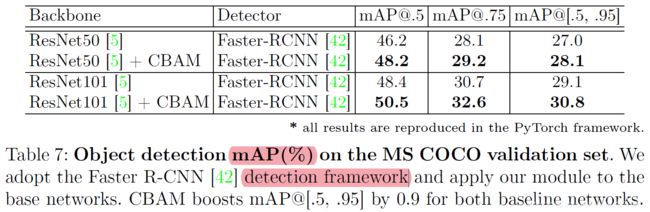

MS COCO目标检测

如表7所示,我们观察到与基线相比有了显著的改善,证明了CBAM在其他识别任务上的泛化性能。

VOC2007目标检测

实验结果如表8所示。我们可以清楚地看到,CBAM提高了两个骨干网的所有强基线的准确性。请注意,CBAM的准确性改进带来的参数开销可以忽略不计,这表明增强不是由于简单的容量增量,而是由于我们有效的特性细化。此外,使用轻量级骨干网的结果再次表明,CBAM可以是一种用于低端设备的有趣方法。