【论文翻译】异构信息网络核的文本分类

异构信息网络核的文本分类

摘要

文本分类是一个具有多种应用的重要问题。传统方法将文本表示为一个单词包,并基于该表示来构建分类器。实体之间的关系,以及实体和关系的类型携带了更多的信息来表示文本,而不是单词、实体短语。提出了一种新的文本网络分类框架,该框架引入了1)结构化和类型化的异构信息网络文本表示,2)基于元路径的文本链接方法。我们表明,有了新的文本表示和链接,实体和关系的结构化和类型化信息可以合并到内核中。特别地,我们在文本的HIN表示中开发了基于元路径的简单线性核和不定核,我们称它们为HIN核。利用世界著名的知识库Freebase构建文本的HIN,在两个基准数据集上的实验表明,基于加权元路径的不定HIN核优于现有方法和其他HIN核。

引言

文本分类已被广泛应用于许多领域,如新闻文章分类、社交媒体分析和在线广告。大多数文本分类技术将文本表示为词袋特征,并基于这些特征构建分类器来学习文本和标签之间的预测函数。虽然将文本表示为BOW是简单且常用的,但是单词和内部实体之间语义关系的结构性本质是不太探索的,但是信息丰富。与单个单词相比,实体可以不那么模糊,并且具有更多关于类别的信息。比如“诺贝尔之子”和“诺贝尔奖”代表不同的含义。与“诺贝尔”、“儿子”等词相比,它们分别为电影和奖项类别提供了更多有用的信息..如果我们能够识别实体名称和类型(粗粒度的类型如人、位置和组织;细粒度类型,如政治家、音乐家、国家和城市),这些将有助于更好地确定文本的类别。而且实体和文字之间的链接信息也很重要。例如,如果有两个文件分别谈论谷歌和微软的首席执行官,如果我们在一个文本中的子类型企业家的“拉里·佩奇”和另一个文本中的子类型企业家的“比尔·盖茨”之间建立联系,那么他们就在同一个类别中,因为他们都谈论企业家,并连接到谷歌和微软所在的“美国”。因此,可以利用非结构化文本中的结构信息来进一步提高文本分类的性能。

目前已有一些研究使用外部知识库如WordNet(Hoto,Staab,Stumme,2003),Wikipedia (Gabrilovich,Markovitch,2007)或Probase (Song,Wang,Wang,2015)来自动丰富文本表示,从而提高分类器的预测能力。然而,这些方法忽略了知识库中的结构信息,只将知识视为“扁平”特征。其他人试图从文档中的单词来构建网络(王、Do和林2005;Rousseau、Kiagias和Vazirgiannis(2015),并使用图形相似性或图形核来比较文本(Vishwanathan等人,2010)。然而,他们没有考虑文本内部的实体和关系,以及实体和关系的类型。

在本文中,我们提出将一个文本表示为一个异构信息网络,并考虑连接不同文档的结构化和类型化信息对文本进行分类。结构化和类型化的信息是通过将文本建立在世界知识库的基础上而生成的(王等,2015a)。然后我们使用元路径(孙和韩2012)来链接不同的文档。我们开发了简单的基于链接的传统文本特征表示的增强和更复杂的基于加权元路径的相似性来比较文档。这两种方法都可以是统一的。由于复杂的相似性不是正半定的,为了定义一个基于相似性的合法核,我们提出用一个不定核SVM来解决这个问题。在两个基准数据集上的实验结果表明,具有基于加权元路径相似性的不确定HIN核优于现有技术表示和其他HIN核。本文的主要贡献如下:

- 我们研究将文本分类转换为结构化和类型化的网络分类问题,以整合来自知识库的丰富语义信息。

- 我们提出了一个通用的分类框架,通过使用不同类型的HIN内核合并类型化的链接信息

基于链接的线性核

我们的文本作为网络分类框架将文本分类转化为网络分类,以便利用网络的结构化和类型化信息来提高学习模型的预测能力。在这一节中,我们给出了一个简单的方法,将元路径显示的链接合并到特性中。

基于HIN链接的文本分类

我们使用Wang et al.(Wang et al.2015a)提出的世界知识规范框架,将文本数据连接到世界知识库。它包括两个主要步骤,语义分析(从文本中生成部分逻辑形式)和语义过滤(消除从文本中检测到的实体和关系的歧义)。语义分析和语义过滤的输出不仅是与实体相关联的文本,而且是与类型和关系相关联的文本。然后我们使用HIN(Sun和Han 2012)来表示数据。定义1显示了我们使用HIN的重要概念。

定义1 给定了一个HIN G=(V,E),实体类型映射![]() ,关系类型映射ψ:E→R,网络G的网络模式,表示为

,关系类型映射ψ:E→R,网络G的网络模式,表示为![]() ,是一个图,节点作为从A到边的实体类型,作为R的关系类型。元路径P是网络模式

,是一个图,节点作为从A到边的实体类型,作为R的关系类型。元路径P是网络模式![]() 图上定义的路径,并在

图上定义的路径,并在![]() ,定义复合关系

,定义复合关系![]() ,在类型

,在类型![]() 中,其中·表示关系组合运算符,L为P的长度。

中,其中·表示关系组合运算符,L为P的长度。

然后文本网络包含多个实体类型:文本D、单词W、命名实体![]() ,以及连接实体类型的关系类型。我们基于HIN的文本分类旨在整合文本中结构化和类型化的链接信息,以及用于分类任务的文本表示(如BOW)。

,以及连接实体类型的关系类型。我们基于HIN的文本分类旨在整合文本中结构化和类型化的链接信息,以及用于分类任务的文本表示(如BOW)。

表述分类问题的一种直观方法是使用基于链接的分类框架(Lu和Getoor 2003)。我们介绍了基于文档(HIN中的一个实体)的特性及其与其他实体的关系。在形式上,我们将文档之间的关系表示为![]() 我们把文档d ∈ D的实体和关系特征分别表示为

我们把文档d ∈ D的实体和关系特征分别表示为![]() 和

和![]() 。对于实体特征

。对于实体特征![]() ,我们只使用带有术语频率(tf)加权机制的词包。下面介绍基于HIN的关系特征构造。受(Lu和Getoor 2003)中提出的计数链接方法的启发,对于连接两个文档

,我们只使用带有术语频率(tf)加权机制的词包。下面介绍基于HIN的关系特征构造。受(Lu和Getoor 2003)中提出的计数链接方法的启发,对于连接两个文档![]() 和

和![]() 的每个元路径,我们使用元路径的元路径实例的数量作为

的每个元路径,我们使用元路径的元路径实例的数量作为![]() 和

和![]() 的一个对应特征。与Lu和Getoor的设置不同,我们不区分输入、输出和共链,因为HIN是无向图。

的一个对应特征。与Lu和Getoor的设置不同,我们不区分输入、输出和共链,因为HIN是无向图。

现在我们可以将HIN-link合并到常用的模型中,例如朴素贝叶斯和SVM,并分别提出![]() 和

和![]() 。我们将一组训练示例表示为

。我们将一组训练示例表示为![]() ,相应的标签表示为

,相应的标签表示为![]() 。

。

![]() 。用于文本分类的传统朴素贝叶斯分类器被表述为:

。用于文本分类的传统朴素贝叶斯分类器被表述为:

其中![]() 表示文件d的实体特征向量

表示文件d的实体特征向量![]() 中的特征。

中的特征。

我们还将这些链接合并到朴素贝叶斯模型中:

那么组合的估计函数是:

![]() 。设矩阵X为矩阵,其中

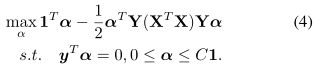

。设矩阵X为矩阵,其中![]() ,矩阵Y = diag(y),向量1为所有1的n维向量,C为正的权衡参数。然后,1-范数软边缘SVM的对偶公式由下式给出

,矩阵Y = diag(y),向量1为所有1的n维向量,C为正的权衡参数。然后,1-范数软边缘SVM的对偶公式由下式给出

这里我们有![]() 个等价于

个等价于![]() 中的

中的![]() 。通过这样做,

。通过这样做,![]() 提供了一种将结构化信息与传统特征相结合的简单方法。为了学习

提供了一种将结构化信息与传统特征相结合的简单方法。为了学习![]() ,我们使用凸二次规划来解决等式(4)中的对偶问题。

,我们使用凸二次规划来解决等式(4)中的对偶问题。

基于链接的内核

一般来说,用于文本分类任务的主要模型族是类似线性的模型,其可以表示为对应于特征的参数向量θ。对于输入实例![]() 和输出赋值y,实例的得分可以表示为

和输出赋值y,实例的得分可以表示为![]() 。我们的框架引入了实体和关系特征,因此

。我们的框架引入了实体和关系特征,因此![]() .我们的文本作为网络分类框架的目的是推断输出变量的最佳标签分配,

.我们的文本作为网络分类框架的目的是推断输出变量的最佳标签分配,

其中![]() 是从要素到标签的映射函数。特别是对于像SVM这样的判别模型,很容易验证

是从要素到标签的映射函数。特别是对于像SVM这样的判别模型,很容易验证![]() 是一个线性核,它可以包含来自HIN的结构化链接信息。

是一个线性核,它可以包含来自HIN的结构化链接信息。

不定HIN核SVM

虽然基于HIN链接的分类可以成功地使用HIN中的结构化和类型化信息,但它仍然会丢失很多信息,例如不同元路径的重要性。一些元路径比其他的更重要。例如,对于谈论体育的文档,以下元路径比关于宗教的文档更重要:

文档→棒球→体育→棒球→文档

而不是这个关于宗教的:

文档→宗教→政府→宗教→文档。

因此,我们应该把元路径作为一个整体来考虑,而不仅仅是把它们当作到文档的链接。

在这一部分,我们介绍了一种新的文本分类相似度。我们引入了一个基于加权元路径相似性的SVM核,而不是使用元路径作为链接。为了合并所有连接两个文档的感兴趣的(或重要的)元路径,我们基于上一节开发的文本HIN的元路径开发了以下相似性。

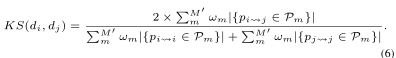

定义2 KnowSim:知识驱动的文档相似性度量。给定对称元路径的集合,表示为![]() ,两个文档之间的

,两个文档之间的![]() 和

和![]() 定义为:

定义为:

其中![]() 是跟随元路径

是跟随元路径![]() 的

的![]() 和

和![]() 之间的路径实例。

之间的路径实例。![]() 是

是![]() 和

和![]() 之间的,还有

之间的,还有![]() 是

是![]() 和

和![]() 之间的那个。我们有

之间的那个。我们有![]() ,

,![]()

![]() 和

和![]() 。

。

在这里,我们使用交换矩阵的定义如下。

定义3 交换矩阵。给定网络G = (V,E)及其网络模式![]() ,元路径

,元路径![]() 的交换矩阵

的交换矩阵![]() 定义为

定义为![]() ,其中

,其中![]() 是Ai和Aj类型之间的邻接矩阵。

是Ai和Aj类型之间的邻接矩阵。![]() (i,j)表示对象xi和yj之间的路径实例数,其中,在元路径P下,

(i,j)表示对象xi和yj之间的路径实例数,其中,在元路径P下,![]() 和

和![]() 。

。

我们使用依赖于元路径的PageRank-Nibble算法来加速所有交换矩阵的计算过程(Andersen,Chung和Lang 2006),并使用拉普拉斯评分(he,Cai和Niyogi 2006)来基于对应于权重ωm的文档相似性对不同元路径的重要性进行评分(王等人2015b)。

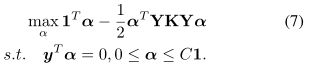

具有不定HIN核的SVM

我们用K来表示核矩阵。假设K是半正定的(PSD)。类似于等式(4),设矩阵Y = diag(y),向量1是所有1的n维向量,C是正的权衡参数。然后1-范数软边缘SVM的对偶公式由下式给出

当K为PSD时,上述问题为凸二次规划,得到有效解决。

然而,KnowSim矩阵K,其中![]()

![]() ,是非PSD (Berg,Christensen和Ressel 1984)。我们用

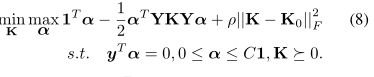

,是非PSD (Berg,Christensen和Ressel 1984)。我们用![]() 来表示由KnowSim生成的不定核矩阵。Luss和d'Aspremont (Luss和d'Aspremont 2008)提出了一种鞍点(min-max)方法来同时学习不定矩阵K0和SVM分类的代理PSD核矩阵K,如下所示:

来表示由KnowSim生成的不定核矩阵。Luss和d'Aspremont (Luss和d'Aspremont 2008)提出了一种鞍点(min-max)方法来同时学习不定矩阵K0和SVM分类的代理PSD核矩阵K,如下所示:

设![]() ,

,![]()

![]() 。参数ρ > 0控制对K和K0之间距离的惩罚幅度。如果有一个矩阵A是PSD,我们就写成

。参数ρ > 0控制对K和K0之间距离的惩罚幅度。如果有一个矩阵A是PSD,我们就写成![]() 基于最小-最大定理(Boyd和V andenberghe 2004),等式(8)等于

基于最小-最大定理(Boyd和V andenberghe 2004),等式(8)等于![]() 。因此,目标函数表示为

。因此,目标函数表示为

然后,我们遵循(应,坎贝尔和吉罗拉米2009)中的定理1来建立目标函数的可微性

![]()

基于(Luss和d'Aspremont 2008),对于固定α,![]() 的最优解由

的最优解由![]() 得出。对于任何矩阵A,符号A+的概念通过将其负特征值设置为零来表示A的正部分。然后我们遵循(Ying,Campbell,和Girolami 2009)中的定理2,并证明了方程(10)中目标函数的梯度是Lipschitz连续梯度。Lipschitz常数等于

得出。对于任何矩阵A,符号A+的概念通过将其负特征值设置为零来表示A的正部分。然后我们遵循(Ying,Campbell,和Girolami 2009)中的定理2,并证明了方程(10)中目标函数的梯度是Lipschitz连续梯度。Lipschitz常数等于![]()

![]() 。因此,对于任何

。因此,对于任何![]() ,

,![]()

![]()

这表明不需要平滑目标函数,这将极大地促进梯度族算法。我们使用内斯特罗夫的有效平滑优化方法(内斯特罗夫2005)来解决我们的凸规划问题。因为该方案与(Luss和d'Aspremont 2008)![]() 中提出的常用投影梯度法相比,具有最优收敛速度

中提出的常用投影梯度法相比,具有最优收敛速度![]() 。k是迭代次数。我们特别将(内斯特罗夫2005)中介绍的特定一阶平滑优化方案应用于我们的目标函数(9)。然后得到不定SVM的光滑优化算法。

。k是迭代次数。我们特别将(内斯特罗夫2005)中介绍的特定一阶平滑优化方案应用于我们的目标函数(9)。然后得到不定SVM的光滑优化算法。

实验

在这一节中,我们从经验上展示了如何将外部知识融入到HIN内核中。

数据集

我们从两个基准数据集得出四个分类问题,如下所示。

20个工作组(20个工作组):本着(Basu,Bilenko和Mooney 2004)的精神,通过从20个工作组中选择三个类别来创建两个数据集。20NG-SIM由三个主题相似的新闻组(comp.graphics、comp.sys.mac.hardware和comp.os.ms-windows.misc)组成,各组之间有很大的重叠。20NG-DIF由三个新闻组中的文章组成,这些文章涵盖不同的主题(rec.autos、comp.os.mswindows.misc和sci.space),并有很好的分类。

RCV1:我们从顶级类别GCA T(政府/社会)中导出RCV1的两个子集(刘易斯等人,2004)。类似于20NG,每个都包含三个叶类。GCAT-SIM由三个类似主题(天气、GDIS、环境和自然世界)的文章组成,在这些类别之间有很大的重叠。我们分别有1014、2083和499份三类文件。GCAT-DIF由三个叶类组成,涵盖不同的主题(根特(艺术、文化和娱乐)、戈达德(人类兴趣)和国防),并有很好的分类。我们分别有1062、1096和542份文件用于这三个类别。

免费基础的基础文本

我们在实验中使用Freebase作为我们的世界知识来源。Freebase包含超过20亿个4000万个实体之间的关系表达式。而且Freebase中有1500+实体类型和3500+关系类型(Dong等2014)。我们将语义解析器生成的逻辑形式转换成SPARQL查询,并使用Virtuoso引擎在Freebase的副本上执行它。

在进行语义解析和过滤后,表1总结了不同文档数据集中使用Freebase的实体数量。数据集的关系数是(通过语义解析和过滤解析的逻辑形式)20NG-SIM (1,834,399)、20NG-DIF (1,587,864)、GCAT-SIM (962,084)和GCAT-DIF (1,486,961)。我们为20NG和GCA T保留了20个和43个顶级实体类型,然后基于依赖于元路径的PageRank-Nibble算法生成325个和1,682个对称元路径来计算交换矩阵。

分类结果

在这个实验中,我们分析了我们的分类方法的性能。

基于HIN链接的文本分类 我们首先通过比较![]() 和

和![]() 与传统的朴素贝叶斯和SVM来评估基于HIN链接的分类的有效性。关于NB和SVM的功能设置定义如下。

与传统的朴素贝叶斯和SVM来评估基于HIN链接的分类的有效性。关于NB和SVM的功能设置定义如下。

- BOW。具有tf加权机制的传统词袋模型。弓+实体。

- BOW+ENTITY。BOW集成了来自实体的附加功能,这些实体来自Freebase的基础世界知识。此设置将世界知识作为平面特征纳入。

- WEAvg。我们使用Word2V ec (Mikolov等2013)分别基于20NG和GCAT训练单词嵌入。然后,我们使用平均单词向量作为特征,将它们馈送给分类器。我们将窗口大小设置为5,使用CBOW模型和分层softmax进行快速训练,学习的单词表示为400维。

![]() 和

和![]() 是基于HIN链接的文本分类算法。实体特征和关系特征是相对应的。我们实验了上面的四个数据集。每个数据分割有三个二进制分类任务。对于每个任务,相应的数据随机分为80%的训练数据和20%的测试数据。我们对训练集进行5倍交叉验证,以确定SVM和奇异值分解的最佳超参数。然后将所有的分类模型放在一个训练集上(基于SVM的方法,用C语言),并在测试集上进行测试。我们采用分类精度作为评价指标。

是基于HIN链接的文本分类算法。实体特征和关系特征是相对应的。我们实验了上面的四个数据集。每个数据分割有三个二进制分类任务。对于每个任务,相应的数据随机分为80%的训练数据和20%的测试数据。我们对训练集进行5倍交叉验证,以确定SVM和奇异值分解的最佳超参数。然后将所有的分类模型放在一个训练集上(基于SVM的方法,用C语言),并在测试集上进行测试。我们采用分类精度作为评价指标。

表1:使用Freebase进行语义解析和过滤的不同数据集中实体的统计:#(Document)是所有文档的数量;类似于#(单词)(# of单词)、#(FBEntity) (# of Freebase实体)、#(Total)(实体总数)和# Types(实体子类型总数)。

在表2中,我们显示了在所有四个数据集上具有不同设置的所有分类模型的性能。我们在四个数据集的每个数据集中报告三个二进制分类结果的平均分类精度。请注意,这里我们关注的是![]() 对NB,以及

对NB,以及![]() 对SVM,直接测试我们的一般分类框架。从结果来看,我们发现

对SVM,直接测试我们的一般分类框架。从结果来看,我们发现![]() 和

和![]() 与NB和SVM在WEAvg上有竞争力,在其他设置上优于NB和SVM。这意味着,通过使用从世界知识中提取的HIN中的链接信息(具体指关系特征),我们可以改进文本分类,尤其是与仅使用实体作为附加特征(BOW+ENTITY)的文本分类相比。该结果甚至可以与分别基于20NG和GCAT数据训练的最先进的单词嵌入方法相媲美。此外,我们还发现

与NB和SVM在WEAvg上有竞争力,在其他设置上优于NB和SVM。这意味着,通过使用从世界知识中提取的HIN中的链接信息(具体指关系特征),我们可以改进文本分类,尤其是与仅使用实体作为附加特征(BOW+ENTITY)的文本分类相比。该结果甚至可以与分别基于20NG和GCAT数据训练的最先进的单词嵌入方法相媲美。此外,我们还发现![]() 和

和![]() 在GCAT-SIM和GCAT-DIF上的改进大于20NG-SIM和20NGDIF。如表1所示,GCAT-SIM和GCA T-DIF有更多基于Freebase的实体和相关类型。

在GCAT-SIM和GCAT-DIF上的改进大于20NG-SIM和20NGDIF。如表1所示,GCAT-SIM和GCA T-DIF有更多基于Freebase的实体和相关类型。

表2:不同分类算法在20NG-SIM、20NG-DIF、GCAT-SIM和GCAT-DIF数据集上的性能。BOW、ENTITY分别代表词袋特征和基于Freebase的世界知识规范框架生成的实体。在我们基于HIN链接的文本分类框架下,使用传统朴素贝叶斯和SVM的变种。![]() +KnowSim代表等式中定义(7)的1范数软边缘SVM,具有不确定的基于KnowSim的内核。Indef

+KnowSim代表等式中定义(7)的1范数软边缘SVM,具有不确定的基于KnowSim的内核。Indef![]() +KnowSim代表SVM,它有一个代理PSD内核,用于不定的KnoWSIM矩阵,如等式(8)所示。DWD和DWD+MP分别代表了基于KnowSim构造的核矩阵,该核矩阵具有单个PDW路径和基于文本HIN生成的各种元路径。

+KnowSim代表SVM,它有一个代理PSD内核,用于不定的KnoWSIM矩阵,如等式(8)所示。DWD和DWD+MP分别代表了基于KnowSim构造的核矩阵,该核矩阵具有单个PDW路径和基于文本HIN生成的各种元路径。

基于不定HIN核的SVM 接下来,我们通过与框架下的其他分类方法(即![]() 和

和![]() )进行比较来测试KnowSim内核方法的性能。我们用核方法导出了两个SVM。

)进行比较来测试KnowSim内核方法的性能。我们用核方法导出了两个SVM。

- 一个被表示为“

+KnowSim”,使用等式(7)中定义的1形式软余量SVM。通过将KnowSim矩阵的负特征值设置为零。

+KnowSim”,使用等式(7)中定义的1形式软余量SVM。通过将KnowSim矩阵的负特征值设置为零。 - 另一个表示为“不确定性+已知性”它为不定的KnowSim矩阵学习一个代理PSD内核,如等式(8).所示。如果目标函数值的变化小于10-6,则基于5重交叉验证和的有效平滑优化方法(2005)对不定的参数C和ρ进行调整(应,坎贝尔和吉洛拉米2009)。

我们还探索了使用KnowSim(定义2)作为文本分类的核心矩阵的最佳方式。我们特别探索了两种不同的KnowSim计算设置。

- DWD。内核矩阵是基于只使用属于

元路径(即等式(6)中的M'=1).这个设置的目的是测试内核方法本身是否仍然有效,即使在HIN中有最简单的结构信息的情况下,当我们拥有与单词包特征几乎相同的信息量时。

元路径(即等式(6)中的M'=1).这个设置的目的是测试内核方法本身是否仍然有效,即使在HIN中有最简单的结构信息的情况下,当我们拥有与单词包特征几乎相同的信息量时。 - DWD+MP。核矩阵是基于KnowSim使用属于文本HIN中各种元路径的元路径实例来构造的。这个设置的目的是测试基于SVM核的系统如何利用指定的世界知识进行文本分类。

如表2所示,在所有数据集上,使用DWD+MP的Indef![]() +Knowsim始终表现最佳。通过t检验,我们发现这些改进在0.05显著性水平上是显著的。特别是,我们可以得出以下的观察和结论。

+Knowsim始终表现最佳。通过t检验,我们发现这些改进在0.05显著性水平上是显著的。特别是,我们可以得出以下的观察和结论。

+KnowSim和DWD的性能比SVM和BOW的性能要好。这是因为在等式(6)交换矩阵中的值有一个归一化项,即文档和单词之间的矩阵。等式(6)中的归一化项。

+KnowSim和DWD的性能比SVM和BOW的性能要好。这是因为在等式(6)交换矩阵中的值有一个归一化项,即文档和单词之间的矩阵。等式(6)中的归一化项。 ,对应于信息网络中文档节点的度。对比等式(4)在没有执行标准化的情况下,这表明标准化确实有助于形成更好的相似性。注意,余弦相似度是另一种广泛使用的归一化文档长度的方法,但它不能应用于信息网络。

,对应于信息网络中文档节点的度。对比等式(4)在没有执行标准化的情况下,这表明标准化确实有助于形成更好的相似性。注意,余弦相似度是另一种广泛使用的归一化文档长度的方法,但它不能应用于信息网络。- 带有DWD+MP的两种内核方法都优于

和

和 。原因是通过将元路径信息作为一个整体来考虑,并使用一些加权机制来选择更重要的元路径确实有助于为文本分类编码更多的信息。

。原因是通过将元路径信息作为一个整体来考虑,并使用一些加权机制来选择更重要的元路径确实有助于为文本分类编码更多的信息。 - 无论是

+KnowSim还是Indef

+KnowSim还是Indef +KnowSim,DWD+MP都比DWD强。这表明,HIN中的元路径与知识(例如,实体和关系)相比,通过单词来获取文档之间的链接,可以获取更多的文档相似性信息。

+KnowSim,DWD+MP都比DWD强。这表明,HIN中的元路径与知识(例如,实体和关系)相比,通过单词来获取文档之间的链接,可以获取更多的文档相似性信息。 - 不定

+KnowSim总是比

+KnowSim总是比 +KnowSim好用。原因可能是通过去除负特征值去噪非平稳核会丢失一些关于相似性的有用信息。

+KnowSim好用。原因可能是通过去除负特征值去噪非平稳核会丢失一些关于相似性的有用信息。 - 带有DWD+MP的Indef

+KnowSim始终优于带有WEAvg的分类器。这意味着,与隐式嵌入所暗示的相比,具有世界知识的KnowSim内核承载了更多关于文本之间相似性的语义。

+KnowSim始终优于带有WEAvg的分类器。这意味着,与隐式嵌入所暗示的相比,具有世界知识的KnowSim内核承载了更多关于文本之间相似性的语义。

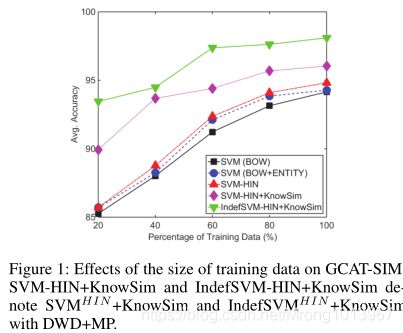

此外,我们测试了世界知识对于提高分类性能的有效性。我们选择一个数据集(GCAT模拟),并为每个算法改变训练数据的大小(20%,40%,60%,80%,100%)。结果总结在图1中。似乎在训练数据较少的情况下,外部知识可以更好地提高分类精度。

除了使用KnowSim,我们还使用了Schuhmacher和Ponzetto(2014)提出的知识库图语义相似度(GSim)来度量文档相似度。我们使用不确定SVM来编码内核中的GSim相似性。由于GSim的时间复杂度较高,我们基于Freebase的子图文本HIN实现了GSim。在20NG-SIM数据集上,我们达到了50.44%的准确率。这表明GSim可能不太适合在大规模数据集的不定SVM中使用。

相关工作

对文本分类早期研究的一些深入回顾可以在(塞巴斯蒂安,2002;Aggarwal和翟2012)。几个里程碑式的研究包括使用支持向量机(SVM)(约阿希姆1998)和朴素贝叶斯(麦卡勒姆,尼甘和其他人1998)与BOW特征进行文本分类。最近工作的一个方向是利用结构信息进行更好的分类。基于链接的分类(Lu和Getoor 2003Kong等人(2012)使用文本之间的关系(例如,链接的数量)作为原始BOWs特征的附加特征。王、杜、林2005;Hassan,Mihalcea,和Banea 2007Rousseau、Kiagias和Vazirgianis(2015)最近提出了代表性,与BOW相比显示出更好的结果。然而,这些方法侧重于数据统计,而没有考虑链接的语义。例如,在单词图中,如果两个单词出现在一个文档的附近,这些单词将被链接。我们的方法旨在利用链接的语义来进行分类,即实体和链接是带类型的。

另一个方向是用来自世界知识的语义来丰富文本表示。语言知识库如WordNet(Hoto,Staab,Stumme 2003)或通用知识库如Open Directory (Gabrilovich和Markovitch 2005),Wikipedia (Gabrilovich和Markovitch 2007胡等2008;2009),或从开放领域数据如网页中提取的知识(王等,2013;2015c)和Probase (Song等人,2011;宋、王和王(2015)已经被用来扩展文档的特征以改进文本分类。然而,我们并不使用平面特征这样的知识,而是在内核中基于链接(元路径)对文档之间的相似性进行编码,这些相似性是在从知识库Freebase生成的网络中得到的。

使用世界知识为文本分类建立语义核的建议已在(Siolas和Buc 2000;王等2007;王和多梅尼科尼(2008)。语义内核以监督的方式构建,只考虑直接(单跳)链接。然而,我们不需要额外的邻近矩阵来构造内核。此外,KnowSim内核通过一种完全不受监督的方式获取多跳链接(即元路径)。除了KnowSim之外,Schuhmacher和Ponzetto(2014)还提出了基于知识的图语义相似度(GSim)来度量基于DBpedia的文档相似度。但是计算GSim的时间复杂度很高。因此,这在我们的大规模数据集上是不可行的(在原始论文中,他们在包含50个文档的文档集上进行实验)。然而,KnowSim可以在几乎线性的时间内计算出来。最近,Kim等人(Kim,Rousseau和Vazirgiannis 2015)介绍了基于单词嵌入由给定单词向量空间的单词距离生成的句子核。然而,我们提出的基于知识模型的内核是建立在由知识库中的显式世界知识所构建的核上的。整合单词嵌入结果和显性世界知识信息也很有意思(宋和Roth 2015)。这样,当面对某些特定领域的知识稀缺时,知识模型可以更加健壮。在(Siolas和Buc,2000年;王等2007;王和多梅尼科尼(2008)。语义内核以监督的方式构建,只考虑直接(单跳)链接。然而,我们不需要额外的邻近矩阵来构造内核。此外,KnowSim内核通过一种完全不受监督的方式获取多跳链接(即元路径)。除了KnowSim之外,Schuhmacher和Ponzetto(2014)还提出了基于知识的图语义相似度(GSim)来度量基于DBpedia的文档相似度。但是计算GSim的时间复杂度很高。因此,这在我们的大规模数据集上是不可行的(在原始论文中,他们在包含50个文档的文档集上进行实验)。然而,KnowSim可以在几乎线性的时间内计算出来。最近,Kim等人(Kim,Rousseau和Vazirgiannis 2015)介绍了基于单词嵌入由给定单词向量空间的单词距离生成的句子核。然而,我们提出的基于知识模型的内核是建立在由知识库中的显式世界知识所构建的核上的。整合单词嵌入结果和显性世界知识信息也很有意思(宋和Roth 2015)。这样,当面对某些特定领域的知识稀缺时,知识模型可以更加健壮。

结论

本文研究了将文本分类转化为结构化异构信息网络分类的问题。我们首先提出了一个基于HIN-link的文本分类框架,并表明它相当于在HIN中引入了一个结合实体和关系的线性核。我们进一步开发了一个SVM分类器,它使用基于知识驱动的文本相似性度量的不定核矩阵,可以自然地对文本中的结构信息进行编码。在各种基准数据集上显示了改进的分类结果。