Image-embodied Knowledge Representation Learning

摘要

实体图像可以为知识表示学习提供重要的视觉信息。大多数传统方法仅仅从结构化的三元组中学习知识表示,忽略了从实体图像中提取的丰富的视觉信息。在本文中,我们提出了一种新的基于图像的知识表示学习模型(IKRL),该模型同时使用三重事实和图像学习知识表示。更具体地说,我们首先用神经图像编码器为实体的所有图像构造表示。然后通过基于注意的方法将这些图像表示集成到聚合的基于图像的表示中。我们在知识图补全和三重分类方面评价了我们的IKRL模型。实验结果表明,我们的模型在这两个任务上的表现都优于所有基线,这表明了视觉信息对知识表示的重要性,以及我们的模型在学习用图像表示知识的能力。https://github.com/thunlp/IKRL

1.介绍

知识图(KGs)为实体和关系提供了大量的结构化信息,已成功应用于知识推理[Yang等,2014]和问题回答[Yin等,2016]等各个领域。典型的KG(如Freebase或DBpedia)通常用大量的三重事实对多关系信息建模,表示为(头实体、关系、尾实体),也被简化为(h, r, t)。

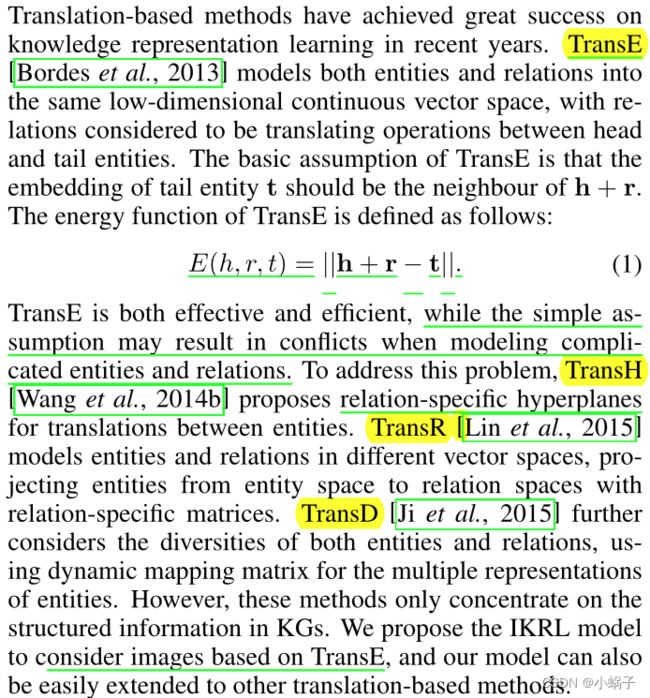

近年来,基于翻译的知识图建模方法被提出。这些方法将实体和关系投射到一个连续的低维语义空间中,关系被认为是头部和尾部实体之间的翻译操作[Bordes等人,2013]。基于翻译的方法可以兼顾知识表示学习的有效性和效率,因此近年来受到了广泛关注。然而,大多数传统的KRL方法只关注于三重事实中的结构化信息,而忽略了实体图像中丰富的外部信息。

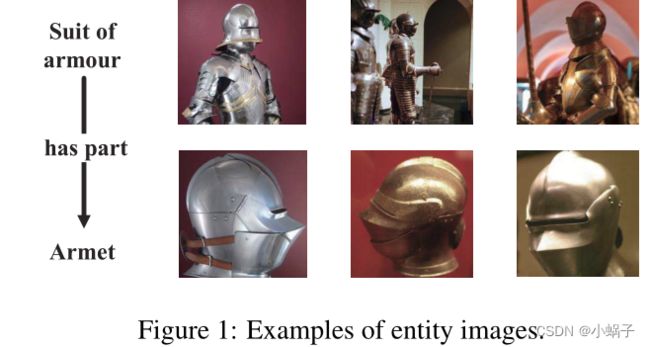

图1展示了实体图像的一些例子。每个实体都有多个图像,这些图像可以提供重要的视觉信息,直观地描述该实体的外观和行为。为了充分利用图像中丰富的信息,提出了图像嵌入知识表示学习模型(IKRL)。更具体地说,我们首先提出了一种由神经表示模块和投影模块组成的图像编码器,用于为每个图像实例生成基于图像的表示。其次,采用基于注意的方法,综合考虑各个实体的所有图像实例,为其构建基于图像的聚合表示。最后,我们共同学习了基于翻译方法的知识表示。

我们对知识图补全和三重分类的IKRL模型进行了评价。实验结果表明,我们的模型在两个任务上都达到了最先进的性能,证实了视觉信息在知识表示学习中的重要性。这也表明我们的IKRL模型能够很好地将图像信息编码为知识表示。我们展示了这项工作的主要贡献如下:

- 我们提出了一种新的考虑实体图像中视觉信息的知识表示学习IKRL模型。据我们所知,这是第一次尝试将图像和知识图结合起来进行知识表示学习。

- 我们在一个真实的数据集上评估了我们的模型,在知识图补全和三重分类方面都获得了有前景的表现。

- 我们进一步对有代表性的案例进行了详细的分析,证实了注意力在信息图像选择中的作用。我们还在图像表示之间发现了一些有趣的语义规律。

2.相关工作

2.1基于翻译的方法

2.2多源信息的学习

多源信息(如文本信息和可视化信息)对知识表示具有重要意义。为了利用丰富的文本信息,[Wang等人,2014a]将实体和单词投射到具有对齐模型的联合向量空间中。[Xie等人,2016]直接从实体描述构建实体表示,这能够对新的实体建模。在视觉信息方面,基于文字和图像的多模态表示广泛应用于图像句子排序[Kiros等,2014]、隐喻识别[Shutova等,2016]和视觉问题回答[Antol等,2015]等各种任务。然而,图像信息还没有用于知识表示。据我们所知,IKRL是第一个将图像中的视觉信息显式编码为知识表示的尝试。

Wang等人,2014a Knowledge graph and text jointly embedding

3.方法

3.1总的架构

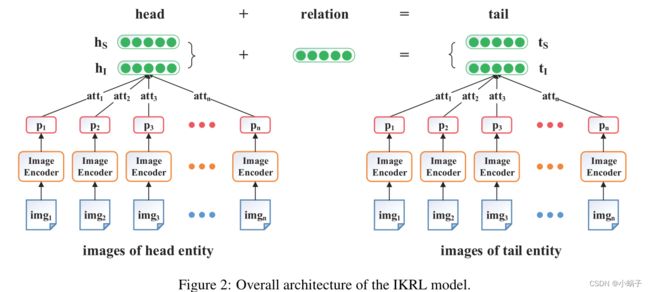

根据能量函数,IKRL模型的整体架构如图2所示。每个实体都有多个实体图像,提供重要的视觉信息。首先,设计了一个以实体图像为输入的神经图像编码器。图像编码器旨在从图像中提取信息特征,并在实体空间中构建图像表示。其次,为了组合多个图像表示,我们实现了一个实例级的基于注意的学习方法,自动计算我们应该对每个实体的不同图像实例的注意。最后,在整体能量函数下,将基于图像的聚合表示与基于结构的聚合表示联合学习。

根据能量函数,IKRL模型的整体架构如图2所示。每个实体都有多个实体图像,提供重要的视觉信息。首先,设计了一个以实体图像为输入的神经图像编码器。图像编码器旨在从图像中提取信息特征,并在实体空间中构建图像表示。其次,为了组合多个图像表示,我们实现了一个实例级的基于注意的学习方法,自动计算我们应该对每个实体的不同图像实例的注意。最后,在整体能量函数下,将基于图像的聚合表示与基于结构的聚合表示联合学习。

3.2图像编码

图像提供了信息丰富的视觉信息,可以直观地描述实体的外观和行为,被认为是IKRL模型的基本输入数据。

为了有效地将图像信息编码为知识表示,提出了一种由图像表示模块和图像投影模块组成的图像编码器。图像表示模块利用神经网络提取图像中的判别特征,并为每幅图像构建图像特征表示。接下来,图像投影模块尝试将这些图像特征表示从图像空间投影到实体空间。图3展示了图像编码器的总体管道。

图像表示模块

图像表示模块的目的是构建图像特征表示。我们利用一种广泛使用的神经网络AlexNet,它包含五个卷积层,两个完全连接层和一个softmax层,来提取图像特征[Krizhevsky et al., 2012]。在预处理过程中,将所有图像从中心、角及其水平反射处重塑为224 × 224。受[Shutova et al., 2016]的启发,我们将4096维嵌入作为图像特征表示,这些嵌入是第二层全连接层(也称为fc7)的输出。

图像投影模块

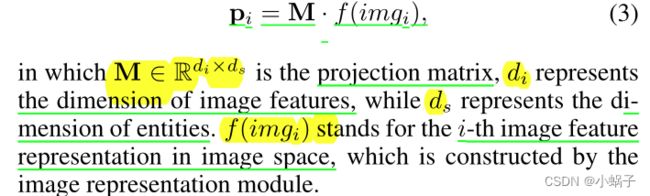

在得到每个图像的压缩特征表示后,下一步是通过图像投影模块建立图像与实体之间的桥梁。具体地说,我们利用共享投影矩阵将图像特征表示形式从图像空间转移到实体空间。第i幅图像在实体空间中的基于图像的表示pi定义为

3.3基于注意的多实例学习

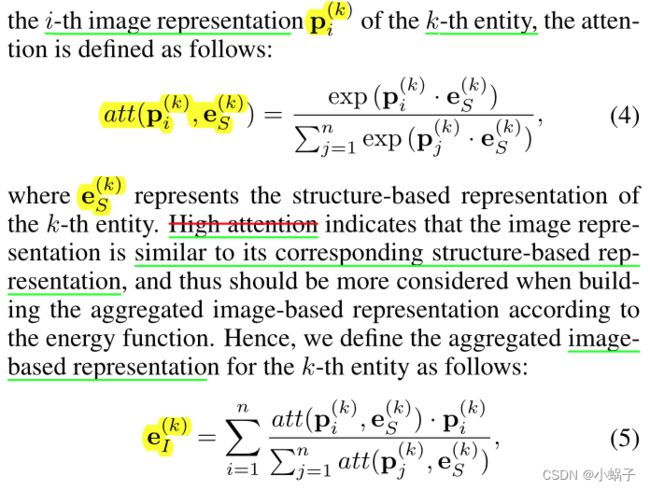

图像编码器将图像作为输入,然后为每一个图像构造基于图像的表示。然而,大多数实体在不同的场景中有多个来自不同方面的图像。确定哪些图像更好地表示其对应的实体是必要的,但也是具有挑战性的。简单地将所有的图像表示进行汇总可能会产生噪声,丢失详细的信息。为了从多个实例中为每个实体构建基于图像的聚合表示,我们提出了一种基于注意的多实例学习方法。

基于注意的方法可以从多个候选实例中自动选择信息实例。它被广泛应用于图像分类[Mnih等,2014]、机器翻译[Bahdanau等,2015]和抽象句子摘要[Rush等,2015]等各个领域。我们联合考虑每个图像表示及其对应实体的基于结构的表示,以生成实例级注意。

除了基于注意的方法,我们还实现了两种可供选择的组合方法进行进一步的比较。VG是一种简单的组合方法,它取所有图像嵌入的平均值,假设每个图像对最终基于图像的表示有相同的贡献。MAX是注意力的简化版本,它只考虑注意力最高的图像表示。

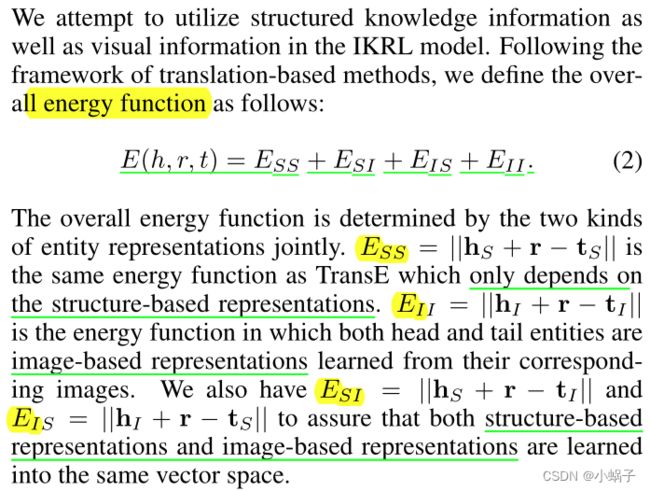

3.4目标形式化

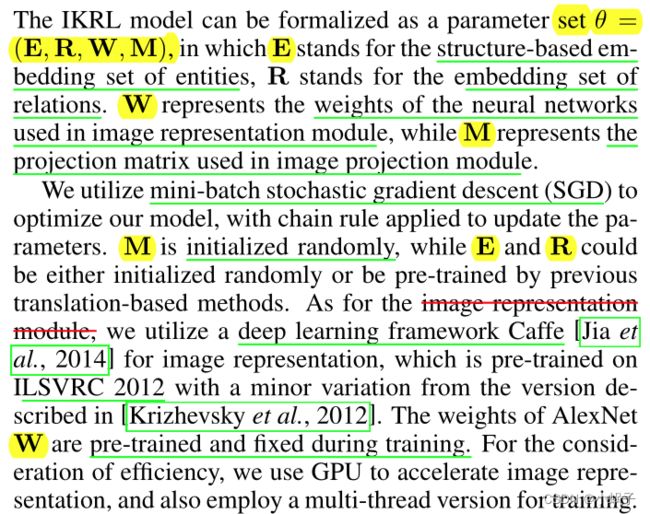

3.5优化与实现细节

4.实验

4.1数据集

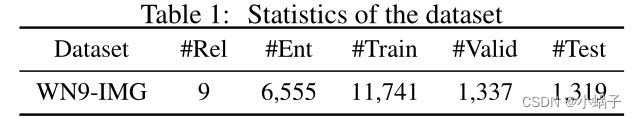

在本文中,我们结合WN9-IMG图像构造了一个新的知识图数据集,用于完成知识图补全和三重分类等评价任务。WN9-IMG的三重部分是经典KG数据集WN18 [Bordes et al., 2014]的子集,该数据集最初提取自WordNet [Miller, 1995]。考虑到图像质量,我们使用了从ImageNet中提取的63,225张图像[Deng等人,2009],ImageNet是一个按照WordNet层次结构组织的巨大图像数据库。我们保证WN9-IMG中的所有实体都有图像,并将提取的三元组随机分成训练集、验证集和测试集。WN9-IMG的统计数据如表1所示。

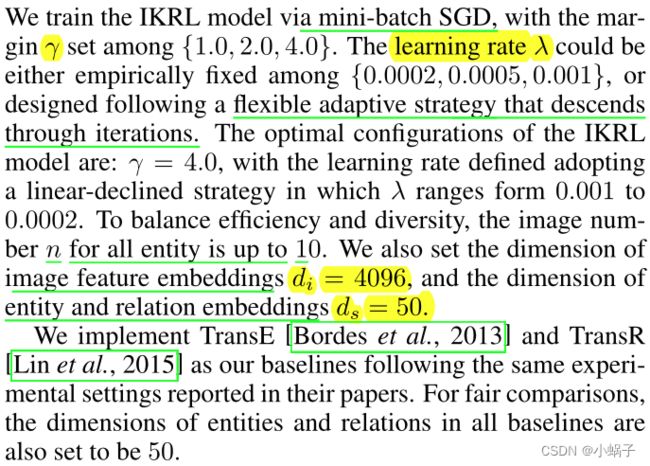

4.2实验设置

4.3知识图补全

评估协议

知识图谱补全任务的目标是在缺一个h, r, t时补全一个三重(h, r, t)。我们主要关注评估中的实体预测。该任务已被广泛用于评估知识表示的质量[Bordes等人,2012;Bordes等人,2013]。预测通过不相似函数||h + r−t||来确定。由于IKRL模型有两种表示形式,我们将根据我们的模型报告三种预测结果:在预测缺失的实体时,IKRL (SBR)只使用基于结构的表示形式对所有实体进行预测,而IKRL (IBR)只使用基于图像的表示形式进行预测。IKRL (UNION)是一种简单的联合方法,考虑了两种实体表示的加权拼接。

按照[Bordes et al., 2013]中的相同设置,我们考虑两个度量作为实体预测的评估指标:(1)正确实体的平均排名(mean rank);(2)正确实体结果排名前10的比例(Hits@10)。我们还遵循[Bordes等人,2013]中使用的两个名为“Raw”和“Filter”的评估设置。在本节中,我们首先演示实体预测的结果,然后实施另一个实验,进一步讨论注意的力量。

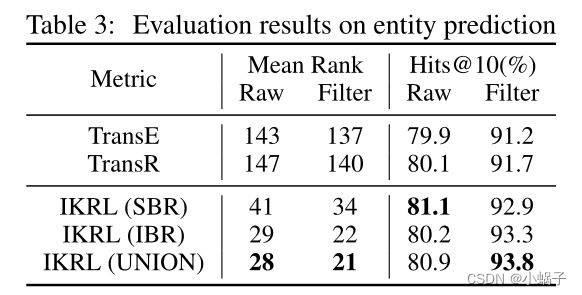

实体预测

实体预测结果如表3所示。从结果可以看出:(1)所有IKRL模型在Mean Rank和Hits@10两个评价指标上都优于所有基线,其中IKRL (UNION)模型表现最好。这表明图像的视觉信息已成功编码为实体表示,这对构建知识表示具有重要意义。(2)与基线相比,IKRL (SBR)和IKRL (IBR)都有更好的性能,这表明视觉信息不仅可以指导基于图像的表示的构建,而且可以提高基于结构的表示的性能。(3) IKRL模型在平均Rank上显著且持续优于基线。这是因为Mean Rank依赖于知识表示的整体质量,因此对错误预测结果很敏感。以往的基于翻译的方法,如TransE,只考虑三元组的结构化信息,如果相应的信息缺失,可能无法预测两者之间的关系。然而,在IKRL中使用的图像信息可以提供补充信息。因此,IKRL的结果比平均Rank基线要好得多。

关于注意的进一步讨论

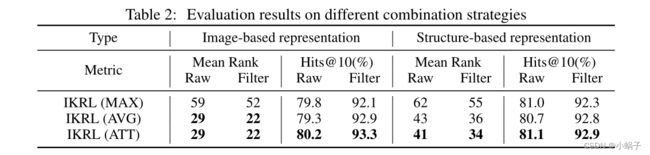

为了进一步展示基于注意力的方法的威力,我们实现了三种组合策略来联合考虑多个图像实例。IKRL (ATT)表示在构建聚合的基于图像的表示时具有注意的基本模型,IKRL (MAX)表示只考虑具有最大注意的图像实例的组合策略,IKRL (AVG)表示将所有图像实例的平均嵌入来表示一个实体的策略。基于图像表示和基于结构表示的实体预测评价结果如表2所示。

从表2中我们观察到:(1)无论组合策略是什么,所有IKRL模型在Mean Rank和Hits@10上的表现仍然优于基线。(2)在三种组合策略中,IKRL (ATT)模型的性能最好,这意味着基于注意的方法能够自动选择信息量更大的图像实例来表示实体。(3) IKRL (AVG)模型优于IKRL (MAX)模型,这说明只考虑注意力最大的图像会丢失位于其他实例中的重要信息。(4)与IKRL (AVG)模型相比,IKRL (ATT)模型似乎只有微小的优势。原因是我们从ImageNet中提取的图像质量非常高,这可能会缩小基于注意力的方法和基于平均的方法之间的差距。为了进一步分析,我们将在案例研究中给出一些有注意的例子,可以成功地从所有候选图像中区分出相对较好的和较差的图像。

4.4三元组分类

评估协议

三重分类的目的是根据不相似函数预测一个三重事实(h, r, t)是否正确[Socher et al., 2013]。它可以被看作是三元组上的二元分类任务。由于WN9-IMG没有显式的负实例,我们按照[Socher等人,2013]中使用的相同协议,通过随机地用另一个实体替换头部或尾部实体来生成负实例。我们还确保正三元组的数量等于负三元组的数量。

在分类中,我们为每个关系设置不同的关系特定阈值δr,通过最大化验证集上对应关系的分类精度来进行优化。对于要分类的三重函数,如果其不相似函数||h + r−t||大于δr,则预测其为负,否则为正。为了更好地展示IKRL模型的优点,在计算每个三元组的不相似函数时,只使用基于图像的表示。

实验结果

从表4中我们可以观察到:(1)所有的IKRL模型都优于两个基线,这证明了我们的模型将结构化的三元组信息与图像中的可视信息相结合的有效性和鲁棒性。请注意,IKRL是基于TransE框架的,但即使与增强的TransR模型相比,它的性能仍然更好,这证实了图像引入的改进。(2)与其他组合策略相比,IKRL (ATT)模型的性能最好。这说明基于注意的方法可以综合考虑多个实例,并从所有候选图像中聪明地选择出信息量更大的图像。

4.5案例研究

在本节中,我们给出两个案例进行详细分析。一是介绍图像的语义规律,二是展示注意能力。为了更好的演示,在包含主要对象的情况下,可以对案例研究中显示的图像进行切割。

图像的语义规律

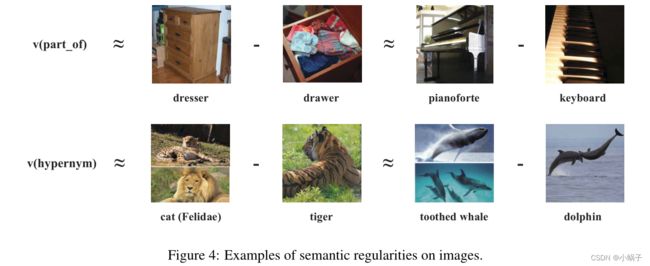

[Mikolov et al., 2013]表明单词表示具有一些有趣的语义规律,如v(king)−v(man)≈v(queen)−v(woman),其中v(x)表示x的单词嵌入。在图像-文本空间中也发现了类似的规律[Kiros et al., 2014]。在图像知识联合空间中,我们探索了如图4所示的基于图像的表示的语义翻译规律。与以往研究不同的是,梳妆台减去抽屉的结果匹配了一个具体的、有意义的关系部分,使得图像-知识空间中的语义翻译规律更具可解释性。

注意力能力

图5展示了一些具有不同注意的图像实例对,旨在证实注意能力从多个实例中选择信息量更大的图像。在便携式电脑的第一个例子中,基于注意力的方法通过分配低注意力成功地检测到低质量的实例,实际上是一个电话。对于高尔夫比赛,关注度较低的图像只是草坪的概览,没有任何人物,也没有详细的体育用品,因此在组合上较少考虑。至于水壶,低注意的图像集中在水壶的壶嘴上,这将会让人感到困惑,不能代表整个实体。在注意力的帮助下,我们可以从更好的图像中自动学习知识表示,减轻多个图像实例中的噪声。

5.总结和未来工作

在本文中,我们提出了用图像学习知识表示的IKRL模型。我们利用神经网络和投影模块对每个图像进行建模,然后将基于注意力的多个图像实例结合起来,构建聚合的基于图像的表示。实验结果表明,该模型能够将图像信息编码为知识表示。

未来我们将探索以下研究方向:(1)图像表示的质量至关重要。我们将利用更复杂的模型在某些特定领域提取更好的图像特征。(2)目前的IKRL模型是基于TransE的。当扩展到其他基于翻译的增强方法时,我们将探索我们的模型的有效性。(3)在本文中,我们只将每个实体图像看作是其目标实体的视觉表示,而有时一个图像包含的实体远远不止一个简单的实体。我们将结合我们的IKRL模型,探索学习一个图像中的多个实体及其关系。