ALIGN:基于噪声文本监督的视觉和视觉语言表示学习

1.Title:Scaling Up Visual and Vision-Language Representation Learning With Noisy Text Supervision

2.Author:Jia Chao et al.

3.Abstract

预训练的表示在许多NLP和感知任务上变得越来越重要。虽然NLP中的表示学习已经过渡到在没有人工注释的原始文本上进行训练,但视觉和视觉语言表示仍然严重依赖精心设计的训练数据集,这些数据集的获取往往成本高昂。人们通常使用带有显式类别标签的数据集(如ImageNet或OpenImages)进行视觉表示学习。对于视觉语言表示学习,像Conceptual Captions、MSCOCO或CLIP这样的流行数据集都涉及到数据收集和清理的过程。这种昂贵的管理过程限制了数据集的大小,因此阻碍了训练模型的扩展。我们使用了一个超过10亿图像文本对的噪声数据集,该数据集不需要在Conceptual Captions数据集中进行昂贵的过滤或后处理即可获得。我们使用对比损失训练了一个简单的双编码器模型,以学习对齐图像文本对的视觉语言表示。我们表明,即使使用如此简单的学习方案,我们的语料库的规模也可以弥补其噪声,并达到最先进的表示。我们的视觉表示在迁移到ImageNet和VTAB等分类任务时实现了强大的性能。即使与更复杂的交叉注意力模型相比,我们的视觉语言表示也在Flickr30K和MSCOCO基准测试中取得了最先进的结果。这些表示还支持复杂文本和图像+文本跨模态检索。

4.Introduction

我们的模型名为ALIGN(A Large-scale ImaGe and Noisy-text embedding):意为大规模图像和噪声文本嵌入。

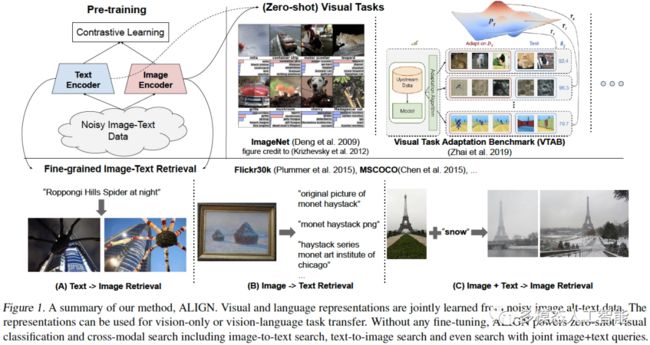

图1. ALIGN方法总结。视觉和语言表示是从含有噪声的图像文本数据中联合学习的。这些表示可以迁移到视觉或视觉语言任务上。在没有任何微调的情况下,ALIGN支持Zero-Shot视觉分类和跨模态搜索,包括以图搜文,以文搜图,甚至联合使用图像+文本进行搜索。

5.Related Work

与我们的工作密切相关的是CLIP,它提出了在类似的对比学习环境中通过自然语言监督进行视觉表示学习。除了使用不同的视觉和语言编码器架构外,关键区别在于训练数据:ALIGN遵循原始数据中图像文本对的自然分布,而CLIP通过从英文维基百科中构建高频视觉概念的允许列表来收集数据集。我们表明,强大的视觉和视觉语言表示可以通过不需要专家知识的数据集来学习。

6.Dataset:

我们使用了一个规模庞大、噪声也大的数据集,该数据集包含18亿图像文本对。

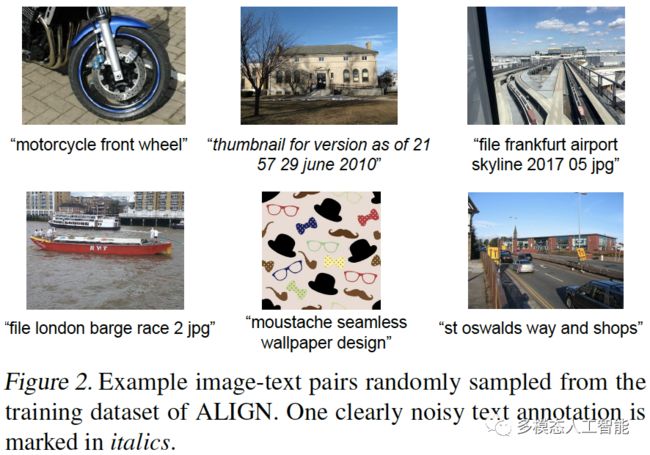

图2. 从ALIGN的训练数据集中随机采样的图像文本对示例。其中一个明显的噪声文本注释以斜体标记。

7.Experiments and Results

我们从头开始训练ALIGN模型,用EfficientNet作为图像编码器,用BERT作为文本编码器。

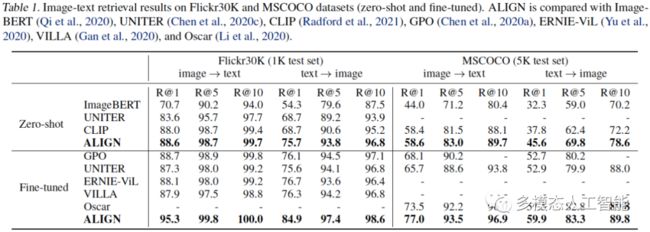

表1. 基于Flickr30K和MSCOCO数据集的图像文本检索结果。ALIGN与Image-BERT、UNITER、CLIP、GPO、ERNIE-ViL、VILLA和Oscar进行比较。

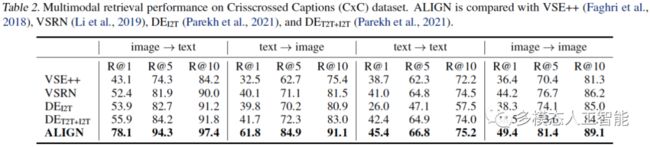

表2. 基于Crisscrossed Captions数据集的多模态检索性能。ALIGN与VSE++、VSRN、DEI2T和DET2T+I2T进行比较。

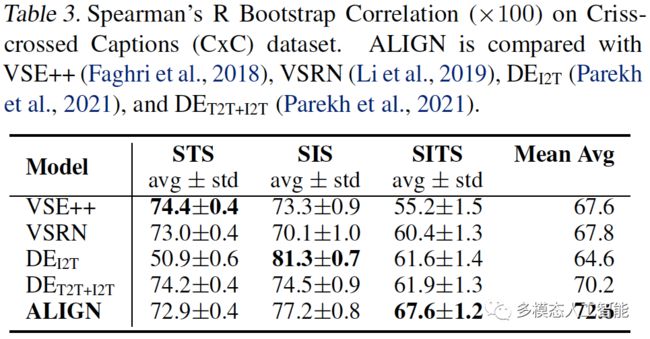

表3. 基于Crisscrossed Captions数据集的Spearman’s R自举相关性。ALIGN与VSE++、VSRN、DEI2T和DET2T+I2T进行比较。

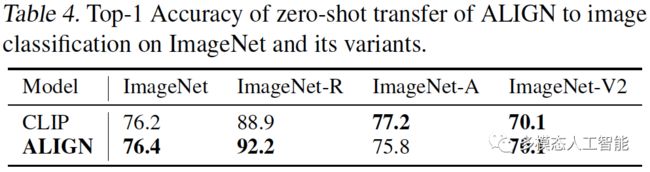

表4. 将ALIGN模型Zero-Shot迁移到ImageNet及其变体数据集的图像分类任务的Top-1准确率。

表5. ImageNet分类结果。ALIGN与WSL、CLIP、BiT、ViT、NoisyStudent、Meta-Pseudo-Labels进行比较。

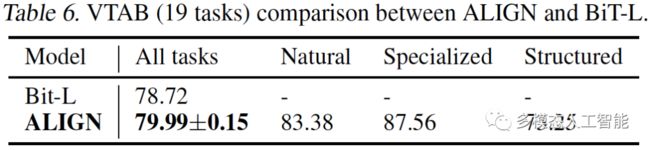

表6. ALIGN和BiT-L之间的VTAB比较。

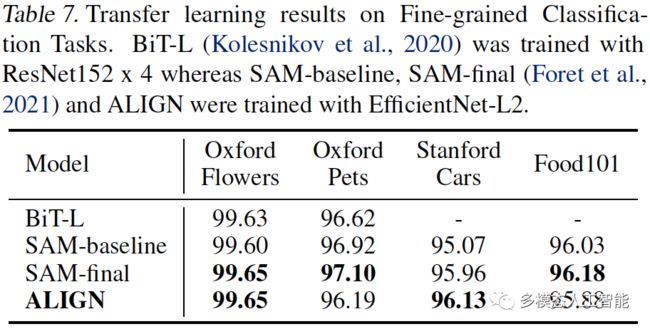

表7. 细粒度分类任务的迁移学习结果。BiT-L使用ResNet152x4进行训练,而SAM-baseline、SAM-final和ALIGN使用EfficientNet-L2进行训练。

表8. 关键架构参数的消融研究。

表9. 不同训练数据集的消融研究。

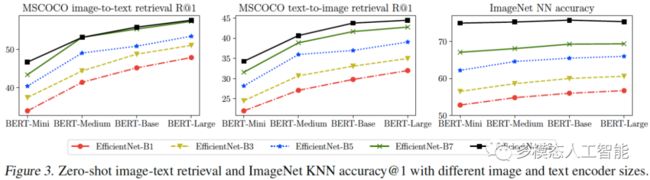

图3. 不同大小的图像和文本编码器在Zero-Shot图文检索和ImageNet KNN任务上的准确率。

表10. 训练数据大小和质量之间的权衡。

图4. 使用基于ALIGN嵌入的细粒度文本查询进行图像检索。

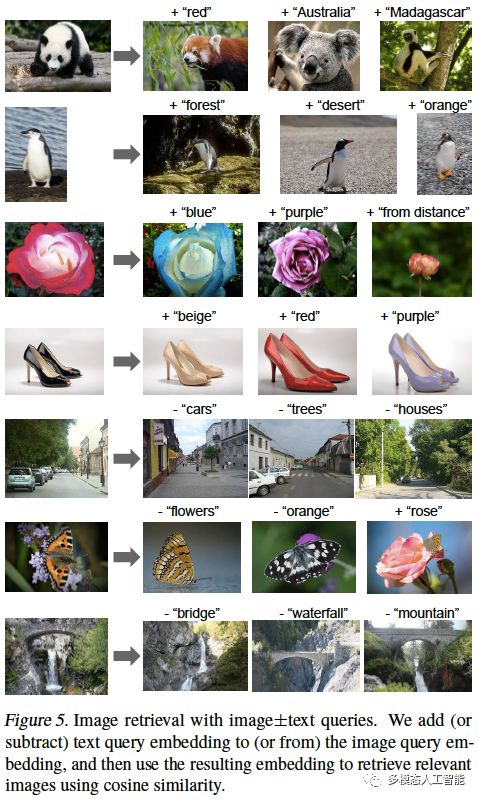

图5. 使用图像文本查询进行图像检索。我们在图像查询嵌入中添加(或减去)文本查询嵌入,然后基于生成的嵌入结果,使用余弦相似度检索相关图像。

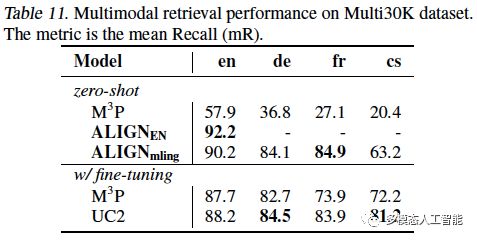

表11. Multi30K数据集上的多模态检索性能。

8.Conclusion

我们提出了一种利用大规模噪声图像文本数据来扩展视觉和视觉语言表示学习的简单方法。我们的方法避免了繁重的数据管理和注释工作,并且只需要最小的基于频率的清理即可。在这个数据集上,我们使用对比损失训练了一个简单的双编码器模型,得到的模型名为ALIGN,它能够进行跨模态检索,性能显著优于SOTA VSE和交叉注意力视觉语言模型。在面向视觉的下游任务中,ALIGN可以与使用大规模标记数据训练的SOTA模型相媲美,甚至优于后者。