简易的站内搜索引擎 (万字长文!!绝对值得一看!!)

搜索引擎的实现

- 项目简介

-

- 项目背景

- 项目开始前

-

- 开始前的准备

- 四个模块

-

- 预处理模块

- 索引模块

- 搜索模块

- 服务器模块

项目简介

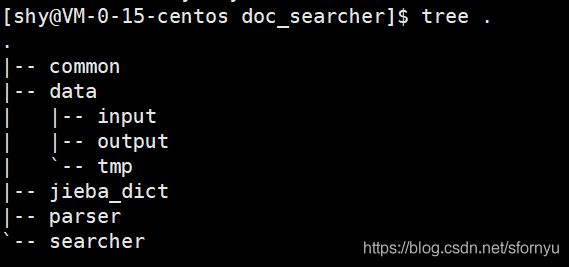

这里所实现的并非如同百度、谷歌一样的全网搜索,我们的硬件条件达不到,并且技术实力也不够,但是我们可以按照搜索引擎的基本原理,来实现一个站内搜索,实现原理也算是大同小异,此项目分为四个模块:预处理模块、索引模块、搜索模块、服务器模块

项目背景

想要写一个搜索引擎也是源于偶然,在知乎上看到一篇文章,说是百度搜索为什么可以那么快?回答里说了很多方面的技术,其中最核心的就是倒排索引,这让我产生了浓厚的兴趣,但是因为实力和设备都有欠缺,没法做一个像是百度和搜狗一样的全网搜索,但我可以做一个站内搜索,来理解相应的技术。

项目开始前

虽然我们要实现的是站内搜索,但是与全网搜索大同小异,那么我们可以看一看搜索应该要包含什么

我们可以看到当我们在上面的文本框输入关键字之后点击搜索,在下面会显示出许多具有相关性的搜索结果,而这些搜索结果中至少需要包含以下四个部分:

标题

描述(网页正文摘要出一部分)

展示url

点击url,点击标题会跳转到另外一个url中

因此我们可以仿照百度的方式,来实现我们的搜索引擎

开始前的准备

httplib

g++版本必须得是4.9以上

jieba分词的库

用这个库的时候直接用include是不够的,需要将deps目录下的limonp也拷贝到include目录下

boost: yum install boost-devel.x86_64

jsoncpp: yum install jsoncpp-devel.x86_64

四个模块

预处理模块

这里就要提一下我为什么会选择boost网站来实现站内搜索了,

- 我们暂时无法实现一个全网搜索,只能完成站内搜索

- boost官方文档没有一个搜索功能,但是boost文档很常用,没有搜索功能比较麻烦

- boost文档提供了两个版本,

离线版本,在线版本

boost提供了离线版本,那么我们就可以基于离线版本,分析文档页面的内容,为搜索功能提供支持。点击搜索结果的标题的时候,就能够跳转到在线版本的文档上,而如果网站内容无法直接下载,就必须使用爬虫来抓取页面到本地。

boost 在线文档.

我为什么选择1.53版本的boost呢?其实主要是因为我用的Linux版本是contos7,它默认就是1.53

那么我们现在得到了boost文档的离线版本之后需要干什么呢?

我们下载下来的boost文档,其实就是一个个的html,而这些html里面是有很多内容和标签混合在一起的,而我们需要的只是其中的标题,正文,url,而我们预处理阶段所要做的就是读取原始的html文档内容,提取我们所要的,整理成一个行文本,以供下面的模块使用

接下来我们就开始写预处理模块的代码了

首先我们需要定义两个变量来表示从哪里读数据和要把最后生成的行文本放到哪个路径下面展示一些 内联代码片。

这个变量表示从哪个目录中读取boost文档的html

string g_input_path ="../data/input";

这个变量表示预处理模块输出结果放到哪里

string g_output_path ="../data/tmp/raw_input";

我们还需要一个结构体,来表示一个个的html

struct DocInfo{

string title;//文档的标题

string url;//文档的url

string content;//文档的正文

};

既然我们要将所有的html都解析成行文件,那么我们首要做的就是将所下载的所有html都枚举加载进来,那么我们就可以封装一个函数

bool EnumFile(const string &input_path, vector<string> *file_list)

其中input_path为输入参数,file_list是输出参数,将上面定义的输入变量传进来,然后将所有的html都枚举到输出参数file_list中。我们的枚举过程中是会遇到目录的,而我们只要枚举html,C++的标准库中没有能做到这个的,但是boost库中可以。

//把boost::filesystem这个命名空间定义一个别名

39 namespace fs = boost::filesystem;

40 fs::path root_path(input_path);

41 if(!fs::exists(root_path)){

42 std::cout << "当前的目录不存在" << std::endl;

43 }

44

45 //递归目录迭代器,迭代器使用循环实现的时候可以自动完成递归

46

47 fs::recursive_directory_iterator end_iter;

48 for(fs::recursive_directory_iterator begin_iter(root_path); begin_iter != end_iter; ++begin_iter){

49 //需要判定当前的路径对应的是不是一个普通文件

50 //如果是目录直接跳过

51 if(!fs::is_regular_file(*begin_iter))

52 {

53 continue;

54 }

55 //当前路径对应的文件是不是一个html文件,如果不是也跳过

56 if(begin_iter->path().extension() != ".html"){

57 continue;

58 }

59

60 //把得到的html加入到最终结果的vector中

61 file_list->push_back(begin_iter->path().string());

接下来就是遍历vector里面的html了,打开每一个html,然后解析其中的内容,解析出标题、正文、url,对应我们之前创建好的结构体

找到标题

70 //找到html中的title标签

71 bool ParseTitle(const string& html, string *title){

72 size_t beg = html.find(""</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">73</span> <span class="token keyword">if</span><span class="token punctuation">(</span>beg <span class="token operator">==</span> string<span class="token operator">::</span>npos<span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">74</span> std<span class="token operator">::</span>cout <span class="token operator"><<</span> <span class="token string">"标题未找到"</span> <span class="token operator"><<</span> std<span class="token operator">::</span>endl<span class="token punctuation">;</span>

<span class="token number">75</span> <span class="token keyword">return</span> <span class="token boolean">false</span><span class="token punctuation">;</span>

<span class="token number">76</span> <span class="token punctuation">}</span>

<span class="token number">77</span> size_t end <span class="token operator">=</span> html<span class="token punctuation">.</span><span class="token function">find</span><span class="token punctuation">(</span><span class="token string">" ");

78 if(end == string::npos){

79 std::cout <<"标签未找到" <<std::endl;

80 return false;

81 }

82 beg += string(""</span><span class="token punctuation">)</span><span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">83</span> <span class="token keyword">if</span><span class="token punctuation">(</span>beg <span class="token operator">>=</span> end<span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">84</span> std<span class="token operator">::</span>cout <span class="token operator"><<</span><span class="token string">"标题位置不合法"</span> <span class="token operator"><<</span>std<span class="token operator">::</span>endl<span class="token punctuation">;</span>

<span class="token number">85</span> <span class="token keyword">return</span> <span class="token boolean">false</span><span class="token punctuation">;</span>

<span class="token number">86</span> <span class="token punctuation">}</span>

<span class="token number">87</span> <span class="token operator">*</span>title <span class="token operator">=</span> html<span class="token punctuation">.</span><span class="token function">substr</span><span class="token punctuation">(</span>beg<span class="token punctuation">,</span> end<span class="token operator">-</span>beg<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">88</span> <span class="token keyword">return</span> <span class="token boolean">true</span><span class="token punctuation">;</span>

<span class="token number">89</span>

<span class="token number">90</span> <span class="token punctuation">}</span>

</code></pre>

<p><em><strong>获取url</strong></em></p>

<pre><code class="prism language-cpp"> <span class="token number">70</span> <span class="token comment">//找到html中的title标签</span>

<span class="token number">71</span> <span class="token keyword">bool</span> <span class="token function">ParseTitle</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> html<span class="token punctuation">,</span> string <span class="token operator">*</span>title<span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">72</span> size_t beg <span class="token operator">=</span> html<span class="token punctuation">.</span><span class="token function">find</span><span class="token punctuation">(</span><span class="token string">"<title>"</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">73</span> <span class="token keyword">if</span><span class="token punctuation">(</span>beg <span class="token operator">==</span> string<span class="token operator">::</span>npos<span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">74</span> std<span class="token operator">::</span>cout <span class="token operator"><<</span> <span class="token string">"标题未找到"</span> <span class="token operator"><<</span> std<span class="token operator">::</span>endl<span class="token punctuation">;</span>

<span class="token number">75</span> <span class="token keyword">return</span> <span class="token boolean">false</span><span class="token punctuation">;</span>

<span class="token number">76</span> <span class="token punctuation">}</span>

<span class="token number">77</span> size_t end <span class="token operator">=</span> html<span class="token punctuation">.</span><span class="token function">find</span><span class="token punctuation">(</span><span class="token string">" ");

78 if(end == string::npos){

79 std::cout <<"标签未找到" <<std::endl;

80 return false;

81 }

82 beg += string(""</span><span class="token punctuation">)</span><span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">83</span> <span class="token keyword">if</span><span class="token punctuation">(</span>beg <span class="token operator">>=</span> end<span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">84</span> std<span class="token operator">::</span>cout <span class="token operator"><<</span><span class="token string">"标题位置不合法"</span> <span class="token operator"><<</span>std<span class="token operator">::</span>endl<span class="token punctuation">;</span>

<span class="token number">85</span> <span class="token keyword">return</span> <span class="token boolean">false</span><span class="token punctuation">;</span>

<span class="token number">86</span> <span class="token punctuation">}</span>

<span class="token number">87</span> <span class="token operator">*</span>title <span class="token operator">=</span> html<span class="token punctuation">.</span><span class="token function">substr</span><span class="token punctuation">(</span>beg<span class="token punctuation">,</span> end<span class="token operator">-</span>beg<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">88</span> <span class="token keyword">return</span> <span class="token boolean">true</span><span class="token punctuation">;</span>

<span class="token number">89</span>

<span class="token number">90</span> <span class="token punctuation">}</span>

</code></pre>

<p><em><strong>找到正文</strong></em></p>

<pre><code class="prism language-cpp"><span class="token number">101</span> <span class="token comment">//获取正文</span>

<span class="token number">102</span> <span class="token keyword">bool</span> <span class="token function">ParseContent</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> html<span class="token punctuation">,</span> string<span class="token operator">*</span> content<span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">103</span> <span class="token comment">//这里引入一个bool变量,当进入标签之后,此值为false</span>

<span class="token number">104</span> <span class="token comment">//判断这个变量就能知道是在标签内还是在标签外了</span>

<span class="token number">105</span> <span class="token keyword">bool</span> is_content <span class="token operator">=</span> <span class="token boolean">true</span><span class="token punctuation">;</span>

<span class="token number">106</span> <span class="token keyword">for</span><span class="token punctuation">(</span><span class="token keyword">auto</span> c <span class="token operator">:</span> html<span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">107</span> <span class="token keyword">if</span><span class="token punctuation">(</span>is_content<span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">108</span> <span class="token comment">//当前是正文</span>

<span class="token number">109</span> <span class="token keyword">if</span><span class="token punctuation">(</span>c <span class="token operator">==</span> <span class="token string">'<'</span><span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">110</span> is_content <span class="token operator">=</span> <span class="token boolean">false</span><span class="token punctuation">;</span>

<span class="token number">111</span> <span class="token punctuation">}</span>

<span class="token number">112</span> <span class="token keyword">else</span><span class="token punctuation">{</span>

<span class="token number">113</span> <span class="token comment">//当前是普通字符,就把结果写入到content中</span>

<span class="token number">114</span> <span class="token keyword">if</span><span class="token punctuation">(</span>c <span class="token operator">==</span> <span class="token string">'\n'</span><span class="token punctuation">)</span><span class="token punctuation">{</span>

<span class="token number">115</span> c <span class="token operator">=</span> <span class="token string">' '</span><span class="token punctuation">;</span>

<span class="token number">116</span> <span class="token punctuation">}</span>

<span class="token number">117</span> content<span class="token operator">-></span><span class="token function">push_back</span><span class="token punctuation">(</span>c<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">118</span> <span class="token punctuation">}</span>

<span class="token number">119</span> <span class="token punctuation">}</span>

<span class="token number">120</span> <span class="token keyword">else</span><span class="token punctuation">{</span>

<span class="token number">121</span> <span class="token comment">//当前是在标签内</span>

<span class="token number">122</span> <span class="token keyword">if</span><span class="token punctuation">(</span>c <span class="token operator">==</span> <span class="token string">'>'</span><span class="token punctuation">)</span>

<span class="token number">123</span> <span class="token punctuation">{</span>

<span class="token number">124</span> <span class="token comment">//标签结束</span>

<span class="token number">125</span> is_content <span class="token operator">=</span> <span class="token boolean">true</span><span class="token punctuation">;</span>

<span class="token number">126</span> <span class="token punctuation">}</span>

<span class="token number">127</span> <span class="token comment">//标签里的其他内容都直接忽略掉</span>

<span class="token number">128</span> <span class="token punctuation">}</span>

<span class="token number">129</span> <span class="token punctuation">}</span>

<span class="token number">130</span> <span class="token keyword">return</span> <span class="token boolean">true</span><span class="token punctuation">;</span>

<span class="token number">131</span> <span class="token punctuation">}</span>

</code></pre>

<p>最后只需要将我们解析出来的结果写入到我们最开始设置好的输出文件中就可以了,<mark>不过要记得选择一个不可见分隔符对标题、正文、url进行分割!!不然会出现粘包问题!!</mark><br> 以上就是预处理模块的全部内容了,可以编译运行一下,看看输出文件中是否如愿解析出来了。</p>

<h3>索引模块</h3>

<p>现在我们已经有了解析好的行文本了,那么我们接下来就要进入索引模块了,<mark>索引模块是最核心的部分,在这个模块我们就要引入倒排索引了!!!</mark><br> 不管是站内搜索还是全网搜索,面对大量的数据,最核心的点就是效率,我们需要在大量的数据中,快速而准确的找出我们所要的数据,那么解决这个问题,最核心的就是倒排索引。<br> 那么什么是倒排索引呢?<br> 我们来看一个经典的例子,我所学习倒排索引的时候,就是看的这个例子<br> <a href="http://img.e-com-net.com/image/info8/fdfc1ed7fde64891be9a075762a91f59.jpg" target="_blank"><img src="http://img.e-com-net.com/image/info8/fdfc1ed7fde64891be9a075762a91f59.jpg" alt="简易的站内搜索引擎 (万字长文!!绝对值得一看!!)_第4张图片" width="342" height="211" style="border:1px solid black;"></a><br> 中文和英文等语言不同,单词之间没有明确分隔符号,所以首先要用分词系统将文档自动切分成单词序列。这样每个文档就转换为由单词序列所组成,然后对每个不同的单词赋予唯一的单词编号,同时记录下哪些文档包含这个单词,在如此处理结束后,我们可以得到最简单的倒排索引。<br> <a href="http://img.e-com-net.com/image/info8/0f7861490b1c4d8c8f7e44f215cb4f39.jpg" target="_blank"><img src="http://img.e-com-net.com/image/info8/0f7861490b1c4d8c8f7e44f215cb4f39.jpg" alt="简易的站内搜索引擎 (万字长文!!绝对值得一看!!)_第5张图片" width="369" height="347" style="border:1px solid black;"></a><br> 我们可以概括性的理解为:<code>正排索引就是利用文档id来得到文本内容,倒排索引就是根据文本内容来得到文本id</code><br> 那么我们的基本逻辑就是构建出正排索引,并且对字符串进行分词切割,然后切分出来的单词,再根据切分的单词和正排索引构建倒排索引,通过倒排索引找到对应的文档id,再通过文档id查找正排索引,从正排索引找到文档的内容。<br> 因此我们现在要做的就是:<mark>构建正排索引</mark>,<mark>构建倒排索引</mark>,<mark>进行分词</mark>,<mark>查找倒排索引</mark>,<mark>查找正排索引</mark><br> 下面我们构建一下正排索引和倒排索引的基本结构体</p>

<pre><code class="prism language-cpp"> <span class="token number">23</span> <span class="token keyword">struct</span> <span class="token class-name">DocInfo</span> <span class="token punctuation">{</span>

<span class="token number">24</span> <span class="token keyword">int64_t</span> doc_id<span class="token punctuation">;</span>

<span class="token number">25</span> string title<span class="token punctuation">;</span>

<span class="token number">26</span> string url<span class="token punctuation">;</span>

<span class="token number">27</span> string content<span class="token punctuation">;</span>

<span class="token number">28</span> <span class="token punctuation">}</span><span class="token punctuation">;</span>

<span class="token number">29</span>

<span class="token number">30</span> <span class="token comment">// 倒排索引是给定词, 映射到包含该词的文档 id 列表. (此处不光要有文档 id,</span>

<span class="token number">31</span> <span class="token comment">// 还得有权重信息, 以及该词的内容)</span>

<span class="token number">32</span> <span class="token keyword">struct</span> <span class="token class-name">Weight</span> <span class="token punctuation">{</span>

<span class="token number">33</span> <span class="token comment">// 该词在哪个文档中出现</span>

<span class="token number">34</span> <span class="token keyword">int64_t</span> doc_id<span class="token punctuation">;</span>

<span class="token number">35</span> <span class="token comment">// 对应的权重是多少</span>

<span class="token number">36</span> <span class="token keyword">int</span> weight<span class="token punctuation">;</span>

<span class="token number">37</span> <span class="token comment">// 词是什么 </span>

<span class="token number">38</span> string word<span class="token punctuation">;</span>

<span class="token number">39</span> <span class="token punctuation">}</span><span class="token punctuation">;</span>

</code></pre>

<p>这就是我们需要做的所有操作</p>

<pre><code class="prism language-cpp"> <span class="token number">37</span> <span class="token keyword">typedef</span> vector<span class="token operator"><</span>Weight<span class="token operator">></span> InvertedList<span class="token punctuation">;</span>

<span class="token number">38</span>

<span class="token number">39</span> <span class="token comment">// Index 类用于表示整个索引结构, 并且提供一些供外部调用的 API</span>

<span class="token number">40</span> <span class="token keyword">class</span> <span class="token class-name">Index</span> <span class="token punctuation">{</span>

<span class="token number">41</span> <span class="token keyword">private</span><span class="token operator">:</span>

<span class="token number">42</span> <span class="token comment">// 索引结构</span>

<span class="token number">43</span> <span class="token comment">// 正排索引, 数组下标就对应到 doc_id</span>

<span class="token number">44</span> vector<span class="token operator"><</span>DocInfo<span class="token operator">></span> forward_index<span class="token punctuation">;</span>

<span class="token number">45</span> <span class="token comment">// 倒排索引, 使用一个 hash 表来表示这个映射关系</span>

<span class="token number">46</span> unordered_map<span class="token operator"><</span>string<span class="token punctuation">,</span> InvertedList<span class="token operator">></span> inverted_index<span class="token punctuation">;</span>

<span class="token number">47</span>

<span class="token number">48</span> <span class="token keyword">public</span><span class="token operator">:</span>

<span class="token number">49</span> <span class="token function">Index</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">50</span> <span class="token comment">// 提供一些对外调用的函数</span>

<span class="token number">51</span> <span class="token comment">// 1. 查正排</span>

<span class="token number">52</span> <span class="token keyword">const</span> DocInfo<span class="token operator">*</span> <span class="token function">GetDocInfo</span><span class="token punctuation">(</span><span class="token keyword">int64_t</span> doc_id<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">53</span> <span class="token comment">// 2. 查倒排</span>

<span class="token number">54</span> <span class="token keyword">const</span> InvertedList<span class="token operator">*</span> <span class="token function">GetInvertedList</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> key<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">55</span> <span class="token comment">// 3. 构建索引</span>

<span class="token number">56</span> <span class="token keyword">bool</span> <span class="token function">Build</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> input_path<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">57</span> <span class="token comment">// 4. 分词函数</span>

<span class="token number">58</span> <span class="token keyword">void</span> <span class="token function">CutWord</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> input<span class="token punctuation">,</span> vector<span class="token operator"><</span>string<span class="token operator">></span><span class="token operator">*</span> output<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">59</span>

<span class="token number">60</span> <span class="token keyword">private</span><span class="token operator">:</span>

<span class="token number">61</span> DocInfo<span class="token operator">*</span> <span class="token function">BuildForward</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> line<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">62</span> <span class="token keyword">void</span> <span class="token function">BuildInverted</span><span class="token punctuation">(</span><span class="token keyword">const</span> DocInfo<span class="token operator">&</span> doc_info<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">63</span>

<span class="token number">64</span> cppjieba<span class="token operator">::</span>Jieba jieba<span class="token punctuation">;</span>

<span class="token number">65</span> <span class="token punctuation">}</span><span class="token punctuation">;</span>

</code></pre>

<p>接下来就具体实现一下,咱们先挑简单的查正排和查倒排来实现一下</p>

<pre><code class="prism language-cpp"> <span class="token number">28</span> <span class="token keyword">const</span> DocInfo<span class="token operator">*</span> <span class="token class-name">Index</span><span class="token operator">::</span><span class="token function">GetDocInfo</span><span class="token punctuation">(</span><span class="token keyword">int64_t</span> doc_id<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">29</span> <span class="token keyword">if</span> <span class="token punctuation">(</span>doc_id <span class="token operator"><</span> <span class="token number">0</span> <span class="token operator">||</span> doc_id <span class="token operator">>=</span> forward_index<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">30</span> <span class="token keyword">return</span> <span class="token keyword">nullptr</span><span class="token punctuation">;</span>

<span class="token number">31</span> <span class="token punctuation">}</span>

<span class="token number">32</span> <span class="token keyword">return</span> <span class="token operator">&</span>forward_index<span class="token punctuation">[</span>doc_id<span class="token punctuation">]</span><span class="token punctuation">;</span>

<span class="token number">33</span> <span class="token punctuation">}</span>

<span class="token number">34</span>

<span class="token number">35</span> <span class="token keyword">const</span> InvertedList<span class="token operator">*</span> <span class="token class-name">Index</span><span class="token operator">::</span><span class="token function">GetInvertedList</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> key<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">36</span> <span class="token keyword">auto</span> it <span class="token operator">=</span> inverted_index<span class="token punctuation">.</span><span class="token function">find</span><span class="token punctuation">(</span>key<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">37</span> <span class="token keyword">if</span> <span class="token punctuation">(</span>it <span class="token operator">==</span> inverted_index<span class="token punctuation">.</span><span class="token function">end</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">38</span> <span class="token keyword">return</span> <span class="token keyword">nullptr</span><span class="token punctuation">;</span>

<span class="token number">39</span> <span class="token punctuation">}</span>

<span class="token number">40</span> <span class="token keyword">return</span> <span class="token operator">&</span>it<span class="token operator">-></span>second<span class="token punctuation">;</span>

<span class="token number">41</span> <span class="token punctuation">}</span>

</code></pre>

<p>这俩就是查找正排和倒排,查不到就返回nullptr,查到了就返回对应的指针即可<br> 接下来要做的就是构建索引了</p>

<pre><code class="prism language-cpp"> <span class="token number">43</span> <span class="token keyword">bool</span> <span class="token class-name">Index</span><span class="token operator">::</span><span class="token function">Build</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> input_path<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">44</span> <span class="token comment">// 1. 按行读取输入文件内容(上个环节预处理模块生成的 raw_input 文件)</span>

<span class="token number">45</span> <span class="token comment">// 每一行又分成三个部分, 使用 \3 来切分, 分别是标题, url, 正文</span>

<span class="token number">46</span> std<span class="token operator">::</span>cerr <span class="token operator"><<</span> <span class="token string">"开始构建索引"</span> <span class="token operator"><<</span> std<span class="token operator">::</span>endl<span class="token punctuation">;</span>

<span class="token number">47</span> std<span class="token operator">::</span>ifstream <span class="token function">file</span><span class="token punctuation">(</span>input_path<span class="token punctuation">.</span><span class="token function">c_str</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">48</span> <span class="token keyword">if</span> <span class="token punctuation">(</span><span class="token operator">!</span>file<span class="token punctuation">.</span><span class="token function">is_open</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">49</span> std<span class="token operator">::</span>cout <span class="token operator"><<</span> <span class="token string">"raw_input 文件打开失败"</span> <span class="token operator"><<</span> std<span class="token operator">::</span>endl<span class="token punctuation">;</span>

<span class="token number">50</span> <span class="token keyword">return</span> <span class="token boolean">false</span><span class="token punctuation">;</span>

<span class="token number">51</span> <span class="token punctuation">}</span>

<span class="token number">52</span> string line<span class="token punctuation">;</span>

<span class="token number">53</span> <span class="token keyword">while</span> <span class="token punctuation">(</span>std<span class="token operator">::</span><span class="token function">getline</span><span class="token punctuation">(</span>file<span class="token punctuation">,</span> line<span class="token punctuation">)</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">54</span> <span class="token comment">// 2. 解析成 正排结构的DocInfo 对象, 并构造为正排索引</span>

<span class="token number">55</span> DocInfo<span class="token operator">*</span> doc_info <span class="token operator">=</span> <span class="token function">BuildForward</span><span class="token punctuation">(</span>line<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">56</span> <span class="token keyword">if</span> <span class="token punctuation">(</span>doc_info <span class="token operator">==</span> <span class="token keyword">nullptr</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">57</span> std<span class="token operator">::</span>cout <span class="token operator"><<</span> <span class="token string">"构建正排失败!"</span> <span class="token operator"><<</span> std<span class="token operator">::</span>endl<span class="token punctuation">;</span>

<span class="token number">58</span> <span class="token keyword">continue</span><span class="token punctuation">;</span>

<span class="token number">59</span> <span class="token punctuation">}</span>

<span class="token number">60</span> <span class="token comment">// 3.构造成倒排索引.</span>

<span class="token number">61</span> <span class="token function">BuildInverted</span><span class="token punctuation">(</span><span class="token operator">*</span>doc_info<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">62</span>

<span class="token number">63</span> <span class="token comment">//此时需要知道进度是多少,但是如果每一个都进行打印</span>

<span class="token number">64</span> <span class="token comment">//每个数据都进行I/O操作的话过于影响效率</span>

<span class="token number">65</span> <span class="token keyword">if</span> <span class="token punctuation">(</span>doc_info<span class="token operator">-></span>doc_id <span class="token operator">%</span> <span class="token number">100</span> <span class="token operator">==</span> <span class="token number">0</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">66</span> std<span class="token operator">::</span>cerr <span class="token operator"><<</span> doc_info<span class="token operator">-></span>doc_id <span class="token operator"><<</span> std<span class="token operator">::</span>endl<span class="token punctuation">;</span>

<span class="token number">67</span> <span class="token punctuation">}</span>

<span class="token number">68</span> <span class="token punctuation">}</span>

<span class="token number">69</span> std<span class="token operator">::</span>cerr <span class="token operator"><<</span> <span class="token string">"结束构建索引"</span> <span class="token operator"><<</span> std<span class="token operator">::</span>endl<span class="token punctuation">;</span>

<span class="token number">70</span> file<span class="token punctuation">.</span><span class="token function">close</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">71</span> <span class="token keyword">return</span> <span class="token boolean">true</span><span class="token punctuation">;</span>

<span class="token number">72</span> <span class="token punctuation">}</span>

</code></pre>

<p>这是整体的构建思路,我们接下来就分别完成倒排索引和正排索引<br> =<mark>正排索引</mark>=<br> 我们要做的核心操作: 按照 <code>设定的分隔符</code> 对 <code>行文本</code> 进行切分, 第一个部分就是<code>标题</code>, 第二个部分就是 <code>url</code>, 第三个部分就是<code>正文</code>,然后将这三个部分填充到正排索引对应的结构体中即可。</p>

<pre><code class="prism language-cpp"> <span class="token number">77</span> DocInfo<span class="token operator">*</span> <span class="token class-name">Index</span><span class="token operator">::</span><span class="token function">BuildForward</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> line<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">78</span> <span class="token comment">// 1. 先把 line 按照 \3 切分成 3 个部分</span>

<span class="token number">79</span> vector<span class="token operator"><</span>string<span class="token operator">></span> tokens<span class="token punctuation">;</span>

<span class="token number">80</span> common<span class="token operator">::</span><span class="token class-name">Util</span><span class="token operator">::</span><span class="token function">Split</span><span class="token punctuation">(</span>line<span class="token punctuation">,</span> <span class="token string">"\3"</span><span class="token punctuation">,</span> <span class="token operator">&</span>tokens<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">81</span> <span class="token keyword">if</span> <span class="token punctuation">(</span>tokens<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator">!=</span> <span class="token number">3</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">82</span> <span class="token keyword">return</span> <span class="token keyword">nullptr</span><span class="token punctuation">;</span>

<span class="token number">83</span> <span class="token punctuation">}</span>

<span class="token number">84</span> <span class="token comment">// 2. 把切分结果填充到 DocInfo 对象中</span>

<span class="token number">85</span> DocInfo doc_info<span class="token punctuation">;</span>

<span class="token number">86</span> doc_info<span class="token punctuation">.</span>doc_id <span class="token operator">=</span> forward_index<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">87</span> doc_info<span class="token punctuation">.</span>title <span class="token operator">=</span> tokens<span class="token punctuation">[</span><span class="token number">0</span><span class="token punctuation">]</span><span class="token punctuation">;</span>

<span class="token number">88</span> doc_info<span class="token punctuation">.</span>url <span class="token operator">=</span> tokens<span class="token punctuation">[</span><span class="token number">1</span><span class="token punctuation">]</span><span class="token punctuation">;</span>

<span class="token number">89</span> doc_info<span class="token punctuation">.</span>content <span class="token operator">=</span> tokens<span class="token punctuation">[</span><span class="token number">2</span><span class="token punctuation">]</span><span class="token punctuation">;</span>

<span class="token number">90</span> forward_index<span class="token punctuation">.</span><span class="token function">push_back</span><span class="token punctuation">(</span>std<span class="token operator">::</span><span class="token function">move</span><span class="token punctuation">(</span>doc_info<span class="token punctuation">)</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">91</span> <span class="token keyword">return</span> <span class="token operator">&</span>forward_index<span class="token punctuation">.</span><span class="token function">back</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">92</span> <span class="token punctuation">}</span>

</code></pre>

<p>这里的切分,在C++的标准库中并没有,但是boost库中是有的,因此我们用boost库中的split函数,不过这里我将split封装了一下,比boost库中的split函数少了一个参数,也就是boost::token_compress_on:将连续多个分隔符当一个,默认没有打开,当用的时候一般是要打开的。<br> boost:: token_compress_off:不会压缩分割结果,连续的分隔符时会返回 ""字符串<br> 我默认选择了compress_off因为也许有的html中的字段是空的,那我们也不能将其压缩。<br> <code>并且最后我选择了将doc_info转化成了右值(将亡值)进行了右值引用(效率就是一点点省出来的哦)</code><br> 接下来就是构建倒排索引了,而我们构建倒排索引要做的首先就是构建正排和分词,现在正排已经构建完毕了,那我们就需要分词了,分词我们选择了<code>cppjieba分词库</code>来帮我们完成</p>

<pre><code class="prism language-cpp"> <span class="token number">147</span> <span class="token keyword">void</span> <span class="token class-name">Index</span><span class="token operator">::</span><span class="token function">CutWord</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> input<span class="token punctuation">,</span> vector<span class="token operator"><</span>string<span class="token operator">></span><span class="token operator">*</span> output<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">148</span> jieba<span class="token punctuation">.</span><span class="token function">CutForSearch</span><span class="token punctuation">(</span>input<span class="token punctuation">,</span> <span class="token operator">*</span>output<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">149</span> <span class="token punctuation">}</span>

</code></pre>

<p>那么我们现在终于可以开始期待已久的倒排索引了</p>

<pre><code class="prism language-cpp"> <span class="token number">97</span> <span class="token keyword">void</span> <span class="token class-name">Index</span><span class="token operator">::</span><span class="token function">BuildInverted</span><span class="token punctuation">(</span><span class="token keyword">const</span> DocInfo<span class="token operator">&</span> doc_info<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">98</span> <span class="token comment">// 创建专门用于统计词频的结构</span>

<span class="token number">99</span> <span class="token keyword">struct</span> <span class="token class-name">WordCnt</span> <span class="token punctuation">{</span>

<span class="token number">100</span> <span class="token keyword">int</span> title_cnt<span class="token punctuation">;</span>

<span class="token number">101</span> <span class="token keyword">int</span> content_cnt<span class="token punctuation">;</span>

<span class="token number">102</span> <span class="token function">WordCnt</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator">:</span> <span class="token function">title_cnt</span><span class="token punctuation">(</span><span class="token number">0</span><span class="token punctuation">)</span><span class="token punctuation">,</span> <span class="token function">content_cnt</span><span class="token punctuation">(</span><span class="token number">0</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">103</span> <span class="token punctuation">}</span>

<span class="token number">104</span> <span class="token punctuation">}</span><span class="token punctuation">;</span>

<span class="token number">105</span> unordered_map<span class="token operator"><</span>string<span class="token punctuation">,</span> WordCnt<span class="token operator">></span> word_cnt_map<span class="token punctuation">;</span>

<span class="token number">106</span> <span class="token comment">// 针对标题进行分词 </span>

<span class="token number">107</span> vector<span class="token operator"><</span>string<span class="token operator">></span> title_token<span class="token punctuation">;</span>

<span class="token number">108</span> <span class="token function">CutWord</span><span class="token punctuation">(</span>doc_info<span class="token punctuation">.</span>title<span class="token punctuation">,</span> <span class="token operator">&</span>title_token<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">109</span> <span class="token comment">// 遍历分词结果, 统计每个词出现的次数</span>

<span class="token number">110</span> <span class="token keyword">for</span> <span class="token punctuation">(</span>string word <span class="token operator">:</span> title_token<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">111</span> <span class="token comment">//将只是大小写不同的词当作同一个词来处理</span>

<span class="token number">112</span> <span class="token comment">//因此都转化成小写 </span>

<span class="token number">113</span> boost<span class="token operator">::</span><span class="token function">to_lower</span><span class="token punctuation">(</span>word<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">114</span> <span class="token operator">++</span>word_cnt_map<span class="token punctuation">[</span>word<span class="token punctuation">]</span><span class="token punctuation">.</span>title_cnt<span class="token punctuation">;</span>

<span class="token number">115</span> <span class="token punctuation">}</span>

<span class="token number">116</span> <span class="token comment">// 针对正文进行分词 </span>

<span class="token number">117</span> vector<span class="token operator"><</span>string<span class="token operator">></span> content_token<span class="token punctuation">;</span>

<span class="token number">118</span> <span class="token function">CutWord</span><span class="token punctuation">(</span>doc_info<span class="token punctuation">.</span>content<span class="token punctuation">,</span> <span class="token operator">&</span>content_token<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">119</span> <span class="token comment">// 遍历分词结果, 统计每个词出现的次数 </span>

<span class="token number">120</span> <span class="token keyword">for</span> <span class="token punctuation">(</span>string word <span class="token operator">:</span> content_token<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">121</span> boost<span class="token operator">::</span><span class="token function">to_lower</span><span class="token punctuation">(</span>word<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">122</span> <span class="token operator">++</span>word_cnt_map<span class="token punctuation">[</span>word<span class="token punctuation">]</span><span class="token punctuation">.</span>content_cnt<span class="token punctuation">;</span>

<span class="token number">123</span> <span class="token punctuation">}</span>

<span class="token number">124</span> <span class="token comment">// 填充Weight对象</span>

<span class="token number">125</span> <span class="token keyword">for</span> <span class="token punctuation">(</span><span class="token keyword">const</span> <span class="token keyword">auto</span><span class="token operator">&</span> word_pair <span class="token operator">:</span> word_cnt_map<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">126</span> <span class="token comment">// 构造 Weight 对象</span>

<span class="token number">127</span> Weight weight<span class="token punctuation">;</span>

<span class="token number">128</span> weight<span class="token punctuation">.</span>doc_id <span class="token operator">=</span> doc_info<span class="token punctuation">.</span>doc_id<span class="token punctuation">;</span>

<span class="token number">129</span> <span class="token comment">// 权重 = 标题出现次数 * 10 + 正文出现次数</span>

<span class="token number">130</span> weight<span class="token punctuation">.</span>weight <span class="token operator">=</span> <span class="token number">10</span> <span class="token operator">*</span> word_pair<span class="token punctuation">.</span>second<span class="token punctuation">.</span>title_cnt <span class="token operator">+</span> word_pair<span class="token punctuation">.</span>second<span class="token punctuation">.</span>content_cnt<span class="token punctuation">;</span>

<span class="token number">131</span> weight<span class="token punctuation">.</span>word <span class="token operator">=</span> word_pair<span class="token punctuation">.</span>first<span class="token punctuation">;</span>

<span class="token number">132</span>

<span class="token number">133</span> <span class="token comment">// 把 weight 对象插入到倒排索引中 </span>

<span class="token number">134</span> InvertedList<span class="token operator">&</span> inverted_list <span class="token operator">=</span> inverted_index<span class="token punctuation">[</span>word_pair<span class="token punctuation">.</span>first<span class="token punctuation">]</span><span class="token punctuation">;</span>

<span class="token number">135</span> inverted_list<span class="token punctuation">.</span><span class="token function">push_back</span><span class="token punctuation">(</span>std<span class="token operator">::</span><span class="token function">move</span><span class="token punctuation">(</span>weight<span class="token punctuation">)</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">136</span> <span class="token punctuation">}</span>

<span class="token number">137</span> <span class="token punctuation">}</span>

</code></pre>

<p>整体思路就是将倒排索引设置成一个hash表,key是关键词,value 是倒排拉链 (包含若干个 Weight 对象),同时设置一个hash表,来统计词频key是关键词,value是WordCnt结构体,因此统计出标题的词频和正文的词频,根据这两者的词频算出权重,将权重和分词结果、文档id填入Weight对象,再将Weight对象填入到第一个hash表中。</p>

<p>以上就是索引部分的全部内容了。</p>

<h3>搜索模块</h3>

<p>上面我们构建好了索引模块,现在我们的搜索模块就是要利用上面的索引,首先我们还是将这个模块进行一个封装</p>

<pre><code class="prism language-cpp"> <span class="token number">68</span> <span class="token keyword">class</span> <span class="token class-name">Searcher</span> <span class="token punctuation">{</span>

<span class="token number">69</span> <span class="token keyword">private</span><span class="token operator">:</span>

<span class="token number">70</span> Index<span class="token operator">*</span> index<span class="token punctuation">;</span>

<span class="token number">71</span>

<span class="token number">72</span> <span class="token keyword">public</span><span class="token operator">:</span>

<span class="token number">73</span> <span class="token function">Searcher</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator">:</span> <span class="token function">index</span><span class="token punctuation">(</span><span class="token keyword">new</span> <span class="token function">Index</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">74</span> <span class="token punctuation">}</span>

<span class="token number">75</span> <span class="token keyword">bool</span> <span class="token function">Init</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> input_path<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">76</span> <span class="token keyword">bool</span> <span class="token function">Search</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> query<span class="token punctuation">,</span> string<span class="token operator">*</span> results<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">77</span>

<span class="token number">78</span> <span class="token keyword">private</span><span class="token operator">:</span>

<span class="token number">79</span> string <span class="token function">GenerateDesc</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> content<span class="token punctuation">,</span> <span class="token keyword">const</span> string<span class="token operator">&</span> word<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">80</span> <span class="token punctuation">}</span><span class="token punctuation">;</span>

</code></pre>

<p>这里的对象是Index的一个指针,因为我们要使用到上一个类,而Init初始化也是这个用处</p>

<pre><code class="prism language-cpp"> <span class="token number">145</span> <span class="token keyword">bool</span> <span class="token class-name">Searcher</span><span class="token operator">::</span><span class="token function">Init</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> input_path<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">146</span> <span class="token keyword">return</span> index<span class="token operator">-></span><span class="token function">Build</span><span class="token punctuation">(</span>input_path<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">147</span> <span class="token punctuation">}</span>

</code></pre>

<p>也就是将所有的正排索引和倒排索引都建立好,以便我们接下来使用,接下来就是查询倒排了,并且按照权重进行排序了</p>

<pre><code class="prism language-cpp"> <span class="token number">149</span> <span class="token comment">// 搜索查询词, 得到搜索结果. </span>

<span class="token number">150</span> <span class="token keyword">bool</span> <span class="token class-name">Searcher</span><span class="token operator">::</span><span class="token function">Search</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> query<span class="token punctuation">,</span> string<span class="token operator">*</span> output<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">151</span> <span class="token comment">// 针对查询词进行分词 </span>

<span class="token number">152</span> vector<span class="token operator"><</span>string<span class="token operator">></span> tokens<span class="token punctuation">;</span>

<span class="token number">153</span> index<span class="token operator">-></span><span class="token function">CutWord</span><span class="token punctuation">(</span>query<span class="token punctuation">,</span> <span class="token operator">&</span>tokens<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">154</span> <span class="token comment">// 根据分词结果, 查倒排, 把相关的文档都获取到</span>

<span class="token number">155</span> vector<span class="token operator"><</span>Weight<span class="token operator">></span> all_token_result<span class="token punctuation">;</span>

<span class="token number">156</span> <span class="token keyword">for</span> <span class="token punctuation">(</span>string word <span class="token operator">:</span> tokens<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">157</span> boost<span class="token operator">::</span><span class="token function">to_lower</span><span class="token punctuation">(</span>word<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">158</span> <span class="token keyword">auto</span><span class="token operator">*</span> inverted_list <span class="token operator">=</span> index<span class="token operator">-></span><span class="token function">GetInvertedList</span><span class="token punctuation">(</span>word<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">159</span> <span class="token keyword">if</span> <span class="token punctuation">(</span>inverted_list <span class="token operator">==</span> <span class="token keyword">nullptr</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">160</span> <span class="token keyword">continue</span><span class="token punctuation">;</span>

<span class="token number">161</span> <span class="token punctuation">}</span>

<span class="token number">162</span> <span class="token comment">// 将搜索到的结果都合并到一起进行统一的排序</span>

<span class="token number">163</span> all_token_result<span class="token punctuation">.</span><span class="token function">insert</span><span class="token punctuation">(</span>all_token_result<span class="token punctuation">.</span><span class="token function">end</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">,</span> inverted_list<span class="token operator">-></span><span class="token function">begin</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">,</span> inverted_list<span class="token operator">-></span><span class="token function">end</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">164</span> <span class="token punctuation">}</span>

<span class="token number">165</span> std<span class="token operator">::</span><span class="token function">sort</span><span class="token punctuation">(</span>all_token_result<span class="token punctuation">.</span><span class="token function">begin</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">,</span> all_token_result<span class="token punctuation">.</span><span class="token function">end</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">,</span> <span class="token punctuation">[</span><span class="token punctuation">]</span><span class="token punctuation">(</span><span class="token keyword">const</span> Weight<span class="token operator">&</span> w1<span class="token punctuation">,</span> <span class="token keyword">const</span> Weight<span class="token operator">&</span> w2<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">166</span> <span class="token keyword">return</span> w1<span class="token punctuation">.</span>weight <span class="token operator">></span> w2<span class="token punctuation">.</span>weight<span class="token punctuation">;</span>

<span class="token number">167</span> <span class="token punctuation">}</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

</code></pre>

<p>然后用得到的文档id,去查找正排,再将正排查到的行文本转化成json格式以便我们使用,使用 jsoncpp 这个库来实现 json 的操作.</p>

<pre><code class="prism language-cpp"> <span class="token number">170</span> Json<span class="token operator">::</span>Value results<span class="token punctuation">;</span>

<span class="token number">171</span> <span class="token keyword">for</span> <span class="token punctuation">(</span><span class="token keyword">const</span> <span class="token keyword">auto</span><span class="token operator">&</span> weight <span class="token operator">:</span> all_token_result<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">172</span> <span class="token comment">// 根据 weight 中的 doc_id 查正排 </span>

<span class="token number">173</span> <span class="token keyword">const</span> DocInfo<span class="token operator">*</span> doc_info <span class="token operator">=</span> index<span class="token operator">-></span><span class="token function">GetDocInfo</span><span class="token punctuation">(</span>weight<span class="token punctuation">.</span>doc_id<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">174</span> <span class="token comment">// 把这个 doc_info 对象再进一步的包装成一个 JSON 对象 </span>

<span class="token number">175</span> Json<span class="token operator">::</span>Value result<span class="token punctuation">;</span>

<span class="token number">176</span> result<span class="token punctuation">[</span><span class="token string">"title"</span><span class="token punctuation">]</span> <span class="token operator">=</span> doc_info<span class="token operator">-></span>title<span class="token punctuation">;</span>

<span class="token number">177</span> result<span class="token punctuation">[</span><span class="token string">"url"</span><span class="token punctuation">]</span> <span class="token operator">=</span> doc_info<span class="token operator">-></span>url<span class="token punctuation">;</span>

<span class="token number">178</span> result<span class="token punctuation">[</span><span class="token string">"desc"</span><span class="token punctuation">]</span> <span class="token operator">=</span> <span class="token function">GenerateDesc</span><span class="token punctuation">(</span>doc_info<span class="token operator">-></span>content<span class="token punctuation">,</span> weight<span class="token punctuation">.</span>word<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">179</span> results<span class="token punctuation">.</span><span class="token function">append</span><span class="token punctuation">(</span>result<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">180</span> <span class="token punctuation">}</span>

<span class="token number">181</span> <span class="token comment">// 把得到的 results 这个 JSON 对象序列化成字符串. 写入 output 中</span>

<span class="token number">182</span> Json<span class="token operator">::</span>FastWriter writer<span class="token punctuation">;</span>

<span class="token number">183</span> <span class="token operator">*</span>output <span class="token operator">=</span> writer<span class="token punctuation">.</span><span class="token function">write</span><span class="token punctuation">(</span>results<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">184</span> <span class="token keyword">return</span> <span class="token boolean">true</span><span class="token punctuation">;</span>

<span class="token number">185</span> <span class="token punctuation">}</span>

</code></pre>

<p>而这里的desc,就是在网页上所显示的,文本的部分摘要的内容,而我们要用多少文本来作为摘要呢?<br> 我们先根据正文, 找到 word 出现的位置. 以该位置为中心, 往前找 80 个字节, 作为描述的起始位置.<br> 再从起始位置开始往后找 160 个字节, 作为整个描述. 这里的取值完全根据个人自定义就行</p>

<pre><code class="prism language-cpp"> <span class="token number">187</span> string <span class="token class-name">Searcher</span><span class="token operator">::</span><span class="token function">GenerateDesc</span><span class="token punctuation">(</span><span class="token keyword">const</span> string<span class="token operator">&</span> content<span class="token punctuation">,</span> <span class="token keyword">const</span> string<span class="token operator">&</span> word<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">188</span> <span class="token comment">// 1. 先找到 word 在正文中出现的位置.</span>

<span class="token number">189</span> size_t first_pos <span class="token operator">=</span> content<span class="token punctuation">.</span><span class="token function">find</span><span class="token punctuation">(</span>word<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">190</span> size_t desc_beg <span class="token operator">=</span> <span class="token number">0</span><span class="token punctuation">;</span>

<span class="token number">191</span> <span class="token keyword">if</span> <span class="token punctuation">(</span>first_pos <span class="token operator">==</span> string<span class="token operator">::</span>npos<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">192</span> <span class="token comment">// 如果找不到, 就直接从头开始作为起始位置.</span>

<span class="token number">193</span> <span class="token keyword">if</span> <span class="token punctuation">(</span>content<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator"><</span> <span class="token number">160</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">194</span> <span class="token keyword">return</span> content<span class="token punctuation">;</span>

<span class="token number">195</span> <span class="token punctuation">}</span>

<span class="token number">196</span> string desc <span class="token operator">=</span> content<span class="token punctuation">.</span><span class="token function">substr</span><span class="token punctuation">(</span><span class="token number">0</span><span class="token punctuation">,</span> <span class="token number">160</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">197</span> desc<span class="token punctuation">[</span>desc<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator">-</span> <span class="token number">1</span><span class="token punctuation">]</span> <span class="token operator">=</span> <span class="token string">'.'</span><span class="token punctuation">;</span>

<span class="token number">198</span> desc<span class="token punctuation">[</span>desc<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator">-</span> <span class="token number">2</span><span class="token punctuation">]</span> <span class="token operator">=</span> <span class="token string">'.'</span><span class="token punctuation">;</span>

<span class="token number">199</span> desc<span class="token punctuation">[</span>desc<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator">-</span> <span class="token number">3</span><span class="token punctuation">]</span> <span class="token operator">=</span> <span class="token string">'.'</span><span class="token punctuation">;</span>

<span class="token number">200</span> <span class="token keyword">return</span> desc<span class="token punctuation">;</span>

<span class="token number">201</span> <span class="token punctuation">}</span>

<span class="token number">202</span> <span class="token comment">// 2. 找到了 first_pos 位置, 以这个位置为基准, 往前找一些字节.</span>

<span class="token number">203</span> desc_beg <span class="token operator">=</span> first_pos <span class="token operator"><</span> <span class="token number">80</span> <span class="token operator">?</span> <span class="token number">0</span> <span class="token operator">:</span> first_pos <span class="token operator">-</span> <span class="token number">80</span><span class="token punctuation">;</span>

<span class="token number">204</span> <span class="token keyword">if</span> <span class="token punctuation">(</span>desc_beg <span class="token operator">+</span> <span class="token number">160</span> <span class="token operator">>=</span> content<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">205</span> <span class="token comment">// desc_beg 后面的内容不够 160 了, 直接到末尾结束即可 </span>

<span class="token number">206</span> <span class="token keyword">return</span> content<span class="token punctuation">.</span><span class="token function">substr</span><span class="token punctuation">(</span>desc_beg<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">207</span> <span class="token punctuation">}</span> <span class="token keyword">else</span> <span class="token punctuation">{</span>

<span class="token number">208</span> string desc <span class="token operator">=</span> content<span class="token punctuation">.</span><span class="token function">substr</span><span class="token punctuation">(</span>desc_beg<span class="token punctuation">,</span> <span class="token number">160</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">209</span> desc<span class="token punctuation">[</span>desc<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator">-</span> <span class="token number">1</span><span class="token punctuation">]</span> <span class="token operator">=</span> <span class="token string">'.'</span><span class="token punctuation">;</span>

<span class="token number">210</span> desc<span class="token punctuation">[</span>desc<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator">-</span> <span class="token number">2</span><span class="token punctuation">]</span> <span class="token operator">=</span> <span class="token string">'.'</span><span class="token punctuation">;</span>

<span class="token number">211</span> desc<span class="token punctuation">[</span>desc<span class="token punctuation">.</span><span class="token function">size</span><span class="token punctuation">(</span><span class="token punctuation">)</span> <span class="token operator">-</span> <span class="token number">3</span><span class="token punctuation">]</span> <span class="token operator">=</span> <span class="token string">'.'</span><span class="token punctuation">;</span>

<span class="token number">212</span> <span class="token keyword">return</span> desc<span class="token punctuation">;</span>

<span class="token number">213</span> <span class="token punctuation">}</span>

<span class="token number">214</span> <span class="token punctuation">}</span>

</code></pre>

<p>这就是搜索模块所实现的所有功能了,像是测试,我就不在这里写了,不过完成每一个模块的时候都要测试一下,不要最后发现出错了都不知道去哪里找</p>

<h3>服务器模块</h3>

<p>接下来就是最后的一个模块了,服务器模块,这里我们就用cpp-httplib库来搭建服务器了,就不自己手动用stocket套接字搭建了,根据项目文档来使用即可,这里我就不多介绍了</p>

<pre><code class="prism language-cpp"> <span class="token number">25</span> Server server<span class="token punctuation">;</span>

<span class="token number">26</span> server<span class="token punctuation">.</span><span class="token function">Get</span><span class="token punctuation">(</span><span class="token string">"/searcher"</span><span class="token punctuation">,</span> <span class="token punctuation">[</span><span class="token operator">&</span>searcher<span class="token punctuation">]</span><span class="token punctuation">(</span><span class="token keyword">const</span> Request<span class="token operator">&</span> req<span class="token punctuation">,</span> Response<span class="token operator">&</span> resp<span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">27</span> <span class="token keyword">if</span> <span class="token punctuation">(</span><span class="token operator">!</span>req<span class="token punctuation">.</span><span class="token function">has_param</span><span class="token punctuation">(</span><span class="token string">"query"</span><span class="token punctuation">)</span><span class="token punctuation">)</span> <span class="token punctuation">{</span>

<span class="token number">28</span> resp<span class="token punctuation">.</span><span class="token function">set_content</span><span class="token punctuation">(</span><span class="token string">"您发的请求参数错误"</span><span class="token punctuation">,</span> <span class="token string">"text/plain"</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">29</span> <span class="token keyword">return</span><span class="token punctuation">;</span>

<span class="token number">30</span> <span class="token punctuation">}</span>

<span class="token number">31</span> string query <span class="token operator">=</span> req<span class="token punctuation">.</span><span class="token function">get_param_value</span><span class="token punctuation">(</span><span class="token string">"query"</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">32</span> string results<span class="token punctuation">;</span>

<span class="token number">33</span> searcher<span class="token punctuation">.</span><span class="token function">Search</span><span class="token punctuation">(</span>query<span class="token punctuation">,</span> <span class="token operator">&</span>results<span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">34</span> resp<span class="token punctuation">.</span><span class="token function">set_content</span><span class="token punctuation">(</span>results<span class="token punctuation">,</span> <span class="token string">"application/json"</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">35</span> <span class="token punctuation">}</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

</code></pre>

<p>先创建Server对象,然后调用Get函数,这个函数有两个参数,第一个表示的是,你要用哪个http路径来触发get操作,第二个参数是一个lambda表达式,是一个回调函数,也就是当服务器收到第一个参数的请求的时候,会触发回调函数的操作,Request就是请求,Response就是相应,我们收到请求之后就可以解析请求,根据请求内容,来完成响应。set_content就是将我们的结果写到响应的body中,然后返回,他的第二个参数就是返回的body的数据格式,text/plain就是纯文本,application/json就是json格式。<br> 最后将我们的所做的前端页面,也就是静态资源挂载就可以了。</p>

<pre><code class="prism language-cpp"> <span class="token number">36</span> <span class="token comment">// 告诉服务器, 静态资源存放在 wwwroot 目录下. (html, css, js, 图片....) </span>

<span class="token number">37</span> server<span class="token punctuation">.</span><span class="token function">set_mount_point</span><span class="token punctuation">(</span><span class="token string">"/"</span><span class="token punctuation">,</span> <span class="token string">"./ShySearcher"</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

<span class="token number">38</span> <span class="token comment">// 3. 启动服务器 </span>

<span class="token number">39</span> server<span class="token punctuation">.</span><span class="token function">listen</span><span class="token punctuation">(</span><span class="token string">"0.0.0.0"</span><span class="token punctuation">,</span> <span class="token number">10001</span><span class="token punctuation">)</span><span class="token punctuation">;</span>

</code></pre>

<p>我前端做的不太好,也就不给大家展示了。<br> 咱们的站内搜索引擎也基本就结束了。<br> <a href="http://img.e-com-net.com/image/info8/15747abf027d4f0fb26b95ace0490e0f.jpg" target="_blank"><img src="http://img.e-com-net.com/image/info8/15747abf027d4f0fb26b95ace0490e0f.jpg" alt="简易的站内搜索引擎 (万字长文!!绝对值得一看!!)_第6张图片" width="255" height="255" style="border:1px solid black;"></a><a href="http://img.e-com-net.com/image/info8/5d8f7b668c684c11b1c3dd62c273043c.jpg" target="_blank"><img src="http://img.e-com-net.com/image/info8/5d8f7b668c684c11b1c3dd62c273043c.jpg" alt="简易的站内搜索引擎 (万字长文!!绝对值得一看!!)_第7张图片" width="500" height="499" style="border:1px solid black;"></a></p>

</div>

</div>

</div>

</div>

</div>

<!--PC和WAP自适应版-->

<div id="SOHUCS" sid="1592317582126456832"></div>

<script type="text/javascript" src="/views/front/js/chanyan.js"></script>

<!-- 文章页-底部 动态广告位 -->

<div class="youdao-fixed-ad" id="detail_ad_bottom"></div>

</div>

<div class="col-md-3">

<div class="row" id="ad">

<!-- 文章页-右侧1 动态广告位 -->

<div id="right-1" class="col-lg-12 col-md-12 col-sm-4 col-xs-4 ad">

<div class="youdao-fixed-ad" id="detail_ad_1"> </div>

</div>

<!-- 文章页-右侧2 动态广告位 -->

<div id="right-2" class="col-lg-12 col-md-12 col-sm-4 col-xs-4 ad">

<div class="youdao-fixed-ad" id="detail_ad_2"></div>

</div>

<!-- 文章页-右侧3 动态广告位 -->

<div id="right-3" class="col-lg-12 col-md-12 col-sm-4 col-xs-4 ad">

<div class="youdao-fixed-ad" id="detail_ad_3"></div>

</div>

</div>

</div>

</div>

</div>

</div>

<div class="container">

<h4 class="pt20 mb15 mt0 border-top">你可能感兴趣的:(c++,http,linux)</h4>

<div id="paradigm-article-related">

<div class="recommend-post mb30">

<ul class="widget-links">

<li><a href="/article/1835513699826233344.htm"

title="android系统selinux中添加新属性property" target="_blank">android系统selinux中添加新属性property</a>

<span class="text-muted">辉色投像</span>

<div>1.定位/android/system/sepolicy/private/property_contexts声明属性开头:persist.charge声明属性类型:u:object_r:system_prop:s0图12.定位到android/system/sepolicy/public/domain.te删除neverallow{domain-init}default_prop:property</div>

</li>

<li><a href="/article/1835511912843014144.htm"

title="理解Gunicorn:Python WSGI服务器的基石" target="_blank">理解Gunicorn:Python WSGI服务器的基石</a>

<span class="text-muted">范范0825</span>

<a class="tag" taget="_blank" href="/search/ipython/1.htm">ipython</a><a class="tag" taget="_blank" href="/search/linux/1.htm">linux</a><a class="tag" taget="_blank" href="/search/%E8%BF%90%E7%BB%B4/1.htm">运维</a>

<div>理解Gunicorn:PythonWSGI服务器的基石介绍Gunicorn,全称GreenUnicorn,是一个为PythonWSGI(WebServerGatewayInterface)应用设计的高效、轻量级HTTP服务器。作为PythonWeb应用部署的常用工具,Gunicorn以其高性能和易用性著称。本文将介绍Gunicorn的基本概念、安装和配置,帮助初学者快速上手。1.什么是Gunico</div>

</li>

<li><a href="/article/1835511030260789248.htm"

title="c++ 的iostream 和 c++的stdio的区别和联系" target="_blank">c++ 的iostream 和 c++的stdio的区别和联系</a>

<span class="text-muted">黄卷青灯77</span>

<a class="tag" taget="_blank" href="/search/c%2B%2B/1.htm">c++</a><a class="tag" taget="_blank" href="/search/%E7%AE%97%E6%B3%95/1.htm">算法</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a><a class="tag" taget="_blank" href="/search/iostream/1.htm">iostream</a><a class="tag" taget="_blank" href="/search/stdio/1.htm">stdio</a>

<div>在C++中,iostream和C语言的stdio.h都是用于处理输入输出的库,但它们在设计、用法和功能上有许多不同。以下是两者的区别和联系:区别1.编程风格iostream(C++风格):C++标准库中的输入输出流类库,支持面向对象的输入输出操作。典型用法是cin(输入)和cout(输出),使用>操作符来处理数据。更加类型安全,支持用户自定义类型的输入输出。#includeintmain(){in</div>

</li>

<li><a href="/article/1835509770287673344.htm"

title="swagger访问路径" target="_blank">swagger访问路径</a>

<span class="text-muted">igotyback</span>

<a class="tag" taget="_blank" href="/search/swagger/1.htm">swagger</a>

<div>Swagger2.x版本访问地址:http://{ip}:{port}/{context-path}/swagger-ui.html{ip}是你的服务器IP地址。{port}是你的应用服务端口,通常为8080。{context-path}是你的应用上下文路径,如果应用部署在根路径下,则为空。Swagger3.x版本对于Swagger3.x版本(也称为OpenAPI3)访问地址:http://{ip</div>

</li>

<li><a href="/article/1835509391361667072.htm"

title="Linux下QT开发的动态库界面弹出操作(SDL2)" target="_blank">Linux下QT开发的动态库界面弹出操作(SDL2)</a>

<span class="text-muted">13jjyao</span>

<a class="tag" taget="_blank" href="/search/QT%E7%B1%BB/1.htm">QT类</a><a class="tag" taget="_blank" href="/search/qt/1.htm">qt</a><a class="tag" taget="_blank" href="/search/%E5%BC%80%E5%8F%91%E8%AF%AD%E8%A8%80/1.htm">开发语言</a><a class="tag" taget="_blank" href="/search/sdl2/1.htm">sdl2</a><a class="tag" taget="_blank" href="/search/linux/1.htm">linux</a>

<div>需求:操作系统为linux,开发框架为qt,做成需带界面的qt动态库,调用方为java等非qt程序难点:调用方为java等非qt程序,也就是说调用方肯定不带QApplication::exec(),缺少了这个,QTimer等事件和QT创建的窗口将不能弹出(包括opencv也是不能弹出);这与qt调用本身qt库是有本质的区别的思路:1.调用方缺QApplication::exec(),那么我们在接口</div>

</li>

<li><a href="/article/1835504596898902016.htm"

title="linux sdl windows.h,Windows下的SDL安装" target="_blank">linux sdl windows.h,Windows下的SDL安装</a>

<span class="text-muted">奔跑吧linux内核</span>

<a class="tag" taget="_blank" href="/search/linux/1.htm">linux</a><a class="tag" taget="_blank" href="/search/sdl/1.htm">sdl</a><a class="tag" taget="_blank" href="/search/windows.h/1.htm">windows.h</a>

<div>首先你要下载并安装SDL开发包。如果装在C盘下,路径为C:\SDL1.2.5如果在WINDOWS下。你可以按以下步骤:1.打开VC++,点击"Tools",Options2,点击directories选项3.选择"Includefiles"增加一个新的路径。"C:\SDL1.2.5\include"4,现在选择"Libaryfiles“增加"C:\SDL1.2.5\lib"现在你可以开始编写你的第</div>

</li>

<li><a href="/article/1835504218178416640.htm"

title="Google earth studio 简介" target="_blank">Google earth studio 简介</a>

<span class="text-muted">陟彼高冈yu</span>

<a class="tag" taget="_blank" href="/search/%E6%97%85%E6%B8%B8/1.htm">旅游</a>