第三章 回归分析

一、回归分析相关概念

1.1回归分析是研究变量间函数关系的一种方法。变量之间的关系可以表示为方程的形式。

大数据分析中,回归分析是一种预测性的建模技术。这种技术通常用于预测分析、时间序列模型,以及发现变量之间的因果关系。

1.2可以解决的问题

进行因素分析,确定影响某一变量的若干变量(因素)中,何者为主要,何者为次要,以及它们之间的关系

1.3回归分析的步骤

①首先确定要进行预测的因变量,然后集中于说明变量,进行多元回归分析

②多元回归分析将给出因变量与说明变量之间的关系

③这一关系最后以公式(模型)形式给出,通过它预测因变量的未来值

二、线性回归

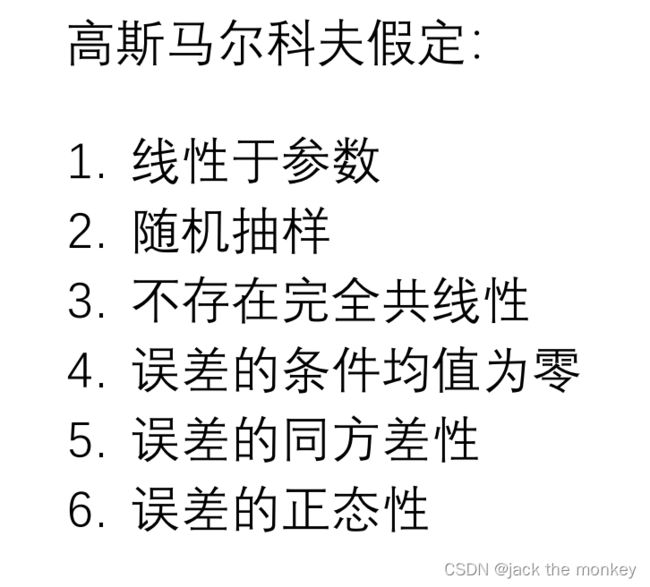

前提假设(重要):

①线性相关:自变量与因变量之间存在线性相关性

②随机抽样:样本来自于总体的随机抽样。

③期望0:误差项是期望为0的随机变量

④同方差:对于任意的Xi的误差项的方差相同

⑤正态性:误差项独立于解释变量,且服从正态分布,相互独立

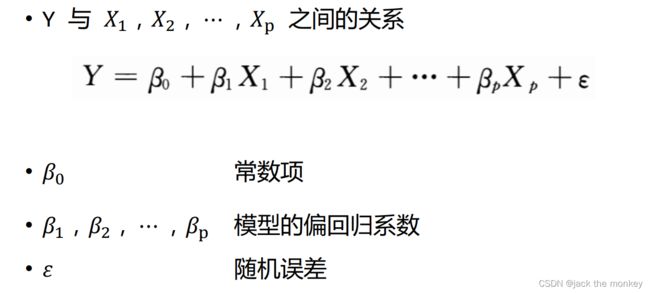

2.1模型

ε是随机误差

回归参数值可通过数据集进行估算

2.2拟合方法

①最大似然估计法

(1)写出似然函数;

(2)对似然函数取对数,并整理;

(3)求导数;

(4)解似然方程。

②最小二乘法:总的误差平方和达到最小(损失函数最小来确定参数)

③梯度下降法:梯度的本意是一个向量(矢量),表示某一函数(该函数一般是二元及以上的)在该点处的方向导数沿着该方向取得最大值,即函数在该点处沿着该方向(此梯度的方向)变化最快,变化率最大(为该梯度的模)。

当函数是一元函数时,梯度就是导数。

2.2一元线性回归

前提条件:

2.2.1模型检验:

①拟合优度检验:

1)判定系数R^2:回归平方和占总平方和的比例。

判定系数越接近1,表明回归平方和占总平方和的比例越大,回归直线与各观测点越接近,回归直线的拟合程度越好。

2)估计标准误差

度量各实际观测点在直线周围的散布状况的一个统计量,是均方残差(MSE)的平方根,用Se表示。Se越小,回归直线对各观测点的代表性就越好。

②显著性检验

方程是样本数据建立,是否真实反映变量x和y之间的关系,需要通过检验来证实。

1)线性关系检验(β1=0)

F=MSR/MSE,当原假设H0成立时,F值应接近1,若不成立,将无穷大。

2)回归系数的检验

t检验,检验回归系数β1是否=0

多元回归分析中,F检验是检验总体回归关系的显著性,t检验是检验各回归系数的显著性。

2.2.3 预测

计算特定Y值;Y值的平均值

2.2.4残差分析

符合三个假定:误差项期望为0;所有误差同方差;服从正态分布

2.3多元回归分析

2.3.1模型检验:

①拟合优度检验:

多重判定系数R^2:反映Y的误差中属于回归方程所解释的比例。

由于自变量个数增加会使预测误差变小,从而减少残差平方和SSE。为避免高估R^2,使用调整后的多重判定系数。

估计标准误差:

Se

②显著性检验

线性关系检验:F检验

回归系数检验和推断:t检验

2.3.2多重共线性

含义:回归模型两个或以上的自变量彼此相关

判定:计算变量间相关系数,并对相关系数进行显著性检验。

容忍度:1-判定系数(该自变量为因变量,其余所有自变量为预测变量)

VIF(方差膨胀因子):容忍度的倒数

解决方法:保留重要解释变量,去掉次要或可替代解释变量;逐步回归分析;主成份分析(降维)

2.3.3变量选择与逐步回归

①向前选择:略

②向后剔除:

③逐步回归:逐个引入自变量,引入的条件是该自变量经F检验是显著的,每引入一个自变量后,对已选入的变量进行逐个检验,如果原来引入的变量由于后面变量的引入而变得不再显著,那么就将其剔除。引入一个变量或从回归方程中剔除一个变量,为逐步回归的一步,每一步都要进行F 检验,以确保每次引入新变量之前回归方程中只包含显著的变量。

2.4 逻辑回归

当你的目标变量是分类变量时,才会考虑逻辑回归,并且主要用于两分类问题。

Logistic 回归通过 logit 转换将取值为 的线性方程的值域转化为 ,正好与 概率的取值范围一致,模型的表达式为:

在二元 logistic 回归中, 表示某件事情发生的概率。

逻辑回归的损失函数:

损失函数(Loss Function) 直接作用于单个样本,用来表达样本的误差

代价函数(Cost Function)是整个样本集的平均误差,对所有损失函数值的平均

目标函数(Object Function)是我们最终要优化的函数,也就是代价函数+正则化函数(经验风险+结构风险)

在逻辑回归中,最常用的是代价函数是交叉熵(Cross Entropy)

2.5 交叉熵简介

信息熵也被称为熵,用来表示所有信息量的期望。

交叉熵能够衡量同一个随机变量中的两个不同概率分布的差异程度,在机器学习中就表示为真实概率分布与预测概率分布之间的差异。交叉熵的值越小,模型预测效果就越好。

交叉熵在分类问题中常常与softmax是标配,softmax将输出的结果进行处理,使其多个分类的预测值和为1,再通过交叉熵来计算损失。

交叉熵可在神经网络(机器学习)中作为损失函数,p表示真实标记的分布,q则为训练后的模型的预测标记分布,交叉熵损失函数可以衡量p与q的相似性。交叉熵作为损失函数还有一个好处是使用sigmoid函数在梯度下降时能避免均方误差损失函数学习速率降低的问题,因为学习速率可以被输出的误差所控制。